Künstliche Intelligenz

InstructIR: Hochwertige Bildwiederherstellung nach menschlichen Anweisungen

Ein Bild kann viel vermitteln, kann aber auch durch verschiedene Probleme wie Bewegungsunschärfe, Dunst, Rauschen und geringen Dynamikbereich beeinträchtigt werden. Diese Probleme, die gemeinhin als Beeinträchtigungen des Computersehens auf niedriger Ebene bezeichnet werden, können durch schwierige Umgebungsbedingungen wie Hitze oder Regen oder durch Einschränkungen der Kamera selbst entstehen. Die Bildwiederherstellung stellt eine zentrale Herausforderung im Bereich Computer Vision dar, bei der es darum geht, aus einem Bild, das solche Beeinträchtigungen aufweist, ein qualitativ hochwertiges, sauberes Bild wiederherzustellen. Die Bildwiederherstellung ist komplex, da es mehrere Lösungen für die Wiederherstellung eines bestimmten Bildes geben kann. Einige Ansätze zielen auf bestimmte Beeinträchtigungen ab, beispielsweise auf die Reduzierung von Rauschen oder die Entfernung von Unschärfe oder Dunst.

Während diese Methoden bei bestimmten Problemen gute Ergebnisse liefern können, ist es oft schwierig, sie auf verschiedene Arten von Verschlechterungen zu übertragen. Viele Frameworks verwenden ein generisches neuronales Netzwerk für eine Vielzahl von Bildwiederherstellungsaufgaben, diese Netzwerke werden jedoch jeweils separat trainiert. Die Notwendigkeit unterschiedlicher Modelle für jede Art von Verschlechterung macht diesen Ansatz rechenintensiv und zeitaufwändig, was dazu führt, dass in den jüngsten Entwicklungen der Schwerpunkt auf All-In-One-Restaurierungsmodellen liegt. Diese Modelle verwenden ein einziges, tief blindes Wiederherstellungsmodell, das mehrere Ebenen und Arten der Verschlechterung berücksichtigt und häufig abbauspezifische Aufforderungen oder Leitvektoren verwendet, um die Leistung zu verbessern. Obwohl All-In-One-Modelle in der Regel vielversprechende Ergebnisse liefern, stehen sie immer noch vor Herausforderungen mit inversen Problemen.

InstructIR stellt einen bahnbrechenden Ansatz auf diesem Gebiet dar und ist der erste Bildwiederherstellung Rahmen, der das Restaurierungsmodell durch von Menschen geschriebene Anweisungen leiten soll. Es kann Eingabeaufforderungen in natürlicher Sprache verarbeiten, um qualitativ hochwertige Bilder aus beeinträchtigten Bildern wiederherzustellen, wobei verschiedene Verschlechterungstypen berücksichtigt werden. InstructIR setzt einen neuen Leistungsstandard für ein breites Spektrum von Bildwiederherstellungsaufgaben, einschließlich Entraining, Rauschunterdrückung, Dunstentfernung, Unschärfe und Verbesserung von Bildern bei schlechten Lichtverhältnissen.

Ziel dieses Artikels ist es, das InstructIR-Framework eingehend zu behandeln. Wir untersuchen den Mechanismus, die Methodik und die Architektur des Frameworks sowie seinen Vergleich mit modernsten Bild- und Videogenerierungs-Frameworks. Also lasst uns anfangen.

InstructIR: Hochwertige Bildwiederherstellung

Die Bildwiederherstellung ist ein grundlegendes Problem in der Computer Vision, da sie darauf abzielt, aus einem Bild, das Verschlechterungen aufweist, ein hochwertiges, sauberes Bild wiederherzustellen. In der Low-Level-Computer-Vision ist der Begriff „Degradations“ ein Begriff, der unangenehme Effekte beschreibt, die in einem Bild beobachtet werden, wie Bewegungsunschärfe, Dunst, Rauschen, geringer Dynamikbereich und mehr. Der Grund dafür, dass die Bildwiederherstellung eine komplexe umgekehrte Herausforderung darstellt, liegt darin, dass es mehrere verschiedene Lösungen für die Wiederherstellung eines Bildes geben kann. Einige Frameworks konzentrieren sich auf spezifische Beeinträchtigungen wie die Reduzierung von Instanzrauschen oder die Rauschunterdrückung des Bildes, während andere sich möglicherweise mehr auf die Entfernung von Unschärfe oder Unschärfe oder die Beseitigung von Trübungen oder Unschärfen konzentrieren.

Aktuelle Deep-Learning-Methoden haben im Vergleich zu herkömmlichen Bildwiederherstellungsmethoden eine stärkere und konsistentere Leistung gezeigt. Diese Deep-Learning-Bildwiederherstellungsmodelle schlagen die Verwendung neuronaler Netze vor, die auf Transformatoren und Faltungs-Neuronalen Netzen basieren. Diese Modelle können unabhängig voneinander für verschiedene Bildwiederherstellungsaufgaben trainiert werden und verfügen außerdem über die Fähigkeit, lokale und globale Merkmalsinteraktionen zu erfassen und zu verbessern, was zu einer zufriedenstellenden und konsistenten Leistung führt. Obwohl einige dieser Methoden möglicherweise für bestimmte Abbauarten ausreichend funktionieren, lassen sie sich in der Regel nicht gut auf andere Abbauarten übertragen. Während viele bestehende Frameworks dasselbe neuronale Netzwerk für eine Vielzahl von Bildwiederherstellungsaufgaben verwenden, wird jede Formulierung des neuronalen Netzwerks separat trainiert. Daher ist es offensichtlich, dass die Verwendung eines separaten neuronalen Modells für jede denkbare Verschlechterung undurchführbar und zeitaufwändig ist, weshalb sich neuere Bildwiederherstellungs-Frameworks auf All-In-One-Wiederherstellungs-Proxys konzentriert haben.

All-In-One- oder Multi-Degradation- oder Multi-Task-Bildwiederherstellungsmodelle erfreuen sich im Bereich der maschinellen Bildverarbeitung immer größerer Beliebtheit, da sie in der Lage sind, mehrere Arten und Grade von Verschlechterungen in einem Bild wiederherzustellen, ohne dass die Modelle für jede Verschlechterung einzeln trainiert werden müssen . All-In-One-Bildwiederherstellungsmodelle verwenden ein einziges Deep-Blind-Bildwiederherstellungsmodell, um verschiedene Arten und Grade der Bildverschlechterung zu bewältigen. Verschiedene All-In-One-Modelle implementieren unterschiedliche Ansätze, um das blinde Modell bei der Wiederherstellung des verschlechterten Bildes anzuleiten, beispielsweise ein Hilfsmodell zur Klassifizierung der Verschlechterung oder mehrdimensionale Leitvektoren oder Eingabeaufforderungen, die dem Modell dabei helfen, verschiedene Arten der Verschlechterung innerhalb eines Bildes wiederherzustellen Bild.

Damit kommen wir zur textbasierten Bildbearbeitung, da sie in den letzten Jahren von mehreren Frameworks für die Text-zu-Bild-Generierung und textbasierte Bildbearbeitungsaufgaben implementiert wurde. Diese Modelle verwenden häufig Textaufforderungen, um Aktionen oder Bilder zu beschreiben diffusionsbasierte Modelle um die entsprechenden Bilder zu erzeugen. Die Hauptinspiration für das InstructIR-Framework ist das InstructPix2Pix-Framework, das es dem Modell ermöglicht, das Bild mithilfe von Benutzeranweisungen zu bearbeiten, die dem Modell Anweisungen geben, welche Aktion ausgeführt werden soll, anstelle von Textbeschriftungen, Beschreibungen oder Bildunterschriften des Eingabebilds. Dadurch können Benutzer natürliche geschriebene Texte verwenden, um dem Modell Anweisungen zu geben, welche Aktion es ausführen soll, ohne Beispielbilder oder zusätzliche Bildbeschreibungen bereitstellen zu müssen.

Aufbauend auf diesen Grundlagen ist das InstructIR-Framework das erste Computer-Vision-Modell überhaupt, das von Menschen geschriebene Anweisungen verwendet, um eine Bildwiederherstellung zu erreichen und inverse Probleme zu lösen. Für Eingabeaufforderungen in natürlicher Sprache kann das InstructIR-Modell qualitativ hochwertige Bilder von ihren beeinträchtigten Gegenstücken wiederherstellen und berücksichtigt auch mehrere Verschlechterungstypen. Das InstructIR-Framework ist in der Lage, modernste Leistung für eine Vielzahl von Bildwiederherstellungsaufgaben zu liefern, darunter Bildentwässerung, Rauschunterdrückung, Dunstentfernung, Unschärfe und Bildverbesserung bei schlechten Lichtverhältnissen. Im Gegensatz zu bestehenden Arbeiten, die eine Bildwiederherstellung mithilfe erlernter Führungsvektoren oder Eingabeaufforderungseinbettungen erreichen, verwendet das InstructIR-Framework rohe Benutzereingabeaufforderungen in Textform. Das InstructIR-Framework kann auf die Wiederherstellung von Bildern mithilfe von Menschen geschriebener Anweisungen verallgemeinert werden, und das von InstructIR implementierte einzelne All-in-One-Modell deckt mehr Wiederherstellungsaufgaben ab als frühere Modelle. Die folgende Abbildung zeigt die verschiedenen Wiederherstellungsbeispiele des InstructIR-Frameworks.

InstructIR: Methode und Architektur

Im Kern besteht das InstructIR-Framework aus einem Text-Encoder und einem Bildmodell. Das Modell verwendet das NAFNet-Framework, ein effizientes Bildwiederherstellungsmodell, das einer U-Net-Architektur als Bildmodell folgt. Darüber hinaus implementiert das Modell Task-Routing-Techniken, um mehrere Aufgaben mit einem einzigen Modell erfolgreich zu erlernen. Die folgende Abbildung veranschaulicht den Trainings- und Bewertungsansatz für das InstructIR-Framework.

Inspiriert vom InstructPix2Pix-Modell übernimmt das InstructIR-Framework von Menschen geschriebene Anweisungen als Kontrollmechanismus, da der Benutzer keine zusätzlichen Informationen bereitstellen muss. Diese Anweisungen bieten eine ausdrucksstarke und klare Möglichkeit zur Interaktion und ermöglichen es Benutzern, den genauen Ort und die Art der Verschlechterung im Bild anzuzeigen. Darüber hinaus verbessert die Verwendung von Benutzereingabeaufforderungen anstelle von festen, degradationsspezifischen Eingabeaufforderungen die Benutzerfreundlichkeit und Anwendungen des Modells, da es auch von Benutzern verwendet werden kann, denen die erforderliche Fachkenntnis fehlt. Um das InstructIR-Framework mit der Fähigkeit auszustatten, verschiedene Eingabeaufforderungen zu verstehen, verwendet das Modell GPT-4, ein großes Sprachmodell zum Erstellen verschiedener Anfragen, wobei mehrdeutige und unklare Eingabeaufforderungen nach einem Filterprozess entfernt werden.

Text-Encoder

Ein Textencoder wird von Sprachmodellen verwendet, um die Benutzeraufforderungen einer Texteinbettung oder einer Vektordarstellung mit fester Größe zuzuordnen. Traditionell ist der Textencoder von a CLIP-Modell ist eine wichtige Komponente für die textbasierte Bildgenerierung und textbasierte Bildbearbeitungsmodelle zur Kodierung von Benutzeraufforderungen, da das CLIP-Framework sich durch visuelle Eingabeaufforderungen auszeichnet. In den meisten Fällen enthalten Benutzeraufforderungen zur Verschlechterung jedoch kaum oder gar keinen visuellen Inhalt, sodass die großen CLIP-Encoder für solche Aufgaben unbrauchbar werden, da sie die Effizienz erheblich beeinträchtigen. Um dieses Problem anzugehen, entscheidet sich das InstructIR-Framework für einen textbasierten Satzkodierer, der darauf trainiert ist, Sätze in einem sinnvollen Einbettungsraum zu kodieren. Satzkodierer werden anhand von Millionen von Beispielen vorab trainiert und sind dennoch im Vergleich zu herkömmlichen CLIP-basierten Textkodierern kompakt und effizient und verfügen gleichzeitig über die Fähigkeit, die Semantik verschiedener Benutzeraufforderungen zu kodieren.

Textanleitung

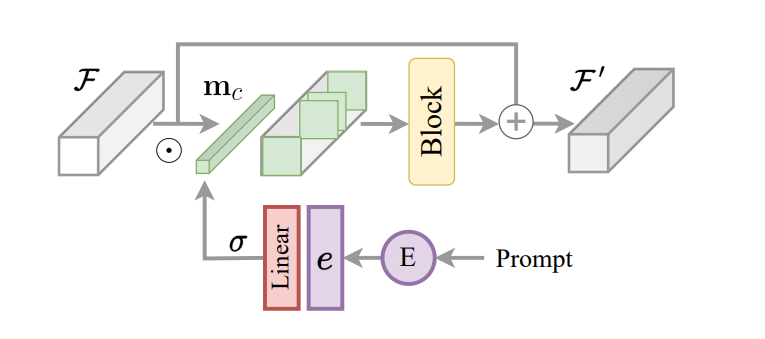

Ein Hauptaspekt des InstructIR-Frameworks ist die Implementierung der codierten Anweisung als Kontrollmechanismus für das Bildmodell. Darauf aufbauend und inspiriert durch das Aufgabenrouting für das Lernen vieler Aufgaben schlägt das InstructIR-Framework einen Instruction Construction Block oder ICB vor, um aufgabenspezifische Transformationen innerhalb des Modells zu ermöglichen. Beim herkömmlichen Task-Routing werden aufgabenspezifische Binärmasken auf Kanalfunktionen angewendet. Da das InstructIR-Framework die Verschlechterung jedoch nicht kennt, wird diese Technik nicht direkt implementiert. Darüber hinaus wendet das InstructIR-Framework für Bildmerkmale und die codierten Anweisungen Task-Routing an und erzeugt die Maske mithilfe einer linearen Schicht, die mithilfe der Sigmoid-Funktion aktiviert wird, um abhängig von den Texteinbettungen einen Satz von Gewichten zu erzeugen und so eine c-dimensionale Pro zu erhalten Kanal-Binärmaske. Das Modell verbessert die konditionierten Features mithilfe eines NAFBlocks weiter und verwendet den NAFBlock und den Instruction Conditioned Block, um die Features sowohl am Encoderblock als auch am Decoderblock zu konditionieren.

Obwohl das InstructIR-Framework die neuronalen Netzwerkfilter nicht explizit konditioniert, erleichtert die Maske dem Modell die Auswahl der Kanäle, die auf der Grundlage der Bildanweisung und -informationen am relevantesten sind.

InstructIR: Implementierung und Ergebnisse

Das InstructIR-Modell ist durchgängig trainierbar und das Bildmodell erfordert kein Vortraining. Es müssen nur die Texteinbettungsprojektionen und der Klassifizierungskopf trainiert werden. Der Text-Encoder wird mit einem BGE-Encoder initialisiert, einem BERT-ähnlichen Encoder, der auf einer großen Menge überwachter und unüberwachter Daten für die Satzkodierung für allgemeine Zwecke vorab trainiert wurde. Das InstructIR-Framework verwendet das NAFNet-Modell als Bildmodell und die Architektur von NAFNet besteht aus einem 4-Ebenen-Encoder-Decoder mit einer unterschiedlichen Anzahl von Blöcken auf jeder Ebene. Das Modell fügt außerdem 4 mittlere Blöcke zwischen dem Encoder und dem Decoder hinzu, um die Funktionen weiter zu verbessern. Darüber hinaus implementiert der Decoder anstelle der Verkettung für die Skip-Verbindungen die Addition, und das InstructIR-Modell implementiert nur den ICB oder Instruction Conditioned Block für das Task-Routing nur im Encoder und Decoder. Im weiteren Verlauf wird das InstructIR-Modell mithilfe des Verlusts zwischen dem wiederhergestellten Bild und dem sauberen Ground-Truth-Bild optimiert, und der Kreuzentropieverlust wird für den Absichtsklassifizierungskopf des Textencoders verwendet. Das InstructIR-Modell verwendet den AdamW-Optimierer mit einer Stapelgröße von 32 und einer Lernrate von 5e-4 für fast 500 Epochen und implementiert auch den Lernratenabfall durch Cosinus-Annealing. Da das Bildmodell im InstructIR-Framework nur 16 Millionen Parameter umfasst und es nur 100 erlernte Textprojektionsparameter gibt, kann das InstructIR-Framework problemlos auf Standard-GPUs trainiert werden, wodurch die Rechenkosten gesenkt und die Anwendbarkeit erhöht werden.

Mehrere Abbauergebnisse

Für mehrere Verschlechterungen und Multitasking-Wiederherstellungen definiert das InstructIR-Framework zwei anfängliche Setups:

- 3D für Drei-Degradations-Modelle zur Bewältigung von Degradationsproblemen wie Dehazing, Denoising und Entraining.

- 5D für fünf Degradationsmodelle zur Bewältigung von Degradationsproblemen wie Bildrauschen, Verbesserung bei schlechten Lichtverhältnissen, Dehazing, Rauschunterdrückung und Entraining.

Die Leistung von 5D-Modellen wird in der folgenden Tabelle veranschaulicht und mit modernsten Bildwiederherstellungs- und All-in-One-Modellen verglichen.

Wie zu beobachten ist, kann das InstructIR-Framework mit einem einfachen Bildmodell und nur 16 Millionen Parametern dank der anweisungsbasierten Anleitung fünf verschiedene Bildwiederherstellungsaufgaben erfolgreich bewältigen und liefert wettbewerbsfähige Ergebnisse. Die folgende Tabelle zeigt die Leistung des Frameworks an 3D-Modellen. Die Ergebnisse sind mit den obigen Ergebnissen vergleichbar.

Das wichtigste Highlight des InstructIR-Frameworks ist die anweisungsbasierte Bildwiederherstellung. Die folgende Abbildung zeigt die unglaublichen Fähigkeiten des InstructIR-Modells, eine breite Palette von Anweisungen für eine bestimmte Aufgabe zu verstehen. Außerdem führt das InstructIR-Modell für eine gegnerische Anweisung eine Identität aus, die nicht erzwungen wird.

Abschließende Überlegungen

Die Bildwiederherstellung ist ein grundlegendes Problem in der Computer Vision, da sie darauf abzielt, aus einem Bild, das Verschlechterungen aufweist, ein hochwertiges, sauberes Bild wiederherzustellen. In der Low-Level-Computer-Vision ist der Begriff „Degradations“ ein Begriff, der unangenehme Effekte beschreibt, die in einem Bild beobachtet werden, wie Bewegungsunschärfe, Dunst, Rauschen, geringer Dynamikbereich und mehr. In diesem Artikel haben wir über InstructIR gesprochen, das weltweit erste Bildwiederherstellungs-Framework, das darauf abzielt, das Bildwiederherstellungsmodell anhand von Menschen geschriebener Anweisungen zu steuern. Für Eingabeaufforderungen in natürlicher Sprache kann das InstructIR-Modell qualitativ hochwertige Bilder von ihren beeinträchtigten Gegenstücken wiederherstellen und berücksichtigt auch mehrere Verschlechterungstypen. Das InstructIR-Framework ist in der Lage, modernste Leistung für eine Vielzahl von Bildwiederherstellungsaufgaben zu liefern, darunter Bildentwässerung, Rauschunterdrückung, Dunstentfernung, Unschärfe und Bildverbesserung bei schlechten Lichtverhältnissen.