Andersonův úhel

AI Video zdokonaluje kočičí selfie

Generátory videa s umělou inteligencí často poskytují výsledky, které jsou sice blízké, ale ne zcela přesné, pokud jde o splnění požadavků textového promptu. Nová oprava na vysoké úrovni však dělá velký rozdíl.

Generativní video systémy mají často potíže s tvorbou skutečně kreativních nebo divokých videí a často nedokážou splnit očekávání uživatelů ohledně textových pokynů.

Částečně je to důvodem zapletení – skutečnost, že modely vidění/jazyka musí dělat kompromisy v tom, jak dlouho se trénují na zdrojových datech. Příliš málo trénování a koncepty jsou flexibilní, ale ne plně zformované – příliš mnoho trénování a koncepty jsou přesné, ale již nejsou dostatečně flexibilní, aby se daly začlenit do nových kombinací.

Nápad si můžete udělat z níže vloženého videa. Vlevo je druh kompromisu, který mnoho systémů umělé inteligence poskytuje v reakci na náročný výzvu (výzva je ve všech čtyřech příkladech v horní části videa), která požaduje nějaké srovnání prvků, jež je příliš fantastické na to, aby se dalo použít jako skutečný tréninkový příklad. Vpravo je výstup umělé inteligence, který se výzvy drží mnohem lépe:

Klikněte pro přehrání (bez zvuku). Vpravo vidíme „faktorizovanou“ WAN 2.2, která skutečně plní zadané pokyny, na rozdíl od vágních interpretací „vanilkové“ verze WAN 2.2 vlevo. Lepší rozlišení a mnoho dalších příkladů naleznete ve zdrojovém videu, ačkoli zde uvedené upravené verze na stránkách projektu neexistují a byly sestaveny pro tento článek. Zdroj

I když musíme odpustit tleskající kachně lidské ruce (!), je jasné, že příklady vpravo se mnohem lépe drží původního textového promptu než ty vlevo.

Je zajímavé, že obě uvedené architektury jsou v podstatě stejný architektura – populární a velmi schopná Wan 2.2, čínské vydání, které si letos získalo značnou podporu v komunitách open source a amatérů.

Rozdíl je v tom, že druhý generativní kanál je faktorizován, což v tomto případě znamená, že k přeinterpretaci prvního (základního) snímku videa byl použit model velkého jazyka programování (LLM), takže pro systém bude mnohem snazší dodat uživateli to, co požaduje.

Toto „vizuální ukotvení“ zahrnuje vložení obrázku vytvořeného z této výzvy vylepšené LLM do generativního kanálu jako „počátečního snímku“ a použití LoRA interpretační model, který pomáhá integrovat snímek „vetřelce“ do procesu tvorby videa.

Výsledky, co se týče přesnosti a přesnosti, jsou poměrně pozoruhodné, zejména u řešení, které se jeví jako poměrně elegantní:

Klikněte pro přehrání (bez zvuku). Další příklady „faktorizovaných“ generací videa, které se skutečně drží scénáře. Lepší rozlišení a mnoho dalších příkladů naleznete ve zdrojových video souborech, ačkoli zde uvedené upravené verze na stránkách projektu neexistují a byly sestaveny pro tento článek.

Toto řešení přichází v podobě nový papír Generování faktorizovaného videa: Konstrukce oddělených scén a časová syntéza v difúzních modelech převodu textu na videoa jeho doprovodné video plné Webové stránky projektu.

Zatímco mnoho současných systémů se snaží zvýšit přesnost výzev pomocí jazykových modelů k přepisování vágního nebo nedostatečně specifikovaného textu, nová práce tvrdí, že tato strategie stále vede k selhání, pokud je model... reprezentace vnitřní scény je vadný.

I s detailně přepsaným promptem modely převodu textu na video často špatně komponují klíčové prvky nebo generují nekompatibilní počáteční stavy, které narušují logiku animace. Dokud první snímek neodráží to, co prompt popisuje, výsledné video se nemůže zotavit, bez ohledu na to, jak dobrý je model pohybu.

V novinách se píše *:

Modely [převodu textu na video] často produkují snímky s distribučním posunem, a přesto dosahují [skóre hodnocení] srovnatelného s modely I2V, což naznačuje, že Jejich modelování pohybu zůstává poměrně přirozené, i když je věrnost scény relativně nízká..

Modely [obrázek-video] vykazují komplementární chování, silné [skóre hodnocení] z přesných počátečních scén a slabší časovou koherenci, zatímco I2V+text oba aspekty vyvažuje.

„Tento kontrast naznačuje strukturální nesoulad v současných modelech T2V: uzemnění scény a časová syntéza těží z odlišných induktivních zkreslení, přesto se stávající architektury pokoušejí učit se obojí současně v rámci jednoho modelu.

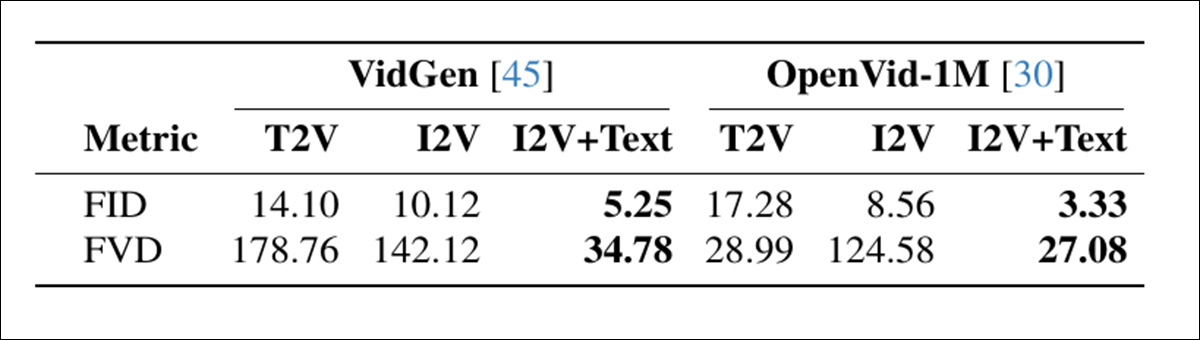

Diagnostické srovnání generačních režimů zjistilo, že modely bez explicitního ukotvení scény dosáhly dobrých výsledků v oblasti pohybu, ale často slevovaly z rozvržení scény, zatímco přístupy založené na podmíněném obrazu vykazovaly opačný vzorec:

Porovnání režimů generování videa na dvou datových sadách, které ukazuje, že I2V+text dosahuje nejlepší kvality snímků (FID) a časové koherence (FVD), a zdůrazňuje výhodu oddělení konstrukce scény od pohybu. Zdroj

Tato zjištění poukazují na strukturální vadu, kdy se současné modely snaží naučit rozvržení scény i animaci najednou, přestože tyto dva úkoly vyžadují různé druhy... indukční zkreslenía je lepší s nimi zacházet odděleně.

Asi nejzajímavější je, že tento „trik“ lze potenciálně aplikovat na lokální instalace modelů, jako jsou Wan 2.1 a 2.2, a podobných modelů pro šíření videa, jako například Hunyuan VideoPři porovnání kvality produkce pro amatéry s komerčními generativními portály, jako jsou Kling a Runway, se anekdoticky stává, že většina hlavních poskytovatelů API zlepšuje své open source nabídky, jako je WAN, s LoRA a – zdá se – s triky, jaké jsou vidět v novém článku. Tento konkrétní přístup by proto mohl představovat dohnání pro kontingent FOSS.

Testy provedené s touto metodou naznačují, že tento jednoduchý a modulární přístup nabízí nový nejmodernější postup v oblasti Benchmark T2V-CompBench, čímž se výrazně zlepšily všechny testované modely. Autoři závěrem poznamenávají, že ačkoli jejich systém radikálně zlepšuje věrnost, neřeší (ani není k tomu určen) posun identity, v současnosti prokletím výzkumu generativní umělé inteligence.

Nový článek pochází od čtyř výzkumníků z Ecole Polytechnique Fédérale de Lausanne (EPFL) ve Švýcarsku.

Metoda a data

Ústředním tvrzením nové techniky je, že difuzní modely text-to-video (T2V) musí být „ukotveny“ k počátečním snímkům, které skutečně odpovídají požadované textové výzvě.

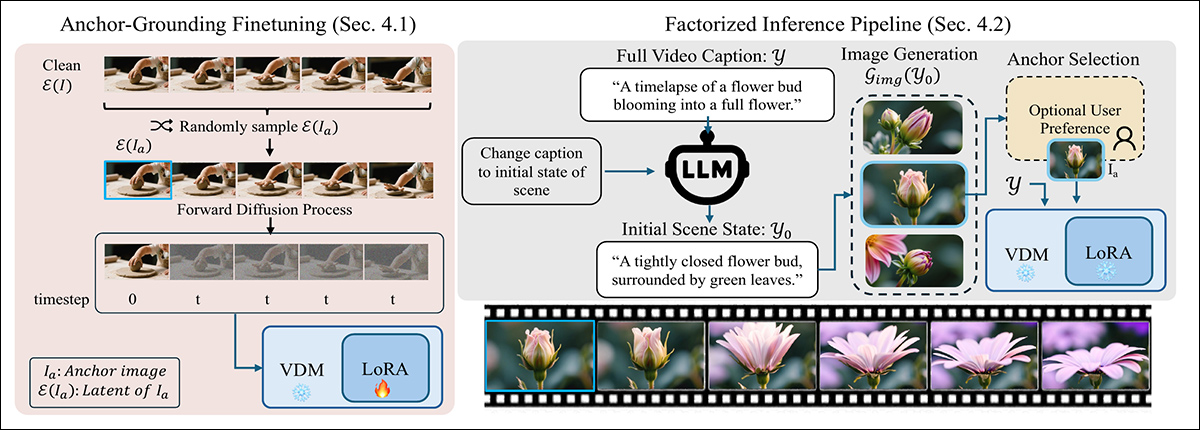

Aby model respektoval počáteční rámec, nová metoda narušuje standardní difúzní proces vstřiknutím čistého latentní z kotevního obrazu v časovém kroku nula, čímž se nahradí jeden z obvyklých zašumených vstupů. Tento neznámý vstup model zpočátku mate, ale s minimální LoRA doladění, naučí se zacházet s vstřikovaným snímkem jako s pevnou vizuální kotvou, nikoli jako se součástí trajektorie šumu:

Dvoustupňová metoda pro uzemnění generování textu na video s vizuální kotvou: Vlevo je model doladěn pomocí odlehčené LoRA, aby se vložený čistý latentní obraz považoval za pevné omezení scény. Vpravo je výzva rozdělena do titulku prvního snímku, který se používá ke generování kotevního obrázku, který vede video.

Při inferenci metoda přepíše výzvu tak, aby popsala pouze první snímek, s využitím LLM k extrakci věrohodného počátečního stavu scény se zaměřením na rozvržení a vzhled.

Tato přepsaná výzva je předána generátoru obrázků, který vytvoří kandidátský kotevní snímek (který může uživatel volitelně upřesnit). Vybraný snímek je zakódován do latentního snímku a vložen do difúzního procesu nahrazením prvního časového kroku, což umožňuje modelu generovat zbytek videa. a zároveň zůstat ukotven v původní scéně – proces, který funguje bez nutnosti změn v základní architektuře.

Proces byl testován vytvořením LoRA pro Wan2.2-14B, Wan2.1-1B, a CogVideo1.5-5BŠkolení LoRA proběhlo na hodnost z 256, na 5000 náhodně vzorkovaných klipech z UltraVideo kolekce.

Trénink trval 6000 kroků a vyžadoval 48 hodin GPU† pro Wan-1B a CogVideo-5B a 96 hodin GPU pro Wan-14B. Autoři poznamenávají, že Wan-5B nativně podporuje podmiňování pouze textu a textu s obrázkem (které je v tomto případě vnucováno starším frameworkům), a proto nevyžadoval žádné jemné ladění.

Zkoušky

V experimentech prováděných pro tento proces byla každá textová výzva zpočátku upřesněna pomocí Qwen2.5-7B-Pokyn, který na základě výsledku vygeneroval podrobný popisek „výchozího obrázku“ obsahující popis celé scény. Ten byl poté předán do QwenImage, který měl za úkol vytvořit „magický rámec“, který měl být vložen do procesu difúze.

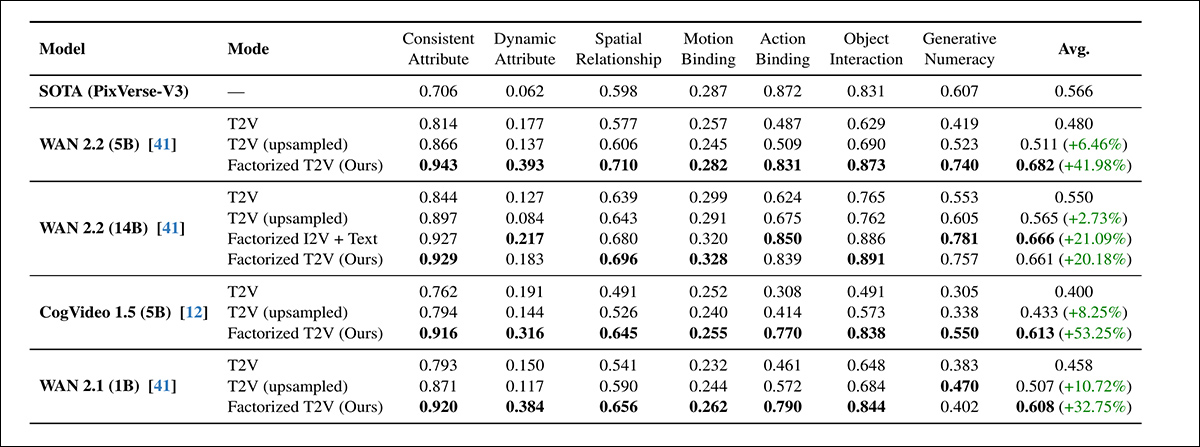

Mezi benchmarky použité k posouzení systému patřil výše zmíněný T2V-CompBench, který testoval porozumění kompozici hodnocením toho, jak dobře modely zachovaly objekty, atributy a akce v rámci koherentní scény; a VBench 2.0, pro hodnocení širšího zdůvodnění a konzistence napříč 18 metrikami, seskupenými do tvořivost, zdravý rozum, ovladatelnost, lidská věrnost, a fyzika:

Ve všech sedmi kategoriích hodnocení T2V-CompBench překonala faktorizovaná metoda T2V standardní i převzorkované základní hodnoty T2V u každého testovaného modelu, přičemž zisky dosáhly až 53.25 %. Varianty s nejvyšším skóre často odpovídaly nebo překračovaly proprietární benchmark PixVerse-V3.

Pokud jde o toto úvodní kolo testů, autoři uvádějí*:

„[Napříč] všemi modely přidání kotevního obrázku konzistentně zlepšuje kompoziční výkon. Všechny menší faktorizované modely (CogVideo 5B, Wan 5B a Wan 1B) překonávají větší model Wan 14B T2V.“

"Náš faktorizovaný Wan 5B také překonává komerční základní model PixVerse-V3, který je v benchmarku nejlépe zaznamenaným modelem. To ukazuje, že vizuální uzemnění podstatně zlepšuje pochopení scény a děje i v modelech s menší kapacitou.

„V rámci každé modelové rodiny faktorizovaná verze překonává původní model. Je pozoruhodné, že naše odlehčená LoRA s uzemněním na WAN 14B dosahuje výkonu srovnatelného s předtrénovanou variantou I2V 14B (0.661 vs. 0.666), a to i přesto, že nevyžaduje žádné úplné přetrénování.“

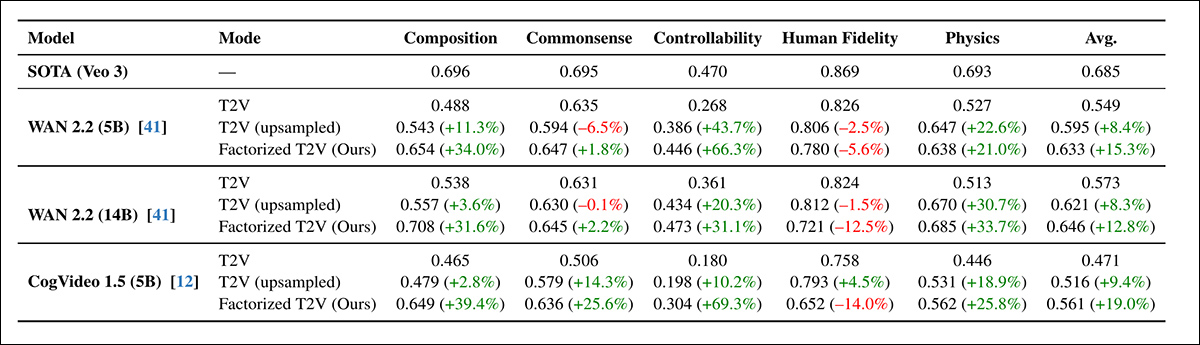

Dalším krokem bylo kolo VBench2.0:

Faktorizovaný přístup T2V konzistentně zlepšoval výkon VBench 2.0 v oblasti kompozice, logického uvažování, ovladatelnosti a fyziky, přičemž některé zisky přesahovaly 60 % – ačkoli lidská věrnost zůstala pod proprietární základní úrovní Veo 3.

Napříč všemi architekturami faktorizovaný přístup zvýšil skóre ve všech kategoriích VBench kromě lidská věrnost, který mírně poklesl i po rychlém převzorkování. WAN 5B překonal větší WAN 14B, což potvrdilo dřívější výsledky T2V-CompBench, které ukazovaly, že vizuální uzemnění přispívá více než škálování.

I když byly zisky na VBench konzistentní, byly menší než ty zaznamenané na T2V-CompBench a autoři to připisují přísnějšímu režimu binárního bodování VBench.

Pro kvalitativní testy článek poskytuje statické obrázky, ale pro jasnější představu odkazujeme čtenáře na kompozitní videa vložená do tohoto článku, s výhradou, že zdrojová videa jsou početnější a rozmanitější a mají také vyšší rozlišení a detaily. Najděte je. zdePokud jde o kvalitativní výsledky, článek uvádí:

„Ukotvená videa konzistentně vykazují přesnější kompozici scény, silnější vazbu mezi objektem a atributem a jasnější časový postup.“

Faktorizovaná metoda zůstala stabilní i po snížení počtu difúzních kroků z 50 na 15, což nevykazuje téměř žádnou ztrátu výkonu na T2V-CompBench. Naproti tomu jak textová, tak i převzorkovaná základní linie se za stejných podmínek prudce zhoršily.

Ačkoli by snížení počtu kroků teoreticky mohlo ztrojnásobit rychlost, v praxi se celý generační proces zrychlil pouze 2.1krát kvůli fixním nákladům na generování ukotvených obrazů. Výsledky však ukázaly, že ukotvení nejen zlepšilo kvalitu vzorku, ale také pomohlo stabilizovat proces difúze, což podpořilo rychlejší a efektivnější generování bez ztráty přesnosti.

Webové stránky projektu poskytují příklady generování metod s vyšším vzorkováním vs. nových, z nichž několik (s nižším rozlišením) nabízíme zde:

Klikněte pro přehrání (bez zvuku). Převzorkované výchozí zdroje vs. faktorizovaný přístup autorů.

Autoři uzavírají:

„Naše výsledky naznačují, že stejně důležité může být spíše zlepšené uzemnění než samotná zvýšená kapacita. Nedávný pokrok v difúzi T2V se silně spoléhal na rostoucí velikost modelu a trénovací data, přesto i velké modely často potíže s odvoděním koherentní počáteční scény pouze z textu.“

„To je v kontrastu s difúzí obrazu, kde je škálování relativně přímočaré; ve video modelech musí každé architektonické vylepšení fungovat v další časové dimenzi, což škálování činí podstatně náročnějším na zdroje.“

„Naše zjištění naznačují, že vylepšené uzemnění může doplnit škálování tím, že řeší jiný úzký problém: vytvoření správné scény před zahájením syntézy pohybu.“

„Začleněním generování videa do kompozice scény a časového modelování zmírňujeme několik běžných poruchových režimů, aniž bychom vyžadovali podstatně větší modely. Vnímáme to jako doplňkový princip návrhu, který může vést budoucí architektury k spolehlivější a strukturovanější syntéze videa.“

Proč investovat do čističky vzduchu?

Ačkoli jsou problémy s provázáním velmi reálné a mohou vyžadovat specializovaná řešení (jako je vylepšené kurování a distribuční hodnocení před trénováním), bylo pro nás poučné sledovat, jak faktorizace „odděluje“ několik tvrdohlavých a „zaseknutých“ konceptů od orchestrací do mnohem přesnějších renderů – pouze s mírnou vrstvou LoRA podmiňování a zásahem výrazně vylepšeného počátečního/základního obrazu.

Rozdíl ve zdrojích mezi lokálními amatérskými řešeními a komerčními řešeními nemusí být tak obrovský, jak se předpokládá, vzhledem k tomu, že téměř všichni poskytovatelé se snaží racionalizovat své značné výdaje na zdroje GPU pro spotřebitele.

Podle neoficiálních informací velmi velký počet současných poskytovatelů generativního videa používá značkové a obecně „vylepšené“ verze čínských modelů FOSS. Hlavním „nevýhodou“ těchto „zprostředkovatelských“ systémů je, že si daly práci s trénováním LoRA, nebo – za vyšší náklady a o něco větší odměnu – provedly úplné doladění vah modelů.††.

Poznatky tohoto druhu by mohly pomoci tuto mezeru dále překlenout v kontextu scény s vydáváním produktů, kde se Číňané zdají být odhodláni (ne nutně z altruistických nebo idealistických důvodů) demokratizovat generaci umělé inteligence, zatímco západní obchodní zájmy by možná preferovaly, aby rostoucí velikost modelu a regulace nakonec uzavřely jakékoli skutečně dobré modely za API a více vrstev obsahových filtrů.

* Důrazy autorů, ne moje.

† Článek neuvádí, která grafická karta byla vybrána ani kolik jich bylo použito.

†† Ačkoli je cesta LoRA pravděpodobnější, a to jak z ekonomického hlediska, tak i proto, že se jedná o plné váhy, spíše než kvantován závaží nejsou vždy k dispozici.

Poprvé publikováno v pátek 19. prosince 2025