Andersonův úhel

Přidávání dialogů do skutečného videa pomocí umělé inteligence

Nový systém umělé inteligence dokáže přepsat, odstranit nebo přidat slova osoby ve videu bez nutnosti opětovného natáčení, a to v rámci jediného komplexního systému.

Před třemi lety by internet ohromil kterýkoli z 20–30 frameworků pro úpravu videa s využitím umělé inteligence, které se každý týden zveřejňují na akademických portálech; v současnosti se tento populární směr výzkumu stal tak plodným, že téměř tvoří další větev „AI Slopu“, a já se věnuji mnohem menšímu počtu takových publikací než před dvěma nebo třemi lety.

Jedna aktuální verze v této řadě mě však zaujala: integrovaný systém, který dokáže zasahovat do skutečných videoklipů a vkládat novou řeč do existujícího videa (místo vytváření celého generativního klipu z obličeje nebo záběru, což je mnohem běžnější).

V níže uvedených příkladech, které jsem sestříhal z mnoha ukázkových videí dostupných v době vydání Webové stránky projektu, nejprve vidíme skutečný zdrojový klip a poté pod ním vložený projev umělé inteligence uprostřed klipu, včetně hlasové syntézy a synchronizace rtů:

Klepnutím přehrajte. Lokální editace se sešíváním – jedna z několika modalit nabízených službou FacEDiT. Lepší rozlišení naleznete na webových stránkách zdroje. Zdroj – https://facedit.github.io/

Tento přístup je jeden ze tří vyvinutých pro novou metodu, tento s názvem „lokální editace se spojováním“ a ten, který nejvíce zajímá autory (stejně jako mě). Klip je v podstatě rozšířen o použití jednoho ze prostředních snímků jako výchozího bodu pro novou interpretaci umělé inteligence a jeho následného (skutečného) snímku jako cíle, ke kterému by se měl generativně vložený klip snažit přizpůsobit. Ve výše uvedených klipech jsou tyto „počáteční“ a „cílové“ snímky reprezentovány nejvyšším pozastaveným videem, zatímco upravené video níže poskytuje generativní výplň.

Autoři tento přístup k syntéze obličeje a hlasu chápou jako první plně integrovanou end-to-end metodu pro AI video střihy tohoto druhu a pozorují potenciál plně vyvinutého frameworku, jako je tento, pro televizní a filmovou produkci:

„Filmaři a mediální producenti často potřebují revidovat určité části nahraných videí – třeba se stalo, že došlo k chybě v proneseném slově nebo se scénář po natáčení změnil. Například v ikonické scéně z…“ Titánský (1997), kde Rose říká, „Nikdy tě nepustím, Jacku,“ režisér by se mohl později rozhodnout, že by to tak mělo být „Nikdy na tebe nezapomenu, Jacku“.

„Tradičně takové změny vyžadují přetáčení celé scény, což je nákladné a časově náročné. Syntéza mluvících obličejů nabízí praktickou alternativu tím, že automaticky upravuje pohyb obličeje tak, aby odpovídal revidované řeči, čímž eliminuje potřebu přetáčení.“

Ačkoli se interpozice umělé inteligence tohoto druhu mohou setkat kulturní nebo odpor průmyslu, mohou také představovat nový typ funkcionality v systémech a sadách nástrojů pro vizuální efekty řízených člověkem. V každém případě jsou prozatím výzvy čistě technické.

Kromě rozšíření klipu o další dialogy generované umělou inteligencí dokáže nový systém také změnit existující řeč:

Klepnutím přehrajte. Příklad změny stávajícího dialogu namísto vložení dalšího dialogu. Lepší rozlišení naleznete na webových stránkách zdroje.

Stav techniky

V současné době neexistují žádné komplexní systémy, které by tento druh syntézy nabízely; ačkoli rostoucí počet generativních platforem umělé inteligence, jako jsou například platformy od Googlu, Řada Veo, může generovat zvuk a různé další frameworky mohou vytvářet hlubokoparodovaný zvuk, je v současné době nutné vytvořit poměrně složitý systém rozmanitých architektur a triků, aby se do skutečných záběrů zasahovalo tak, jak to dělá nový systém – s názvem FaceEDiT – dokáže to splnit.

Systém využívá Difuzní transformátory (DiT) v kombinaci s Flow Matching vytvářet pohyby obličeje podmíněné okolními (kontextovými) pohyby a řečovým zvukovým obsahem. Systém využívá stávající populární balíčky, které se zabývají rekonstrukcí obličeje, včetně Živý portrét (nedávno převzala společnost Kling).

Kromě této metody, vzhledem k tomu, že jejich přístup je prvním, který integruje tyto výzvy do jednoho řešení, autoři vytvořili nový benchmark s názvem FaceEDiTBench, spolu s několika zcela novými hodnotícími metrikami vhodnými pro tento velmi specifický úkol.

Jedno nová práce je s názvem FacEDiT: Sjednocená editace a generování mluvících obličejů pomocí vyplňování pohybem obličejea pochází od čtyř výzkumníků z korejské Pohangské univerzity vědy a technologie (POSTECH), Korejského pokročilého institutu vědy a technologie (KAIST) a Texaské univerzity v Austinu.

Metoda

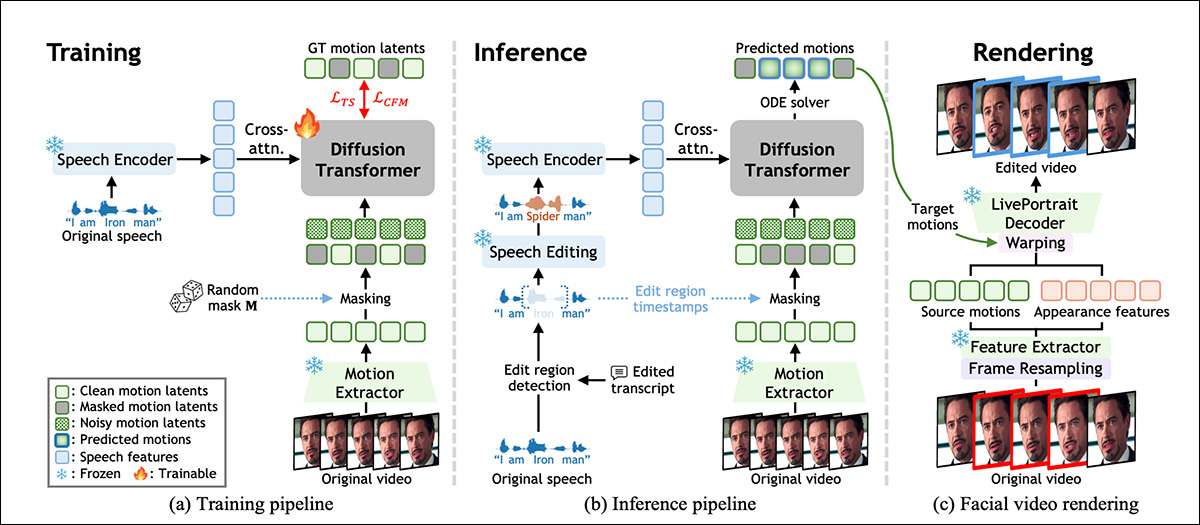

FacEDiT je trénován k rekonstrukci pohybů obličeje tím, že se učí, jak doplnit chybějící části původního hercova výkonu na základě okolního pohybu a zvuku řeči. Jak je znázorněno na níže uvedeném schématu, tento proces umožňuje modelu fungovat jako vyplňovač mezer během trénování a predikovat pohyby obličeje, které odpovídají hlasu, a zároveň zůstávají konzistentní s původním videem:

Přehled systému FacEDiT, ukazující, jak se pohyby obličeje učí pomocí samokontrolovaného doplňování během tréninku, řízeného upravenou řečí při inferenci a nakonec se renderují zpět do videa opětovným použitím vzhledu původního záznamu, přičemž se nahrazuje pouze cílený pohyb. Zdroj

V době inference stejná architektura podporuje dva různé výstupy v závislosti na tom, jak velká část videa je maskována: částečné úpravy, kdy se změní pouze fráze a zbytek zůstane nedotčen; nebo generování celých vět, kdy se nový pohyb syntetizuje zcela od nuly.

Model je trénován pomocí přizpůsobení průtoku, který zachází s úpravami videa jako s jakousi cestou mezi dvěma verzemi pohybu obličeje.

Místo učení se od nuly odhadovat, jak by měl upravený obličej vypadat, se flow matching učí postupně a plynule přecházet mezi zašuměným zástupným symbolem a správným pohybem. Aby to systém usnadnilo, reprezentuje pohyb obličeje jako kompaktní sadu čísel extrahovaných z každého snímku pomocí verze výše zmíněného systému LivePortrait (viz schéma výše).

Tyto pohybové vektory jsou navrženy tak, aby popisovaly výrazy a polohu hlavy bez zapletení identitu, aby změny řeči mohly být lokalizovány, aniž by to ovlivnilo celkový vzhled dané osoby.

Školení FaceEDiT

Pro trénování FacEDiT byl každý videoklip rozdělen do série snímků pohybu obličeje a každý snímek byl spárován s odpovídajícím blokem zvuku. Náhodné části dat o pohybu byly poté skryty a model byl požádán, aby uhodl, jak by tyto chybějící pohyby měly vypadat, s využitím jak řeči, tak okolního nemaskovaného pohybu pro kontext.

Protože se maskované rozsahy a jejich pozice liší od jednoho trénovacího příkladu k druhému, model se postupně učí, jak zpracovávat jak malé interní úpravy, tak delší mezery pro generování celé sekvence, v závislosti na tom, kolik informací je mu poskytnuto.

Výše zmíněný difuzní transformátor systému se učí obnovovat maskovaný pohyb zdokonalováním šumových vstupů v průběhu času. Místo současného přivádění řeči a pohybu do modelu je zvuk propojen do každého bloku zpracování prostřednictvím... křížová pozornost, což pomáhá systému přesněji přizpůsobit pohyby rtů zvukové řeči.

Aby se zachoval realismus napříč úpravami, pozornost je zaměřena na sousední snímky, nikoli na celou časovou osu, což nutí model soustředit se na lokální kontinuitu a zabraňuje blikání nebo skokům v pohybu na okrajích změněných oblastí. Poziční vnoření (která modelu sdělují, kde se každý snímek v sekvenci objevuje) dále pomáhají modelu zachovat přirozený časový tok a kontext.

Během trénování se systém učí předpovídat chybějící pohyby obličeje rekonstrukcí maskovaných úseků na základě řeči a blízkého nemaskovaného pohybu. V době inference se toto nastavení znovu použije, ale masky jsou nyní řízeny úpravami v řeči.

Když je vloženo, odebráno nebo změněno slovo nebo fráze, systém vyhledá postiženou oblast, maskuje ji a regeneruje pohyb, který odpovídá novému zvuku. Generování plné sekvence je považováno za speciální případ, kdy je celá oblast maskována a syntetizována od nuly.

Data a testy

Páteř systému se skládá z 22 vrstev pro difuzní transformátor, každá s 16 pozornost hlavy a dopředné rozměry 1024 a 2024 pixelů. Pohybové a vzhledové prvky jsou extrahovány pomocí zmrazené komponenty LivePortrait a řeč kódovaná pomocí WavLM a upravené pomocí VoiceCraft.

Vyhrazená projekční vrstva mapuje 786rozměrné řečové prvky do latentního prostoru DiT, přičemž od nuly jsou trénovány pouze moduly DiT a projekční moduly.

Školení probíhalo v rámci AdamW optimalizátor s cílovou rychlostí učení 1e-4, pro milion kroků, na dvou grafických procesorech A6000 (každý se 48 GB VRAM), celkem objem várky z osmi.

FaceEDiTBench

Datová sada FacEDiTBench obsahuje 250 příkladů, každý s videoklipem původního a upraveného projevu a přepisy obou. Videa pocházejí ze tří zdrojů, přičemž 100 klipů z… HDTF, 100 od Ahoj 3a 50 od CelebV-DubKaždý byl ručně zkontrolován, aby se potvrdilo, že zvuk i video jsou dostatečně čisté pro vyhodnocení.

GPT‑4o byl použit k revizi každého přepisu za účelem vytvoření gramaticky platných úprav. Tyto revidované přepisy byly spolu s původní řečí odeslány do VoiceCraftu za účelem vytvoření nového zvuku; a v každé fázi byla ručně zkontrolována kvalita přepisu i vygenerované řeči.

Každý vzorek byl označen typem úpravy, načasováním změny a délkou upraveného rozsahu a úpravy byly klasifikovány jako inzerce, delecenebo substitucíPočet změněných slov se pohyboval od krátkých úprav o 1 až 3 slovech, přes střední úpravy o 4 až 6 slovech až po delší úpravy o 7 až 10 slovech.

Pro vyhodnocení kvality úprav byly definovány tři vlastní metriky. Fotometrická kontinuita, k měření toho, jak dobře se osvětlení a barva upraveného segmentu prolínají s okolním videem, porovnáním rozdílů na úrovni pixelů na hranicích; kontinuita pohybu, posoudit konzistenci pohybu obličeje měřením změn optického toku napříč upravenými a neupravenými snímky; a zachování identity, odhadnout, zda vzhled subjektu zůstává po úpravě konzistentní, porovnáním vložení obličeje z původní a generované sekvence pomocí ArcFace model rozpoznávání obličeje.

Zkoušky

Testovací model byl trénován na materiálu ze tří výše zmíněných datových sad, celkem přibližně 200 hodin video obsahu, včetně vlogov a filmů, a také videí z YouTube ve vysokém rozlišení.

Pro vyhodnocení úpravy mluvících obličejů byl použit FacEDiTBench, a to kromě testovacího rozdělení HDTF, které se stalo benchmarkovým standardem pro tuto sadu úloh.

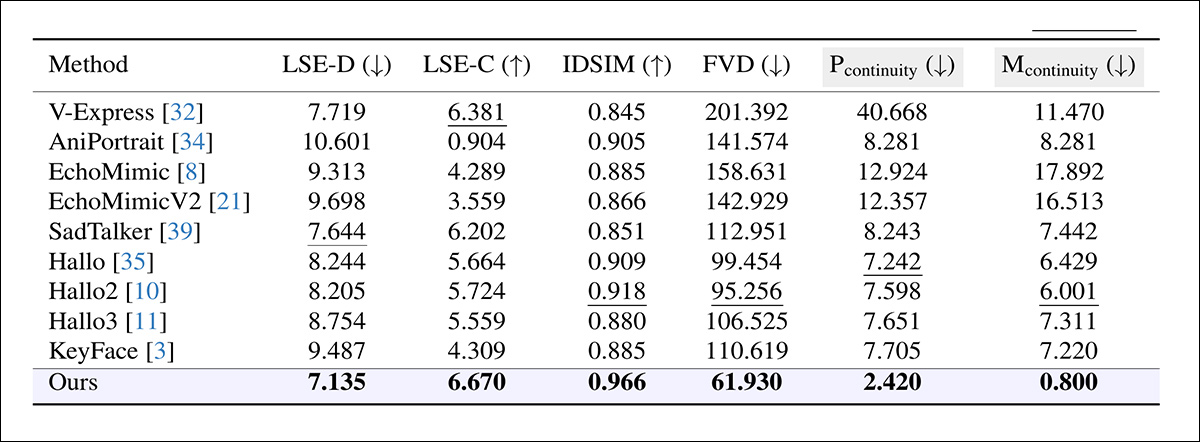

Protože neexistovaly žádné přímo srovnatelné systémy schopné zapouzdřit tento druh komplexní funkcionality, autoři zvolili řadu frameworků, které reprodukovaly alespoň část cílové funkcionality a mohly by fungovat jako základní systémy; konkrétně: KeyFace; EchoMimic; EchoMimicV2; Ahoj; Ahoj 2; Ahoj 3; V-Express; AniPortraitA SadTalker.

K posouzení kvality generace a střihu bylo také použito několik zavedených metrik, přičemž přesnost synchronizace rtů byla hodnocena pomocí SyncNet, přičemž se uvádí jak absolutní chyba mezi pohyby rtů a zvukem (LSE-D), tak skóre spolehlivosti (LSE-C); Frechet Video Vzdálenost (FVD) kvantifikace toho, jak realisticky video celkově působilo; a Naučené metriky vjemové podobnosti (LPIPS), měření percepční podobnosti mezi generovanými a původními snímky.

Pro editaci byly všechny metriky kromě LPIPS aplikovány pouze na upravený segment; pro generování bylo vyhodnoceno celé video s vyloučením hraniční kontinuity.

Každý model byl vytvořen tak, aby syntetizoval odpovídající video segment, který byl následně vložen do původního klipu (vědci poznamenávají, že tato metoda často způsobovala viditelné nespojitosti, kdy se upravená část setkávala s okolním záběrem). Testován byl také druhý přístup, kdy bylo celé video regenerováno z upraveného zvuku – to však nevyhnutelně přepsalo neupravené oblasti a nepodařilo se zachovat původní výkon:

Porovnání výkonu editace napříč systémy původně navrženými pro generování mluvících obličejů, přičemž FacEDiT překonal všechny základní úrovně ve všech metrikách, dosáhl nižší chyby synchronizace rtů (LSE-D), vyšší spolehlivosti synchronizace (LSE-C), lepšího zachování identity (IDSIM), většího percepčního realismu (FVD) a plynulejších přechodů mezi hranicemi editace (Pcontinuity, Mcontinuity). Šedě stínované sloupce zvýrazňují klíčová kritéria pro posouzení kvality hranic; tučné a podtržené hodnoty označují nejlepší a druhý nejlepší výsledek.

K těmto výsledkům autoři komentují:

„[Náš] model výrazně překonává stávající metody v oblasti střihu. Dosahuje silné kontinuity hranic a vysokého zachování identity, což dokazuje jeho schopnost udržovat časovou a vizuální konzistenci během střihu. Jeho vynikající přesnost synchronizace rtů a nízká FVD navíc odrážejí realismus syntetizovaného videa.“

Klepnutím přehrajte. Výsledky, sestavené tímto autorem z videí publikovaných na stránkách podpůrného projektu. Lepší rozlišení naleznete na webových stránkách zdroje.

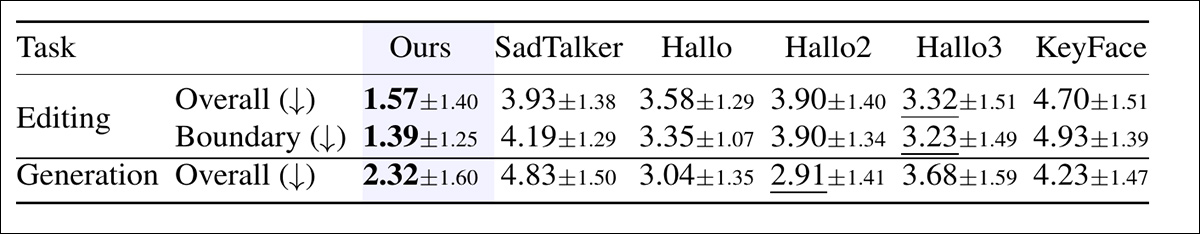

Dále byla provedena studie na lidech, která měla vyhodnotit vnímanou kvalitu jak při editaci, tak při generování.

Pro každé srovnání si účastníci prohlédli šest videí a seřadili je podle celkové kvality, přičemž zohledňovali přesnost synchronizace rtů, přirozenost a realismus pohybu hlavy. V testech střihu účastníci také hodnotili plynulost přechodů mezi upravenými a neupravenými segmenty:

Průměrná hodnocení přiřazovaná lidskými hodnotiteli, kde nižší znamená lepší. Jak při střihu, tak při generování videa účastníci hodnotili, jak přirozeně a dobře synchronizovaně každé video vypadalo. U střihu také hodnotili, jak plynulý byl přechod mezi střiženým a neupraveným projevem. Tučná a podtržená čísla označují dvě nejvyšší skóre.

Ve studii byl FacEDiT konzistentně hodnocen s jasným náskokem, a to jak v kvalitě střihu, tak v plynulosti přechodů, a silné skóre získal i v nastavení generování, což naznačuje, že jeho naměřené výhody se promítají do percepčně preferovaných výstupů.

Vzhledem k nedostatku místa odkazujeme čtenáře na zdrojový článek, kde se dozvíte více o ablačních studiích a dalších testech, které byly provedeny a publikovány v nové práci. Ve skutečnosti prototypové výzkumné nabídky tohoto druhu jen stěží generují smysluplné sekce s výsledky testů, protože samotná základní nabídka je nevyhnutelně potenciálním výchozím bodem pro pozdější práci.

Proč investovat do čističky vzduchu?

I pro inferenci mohou takové systémy vyžadovat značné výpočetní zdroje v době inference, což následným uživatelům – zde pravděpodobně vizuálním efektovým studio – ztěžuje udržování práce v místních podmínkách. Proto budou poskytovatelé, kteří jsou ze zákona povinni chránit záběry a obecné duševní vlastnictví klienta, vždy preferovat přístupy, které lze přizpůsobit realistickým místním zdrojům.

Tím nechci kritizovat novou nabídku, která by docela dobře mohla fungovat perfektně s kvantovanými váhami nebo jinými optimalizacemi a která je první nabídkou svého druhu, která mě po delší době znovu přitahuje k tomuto směru výzkumu.

Poprvé publikováno ve středu 17. prosince 202. Upraveno 20.10 EET, téhož dne, kvůli uvolnění místa v prvním odstavci textu.