Штучний Інтелект

UniTune: Альтернативна техніка нейронного редагування зображень Google

Google Research, здається, атакує редагування зображень на основі тексту з кількох фронтів і, ймовірно, чекає, щоб побачити, що «прийме». По гарячих слідах випуску цього тижня Ілюстрований папір, пошуковий гігант запропонував додатковий метод на основі прихованої дифузії для виконання інакше неможливих редагувань зображень на основі ШІ за допомогою текстових команд, цього разу під назвою UniTune.

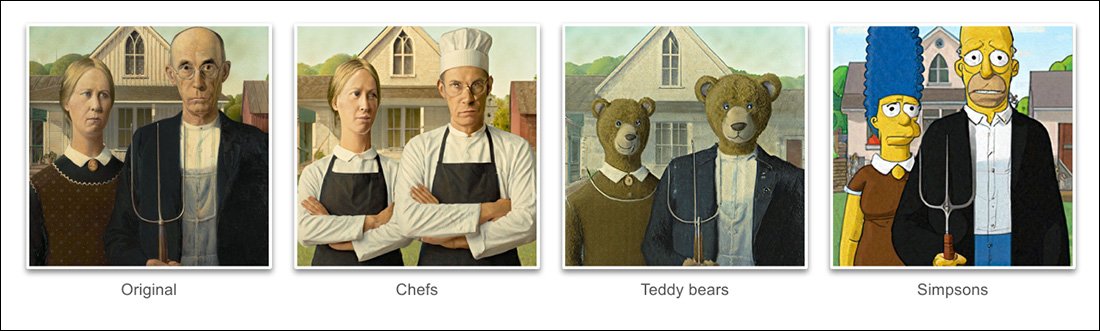

На основі прикладів, наведених у проекті новий папір, UniTune досягла надзвичайного рівня розплутування семантичної пози та ідеї з фактичного жорсткого вмісту зображення:

Команда UniTune щодо семантичної композиції є видатною. Зверніть увагу, як у самому верхньому рядку зображень обличчя двох людей не були спотворені надзвичайною трансформацією на решті вихідного зображення (праворуч). Джерело: https://arxiv.org/pdf/2210.09477.pdf

Як шанувальники Stable Diffusion уже зрозуміли, застосування редагувань до часткових частин зображення без негативного впливу на решту зображення може бути складною, іноді неможливою операцією. Хоча такі популярні дистрибутиви, як АВТОМАТИЧНИЙ1111 може створювати маски для локальних і обмежених редагувань, процес звивистий і часто непередбачуваний.

Очевидна відповідь, принаймні для практикуючого комп’ютерного зору, полягає в тому, щоб вставити шар семантична сегментація який здатний розпізнавати та виокремлювати об’єкти на зображенні без втручання користувача, і справді, останнім часом з’явилося кілька нових ініціатив у цьому напрямку.

Інший можливість для блокування безладних і заплутаних нейронних операцій редагування зображень полягає в тому, щоб використовувати впливовий OpenAI Contrastive Language–Image Pre-training (CLIP), який лежить в основі моделей прихованої дифузії, таких як DALL-E 2 і Stable Diffusion, щоб діяти як фільтр у точці, коли модель тексту в зображення готова надіслати інтерпретований рендер назад користувачеві. . У цьому контексті CLIP має діяти як дозорний модуль і модуль контролю якості, відкидаючи неправильно сформовані або іншим чином непридатні рендери. Це збираються запровадити (Посилання на Discord) на порталі DreamStudio, керованому API Stability.ai.

Однак, оскільки CLIP, можливо, є і винуватцем, і рішенням у такому сценарії (оскільки він, по суті, також інформував про те, як розвивалося зображення), і оскільки вимоги до апаратного забезпечення можуть перевищувати те, що, ймовірно, буде локально доступним для кінцевого користувача, цей підхід може бути не ідеальним.

Стиснута мова

Запропонований UniTune натомість «точне налаштовує» існуючу модель дифузії – у цьому випадку це власний Imagen від Google, хоча дослідники стверджують, що метод сумісний з іншими архітектурами латентної дифузії – так що в неї вводиться унікальний маркер, який можна викликати включивши його в текстову підказку.

За номіналом це звучить як Google будка мрій, наразі одержимість шанувальників і розробників Stable Diffusion, яка може вставляти нових персонажів або об’єкти в існуючу контрольну точку, часто менш ніж за годину, на основі лише кількох вихідних зображень; або ще як Текстова інверсія, який створює файли «побічної коляски» для контрольної точки, які потім обробляються так, ніби вони спочатку були навчені в моделі, і може скористатися перевагами власних величезних ресурсів моделі, модифікувавши її текстовий класифікатор, що призведе до крихітного файлу (порівняно з скорочені контрольні точки DreamBooth мінімум 2 ГБ).

Фактично, стверджують дослідники, UniTune відкинула обидва ці підходи. Вони виявили, що Textual Inversion пропускає занадто багато важливих деталей, тоді як DreamBooth "працював гірше та займав більше часу" ніж рішення, на якому вони врешті зупинилися.

Незважаючи на це, UniTune використовує той самий інкапсульований семантичний підхід «метапідказки», що й DreamBooth, із навченими змінами, викликаними унікальними словами, вибраними тренером, які не суперечитимуть жодним термінам, які зараз існують у старанно навченій моделі публічного випуску.

«Щоб виконати операцію редагування, ми вибираємо налаштовані моделі за допомогою підказки «[rare_tokens] edit_prompt» (наприклад, «beikkpic two dogs in a restaurant» або «beikkpic a minion»).'

процес

Хоча дивно, чому два майже ідентичні документи, з точки зору їхньої кінцевої функціональності, повинні надійти від Google протягом одного тижня, незважаючи на величезну кількість подібностей між двома ініціативами, є принаймні одна чітка відмінність між UniTune та Imagic – останній використовує «нестиснуті» підказки природної мови для керування операціями редагування зображень, тоді як UniTune навчається на унікальних маркерах стилю DreamBooth.

Тому, якщо ви редагували за допомогою Imagic і бажали здійснити таку трансформацію...

Зі статті UniTune – UniTune протиставляє себе улюбленій конкурентній системі нейронного редагування Google SDEdit. Результати UniTune розташовані праворуч, тоді як розрахункова маска показана на другому зображенні зліва.

.. в Imagic ви б ввели "третя особа, яка сидить на задньому плані, у вигляді милого пухнастого монстра".

Еквівалентною командою UniTune буде «Хлопець ззаду як [x]», Де x це будь-яке дивне та унікальне слово, пов’язане з тонко навченою концепцією, пов’язаною з персонажем пухнастого монстра.

У той час як низка зображень подається або в DreamBooth, або в Textual Inversion з метою створення абстракції у стилі deepfake, якій можна керувати у багатьох позах, і UniTune, і Imagic натомість подають одне зображення в систему – оригінальне, незаймане зображення.

Це схоже на те, як працювали багато інструментів редагування GAN за останні кілька років – шляхом перетворення вхідного зображення на латентні коди в латентному просторі GAN, а потім звертання до цих кодів і надсилання їх до інших частин латентного простору. простір для модифікації (тобто введення зображення молодої темноволосої людини та проектування його через приховані коди, пов’язані зі «старим» або «блондином» тощо).

Однак результати в дифузійній моделі та за цим методом досить точні у порівнянні та набагато менш неоднозначні:

Процес тонкого налаштування

Метод UniTune по суті надсилає оригінальне зображення через дифузійну модель із набором інструкцій щодо того, як його слід модифікувати, використовуючи величезні сховища доступних даних, навчених у моделі. По суті, ви можете зробити це прямо зараз за допомогою Stable Diffusion img2img функціональність – але не без деформації або певним чином змінивши частини зображення, які ви бажаєте зберегти.

Під час процесу UniTune система є тонка настройкаd, що означає, що UniTune змушує модель відновити навчання, при цьому більшість її шарів розморожено (див. нижче). У більшості випадків тонке налаштування призведе до цілі загальний значення втрат важко здобутої високоефективної моделі на користь впровадження або вдосконалення якогось іншого аспекту, який бажано створити або покращити.

Однак з UniTune здається, що копія моделі, з якою працювали, хоча вона може важити кілька гігабайт або більше, розглядатиметься як одноразова допоміжна «лушпиння» та буде відкинута наприкінці процесу, виконавши одну мету. Такий випадковий обсяг даних стає повсякденною проблемою для шанувальників DreamBooth, чиї власні моделі, навіть якщо їх скоротити, мають не менше 2 ГБ на тему.

Як і в Imagic, основне налаштування в UniTune відбувається на двох нижніх із трьох шарів у Imagen (база 64 пікселя, 64 пікселя > 256 пікселів і 256 пікселів > 1024 пікселя). На відміну від Imagic, дослідники бачать певну потенційну цінність в оптимізації налаштування також для цього останнього та найбільшого шару з надвисокою роздільною здатністю (хоча вони ще не намагалися це зробити).

Для найнижчого шару розміром 64 пікселя модель зміщується до базового зображення під час навчання, із кількома дубльованими парами зображення/тексту, що подаються в систему протягом 128 ітерацій із розміром пакету 4 і з Адафактор як функція втрат, що працює зі швидкістю навчання 0.0001. Хоча Т5 кодер лише зависає під час цього тонкого налаштування, воно також зависає під час первинного навчання Imagen

Потім описану вище операцію повторюють для шару 64>256 пікселів, використовуючи ту саму процедуру посилення шуму, яка використовувалася в оригінальному навчанні Imagen.

Вибірка

Існує багато можливих методів вибірки, за допомогою яких можна отримати внесені зміни з точно налаштованої моделі, включно з настановами без використання класифікатора (CFG), також є основою стабільної дифузії. CFG в основному визначає ступінь, до якого модель вільна «слідувати своїй уяві» та досліджувати можливості рендерингу – або ж, за нижчих налаштувань, ступінь, до якого вона повинна відповідати вхідним джерелом даних і вносити менш масштабні чи різкі зміни .

Подібно до текстової інверсії (трохи менше з DreamBooth), UniTune здатний застосовувати різні графічні стилі до оригінальних зображень, а також більш фотореалістичні редагування.

Дослідники також експериментували з SDEditТехніка «пізнього старту», коли система заохочується зберігати оригінальні деталі, будучи лише частково «шумовими» з самого початку, але радше зберігаючи свої основні характеристики. Хоча дослідники використовували це лише на найнижчому з шарів (64 пікселя), вони вважають, що це може бути корисною додатковою технікою вибірки в майбутньому.

Дослідники також експлуатували підказка до підказки як додаткова текстова техніка для кондиціонування моделі:

«У налаштуваннях «від підказки до підказки» ми виявили, що техніка, яку ми називаємо «Швидка підказка», особливо корисна для налаштування точності та виразності.

«Підказка схожа на безкоштовну підказку класифікатора, за винятком того, що базова лінія є іншою підказкою замість безумовної моделі. Це спрямовує модель до дельти між двома підказками.'

Проте швидке керівництво, як стверджують автори, було потрібне лише зрідка у випадках, коли CFG не досягало бажаного результату.

Іншим новим підходом до вибірки, який зустрівся під час розробки UniTune, був інтерполяція, де ділянки зображення достатньо чіткі, що оригінальне та змінене зображення дуже схожі за композицією, що дозволяє використовувати більш «наївну» інтерполяцію.

Інтерполяція може зробити надлишковими процеси UniTune, які потребують більших зусиль, у випадках, коли області, які потрібно трансформувати, є дискретними та добре окресленими.

Автори припускають, що інтерполяція потенційно може працювати настільки добре для великої кількості цільових вихідних зображень, що її можна використовувати як параметр за замовчуванням, і також відзначають, що вона має силу здійснювати надзвичайні трансформації у випадках, коли складні оклюзії не працюють. необхідно вести переговори більш інтенсивними методами.

UniTune може виконувати локальні редагування з масками редагування або без них, але також може в односторонньому порядку вирішувати, де розташувати редагування, завдяки незвичайній комбінації можливостей інтерпретації та надійної інтерпретації вихідних вхідних даних:

На самому верхньому зображенні у другому стовпці UniTune, якому доручено вставити «червоний потяг на задньому плані», розташував його у відповідному та автентичному місці. Зверніть увагу на інші приклади, як зберігається семантична цілісність вихідного зображення навіть посеред надзвичайних змін у вмісті пікселів і основних стилях зображень.

Затримка

Хоча перша ітерація будь-якої нової системи буде повільною, і хоча можливо, що або участь спільноти, або корпоративні зобов’язання (зазвичай це не те й інше) зрештою пришвидшать і оптимізують ресурсомістку процедуру, і UniTune, і Imagic виконують деякі досить значні маневри машинного навчання, щоб створити ці дивовижні редагування, і сумнівно, наскільки такий ресурсоємний процес можна було б зменшити до домашнього використання, а не до доступу, керованого API (хоча останній може бути більш бажаним для Google ).

На даний момент шлях від введення до результату займає приблизно 3 хвилини на графічному процесорі T4 з додатковими приблизно 30 секундами для висновків (відповідно до будь-якої процедури висновку). Автори визнають, що це висока затримка, і це навряд чи можна кваліфікувати як «інтерактивне», але вони також зауважують, що модель залишається доступною для подальших редагувань після початкового налаштування, доки користувач не завершить процес, що скорочує час редагування. .

Вперше опубліковано 21 жовтня 2022 р.