Штучний Інтелект

Розплутування — це наступна революція Deepfake

Розширення даних CGI використовується в новому проекті, щоб отримати більший контроль над зображеннями deepfake. Хоча ви все ще не можете ефективно використовувати CGI-голови, щоб заповнити відсутні прогалини в наборах даних про обличчя deepfake, нова хвиля досліджень роз’єднання ідентичності з контексту означає, що незабаром вам, можливо, не доведеться цього робити.

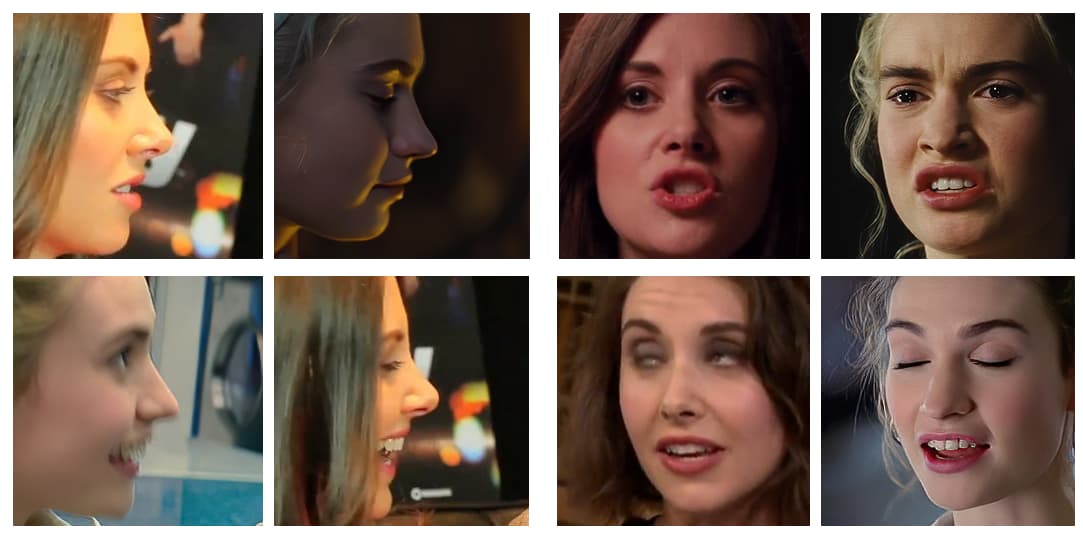

Творці деяких із найуспішніших вірусних дипфейкових відео за останні кілька років дуже ретельно відбирають вихідні відео, уникаючи постійних знімків у профілі (тобто таких знімків збоку, які популяризують процедури арешту поліцією), гострих кутів і незвичайних або перебільшених виразів. . Все частіше демонстраційні відео, створені вірусними дипфейкерами, є відредагованими компіляціями, які вибирають «найпростіші» ракурси та вирази для дипфейку.

Насправді, найкраще цільове відео, у яке можна вставити підроблену знаменитість, це те, де оригінальна особа (чию особу буде стерто підробкою) дивиться прямо в камеру з мінімальною кількістю виразів.

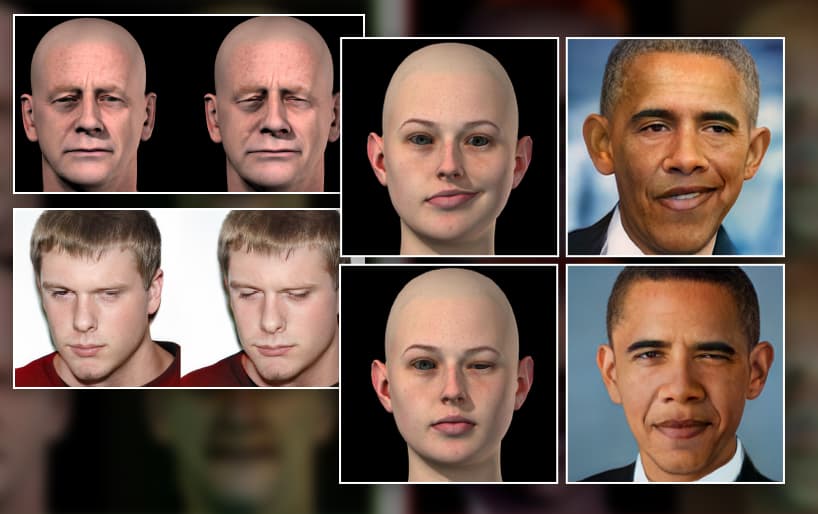

У більшості популярних дипфейків останніх років об’єкти зображені прямо перед камерою та мають лише популярні вирази (наприклад, посмішку), які можна легко витягти з матеріалів папараці на червоній доріжці, або (як у випадку з фейком Сильвестра Сталлоне 2019 року). як Термінатор, зображений ліворуч), в ідеалі взагалі без виразів, оскільки нейтральні вирази надзвичайно поширені, тому їх легко включати в моделі deepfake.

Оскільки технології deepfake, такі як DeepFaceLab та Заміна обличчя виконувати ці простіші обміни дуже добре, ми настільки вражені їхніми досягненнями, щоб не помічати, на що вони нездатні, і – часто – навіть не намагаємось:

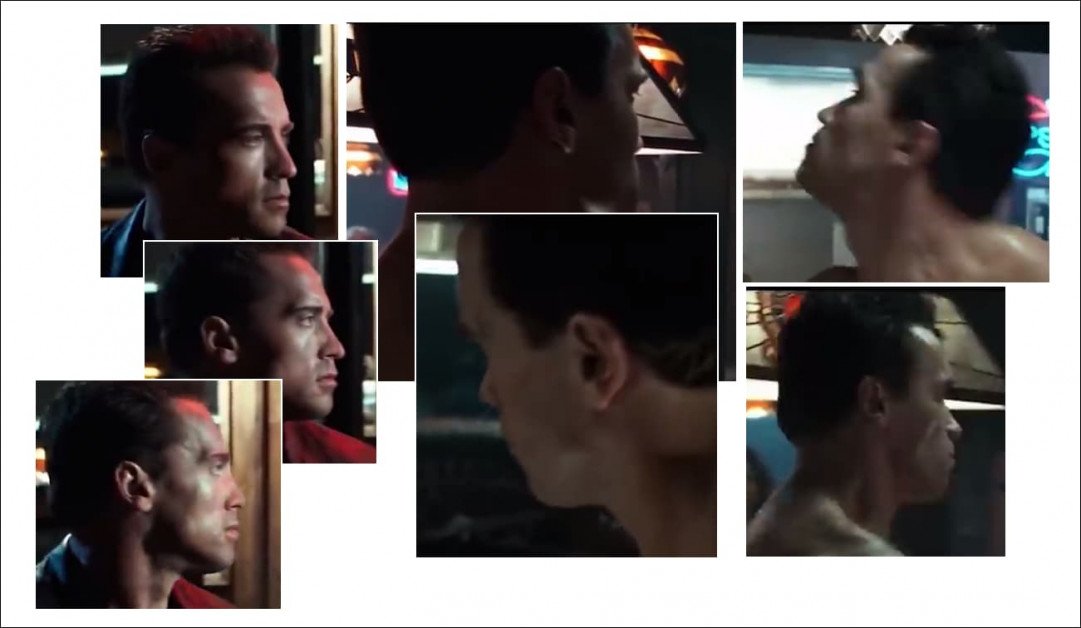

Захоплення з відомого глибокого фейкового відео, де Арнольд Шварценеггер перетворюється на Сильвестра Сталлоне – якщо ракурси не надто складні. Профілі залишаються постійною проблемою з поточними підходами deepfake, частково через те, що програмне забезпечення з відкритим кодом, яке використовується для визначення поз обличчя в рамках deepfake, не оптимізоване для перегляду збоку, а головним чином через брак відповідного вихідного матеріалу в одному або обох необхідних набори даних. Джерело: https://www.youtube.com/watch?v=AQvCmQFScMA

нове дослідження з Ізраїлю пропонує новий метод використання синтетичних даних, таких як CGI-голови, щоб перенести дипфейк у 2020-ті роки, справді відокремлюючи ідентифікацію обличчя (тобто основні характеристики обличчя «Тома Круза» з усіх боків) від їх контексту (тобто дивлячись, дивлячись збоку, насуплений, хмуриться в темряві, брови насуплені, очі закритіІ т.д.).

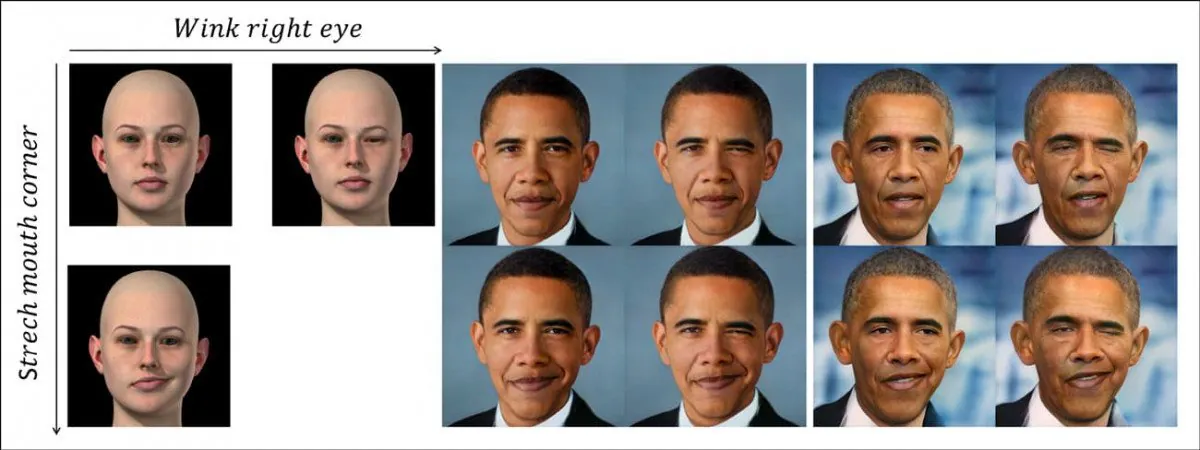

Нова система дискретно відокремлює позу та контекст (тобто підморгування оком) від кодування особистості людини, використовуючи непов’язані синтетичні дані обличчя (на фото ліворуч). У верхньому рядку ми бачимо «підморгування», перенесене на особу Барака Обами, викликане вивченим нелінійним шляхом латентного простору GAN, представленого зображенням CGI зліва. У рядку нижче ми бачимо розтягнутий фасет кута рота, перенесений на колишнього президента. Внизу праворуч ми бачимо, що обидві характеристики застосовуються одночасно. Джерело: https://arxiv.org/pdf/2111.08419.pdf

Це не просто deepfake head-puppetry, техніка, більш придатна для аватарів і синхронізації часткових облич, і яка має обмежений потенціал для повноцінного глибокого фейкового перетворення відео.

Скоріше це являє собою шлях вперед для фундаментального поділу інструментальності (наприклад, "змінити кут нахилу голови", "створити хмурий погляд") від ідентичності, пропонуючи шлях до високорівневої, а не «похідної» структури глибокого фейку на основі синтезу зображень.

Нова стаття має назву Delta-GAN-Encoder: кодування семантичних змін для явного редагування зображень, використовуючи декілька синтетичних зразків, і походить від дослідників Техніону – Ізраїльського технологічного інституту.

Щоб зрозуміти, що означає ця робота, давайте подивимося, як глибокі фейки в даний час виробляються всюди, від глибоких фейкових порносайтів до Промислове світло та магія (оскільки сховище з відкритим кодом DeepFaceLab наразі домінує як у «аматорському», так і в професійному дипфейку).

Що стримує поточну технологію Deepfake?

Deepfakes наразі створюються шляхом навчання an кодер/декодер модель машинного навчання на двох папках зображень обличчя – людини, яку ви хочете «зафарбувати» (у попередньому прикладі це Арні), і людини, яку ви хочете накласти на кадр (Слай).

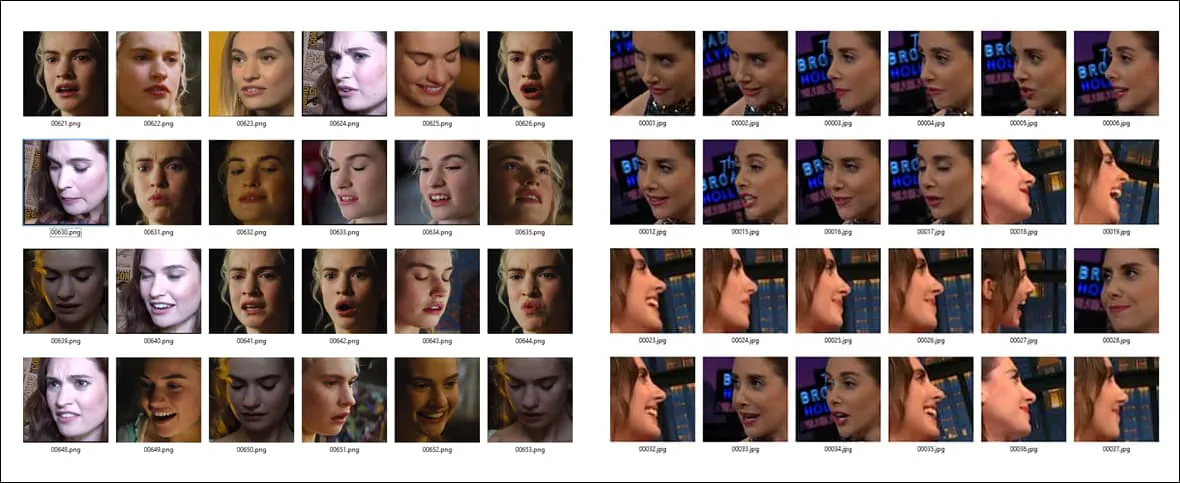

Приклади різних поз і умов освітлення для двох різних наборів обличчя. Зверніть увагу на відмінний вираз у кінці третього рядка в стовпці A, який навряд чи матиме близький еквівалент в іншому наборі даних.

Тоді система кодера/декодера порівнює кожне зображення у кожній папці один до одного, підтримуючи, покращуючи та повторюючи цю операцію протягом сотень тисяч ітерацій (часто протягом тижня), поки він не зрозуміє основні характеристики обох ідентичностей достатньо добре, щоб міняти їх місцями за бажанням.

Те, що архітектура deepfake дізнається про особистість кожного з двох людей, які обмінюються в процесі заплутаний контекстом. Він не може вивчити та застосувати принципи загальної пози «назавжди», але потребує численних прикладів у навчальному наборі даних для кожної особистості, яка буде залучена до зміни обличчя.

Тому, якщо ви хочете поміняти місцями дві особистості, які роблять щось більш незвичне, ніж просто посміхаються або дивляться прямо в камеру, вам знадобиться багато екземпляри цієї конкретної пози/ідентичності на двох наборах обличчя:

Оскільки ідентифікація обличчя та характеристики пози наразі настільки переплетені, необхідна широка паритетність виразів, пози голови та (меншою мірою) освітлення в двох наборах даних обличчя, щоб навчити ефективну модель deepfake на таких системах, як DeepFaceLab. Чим менше конкретна конфігурація (наприклад, «вид збоку/усміхнений/освітлений сонцем») представлена в обох наборах обличчя, тим менш точно вона відтворюватиметься у відео підробки, якщо це необхідно.

Якщо набір A містить незвичайну позу, але набір B її не має, вам майже не пощастило; незалежно від того, як довго ви тренуєте модель, вона ніколи не навчиться добре відтворювати цю позу між ідентичностями, тому що вона мала лише половину необхідної інформації під час навчання.

Навіть якщо у вас є відповідні зображення, цього може бути недостатньо: якщо набір A має відповідну позу, але з різким боковим освітленням, порівняно з рівно освітленою еквівалентною позою в іншому наборі обличчя, якість заміни виграла не буде таким хорошим, якби кожен мав спільні характеристики освітлення.

Чому даних мало

Якщо вас регулярно не арештовують, у вас, напевно, не так багато знімків у профіль. Усе, що з’явилося, ви, швидше за все, викинули. Оскільки фотоагенції роблять те ж саме, фотографії обличчя в профіль знайти важко.

Deepfakers часто включають кілька копій обмежених даних профілю бокового вигляду, які вони мають для ідентичності, у набір обличчя, щоб ця поза отримала принаймні трохи уваги та часу під час навчання, замість того, щоб бути зниженим як чуже.

Але існує набагато більше можливих типів зображень обличчя збоку, ніж, імовірно, доступно для включення в набір даних – посміхатися, насупившись, кричущий, плач, темно-освітлений, зневажливий, нудьгуючий, веселий, освітлений спалахом, дивлячись, дивлячись униз, очі відкриті, очі закриті…і так далі. Будь-яка з цих поз у кількох комбінаціях може знадобитися в цільовому відео для цільового дипфейку.

І це тільки профілі. Скільки у вас фотографій, на яких ви дивитесь прямо? У вас достатньо, щоб широко представити 10,000 XNUMX можливих виразів ви можете одягнути, утримуючи саме цю позу під таким кутом камери, охоплюючи принаймні деякі з них один мільйон можливих середовищ освітлення?

Швидше за все, у вас навіть немає один зображення, на якому ви дивитеся вгору. І це лише два ракурси зі ста чи більше, необхідних для повного покриття.

Навіть якби можна було згенерувати повне покриття обличчя з усіх кутів за різних умов освітлення, отриманий набір даних був би занадто великим для навчання, порядку сотень тисяч зображень; і навіть якщо це може Навчання, характер процесу навчання для поточних фреймворків deepfake відкидає переважну більшість цих додаткових даних на користь обмеженої кількості похідних функцій, оскільки поточні фреймворки є редукціоністськими та не надто масштабованими.

Синтетична заміна

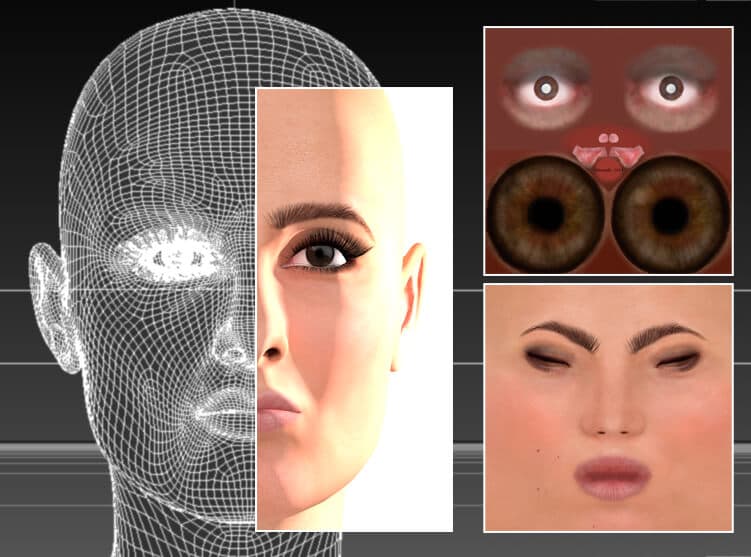

З самого початку дипфейків дипфейкери експериментували з використанням зображень у стилі CGI, голов, створених у 3D-додатках, таких як Cinema4D і Maya, для створення цих «відсутніх поз».

ШІ не потрібен; актрису відтворюють у традиційній програмі CGI, Cinema 4D, з використанням сітки та растрових текстур – технології, яка бере свій початок із 1960-х років, але набула широкого використання лише з 1990-х років. Теоретично цю модель обличчя можна використовувати для генерації вихідних даних deepfake для незвичайних поз, стилів освітлення та виразів обличчя. Насправді це було обмежено або взагалі не використовувалося для глибокого підроблення, оскільки «фальшивість» візуалізацій має тенденцію просвічувати в замінених відео. Джерело: зображення автора цієї статті на https://rossdawson.com/futurist/implications-of-ai/comprehensive-guide-ai-artificial-intelligence-visual-effects-vfx/

Від цього методу, як правило, рано відмовляються нові практики глибокого фейку, тому що, хоча він може забезпечити пози та вирази, які інакше недоступні, синтетичний вигляд CGI-облич зазвичай просочується до свопів через заплутаність ID та контекстної/семантичної інформації.

Це може призвести до раптового спалаху облич «страшної долини» у переконливому deepfake-відео, оскільки алгоритм починає використовувати єдині дані, які він може мати для незвичайної пози чи виразу – явно фальшиві обличчя.

Серед найпопулярніших сюжетів для діпфейків — алгоритм 3D-діпфейку для австралійської актриси Марго Роббі. включені у стандартній установці DeepFaceLive, версії DeepFaceLab, яка може виконувати глибокі фейки під час прямого ефіру, наприклад під час сеансу веб-камери. CGI-версію, як показано вище, можна використовувати для отримання незвичайних «відсутніх» кутів у масивах даних deepfake. Source: https://sketchfab.com/3d-models/margot-robbie-bust-for-full-color-3d-printing-98d15fe0403b4e64902332be9cfb0ace

Обличчя CGI як окремі, концептуальні настанови

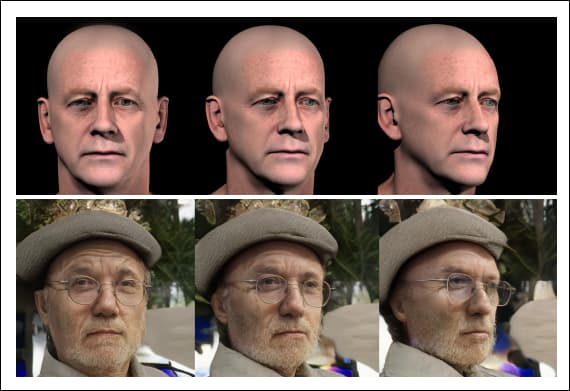

Натомість новий метод Delta-GAN Encoder (DGE) від ізраїльських дослідників є більш ефективним, оскільки поза та контекстна інформація із зображень CGI були повністю відокремлені від інформації про «ідентифікацію» цілі.

Ми можемо побачити цей принцип у дії на зображенні нижче, де різні орієнтації голови були отримані за допомогою зображень CGI як орієнтира. Оскільки ідентифікаційні характеристики не пов’язані з контекстними особливостями, немає жодного просвічування ані фальшивого синтетичного вигляду CGI-обличчя, ані ідентифікації, зображеної на ньому:

Завдяки новому методу вам не потрібно шукати три окремі вихідні зображення в реальному житті, щоб створити дипфейк під різними кутами – ви можете просто повернути голову CGI, чиї абстрактні риси високого рівня накладаються на ідентифікатор без витоку ідентифікатора. інформації.

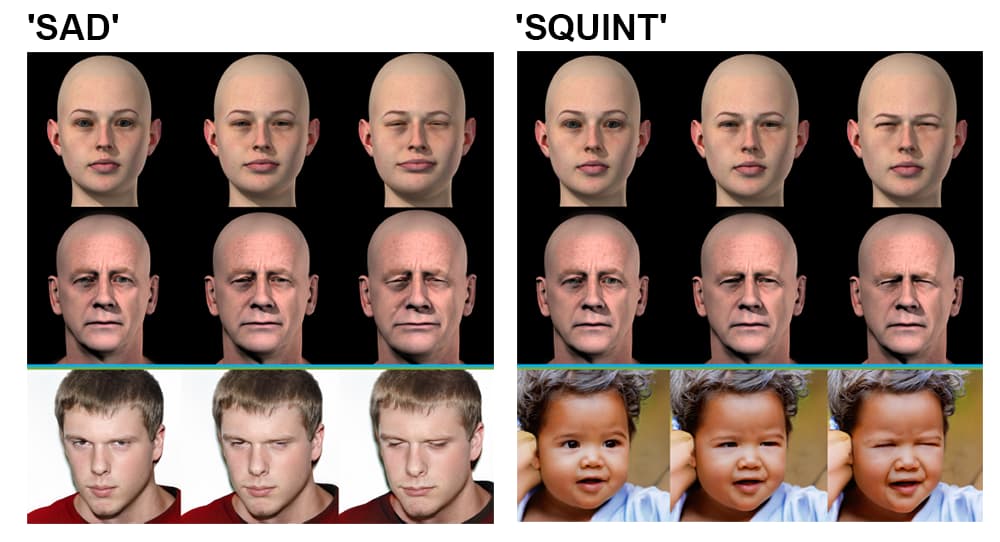

Дельта-ГАН-Кодер. Верхня ліва група: кут вихідного зображення можна змінити за секунду, щоб відтворити нове вихідне зображення, яке відображається на виході; верхня права група: освітлення також відокремлено від ідентичності, дозволяючи накладати стилі освітлення; нижня ліва група: кілька деталей обличчя змінено, щоб створити «сумний» вираз; нижня права група: одна деталь виразу обличчя змінена, так що очі примружені.

Це поділ ідентичності та контексту досягається на етапі навчання. Конвеєр для нової архітектури deepfake шукає прихований вектор у попередньо підготовленій Generative Adversarial Network (GAN), яка відповідає зображенню, яке потрібно трансформувати — методологія Sim2Real, яка базується на 2018 році. проект із відділу досліджень штучного інтелекту IBM.

Дослідники спостерігають:

«Використовуючи лише кілька зразків, які відрізняються певним атрибутом, можна навчитися розлученій поведінці попередньо навченої заплутаної генеративної моделі. Немає потреби в точних реальних зразках для досягнення цієї мети, що не обов’язково можливо.

«Використовуючи нереалістичні зразки даних, можна досягти тієї ж мети завдяки використанню семантики закодованих латентних векторів. Застосування бажаних змін до існуючих зразків даних можна здійснити без явного дослідження поведінки в прихованому просторі.'

Дослідники передбачають, що ключові принципи розплутування, досліджені в проекті, можна буде перенести в інші області, такі як симуляція внутрішньої архітектури, і що метод Sim2Real, прийнятий для Delta-GAN-Encoder, може врешті-решт увімкнути інструментальність deepfake на основі простих ескізів, а не Введення в стилі CGI.

Можна стверджувати, що ступінь, до якого нова ізраїльська система може або не зможе синтезувати глибокі фейкові відео, набагато менш значущий, ніж прогрес, досягнутий дослідженнями у розмежуванні контексту з ідентичністю, у процесі отримання більшого контролю над латентним простором. GAN.

Disentanglement є активною сферою дослідження синтезу зображень; у січні 2021 року дослідження під керівництвом Amazon папір продемонстрував подібний контроль пози та розплутування, а в 2018 році a папір з Інституту передових технологій Шеньчженя Китайської академії наук досягли прогресу в створенні довільних точок зору в GAN.