Anderson's Angle

ІІ Відео вдосконалює селфі кота

Генератори відео на основі штучного інтелекту часто дають результати, які майже відповідають тому, що ви хотіли отримати за допомогою текстового запиту, але не зовсім. Проте нове високорівневе рішення змінює все.

Системи генерації відео часто мають труднощі з створенням дійсно креативних або дивовижних відео і часто не виправдовують очікувань користувачів щодо текстових запитів.

Частково це пов’язано з заплутаністю – тим, що моделі зору/мови повинні йти на компроміс щодо того, скільки часу вони навчаються на своїх вихідних даних. Занадто мало навчання – і концепції гнучкі, але не повністю сформовані; занадто багато – і концепції точні, але вже не достатньо гнучкі, щоб включати їх у нові комбінації.

Ви можете зрозуміти ідею з відео, вбудованого нижче. Ліворуч – це свого роду компроміс, який багато систем штучного інтелекту надають у відповідь на вимогливий запит (запит знаходиться вгорі відео у всіх чотирьох прикладах), що вимагає деякого поєднання елементів, яке занадто фантастичне, щоб бути реальним прикладом навчання. Праворуч – це вихід штучного інтелекту, який набагато краще дотримується запиту:

Натисніть, щоб відтворити (без звуку). Праворуч ми бачимо, як ‘факторизований’ WAN 2.2 дійсно виконує запити, у порівнянні з нечіткими інтерпретаціями ‘ванільного’ Wan 2.2, ліворуч. Будь ласка, зверніться до вихідних відеофайлів для кращої роздільної здатності та багатьох інших прикладів, хоча кураторські версії, які ви бачите тут, не існують на сайті проекту і були зібрані для цієї статті.Джерело

Ну, хоча ми повинні пробачити качці, що плескає руками людини (!), зрозуміло, що приклади праворуч набагато краще дотримуються оригінального текстового запиту, ніж ті, що ліворуч.

Цікаво, що обидві архітектури, які представлені, по суті, є однією і тією ж архітектурою – популярним і дуже здатним Wan 2.2, китайським релізом, який цього року здобув значну популярність у спільнотах з відкритим кодом і серед любителів.

Різниця полягає в тому, що друга генеративна лінія факторизована, що в даному випадку означає, що велика мовна модель (LLM) була використана для повторної інтерпретації першого (початкового) кадру відео, щоб системі було набагато легше надати те, що користувач просить.

Це ‘візуальне закріплення’ передбачає введення зображення, створеного з цього покращеного LLM запиту, у генеративну лінію як ‘стартовий кадр’, і використання LoRA інтерпретативної моделі для допомоги в інтеграції ‘вторгненого’ кадру в процес створення відео.

Результати, з точки зору точності запиту, досить вражаючі, особливо для рішення, яке здається досить елегантним:

Натисніть, щоб відтворити (без звуку). Подальші приклади ‘факторизованих’ генерацій відео, які дійсно дотримуються сценарію. Будь ласка, зверніться до вихідних відеофайлів для кращої роздільної здатності та багатьох інших прикладів, хоча кураторські версії, які ви бачите тут, не існують на сайті проекту і були зібрані для цієї статті.

Це рішення представлено у формі нової статті Факторизована генерація відео: розділення побудови сцени та тимчасового синтезу в моделях дифузії тексту у відео, та її відеонаповненого супровідного веб-сайту проекту.

Хоча багато сучасних систем намагаються підвищити точність запиту, використовуючи мовні моделі для переписування нечітких або недостатньо визначених текстів, нова робота стверджує, що ця стратегія все ще призводить до невдачі, коли внутрішнє представлення сцени моделі є недосконалим.

Навіть з детально переписаним запитом, моделі тексту у відео часто неправильно компонують ключові елементи або генерують несумісні початкові стани, які порушують логіку анімації. Поки перший кадр не відображає те, що описує запит, результуюче відео не може відновитися, незалежно від того, наскільки хороша модель руху.

У статті зазначено*:

‘[Моделі тексту у відео] часто продукують кадри зі зміщеним розподілом, але все ще досягають [оцінок оцінювання], порівнянних з моделями I2V, що вказує на те, що їх моделювання руху залишається досить природним, навіть коли точність сцени відносно низька.

‘[Моделі зображення у відео] демонструють комплементарну поведінку, сильні [оцінки оцінювання] від точних початкових сцен і слабшу тимчасову узгодженість, тоді як I2V+текст балансує обидва аспекти.

‘Цей контраст вказує на структурну невідповідність у поточних моделях T2V: закріплення сцени та тимчасовий синтез виграють від різних індуктивних упереджень, але існуючі архітектури намагаються навчити обидва одночасно в межах однієї моделі.’

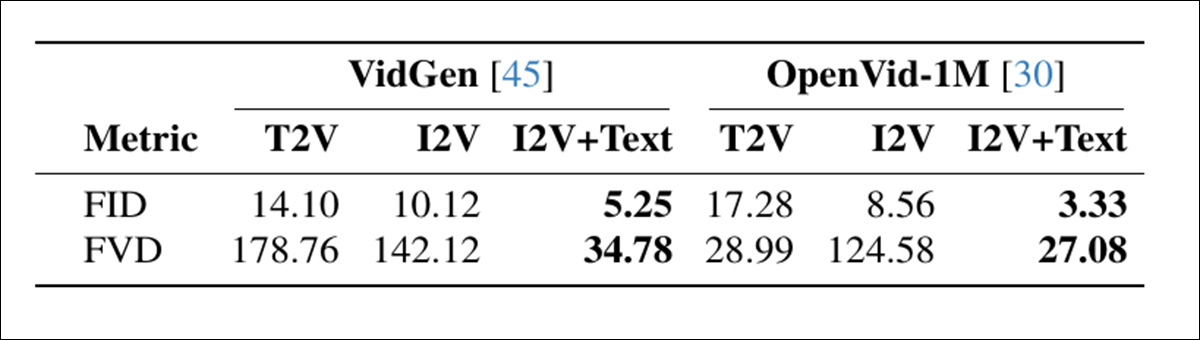

Діагностичне порівняння режимів генерації виявило, що моделі без явного закріплення сцени добре оцінювалися за рух, але часто йшли на компроміс щодо розташування сцени, тоді як підходи, засновані на зображеннях, показали протилежний патерн:

Порівняння режимів генерації відео на двох наборах даних, що показує, що I2V+текст досягає найкращої якості кадру (FID) та тимчасової узгодженості (FVD), підкреслюючи перевагу розділення побудови сцени від руху. Джерело

Ці висновки вказують на структурний недолік, коли поточні моделі намагаються навчити як розташування сцени, так і анімацію одночасно, хоча обидва завдання вимагають різних видів індуктивного упередження, і краще обробляються окремо.

Можливо, найбільший інтерес викликає те, що цей ‘трюк’ потенційно може бути застосований до локальних установок моделей, таких як Wan 2.1 і 2.2, та подібних моделей дифузії відео, таких як Hunyuan Video. Анехдотично, порівнюючи якість виходу любителів з комерційними генеративними порталами, такими як Kling і Runway, більшість основних постачальників API покращують пропозиції з відкритим кодом, такі як WAN, за допомогою LoRA, і – здається – з трюками, подібними до тих, що представлені в новій статті. Тому цей підхід може представляти можливість наздогнати для спільноти FOSS.

Тести, проведені для методу, показують, що цей простий і модульний підхід пропонує новий стан мистецтва на T2V-CompBench benchmark, значно покращуючи всі протестовані моделі. Автори зазначають у висновку, що хоча їх система радикально покращує точність, вона не вирішує (і не призначена для вирішення) дрейфу ідентичності, який наразі є бичем досліджень генеративного ІІ.

Нова стаття походить від чотирьох дослідників з Ecole Polytechnique Fédérale de Lausanne (EPFL) у Швейцарії.

Метод і дані

Центральна пропозиція нової техніки полягає в тому, що моделі дифузії тексту у відео (T2V) повинні бути ‘закріплені’ на стартових кадрах, які дійсно відповідають бажаному текстовому запиту.

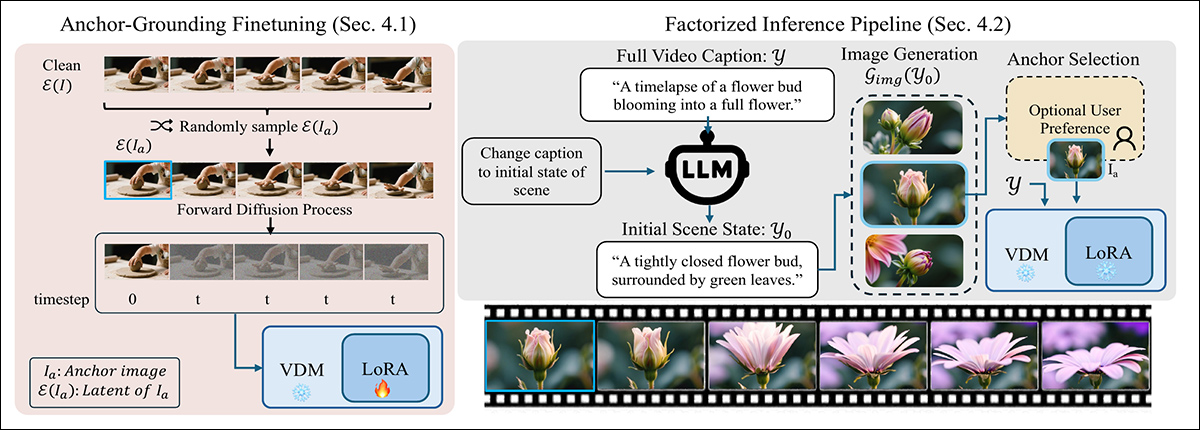

Щоб забезпечити дотримання моделі стартового кадру, новий метод порушує стандартний процес дифузії, вводячи чистий латентний з закріпленого зображення на нульовому кроці, замінюючи один з звичайних шумових входів. Цей незвичний вхід спочатку збиває модель з пантелику, але з мінімальним тонким налаштуванням LoRA, вона навчається сприймати введений кадр як фіксований візуальний якір, а не частину траєкторії шуму:

Двоступеневий метод закріплення генерації тексту у відео з візуальним якорем: Ліворуч, модель налаштовується за допомогою легкого LoRA для обробки введеного чистого латентного як фіксованого обмеження сцени. Праворуч, запит розділяється на підпис першого кадру, який використовується для генерації закріпленого зображення, що направляє відео.

На етапі висновку метод переписує запит, щоб описати лише перший кадр, використовуючи LLM для вилучення правдоподібного початкового стану сцени, зосередженого на розташуванні та зовнішньому вигляді.

Цей переписаний запит передається генератору зображень для створення кандидатного закріпленого кадру (який за бажанням може бути уточнений користувачем). Вибраний кадр кодується в латентний і вводиться в процес дифузії, замінюючи перший крок, дозволяючи моделі генерувати решту відео залишаючись закріпленим на початковій сцені – процес, який працює без необхідності змінювати базову архітектуру.

Процес був протестований шляхом створення LoRA для Wan2.2-14B, Wan2.1-1B, і CogVideo1.5-5B. Навчання LoRA проводилося на ранзі 256, на 5000 випадково вибраних кліпах з колекції UltraVideo.

Навчання тривало 6000 кроків і вимагало 48 годин роботи GPU† для Wan-1B і CogVideo-5B, та 96 годин роботи GPU для Wan-14B. Автори зазначають, що Wan-5B нативно підтримує лише текстове та текстово-зображувальне кондиціонування (які в цьому випадку накладаються на старіші фреймворки), і тому не вимагало жодного тонкого налаштування.

Тести

У експериментах, проведених для процесу, кожен текстовий запит спочатку уточнювався за допомогою Qwen2.5-7B-Instruct, який використовував результат для створення детального підпису ‘початкового зображення’, що містить опис всієї сцени. Це потім передавалося QwenImage, яке було завданням генерувати ‘магічний кадр’, який буде вставлений у процес дифузії.

Еталони, використані для оцінки системи, включали згаданий вище T2V-CompBench, для тестування композиційного розуміння шляхом оцінки того, наскільки добре моделі зберігали об’єкти, атрибути та дії в межах узгодженої сцени; та VBench 2.0, для оцінки ширшого розуміння та узгодженості за 18 метриками, згрупованими в креативність, загальнозрозуміле розуміння, контрольованість, людську вірність, та фізику:

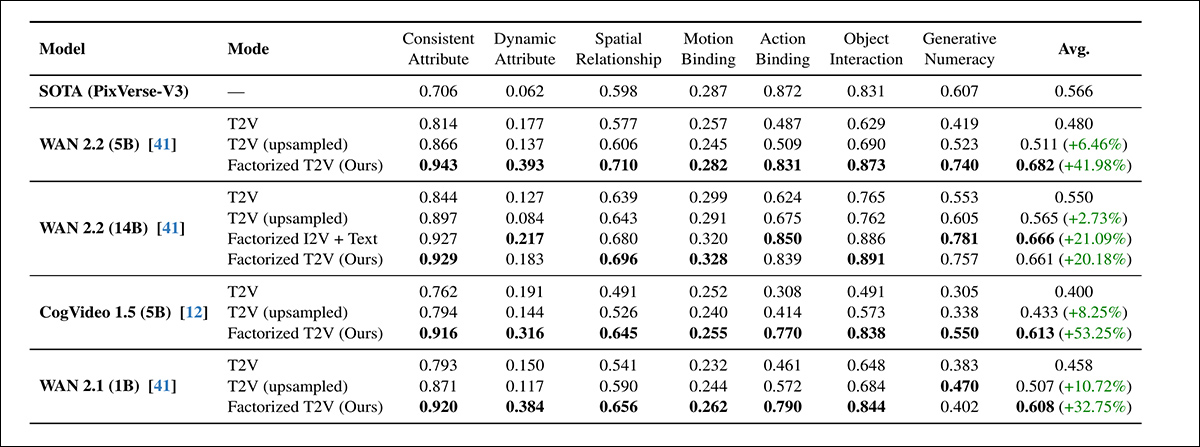

У всіх семи категоріях оцінки T2V-CompBench, факторизований метод T2V перевершив як стандартні, так і збільшені базові моделі T2V для кожної протестованої моделі, з приростами до 53.25%. Найвищі варіанти часто відповідали або перевершували власний еталон PixVerse-V3.

Щодо цього початкового раунду тестів, автори зазначають*:

‘[У всіх] моделях, додавання закріпленого зображення постійно покращує композиційні показники. Всі менші факторизовані моделі (CogVideo 5B, Wan 5B і Wan 1B) перевершують більшу модель Wan 14B T2V.

‘Наш факторизований Wan 5B також перевершує комерційний базовий PixVerse-V3, який є найкращою зареєстрованою моделлю на еталоні. Це демонструє, що візуальне закріплення суттєво покращує розуміння сцени та дій навіть у моделях з меншою потужністю.

‘У кожній сім’ї моделей, факторизована версія перевершує оригінальну модель. Зокрема, наша легка LoRA з закріпленим якорем на WAN 14B досягає продуктивності, порівнянної з її попередньо навченим варіантом I2V 14B (0.661 проти 0.666), незважаючи на те, що не вимагає повного перенавчання.’

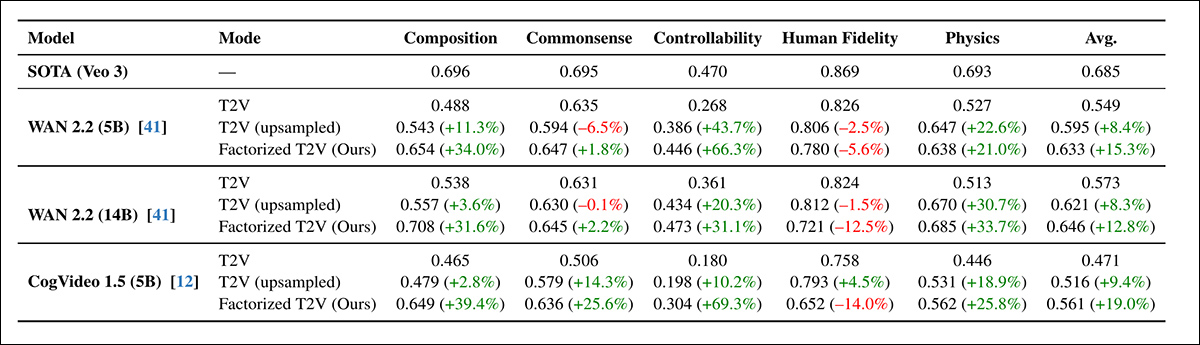

Далі йшов раунд VBench2.0:

Факторизований підхід T2V постійно покращував продуктивність VBench 2.0 у всіх категоріях: композиція, загальнозрозуміле розуміння, контрольованість та фізика, з деякими приростами, що перевищують 60% – хоча людська вірність залишалася нижче власного еталону Veo 3.

У всіх архітектурах факторизований підхід підвищував оцінки в кожній категорії VBench, крім людської вірності, яка трохи знизилася навіть при збільшенні запиту. WAN 5B перевершив більшу WAN 14B, підтверджуючи попередні результати T2V-CompBench, що візуальне закріплення більше сприяло, ніж масштаб.

Хоча прирости на VBench були постійними, вони були меншими, ніж ті, що спостерігалися на T2V-CompBench, і автори пояснюють це більш суворим бінарним режимом оцінювання VBench.

Для якісних тестів стаття надає статичні зображення, але ми рекомендуємо читачеві звернутися до складених відео, вбудованих у цю статтю, для яснішої ідеї, з застереженням, що вихідні відео є численнішими та різноманітнішими, а також мають вищу роздільну здатність і деталі. Знайдіть їх тут. Щодо якісних результатів, у статті зазначено:

‘Закріплені відео постійно демонструють більш точну композицію сцени, сильніше зв’язування об’єктів та атрибутів, а також чіткіший тимчасовий прогрес.’

Факторизований метод залишався стабільним навіть коли кількість кроків дифузії була зменшена з 50 до 15, показуючи майже відсутність втрати продуктивності на T2V-CompBench. На противагу, як текстові, так і збільшені базові моделі різко деградували за тих самих умов.

Хоча зменшення кроків теоретично могло б утричі збільшити швидкість, повний генераційний процес на практиці став лише в 2.1 рази швидшим, через фіксовані витрати на генерацію закріпленого зображення. Проте, результати показали, що закріплення не тільки покращило якість зразків, але й допомогло стабілізувати процес дифузії, підтримуючи швидше та ефективніше генерування без втрати точності.

Веб-сайт проекту надає приклади збільшених проти нових методів генерацій, з яких ми пропонуємо кілька (нижчої роздільної здатності) відредагованих прикладів тут:

Натисніть, щоб відтворити (без звуку). Збільшені стартові джерела проти факторизованого підходу авторів.

Автори роблять висновок:

‘Наші результати свідчать, що покращене закріплення, а не лише збільшення потужності, може бути настільки ж важливим. Останні досягнення в дифузії T2V значною мірою покладалися на збільшення розміру моделі та навчальних даних, але навіть великі моделі часто мають труднощі з виведенням узгодженої початкової сцени лише з тексту.

‘Це контрастує з дифузією зображень, де масштабування є відносно простим; у відео моделях кожне архітектурне покращення повинно працювати над додатковим тимчасовим виміром, що робить масштабування значно більш ресурсомістким.

‘Наші висновки вказують на те, що покращене закріплення може доповнити масштаб, вирішуючи інше вузьке місце: встановлення правильної сцени перед початком синтезу руху.

‘Розділяючи генерацію відео на композицію сцени та тимчасове моделювання, ми зменшуємо кілька поширених режимів невдач без необхідності у значно більших моделях. Ми розглядаємо це як комплементарний принцип дизайну, який може направляти майбутні архітектури до більш надійного та структурованого синтезу відео.’

Висновок

Хоча проблеми заплутаності є дуже реальними і можуть вимагати спеціальних рішень (таких як покращена кураторська робота та оцінки розподілу перед навчанням), було відкриттям спостерігати, як факторизація ‘розклеює’ кілька впертих та ‘застряглих’ концептуальних оркестрацій запитів у набагато точніші рендери – з лише помірним шаром LoRA кондиціонування та втручанням значно покращеного стартового/початкового зображення.

Розрив у ресурсах між локальним висновком любителів та комерційними рішеннями може бути не таким величезним, як вважалося, враховуючи, що майже всі постачальники прагнуть раціоналізувати свої значні витрати на ресурси GPU для споживачів.

Анехдотично, дуже велика кількість поточного покоління постачальників генеративного відео, здається, використовують брендовані та загалом ‘покращені’ версії китайських моделей з відкритим кодом. Основний ‘рів’ будь-якої з цих ‘посередницьких’ систем, здається, полягає в тому, що вони взяли на себе клопіт навчання LoRA, або ж – за більші витрати і трохи більшу винагороду – фактично провели повне тонке налаштування ваг моделі††.

Інсайти такого роду можуть допомогти ще більше закрити цей розрив, в контексті сцени релізу, де китайці, здається, рішуче налаштовані (не обов’язково з альтруїстичних або ідеалістичних причин) демократизувати генеративний ІІ, тоді як західні бізнес-інтереси, можливо, віддали б перевагу тому, щоб збільшення розміру моделі та регуляції врешті-решт закрили будь-які дійсно хороші моделі за API та кількома шарами фільтрів контенту.

* Наголоси авторів, не мої.

† У статті не вказано, який GPU було обрано, або скільки їх використовувалося.

†† Хоча шлях LoRA є більш ймовірним, як з економічної точки зору зручності використання, так і тому, що повні ваги, а не квантизовані ваги, не завжди доступні.

Вперше опубліковано у п’ятницю, 19 грудня 2025 року