Yapay Zeka

Bilgisayarla Görüde "Kaynaşmış" İnsanları Ayırmak

Singapur'daki Hyundai Motor Group İnovasyon Merkezi'nden yeni bir makale, bilgisayar görüşünde 'kaynaşmış' insanları ayırmak için bir yöntem sunuyor. Bu durumlar, nesne tanıma çerçevesinin bir insanın bir başka insana 'çok yakın' olduğunu (örneğin 'sarılma' eylemleri veya 'arkasında durma' pozları) tespit ettiği ve temsil edilen iki kişiyi birbirinden ayıramadığı, onları tek bir kişi veya varlıkla karıştırdığı durumlardır.

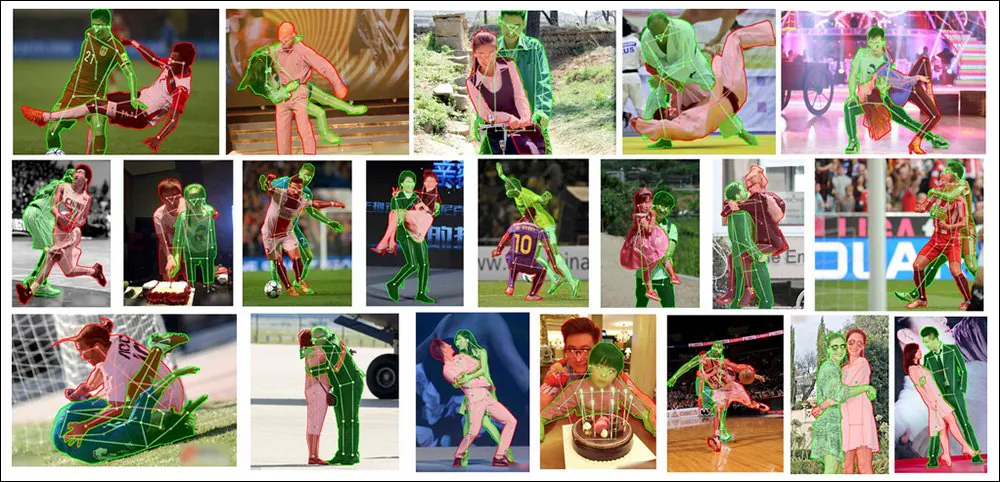

İki kişi bir olur, ancak bu anlamsal segmentasyonda iyi bir şey değildir. Burada, makalenin yeni sisteminin karmaşık ve zorlu görüntülerde iç içe geçmiş insanların bireyselleştirilmesinde son teknoloji sonuçlara ulaştığını görüyoruz. Kaynak: https://arxiv.org/pdf/2210.03686.pdf

Bu, son yıllarda araştırma camiasında büyük ilgi gören dikkate değer bir sorundur. Hiper ölçeğin bariz ama genellikle karşılanamaz maliyeti olmadan bu sorunu çözen insan liderliğindeki özel etiketleme, sonunda aşağıdakiler gibi metinden görüntüye sistemlerde insanın bireyselleşmesinde iyileştirmeler sağlayabilir: Kararlı Difüzyon, sıklıkla insanları birbirine 'eriten' ve birden fazla kişinin birbirine yakın mesafede olmasını gerektiren bir pozdur.

Korkuyu kucaklayın - DALL-E 2 ve Stable Diffusion (her ikisi de yukarıda gösterilmiştir) gibi metinden görüntüye modeller, birbirine çok yakın olan insanları temsil etmekte zorlanır.

DALL-E 2 ve Stable Diffusion gibi üretken modeller (kapalı kaynaklı DALL-E 2 örneğinde olduğu gibi) şu anda semantik segmentasyon veya nesne tanıma kullanmıyor olsa da, bu iğrenç insan karışımları şu anda bu tür yukarı akış yöntemleri uygulanarak düzeltilemez; çünkü en son teknoloji nesne tanıma kütüphaneleri ve kaynakları, insanları birbirinden ayırmada diğerlerine göre çok daha iyi değil. CLIPgizli difüzyon modellerinin tabanlı iş akışları.

Bu sorunu çözmek için, yeni kağıt - başlıklı İnsanların daha fazla insanı etiketlemesine gerek yok: Oklüzyon Kopyala ve Tıkanmış İnsan Örneği Segmentasyonu için Yapıştır– en zorlu kaynak materyale karşı bile görevde yeni bir SOTA üstünlüğü elde etmek için yarı sentetik verilere yönelik yeni 'kes ve yapıştır' yaklaşımını uyarlar ve iyileştirir:

Yeni Oklüzyon Kopyala ve Yapıştır metodolojisi, şu anda, özellikle oklüzyon için modelleme gibi, zorluğu ayrıntılı ve daha özel yollarla ele alan önceki çerçevelere ve yaklaşımlara karşı bile bu alanda lider konumdadır.

Kes şunu!

Değiştirilen yöntem – başlıklı Kapatma Kopyala ve Yapıştır – 2021'den türetilmiştir Basit Kopyala-Yapıştır Çıkarılan nesnelerin ve kişilerin çeşitli kaynak eğitim görüntüleri arasında üst üste bindirilmesinin, bir görüntü tanıma sisteminin bir görüntüde bulunan her örneği ayrıklaştırma yeteneğini geliştirebileceğini öne süren Google Research liderliğindeki makale:

Google Araştırma liderliğindeki 2021 tarihli 'Basit Kopyala-Yapıştır, Örnek Bölümlendirme için Güçlü Bir Veri Artırma Yöntemidir' makalesinde, daha iyi bir görüntü tanıma modeli eğitme amacıyla bir fotoğraftaki öğelerin diğer fotoğraflara 'taşındığını' görüyoruz. Kaynak: https://arxiv.org/pdf/2012.07177.pdf

Yeni versiyon, bu otomatik ve algoritmik 'yeniden yapıştırma' işlemine sınırlamalar ve parametreler ekliyor ve süreci, birkaç temel faktöre dayanarak, diğer görüntülere 'aktarılmaya' aday potansiyellerle dolu bir görüntü 'sepetine' benzetiyor.

OC&P için kavramsal iş akışı.

Öğeleri Kontrol Etme

Bu sınırlayıcı faktörler şunları içerir: olasılık kes ve yapıştır işleminin her zaman tekrarlanmamasını sağlayan, veri artırımını baltalayacak bir 'doygunluk' etkisi yaratacak bir işlemin meydana gelmesi; görüntü sayısı bir sepetin herhangi bir anda sahip olacağı, daha fazla sayıda 'parçanın' örnek çeşitliliğini artırabileceği, ancak ön işleme süresini artırabileceği; ve menzil, bir 'ana' görüntüye yapıştırılacak görüntü sayısını belirler.

İkincisi ile ilgili olarak, kağıt notları 'Yeterli miktarda tıkanıklık olmalı, ancak çok fazla olmamalı, çünkü bunlar görüntüyü aşırı karmaşıklaştırabilir ve öğrenmeye zarar verebilir.'

OC&P için diğer iki yenilik: hedeflenen yapıştırma ve artırılmış örnek yapıştırma.

Hedefli yapıştırma, uygun bir görüntünün hedef görüntüdeki mevcut bir örneğin yakınına inmesini sağlar. Önceki yaklaşımda, önceki çalışmadan, yeni öğe, herhangi bir bağlam dikkate alınmadan yalnızca görüntünün sınırları içinde sınırlandırılmıştı.

Hedefli yapıştırma ile yapılan bu 'yapıştırma' insan gözü için aşikar olsa da, hem OC&P hem de öncülü, görsel özgünlüğün artırılmasının mutlaka önemli olmadığını, hatta bir dezavantaj olabileceğini buldu (aşağıdaki 'Gerçeklik Acıları'na bakın).

Öte yandan, artırılmış örnek yapıştırma, yapıştırılan örneklerin sistem tarafından bir şekilde sınıflandırılabilecek "ayırt edici bir görünüm" sergilememesini sağlar; bu da genelleme ve uygulanabilirliği engelleyebilecek dışlama veya "özel işlem"e yol açabilir. Artırılmış yapıştırma, parlaklık ve keskinlik, ölçekleme ve döndürme ve doygunluk gibi görsel faktörleri düzenler.

Yeni makale için ek materyallerden: OC&P'yi mevcut tanıma çerçevelerine eklemek oldukça önemsizdir ve çok yakın sınırlar içinde insanların üstün bireyselleşmesiyle sonuçlanır. Kaynak: https://arxiv.org/src/2210.03686v1/anc/OcclusionCopyPaste_Supplementary.pdf

Ek olarak, OC&P bir en küçük beden yapıştırılan herhangi bir örnek için. Örneğin, büyük bir kalabalık sahnesinden bir kişinin görüntüsünü çıkarmak ve başka bir görüntüye yapıştırmak mümkün olabilir - ancak böyle bir durumda, dahil olan az sayıdaki piksel muhtemelen tanımaya yardımcı olmaz. Bu nedenle sistem, hedef görüntü için eşitlenmiş kenar uzunluğu oranına dayalı bir minimum ölçek uygular.

Ayrıca OC&P, yapıştırılan konu ile benzer konuları aramanın yanı sıra hedef görüntüdeki sınırlayıcı kutuların boyutunu hesaba kattığı ölçeğe duyarlı yapıştırmayı başlatır. Bununla birlikte, bu, insanların makul veya gerçekçi olduğunu düşünecekleri bileşik görüntülere yol açmaz (aşağıdaki resme bakın), bunun yerine, eğitim sırasında yardımcı olacak şekillerde anlamsal olarak birbirine yakın öğeleri bir araya getirir.

Reality Bites

Hem OC&P'nin dayandığı önceki çalışmalar hem de mevcut uygulama, herhangi bir nihai "montajlı" görüntünün özgünlüğüne veya "fotogerçekliğine" düşük bir önem veriyor. Ancak nihai montajın tamamen Dadaizm (Aksi takdirde eğitilen sistemlerin gerçek dünyadaki uygulamaları, eğitildikleri sahnelerdeki unsurlarla karşılaşmayı asla umamazdı), her iki girişim de 'görsel güvenilirlikte' belirgin bir artışın yalnızca ön işleme süresini uzatmakla kalmayıp, aynı zamanda bu tür 'gerçekçilik iyileştirmelerinin' aslında ters etki yaratma olasılığının yüksek olduğunu buldu.

Yeni makalenin ek materyalinden: 'rastgele harmanlama' ile zenginleştirilmiş görüntü örnekleri. Bu sahneler insana halüsinojenik görünse de, yine de benzer özneler bir araya getirilmiştir; örtüler insan gözü için fantastik olsa da, olası bir örtünün doğası önceden bilinemez ve bu konuda eğitim almak imkansızdır. Bu nedenle, bu tür tuhaf biçim 'kesintileri', eğitilmiş sistemin sahneleri daha inandırıcı kılmak için ayrıntılı Photoshop tarzı metodolojiler geliştirmesine gerek kalmadan, kısmi hedef özneleri arayıp tanımasını sağlamak için yeterlidir.

Veriler ve Testler

Test aşaması için, sistem üzerinde eğitilmiştir. kişi sınıfı MS COCO 262,465 görüntüde 64,115 insan örneği içeren veri kümesi. Ancak MS COCO'nun sahip olduğundan daha kaliteli maskeler elde etmek için görüntüler de alındı. LVIS maske ek açıklamaları.

Facebook araştırmasından 2019'da piyasaya sürülen LVIS, Büyük Kelime Örneği Segmentasyonu için hacimli bir veri kümesidir. Kaynak: https://arxiv.org/pdf/1908.03195.pdf

Artırılmış sistemin çok sayıda kapalı insan görüntüsüyle ne kadar iyi mücadele edebileceğini değerlendirmek için araştırmacılar OC&P'yi OCHinsan (Tıkanmış İnsan) kıyaslaması.

2'de Pose2018Seg algılama projesini desteklemek için tanıtılan OCHuman veri kümesinden örnekler. Bu girişim, vücutlarını temsil eden pikseller için anlamsal bir sınırlayıcı olarak duruşlarını ve pozlarını kullanarak insanların gelişmiş anlamsal bölümlemesini elde etmeyi amaçlıyordu. Kaynak: https://github.com/liruilong940607/OCHumanApi

OCHuman kıyaslaması ayrıntılı olarak açıklanmadığından, yeni makalenin araştırmacıları yalnızca tam olarak etiketlenmiş olan örneklerin bir alt kümesini oluşturdu ve buna OCHuman adını verdi.FL. Bu sayısını azalttı kişi doğrulama için 2,240 görüntüde 1,113 örnek ve test için kullanılan 1,923 gerçek görüntüde 951 örnek. Hem orijinal hem de yeni derlenen setler, temel ölçüm olarak Ortalama Ortalama Kesinlik (mAP) kullanılarak test edildi.

Tutarlılık için mimari şunlardan oluşturuldu: Maske R-CNN ResNet-50 omurgasına sahip ve özellik piramidi ağ, ikincisi doğruluk ve eğitim hızı arasında kabul edilebilir bir uzlaşma sağlar.

Araştırmacıların yukarı akışın zararlı etkisini fark etmesiyle IMAGEnet Benzer durumlarda, tüm sistem Facebook'un 4 sürümünün başlatma parametrelerini izleyerek 100 dönem boyunca 75 NVIDIA V2021 GPU üzerinde sıfırdan eğitildi Dedektör 2.

ÇIKTILAR

Yukarıda belirtilen sonuçlara ek olarak, temel sonuçlar karşı MMAlgılama (ve ilişkili üç modeli), OC&P'nin insanları dolambaçlı pozlardan ayırt etme yeteneğinde OC&P için açık bir lider olduğunu gösterdi.

Daha iyi performans göstermenin yanı sıra PoSeg ve Poz2Seg, belki de makalenin en göze çarpan başarılarından biri, sistemin mevcut çerçevelere, denemelerde kendisine karşı çıkanlar da dahil olmak üzere, oldukça genel bir şekilde uygulanabilmesidir (makalenin başlangıcına yakın ilk sonuç kutusundaki karşılaştırmalı/karşılaştırmasızlara bakın).

Makale şu sonuca varıyor:

Yaklaşımımızın temel avantajlarından biri, herhangi bir model veya diğer model merkezli iyileştirmelerle kolayca uygulanabilmesidir. Derin öğrenme alanının ne kadar hızlı ilerlediği göz önüne alındığında, eğitimin diğer tüm yönleriyle yüksek düzeyde uyumlu yaklaşımlara sahip olmak herkesin avantajınadır. Bunu, gizli kişi örneği segmentasyonunu etkili bir şekilde çözmek için model merkezli iyileştirmelerle entegre etmeyi gelecekteki çalışmalarımıza bırakıyoruz.

Metinden Görüntüye Sentezi İyileştirme Potansiyeli

Baş yazar Evan Ling, bize gönderdiği bir e-postada*, OC&P'nin en büyük faydasının, orijinal maske etiketlerini koruyabilmesi ve bunlardan yeni bir bağlamda, yani yapıştırıldıkları görsellerde 'ücretsiz' yeni bir değer elde edebilmesi olduğunu belirtti.

İnsanların semantik segmentasyonu, Kararlı Yayılma gibi modellerin insanları bireyselleştirmede (sıklıkla yaptığı gibi onları 'birbirine karıştırmak' yerine) yaşadığı zorlukla yakından ilişkili görünse de, semantik etiketleme kültürünün SD ve DALL-E 2'nin sıklıkla ürettiği kabus gibi insan görüntüleri üzerindeki herhangi bir etkisi çok çok daha önce ortaya çıkmıştır.

milyarlarca LAYON 5B Stable Diffusion'ın üretken gücünü dolduran alt küme görüntüleri, sınırlayıcı kutular ve örnek maskeleri gibi nesne düzeyinde etiketler içermez; görüntüleri ve veritabanı içeriğini oluşturan CLIP mimarisi bir noktada bu tür örneklemelerden faydalanmış olsa bile; bunun yerine, LAION görüntüleri 'ücretsiz' olarak etiketlenir, çünkü etiketleri web'den veri kümesine kazındıklarında görüntülerle ilişkilendirilen meta verilerden ve çevresel açıklamalardan türetilmiştir.

'Ama bunu bir kenara bırakırsak,' dedi Ling. 'OC&P'mize benzer bir tür artırma, metinden görüntüye üretim modeli eğitimi sırasında kullanılabilir. Ancak, artırılmış eğitim görüntüsünün gerçekçiliğinin bir sorun olabileceğini düşünüyorum.'

Çalışmamızda, denetlenen örnek segmentasyonu için genellikle 'mükemmel' gerçekçiliğin gerekli olmadığını gösteriyoruz, ancak aynı sonucun metinden görüntüye üretim modeli eğitimi için de çıkarılabileceğinden emin değilim (özellikle de çıktılarının oldukça gerçekçi olması beklendiğinde). Bu durumda, artırılmış görüntülerin gerçekçiliğini 'mükemmelleştirmek' için daha fazla çalışma yapılması gerekebilir.

KLİP zaten kullanılıyor Anlamsal segmentasyon için olası bir çok modlu araç olarak, OC&P gibi geliştirilmiş kişi tanıma ve bireyleştirme sistemlerinin, nihayetinde 'kaynaştırılmış' ve çarpıtılmış insan temsillerini keyfi olarak reddedecek sistem içi filtrelere veya sınıflandırıcılara dönüştürülebileceğini öne sürmektedir; bu, şu anda Kararlı Yayılım ile başarılması zor bir görevdir, çünkü nerede hata yaptığını anlama yeteneği sınırlıdır (eğer böyle bir yeteneği olsaydı, muhtemelen ilk etapta hatayı yapmazdı).

Şu anda DALL-E 2 ve Stable Diffusion'ın kalbi olan OpenAI'nin CLIP çerçevesini anlamsal segmentasyon için kullanan çok sayıda projeden yalnızca biri. Kaynak: https://openaccess.thecvf.com/content/CVPR2022/papers/Wang_CRIS_CLIP-Driven_Referring_Image_Segmentation_CVPR_2022_paper.pdf

Ling, "Başka bir soru da şu olurdu," diye öneriyor. "Eğitim sırasında bu üretken modellere, "insan kaynaşması" sorununu hafifletmek için tamamlayıcı model mimarisi tasarımı olmadan, örtülü insan görüntüleri vermek işe yarar mı? Bu muhtemelen hemen cevaplanması zor bir soru. Metinden görüntüye üretken model eğitimi sırasında bir tür örnek düzeyinde rehberliği (örnek maskesi gibi örnek düzeyinde etiketler aracılığıyla) nasıl aşılayabileceğimizi görmek kesinlikle ilginç olacak."

* 10 Ekim 2022

İlk olarak 10 Ekim 2022'de yayınlandı.