Yapay Zeka

Büyük Dil Modellerinde İnce Ayar Yapmak İçin Tam Kılavuz

Içindekiler

Büyük dil modelleri GPT-4, LaMDA, PaLM ve diğerleri gibi (LLM'ler), çok çeşitli konularda insan benzeri metinleri anlama ve oluşturma konusundaki olağanüstü yetenekleriyle dünyayı kasıp kavurdu. Bu modeller internetten, kitaplardan ve diğer kaynaklardan milyarlarca kelimeden oluşan devasa veri kümeleri üzerinde önceden eğitilmiştir.

Bu ön eğitim aşaması, modellere dil, konular, muhakeme yetenekleri ve hatta eğitim verilerinde mevcut olan belirli önyargılar hakkında kapsamlı genel bilgi aşılar. Bununla birlikte, inanılmaz genişliklerine rağmen, bu önceden eğitilmiş LLM'ler belirli alanlar veya görevler için uzmanlaşmış uzmanlıktan yoksundur.

İnce ayarın devreye girdiği yer burasıdır; önceden eğitilmiş bir LLM'nin belirli bir uygulama veya kullanım durumunda başarılı olacak şekilde uyarlanması süreci. Modeli daha küçük, göreve özgü bir veri kümesi üzerinde daha fazla eğiterek, yeteneklerini o alanın nüansları ve gereksinimleriyle uyumlu olacak şekilde ayarlayabiliriz.

İnce ayar, yüksek eğitimli bir genel uzmanın geniş kapsamlı bilgisini belirli bir alanda uzmanlaşmış bir konu uzmanı oluşturmak için aktarmaya benzer. Bu kılavuzda LLM'lere ince ayar yapmanın ne olduğunu, nedenlerini ve nasıllarını inceleyeceğiz.

İnce Ayar nedir?

Onun çekirdeğinde, ince ayar önceden eğitilmiş büyük bir modelin alınmasını ve hedef görevinize veya alanınıza göre uyarlanmış bir veri kümesi üzerinde ikinci bir eğitim aşamasını kullanarak parametrelerinin güncellenmesini içerir. Bu, modelin söz konusu dar alana özgü nüansları, kalıpları ve hedefleri öğrenmesine ve içselleştirmesine olanak tanır.

Ön eğitim, geniş ve çeşitli bir metin külliyatından geniş bir dil anlayışını yakalarken, ince ayar bu genel yeterliliği uzmanlaştırır. Bu, bir Rönesans adamını alıp onu bir endüstri uzmanı haline getirmeye benzer.

Önceden eğitilmiş modelin genel bilgisini kodlayan ağırlıkları, ince ayar süreci için başlangıç noktası veya başlatma olarak kullanılır. Model daha sonra daha fazla eğitilir, ancak bu sefer doğrudan son uygulamayla ilgili örnekler üzerinde.

Modeli bu özel veri dağıtımına maruz bırakarak ve model parametrelerini buna göre ayarlayarak, LLM'yi hedef kullanım durumu için daha doğru ve etkili hale getirirken, aynı zamanda temel olarak önceden eğitilmiş geniş yeteneklerden faydalanmaya devam ediyoruz.

LLM'lerde Neden İnce Ayar Yapılmalı?

Büyük bir dil modeline ince ayar yapmak istemenizin birkaç temel nedeni vardır:

- Etki Alanı Özelleştirmesi: Hukuktan tıbba ve yazılım mühendisliğine kadar her alanın kendine özgü incelikli dil kuralları, jargonu ve bağlamları vardır. İnce ayar, metni anlamak ve belirli bir alana uygun hale getirmek için genel bir modeli özelleştirmenize olanak tanır.

- Görev Uzmanlığı: LLM'ler, metin özetleme, makine çevirisi, soru yanıtlama vb. gibi çeşitli doğal dil işleme görevleri için ince ayar yapılabilir. Bu uzmanlık hedef görevdeki performansı artırır.

- Veri Uyumu: Sağlık ve finans gibi sıkı düzenlemeye tabi sektörlerin katı veri gizliliği gereksinimleri vardır. İnce ayar, hassas bilgileri korurken LLM'lerin özel kurumsal veriler konusunda eğitilmesine olanak tanır.

- Sınırlı Etiketli Veri: Modelleri eğitmek için büyük etiketli veri kümelerini sıfırdan elde etmek zor olabilir. İnce ayar, önceden eğitilmiş modelin yeteneklerinden yararlanılarak sınırlı denetlenen örneklerden güçlü görev performansı elde edilmesine olanak tanır.

- Model Güncelleme: Bir etki alanında zaman içinde yeni veriler kullanıma sunuldukça, en son bilgi ve yetenekleri dahil etmek için modellerde daha fazla ince ayar yapabilirsiniz.

- Önyargıların Azaltılması: Yüksek Lisans'lar geniş eğitim öncesi verilerden toplumsal önyargıları yakalayabilir. Seçilen veri kümelerinde ince ayar yapılması, bu istenmeyen önyargıların azaltılmasına ve düzeltilmesine yardımcı olabilir.

Aslında ince ayar, genel, geniş bir model ile özel bir uygulamanın odaklanmış gereksinimleri arasındaki boşluğu doldurur. Hedeflenen kullanım durumları için model çıktılarının doğruluğunu, güvenliğini ve uygunluğunu artırır.

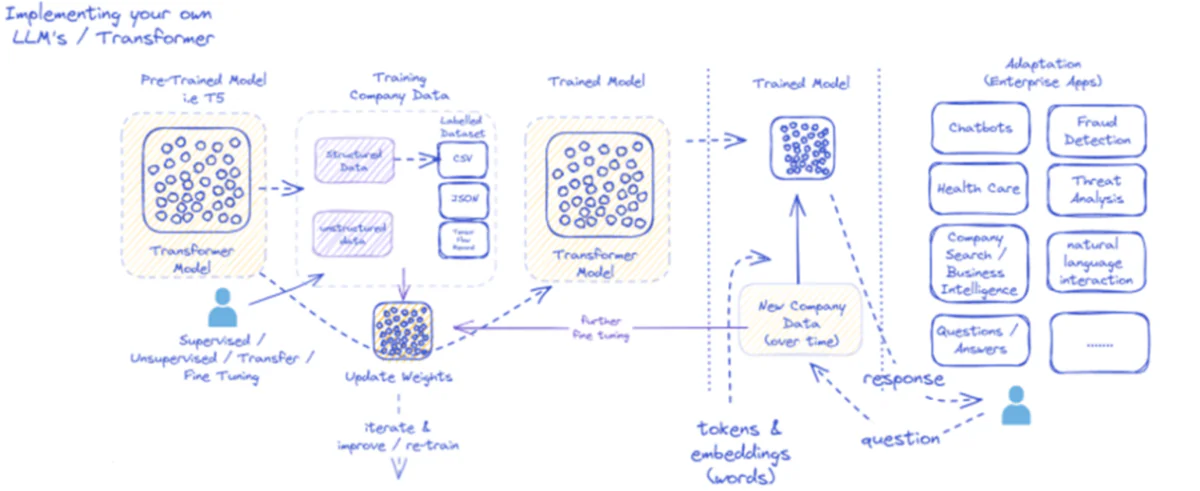

Sağlanan diyagram, özellikle kurumsal uygulamalar için büyük dil modellerinin (LLM'ler) uygulanması ve kullanılması sürecini özetlemektedir. Başlangıçta, T5 gibi önceden eğitilmiş bir model, CSV veya JSON gibi çeşitli formatlarda gelebilecek yapılandırılmış ve yapılandırılmamış şirket verileriyle beslenir. Bu veriler denetlenen, denetlenmeyen veya transfer ince ayar süreçlerinden geçirilerek modelin şirketin özel ihtiyaçlarına uygunluğu artırılır.

Model şirket verileriyle ince ayar yapıldıktan sonra ağırlıkları buna göre güncellenir. Eğitilen model daha sonra daha ileri eğitim döngüleri boyunca yinelenir ve zaman içinde yeni şirket verileriyle yanıtlarını sürekli olarak geliştirir. Süreç, modelin öğrenmesi ve gelişen veri modellerine uyum sağlamak için yeniden eğitilmesiyle yinelemeli ve dinamiktir.

Bu eğitilmiş modelin çıktısı (belirteçler ve sözcükleri temsil eden yerleştirmeler) daha sonra çeşitli kurumsal uygulamalar için devreye alınır. Bu uygulamalar, sohbet robotlarından sağlık hizmetlerine kadar çeşitlilik gösterebilir ve her biri modelin sektöre özel sorguları anlamasını ve yanıt vermesini gerektirir. Finans alanında uygulamalar dolandırıcılık tespiti ve tehdit analizini; Sağlık hizmetlerinde modeller hasta sorgulamalarına ve teşhislere yardımcı olabilir.

Eğitilen modelin zaman içinde yeni şirket verilerini işleme ve bunlara yanıt verme kapasitesi, faydasının sürdürülmesini ve büyümesini sağlar. Sonuç olarak kurumsal kullanıcılar, uygulamalar aracılığıyla modelle etkileşime girebilir, sorular sorabilir ve modelin eğitimini ve alana özgü veriler üzerinde yapılan ince ayarları yansıtan bilinçli yanıtlar alabilir.

Bu altyapı, bir iş bağlamında uygun şekilde uygulandığında ve sürdürüldüğünde LLM'lerin çok yönlülüğünü ve uyarlanabilirliğini sergileyen geniş bir kurumsal uygulama yelpazesini destekler.

İnce Ayar Yaklaşımları

Büyük dil modellerine ince ayar yapmak söz konusu olduğunda iki temel strateji vardır:

1) Tam Model İnce Ayarı

Tam ince ayar yaklaşımında, önceden eğitilmiş modelin tüm parametreleri (ağırlıklar ve sapmalar) ikinci eğitim aşamasında güncellenir. Model, göreve özel etiketli veri kümesine sunulur ve standart eğitim süreci, modelin tamamını söz konusu veri dağıtımı için optimize eder.

Bu, modelin daha kapsamlı ayarlamalar yapmasına ve hedef göreve veya alana bütünsel olarak uyum sağlamasına olanak tanır. Ancak tam ince ayarın bazı dezavantajları vardır:

- Eğitim öncesi aşamaya benzer şekilde, önemli miktarda hesaplama kaynağı ve eğitim süresi gerektirir.

- Her görev için modelin ayrı bir ince ayarlı kopyasını bulundurmanız gerektiğinden, depolama gereksinimleri yüksektir.

- İnce ayarın modelin ön eğitim sırasında öğrenilen bazı genel yetenekleri kaybetmesine neden olduğu "yıkıcı unutma" riski vardır.

Bu sınırlamalara rağmen, tam ince ayar, kaynaklar izin verdiğinde ve hedef görev genel dilden önemli ölçüde farklılaştığında güçlü ve yaygın olarak kullanılan bir teknik olmaya devam etmektedir.

2) Verimli İnce Ayar Yöntemleri

Tam ince ayarın hesaplama zorluklarının üstesinden gelmek için araştırmacılar, ince ayar sırasında modelin parametrelerinin yalnızca küçük bir alt kümesini güncelleyen etkili stratejiler geliştirdiler. Bu parametrik olarak verimli teknikler, uzmanlaşma ile kaynak gereksinimlerinin azaltılması arasında bir denge kurar.

Bazı popüler etkili ince ayar yöntemleri şunları içerir:

Önek Ayarı: Burada, önceden eğitilmiş modelin dikkatini hedef göreve koşullandırmak için az sayıda göreve özgü vektör veya "önek" tanıtılır ve eğitilir. İnce ayar sırasında yalnızca bu önekler güncellenir.

LoRA (Düşük Sıralı Uyarlama): LoRA ince ayar sırasında önceden eğitilmiş modelin her katmanına eğitilebilir düşük dereceli matrisler enjekte eder. Bu küçük dereceli ayarlamalar, modelin tam ince ayardan çok daha az eğitilebilir parametreyle uzmanlaşmasına yardımcı olur.

Elbette, LoRA'nın (Düşük Sıralı Uyarlama) ayrıntılı bir açıklamasını matematiksel formülasyon ve kod örnekleriyle birlikte sunabilirim. LoRA, büyük dil modeli (LLM) uyarlaması alanında önemli bir ilgi kazanmış, popüler bir parametre açısından verimli ince ayar (PEFT) tekniğidir.

LoRA nedir?

LoRA, önceden eğitilmiş LLM'ye az sayıda eğitilebilir parametre tanıtan, orijinal modelin bilgisinin çoğunluğunu korurken aşağı akış görevlerine verimli bir şekilde uyum sağlamaya olanak tanıyan bir ince ayar yöntemidir. LLM'nin tüm parametrelerine ince ayar yapmak yerine LoRA, göreve özel düşük dereceli matrisleri modelin katmanlarına enjekte ederek ince ayar işlemi sırasında önemli miktarda hesaplama ve bellek tasarrufu sağlar.

Matematiksel Formülasyon

LoRA (Düşük Sıralı Uyarlama), ağırlık matrislerine düşük dereceli bir güncelleme getiren büyük dil modelleri (LLM'ler) için bir ince ayar yöntemidir. Bir ağırlık matrisi için 0∈W0∈Rd×k, LoRA düşük dereceli bir matris ekler BAIle A∈Rr×k ve B∈Rd×r, Burada r rütbedir. Bu yaklaşım, eğitilebilir parametrelerin sayısını önemli ölçüde azaltarak, minimum hesaplama kaynağıyla aşağı yönlü görevlere verimli adaptasyona olanak tanır. Güncellenen ağırlık matrisi şu şekilde verilmektedir: W=W0+B⋅A.

Bu düşük dereceli güncelleme, orijinal ağırlık matrisi $W_{0}$'ın düşük dereceli bir matris $BA$ eklenerek değiştirilmesi olarak yorumlanabilir. Bu formülasyonun temel avantajı, $W_{0}$ içindeki tüm $d \times k$ parametrelerini güncellemek yerine, LoRA'nın yalnızca $A$ ve $B içindeki $r \times (d + k)$ parametrelerini optimize etmesi gerekmesidir. $, eğitilebilir parametrelerin sayısını önemli ölçüde azaltır.

İşte Python'da şunu kullanan bir örnek: peft LoRA'yı metin sınıflandırması için önceden eğitilmiş bir LLM'ye uygulamak için kütüphane:

</div> <div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color="">from</span> transformers <span class="token" data-darkreader-inline-color="">import</span> AutoModelForSequenceClassification </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color="">from</span> peft <span class="token" data-darkreader-inline-color="">import</span> get_peft_model<span class="token" data-darkreader-inline-color="">,</span> LoraConfig<span class="token" data-darkreader-inline-color="">,</span> TaskType </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Load pre-trained model</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">model <span class="token" data-darkreader-inline-color="">=</span> AutoModelForSequenceClassification<span class="token" data-darkreader-inline-color="">.</span>from_pretrained<span class="token" data-darkreader-inline-color="">(</span><span class="token" data-darkreader-inline-color="">"bert-base-uncased"</span><span class="token" data-darkreader-inline-color="">,</span> num_labels<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">2</span><span class="token" data-darkreader-inline-color="">)</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Define LoRA configuration</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">peft_config <span class="token" data-darkreader-inline-color="">=</span> LoraConfig<span class="token" data-darkreader-inline-color="">(</span>task_type<span class="token" data-darkreader-inline-color="">=</span>TaskType<span class="token" data-darkreader-inline-color="">.</span>SEQ_CLS<span class="token" data-darkreader-inline-color="">, </span>r<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">8</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color=""># Rank of the low-rank update</span> lora_alpha<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">16</span><span class="token" data-darkreader-inline-color="">,</span></code><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Scaling factor for the low-rank update</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""> target_modules<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">[</span><span class="token" data-darkreader-inline-color="">"q_lin"</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color="">"v_lin"</span><span class="token" data-darkreader-inline-color="">]</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color=""># Apply LoRA to the query and value layers</span> <span class="token" data-darkreader-inline-color="">)</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Create the LoRA-enabled model</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">model <span class="token" data-darkreader-inline-color="">=</span> get_peft_model<span class="token" data-darkreader-inline-color="">(</span>model<span class="token" data-darkreader-inline-color="">,</span> peft_config<span class="token" data-darkreader-inline-color="">)</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Fine-tune the model with LoRA</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># ... (training code omitted for brevity)</span></code></div> </div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">

Bu örnekte, dizi sınıflandırması için önceden eğitilmiş bir BERT modeli yüklüyoruz ve bir LoRA konfigürasyonu tanımlıyoruz. r parametresi düşük dereceli güncellemenin sırasını belirtir ve lora_alpha güncelleme için bir ölçeklendirme faktörüdür. target_modules parametresi, modelin hangi katmanlarının düşük dereceli güncellemeleri alması gerektiğini belirtir. LoRA destekli modeli oluşturduktan sonra standart eğitim prosedürünü kullanarak ince ayar sürecine geçebiliriz.

Bağdaştırıcı Katmanları: LoRA'ya benzer, ancak düşük dereceli güncellemeler yerine, önceden eğitilmiş modelin her transformatör bloğunun içine ince "adaptör" katmanları eklenir. Yalnızca bu birkaç yeni kompakt katmanın parametreleri eğitilir.

Hızlı Ayarlama: Bu yaklaşım önceden eğitilmiş modelin tamamen donmasını sağlar. Bunun yerine, hedef görev için modelin önceden eğitilmiş bilgisini etkinleştirmek üzere girdi olarak eğitilebilir "istemli" yerleştirmeler sunulur.

Bu verimli yöntemler, tam ince ayara kıyasla hesaplamada 100 kata kadar azalma sağlayabilir ve aynı zamanda birçok görevde rekabetçi performans elde etmeye devam edebilir. Ayrıca tam model çoğaltmasını önleyerek depolama ihtiyaçlarını da azaltırlar.

Ancak performansları, genel dilden çok farklı olan veya daha bütünsel uzmanlık gerektiren görevler için tam ince ayarın gerisinde kalabilir.

İnce Ayar Süreci

İnce ayar stratejisinden bağımsız olarak, bir LLM'de uzmanlaşmaya yönelik genel süreç genel bir çerçeveyi takip eder:

- Veri Seti Hazırlama: Hedef göreviniz için girdileri (istemleri) istenen çıktılarla eşleştiren etiketli bir veri kümesi elde etmeniz veya oluşturmanız gerekecektir. Özetleme gibi metin oluşturma görevleri için bu, özetlenmiş çıktı çiftlerine yönelik girdi metni olacaktır.

- Veri Kümesi Bölme: En iyi uygulamaları takip ederek etiketli veri kümenizi eğitim, doğrulama ve test kümelerine bölün. Bu, verileri model eğitimi, hiper parametre ayarlama ve son değerlendirme için ayırır.

- Hiperparametre Ayarı: Verilerinizde en etkili ince ayarın yapılabilmesi için öğrenme oranı, toplu iş boyutu ve eğitim programı gibi parametrelerin ayarlanması gerekir. Bu genellikle küçük bir doğrulama kümesi içerir.

- Model Eğitimi: Ayarlanmış hiperparametreleri kullanarak, doğrulama kümesindeki modelin performansı iyileşmeyi bırakıncaya kadar (erken durma) tam eğitim kümesinde ince ayar optimizasyon işlemini çalıştırın.

- Değerlendirme: Gerçek dünya etkinliğini tahmin etmek için, ideal olarak hedef kullanım durumu için gerçek dünya örneklerini içeren, ince ayarlı modelin uzun süreli test setindeki performansını değerlendirin.

- Dağıtım ve İzleme: Tatmin edici olduğunda, ince ayarlı model yeni girdiler üzerinde çıkarım yapmak için kullanılabilir. Konsept sapması açısından zaman içindeki performansını ve doğruluğunu izlemek çok önemlidir.

Bu genel süreci özetlese de, birçok nüans, belirli bir Yüksek Lisans veya görev için ince ayar başarısını etkileyebilir. Müfredat öğrenimi, çoklu görevde ince ayar yapma ve birkaç adımlık yönlendirme gibi stratejiler performansı daha da artırabilir.

Ek olarak, verimli ince ayar yöntemleri ekstra hususları içerir. Örneğin LoRA, önceden eğitilmiş model çıktılarının bir birleştirme katmanı aracılığıyla koşullandırılması gibi teknikler gerektirir. İstemi ayarlama, doğru davranışları etkinleştirmek için dikkatle tasarlanmış istemlere ihtiyaç duyar.

Gelişmiş İnce Ayar: İnsan Geri Bildirimini Birleştirme

Etiketli veri kümelerini kullanan standart denetimli ince ayar etkili olsa da, heyecan verici bir sınır, LLM'leri doğrudan insan tercihlerini ve geri bildirimlerini kullanarak eğitmektir. Bu döngüdeki insan yaklaşımı, takviyeli öğrenmeden elde edilen tekniklerden yararlanır:

PPO (Proksimal Politika Optimizasyonu): Burada LLM, çıktıları "eylemler" olan bir takviyeli öğrenme aracısı olarak ele alınır. Bu çıktılar için insan derecelendirmelerini veya kalite puanlarını tahmin etmek üzere bir ödül modeli eğitilir. PPO daha sonra ödül modelinin puanlarını maksimuma çıkaran çıktılar üretmek için LLM'yi optimize eder.

RLHF (İnsan Geri Bildiriminden Güçlendirmeli Öğrenim): Bu, insan geribildirimini doğrudan öğrenme sürecine dahil ederek PPO'yu genişletir. Sabit bir ödül modeli yerine, ödüller, ince ayar sırasında LLM'nin çıktıları üzerine yinelenen insan değerlendirmelerinden gelir.

Hesaplama açısından yoğun olsa da, bu yöntemler, statik bir veri kümesinde yakalanabileceklerin ötesinde, insanlar tarafından değerlendirilen istenen özelliklere dayalı olarak LLM davranışının daha kesin bir şekilde şekillendirilmesine olanak tanır.

Anthropic gibi şirketler, Claude gibi dil modellerine görev yetkinliğinin ötesinde gelişmiş doğruluk, etik ve güvenlik farkındalığı kazandırmak için RLHF'yi kullandı.

Potansiyel Riskler ve Sınırlamalar

Son derece güçlü olmasına rağmen, LLM'lerin ince ayarının dikkatli bir şekilde yönetilmesi gereken riskleri vardır:

Önyargı Amplifikasyonu: İnce ayar verileri cinsiyet, ırk, yaş veya diğer niteliklerle ilgili toplumsal önyargılar içeriyorsa, model bu istenmeyen önyargıları güçlendirebilir. Temsili ve önyargısız veri kümelerinin seçilmesi çok önemlidir.

Gerçek Sürüklenme: Yüksek kaliteli verilere ince ayar yapıldıktan sonra bile, dil modelleri, daha uzun konuşmalar veya yönlendirmeler sonucunda yanlış gerçekleri veya eğitim örnekleriyle tutarsız çıktıları "halüsinasyona uğratabilir". Gerçekleri elde etme yöntemlerine ihtiyaç duyulabilir.

Ölçeklenebilirlik Zorlukları: GPT-3 gibi devasa modellerin tam ince ayarının yapılması, birçok kuruluş için mümkün olmayan çok büyük bilgi işlem kaynakları gerektirir. Verimli ince ayar bunu kısmen azaltır ancak ödünleşimleri vardır.

Felaket Unutuş: Tam ince ayar sırasında modeller, ön eğitim sırasında öğrenilen bazı genel yetenekleri kaybedecekleri felaketle sonuçlanabilecek bir unutma yaşayabilirler. Çok görevli öğrenmeye ihtiyaç duyulabilir.

IP ve Gizlilik Riskleri: İnce ayar için kullanılan özel veriler, halka açık dil modeli çıktılarına sızarak risk oluşturabilir. Farklı gizlilik ve bilgi tehlikesini azaltma teknikleri aktif araştırma alanlarıdır.

Genel olarak, son derece yararlı olsa da ince ayar, veri kalitesine, kimlik hususlarına, risklerin azaltılmasına ve kullanım senaryosu gereksinimlerine göre performans-verimlilik ödünleşimlerinin dengelenmesine dikkat edilmesini gerektiren incelikli bir süreçtir.

Gelecek: Geniş Ölçekte Dil Modeli Özelleştirmesi

İleriye baktığımızda, ince ayar ve model uyarlama tekniklerindeki ilerlemeler, çeşitli uygulamalar ve alanlardaki büyük dil modellerinin tüm potansiyelini ortaya çıkarmak için çok önemli olacaktır.

Kısıtlı kaynaklara sahip PaLM gibi daha büyük modellerde ince ayar yapılmasını sağlayan daha verimli yöntemler, erişimi demokratikleştirebilir. Veri kümesi oluşturma süreçlerini otomatikleştirmek ve hızlı mühendislik, uzmanlaşmayı kolaylaştırabilir.

Etiketsiz ham verilerden ince ayar yapmak için kendi kendini denetleyen teknikler yeni ufuklar açabilir. Farklı görevler veya veriler üzerinde eğitilmiş ince ayarlı alt modelleri birleştirmeye yönelik bileşimsel yaklaşımlar, talep üzerine oldukça özel modellerin oluşturulmasına olanak sağlayabilir.

Sonuçta, Yüksek Lisans'lar daha yaygın hale geldikçe, bunları akla gelebilecek her kullanım durumu için sorunsuz bir şekilde özelleştirme ve uzmanlaştırma yeteneği kritik hale gelecektir. İnce ayar ve ilgili model uyarlama stratejileri, büyük dil modellerinin her alanda ve çabada insan yeteneklerini artıran esnek, güvenli ve güçlü yapay zeka asistanları olduğu vizyonunu gerçekleştirmede önemli adımlardır.

Son beş yılımı, Makine Öğrenimi ve Derin Öğrenmenin büyüleyici dünyasına dalarak geçirdim. Tutkum ve uzmanlığım, özellikle AI/ML'ye odaklanarak 50'den fazla farklı yazılım mühendisliği projesine katkıda bulunmamı sağladı. Devam eden merakım, beni daha fazla keşfetmeye hevesli olduğum bir alan olan Doğal Dil İşleme'ye de çekti.

Beğenebilirsin

ChatGPT-4o Tanıtılıyor: Yeni Nesil Özellikler ve Dönüştürücü Etkileri

Lama 3 Hakkında Bilmeniz Gereken Her Şey | Şimdiye Kadarki En Güçlü Açık Kaynak Modeli | Kullanım Kavramları

BlackMamba: Durum-Uzay Modelleri için Uzmanların Karması

PostgreSQL Veritabanı için AI GPT'ler: Çalışabilirler mi?

GOAT (Aritmetik Görevlerinde İyi): Dil Yeterliliğinden Matematik Dehasına

Açık Kaynak ve Kapalı Kaynak Dil Modellerinin Savaşı: Teknik Bir Analiz

Son Yazılar

- Multimodal Marvel: GPT-4o'nun Son Teknoloji Yeteneklerini Keşfetmek

- Büyük Dil Modelleri veya Üretken Yapay Zeka Oluştururken Veritabanı Altyapınızda Uyumayın

- A2Hosting İncelemesi – Şimdiye Kadarki En Özellikli Web Host?

- En İyi 5 Güvenlik Açığı Değerlendirme Tarama Aracı (Mayıs 2024)

- Sentetik Politika Çağı: Yapay Zeka Tarafından Oluşturulan Kampanya Mesajlarının Etkisinin İncelenmesi