ปัญญาประดิษฐ์

บทนำสู่ Vertex AI

ด้วยภูมิทัศน์ของปัญญาประดิษฐ์ที่เปลี่ยนแปลงอย่างรวดเร็ว หนึ่งในอุปสรรคใหญ่ที่ผู้นำด้านเทคโนโลยีมักพบเจอคือการเปลี่ยนผ่านจาก “การทดลอง” ไปสู่ “ความพร้อมใช้งานสำหรับองค์กร” แม้ว่าแชทบอทสำหรับผู้บริโภคและแพลตฟอร์มแบบโต้ตอบจะช่วยกระตุ้นจินตนาการของสาธารณชนได้ แต่ธุรกิจไม่สามารถประสบความสำเร็จได้ด้วยเพียงแค่ส่วนต่อประสานการแชท ในยุคที่การแข่งขันดุเดือดกว่าที่เคย ธุรกิจต่างๆ ต้องการระบบนิเวศที่แข็งแกร่ง ปรับขนาดได้ และปลอดภัย และนี่คือสิ่งที่ Google พยายามนำเสนอด้วย เวอร์เท็กซ์ AIแพลตฟอร์มปัญญาประดิษฐ์และแมชชีนเลิร์นนิงแบบครบวงจรของ Google Cloud

Vertex AI พยายามที่จะสร้างความแข็งแกร่งให้กับตนเองในฐานะแกนหลักสำหรับการบูรณาการปัญญาประดิษฐ์เชิงสร้างสรรค์ (Generative AI) กับโครงสร้างพื้นฐานคลาวด์สมัยใหม่ โดยนำเสนอชุดคุณสมบัติที่ครอบคลุมซึ่งเชื่อมช่องว่างระหว่างโมเดลพื้นฐานและแอปพลิเคชันระดับใช้งานจริง Vertex AI ไม่ได้เป็นเพียงแค่ตัวห่อหุ้มโมเดลภาษาขนาดใหญ่ (LLM) เท่านั้น แต่เป็นระบบนิเวศการเรียนรู้ของเครื่องและปัญญาประดิษฐ์ (ML/AI) แบบครบวงจรที่ให้ความสำคัญกับปัญญาประดิษฐ์เชิงสร้างสรรค์ในฐานะองค์ประกอบสำคัญของโครงสร้างพื้นฐานคลาวด์สมัยใหม่

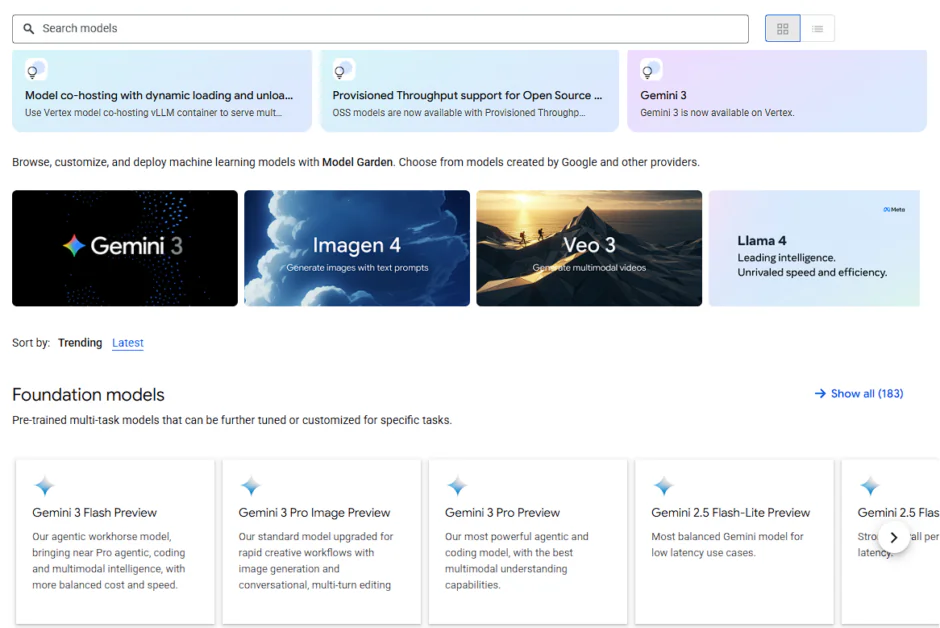

หัวใจสำคัญของ Vertex AI คือ... สวนจำลองเป็นตลาดกลางที่ให้การเข้าถึงโมเดลพื้นฐานที่คัดสรรมาแล้วกว่า 200 แบบ รวมถึง Gemini 2.5 Pro ซึ่งเป็นโมเดลทรงพลังแบบมัลติโมดอล ที่มีหน้าต่างบริบทขนาดมหาศาลถึง 2 ล้านโทเค็น ในบทความนี้ เราจะวิเคราะห์สถาปัตยกรรมของ Vertex AI สำรวจว่า Model Garden ทำหน้าที่เป็น “App Store” สำหรับระบบอัจฉริยะในอุตสาหกรรมได้อย่างไร และพิจารณาถึงเสาหลักทางเทคนิคที่ทำให้แพลตฟอร์มนี้เป็นแกนหลักของซอฟต์แวร์ระดับองค์กรยุคใหม่

สถาปัตยกรรมหลัก: แพลตฟอร์มแบบรวมศูนย์

Vertex AI ไม่ใช่ชุดเครื่องมือที่เชื่อมต่อกันอย่างหลวมๆ แต่เป็นระบบนิเวศข้อมูลและ AI ที่รวมเป็นหนึ่งเดียว ออกแบบมาเพื่อเชื่อมช่องว่างของข้อมูล เครื่องมือ และทีมงาน ที่เป็นปัญหาของการเรียนรู้ของเครื่องจักรในปัจจุบัน โดยทั่วไป การพัฒนา AI มักเกิดขึ้นในสภาพแวดล้อมที่แยกจากกัน และบางครั้ง ข้อมูลก็กระจัดกระจายและติดอยู่ตามแหล่งเก็บข้อมูลหลายแห่ง ตัวอย่างเช่น องค์กรอาจจัดเก็บข้อมูลลูกค้าไว้ในคลังข้อมูล SQL ในขณะที่เอกสารที่ไม่มีโครงสร้างถูกเก็บไว้ใน Data Lake เมื่อข้อมูลถูกแยกส่วน AI จะเห็นเพียง "ความจริงบางส่วน" ซึ่งนำไปสู่ผลลัพธ์ที่ลำเอียงหรืออัตราการเกิดภาพหลอนสูง เนื่องจากขาดบริบทที่สมบูรณ์ขององค์กร

Vertex AI พยายามบูรณาการวงจรชีวิตทั้งหมด ตั้งแต่การนำเข้าข้อมูลดิบใน BigQuery และ Cloud Storage ไปจนถึงการตรวจสอบการทำงานจริง โดยทำหน้าที่เป็นเหมือน "ตัวเชื่อม" ระหว่างระบบต่างๆ เหล่านี้ Vertex AI ผสานรวมเข้ากับ Cloud Storage และ BigQuery ได้อย่างราบรื่น ทำให้โมเดล AI สามารถดึงข้อมูลได้โดยไม่ต้องผ่านกระบวนการ Extraction, Transformation, and Load ที่ซับซ้อน

รากฐาน: ไฮเปอร์คอมพิวเตอร์ AI ของ Google

ชั้น GenAI ของ เวอร์เท็กซ์ AI ตั้งอยู่บนสถาปัตยกรรม AI Hypercomputer ของ Google ซึ่งเป็นระบบซูเปอร์คอมพิวเตอร์แบบบูรณาการที่ประกอบด้วย:

TPU v5p และ v5e (หน่วยประมวลผลเทนเซอร์)

หน่วยประมวลผลเทนเซอร์ของ Google เป็นวงจร ASIC (Application-Specific Integrated Circuits) ที่สร้างขึ้นเป็นพิเศษ ออกแบบมาโดยเฉพาะสำหรับการคูณเมทริกซ์ ซึ่งเป็นหัวใจสำคัญของการเรียนรู้เชิงลึก

- TPU v5p (ประสิทธิภาพ): นี่คือตัวเร่งความเร็วหลักสำหรับการฝึกอบรมขนาดใหญ่ แต่ละพ็อด TPU v5p สามารถขยายขนาดได้ถึง 8,960 ชิปที่เชื่อมต่อกันด้วย Inter-Chip Interconnect (ICI) ที่มีแบนด์วิดท์สูงสุดของ Google ที่ 4,800 Gbps สำหรับหัวหน้าทีมเทคโนโลยี นั่นหมายถึงการฝึกอบรมโมเดลขนาด GPT-3 (พารามิเตอร์ 175 พันล้านตัว) ได้เร็วขึ้น 2.8 เท่า เมื่อเทียบกับรุ่นก่อนหน้า ช่วยลดเวลาในการออกสู่ตลาดได้อย่างมาก

- TPU v5e (ประสิทธิภาพ): ออกแบบมาเพื่อประสิทธิภาพที่ "คุ้มค่าที่สุด" โปรเซสเซอร์ v5e จึงเป็นเครื่องมือสำคัญสำหรับการฝึกอบรมขนาดกลางและการประมวลผลข้อมูลปริมาณมาก ให้ประสิทธิภาพต่อราคาดีกว่าถึง 2.5 เท่า ทำให้เป็นตัวเลือกที่เหมาะสมสำหรับธุรกิจที่ต้องการใช้งานการประมวลผลข้อมูลตลอด 24 ชั่วโมง 7 วันต่อสัปดาห์ โดยไม่ต้องใช้งบประมาณมหาศาล

GPU NVIDIA H100/A100 เพื่อความยืดหยุ่น

แม้ว่า TPU จะเป็นอุปกรณ์เฉพาะทาง แต่ทีมพัฒนาจำนวนมากก็ยังคงพึ่งพาระบบนิเวศของ NVIDIA CUDA Vertex AI ให้การสนับสนุนชั้นเยี่ยมสำหรับฮาร์ดแวร์รุ่นล่าสุดของ NVIDIA:

- NVIDIA H100 (Hopper): เหมาะอย่างยิ่งสำหรับการปรับแต่งโมเดลโอเพนซอร์สขนาดใหญ่ที่สุด (เช่น Llama 3.1 405B) ที่ต้องการแบนด์วิดท์หน่วยความจำมหาศาล

- การเชื่อมต่อเครือข่าย Jupiter: เพื่อป้องกัน “ปัญหาคอขวดของเครือข่าย” Google ใช้โครงสร้างเครือข่ายศูนย์ข้อมูล Jupiter ซึ่งช่วยให้ข้อมูลเคลื่อนย้ายระหว่าง GPU ได้อย่างรวดเร็ว โดยรองรับ RDMA (Remote Direct Memory Access) เพื่อหลีกเลี่ยงภาระการทำงานของ CPU และมอบประสิทธิภาพใกล้เคียงกับเครื่องโลคอลในโหนดที่กระจายอยู่ทั่วกัน

การประสานเสียงแบบไดนามิก

การเปลี่ยนแปลงทางเทคนิคที่สำคัญที่สุดใน Vertex AI คือ การประสานเสียงแบบไดนามิกในสภาพแวดล้อมแบบเดิม หากโหนด GPU เกิดความล้มเหลวระหว่างการฝึกอบรมเป็นเวลา 3 สัปดาห์ งานทั้งหมดอาจล่มได้

- ความยืดหยุ่นอัตโนมัติ: Vertex AI ซึ่งมักขับเคลื่อนโดย เครื่องมือ Google Kubernetes (GKE) ภายใต้ระบบภายใน มีโหนด "ซ่อมแซมตัวเองได้" หากตรวจพบข้อผิดพลาดของฮาร์ดแวร์ แพลตฟอร์มจะย้ายภาระงานไปยังโหนดที่ใช้งานได้ปกติโดยอัตโนมัติ

- ตัวกำหนดตารางงานแบบไดนามิก: เครื่องมือนี้ช่วยให้ทีมสามารถขอใช้ทรัพยากรตามระดับความเร่งด่วนได้ คุณสามารถเลือกใช้ Flex Start (ราคาถูกกว่า เริ่มเมื่อมีทรัพยากรพร้อมใช้งาน) หรือ Guaranteed Capacity สำหรับการเปิดตัวผลิตภัณฑ์ที่สำคัญอย่างยิ่ง

- การฝึกอบรมด้าน Serverless: สำหรับทีมที่ไม่ต้องการการจัดการโครงสร้างพื้นฐานใดๆ เลย Vertex AI Serverless Training ช่วยให้คุณส่งโค้ดและข้อมูลของคุณไปได้ แพลตฟอร์มจะจัดหาคลัสเตอร์ รันงาน และลบระบบทิ้ง โดยคิดค่าบริการเฉพาะเวลาประมวลผลที่ใช้ไปเท่านั้น

สามจุดเริ่มต้น: การค้นพบ การทดลอง และระบบอัตโนมัติ

เพื่อรองรับบุคลากรด้านเทคนิคที่หลากหลาย ตั้งแต่นักวิทยาศาสตร์ข้อมูลไปจนถึงนักพัฒนาแอปพลิเคชัน Vertex AI จึงมีช่องทางการเข้าใช้งานหลักสามช่องทาง:

- สวนจำลอง: ตลาดแห่งการค้นพบ

- เวอร์เท็กซ์ เอไอ สตูดิโอ: สนามเด็กเล่นสำหรับการทดลอง

- Vertex AI Agent Builder: โรงงานแห่งระบบอัตโนมัติ

สวนต้นแบบ: ตลาดแห่งการค้นพบ

Vertex AI Model Garden ของ Google Cloud เป็นแพลตฟอร์มส่วนกลางภายใน Google Cloud สำหรับการค้นหา ทดสอบ ปรับแต่ง และใช้งานโมเดล AI หลากหลายประเภท ทั้งจากผู้พัฒนาเอง โอเพนซอร์ส และจากผู้พัฒนาภายนอก รวมถึงโมเดลแบบมัลติโมดอล (ภาพ ข้อความ โค้ด) เพื่อตอบสนองความต้องการทางธุรกิจต่างๆ โดยมีการผสานรวมอย่างราบรื่นกับเครื่องมือของ Vertex AI เพื่อการทำงาน MLOps ที่คล่องตัวยิ่งขึ้น แพลตฟอร์มนี้ทำหน้าที่เป็นคลังข้อมูลที่ครอบคลุม ช่วยให้นักพัฒนาและธุรกิจต่างๆ เลือกโมเดลที่เหมาะสม (ตั้งแต่โมเดลพื้นฐานขนาดใหญ่ไปจนถึงโมเดลเฉพาะทาง) สำหรับงานของตน ไม่ว่าจะเป็นการสร้างข้อความ การวิเคราะห์ภาพ หรือการเติมโค้ดอัตโนมัติ และใช้งานได้อย่างมีประสิทธิภาพภายในสภาพแวดล้อม Google Cloud ของตน

Model Garden แบ่งแบบจำลองกว่า 200 แบบออกเป็นสามระดับที่แตกต่างกัน ช่วยให้สถาปนิกสามารถสร้างสมดุลระหว่างประสิทธิภาพ ต้นทุน และการควบคุมได้:

- โมเดลจากฝ่ายแรก (Google): นี่คือโมเดลมัลติโมดอลระดับเรือธงที่มีให้บริการภายใน Vertex AI และ Google นำเสนอโมเดลเหล่านี้ในขนาดต่างๆ ตั้งแต่ระดับ Pro ที่มีความสามารถในการให้เหตุผลที่ซับซ้อน ไปจนถึงระดับ Flash ที่มีความหน่วงต่ำและปริมาณข้อมูลสูง ซึ่งช่วยให้นักพัฒนาสามารถปรับแต่งโมเดลให้เหมาะสมกับกรณีการใช้งานของตนได้

- โมเดลของบุคคลที่สาม (กรรมสิทธิ์): ด้วยความร่วมมือเชิงกลยุทธ์ Vertex AI นำเสนอการเข้าถึง "โมเดลในรูปแบบบริการ" (Model-as-a-Service หรือ MaaS) จากผู้ให้บริการ AI ชั้นนำ เช่น Anthropic (Claude 3.5) และ Mistral AI แทนที่จะต้องจัดการการเรียกเก็บเงินและข้อมูลรับรองความปลอดภัยแยกต่างหากสำหรับผู้ให้บริการ AI ห้าราย ทีมเทคโนโลยีสามารถเข้าถึงทั้งหมดได้ผ่านโครงการ Google Cloud ที่มีอยู่ โดยใช้รูปแบบ API ที่เป็นหนึ่งเดียว

- โมเดลโอเพนซอร์สและโอเพนเวท: ระดับนี้ประกอบด้วย ลามะของ Meta 3.2, Mistralและของ Google เอง เจมม่าสิ่งเหล่านี้เหมาะอย่างยิ่งสำหรับองค์กรที่ต้องการใช้งานโมเดลเหล่านี้ด้วยตนเองภายใน VPC (Virtual Private Cloud) เพื่อให้มั่นใจได้ถึงการแยกข้อมูลอย่างสูงสุด

ในสภาพแวดล้อมที่ไม่รวมเป็นหนึ่งเดียว การใช้งานโมเดลโอเพนซอร์สอย่าง Llama จำเป็นต้องตั้งค่าสภาพแวดล้อม PyTorch กำหนดค่าไดรเวอร์ CUDA และจัดการตัวเชื่อมต่อ Flask หรือ FastAPI

Model Garden ขจัดขั้นตอน "การสับเปลี่ยน" นี้ออกไปโดย... ปลายทางที่จัดการแบบรวม:

- การปรับใช้เพียงคลิกเดียว: สำหรับโมเดลหลายๆ รุ่น การคลิก “ปรับใช้” จะทำการจัดเตรียมทรัพยากร TPU/GPU ที่จำเป็นโดยอัตโนมัติ ห่อหุ้มโมเดลไว้ในคอนเทนเนอร์ที่พร้อมใช้งานจริง และจัดเตรียมจุดเชื่อมต่อ REST API ให้ด้วย

- การบูรณาการการกอดใบหน้า: ขณะนี้ Vertex AI อนุญาตให้นักพัฒนาสามารถปรับใช้โมเดลโดยตรงจาก Hugging Face Hub ไปยัง Vertex endpoint ซึ่งเป็นการขยายขีดความสามารถด้านปัญญาประดิษฐ์ได้อย่างแทบไม่มีที่สิ้นสุด

- บริการเชื่อมต่อส่วนตัว (PSC): สำหรับอุตสาหกรรมที่มีการควบคุมอย่างเข้มงวด สามารถนำแบบจำลองไปใช้งานได้โดยใช้ การเชื่อมต่อบริการส่วนตัวเพื่อให้มั่นใจว่าปลายทางของโมเดลจะไม่ถูกเปิดเผยสู่สาธารณะทางอินเทอร์เน็ต โดยจะจำกัดการรับส่งข้อมูลไว้เฉพาะภายในเครือข่ายขององค์กรเท่านั้น

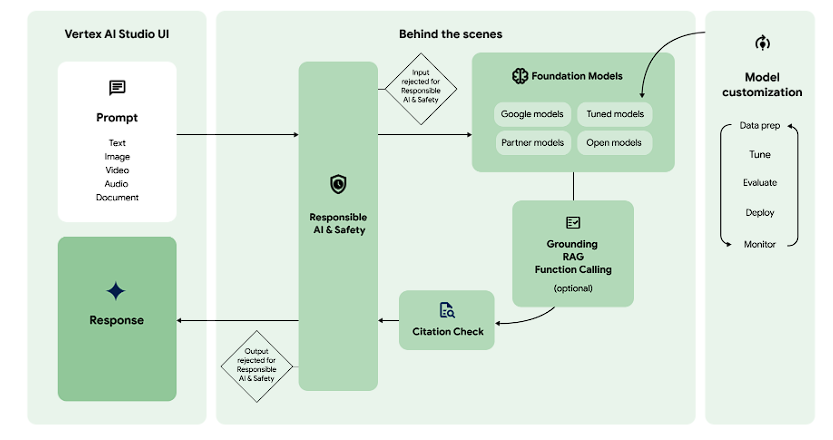

Vertex AI Studio: สนามเด็กเล่นสำหรับการทดลอง

ในขณะที่ สวนจำลอง เกี่ยวกับการคัดเลือก เวอร์เท็กซ์ เอไอ สตูดิโอ เกี่ยวกับ ความแม่นยำ Vertex AI Studio เปรียบได้กับคอมไพเลอร์และดีบักเกอร์ที่คุณพบเห็นในโลกของซอฟต์แวร์แบบดั้งเดิม Vertex AI Studio คือพื้นที่ทำงานที่ใช้ในการปรับแต่งโมเดลดิบให้เป็นเครื่องมือทางธุรกิจเฉพาะด้าน ผ่านการผสมผสานระหว่างการออกแบบอย่างรวดเร็ว การทดสอบแบบหลายรูปแบบ และการปรับแต่งพารามิเตอร์ขั้นสูง

การสร้างต้นแบบแบบมัลติโมดอล: นอกเหนือจากข้อความ

หนึ่งในคุณสมบัติเด่นของ Studio คือการรองรับแบบเนทีฟสำหรับ ความหลากหลายในขณะที่แพลตฟอร์มอื่นๆ ต้องการการเขียนโค้ดที่ซับซ้อนเพื่อจัดการกับข้อมูลที่ไม่ใช่ข้อความ แต่ Vertex AI Studio ช่วยให้คุณสามารถลากไฟล์ลงในอินเทอร์เฟซโดยตรงเพื่อทดสอบได้ ราศีเมถุน 2.5 ความสามารถในการใช้เหตุผล

- วิดีโออินเทลลิเจนซ์: คุณสามารถอัปโหลดคลิปนำเสนอทางเทคนิคความยาว 45 นาที และขอให้โมเดล "ระบุทุกครั้งที่มีการกล่าวถึง API เฉพาะ และแสดงสรุปพร้อมระบุเวลา"

- การวิเคราะห์เอกสาร: แทนที่จะอ่านข้อความเพียงอย่างเดียว โมเดลนี้สามารถวิเคราะห์ได้ รูปแบบภาพ จากไฟล์ PDF ขนาด 1,000 หน้า ต้องเข้าใจความสัมพันธ์ระหว่างแผนภูมิ ตาราง และข้อความโดยรอบ

- การดำเนินการโค้ด: สตูดิโอรองรับแล้ว การเรียกใช้โค้ดในพื้นที่ทดลองหากคุณขอให้โมเดลแก้ปัญหาทางคณิตศาสตร์ที่ซับซ้อนหรือวิเคราะห์ไฟล์ CSV โมเดลสามารถเขียนและเรียกใช้โค้ด Python ในสภาพแวดล้อมแบบแซนด์บ็อกซ์ที่ปลอดภัยเพื่อให้ได้คำตอบที่ผ่านการตรวจสอบแล้ว

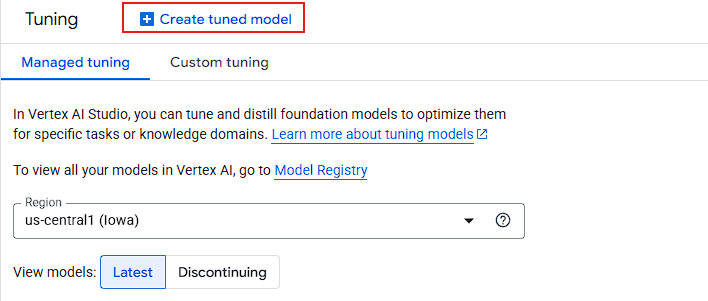

การปรับแต่งขั้นสูง: เส้นทางการปรับแต่ง

เมื่อการพัฒนาซอฟต์แวร์แบบรวดเร็ว (Zero-shot หรือ Few-shot) ถึงขีดจำกัดสูงสุด Vertex AI Studio จะนำเสนอเครื่องมือขั้นสูงมาช่วย: การปรับแต่งโมเดล.

- การปรับแต่งอย่างละเอียดภายใต้การกำกับดูแล (SFT): นักพัฒนาจะจัดเตรียมชุดข้อมูลคู่ "คำถาม/คำตอบ" (โดยควรมีมากกว่า 100 ตัวอย่าง) เพื่อฝึกให้โมเดลปรับใช้โทนเสียงของแบรนด์ รูปแบบผลลัพธ์ (เช่น JSON เฉพาะทาง) หรือศัพท์เฉพาะทางด้านนั้นๆ

- การแคชบริบท: สำหรับองค์กรที่ต้องจัดการกับชุดข้อมูลขนาดใหญ่และคงที่ (เช่น ห้องสมุดกฎหมายหรือฐานรหัสโปรแกรม) Studio ช่วยให้สามารถ... การแคชบริบทวิธีนี้ช่วยให้คุณสามารถ "โหลด" ข้อมูลจำนวนล้านโทเค็นลงในหน่วยความจำของโมเดลได้ล่วงหน้า ซึ่งจะช่วยลดเวลาแฝงและค่าใช้จ่ายสำหรับการสืบค้นข้อมูลในภายหลังได้อย่างมาก

- การกลั่น (ครู-นักเรียน): นี่คือกลยุทธ์ทางสถาปัตยกรรมระดับสูง คุณสามารถใช้โมเดลขนาดใหญ่ (Gemini 2.5 Pro) เพื่อ "สอน" โมเดลขนาดเล็กกว่าและเร็วกว่า (Gemini 2.0 Flash) ผลลัพธ์ที่ได้คือโมเดลน้ำหนักเบาที่มีประสิทธิภาพในระดับ "โปร" แต่ทำงานด้วยความเร็วและต้นทุนแบบ "Flash"

Vertex AI Agent Builder: โรงงานแห่งระบบอัตโนมัติ

Vertex AI Agent Builder เป็นเฟรมเวิร์กการจัดการระดับสูงที่ช่วยให้นักพัฒนาสามารถสร้างเอเจนต์เหล่านี้ได้โดยการผสมผสานโมเดลพื้นฐานเข้ากับข้อมูลระดับองค์กรและ API ภายนอก

สถาปัตยกรรมแห่ง “ความจริง”: การวางรากฐานและ RAG

อุปสรรคทางเทคนิคที่สำคัญที่สุดสำหรับ AI ในระดับองค์กรคือ ภาพหลอนAgent Builder แก้ปัญหานี้ด้วยวิธีการที่ซับซ้อน Grounding เครื่องยนต์

- การเชื่อมต่อข้อมูลกับ Google Search: สำหรับคำถามที่ต้องการข้อมูลแบบเรียลไทม์ (เช่น “อัตราดอกเบี้ยสินเชื่อบ้านในนิวยอร์กปัจจุบันอยู่ที่เท่าไร?”) ตัวแทนสามารถค้นหาข้อมูลผ่าน Google Search ดึงข้อมูลออกมา และอ้างอิงแหล่งที่มาได้

- Vertex AI Search (RAG-as-a-Service): แทนที่จะสร้างฐานข้อมูลเวกเตอร์ด้วยตนเอง (เช่น Pinecone, Weaviate) นักพัฒนาสามารถใช้... การค้นหาจุดยอด AI เพื่อจัดทำดัชนีเอกสารของตนเอง (PDF, HTML, BigQuery) โดยจะจัดการขั้นตอน "การแบ่งส่วน" "การฝัง" และ "การดึงข้อมูล" โดยอัตโนมัติ ทำให้มั่นใจได้ว่าเอเจนต์จะตอบกลับโดยอิงจาก "แหล่งข้อมูลที่ถูกต้อง" ภายในของคุณเท่านั้น

- Vertex AI RAG Engine: สำหรับการใช้งานแบบกำหนดเองในระดับสูง บริการจัดการนี้ช่วยให้สามารถค้นหาแบบไฮบริด (ผสมผสานผลลัพธ์แบบเวกเตอร์และแบบคีย์เวิร์ด) เพื่อเพิ่มความแม่นยำได้สูงสุดถึง สูงกว่าผลลัพธ์มาตรฐานของหลักสูตร LLM 30%.

การจัดการระบบแบบหลายเอเจนต์ (โปรโตคอล A2A)

เวิร์กโฟลว์ระดับองค์กรขั้นสูงมักต้องการตัวแทนผู้เชี่ยวชาญหลายคนทำงานร่วมกัน Vertex AI ขอแนะนำ... โปรโตคอลตัวแทนต่อตัวแทน (A2A)มาตรฐานแบบเปิดที่อนุญาตให้:

- “ตัวแทนท่องเที่ยว” เพื่อพูดคุยกับ “ตัวแทนด้านการเงิน” เพื่อให้แน่ใจว่าการจองเที่ยวบินอยู่ในงบประมาณของบริษัท

- ความสามารถในการทำงานร่วมกัน: เนื่องจากใช้โปรโตคอลแบบเปิด เอเจนต์ที่สร้างบน Vertex จึงสามารถสื่อสารกับเอเจนต์ที่สร้างบนเฟรมเวิร์กอื่นๆ เช่น LangChain หรือ CrewAI ได้

เครื่องมือสำหรับนักพัฒนา: ADK และ Agent Engine

สำหรับกลุ่มเป้าหมาย “แพลตฟอร์มเทคโนโลยี” นั้น Agent Builder นำเสนอสองเส้นทางที่แตกต่างกัน:

- คอนโซลแบบไม่ต้องเขียนโค้ด: อินเทอร์เฟซแบบลากและวางที่ใช้งานง่ายสำหรับการสร้างต้นแบบอย่างรวดเร็วและการกำหนดค่าสำหรับผู้ใช้ทางธุรกิจ

- ชุดพัฒนาเอเจนต์ (ADK): ชุดเครื่องมือ Python สำหรับวิศวกรที่เน้นการเขียนโค้ดเป็นหลัก ช่วยให้สามารถใช้งาน "Prompt-as-Code" ผสานรวมระบบควบคุมเวอร์ชัน และสามารถปรับใช้ไปยังระบบต่างๆ ได้ เครื่องมือตัวแทน Vertex AI—รันไทม์แบบจัดการที่ดูแลการคงอยู่ของเซสชัน การปรับขนาด และการจัดการสถานะโดยอัตโนมัติ

สรุป: จาก “ถ้าหากว่า” สู่ “อะไรจะเกิดขึ้นต่อไป”

การเปลี่ยนผ่านจากการสาธิต AI ที่น่าตื่นตาตื่นใจไปสู่แอปพลิเคชันระดับองค์กรที่ใช้งานได้จริงนั้น ถือเป็น "หุบเขาแห่งความตาย" สำหรับโครงการเปลี่ยนแปลงทางดิจิทัลมาอย่างยาวนาน ดังที่เราได้กล่าวไปแล้ว Vertex AI ได้รับการออกแบบมาโดยเฉพาะเพื่อเชื่อมช่องว่างนี้ ด้วยการรวมข้อมูลที่กระจัดกระจาย โครงสร้างพื้นฐาน และการจัดการโมเดลเข้าด้วยกัน Google Cloud ได้เปลี่ยนหัวข้อสนทนาจากการเน้นพลังดิบของโมเดลภาษาขนาดใหญ่ไปสู่การใช้งานจริง ความครบถ้วนในการดำเนินงาน ของวงจรชีวิตของ AI