Угол Андерсона

Почему языковые модели «теряются» в разговоре

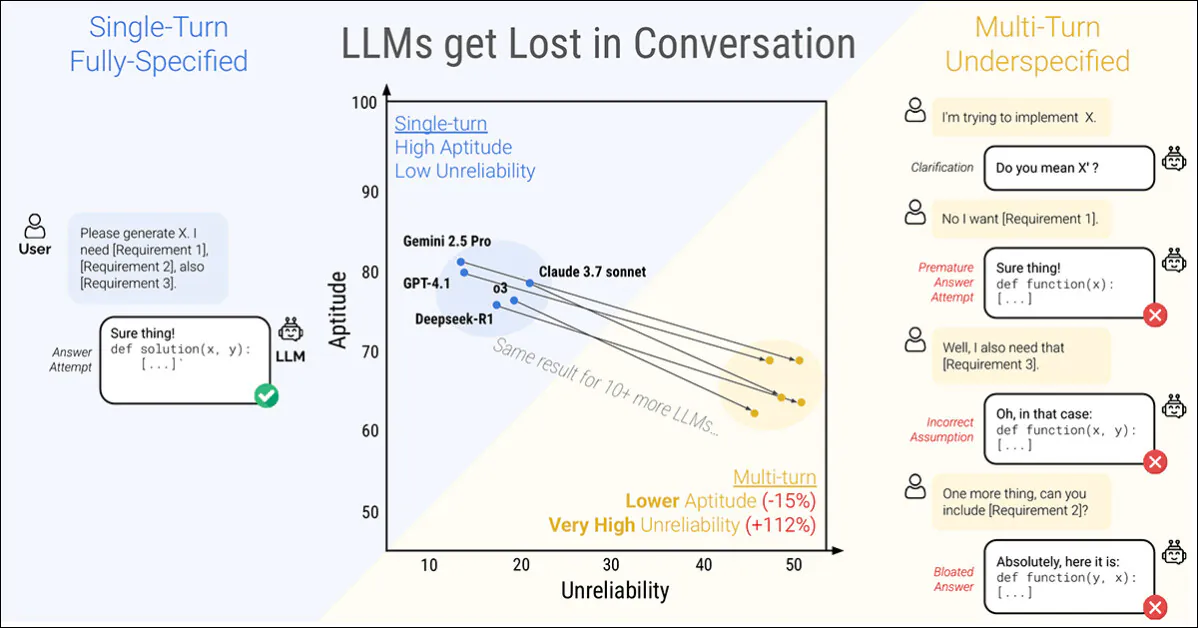

В новом исследовании Microsoft Research и Salesforce говорится, что даже самые способные Большие языковые модели (LLM) разваливаются, когда им дают инструкции поэтапно а не все сразу. Авторы обнаружили, что производительность падает в среднем на 39 процентов по шести задачам, когда подсказка разделить на несколько ходов:

Однократный разговор (слева) дает наилучшие результаты, но неестественный для конечного пользователя. Многократный разговор (справа) обнаруживает, что даже самые высоко оцененные и наиболее производительные LLM теряют эффективный импульс в разговоре. Источник: https://arxiv.org/pdf/2505.06120

Еще более поразительно то, что надежность откликов резко падает, и такие престижные модели, как ЧатGPT-4.1 и Близнецы 2.5 Про колебания между почти идеальными ответами и явными провалами в зависимости от того, как сформулирована одна и та же задача; кроме того, согласованность вывода может снизиться более чем вдвое в ходе процесса.

Для изучения этого поведения в статье представлен метод, называемый Sharding*, который разбивает полностью определенные подсказки на более мелкие фрагменты и выпускает их по одной в беседе.

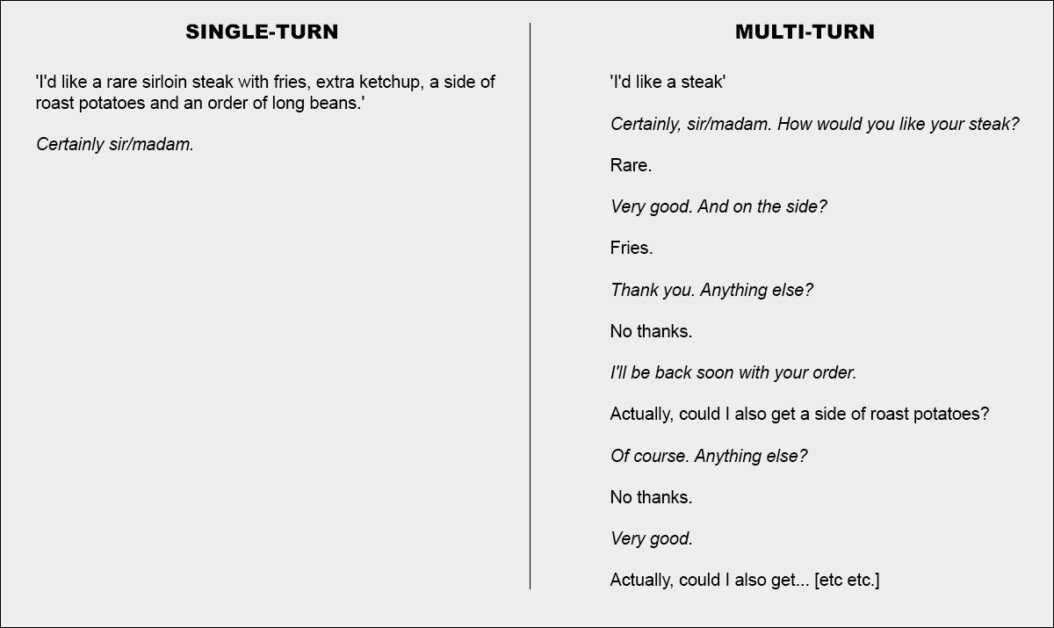

Проще говоря, это эквивалентно единому и понятному заказу в ресторане, когда официанту ничего не остается, кроме как подтвердить просьбу; или же он решает совместно заняться решением вопроса:

Две крайние версии разговора в ресторане (не из новой статьи, исключительно в иллюстративных целях).

Для акцента, пример выше, возможно, выставляет клиента в негативном свете. Но основная идея, изображенная во втором столбце, заключается в транзакционном обмене, который проясняет набор проблем, прежде чем решать проблемы – по-видимому, рациональный и разумный способ подхода к задаче.

Эта установка отражена в новой работе, которая подается постепенно, сегментированный подход к взаимодействию LLM. Авторы отмечают, что LLM часто генерируют слишком длинные ответы, а затем продолжают полагаться на собственные идеи даже после того, как было показано, что эти идеи неверны или неактуальныЭта тенденция в сочетании с другими факторами может привести к тому, что система полностью потеряет контроль над обменом.

На самом деле, исследователи отмечают то, что многие из нас обнаружили анекдотично – что лучший способ вернуть разговор в нужное русло – это начать новый разговор с магистром права.

«Если разговор с магистром права не привел к ожидаемым результатам, начало нового разговора, в котором повторяется та же информация, может дать значительно лучшие результаты, чем продолжение текущего разговора.

«Это связано с тем, что нынешние LLM могут теряться в разговоре, и наши эксперименты показывают, что настойчивое продолжение разговора с моделью неэффективно. Кроме того, поскольку LLM генерируют текст случайным образом, новый разговор может привести к лучшим результатам».

Авторы признают, что агентные системы, такие как Автоген or Лангчейн могут потенциально улучшить результаты, выступая в качестве интерпретативных слоев между конечным пользователем и LLM, взаимодействуя с LLM только после того, как они соберут достаточно «шадрированных» ответов для объединения в единый связный запрос (с которым конечный пользователь не столкнется).

Однако авторы утверждают, что отдельный уровень абстракции не нужен или должен быть встроен непосредственно в исходный LLM:

«Можно утверждать, что многопоточные возможности не являются обязательной функцией LLM, поскольку их можно переложить на фреймворк агента. Другими словами, нужна ли нам встроенная поддержка многопоточных возможностей в LLM, если фреймворк агента может организовывать взаимодействие с пользователями и использовать LLM только как однопоточные операторы?…»

Но, проверив это предположение на множестве примеров, они приходят к выводу:

«[Использование] агентоподобной структуры для обработки информации может быть ограничивающим фактором, и мы считаем, что LLM должны изначально поддерживать многопоточное взаимодействие».

Это интересно Новый документ называется LLM теряются в многовариантном разговоре, и исходит от четырех исследователей из MS Research и Salesforce,

Фрагментированные беседы

Новый метод сначала разбивает обычные одношаговые инструкции на более мелкие фрагменты, предназначенные для введения в ключевые моменты во время взаимодействия LLM, — структура, которая отражает исследовательский, возвратно-поступательный стиль взаимодействия, наблюдаемый в таких системах, как ChatGPT или Google Gemini.

Каждая оригинальная инструкция представляет собой отдельную, самостоятельную подсказку, которая предоставляет всю задачу за один раз, объединяя вопрос высокого уровня, поддерживающий контекст и любые соответствующие условия. Шардированная версия разбивает это на несколько более мелких частей, причем каждый шард добавляет только один фрагмент информации:

Парные инструкции, показывающие (a) полную подсказку, доставленную за один ход, и (b) ее фрагментированную версию, используемую для имитации недостаточно определенного многоходового взаимодействия. Семантически каждая версия доставляет одинаковую информационную нагрузку.

Первый осколок всегда вводит основную цель задачи, а остальные предоставляют уточняющие детали. Вместе они передают то же содержание, что и исходная подсказка, но естественным образом распределяются по нескольким поворотам в разговоре.

Каждый моделируемый разговор разворачивается между тремя компонентами: помощник, оцениваемая модель; пользователь, имитируемый агент с доступом к полной инструкции в шардированной форме; и система, который наблюдает и оценивает обмен.

Разговор начинается с того, что пользователь раскрывает первый осколок, а помощник отвечает свободно. Затем система классифицирует этот ответ в одну из нескольких категорий, например запрос на разъяснение или полная попытка ответа.

Если модель приносит попытка ответа, отдельный компонент извлекает только соответствующий диапазон для оценки, игнорируя любой окружающий текст. На каждом новом ходу пользователь раскрывает один дополнительный осколок, вызывая другой ответ. Обмен продолжается до тех пор, пока модель не даст правильный ответ или не останется никаких осколков для раскрытия:

Схема моделирования сегментированного разговора, где оцененная модель выделена красным цветом.

Ранние тесты показали, что модели часто спрашивали об информации, которая еще не была предоставлена, поэтому авторы отказались от идеи раскрытия осколков в фиксированном порядке. Вместо этого использовался симулятор, чтобы решить, какой осколок раскрыть следующим, на основе того, как проходил разговор.

Таким образом, симулятор пользователя, реализованный с использованием GPT-4o-mini, получил полный доступ как ко всей инструкции, так и к истории разговора, и ему было поручено на каждом шагу решать, какой шард раскрыть следующим, исходя из того, как разворачивался обмен.

Пользовательский симулятор также перефразированный Каждый фрагмент поддерживал коммуникацию, не искажая смысл. Это позволяло симуляции отражать «взаимообмен» реального диалога, сохраняя при этом контроль над структурой задачи.

Перед началом разговора помощнику предоставляется только основная информация, необходимая для выполнения задачи, например, схема базы данных или ссылка на API. Ему не сообщается, что инструкции будут разбиты, и он не ориентируется на какой-либо конкретный способ ведения разговора. Это сделано намеренно: в реальном использовании моделям почти никогда не говорят, что подсказка будет неполной или будет обновляться с течением времени, и исключение этого контекста помогает моделированию отражать, как модель ведет себя в более реалистичном контексте.

GPT-4o-mini также использовался для принятия решения о том, как следует классифицировать ответы модели, и для извлечения любых окончательных ответов из этих ответов. Это помогло симуляции оставаться гибкой, но вносило случайные ошибки: однако, проверив вручную несколько сотен разговоров, авторы обнаружили, что менее пяти процентов имели какие-либо проблемы, а менее двух процентов показали изменение результата из-за них, и они посчитали это достаточно низким уровнем ошибок в рамках параметров проекта.

Сценарии моделирования

Авторы использовали пять типов моделирования для проверки поведения модели в различных условиях, каждый из которых представлял собой вариацию того, как и когда раскрываются части инструкции.

В Длинный настройка, модель получает всю инструкцию за один ход. Это представляет собой стандартный формат бенчмарка и служит базовым уровнем производительности.

Команда Sharded настройка разбивает инструкцию на несколько частей и доставляет их по одной за раз, имитируя более реалистичный, недоопределенный разговор. Это основная настройка, используемая для проверки того, насколько хорошо модели справляются с многооборотным вводом.

В Конкат настройка, осколки сшиваются обратно в единый список, сохраняя их формулировки, но удаляя пошаговую структуру. Это помогает изолировать эффекты разговорной фрагментации от перефразирования или потери контента.

Команда Краткое содержание настройка работает как Sharded, но добавляет последний поворот, где все предыдущие осколки переформулируются, прежде чем модель даст окончательный ответ. Это проверяет, может ли подсказка резюме помочь восстановить потерянный контекст.

Наконец, Снежный ком идет дальше, повторяя все предыдущие осколки на каждом ходу, сохраняя полную инструкцию видимой по мере развития разговора и предлагая более щадящий тест на способность к многоходовкам.

Типы симуляции на основе фрагментированных инструкций. Полностью заданная подсказка разбивается на более мелкие части, которые затем можно использовать для симуляции однооборотных (Full, Concat) или многооборотных (Sharded, Recap, Snowball) разговоров, в зависимости от того, насколько быстро раскрывается информация.

Задачи и метрики

Было выбрано шесть задач по генерации кода, охватывающих как программирование, так и область естественного языка: подсказки по генерации кода были взяты из HumanEval и LiveCodeBench; Запросы Text-to-SQL были получены из Spiders; Вызовы API были созданы с использованием данных из Таблица лидеров по вызову функций Беркли; элементарные математические задачи были предоставлены GSM8K; задания по табличному созданию подписей были основаны на ToTTo; и Многодокументные резюме были составлены из Краткое содержание стога сена набор данных.

Эффективность модели измерялась с использованием трех основных показателей: средняя производительность, способность и ненадежность.

Средняя производительность фиксировалось, насколько хорошо модель показала себя в целом после нескольких попыток; способность отражали наилучшие результаты, которых могла достичь модель, основываясь на ее самых высоких результатах; и ненадежность измеряли, насколько сильно варьировались эти результаты, при этом большие разрывы между лучшими и худшими результатами указывали на менее стабильное поведение.

Все оценки были выставлены по шкале от 0 до 100, чтобы обеспечить единообразие между заданиями, а метрики вычислялись для каждой инструкции, а затем усреднялись для получения общей картины эффективности модели.

Шесть шардированных задач, используемых в экспериментах, охватывающих как программирование, так и генерацию естественного языка. Каждая задача показана с полностью определенной инструкцией и ее шардированной версией. От 90 до 120 инструкций были адаптированы из установленных контрольных показателей для каждой задачи.

Претенденты и тесты

В ходе первоначального моделирования (предполагаемая стоимость которого составила 5000 долларов США) 600 инструкций, охватывающих шесть задач, были разделены и использовались для моделирования трех типов разговоров: полный, CONCAT и сегментированныйДля каждой комбинации модели, инструкции и типа симуляции было проведено десять бесед, что в общей сложности дало более 200,000 XNUMX симуляций — схема, которая позволила фиксировать как общую производительность, так и более глубокие показатели способностей и надежности.

Было протестировано пятнадцать моделей, охватывающих широкий спектр поставщиков и архитектур: модели OpenAI ГПТ-4о (версия 2024-11-20), GPT-4o-мини (2024), GPT-4.1 (2025-04-14) и модель мышления o3 (2025-04-16).

Антропные модели были Клод 3 Хайку (2024-03-07) и Клод 3.7 Сонет (2025), доступ через Amazon Bedrock.

Google внес вклад Близнецы 2.5 Флэш (превью-04-17) и Близнецы 2.5 Про (превью-03-25). Мета-модели были Лама 3.1-8Б-Инструкт и Лама 3.3-70Б-Инструкт, так же как Лама 4 Скаут-17Б-16Э, через Together AI.

Другие записи были ОЛМо 2 13Б, Фи-4 и Command-A, доступ ко всем из которых осуществляется локально через API Ollama или Cohere; и Deepseek-R1, доступ к которому осуществляется через Amazon Bedrock.

Для двоих «думая» модели (o3 и R1), лимиты токенов были увеличены до 10,000 XNUMX для поддержки более длинных цепочек рассуждений:

Средние оценки производительности для каждой модели по шести задачам: код, база данных, действия, данные в текст, математика и сводка. Результаты показаны для трех типов моделирования: полное, объединенное и сегментированное. Модели упорядочены по их средней оценке полной настройки. Затенение отражает степень падения производительности по сравнению с полной настройкой, а последние два столбца показывают среднее снижение для объединенного и сегментированного относительно полной настройки.

Относительно этих результатов авторы заявляют:†:

«На высоком уровне, производительность каждой модели снижается при выполнении каждой задачи при сравнении производительности FULL и SHARDED, со средней деградацией -39%. Мы называем это явление Потерянный в разговоре: модели, которые достигают выдающихся (90%+) результатов в лабораторных условиях полностью определенных однопоточных разговорных проблем на тех же самых задачах в более реалистичной обстановке, когда разговор неконкретен и многовариантен».

Конкат средние баллы составили 95 процентов полный, что указывает на то, что падение производительности в настройках sharded не может быть объяснено потерей информации. Меньшие модели, такие как Llama3.1-8B-Instruct, OLMo-2-13B и Claude 3 Haiku, показали более выраженную деградацию при CONCAT, что говорит о том, что меньшие модели, как правило, менее устойчивы к перефразированию, чем большие.

Авторы отмечают†:

«Удивительно, Более производительные модели (Claude 3.7 Sonnet, Gemini 2.5, GPT-4.1) в равной степени теряются в разговоре по сравнению с более мелкими моделями (Llama3.1-8B-Instruct, Phi-4)), со средними ухудшениями на 30-40%. Это отчасти связано с метрическими определениями. Поскольку меньшие модели достигают более низких абсолютных оценок в ПОЛНЫЙ, у них меньше возможностей для деградации, чем у лучших моделей.

«Короче говоря, независимо от того, насколько хороши однооборотные характеристики LLM, мы наблюдаем значительное ухудшение характеристик в многооборотных условиях».

Первоначальный тест показывает, что некоторые модели лучше справились с определенными задачами: Command-A с Actions, Claude 3.7 Sonnet и GPT-4.1 с code; и Gemini 2.5 Pro с Data-to-Text, что указывает на то, что способность к многооборотному мышлению варьируется в зависимости от области. Модели рассуждений, такие как o3 и Deepseek-R1, в целом не показали лучших результатов, возможно, потому, что их более длинные ответы вводили больше предположений, что, как правило, запутывало разговор.

Надежность

Связь между способностями и надежностью, очевидная в однооборотных симуляциях, по-видимому, развалилась в многооборотных условиях. В то время как способности снизились лишь незначительно, ненадежность удвоился в среднем. Модели, которые были стабильны в полноформатных подсказках, таких как GPT-4.1 и Gemini 2.5 Pro, стали такими же нестабильными, как и более слабые модели, такие как Llama3.1-8B-Instruct или OLMo-2-13B, после того, как инструкция была фрагментирована.

Обзор способностей и ненадежности, представленный на диаграмме (a), за которой следуют результаты надежности, полученные в ходе экспериментов с пятнадцатью моделями (b), и результаты теста постепенного дробления, в ходе которого инструкции были разделены на от одного до восьми фрагментов (c).

Ответы модели часто различались на целых 50 баллов при выполнении одного и того же задания, даже когда не добавлялось ничего нового, что позволяет предположить, что падение производительности было вызвано не недостатком навыков, а тем, что модель становилась все более нестабильной между ходами.

В документе говорится:†:

'[Хотя] лучшие модели, как правило, имеют немного более высокую способность к многооборотному движению, все модели, как правило, имеют схожие уровни ненадежности. Другими словами, в многооборотных, недостаточно определенных настройках все модели, которые мы тестируем, демонстрируют очень высокую ненадежность, при этом производительность снижается в среднем на 50 процентов между лучшим и худшим смоделированным запуском для фиксированной инструкции».

Чтобы проверить, связано ли снижение производительности с количеством ходов, авторы провели эксперимент по постепенному фрагментированию, разделив каждую инструкцию на от одного до восьми фрагментов (см. крайний правый столбец на изображении выше).

По мере увеличения количества осколков ненадежность неуклонно росла, подтверждая, что даже незначительное увеличение количества ходов делало модели более нестабильными. Способность осталась практически неизменной, что подтверждает, что проблема заключается в согласованность, а не способность.

Контроль температуры

Отдельный набор экспериментов проверял, является ли ненадежность просто побочным продуктом случайности. Для этого авторы варьировали настройку температуры как помощника, так и симулятора пользователя в трех значениях: 1.0, 0.5 и 0.0.

В однооборотных форматах, таких как полный и CONCAT, снижение температуры помощника значительно повысило надежность, сократив отклонения на целых 80 процентов; но в сегментированный обстановка, то же самое вмешательство имело незначительный эффект:

Оценки ненадежности для различных комбинаций температуры помощника и пользователя при полных, объединенных и сегментированных настройках, при этом более низкие значения указывают на большую согласованность ответа.

Даже когда и помощник, и пользователь были настроены на нулевую температуру, ненадежность оставалась высокой, при этом GPT-4o показывал отклонение около 30 процентов, что говорит о том, что нестабильность, наблюдаемая в многопоточных разговорах, не просто стохастический шум, но структурная слабость в том, как модели обрабатывают фрагментированные входные данные.

Значение

В заключении статьи авторы необычно подробно описывают последствия своих выводов, утверждая, что высокие показатели работы в один оборот не гарантируют надежности в многооборотном режиме, и предостерегая от чрезмерной опоры на полностью определенные контрольные показатели при оценке готовности к реальным условиям (поскольку такие контрольные показатели скрывают нестабильность в более естественных, фрагментированных взаимодействиях).

Они также предполагают, что ненадежность — это не просто артефакт выборки, а фундаментальное ограничение в том, как текущие модели обрабатывают меняющиеся входные данные, и они предполагают, что это вызывает опасения относительно структур агентов, которые зависят от постоянных рассуждений между ходами.

Наконец, они утверждают, что способность к многооборотному обучению следует рассматривать как основную способность магистра права, а не как нечто, переданное внешним системам.

Авторы отмечают, что их результаты, вероятно, недооценивать истинный масштаб проблемы и обратить внимание на идеальные условия теста: симулятор пользователя в их установке имел полный доступ к инструкции и мог раскрывать осколки в оптимальном порядке, что давало помощнику нереалистично благоприятный контекст (в реальном использовании пользователи часто предоставляют фрагментарные или неоднозначные подсказки, не зная, что модель должна услышать дальше).

Кроме того, помощник был оценен немедленно после каждого поворота, до того, как разворачивался полный разговор, предотвращая последующее замешательство или внутреннее противоречие от штрафа, что в противном случае ухудшило бы производительность. Эти выборы, хотя и необходимы для экспериментального контроля, означают, что разрывы в надежности, наблюдаемые на практике, вероятно, будут даже больше, чем сообщалось.

Они заключают:

«[Мы] считаем, что проведенное моделирование представляет собой благоприятный испытательный полигон для многооборотных возможностей LLM. Из-за чрезмерно упрощенных условий моделирования мы полагаем, что наблюдаемая в экспериментах деградация, скорее всего, является недооценкой ненадежности LLM и того, насколько часто LLM теряются в разговоре в реальных условиях."

Заключение

Любой, кто провел значительное количество времени с LLM, вероятно, узнает сформулированные здесь проблемы по практическому опыту; и большинство из нас, я полагаю, интуитивно отказались от «потерянных» разговоров LLM в пользу новых, в надежде, что LLM сможет «начать заново» и перестанет зацикливаться на материале, возникшем в ходе долгого, извилистого и все более раздражающего обмена мнениями.

Интересно отметить, что предоставление большего контекста проблеме не обязательно решит ее; и действительно, можно заметить, что статья поднимает больше вопросов, чем дает ответов (за исключением способов обойти проблему).

* Как ни странно, это не имеет никакого отношения к традиционное значение термина «шардинг» в ИИ.

† Яркие акценты авторов.

Впервые опубликовано Понедельник, 12 мая 2025 г.