Угол Андерсона

Программирование в стиле Vibe страдает от расширения роли искусственного интеллекта.

Новое исследование показало, что точность распознавания эмоций улучшается, когда инструкции дают люди, но снижается, когда это делает ИИ, при этом наилучшая гибридная схема предполагает, что человек играет ведущую роль, а ИИ выступает в качестве арбитра или судьи.

Новое исследование из США изучает, что происходит, когда системам искусственного интеллекта позволяют управлять процессом. кодирование вибрацииВместо того чтобы просто выполнять инструкции человека, было обнаружено, что когда большие языковые модели (LLMЕсли же фактор берет на себя более значительную направляющую роль, результаты почти всегда оказываются хуже.

Хотя исследователи использовали OpenAI, GPT-5 В качестве основы для своих экспериментов по сотрудничеству человека и ИИ они позже подтвердили, что обе компании Anthropic... Клод Опус 4.5 и Google Близнецы 3 Pro Они подвергались той же самой кривой ухудшения по мере роста ответственности, утверждая, что «даже ограниченное участие человека неуклонно улучшает результаты»:

«[Люди] обеспечивают уникально эффективное руководство на высоком уровне на протяжении итераций, [в то время как] руководство со стороны ИИ часто приводит к падению производительности. Кроме того, мы обнаружили, что тщательное распределение ролей, при котором люди продолжают определять направление работы, а оценку перекладывают на ИИ, может улучшить гибридную производительность».

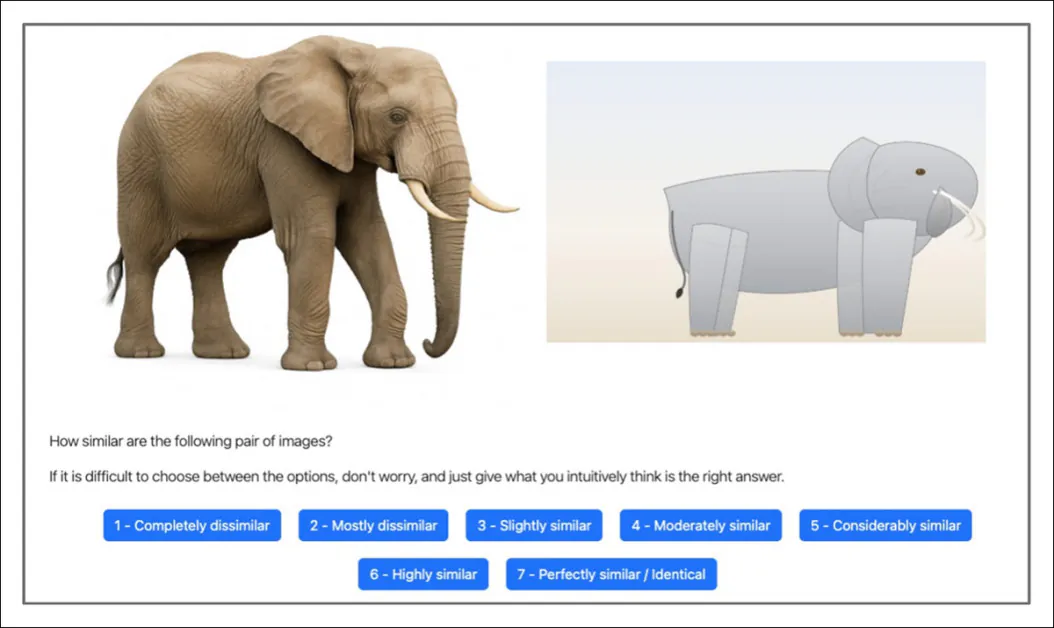

Для обеспечения согласованного теста, который мог бы одинаково оцениваться как людьми, так и искусственным интеллектом, была создана контролируемая экспериментальная структура, основанная на итеративной задаче кодирования, в которой эталонное изображение — фотография кошки, собаки, тигра, птицы, слона, пингвина, акулы, зебры, жирафа или панды — должно было быть воссоздано с использованием масштабируемой векторной графики.SVG), и эта реконструкция оценивалась по фотоисточнику, из которого она была получена:

Участникам, как людям, так и ИИ, показывали эталонное фотоизображение и реконструкцию в формате SVG, созданную ИИ, и просили оценить степень сходства между ними по семибалльной шкале. Источник

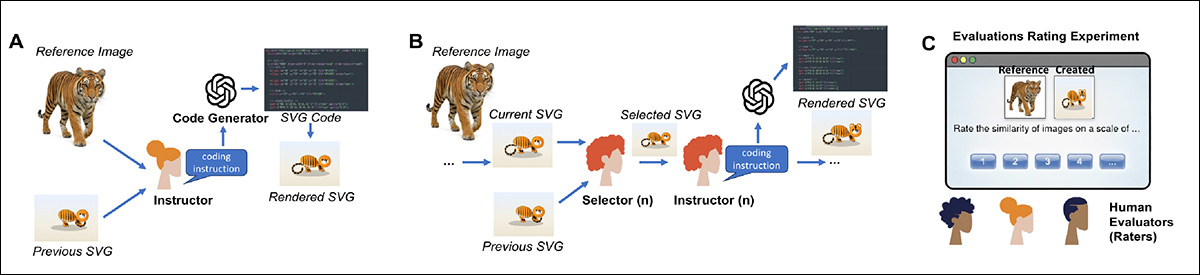

В каждом раунде один агент предоставлял высокоуровневые инструкции на естественном языке для управления генератором кода, а другой решал, сохранить ли новую версию или вернуться к предыдущей — структурированный цикл, имитирующий реальные процессы совместной работы.

В ходе 16 экспериментов с участием 604 человек и тысячами вызовов API, этапы тестирования, полностью проводимые людьми, сравнивались напрямую с этапами, полностью проводимыми искусственным интеллектом, при прочих равных условиях.

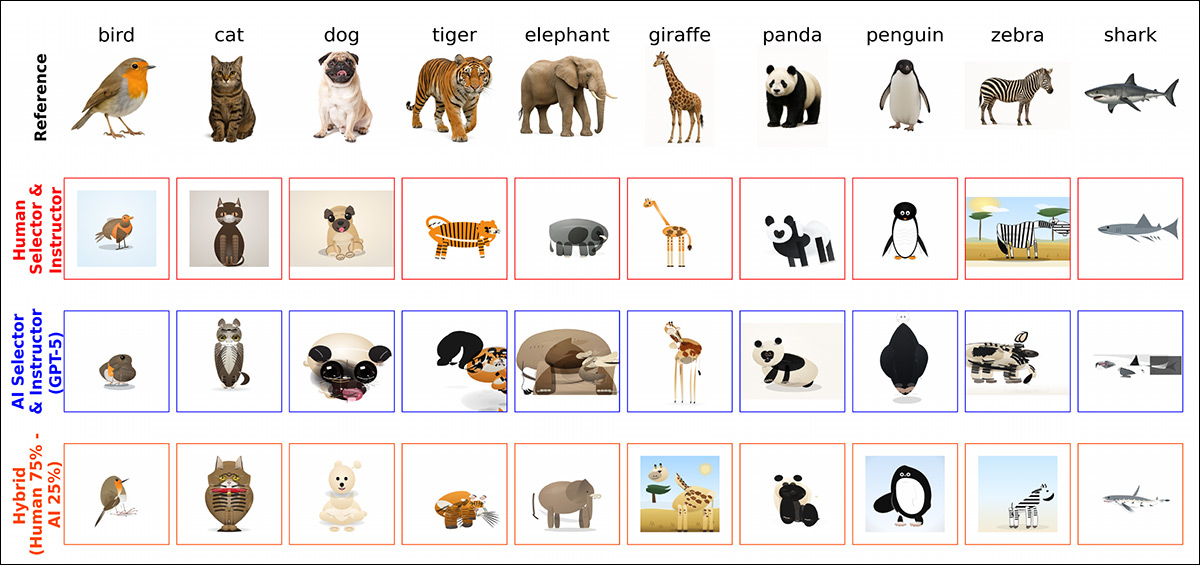

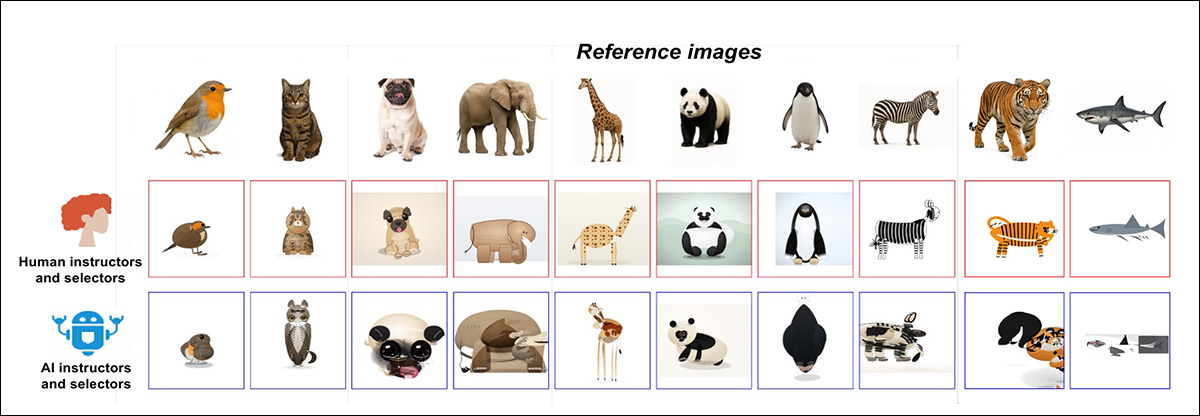

Некоторые из разнообразных решений, полученных в результате различных комбинаций процентного соотношения и типов сотрудничества человека и ИИ (взято из более подробной иллюстрации в исходной статье, на которую мы отсылаем читателя).

Хотя на начальном этапе тестирования люди и ИИ демонстрировали схожие результаты, со временем их траектории разошлись: когда люди давали инструкции и принимали решения о выборе, показатели сходства увеличивались с каждой итерацией, демонстрируя устойчивое кумулятивное улучшение; но когда системы ИИ выполняли обе роли, производительность не показывала последовательного роста и часто снижалась с каждым раундом – даже несмотря на то, что для генерации кода использовалась одна и та же базовая модель, и ИИ имел доступ к той же информации, что и участники-люди.

Эффект многословия

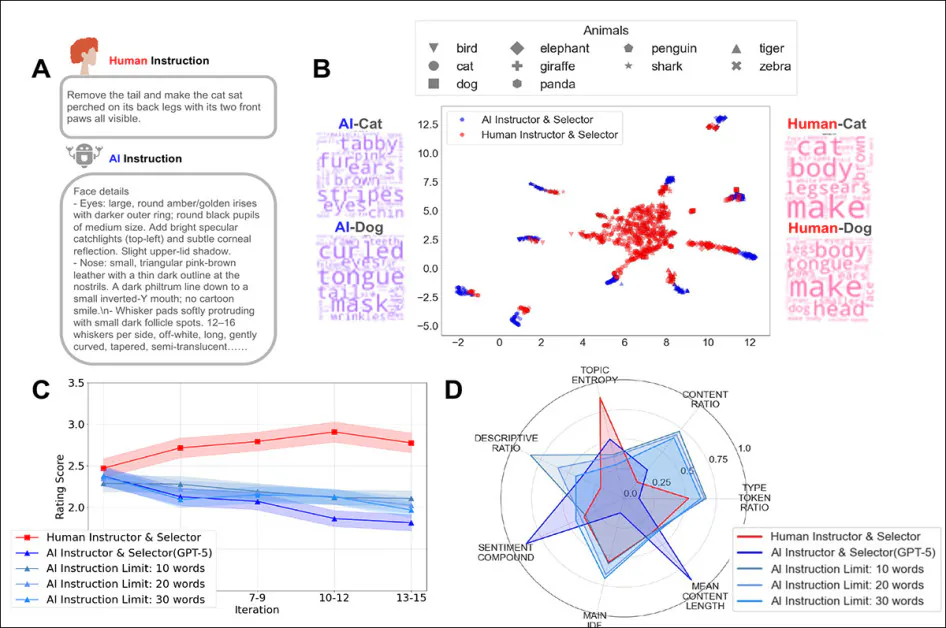

Результаты также показали, что инструкции, данные человеком, как правило, были короткими и ориентированными на действия, фокусируясь на том, что нужно изменить дальше на текущем изображении; напротив, инструкции, данные ИИ, были гораздо длиннее и содержали много описаний (фактор, который был параметризовано для GPT-5), детализируя визуальные характеристики, а не отдавая приоритет постепенной коррекции.

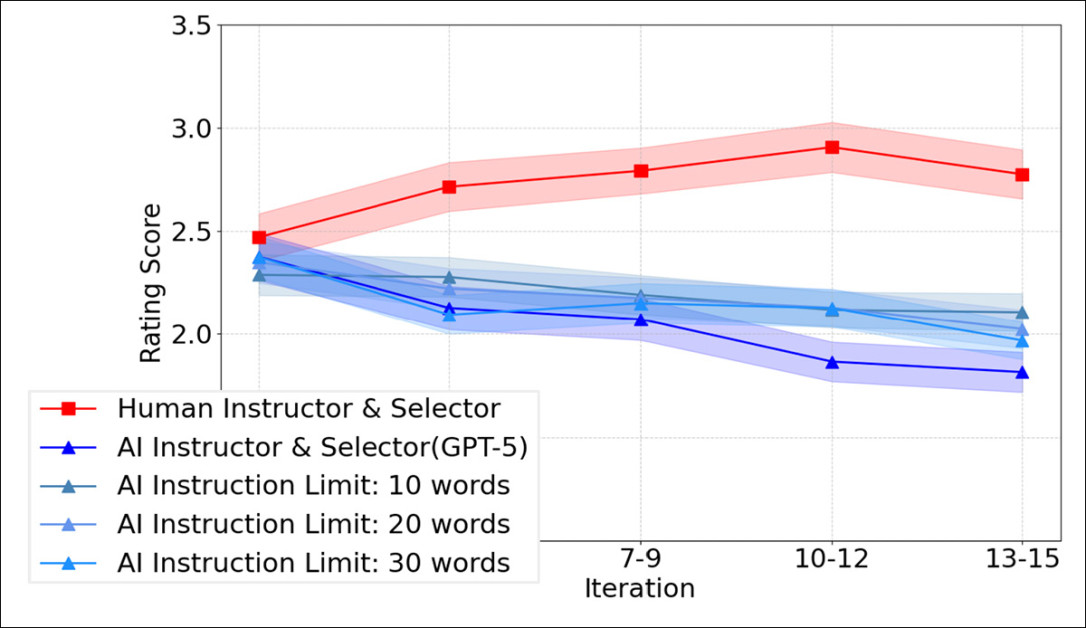

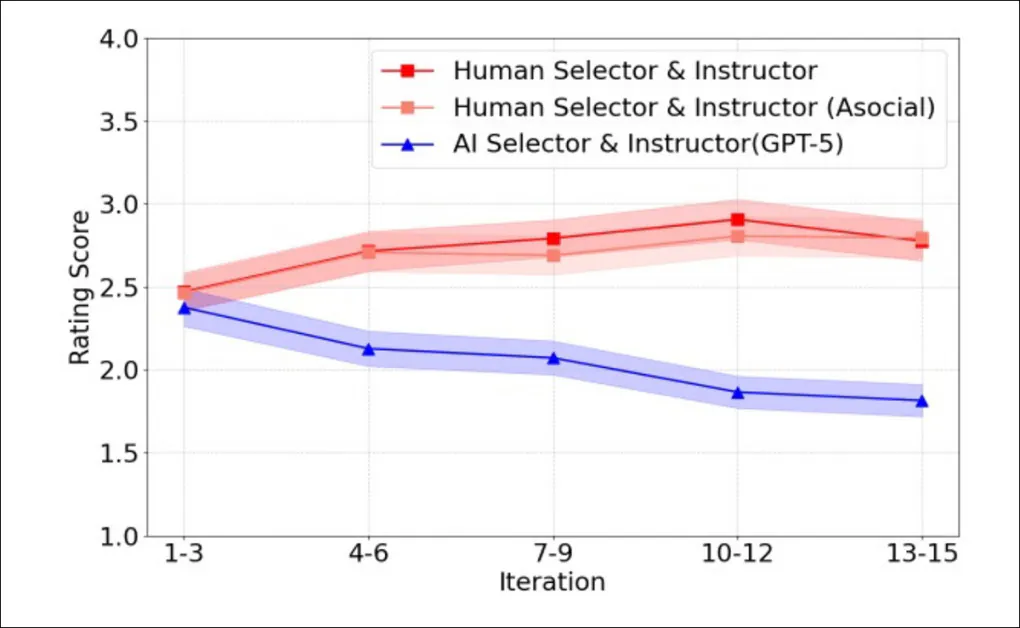

Однако, как видно на графике ниже, введение строгих ограничений на количество слов в инструкциях ИИ не изменило ситуацию; даже при ограничении в 10, 20 или 30 слов цепочки инструкций, управляемые ИИ, по-прежнему не улучшались со временем:

Сравнивались оценки сходства между итерациями в раундах, проводимых человеком, с раундами, полностью проводимыми ИИ, с ограничениями в 10, 20 или 30 слов в инструкциях. Очевидно, что сокращение подсказок ИИ не предотвращает наблюдаемое итеративное снижение производительности, когда ИИ управляет как инструкциями, так и выбором.

Гибридные эксперименты позволили более четко выявить закономерность, показав, что даже небольшое участие человека улучшает результаты по сравнению с системами, полностью управляемыми ИИ; однако производительность обычно снижается по мере увеличения доли управления со стороны ИИ.

Когда роли были разделены, оценку и отбор можно было передать ИИ с относительно небольшим снижением качества; однако замена высокоуровневого обучения человеком на руководство ИИ привела к заметному снижению производительности, что говорит о том, что важнее всего было не то, кто именно выполнял работу. сгенерировал код, но кто задали и поддерживали выбранное направление на протяжении итераций.

Авторы заключают:

«В ходе многочисленных экспериментов кодирование, выполняемое человеком, неизменно улучшалось с каждой итерацией, в то время как кодирование, выполняемое ИИ, часто терпело крах, несмотря на доступ к той же информации и аналогичные возможности выполнения».

«Это указывает на ключевые проблемы современных систем искусственного интеллекта в поддержании согласованного высокоуровневого направления в ходе многократных взаимодействий, необходимого для успешного кодирования атмосферы».

Команда Новый документ называется Почему человеческое руководство важно в программировании, основанном на принципах сотрудничестваЭта работа выполнена семью исследователями из Корнельского университета, Принстонского университета, Массачусетского технологического института и Нью-Йоркского университета.

Способ доставки

Для проведения экспериментов инструктор-человек рассматривал эталонное фото животного, сгенерированное GPT-5, вместе с последней соответствующей попыткой имитации в формате SVG. Затем программа писала инструкции на естественном языке, чтобы направить генератор кода к более точному совпадению.

Таким образом, генератор будет создавать новый SVG-файл в каждом раунде, обеспечивая итеративный цикл для проверки того, как эффект от управляющих воздействий накапливается со временем. В качестве целевых изображений были выбраны десять изображений животных, сгенерированных GPT-5, охватывающих широкий диапазон форм и текстур, чтобы улучшения или ошибки было легко обнаружить:

Схема рабочего процесса кодирования, используемого в исследовании. В пункте А) инструктор просматривает эталонное фотоизображение вместе с лучшим созданным на данный момент SVG-файлом и пишет инструкции на естественном языке для генератора кода, которым он должен следовать при создании следующего SVG-файла; в пункте B) специалист сравнивает новый SVG-файл с предыдущим и выбирает версию, которая лучше соответствует эталонному изображению, прежде чем передать выбранный SVG-файл для следующего раунда инструкций; и в пункте C) независимые эксперты оценивают степень сходства каждого сгенерированного SVG-файла с эталонным изображением, предоставляя оценки, используемые для оценки общей производительности.

Человек-селектор сравнивал каждый вновь созданный SVG-файл с предыдущим и либо принимал, либо отклонял его, что обеспечивало согласованность процесса с эталонным изображением на протяжении всех этапов. В этой базовой конфигурации один и тот же человек выполнял обе роли.

Измерять Независимые эксперты-оценщики определяли степень сходства каждого сгенерированного SVG-изображения с эталонным изображением. В шестнадцати экспериментах 120 человек дали 4,800 оценок. Все эксперименты проводились на платформе. PsyNet Framework — это портал, предназначенный для обеспечения структурированного взаимодействия между людьми и системами искусственного интеллекта.

В исследовании должны были принять участие 604 носителя английского языка, которые должны были выполнить 4,800 вызовов API для генерации кода и 5,327 вызовов API для обучения. Хотя основной моделью была GPT-5, были проведены и меньшие сравнительные тесты с Claude Opus 4.5 и Gemini 3 Pro, каждый из которых обрабатывал по 280 запросов.

Результаты

Было проведено тридцать раундов кодирования атмосферы, каждый из которых включал пятнадцать правок десяти основных эталонных изображений. Для этого были выбраны 45 участников-людей, каждый из которых выступал одновременно в роли отборщика и инструктора на протяжении десяти итераций в раундах, проводимых под руководством человека.

В каждом раунде один и тот же участник сначала выбирал между текущим и предыдущим SVG-изображением, а затем писал инструкции для следующего раунда. Во второй версии теста эти решения, принимаемые человеком, были заменены вызовами API к GPT 5, при этом остальная часть настройки осталась неизменной. Во всех случаях роли инструктора и селектора запускали генератор кода с помощью простого языка.

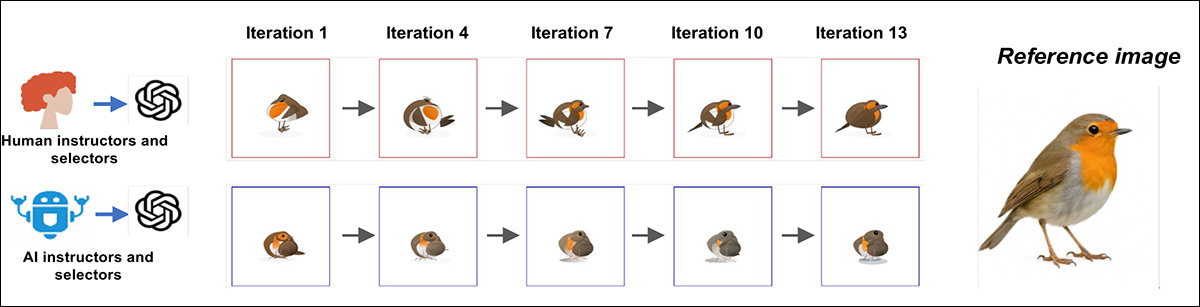

Показательный пример многоэтапного кодирования атмосферы демонстрирует, как процесс расходится со временем; когда люди выступали одновременно в роли селектора и инструктора, результат в формате SVG неуклонно улучшался на протяжении итераций, приближаясь к эталонному изображению с каждым раундом:

Примеры прогресса для одного эталонного изображения при кодировании с участием человека (сверху) и ИИ (снизу), демонстрирующие устойчивое улучшение на протяжении итераций при участии людей в обеих ролях, а также стагнацию или дрейф, когда обе роли выполняются ИИ.

Напротив, в версии с использованием ИИ на ранних этапах иногда удавалось захватить ключевые визуальные особенности, но последующие попытки не смогли развить эти успехи, а в некоторых случаях отклонялись от цели:

Итоговые результаты финальной итерации, сравнивающие повороты, инициированные человеком (верхний ряд), с цепочками, управляемыми ИИ (нижний ряд), на одном и том же наборе эталонных изображений. Результаты, полученные с помощью человека, более точно соответствуют исходным животным, в то время как результаты, полученные с помощью ИИ, демонстрируют видимые искажения или потерю ключевых особенностей.

Для количественной оценки возникающих тенденций финальные изображения были показаны независимым экспертам-оценщикам, которые оценили их на предмет сходства с эталонными изображениями. На ранних этапах оценки, полученные экспертами и ИИ, были примерно одинаковыми; однако к пятнадцатому этапу разница стала очевидной: изображения, выбранные экспертами, были оценены гораздо ближе к целевым показателям. Со временем оценки экспертов неуклонно росли, достигнув наибольшего относительного прироста по сравнению с ИИ в 27.1%.

Средние показатели сходства по итерациям для кодирования атмосферы под руководством человека и ИИ демонстрируют устойчивый рост, когда люди выступают одновременно в роли селектора и инструктора, и постепенное снижение, когда обе роли выполняет GPT 5.

Чтобы убедиться, что наблюдаемые тенденции не были результатом коллективной работы множества одновременно участвующих людей, исследователи привлекли еще десять человек для самостоятельной работы, каждый из которых провел три раунда самостоятельно, — и результаты улучшались с той же стабильной скоростью, демонстрируя, что улучшения не были случайностью коллективных усилий.

The Big Picture

Однако, если бы GPT-5 оценивал результаты самостоятельно, признал бы он, что результаты, полученные человеком, были лучше? Оценки, данные человеком и ИИ, в целом двигались в одном направлении, поэтому модель могла отличать хорошие изображения от плохих, но при этом неизменно получала высокие оценки от изображений, сгенерированных ИИ. выше, чем у людей.

«В частности, мы задались вопросом, будут ли агенты ИИ распознавать, что их собственные результаты уступают результатам, созданным людьми, или же, наоборот, будут отдавать предпочтение своим собственным творениям, что указывало бы на потенциальную проблему согласованности».

Как выяснилось, проблема с выравниванием действительно существует*:

«Оценщики, использующие ИИ, присвоили более высокие оценки результатам, сгенерированным ИИ. Эти результаты позволяют предположить, что наблюдаемые различия в производительности могут быть обусловлены…» несоответствие в представлениях «Между людьми и искусственным интеллектом».

При изучении того, как люди и ИИ формулируют свои указания, в ходе тестирования выявились расхождения. Как видно на рисунке ниже, оба подхода фокусируются на... и Длина является предметом разногласий между ИИ и человеком:

Сравнение того, как люди и ИИ давали инструкции во время выполнения задания по программированию. «А» показывает, что люди пишут короткие, прямые инструкции, в то время как ИИ пишет длинные, подробные описания. «B» отображает инструкции, показывая, что подсказки людей группируются вместе, в то время как подсказки ИИ разделяются по животным. «C» показывает, как ограничение длины инструкций ИИ не исправляет его плохие результаты с течением времени; и «D» иллюстрирует, что люди дают более разнообразные и сбалансированные указания, чем ИИ, даже при установлении ограничений по количеству слов.

Инструкции, данные человеком, как правило, были краткими и по существу, предлагая четкие правки, которые можно было применять ко всем целям. Инструкции ИИ, напротив, были перегружены подробными описаниями и часто содержали множество деталей о затенении, текстурах, освещении или анатомических тонкостях — описания, которые могут иметь смысл сами по себе, но не дают полезных указаний на дальнейшие шаги для модели (и которые будут знакомы тем, кто знаком с проблемами моделей с низкой степенью точности). около длины контекста(то есть, способность сохранять «общую картину» по мере развития и роста проекта).

Чтобы проверить, улучшит ли снижение детализации производительность, GPT-5 был ограничен 10, 20 или 30 словами на инструкцию; но даже эти сжатые инструкции не показали никакого улучшения (см. нижний правый угол графика выше).

Совместные усилия

Чтобы проверить, что произойдет, когда люди и ИИ столкнутся. Share В контрольной группе исследователи выполняли задания по программированию с различными сочетаниями человеческого и искусственного интеллекта в качестве входных данных, начиная с... в основном люди в в основном ИИ.

Все гибридные комбинации показали результаты лучше, чем полное управление с помощью ИИ, так что даже небольшое участие человека улучшило показатели:

Гибридные схемы кодирования с различным соотношением участия человека и ИИ. (A) Показано, как люди и ИИ по очереди выступали в роли инструкторов и отборщиков на каждом этапе кодирования; (B) показано, что большее участие человека приводило к более качественным результатам, в то время как большее участие ИИ снижало оценки; и (C) демонстрирует устойчивое снижение качества конечного результата по мере уменьшения доли участия человека, подтверждая, что более последовательное руководство со стороны человека приводило к лучшим результатам.

По мере того, как ИИ всё больше брал на себя управление процессом, производительность снижалась: лучшие результаты наблюдались, когда большую часть раундов руководили люди, а худшие — когда большую часть раундов руководил ИИ. Ни одна из этих смешанных конфигураций не смогла продолжать улучшаться с каждым новым раундом, что говорит о том, что человеческое руководство работает лучше всего, когда оно стабильно и последовательно, а не эпизодично.

Смена ролей

В исследовании также изучалось, имеет ли это значение. кто что делает в подобных задачах, и это было проверено. Пересмотренное упражнение включало две задачи: один участник должен был указать, как изменить изображение, а другой — выбрать предпочтительный вариант.

Когда обе задачи выполнялись людьми, качество поддерживалось на должном уровне; но когда человек давал инструкции и никто не При выборе между версиями качество ухудшилось.

Тесты разделения ролей в программировании Vibe: в (A) удаление роли селектора привело к ухудшению производительности, даже когда инструкции давал человек; в (B) замена человеческого селектора на ИИ немного снизила качество, но не так сильно, как полный отказ от выбора.

Когда за управление отвечал ИИ, пропуск этапа выбора не имел значения, поскольку результаты оставались неизменными в любом случае; но когда инструкции давали люди, а ИИ выбирал между результатами, качество оставалось близким к уровню, наблюдаемому при работе только людей.

Обратный вариант не сработал: когда ИИ давал указания, а люди выбирали результаты, это привело к следующему: слабее Результаты показывают, что человеческое творческое руководство по-прежнему имеет важное значение, в то время как задачу выбора между вариантами можно передать искусственному интеллекту без существенных потерь.

В статье делается вывод:

«Генерация идей высокого уровня и обучение являются важнейшими задачами, выполняемыми человеком, в то время как оценку и отбор часто можно делегировать искусственному интеллекту без потери эффективности».

«Это наводит на мысль о практическом принципе проектирования гибридных систем: люди должны задавать направление, а ИИ может поддерживать оценку и выполнение».

Заключение

Остается выяснить, в какой степени улучшенные и/или расширенные контекстные окна повлияют на производительность LLM в задачах такого рода. День, когда «амнезия LLM» перестанет быть ежедневной головной болью в сотрудничестве человека и ИИ, может стать поводом как для радости, так и для тревоги, поскольку проблема, которую ИИ стремится решить, по всей видимости, заключается в люди.

Тем не менее, работа авторов также ясно показывает, что существуют врожденный а также критические разногласия между ИИ и людьми по поводу , которое, возможно, потребители сочтут незаменимым человеческим понятием.

* Мое преобразование встроенных ссылок на работы авторов в гиперссылки.

Впервые опубликовано Пятница, 13 февраля 2026 г.