Угол Андерсона

Использование телешоу «Доктор Хаус» для развития диагностических возможностей ИИ

Хотя диагностика редких заболеваний представляет собой особенно сложную задачу для ИИ (как и для людей), популярные языковые модели ChatGPT и Gemini демонстрируют многообещающие результаты при обучении на диагностических случаях из популярной медицинской драмы «Доктор Хаус».

Почти половина всех студентов медицинских наук регулярно смотреть медицинские драмы, такие как Дом, Анатомия Грей и СкрабыХотя этот тип материала может быть использован только в дидактических целях с большой фильтрацией и фреймингом, из-за риска распространения опасной дезинформации, стандарт исследования драм, посвященных медицинским состояниям, как правило, довольно высок (хотя точность меняется в разных постановках).

Неудивительно, что врачи часто происходить, консультировать и/или записывать Медицинские теледрамы. В таких случаях обширные знания в области медицины полезны не только для точного изложения медицинских вопросов, но и для создания идей для новых и интересных сюжетных линий.

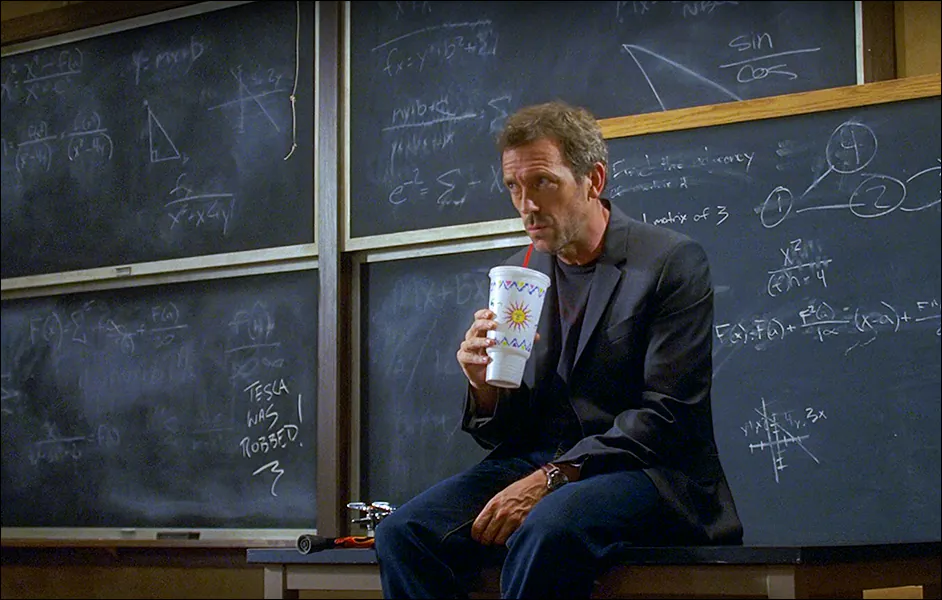

Одно из самых тщательно исследованных медицинских шоу недавнего «золотого века» телевидения – это Дом (она же Доктор Хаус), в котором эксцентричность главного героя и огромные перемены в составе второстепенных персонажей, какими бы занимательными они ни были, отошли на второй план после «болезни недели».

Фактически, из 177 серий, вышедших в эфир за восемь сезонов, Дом Провели тщательное исследование 176 диагностических случаев. Хотя шоу закончилось в 2012 году, к 2015 году оно уже использовалось в качестве учебного пособия, особый Доктор Дом семинар предлагая улучшенные результаты по сравнению со стандартными семинарскими занятиями, хотя за посещение не начислялись студенческие баллы:

![Исследование 2015 года выявило различные причины, по которым студенты-медики хотели посетить диагностический семинар, в котором использовалась информация из сериала «Доктор Хаус». Источник [ https://journals.plos.org/plosone/article/file?id=10.1371/journal.pone.0193972&type=printable ]](https://www.unite.ai/wp-content/uploads/2025/11/house-seminar.jpg)

Исследование 2015 года выявило различные причины, по которым студенты-медики хотели посетить диагностический семинар, основанный на информации из сериала «Доктор Хаус». Семинары были запланированы на намеренно сложное время и не предполагали зачётных единиц; несмотря на эти факторы, инициатива имела успех. Источник

Дом и ИИ

Хотя использование Дом и другие разнообразные телешоу, как было доказано в многочисленных исследованиях, являются эффективным вспомогательным средством для обучения студентов-медиков, однако до сих пор мало какой подход был опробован в контексте машинного обучения.

В новой статье Университета штата Пенсильвания предпринята первая попытка в этом направлении, путем разработки набора данных, включающего все пригодные для использования 176 Дом тематические исследования, сформулированные в повествовательную диагностическую структуру, впоследствии оценены на популярных программах магистратуры права от OpenAI и Google.

Несмотря на сложность этой задачи (которая характеризует одну из самых сложных областей биологических наук), исследователи обнаружили, что более поздние версии ChatGPT и Gemini демонстрируют улучшения по сравнению со старыми версиями, что указывает на то, что эволюционная тенденция развития моделей, вероятно, со временем эффективно приспособится к диагностическим процессам.

В документе говорится:

Результаты демонстрируют значительный разброс в производительности: точность варьируется от 16.48% до 38.64%, при этом новые поколения моделей демонстрируют улучшение в 2.3 раза. Хотя все модели сталкиваются со значительными трудностями при диагностике редких заболеваний, наблюдаемое улучшение в различных архитектурах указывает на перспективные направления для дальнейшего развития.

«Наш образовательно-проверенный эталон устанавливает базовые показатели эффективности для нарративного медицинского мышления и предоставляет общедоступную структуру оценки для продвижения исследований в области диагностики с использованием ИИ».

Помимо установления базовых показателей производительности, на основе которых можно будет оценивать будущие усилия, авторы отмечают, что новый набор данных, который они создают, общедоступной – решает проблему отсутствия повествовательного процесса в существующих наборах медицинских данных и является легкодоступным, в отличие от закрытой культуры стандартных наборов медицинских данных.

Команда новая работа называется Оценка больших языковых моделей диагностики редких заболеваний: пример из книги «Доктор Хаус»и исходит от четырех исследователей из Университета штата Пенсильвания*.

Цены

Для заполнения своего набора данных авторы использовали общедоступные материалы из давно известных источников. Дом Вики Сайт фандома. Содержание повествования было извлечено и обработано с использованием популярного Фреймворк Beautiful Soup, который может извлекать структурные данные из HTML-источника веб-страниц.

После того, как базовые нарративы были собраны таким образом, четыре магистра права (LLM) были использованы для преобразования результатов в стандартизированное форматирование кейсов. Использовались следующие модели: ГПТ-4о мини; ГПТ-5 Мини; Близнецы 2.5 Флэши Близнецы 2.5 Про. Наконец, была применена фильтрация качества, чтобы гарантировать, что набор данных содержит необходимые клинические данные и соответствует текущему уровню развития медицинской логики.

Авторы отмечают, что «сиротские» заболевания (также известные как редкие заболевания) недостаточно представлены в стандартных медицинских базах данных; в некоторых случаях их охват в Дом шоу может представлять необычный процент от общего существующего охвата.

Авторы признают, что полезность источника данных такого типа должна быть ограничена осторожностью в отношении художественной вольности, которая порой может оказаться приоритетной при разработке медицинской драмы:

«Хотя наш набор данных отражает ограничения вымышленного контента, включая драматическое преувеличение и сложную фокусировку на случаях, эти характеристики могут принести пользу оценке, предоставляя сложные пограничные случаи, которые проверяют надежность модели.

«Образовательная валидация сериала «Доктор Хаус» медицинскими специалистами дает уверенность в том, что извлеченные сценарии содержат клинически значимую информацию, пригодную для [оценки] с помощью ИИ».

![Примеры из набора данных, созданного для проекта. Источник [ https://www.kaggle.com/datasets/arshgupta23/housemd-data-for-rare-disease-accuracy-using-llms?resource=download ]](https://www.unite.ai/wp-content/uploads/2025/11/dataset-examples.jpg)

Примеры из набора данных, созданного для проекта. Источник

Tests

Для оценки точности модели при выполнении задач повествовательной диагностики авторы разработали простой конвейер, объединяющий генерацию подсказок, вывод модели и оценку.

Были протестированы четыре вышеупомянутых LLM, каждая модель была настроена следующим образом: температура установлен на ноль (обеспечивая детерминистический а не «творческий» результат), и с максимальным знак Длина 1,500 символов — допуск, предназначенный для решения сложных диагностических задач. Дополнительные системные подсказки для дальнейшего формулирования запросов не использовались.

Сами подсказки соответствовали стандартному структурированному формату презентации медицинского случая — виду, который зрителям больше всего знаком по медицинским драмам, когда представляется новый пациент/болезнь, и врач делает краткий обзор для других присутствующих врачей (хотя на самом деле это полезно и для зрителей).

Каждая подсказка представляла собой клиническое описание, включающее демографические данные, хронологию симптомов, соответствующий анамнез и результаты ранней диагностики. Модель должна определить один первичный диагноз и обосновать свой вывод. рассуждение.

Каждая модель генерировала свой диагностический ответ за один проход, без какого-либо итеративного уточнения; ответы собирались в одинаковых условиях во всех 176 случаях:

![Наглядный оценочный пример, демонстрирующий повествовательную клиническую подсказку и соответствующий ей точный диагноз, используемый для тестирования Gemini 2.5 Pro. Источник [ https://arxiv.org/pdf/2511.10912 ]](https://www.unite.ai/wp-content/uploads/2025/11/table-2-1.jpg)

Наглядный пример, демонстрирующий повествовательную клиническую подсказку и соответствующую ей истинную диагностику, использованную для тестирования Gemini 2.5 Pro. Источник

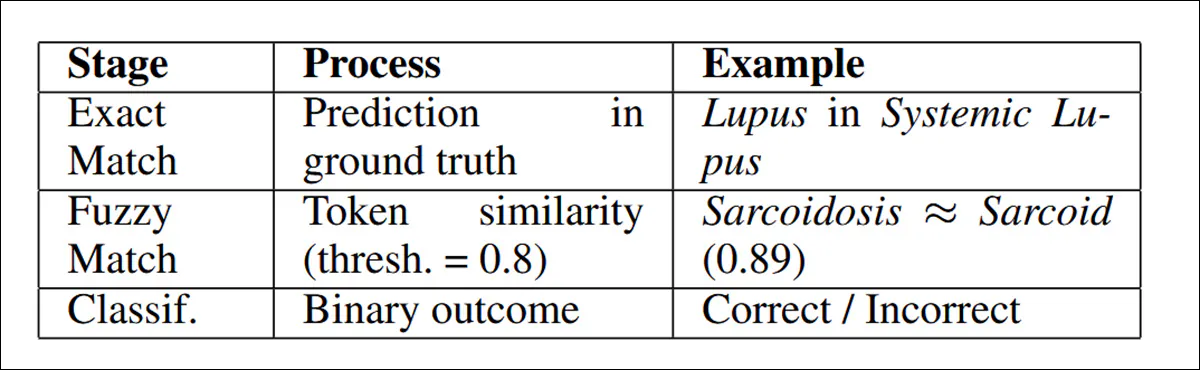

Для оценки метрик прогнозы оценивались с помощью процедуры «нечёткого» сопоставления строк, разработанной для учёта неоднозначности медицинской терминологии. В этом подходе использовался язык программирования Python. Библиотека SequenceMatcher, с порогом сходства 0.8, начиная с точного совпадения подстроки и возвращаясь к сравнение по токенам когда необходимо. точность рассчитывалась как доля случаев, классифицированных правильно при данных условиях:

Рабочий процесс «нечеткого соответствия», используемый исследователями.

Авторы отмечают, что нечеткое соответствие может означать, что семантически идентичные диагнозы, использующие разную терминологию, могут быть пропущены, но представляют свой подход как наиболее воспроизводимый, который может соответствовать всем ограничениям проекта.

Результаты

Точность диагностики сильно различалась в зависимости от модели: Gemini 2.5 Pro показала лучший результат — 38.64%, за ней следовали GPT-5 Mini — 36.93%, Gemini 2.5 Flash — 32.95% и GPT-4o Mini — 16.48%. Несмотря на эти различия, все модели испытывали трудности с диагностикой редких заболеваний:

Результаты диагностической точности по четырем испытанным моделям.

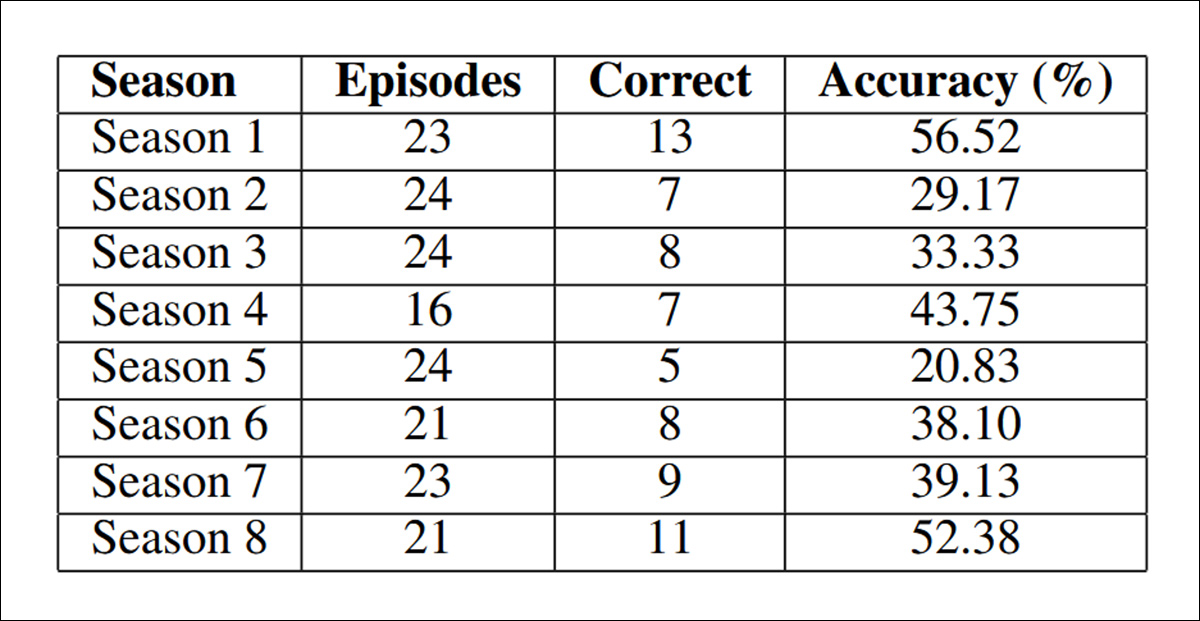

Авторы также отмечают, что результативность варьировалась в зависимости от сезона шоу:

Точность в разных сезонах «Доктора Хауса» разная, но без какой-либо очевидной кривой или ясной причины.

В документе говорится:

«В первом сезоне точность достигла наивысшей отметки — 56.52%, а в пятом — самой низкой — 20.83%. Эта вариация говорит о том, что сложность диагностики варьируется на протяжении всего сериала, и в последующих сезонах могут быть представлены более сложные случаи редких заболеваний».

«Однако относительно высокие показатели в 8-м сезоне (52.38%) свидетельствуют о том, что временная прогрессия сама по себе не в полной мере объясняет различия в точности, а скорее всего, основным фактором является сложность диагностики в каждом конкретном случае».

Модели работали более надёжно при диагностике распространённых заболеваний с узнаваемыми симптомами, таких как менингит, инфаркт миокарда и тромбоэмболия лёгочной артерии, но постоянно испытывали трудности с диагностикой редких заболеваний, таких как нейроцистицеркоз и болезнь Эрдгейма-Честера, а также сложных аутоиммунных заболеваний, таких как системная красная волчанка и саркоидоз. Эффективность также снижалась при диагностике токсикологических случаев, требующих связи между историей воздействия и клиническими проявлениями.

Авторы предполагают, что разница в точности между моделями указывает на существенные различия в архитектуре и стратегии обучения, при этом более высокая производительность GPT-5 Mini и Gemini 2.5 Pro свидетельствует о том, что новые поколения LLM выигрывают от улучшенных возможностей рассуждения, хотя их результаты по-прежнему демонстрируют явные ограничения в решении сложных диагностических задач.

Результаты, по их мнению, дают базовые показатели для повествовательной диагностики редких заболеваний, что убедительно свидетельствует о том, что современные языковые модели начинают демонстрировать полезные способности медицинского мышления.

В статье делается вывод о том, что скачок производительности GPT-4o Mini на 16.48% до Gemini 2.5 Pro на 38.64% свидетельствует о стабильном прогрессе в направлении создания клинически применимых инструментов поддержки ИИ.

Хотя исследователи признают, что уровень точности остается невысоким, тест ориентирован исключительно на крайне сложные случаи, которые обычно бросают вызов даже опытным врачам, а способность правильно определить диагноз почти в 40% этих трудных примеров указывает на подлинную способность к рассуждению, закладывая основу для будущих улучшений посредством целенаправленной тонкой настройки, структурированной интеграции медицинских знаний или гибридных стратегий рассуждения.

Заключение

Существуют некоторые очевидные опасности в переносе сюжетов телешоу в реальные медицинские наборы данных – даже в таких случаях, как Дом, где исходный материал имеет высокий уровень квалифицированного медицинского вклада и/или надзора.

Интересно отметить, что типичный эпизод Дом фактически действует как машина для резюмирования ряда медицинских записей, которые могут быть не доступны напрямую в Интернете для обычного человека, или для источников данных, которые представляют информацию в гораздо более фрагментированном и нелинейном виде.

На самом деле, сценарий для эпизода написал врач, как это часто случалось с Дом, могли бы быть использованы исследователями как некая форма «подписи» под содержанием; однако это игнорирует тот факт, что художественные соображения могли повлиять на представление болезни в эпизоде.

Это оставляет данные в состоянии, при котором многие другие потенциально полезные источники данных для обучения нуждаются в новом уровне дорогостоящего, квалифицированного человеческого контроля.

* Обратите внимание, что эта очень короткая статья не следует общепринятому шаблону, и мне пришлось адаптировать изложение материала с учетом этого.

Впервые опубликовано Понедельник, 17 ноября 2025 г.