Искусственный интеллект

Perplexity AI «отменяет цензуру» DeepSeek R1: кто определяет границы ИИ?

В ходе этого шага, который привлек внимание многих, Недоумение ИИ выпустила новую версию популярной модели языка с открытым исходным кодом, которая убирает встроенную китайскую цензуру. Эта модифицированная модель, названная R1 1776 (название, вызывающее дух независимости), основана на разработанной китайцами DeepSeek R1. Оригинальный DeepSeek R1 произвел фурор своими мощными аналитическими возможностями — как сообщается, он мог конкурировать с моделями высшего класса, но стоил в разы дешевле, — но у него было существенное ограничение: он отказывался рассматривать некоторые деликатные темы.

Почему это важно?

Это поднимает важные вопросы о ИИ-наблюдение, предвзятость, открытость и роль геополитики в системах ИИ. В этой статье рассматривается, что именно сделала Perplexity, последствия отмены цензуры модели и как она вписывается в более широкий разговор о прозрачности и цензуре ИИ.

Что произошло: DeepSeek R1 выходит без цензуры

DeepSeek R1 — это модель языка с открытым весом, разработанная в Китае и получил известность благодаря своим превосходным способностям к рассуждению – даже приближаясь к производительности ведущих моделей – и все это при более высокой вычислительной эффективности. Однако пользователи быстро заметили странность: всякий раз, когда запросы касались тем, чувствительных для Китая (например, политических споров или исторических событий, считающихся табуированными властями), DeepSeek R1 не отвечал напрямую. Вместо этого он отвечал шаблонными, одобренными государством заявлениями или прямыми отказами, отражая правила цензуры китайского правительства. Эта встроенная предвзятость ограничивала полезность модели для тех, кто искал откровенных или тонких обсуждений этих тем.

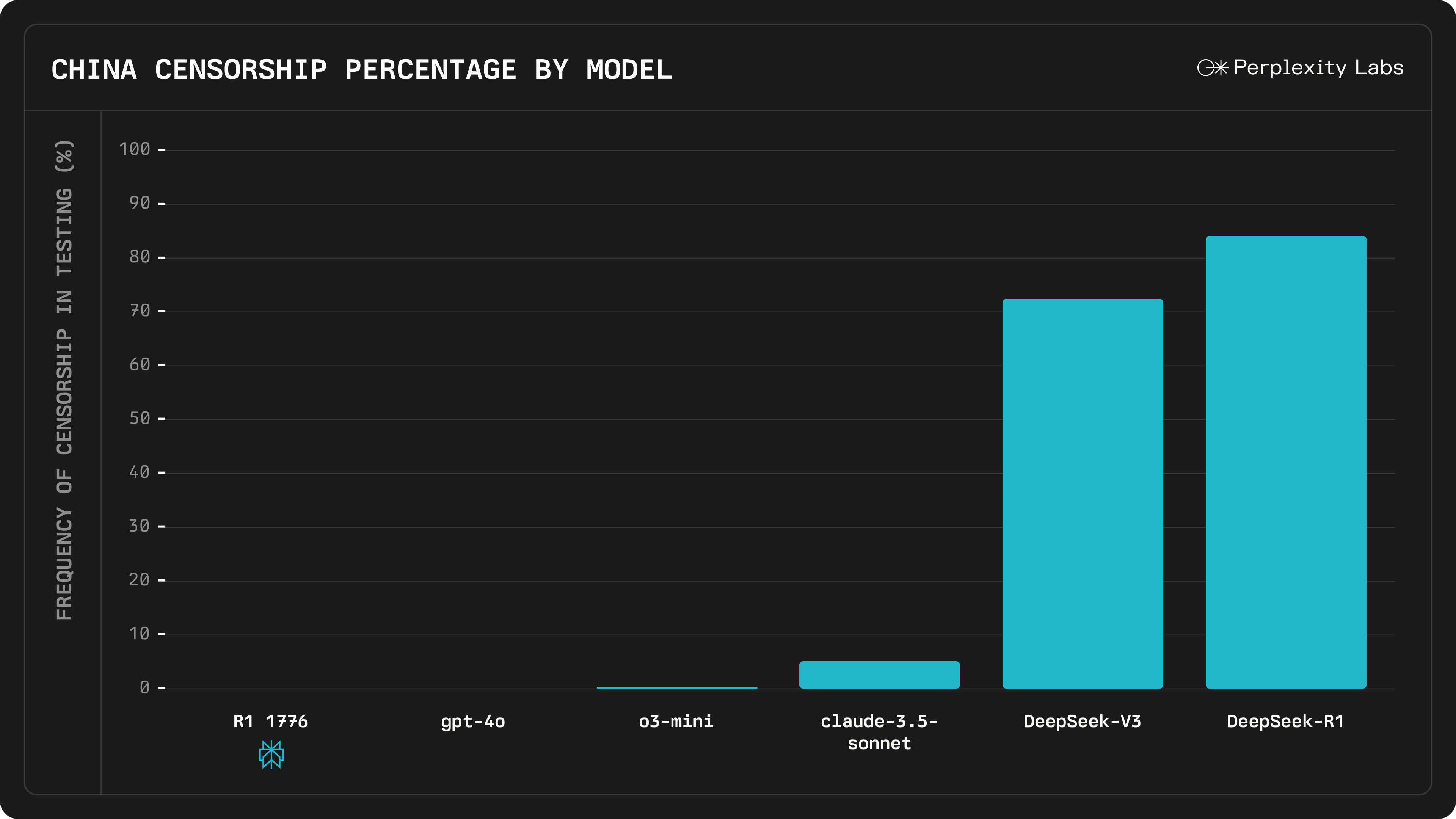

Решение Perplexity AI состояло в том, чтобы «децензурировать» модель с помощью обширного процесса постобучения. Компания собрала большой набор данных из 40,000 1 многоязычных подсказок, охватывающих вопросы, которые DeepSeek R300 ранее цензурировал или на которые отвечал уклончиво. С помощью экспертов-людей они выявили около 1 деликатных тем, где исходная модель имела тенденцию следовать партийной линии. Для каждой такой подсказки команда подбирала фактические, хорошо обоснованные ответы на нескольких языках. Эти усилия были включены в многоязычную систему обнаружения и исправления цензуры, по сути обучая модель тому, как распознавать, когда она применяет политическую цензуру, и отвечать вместо этого информативным ответом. После этой специальной тонкой настройки (которую Perplexity прозвала «R1776 1», чтобы подчеркнуть тему свободы), модель была сделана общедоступной. Perplexity утверждает, что устранила китайские цензурные фильтры и предвзятость из ответов DeepSeek RXNUMX, не изменив при этом его основные возможности.

Важно отметить, что R1 1776 ведет себя совершенно иначе в отношении ранее табуированных вопросов. Perplexity привел пример, связанный с запросом о независимости Тайваня и ее потенциальном влиянии на стоимость акций NVIDIA — политически чувствительная тема, которая затрагивает отношения между Китаем и Тайванем. Оригинальный DeepSeek R1 избегал вопроса, отвечая банальностями в духе КПК. Напротив, R1 1776 дает подробную, откровенную оценку: в нем обсуждаются конкретные геополитические и экономические риски (сбои в цепочке поставок, волатильность рынка, возможный конфликт и т. д.), которые могут повлиять на стоимость акций NVIDIA.

Благодаря открытию исходного кода R1 1776, Perplexity также сделала веса и изменения модели прозрачными для сообщества. Разработчики и исследователи могут скачать его с Hugging Face и даже интегрировать его через API, гарантируя, что снятие цензуры может быть тщательно проверено и использовано другими.

(Источник: Perplexity AI)

Последствия отмены цензуры

Решение Perplexity AI снять китайскую цензуру с DeepSeek R1 имеет несколько важных последствий для сообщества ИИ:

- Повышенная открытость и правдивость: Пользователи R1 1776 теперь могут получать неотцензурированные, прямые ответы на ранее закрытые темы, что является победой для открытого расследования. Это может сделать его более надежным помощником для исследователей, студентов или всех, кто интересуется деликатными геополитическими вопросами. Это конкретный пример использования ИИ с открытым исходным кодом для противодействия подавлению информации.

- Поддерживаемая производительность: Были опасения, что настройка модели для удаления цензуры может ухудшить ее производительность в других областях. Однако Perplexity сообщает, что основные навыки R1 1776 — такие как математика и логическое мышление — остаются на уровне исходной модели. В тестах на более чем 1,000 примерах, охватывающих широкий спектр конфиденциальных запросов, было обнаружено, что модель «полностью не подвергалась цензуре», сохраняя при этом тот же уровень точности рассуждений, что и DeepSeek R1. Это говорит о том, что удаление предвзятости (по крайней мере, в этом случае) не было достигнуто за счет снижения общего уровня интеллекта или возможностей, что является обнадеживающим признаком для аналогичных усилий в будущем.

- Положительный отклик сообщества и сотрудничество: Открывая исходный код децензурированной модели, Perplexity приглашает сообщество ИИ к проверке и улучшению своей работы. Это демонстрирует приверженность прозрачности — эквиваленту ИИ демонстрации своей работы. Энтузиасты и разработчики могут убедиться, что ограничения цензуры действительно исчезли, и потенциально способствовать дальнейшим улучшениям. Это способствует доверию и совместным инновациям в отрасли, где закрытые модели и скрытые правила модерации являются обычным явлением.

- Этические и геополитические соображения: С другой стороны, полное устранение цензуры поднимает сложные этические вопросы. Одной из непосредственных проблем является то, как эта неотцензурированная модель может быть использована в контекстах, где цензурируемые темы являются незаконными или опасными. Например, если кто-то в материковом Китае использовал R1 1776, неотцензурированные ответы модели о площади Тяньаньмэнь или Тайване могут подвергнуть пользователя риску. Есть также более широкий геополитический сигнал: американская компания, изменяющая модель китайского происхождения, чтобы бросить вызов китайской цензуре, может рассматриваться как смелая идеологическая позиция. Само название «1776» подчеркивает тему освобождения, которая не осталась незамеченной. Некоторые критики утверждают, что замена одного набора предубеждений другим возможна – по сути, подвергая сомнению, может ли модель теперь отражать западную точку зрения в чувствительных областях. Дебаты подчеркивают, что цензура против открытости в ИИ – это не просто технический вопрос, но политический и этический. Где один человек видит необходимая модерация, другой видит цензурой, и найти правильный баланс непросто.

Отмена цензуры широко приветствуется как шаг к более прозрачным и полезным в глобальном масштабе моделям ИИ, но она также служит напоминанием о том, что такое ИИ должен сказать, что это деликатный вопрос, по которому нет всеобщего согласия.

(Источник: Perplexity AI)

Общая картина: цензура ИИ и прозрачность открытого исходного кода

Запуск R1 1776 от Perplexity происходит в то время, когда сообщество ИИ сталкивается с вопросами о том, как модели должны обрабатывать спорный контент. Цензура в моделях ИИ может исходить из многих мест. В Китае, Технологические компании обязаны встраивать строгие фильтры и даже жестко закодированные ответы на политически чувствительные темы. DeepSeek R1 является ярким примером этого — это была модель с открытым исходным кодом, но она явно несла отпечаток норм цензуры Китая в своем обучении и тонкой настройке. Напротив, многие модели, разработанные на Западе, такие как GPT-4 OpenAI или LLaMA Meta, не обязаны рекомендациям КПК, но у них все еще есть уровни модерации (для таких вещей, как разжигание ненависти, насилие или дезинформация), которые некоторые пользователи называют «цензурой». Граница между разумная умеренность и нежелательная цензура может быть размытым и часто зависит от культурной или политической точки зрения.

То, что Perplexity AI сделала с DeepSeek R1, наводит на мысль, что модели с открытым исходным кодом можно адаптировать к различным системам ценностей или нормативным средам. Теоретически можно создать несколько версий модели: одну, которая соответствует китайским нормам (для использования в Китае), и другую, которая полностью открыта (для использования в других местах). R1 1776 по сути является последним случаем — неотцензурированным форком, предназначенным для глобальной аудитории, которая предпочитает неотфильтрованные ответы. Такой тип форка возможен только потому, что веса DeepSeek R1 были общедоступны. Он подчеркивает преимущество открытого исходного кода в ИИ: прозрачность. Любой может взять модель и настроить ее, будь то добавление мер безопасности или, как в этом случае, снятие наложенных ограничений. Открытие исходного кода обучающих данных модели, кода или весов также означает, что сообщество может проверить, как была изменена модель. (Perplexity не полностью раскрыла все источники данных, которые она использовала для децензурирования, но, опубликовав саму модель, они позволили другим наблюдать за ее поведением и даже переобучать ее при необходимости.)

Это событие также намекает на более широкую геополитическую динамику развития ИИ. Мы наблюдаем форму диалога (или конфронтации) между различными моделями управления ИИ. Разработанная в Китае модель с определенными заложенными мировоззрениями взята американской командой и изменена для отражения более открытой информационной этики. Это свидетельство того, как глобальный и безграничный Технология ИИ заключается в следующем: исследователи в любой точке мира могут опираться на работу друг друга, но они не обязаны переносить изначальные ограничения. Со временем мы можем увидеть больше примеров этого — когда модели «переводятся» или корректируются между различными культурными контекстами. Это поднимает вопрос о том, может ли ИИ когда-либо стать по-настоящему универсальным или мы в конечном итоге получим версии, специфичные для региона, которые придерживаются местных норм. Прозрачность и открытость предоставляют один из путей для навигации: если все стороны могут проверять модели, по крайней мере, разговор о предвзятости и цензуре выходит на открытое пространство, а не скрывается за корпоративной или правительственной тайной.

Наконец, шаг Perplexity подчеркивает ключевой момент в дебатах о контроле ИИ: Кто решает, что может сказать ИИ, а что нет? В проектах с открытым исходным кодом эта власть становится децентрализованной. Сообщество — или отдельные разработчики — могут решить внедрить более строгие фильтры или ослабить их. В случае R1 1776 Perplexity решила, что преимущества нецензурированной модели перевешивают риски, и у них была свобода сделать этот выбор и публично поделиться результатом. Это смелый пример экспериментов, которые позволяет открытая разработка ИИ.