Искусственный интеллект

Создание языковой модели в стиле GPT для одного вопроса

Исследователи из Китая разработали экономичный метод создания систем обработки естественного языка в стиле GPT-3, избегая при этом все более непомерно высоких затрат времени и денег, связанных с обучением больших объемов данных — растущая тенденция, которая в противном случае грозит в конечном итоге отодвинуть этот сектор ИИ на второй план. игрокам FAANG и инвесторам высокого уровня.

Предлагаемая структура называется Управляемое задачами языковое моделирование (ТЛМ). Вместо того, чтобы обучать огромную и сложную модель на обширном корпусе из миллиардов слов и тысяч меток и классов, TLM вместо этого обучает гораздо меньшую модель, которая на самом деле включает запрос непосредственно внутри модели.

Слева — типичный гипермасштабный подход к языковым моделям большого объема; справа — тонкий метод TLM для исследования большого языкового корпуса по каждой теме или вопросу. Источник: https://arxiv.org/pdf/2111.04130.pdf

По сути, уникальный алгоритм или модель НЛП создается для того, чтобы ответить на один вопрос, вместо того, чтобы создавать громоздкую и громоздкую общую языковую модель, которая может отвечать на более широкий спектр вопросов.

При тестировании TLM исследователи обнаружили, что новый подход дает результаты, которые аналогичны или лучше, чем предварительно обученные языковые модели, такие как РОБЕРТа-Большойи гипермасштабные системы обработки естественного языка, такие как GPT-3 от OpenAI, TRILLION Parameter Switch Transformer от Google Модель, Корея Гиперклевер, AI21 Labs' Юрский 1и Microsoft Мегатрон-Тьюринг NLG 530B.

В испытаниях TLM на восьми наборах классификационных данных в четырех областях авторы дополнительно обнаружили, что система снижает количество обучающих FLOP (операций с плавающей запятой в секунду) требуется на два порядка. Исследователи надеются, что TLM сможет «демократизировать» сектор, который становится всё более элитарным, с моделями NLP настолько большими, что их невозможно установить локально, и вместо этого, как в случае GPT-3, они остаются позади завышенным ценам на API, и API с ограниченным доступом OpenAI и, теперь Microsoft Azure.

Авторы заявляют, что сокращение времени обучения на два порядка снижает стоимость обучения более 1,000 графических процессоров в течение одного дня до 8 графических процессоров за 48 часов.

Новый докладе называется НЛП с нуля без крупномасштабного предварительного обучения: простая и эффективная структура, и исходит от трех исследователей из Университета Цинхуа в Пекине и исследователя из китайской компании по разработке ИИ Recurrent AI, Inc.

Недоступные ответы

Команда стоят обучения эффективным, универсальным языковым моделям все чаще характеризуется как потенциальный «термический предел» того, в какой степени производительное и точное НЛП может действительно распространиться в культуре.

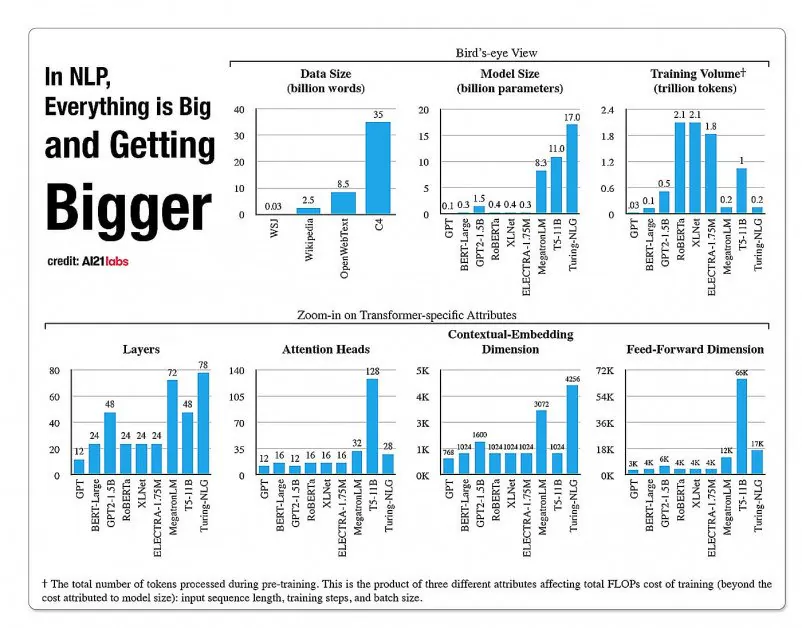

Статистика роста фасетов в архитектурах моделей НЛП из отчета A2020 Labs за 121 год. Источник: https://arxiv.org/pdf/2004.08900.pdf

В 2019 году исследователь рассчитанный что обучение стоит 61,440 XNUMX долларов США. XLNet модель (в то время сообщалось, что он превзошел BERT в задачах NLP) более 2.5 дней на 512 ядрах на 64 устройствах, в то время как GPT-3 оценкам обучение обошлось в 12 миллионов долларов, что в 200 раз превышает затраты на обучение его предшественника, GPT-2 (хотя недавние переоценки утверждают, что теперь его можно обучить за всего 4,600,000 доллара на самых дешевых облачных графических процессорах).

Подмножества данных на основе запросов

Вместо этого новая предлагаемая архитектура направлена на получение точных классификаций, меток и обобщений с использованием запроса в качестве своего рода фильтра для определения подмножества информации из большой языковой базы данных, которая будет обучаться вместе с запросом для предоставления ответов. на ограниченную тему.

Авторы заявляют:

«TLM мотивируется двумя ключевыми идеями. Во-первых, люди справляются с заданием, используя лишь небольшую часть знаний о мире (например, учащимся нужно просмотреть всего несколько глав из всех книг в мире, чтобы зубрить перед экзаменом).

Мы предполагаем, что в большом корпусе данных для конкретной задачи существует значительная избыточность. Во-вторых, обучение на контролируемых размеченных данных гораздо более эффективно с точки зрения производительности в дальнейшем, чем оптимизация цели языкового моделирования на неразмеченных данных. Исходя из этих причин, TLM использует данные задачи в качестве запросов для извлечения небольшого подмножества общего корпуса. После этого выполняется совместная оптимизация цели контролируемой задачи и цели языкового моделирования с использованием как извлеченных данных, так и данных задачи.

Помимо доступности высокоэффективного обучения моделям НЛП, авторы видят ряд преимуществ в использовании моделей НЛП, ориентированных на задачи. Во-первых, исследователи могут наслаждаться большей гибкостью благодаря настраиваемым стратегиям длины последовательности, токенизации, настройке гиперпараметров и представлению данных.

Исследователи также предвидят разработку гибридных будущих систем, которые компенсируют ограниченное предварительное обучение PLM (которое иначе не ожидается в текущей реализации) с большей универсальностью и обобщением по сравнению со временем обучения. Они считают эту систему шагом вперед в продвижении методов обобщения с нулевым выстрелом в предметной области.

Тестирование и результаты

TLM был протестирован на задачах классификации в восьми задачах в четырех областях — биомедицинские науки, новости, обзоры и информатика. Задачи были разделены на высокоресурсные и низкоресурсные категории. Высокоресурсные задачи включали более 5,000 данных о задачах, таких как АГНовости и RCT, среди прочего; задачи с низкими ресурсами включали ChemProt и ACL-ARC, а также Гиперпартизан набор данных обнаружения новостей.

Исследователи разработали два тренировочных набора под названием Corpus-BERT и Corpus-RoBERTa, последний в десять раз больше первого. Эксперименты сравнивали общие предварительно обученные языковые модели. БЕРТ (из Google) и РОБЕРТА (от Facebook) к новой архитектуре.

В документе отмечается, что, хотя TLM является общим методом и должен быть более ограниченным по объему и применимости, чем более широкие и объемные современные модели, он способен выполнять методы тонкой настройки, близкие к адаптивным к предметной области.

Результаты сравнения производительности TLM с наборами на основе BERT и RoBERTa. В результатах указан средний балл F1 по трем различным шкалам обучения, а также указано количество параметров, общее количество вычислений для обучения (FLOP) и размер тренировочного корпуса.

Авторы приходят к выводу, что TLM способен достигать результатов, сравнимых или даже лучше, чем PLM, со значительным сокращением необходимых FLOP и требуя только 1/16 обучающего корпуса. В средних и больших масштабах TLM, по-видимому, может улучшить производительность в среднем на 0.59 и 0.24 балла, при этом уменьшая размер обучающих данных на два порядка.

«Эти результаты подтверждают, что TLM обладает высокой точностью и значительно более высокой эффективностью, чем PLM. Более того, TLM получает больше преимуществ в эффективности при больших масштабах. Это указывает на то, что PLM большего масштаба, возможно, были обучены хранить более общие знания, которые бесполезны для конкретной задачи».