Artificial Intelligence

LoReFT: точная настройка представления языковых моделей

Методы точной настройки с эффективным использованием параметров или методы PeFT направлены на адаптацию больших языковых моделей посредством обновлений к небольшому количеству весов. Однако большая часть существующих работ по интерпретации продемонстрировала, что представления кодируют богатую семантическую информацию, что позволяет предположить, что это может быть лучшей и более мощной альтернативой редактированию этих представлений. Предварительно обученные большие модели часто настраиваются для использования в новых областях или задачах, а в процессе тонкой настройки одна базовая модель может быть адаптирована к широкому кругу задач даже при наличии лишь небольших объемов внутридоменных данных. к модели. Однако процесс тонкой настройки всей модели ресурсоемок и дорог, особенно для языковых моделей со значительно большим количеством размеров и параметров.

Методы точной настройки с эффективным использованием параметров или PeFT предлагают решить проблему высоких затрат, связанных с точной настройкой всей модели, путем обновления только небольшого количества доступных общих весов, и этот процесс помогает сократить время обучения и использование памяти. Что еще более важно, так это то, что методы точной настройки с эффективным использованием параметров или PeFT продемонстрировали эффективность, аналогичную точной настройке в нескольких практических условиях. Адаптеры, общее семейство методов точной настройки с эффективным использованием параметров или методов PeFT, изучают редактирование, которое можно добавить к дополнительному набору весов, которые работают вместе с замороженной базовой моделью, а последние адаптеры, такие как LoRA, уменьшают количество обучаемых параметров в изученных обновления веса за счет использования аппроксимаций низкого ранга вместо полновесовых матриц при обучении адаптеров.

Поскольку предыдущие работы демонстрировали, что редактирование представлений может быть лучшей альтернативой методам точной настройки с эффективным использованием параметров или методам PeFT, в этой статье мы будем говорить о методах точной настройки представления или методах ReFT, которые работают с замороженной моделью, и изучим конкретные задачи. вмешательства в скрытые представления. Целью этой статьи является подробное освещение платформы ReFt или тонкой настройки представления, и мы исследуем механизм, методологию, архитектуру платформы, а также ее сравнение с современными платформами. Итак, давайте начнем.

ReFT: точная настройка представления для языковых моделей

Пытаясь адаптировать предварительно обученные языковые модели к новым областям и задачам, существующие платформы часто настраивают эти предварительно обученные языковые модели, поскольку благодаря реализованному процессу тонкой настройки единая базовая модель может быть адаптирована к множеству даже самых разных задач. при работе с небольшим объемом внутридоменных данных. Хотя процесс тонкой настройки действительно повышает общую производительность, это дорогостоящий процесс, особенно если языковая модель имеет значительно большое количество параметров. Чтобы решить эту проблему и снизить связанные с этим затраты, необходимо использовать PeFT или параметрически-эффективный подход. точная настройка фреймворков обновлять только небольшую часть общих весов. Этот процесс не только сокращает время обучения, но и уменьшает использование памяти, позволяя платформам PeFT достигать аналогичной производительности по сравнению с подходами полной точной настройки в практических сценариях. Адаптеры, общее семейство PeFT, работают путем обучения редактированию, которое можно добавить к дополнительному набору гирь вместе с подмножеством гирь, которые работают в унисон с базовой моделью с замороженными гирями. Последние платформы адаптеров, такие как ЛоРА и КЛоРА продемонстрировали, что можно обучать адаптеры полной точности поверх моделей пониженной точности без ущерба для производительности. Адаптеры обычно более эффективны и действенны по сравнению с другими методами, которые вводят новые компоненты модели.

Главной особенностью современных систем точной настройки, эффективных по параметрам, является то, что вместо изменения представлений они изменяют веса. Однако структуры, занимающиеся интерпретируемостью, продемонстрировали, что представления кодируют богатую семантическую информацию, что позволяет предположить, что редактирование представлений может быть лучшим и более мощным подходом по сравнению с обновлением веса. Это предположение о том, что редактирование представлений является лучшим подходом, составляет основу ReFT или структуры точной настройки представлений, которая обучает вмешательствам вместо адаптации весов модели, позволяя модели манипулировать небольшой частью всех представлений в попытке управлять поведением модели. для решения последующих задач во время вывода. Методы ReFT или точной настройки представления являются полной заменой основанных на весах систем точной настройки PeFT или эффективных по параметрам. Подход ReFT черпает вдохновение из последних моделей, работающих с большими интерпретируемыми моделями, которые вмешиваются в представления, чтобы найти точные причинные механизмы, и управляют поведением модели во время вывода, и поэтому его можно рассматривать как обобщение моделей редактирования представлений. Основываясь на том же, LoReFT или подпространство низкого ранга ReFT является сильным и эффективным примером ReFT и представляет собой параметризацию ReFT, которая вмешивается в скрытые представления в линейном пространстве, охватываемом матрицей проекции низкого ранга, и строится непосредственно на DAS. или структура поиска распределенного выравнивания.

В отличие от полной точной настройки, система PeFT или структура тонкой настройки с эффективным использованием параметров обучает лишь небольшую часть параметров модели и позволяет адаптировать модель к последующим задачам. Среду точной настройки с эффективным использованием параметров можно разделить на три основные категории:

- Методы на основе адаптера: Методы на основе адаптеров обучают дополнительные модули, такие как полносвязные слои поверх предварительно обученной модели с замороженными весами. Последовательные адаптеры вставляют компоненты между многослойным персептроном или MLP и LM или уровнями внимания большой модели, тогда как параллельные адаптеры добавляют модули рядом с существующими компонентами. Поскольку адаптеры добавляют новые компоненты, которые невозможно легко сложить в существующие веса модели, они создают дополнительную нагрузку при выводе.

- ЛоРА: LoRA и его недавние варианты аппроксимируют аддитивные веса во время обучения с использованием матриц низкого ранга, и они не требуют дополнительных накладных расходов во время вывода, поскольку обновления весов могут быть объединены в модель, и это причина, по которой они считаются текущими. самые сильные структуры PeFT.

- Методы на основе подсказок: Методы на основе подсказок добавляют во входные данные мягкие токены, которые инициализируются случайным образом, и обучают их внедрения, сохраняя при этом веса языковой модели замороженными. Производительность, обеспечиваемая этими методами, часто неудовлетворительна по сравнению с другими подходами PeFT, и они также несут значительные накладные расходы.

Вместо обновления весов структура ReFT изучает вмешательства для изменения небольшой части общих представлений. Более того, недавние работы по проектированию представлений и управлению активацией показали, что добавление фиксированных векторов управления к остаточному потоку может облегчить определенный уровень контроля над предварительно обученными большими поколениями моделей, не требуя ресурсоемких вычислений. тонкая настройка. Другие платформы продемонстрировали, что редактирование представлений с помощью обученной операции масштабирования и перевода может попытаться соответствовать, но не превзойти производительность, предлагаемую адаптерами LoRA, для широкого спектра задач с меньшим количеством изученных параметров. Кроме того, успех этих фреймворков в решении ряда задач продемонстрировал, что представления, представленные предварительно обученными языковыми моделями, несут богатую семантику, хотя производительность этих моделей неоптимальна, в результате чего PeFT продолжает оставаться современным подходом. без дополнительной нагрузки на вывод.

ReFT: Методология и архитектура

Чтобы упростить процесс сохранения стиля, платформа ReFT предполагает в качестве целевой модели большую модель на основе преобразователя, которая способна создавать контекстуальное представление последовательности токенов. Для заданной последовательности с n количеством входных токенов структура ReFT сначала встраивает эти входные токены в список представлений, после чего m слоев последовательно вычисляют список скрытых представлений как функцию предыдущего списка скрытых представлений. Каждое скрытое представление является вектором, и языковая модель использует окончательные скрытые представления для создания прогнозов. Структура ReFT учитывает как модели языка в масках, так и модели авторегрессионного языка. Теперь, согласно гипотезе линейного представления, в нейронных сетях понятия кодируются внутри линейных подпространств представлений. Недавние модели показали, что это утверждение верно для моделей нейронных сетей, обученных на естественном языке наряду с другими распределениями входных данных.

Более того, в исследованиях интерпретируемости структура случайной абстракции использует вмешательства обмена, чтобы случайно установить роль компонентов нейронной сети при реализации определенного поведения. Логика вмешательства обмена заключается в том, что если кто-то фиксирует представление таким, каким оно было бы для контрфактических входных данных, и это вмешательство последовательно влияет на выходные данные модели так же, как утверждения, сделанные структурой ReFT о компоненте, ответственном за создание это представление, то компонент играет причинную роль в поведении. Хотя существует несколько методов, вмешательство распределенного обмена является идеальным подходом для проверки того, закодировано ли понятие в линейном подпространстве представления, как утверждает гипотеза линейного представления. Кроме того, метод DAS ранее использовался для поиска линейного представления в языковых моделях атрибутов объектов, настроений, лингвистических особенностей и математических рассуждений. Однако несколько экспериментов показали, что метод DAS очень выразителен и обладает способностью находить причинно-следственные эффективные подпространства, даже когда модель языка преобразователя была инициализирована случайным образом, и, следовательно, еще не изучены какие-либо представления для конкретных задач, что приводит к спорят, является ли DAS эффективным и достаточно ответственным для задач интерпретируемости.

Выразительность, предлагаемая DAS, предполагает, что этот подход может стать идеальным инструментом для управления поведением языковой модели, а также ее работой над управляемой генерацией и ответственным редактированием. Поэтому, чтобы адаптировать языковые модели для последующих задач, структура ReFT использует операцию вмешательства распределенного обмена, чтобы создать новый метод, эффективный по параметрам. Более того, метод ReFT представляет собой набор вмешательств, и его структура требует, чтобы для любых двух вмешательств, действующих на одном уровне, позиции вмешательства должны быть непересекающимися, при этом параметры всех функций вмешательства остаются независимыми. В результате ReFT представляет собой общую структуру, которая включает в себя вмешательство в скрытые представления во время прямого прохода модели.

ReFT: эксперименты и результаты

Чтобы оценить свою производительность по сравнению с существующими платформами PEFT, платформа ReFT проводит эксперименты по четырем различным тестам обработки естественного языка и охватывает более 20 наборов данных, при этом основная цель — предоставить полную картину того, как платформа LoReFT работает в различных сценариях. Более того, когда структура LoReFT реализуется в реальной жизни, разработчикам необходимо решить, сколько вмешательств нужно изучить, а также входные позиции и слои для применения каждого из них. Для выполнения задачи платформа ReFT настраивает четыре гиперпараметра.

- Количество позиций префикса, в которых необходимо вмешаться.

- Количество позиций суффикса, в которые необходимо вмешаться.

- Какой набор слоев вмешиваться.

- Следует ли связывать параметры вмешательства в разных позициях на одном слое.

Поступая таким образом, платформа ReFT упрощает пространство поиска гиперпараметров и обеспечивает только фиксированную дополнительную стоимость вывода, которая не зависит от длины приглашения.

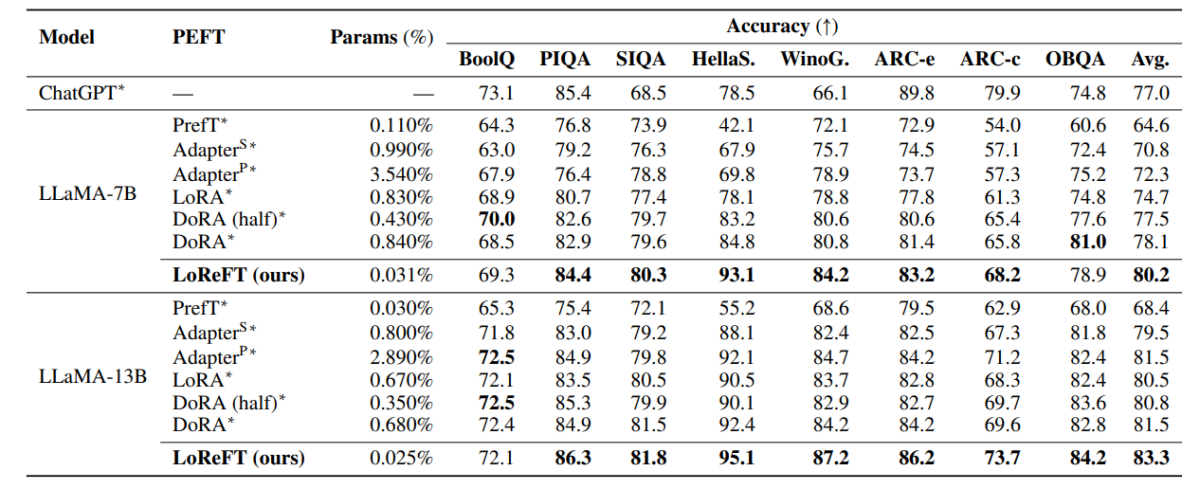

В приведенной выше таблице сравнивается точность рамок LLaMA-7B и LLaMA-13B с существующими моделями PEFT в восьми наборах данных для рассуждений на основе здравого смысла. Как можно заметить, модель LoReFT значительно превосходит существующие подходы PEFT, несмотря на гораздо меньшее количество параметров, при этом средняя производительность трех прогонов сообщается с разными начальными параметрами для модели LoReFT. Параметр (%) рассчитывается путем деления количества обучаемых параметров на количество общих параметров базовой большой модели.

В приведенной выше таблице суммировано сравнение точности инфраструктур LLaMA-7B и LLaMA-13B с существующими моделями PEFT для 4 различных наборов данных арифметических рассуждений, при этом структура сообщает среднюю производительность трех прогонов с разными случайными начальными числами. Как можно заметить, несмотря на гораздо меньшее количество параметров (%), структура LoReFT значительно превосходит существующие структуры PEFT.

В приведенной выше таблице суммировано сравнение точности базовых платформ RoBERTa и больших платформ RoBERTa с существующими моделями PEFT в тесте GLUE, причем платформа сообщает о средней производительности пяти прогонов с различными случайными начальными числами. Как можно заметить, несмотря на гораздо меньшее количество параметров (%), структура LoReFT значительно превосходит существующие структуры PEFT.

Заключение

В этой статье мы говорили о LoReFT, мощной альтернативе существующим структурам PEFT, которая обеспечивает высокую производительность в тестах из четырех различных областей, предлагая при этом эффективность, до 50 раз превышающую эффективность, предлагаемую предыдущими современными моделями PEFT. Предварительно обученные большие модели часто настраиваются для использования в новых областях или задачах, а в процессе тонкой настройки одна базовая модель может быть адаптирована к широкому кругу задач даже при наличии лишь небольших объемов внутридоменных данных. к модели. Однако процесс тонкой настройки всей модели ресурсоемок и дорог, особенно для языковых моделей со значительно большим количеством размеров и параметров. Методы точной настройки с эффективным использованием параметров или PeFT предлагают решить проблему высоких затрат, связанных с точной настройкой всей модели, путем обновления только небольшого количества доступных общих весов, и этот процесс помогает сократить время обучения и использование памяти. Примечательно, что LoReFT демонстрирует новые современные возможности в области здравого смысла, следования инструкциям и понимания естественного языка по сравнению с самыми сильными PEFT.