Искусственный интеллект

Изменение эмоций в видеоматериалах с помощью ИИ

Исследователи из Греции и Великобритании разработали новый подход к глубокому обучению для изменения выражений и кажущегося настроения людей в видеозаписях, сохраняя при этом точность движения их губ в исходном звуке, чего не удавалось добиться в предыдущих попытках. .

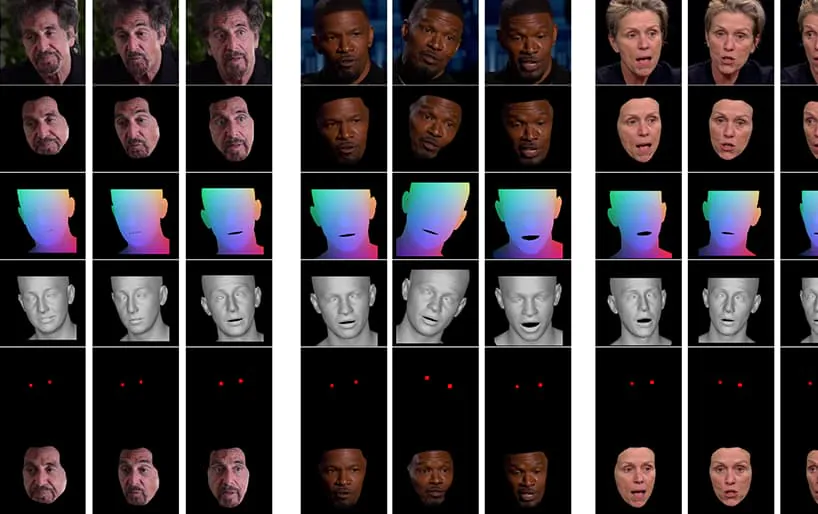

Из видео, прилагаемого к статье (вставлено в конце статьи), короткий фрагмент, где выражение лица актёра Аль Пачино слегка изменено с помощью NED, основанного на высокоуровневых семантических концепциях, определяющих отдельные выражения лица и связанные с ними эмоции. Метод «Reference-Driven» (справа) берёт интерпретированную эмоцию(и) исходного видео и применяет её ко всей видеопоследовательности. Источник: https://www.youtube.com/watch?v=Li6W8pRDMJQ

Эта конкретная область попадает в растущую категорию поддельные эмоции, где личность говорящего сохраняется, но его мимика и микровыражения изменяются. По мере развития этой технологии искусственного интеллекта, она позволяет кино- и телепроизводству вносить едва заметные изменения в мимику актёров, а также открывает довольно новую категорию видео-дипфейков с «изменёнными эмоциями».

Меняющиеся лица

Выражения лиц публичных деятелей, таких как политики, тщательно контролируются; в 2016 году выражение лица Хиллари Клинтон стало... под пристальным вниманием СМИ за их потенциальное негативное влияние на ее электоральные перспективы; мимика, оказывается, тоже интересующая тема в ФБР; и они критический показатель на собеседованиях при приеме на работу, что делает (далекую) перспективу использования живого фильтра «контроля выражения лица» желанной разработкой для соискателей работы, пытающихся пройти предварительный отбор в Zoom.

Исследование 2005 года, проведенное в Великобритании, показало, что внешний вид лица влияет на решения голосования, в то время как статья Washington Post 2019 года исследовала использование вырванных из контекста видеороликов, что в настоящее время является ближайшей вещью, которую сторонники фейковых новостей действительно могут изменить, как публичная фигура выглядит, как ведет себя, реагирует или чувствует.

На пути к манипулированию нейронными выражениями

В настоящее время состояние искусства манипулирования лицевым аффектом находится в зачаточном состоянии, поскольку оно включает в себя решение распутывание концепций высокого уровня (таких как грустный, сердитый, счастливый, улыбаться) из фактического видеоконтента. Хотя традиционные архитектуры дипфейков, по-видимому, достаточно хорошо достигают этого распутывания, отражение эмоций разных личностей по-прежнему требует, чтобы два обучающих набора лиц содержали совпадающие выражения для каждой личности.

Типичные примеры изображений лиц в наборах данных, используемых для обучения дипфейков. В настоящее время манипулировать выражением лица человека можно только путём создания специфических для ID нейронных сетей, отвечающих за выражение лица. Программное обеспечение для дипфейков 2017 года не обладает встроенным семантическим пониманием «улыбки» — оно просто сопоставляет воспринимаемые изменения геометрии лица двух людей.

Желательно, но пока еще не полностью достигнуто, распознать, как улыбается субъект Б (например), и просто создать 'улыбка' переключаться в архитектуре без необходимости сопоставлять ее с эквивалентным изображением улыбающегося субъекта А.

Команда Новый документ называется Neural Emotion Director: семантический контроль мимики с сохранением речи в видео «в дикой природе», и исходит от исследователей из Школы электротехники и вычислительной техники Афинского национального технического университета, Института компьютерных наук Фонда исследований и технологий Hellas (FORTH) и Колледжа инженерии, математики и физических наук в Афинах. Университет Эксетера в Великобритании.

Команда разработала фреймворк под названием Директор по нейронным эмоциям (NED), включающая сеть перевода эмоций на основе 3D, Трехмерный манипулятор эмоций.

NED принимает полученную последовательность параметров выражений лица и транслирует их в целевой домен. Обучение проходит на непараллельных данных, что означает отсутствие необходимости обучения на наборах данных, где каждой личности соответствует своё выражение лица.

Видео, показанное в конце этой статьи, проходит через серию тестов, в которых NED накладывает очевидное эмоциональное состояние на кадры из набора данных YouTube.

Авторы утверждают, что NED — это первый видеометод «управления» актерами в случайных и непредсказуемых ситуациях, и выложили код на NED. Проект страницу.

Метод и архитектура

Система обучена на двух больших наборах видеоданных, аннотированных метками «эмоции».

Вывод осуществляется с помощью видеорендерера лиц, который преобразует желаемые эмоции в видео, используя традиционные методы синтеза изображения лица, включая сегментацию лица, выравнивание лицевых ориентиров и смешивание, при котором синтезируется только область лица, а затем накладывается на исходный материал.

Архитектура конвейера нейронного детектора эмоций (NED). Источник: https://arxiv.org/pdf/2112.00585.pdf

Сначала система получает трёхмерное восстановление лица и накладывает выравнивания по ориентирам лица на входные кадры для определения выражения. После этого восстановленные параметры выражения передаются в трёхмерный манипулятор эмоций, где вычисляется вектор стиля с помощью семантической метки (например, «счастливый») или с помощью файла-образца.

Эталонный файл — это видео, изображающее конкретное распознанное выражение/эмоцию, которое затем накладывается на все целевое видео, заменяя исходное выражение.

Окончательная сгенерированная 3D-форма лица затем объединяется с нормализованной средней координатой лица (NMFC) и изображениями глаз (красные точки на изображении выше) и передается нейронному рендереру, который выполняет окончательную манипуляцию.

Результаты

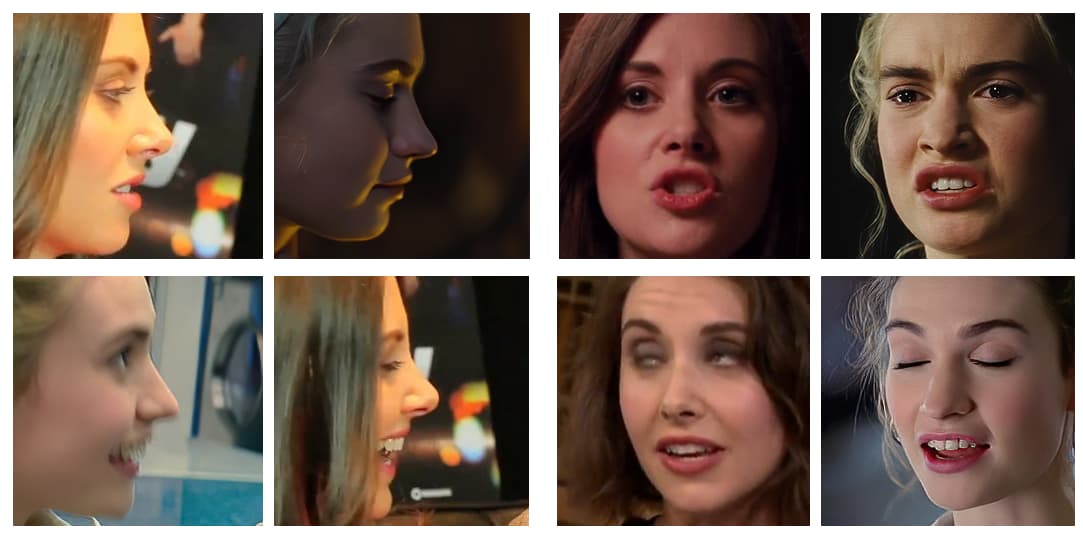

Исследователи провели обширные исследования, в том числе исследования пользователей и абляции, чтобы оценить эффективность метода по сравнению с предыдущими работами, и обнаружили, что в большинстве категорий NED превосходит текущий уровень техники в этом подсекторе нейронных манипуляций с лицом.

Авторы статьи предполагают, что последующие реализации этой работы и инструменты аналогичного характера будут полезны в первую очередь в телевизионной и киноиндустрии, заявляя:

«Наш метод открывает множество новых возможностей для полезного применения технологий нейронного рендеринга: от постобработки фильмов и видеоигр до фотореалистичных аффективных аватаров».

Это ранняя работа в этой области, но одна из первых, в которой предпринята попытка воссоздания лиц с помощью видео, а не статичных изображений. Хотя видео, по сути, представляет собой множество статичных изображений, сменяющих друг друга очень быстро, существуют временные факторы, которые делают предыдущие методы передачи эмоций менее эффективными. В прилагаемом видео и примерах в статье авторы приводят визуальное сравнение результатов NED с другими сопоставимыми современными методами.

Более подробные сравнения и многие другие примеры NED можно найти в полном видео ниже:

3 декабря 2021 г., 18:30 GMT+2 – По просьбе одного из авторов статьи были внесены исправления в «справочный файл», который я ошибочно принял за фотографию (хотя на самом деле это видеоклип). Также было внесено изменение в название Института компьютерных наук Фонда исследований и технологий.

3 декабря 2021 г., 20:50 GMT+2 – Второй запрос от одного из авторов статьи о внесении дополнительных изменений в название вышеупомянутого учреждения.