Artificial Intelligence

Первая годовщина ChatGPT: меняя будущее взаимодействия с искусственным интеллектом

Если вспомнить первый год ChatGPT, становится ясно, что этот инструмент существенно изменил сферу искусственного интеллекта. Запущенный в конце 2022 года ChatGPT выделялся своим удобным диалоговым стилем, благодаря которому взаимодействие с ИИ больше походило на общение с человеком, чем с машиной. Этот новый подход быстро привлек внимание общественности. Всего за пять дней после выпуска ChatGPT уже привлек миллион пользователей. К началу 2023 года это число выросло примерно до 100 миллионов пользователей в месяц, а к октябрю платформа привлекла около 1.7 миллиарда посещений по всему миру. Эти цифры говорят красноречивее всяких слов о его популярности и полезности.

За последний год пользователи нашли множество творческих способов использования ChatGPT: от простых задач, таких как написание электронных писем и обновление резюме, до начала успешного бизнеса. Но дело не только в том, как люди его используют; сама технология выросла и улучшилась. Изначально ChatGPT был бесплатным сервисом, предлагающим подробные текстовые ответы. Теперь есть ChatGPT Plus, который включает ChatGPT-4. Эта обновленная версия обучена на большем количестве данных, дает меньше неправильных ответов и лучше понимает сложные инструкции.

Одним из самых больших обновлений является то, что ChatGPT теперь может взаимодействовать несколькими способами: он может слушать, говорить и даже обрабатывать изображения. Это означает, что вы можете разговаривать с ним через мобильное приложение и показывать ему фотографии, чтобы получить ответы. Эти изменения открыли новые возможности для ИИ и изменили то, как люди смотрят и думают о роли ИИ в нашей жизни.

Путь ChatGPT, от его создания в качестве технологической демонстрации до нынешнего статуса крупного игрока в мире технологий, весьма впечатляет. Первоначально это рассматривалось как способ протестировать и улучшить технологию путем получения обратной связи от общественности. Но он быстро стал неотъемлемой частью ландшафта искусственного интеллекта. Этот успех показывает, насколько эффективна точная настройка больших языковых моделей (LLM) как с контролируемым обучением, так и с обратной связью от людей. В результате ChatGPT может решать широкий спектр вопросов и задач.

Гонка за разработку наиболее эффективных и универсальных систем искусственного интеллекта привела к распространению как открытых, так и проприетарных моделей, таких как ChatGPT. Понимание их общих возможностей требует комплексных тестов для широкого спектра задач. В этом разделе рассматриваются эти тесты, проливающие свет на то, как разные модели, включая ChatGPT, соотносятся друг с другом.

Оценка программ LLM: критерии

- МТ-Скамья: В этом тесте проверяются навыки многоходовой беседы и выполнения инструкций в восьми областях: письмо, ролевая игра, извлечение информации, рассуждение, математика, программирование, знания STEM и гуманитарные/социальные науки. В качестве оценщиков используются более сильные LLM, такие как GPT-4.

- АльпакаЭвал: основанный на наборе оценок AlpacaFarm, этот автоматический оценщик на основе LLM сравнивает модели с ответами продвинутых LLM, таких как GPT-4 и Claude, рассчитывая процент побед моделей-кандидатов.

- Открыть таблицу лидеров LLM: с помощью системы оценки языковой модели эта таблица лидеров оценивает студентов LLM по семи ключевым критериям, включая задачи на рассуждение и тесты на общие знания, как в условиях нулевого, так и малого количества попыток.

- БОЛЬШАЯ скамья: этот совместный тест охватывает более 200 новых языковых задач, охватывающих широкий спектр тем и языков. Его цель — изучить LLM и спрогнозировать их будущие возможности.

- ЧатЭвал: мультиагентная структура дебатов, которая позволяет командам автономно обсуждать и оценивать качество ответов различных моделей на открытые вопросы и традиционные задачи генерации естественного языка.

Сравнительная производительность

Что касается общих показателей, программы LLM с открытым исходным кодом продемонстрировали значительный прогресс. Лама-2-70Б, например, достиг впечатляющих результатов, особенно после точной настройки с помощью данных инструкций. Его вариант, Llama-2-chat-70B, преуспел в AlpacaEval с процентом побед 92.66%, превзойдя GPT-3.5-turbo. Тем не менее, GPT-4 остается лидером с процентом побед 95.28%.

Зефир-7Б, меньшая модель, продемонстрировала возможности, сравнимые с более крупными LLM 70B, особенно в AlpacaEval и MT-Bench. Между тем, WizardLM-70B, настроенный для работы с разнообразными командными данными, набрал самый высокий балл среди LLM с открытым исходным кодом на MT-Bench. Однако он все равно отставал от ГПТ-3.5-турбо и ГПТ-4.

Интересная работа, GodziLLa2-70B, получила конкурентную оценку в таблице лидеров Open LLM, демонстрируя потенциал экспериментальных моделей, объединяющих различные наборы данных. Аналогичным образом, Yi-34B, разработанный с нуля, выделился с оценками, сравнимыми с GPT-3.5-турбо, и лишь немного отстал от GPT-4.

UltraLlama с ее тонкой настройкой на разнообразные и высококачественные данные соответствовала GPT-3.5-turbo в предлагаемых тестах и даже превзошла его в областях мировых и профессиональных знаний.

Расширение масштабов: появление гигантских программ LLM

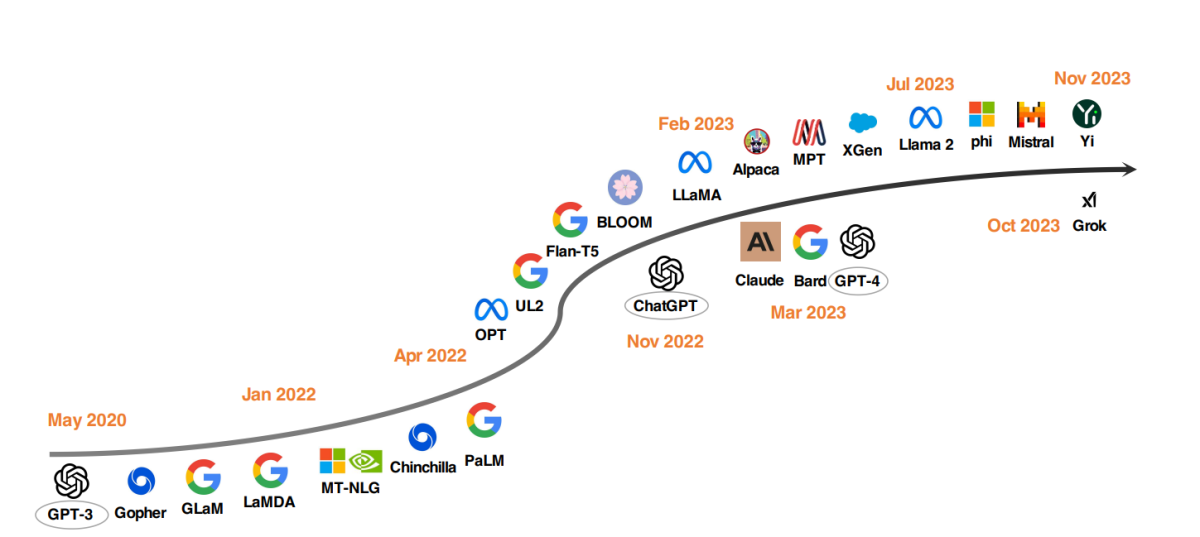

Заметной тенденцией в развитии LLM стало увеличение параметров модели. Такие модели, как Gopher, GLaM, LaMDA, MT-NLG и PaLM, раздвинули границы, достигнув кульминации в моделях, содержащих до 540 миллиардов параметров. Эти модели продемонстрировали исключительные возможности, но их природа с закрытым исходным кодом ограничила их более широкое применение. Это ограничение стимулировало интерес к развитию LLM с открытым исходным кодом, и эта тенденция набирает обороты.

Параллельно с увеличением размеров моделей исследователи изучали альтернативные стратегии. Вместо того, чтобы просто увеличивать модели, они сосредоточились на улучшении предварительного обучения моделей меньшего размера. Примеры включают Шиншиллу и UL2, которые показали, что больше не всегда лучше; более разумные стратегии также могут дать эффективные результаты. Кроме того, значительное внимание уделяется настройке инструкций языковых моделей, причем такие проекты, как FLAN, T0 и Flan-T5, вносят значительный вклад в эту область.

Катализатор ChatGPT

Внедрение OpenAI ChatGPT ознаменовало поворотный момент в исследованиях НЛП. Чтобы конкурировать с OpenAI, такие компании, как Google и Anthropic, запустили свои собственные модели Bard и Claude соответственно. Хотя эти модели во многих задачах демонстрируют производительность, сравнимую с ChatGPT, они все же отстают от последней модели от OpenAI, GPT-4. Успех этих моделей в первую очередь объясняется обучением с подкреплением на основе обратной связи с человеком (RLHF), методикой, которая получает все большее внимание исследователей для дальнейшего совершенствования.

Слухи и спекуляции вокруг Q* (Q-Star) OpenAI

Последние отчеты предполагают, что исследователи из OpenAI, возможно, достигли значительного прогресса в области ИИ благодаря разработке новой модели под названием Q* (произносится как Q-звезда). Предположительно, Q* обладает способностью решать математические задачи на уровне начальной школы — подвиг, который вызвал дискуссии среди экспертов о его потенциале как вехи на пути к искусственному общему интеллекту (AGI). Хотя OpenAI не прокомментировала эти сообщения, слухи о способностях Q* вызвали значительный ажиотаж и спекуляции в социальных сетях и среди энтузиастов искусственного интеллекта.

Разработка Q* примечательна тем, что существующие языковые модели, такие как ChatGPT и GPT-4, хотя и способны решать некоторые математические задачи, не особенно подходят для их надежного решения. Проблема заключается в том, что модели ИИ должны не только распознавать закономерности, как это происходит в настоящее время посредством глубокого обучения и преобразователей, но также рассуждать и понимать абстрактные концепции. Математика, будучи эталоном рассуждения, требует от ИИ планирования и выполнения нескольких шагов, демонстрируя глубокое понимание абстрактных концепций. Эта способность ознаменует значительный скачок в возможностях ИИ, потенциально выходя за рамки математики и позволяя решать другие сложные задачи.

Однако эксперты предостерегают от чрезмерного преувеличения этого развития. Хотя система искусственного интеллекта, которая надежно решает математические задачи, была бы впечатляющим достижением, она не обязательно означает появление сверхразумного искусственного интеллекта или ОИИ. Текущие исследования ИИ, в том числе усилия OpenAI, сосредоточены на элементарных проблемах, с разной степенью успеха в более сложных задачах.

Потенциальные достижения таких приложений, как Q*, огромны: от индивидуального обучения до помощи в научных исследованиях и разработке. Однако также важно управлять ожиданиями и осознавать ограничения и проблемы безопасности, связанные с такими достижениями. Обеспокоенность по поводу того, что ИИ представляет экзистенциальные риски, и это основная проблема OpenAI, остается актуальной, особенно по мере того, как системы ИИ начинают все больше взаимодействовать с реальным миром.

Движение LLM с открытым исходным кодом

Чтобы стимулировать исследования LLM с открытым исходным кодом, Meta выпустила модели серии Llama, вызвав волну новых разработок на основе Llama. Сюда входят модели, точно настроенные с помощью данных инструкций, такие как Alpaca, Vicuna, Lima и WizardLM. Исследования также направлены на расширение возможностей агентов, логическое рассуждение и долгоконтекстное моделирование в рамках структуры на основе Llama.

Кроме того, наблюдается растущая тенденция разработки мощных программ LLM с нуля с помощью таких проектов, как MPT, Falcon, XGen, Phi, Baichuan, Мистраль, Grokи Йи. Эти усилия отражают стремление демократизировать возможности программ LLM с закрытым исходным кодом, делая передовые инструменты искусственного интеллекта более доступными и эффективными.

Влияние ChatGPT и моделей с открытым исходным кодом в здравоохранении

Мы смотрим в будущее, в котором LLM помогают вести клинические записи, заполнять формы для возмещения расходов и поддерживать врачей в диагностике и планировании лечения. Это привлекло внимание как технологических гигантов, так и учреждений здравоохранения.

от Microsoft обсуждения с Epic, ведущий поставщик программного обеспечения для электронных медицинских записей, сигнализирует об интеграции программ LLM в здравоохранение. Инициативы уже реализованы в Медицинском центре Калифорнийского университета в Сан-Диего и Медицинском центре Стэнфордского университета. Аналогично, Google партнерские отношения с клиникой Мэйо и Amazon Web ServicesЗапуск HealthScribe, службы клинической документации с использованием искусственного интеллекта, знаменует собой значительный прогресс в этом направлении.

Однако такое быстрое развертывание вызывает опасения по поводу передачи контроля над медициной в пользу корпоративных интересов. Запатентованный характер этих программ LLM затрудняет их оценку. Их возможная модификация или прекращение по соображениям рентабельности может поставить под угрозу уход за пациентами, конфиденциальность и безопасность.

Острая необходимость заключается в открытом и инклюзивном подходе к развитию LLM в здравоохранении. Медицинские учреждения, исследователи, врачи и пациенты должны сотрудничать во всем мире для создания программ LLM с открытым исходным кодом для здравоохранения. Этот подход, аналогичный Консорциуму триллионов параметров, позволит объединить вычислительные, финансовые ресурсы и опыт.