Artificial Intelligence

Лама 2: глубокое погружение в претендента на ChatGPT с открытым исходным кодом

Большие языковые модели (LLM), способные решать сложные логические задачи, показали себя многообещающе в специализированных областях, таких как программирование и творческое письмо. Однако мир LLM — это не просто рай «подключи и работай»; существуют проблемы с удобством использования, безопасностью и вычислительными требованиями. В этой статье мы углубимся в возможности Llama 2, а также подробное описание настройки этого высокопроизводительного LLM с помощью графических процессоров Hugging Face и T4 в Google Colab.

Эта модель большого языка с открытым исходным кодом, разработанная компанией Meta в сотрудничестве с Microsoft, призвана переопределить сферы генеративного искусственного интеллекта и понимания естественного языка. Llama 2 — это не просто еще одна статистическая модель, обученная на терабайтах данных; это воплощение философии. Тот, который подчеркивает подход с открытым исходным кодом как основу разработки ИИ, особенно в области генеративного ИИ.

Llama 2 и его оптимизированный для диалогов аналог Llama 2-Chat оснащены до 70 миллиардами параметров. Они подвергаются процессу тонкой настройки, призванному привести их в соответствие с предпочтениями человека, что делает их более безопасными и эффективными, чем многие другие общедоступные модели. Этот уровень детализации при тонкой настройке часто сохраняется для закрытых «продуктовых» LLM, таких как ChatGPT и BARD, которые обычно недоступны для публичного изучения или настройки.

Технический обзор Llama 2

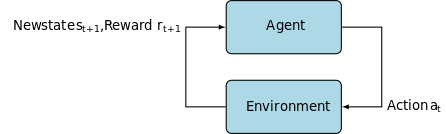

Для тренировки модель Лама 2; как и его предшественники, он использует авторегрессию. трансформаторная архитектура, предварительно обученный на обширном массиве данных самоконтроля. Однако он добавляет дополнительный уровень сложности за счет использования обучения с подкреплением и обратной связью с человеком (RLHF), чтобы лучше согласовывать его с поведением и предпочтениями человека. Это требует больших вычислительных затрат, но жизненно важно для повышения безопасности и эффективности модели.

Предварительное обучение и эффективность данных

Основная инновация Llama 2 заключается в режиме предварительной тренировки. Модель повторяет черты своей предшественницы, Llama 1, но имеет несколько важных усовершенствований, повышающих ее производительность. Примечательно, что выделяется 40%-ное увеличение общего количества обученных токенов и двукратное увеличение длины контекста. Более того, модель использует внимание к групповым запросам (GQA) для повышения масштабируемости вывода.

Контролируемая точная настройка (SFT) и обучение с подкреплением с обратной связью от человека (RLHF)

Llama-2-chat был тщательно настроен с использованием SFT и обучения с подкреплением и обратной связью с человеком (RLHF). В этом контексте SFT служит неотъемлемым компонентом структуры RLHF, уточняя реакцию модели, чтобы она точно соответствовала человеческим предпочтениям и ожиданиям.

OpenAI предоставил содержательную иллюстрацию, объясняющую методологии SFT и RLHF, используемые в InstructGPT. Как и LLaMa 2, InstructGPT также использует эти передовые методы обучения для оптимизации производительности своей модели.

Шаг 1 на изображении ниже посвящен контролируемой точной настройке (SFT), а последующие шаги завершают процесс обучения с подкреплением на основе обратной связи с человеком (RLHF).

Контролируемая точная настройка (SFT) — это специализированный процесс, направленный на оптимизацию предварительно обученной модели большого языка (LLM) для конкретной последующей задачи. В отличие от неконтролируемых методов, которые не требуют проверки данных, SFT использует набор данных, который был предварительно проверен и помечен.

Как правило, создание таких наборов данных является дорогостоящим и трудоемким процессом. Подход Ламы 2 заключался в том, что качество важнее количества. Сделав всего 27,540 XNUMX аннотаций, команда Меты достигла уровня производительности, конкурентоспособного с человеческими аннотаторами. Это хорошо согласуется с недавние исследования показывая, что даже ограниченные, но чистые наборы данных могут обеспечить высококачественные результаты.

В процессе SFT предварительно обученный LLM подвергается воздействию помеченного набора данных, где в игру вступают алгоритмы контролируемого обучения. Внутренние веса модели перекалибровываются на основе градиентов, рассчитанных на основе функции потерь для конкретной задачи. Эта функция потерь количественно определяет расхождения между прогнозируемыми результатами модели и фактическими метками истинности.

Эта оптимизация позволяет LLM улавливать сложные закономерности и нюансы, заложенные в размеченном наборе данных. Следовательно, модель становится не просто обобщенным инструментом, а превращается в специализированный актив, способный выполнить целевую задачу с высокой степенью точности.

Обучение с подкреплением — это следующий шаг, направленный на более точное согласование поведения модели с предпочтениями человека.

На этапе настройки использовалось обучение с подкреплением на основе обратной связи с человеком (RLHF), применяя такие методы, как Выборка по важности высокопоставленных Проксимальная политика оптимизации вводить алгоритмический шум, тем самым уклоняясь от локальных оптимумов. Эта итеративная точная настройка не только улучшила модель, но и привела ее результаты в соответствие с человеческими ожиданиями.

Llama 2-Chat использовал протокол двоичного сравнения для сбора данных о предпочтениях человека, что отмечает заметную тенденцию к более качественным подходам. Этот механизм информирует модели вознаграждения, которые затем используются для точной настройки диалоговой модели ИИ.

Призрачное внимание: многоходовые диалоги

Meta представила новую функцию Ghost Attention (GAtt), которая предназначена для повышения производительности Llama 2 в многоходовых диалогах. Это эффективно решает постоянную проблему потери контекста в текущих разговорах. Gatt действует как якорь, связывая начальные инструкции со всеми последующими сообщениями пользователя. В сочетании с методами обучения с подкреплением это помогает генерировать последовательные, релевантные и ориентированные на пользователя ответы в ходе более длительных диалогов.

Из репозитория Meta Git с использованием download.sh

- Посетите мета-сайт: Перейдите к Официальный сайт Llama 2 от Meta и нажмите «Загрузить модель»

- Заполните детали: Прочитайте и примите условия, чтобы продолжить.

- Подтверждение электронной почты: После отправки формы вы получите электронное письмо от Meta со ссылкой для загрузки модели из их репозитория git.

- Выполните download.sh: Клонируйте репозиторий Git и выполните

download.shсценарий. Этот скрипт предложит вам пройти аутентификацию с использованием URL-адреса из Meta, срок действия которого истекает через 24 часа. Вы также выберете размер модели — 7B, 13B или 70B.

От обнимающего лица

- Получить электронное письмо с подтверждением: Получив доступ из Meta, перейдите в Обнимая лицо.

- Запрос доступа: выберите желаемую модель и отправьте запрос на предоставление доступа.

- Подтверждение: Ожидайте электронное письмо о предоставлении доступа в течение 1–2 дней.

- Генерация токенов доступа: перейдите в «Настройки» в своей учетной записи Hugging Face, чтобы создать токены доступа.

Версия Transformers 4.31 полностью совместима с LLaMa 2 и открывает множество инструментов и функций в экосистеме Hugging Face. Набор инструментов обширен: от сценариев обучения и вывода до 4-битного квантования с использованием битов и байтов и эффективной точной настройки параметров (PEFT). Для начала убедитесь, что вы используете последнюю версию Transformers и вошли в свою учетную запись Hugging Face.

Вот упрощенное руководство по выполнению вывода модели LLaMa 2 в Google Colab среде, используя среду выполнения графического процессора:

Установка пакета

!pip install transformers !huggingface-cli login

Импортируйте необходимые библиотеки Python.

from transformers import AutoTokenizer import transformers import torch

Инициализируйте модель и токенизатор

На этом этапе укажите, какую модель Llama 2 вы будете использовать. В этом руководстве мы используем мета-лама/Llama-2-7b-chat-hf.

model = "meta-llama/Llama-2-7b-chat-hf" tokenizer = AutoTokenizer.from_pretrained(model)

Настройка конвейера

Используйте конвейер Hugging Face для генерации текста с определенными настройками:

pipeline = transformers.pipeline(

"text-generation",

model=model,

torch_dtype=torch.float16,

device_map="auto")

Генерация текстовых последовательностей

Наконец, запустите конвейер и сгенерируйте текстовую последовательность на основе введенных вами данных:

sequences = pipeline(

'Who are the key contributors to the field of artificial intelligence?\n',

do_sample=True,

top_k=10,

num_return_sequences=1,

eos_token_id=tokenizer.eos_token_id,

max_length=200)

for seq in sequences:

print(f"Result: {seq['generated_text']}")

Пользовательский интерфейс A16Z для LLaMa 2

Andreessen Horowitz (A16Z) недавно запустил передовой интерфейс чат-бота на основе Streamlit, адаптированный для Llama 2. Этот пользовательский интерфейс, размещенный на GitHub, сохраняет историю сеанса чата, а также обеспечивает гибкость выбора из нескольких конечных точек API Llama 2, размещенных на копировать. Этот ориентированный на пользователя дизайн призван упростить взаимодействие с Llama 2, что делает его идеальным инструментом как для разработчиков, так и для конечных пользователей. Для тех, кто заинтересован в этом, живая демо-версия доступна по адресу Лама2.ай.

Llama 2: Чем она отличается от GPT Models и ее предшественницы Llama 1?

Разнообразие масштабов

В отличие от многих языковых моделей, которые предлагают ограниченную масштабируемость, Llama 2 предоставляет вам множество различных вариантов моделей с различными параметрами. Модель масштабируется от 7 до 70 миллиардов параметров, обеспечивая тем самым широкий спектр конфигураций для удовлетворения разнообразных вычислительных потребностей.

Расширенная длина контекста

Модель имеет увеличенную длину контекста в 4 КБ токенов, чем Llama 1. Это позволяет ей сохранять больше информации, тем самым повышая ее способность понимать и генерировать более сложный и обширный контент.

Внимание к групповым запросам (GQA)

В архитектуре используется концепция GQA, предназначенный для ускорения процесса вычисления внимания за счет кэширования предыдущих пар токенов. Это эффективно улучшает масштабируемость вывода модели и повышает доступность.

Тесты производительности

LLama 2 установила новый стандарт показателей производительности. Он не только превосходит своего предшественника LLama 1, но и составляет значительную конкуренцию другим моделям, таким как Falcon и GPT-3.5.

Самая крупная модель Llama 2-Chat, 70B, также превосходит ChatGPT в 36% случаев и соответствует производительности еще в 31.5% случаев. Источник: бумага & картон

Открытый исходный код: сила сообщества

Meta и Microsoft намерены сделать Llama 2 больше, чем просто продуктом; они рассматривают его как инструмент, управляемый сообществом. Доступ к Llama 2 бесплатен как для исследовательских, так и для некоммерческих целей. Они стремятся демократизировать возможности искусственного интеллекта, сделав его доступным для стартапов, исследователей и бизнеса. Парадигма открытого исходного кода позволяет осуществлять «краудсорсинговое устранение неполадок» модели. Разработчики и специалисты по этике искусственного интеллекта могут проводить стресс-тестирование, выявлять уязвимости и предлагать решения в ускоренном темпе.

Хотя условия лицензирования LLaMa 2 в целом разрешающие, Исключения существуют. Крупные предприятия с более чем 700 миллионами пользователей в месяц, такие как Google, требуют явного разрешения Meta для его использования. Дополнительно лицензия запрещает использование LLaMa 2 для улучшения других языковых моделей.

Текущие проблемы с Llama 2

- Обобщение данных: И Llama 2, и GPT-4 иногда дают сбои в одинаково высокой производительности при выполнении различных задач. В этих сценариях качество и разнообразие данных так же важны, как и объем.

- Прозрачность модели: Учитывая предыдущие неудачи, когда ИИ давал вводящие в заблуждение результаты, изучение обоснования принятия решений, лежащих в основе этих сложных моделей, имеет первостепенное значение.

Code Llama – последний релиз Meta

Мета недавно анонсировала Код Ламы это большая языковая модель, специализирующаяся на программировании с размерами параметров от 7 до 34 байт. Похожий на Интерпретатор кода ChatGPT; Code Llama может упростить рабочие процессы разработчиков и сделать программирование более доступным. Он поддерживает различные языки программирования и поставляется в специализированных вариантах, таких как Code Llama-Python для задач, специфичных для Python. Модель также предлагает различные уровни производительности для удовлетворения различных требований к задержке. Code Llama имеет открытую лицензию и приглашает сообщество внести свой вклад в постоянное улучшение.

Представляем Code Llama, инструмент искусственного интеллекта для кодирования

Заключение

В этой статье вы познакомились с настройкой модели Llama 2 для генерации текста в Google Colab с поддержкой Hugging Face. Производительность Llama 2 обеспечивается множеством передовых технологий, от архитектуры авторегрессионного преобразователя до обучения с подкреплением с обратной связью от человека (RLHF). Обладая до 70 миллиардами параметров и функциями, такими как Ghost Attention, эта модель превосходит текущие отраслевые стандарты в определенных областях, а благодаря своей открытой природе она прокладывает путь к новой эре в понимании естественного языка и генеративном искусственном интеллекте.