Anderson's Angle

Wydajność Vibe Coding Spada, Gdy Rola AI Się Zwiększa

Nowe badanie wykazuje, że vibe coding poprawia się, gdy instrukcje dają ludzie, ale pogarsza, gdy robi to AI, przy czym najlepsza hybrydowa konfiguracja utrzymuje człowieka na pierwszym miejscu, z AI jako arbitrem lub sędzią.

Nowe badania ze Stanów Zjednoczonych, analizujące, co się dzieje, gdy systemom AI pozwala się sterować vibe coding, a nie tylko wykonywać ludzkie instrukcje, wykazały, że gdy Duże Modele Językowe (LLM) przejmują większą rolę kierowniczą, wyniki są prawie zawsze gorsze.

Chociaż badacze wykorzystali GPT-5 od OpenAI jako ramy dla swoich eksperymentów z współpracy człowiek/AI, później potwierdzili, że zarówno Claude Opus 4.5 od Anthropic, jak i Google Gemini 3 Pro podlegały tej samej krzywej pogorszenia wraz ze wzrostem odpowiedzialności, stwierdzając, że “nawet ograniczone zaangażowanie człowieka stale poprawia wydajność”:

“[Ludzie] zapewniają wyjątkowo skuteczne wysokopoziomowe wskazówki w kolejnych iteracjach, [podczas gdy] wskazówki AI często prowadzą do załamania wydajności. Stwierdzamy również, że ostrożny podział ról, który utrzymuje ludzi przy ustalaniu kierunku, a zleca ocenę AI, może poprawić wydajność hybrydową.”

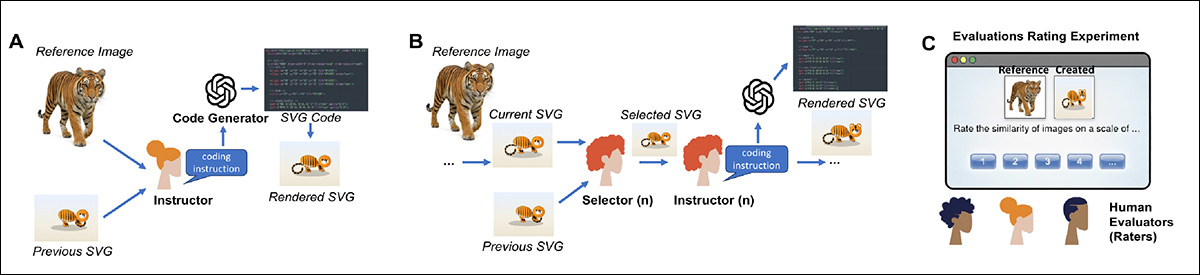

Aby zapewnić spójny test, który mógłby być oceniany zarówno przez ludzi, jak i przez AI, zbudowano kontrolowane ramy eksperymentalne wokół iteracyjnego zadania kodowania, w którym obraz referencyjny – przedstawiający zdjęcie kota, psa, tygrysa, ptaka, słonia, pingwina, rekina, zebry, żyrafy lub pandy – musiał zostać odtworzony przy użyciu skalowalnej grafiki wektorowej (SVG), a to odtworzenie było oceniane względem źródłowego zdjęcia, z którego pochodziło:

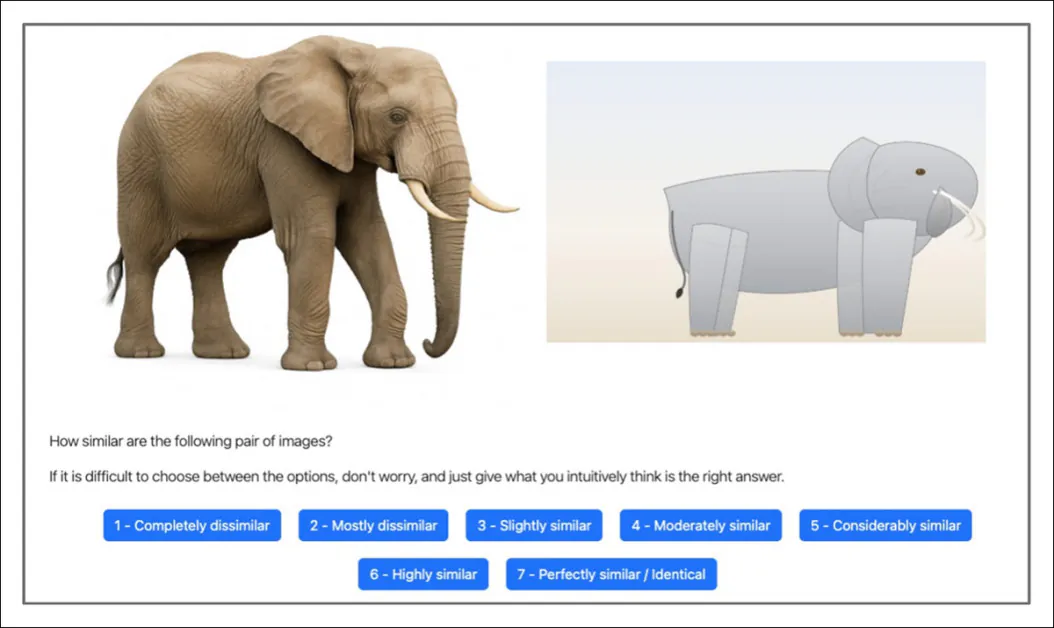

Zarówno ludzkim, jak i AI uczestnikom pokazano referencyjne zdjęcie obok rekonstrukcji SVG wygenerowanej przez AI i poproszono o ocenę, jak podobne są te dwa obrazy w siedmiostopniowej skali. Źródło

W każdej rundzie jeden agent dostarczał wysokopoziomowych instrukcji w języku naturalnym, aby kierować generatorem kodu, a drugi decydował, czy zachować nową wersję, czy wrócić do poprzedniej – ustrukturyzowana pętla odzwierciedlająca rzeczywiste przepływy pracy w współpracy.

W 16 eksperymentach z udziałem 604 uczestników i tysięcy wywołań API, w pełni prowadzone przez ludzi rundy testowe porównano bezpośrednio z w pełni prowadzonymi przez AI rundami, w pozostałych identycznych warunkach.

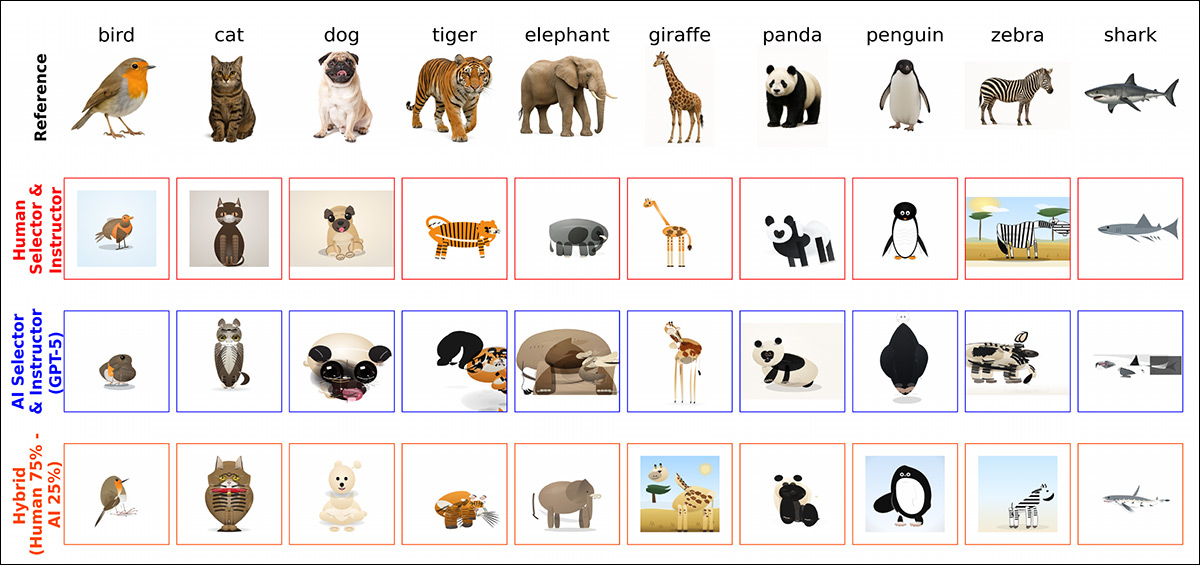

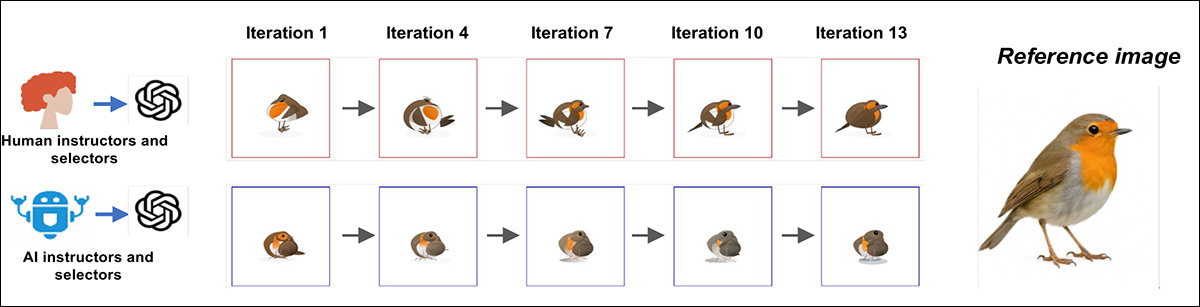

Niektóre z różnorodnych rozwiązań osiągniętych przez różne kombinacje procentów i typów współpracy człowiek/AI (zaczerpnięte z większej ilustracji w artykule źródłowym, do której odsyłamy czytelnika).

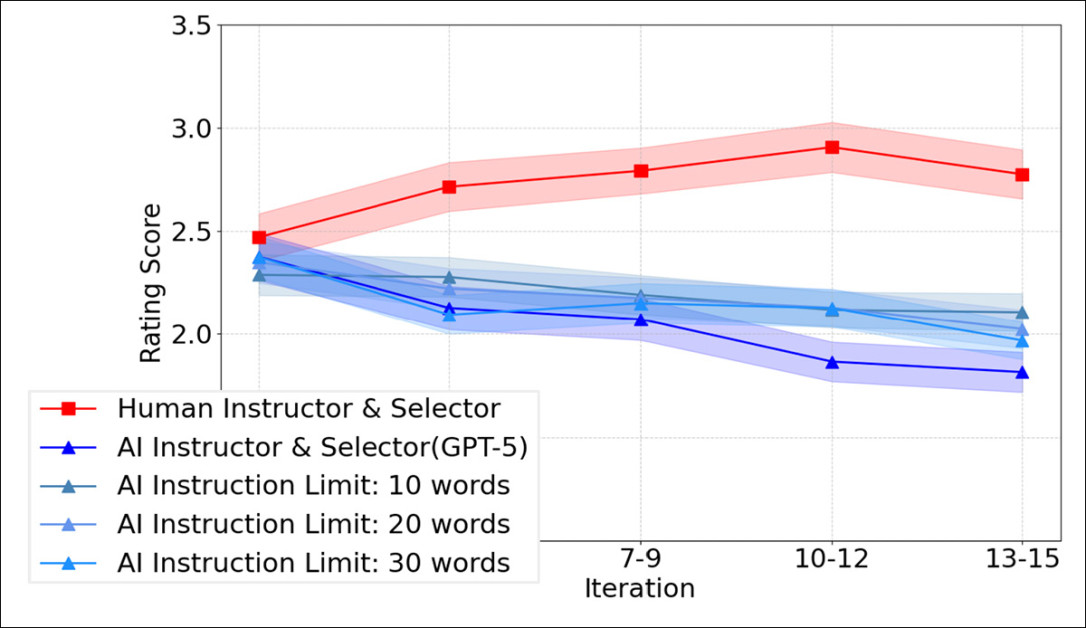

Chociaż ludzie i AI osiągali podobne poziomy na początku testów, z czasem ich trajektorie się rozchodziły: gdy ludzie dostarczali instrukcji i podejmowali decyzje selekcji, wyniki podobieństwa rosły w kolejnych iteracjach, z ciągłą kumulatywną poprawą; ale gdy systemy AI wypełniały obie role, wydajność nie wykazywała spójnych zysków i często spadała w kolejnych rundach – mimo że ten sam podstawowy model był używany do generowania kodu, a AI miała dostęp do tych samych informacji co uczestnicy ludzcy.

Efkt Prolixity

Wyniki pokazały również, że instrukcje ludzi były zazwyczaj krótkie i zorientowane na działanie, skupiając się na tym, co zmienić następnie w obecnym obrazie; odwrotnie, instrukcje AI były znacznie dłuższe i mocno opisowe (czynnik, który był sparametryzowany dla GPT-5), szczegółowo opisując atrybuty wizualne, zamiast priorytetyzować przyrostową korektę.

Ale, jak widać na poniższym wykresie, narzucenie ścisłych limitów słów na instrukcje AI nie odwróciło wzorca; nawet ograniczone do 10, 20 lub 30 słów, łańcuchy prowadzone przez AI nadal nie poprawiały się z czasem:

Oceny podobieństwa w kolejnych iteracjach dla rund prowadzonych przez ludzi w porównaniu z w pełni prowadzonymi przez AI rundami z instrukcjami ograniczonymi do 10, 20 lub 30 słów. Jak widać, skracanie promptów AI nie zapobiega obserwowanemu spadkowi wydajności iteracyjnej, gdy AI kieruje zarówno instrukcją, jak i selekcją.

Eksperymenty hybrydowe uczyniły wzorzec wyraźniejszym, pokazując, że dodanie nawet odrobiny zaangażowania człowieka poprawiało wyniki w porównaniu z konfiguracjami w pełni prowadzonymi przez AI; jednak wydajność zwykle spadała, gdy udział wskazówek AI wzrastał.

Gdy role zostały rozdzielone, ocenę i selekcję można było przekazać AI ze stosunkowo niewielką utratą jakości; ale zastąpienie ludzkiej wysokopoziomowej instrukcji wskazówkami AI prowadziło do zauważalnego spadku wydajności, co sugeruje, że najważniejsze było nie to, kto wygenerował kod, ale kto ustalił i utrzymał kierunek w kolejnych iteracjach.

Autorzy konkludują:

“W wielu eksperymentach kodowanie prowadzone przez ludzi konsekwentnie poprawiało się w iteracjach, podczas gdy kodowanie prowadzone przez AI często się załamywało, mimo dostępu do tych samych informacji i podobnych możliwości wykonawczych.”

“Wskazuje to na kluczowe trudności dzisiejszych systemów AI w utrzymaniu spójnego wysokopoziomowego kierunku w powtarzających się interakcjach, tego rodzaju, który jest niezbędny dla udanego vibe coding.”

Nowy artykuł nosi tytuł Why Human Guidance Matters in Collaborative Vibe Coding i pochodzi od siedmiu badaczy z Cornell University, Princeton University, Massachusetts Institute of Technology i New York University.

Metoda

Do eksperymentów ludzki instruktor patrzył na wygenerowane przez GPT-5 referencyjne zdjęcie zwierzęcia wraz z najnowszą powiązaną próbą imitacji SVG. Następnie pisał instrukcje w języku naturalnym, aby kierować generatorem kodu w kierunku bliższego dopasowania.

W ten sposób generator produkował nowy SVG w każdej rundzie, zapewniając iteracyjną pętlę do testowania, jak efekt wskazówek kumuluje się w czasie. Celami było dziesięć wygenerowanych przez GPT-5 obrazów zwierząt, obejmujących różne kształty i tekstury, tak aby poprawki lub błędy były łatwe do wykrycia:

Schemat przepływu pracy vibe coding użytego w badaniu. W A) ludzki instruktor ogląda referencyjny obraz fotograficzny wraz z najlepszym dotychczas wyprodukowanym SVG i pisze instrukcje w języku naturalnym dla generatora kodu, aby zastosował je przy produkcji następnego SVG; w B) ludzki selektor porównuje nowy SVG z poprzednim i wybiera, która wersja lepiej pasuje do obrazu referencyjnego, przed przekazaniem wybranego SVG do następnej rundy instrukcji; a w C) niezależni ludzcy ewaluatorzy oceniają, jak podobny jest każdy wygenerowany SVG do swojego obrazu referencyjnego, dostarczając oceny użyte do oceny ogólnej wydajności.

Ludzki selektor porównywał każdy nowo wygenerowany SVG z poprzednim i albo go akceptował, albo odrzucał, co utrzymywało proces zorientowany na obraz referencyjny w kolejnych rundach. W tej podstawowej konfiguracji tę samą rolę pełniła ta sama osoba.

Aby zmierzyć jakość, niezależni ludzcy ewaluatorzy oceniali, jak podobny był każdy wygenerowany SVG do swojego obrazu referencyjnego. W szesnastu eksperymentach 120 osób dostarczyło 4800 ocen. Wszystkie eksperymenty przeprowadzono w ramach PsyNet, portalu zaprojektowanego do obsługi ustrukturyzowanych interakcji między ludźmi a systemami AI.

Badanie rekrutowało 604 rodzimych użytkowników języka angielskiego, w testach, które zużyły 4800 wywołań API do generowania kodu i 5327 wywołań API do instrukcji. Chociaż głównym używanym modelem było GPT-5, mniejsze partie porównawcze wykonano z Claude Opus 4.5 i Gemini 3 Pro, z których każdy obsłużył 280 zapytań.

Wyniki

Przeprowadzono trzydzieści rund vibe coding, każda składająca się z piętnastu edycji podstawowych dziesięciu obrazów referencyjnych. Do tego wybrano 45 ludzkich uczestników, z których każdy pełnił rolę zarówno selektora, jak i instruktora przez dziesięć iteracji, w rundach “prowadzonych przez ludzi”.

W każdej turze ten sam uczestnik najpierw wybierał między obecnym a poprzednim SVG, a następnie pisał instrukcje na następną rundę. Druga wersja testu zastąpiła te ludzkie decyzje wywołaniami API do GPT-5, przy niezmienionych pozostałych ustawieniach. We wszystkich przypadkach role instruktora i selektora przekazywały generatorowi kodu prompty w zwykłym języku.

Reprezentatywny przykład wielorundowego vibe coding pokazuje, jak proces rozchodzi się w czasie; gdy ludzie działali zarówno jako selektor, jak i instruktor, wynik SVG stale się poprawiał w kolejnych iteracjach, zbliżając się do obrazu referencyjnego z każdą rundą:

Przykładowe progresje dla jednego obrazu referencyjnego w vibe coding prowadzonym przez ludzi (góra) i przez AI (dół), pokazujące stałą poprawę w iteracjach, gdy ludzie pełnią obie role, oraz stagnację lub dryf, gdy obie role są obsługiwane przez AI.

Odwrotnie, w wersji prowadzonej przez AI, wczesne rundy czasami uchwycały kluczowe cechy wizualne, ale późniejsze próby nie budowały na tych zyskach, a w niektórych przypadkach oddalały się od celu:

<img class=" wp-image-254938" src="https://www.unite.ai/wp-content/uploads/2026/02/figure-2-lower.jpg" alt="Ostateczne wyniki z ostatniej iteracji, porównujące tury prowadzone przez ludzi (górny rząd) z łańcuchami prowadzonymi przez AI (dolny rząd), dla tego samego zestaw