Szybka inżynieria

Zrozumienie dostrajania LLM: dostosowywanie modeli dużych języków do Twoich unikalnych wymagań

We wrześniu 2023 r. w krajobrazie modeli wielkojęzycznych (LLM) wciąż rośnie liczba modeli, w tym alpaki, sokoła, Lama 2, GPT-4 i wiele innych.

Ważnym aspektem wykorzystania potencjału tych LLM jest proces dostrajania – strategia, która pozwala na dostosowywanie wstępnie wyszkolonych modeli, aby precyzyjnie spełniać określone zadania. To dzięki temu dostrojeniu modele te mogą naprawdę dostosować się do zindywidualizowanych wymagań, oferując rozwiązania, które są zarówno innowacyjne, jak i dostosowane do unikalnych potrzeb.

Należy jednak pamiętać, że nie wszystkie możliwości dostrajania są sobie równe. Na przykład dostęp do możliwości dostrajania GPT-4 jest płatny i wymaga płatnej subskrypcji, która jest stosunkowo droższa w porównaniu z innymi opcjami dostępnymi na rynku. Z drugiej strony w domenie open source roi się od alternatyw, które oferują bardziej przystępną drogę do wykorzystania mocy dużych modeli językowych. Te opcje open source demokratyzują dostęp do zaawansowanej technologii sztucznej inteligencji, wspierając innowacje i włączenie w szybko rozwijającym się krajobrazie sztucznej inteligencji.

Dlaczego dostrojenie LLM jest ważne?

Dostrajanie LLM to coś więcej niż ulepszenie techniczne; jest to kluczowy aspekt rozwoju modelu LLM, który pozwala na bardziej szczegółowe i wyrafinowane zastosowanie w różnych zadaniach. Dostrajanie dostosowuje wstępnie wyszkolone modele, aby lepiej pasowały do konkretnych zbiorów danych, zwiększając ich wydajność w poszczególnych zadaniach i zapewniając bardziej ukierunkowane zastosowanie. Ujawnia niezwykłą zdolność LLM do dostosowywania się do nowych danych, wykazując elastyczność, która jest niezbędna w obliczu stale rosnącego zainteresowania zastosowaniami sztucznej inteligencji.

Dostrajanie dużych modeli językowych otwiera wiele możliwości, pozwalając im doskonale sprawdzać się w określonych zadaniach, od analizy sentymentu po przeglądy literatury medycznej. Dostrajając model bazowy do konkretnego przypadku użycia, odblokowujemy nowe możliwości, zwiększając jego wydajność i dokładność. Co więcej, ułatwia to bardziej ekonomiczne wykorzystanie zasobów systemowych, ponieważ dostrajanie wymaga mniejszej mocy obliczeniowej w porównaniu z trenowaniem modelu od podstaw.

W miarę zagłębiania się w ten przewodnik omówimy zawiłości dostrajania LLM, dając kompleksowy przegląd oparty na najnowszych osiągnięciach i najlepszych praktykach w tej dziedzinie.

Dostrajanie oparte na instrukcjach

Faza dostrajania w generatywna sztuczna inteligencja cykl życia przedstawiony na poniższym rysunku charakteryzuje się integracją wejść i wyjść instrukcji, w połączeniu z przykładami rozumowania krok po kroku. Takie podejście ułatwia modelowi generowanie odpowiedzi, które są nie tylko istotne, ale także precyzyjnie zgodne z zawartymi w nim konkretnymi instrukcjami. To właśnie na tym etapie wstępnie wytrenowane modele są dostosowywane do rozwiązywania różnych zadań i przypadków użycia, wykorzystując spersonalizowane zbiory danych w celu zwiększenia ich funkcjonalności.

Dostrajanie pojedynczego zadania

Dostrajanie pojedynczych zadań koncentruje się na doskonaleniu kompetencji modelu w konkretnym zadaniu, takim jak podsumowanie. To podejście jest szczególnie przydatne w optymalizacji przepływów pracy obejmujących obszerne dokumenty lub wątki konwersacji, w tym dokumenty prawne i zgłoszenia do działu obsługi klienta. Co ciekawe, takie dostrajanie może przynieść znaczną poprawę wydajności przy stosunkowo niewielkim zestawie przykładów, od 500 do 1000, w porównaniu z miliardami tokenów wykorzystywanymi w fazie wstępnego trenowania.

Podstawy LLM Fine-Tuning LLM: architektura transformatorów i nie tylko

Podróż ku zrozumieniu dostrajania LLM zaczyna się od zrozumienia podstawowych elementów tworzących LLM. Sercem tych modeli jest architektura transformatora, sieć neuronowa wykorzystująca mechanizmy samouważności do priorytetowego traktowania kontekstu słów nad ich bliskością w zdaniu. To innowacyjne podejście ułatwia głębsze zrozumienie odległych relacji pomiędzy tokenami na wejściu.

Poruszając się po zawiłościach transformatorów, napotykamy wieloetapowy proces rozpoczynający się od kodera. Ta początkowa faza obejmuje tokenizację danych wejściowych i utworzenie wektorów osadzania, które reprezentują dane wejściowe i jego pozycję w zdaniu. Kolejne etapy obejmują szereg obliczeń z wykorzystaniem macierzy tzw Pytanie, Wartość:, Klawisz, którego kulminacją jest wynik samouważności, który nakazuje skupienie się na różnych częściach zdania i różnych symbolach.

Dostrajanie stanowi kluczową fazę rozwoju LLM – procesu, który wymaga wprowadzenia subtelnych korekt w celu osiągnięcia bardziej pożądanych wyników. Ten etap, choć niezbędny, wiąże się z szeregiem wyzwań, w tym wymaganiami obliczeniowymi i pamięciowymi związanymi z obsługą ogromnej liczby parametrów. Efektywne dostrajanie parametrów (PEFT) oferuje techniki zmniejszania liczby parametrów do dostrojenia, upraszczając w ten sposób proces uczenia.

Szkolenie wstępne LLM: utworzenie mocnej bazy

Na początkowych etapach rozwoju LLM, szkolenie wstępne zajmuje centralne miejsce, wykorzystując transformatory o nadmiernej parametryzacji jako podstawową architekturę. Proces ten obejmuje modelowanie języka naturalnego na różne sposoby, takie jak dwukierunkowy, autoregresyjny lub sekwencja po sekwencji na dużych, nienadzorowanych korpusach. Celem jest stworzenie bazy, którą można później dostosować do konkretnych dalszych zadań poprzez wprowadzenie celów specyficznych dla zadania.

Godnym uwagi trendem w tym obszarze jest nieuchronny wzrost skali wstępnie wyszkolonych LLM, mierzonych liczbą parametrów. Dane empiryczne konsekwentnie pokazują, że większe modele w połączeniu z większą liczbą danych prawie zawsze dają lepszą wydajność. Na przykład GPT-3 ze swoimi 175 miliardami parametrów ustanowił punkt odniesienia w generowaniu wysokiej jakości języka naturalnego i sprawnym wykonywaniu szerokiej gamy zadań zero-shot.

Dostrajanie: droga do adaptacji modelu

Po szkoleniu wstępnym LLM przechodzi dostrajanie w celu dostosowania do konkretnych zadań. Pomimo obiecujących wyników wykazanych przez uczenie się kontekstowe we wstępnie przeszkolonych LLM, takich jak GPT-3, dostrajanie pozostaje lepsze w ustawieniach specyficznych dla zadania. Jednak powszechne podejście polegające na pełnym dostrajaniu parametrów stwarza wyzwania, w tym wysokie wymagania obliczeniowe i pamięci, zwłaszcza w przypadku modeli wielkoskalowych.

W przypadku dużych modeli językowych z ponad miliardem parametrów kluczowe znaczenie ma efektywne zarządzanie pamięcią RAM procesora graficznego. Pojedynczy parametr modelu przy pełnej 32-bitowej precyzji wymaga 4 bajtów miejsca, co przekłada się na wymaganie 4 GB pamięci RAM procesora graficznego, aby załadować model zawierający 1 miliard parametrów. Rzeczywisty proces uczenia wymaga jeszcze większej ilości pamięci, aby pomieścić różne komponenty, w tym stany optymalizatora i gradienty, co potencjalnie wymaga do 80 GB pamięci RAM procesora graficznego w przypadku modelu tej skali.

Aby pokonać ograniczenia pamięci RAM procesora graficznego, stosuje się kwantyzację, która jest techniką zmniejszającą precyzję parametrów modelu, zmniejszając w ten sposób wymagania dotyczące pamięci. Na przykład zmiana precyzji z 32-bitowej na 16-bitową może zmniejszyć o połowę ilość pamięci potrzebnej zarówno do ładowania, jak i uczenia modelu. W dalszej części tego artykułu. dowiemy się o Qlorze, która wykorzystuje koncepcję kwantyzacji do strojenia.

Odkrywanie kategorii metod PEFT

W procesie pełnego dostrajania modeli wielkojęzycznych ważne jest posiadanie konfiguracji obliczeniowej, która będzie w stanie skutecznie obsłużyć nie tylko znaczne wagi modeli, które w przypadku najbardziej zaawansowanych modeli osiągają obecnie rozmiary liczone w setkach gigabajtów, ale także zarządzać szereg innych kluczowych elementów. Obejmują one alokację pamięci dla stanów optymalizatora, zarządzanie gradientami, aktywacje do przodu i udostępnianie pamięci tymczasowej na różnych etapach procedury szkoleniowej.

Metoda addytywna

Ten typ dostrajania może rozszerzyć wstępnie wytrenowany model o dodatkowe parametry lub warstwy, koncentrując się na szkoleniu tylko nowo dodanych parametrów. Pomimo zwiększenia liczby parametrów metody te zwiększają efektywność czasu i przestrzeni szkolenia. Metoda addytywna jest dalej podzielona na podkategorie:

- Adaptery: Zawiera małe, w pełni połączone sieci, podwarstwy posttransformatorowe, czego godnymi uwagi przykładami są: AdaMix, KronaAi Kompaktor.

- Miękkie podpowiedzi: Dostrajanie segmentu osadzania danych wejściowych modelu poprzez opadanie gradientu, za pomocą IPT, strojenie prefiksówi WARP są wybitnymi przykładami.

- Inne podejścia addytywne: Uwzględnij techniki takie jak LeTS, AttentionFusion i Ladder-Side Tuning.

Metoda selektywna

Selektywne PEFT dostrajają ograniczoną liczbę górnych warstw w oparciu o typ warstwy i strukturę modelu wewnętrznego. Ta kategoria obejmuje metody takie jak BitFit oraz LN strojenie, które koncentruje się na dostrajaniu określonych elementów, takich jak odchylenia modelu lub określone wiersze.

Metoda oparta na reparametryzacji

Metody te wykorzystują reprezentacje niskiej rangi w celu zmniejszenia liczby parametrów, które można wytrenować, przy czym najbardziej znana to adaptacja niskiej rangi lub LoRA. Metoda ta wykorzystuje prosty rozkład macierzy niskiego rzędu w celu parametryzacji aktualizacji wag, demonstrując skuteczne dostrajanie w podprzestrzeniach niskiego rzędu.

1) LoRA (adaptacja niskiej rangi)

LoRA pojawiła się jako przełomowa technika PEFT, wprowadzona w artykule przez Edward J. Hu i inni w 2021 r. Działa w kategorii reparametryzacji, zamrażając oryginalne wagi LLM i integrując nowe możliwe do trenowania macierze niskiego rzędu z każdą warstwą architektury Transformera. Podejście to nie tylko ogranicza liczbę możliwych do wytrenowania parametrów, ale także skraca czas szkolenia i wymagane zasoby obliczeniowe, stanowiąc w ten sposób bardziej efektywną alternatywę dla pełnego dostrajania.

Aby zrozumieć mechanikę LoRA, należy ponownie przyjrzeć się architekturze transformatora, w której sygnał wejściowy podlega tokenizacji i konwersji na wektory osadzania. Wektory te przechodzą przez segmenty kodera i/lub dekodera transformatora, napotykając sieci samouważności i sieci wyprzedzające, których wagi są wstępnie trenowane.

LoRA wykorzystuje koncepcję Rozkład według wartości osobliwych (SVD). Zasadniczo SVD dzieli macierz na trzy różne macierze, z których jedna jest macierzą diagonalną zawierającą wartości osobliwe. Te pojedyncze wartości są kluczowe, ponieważ mierzą znaczenie różnych wymiarów w macierzach, przy czym większe wartości wskazują na większe znaczenie, a mniejsze oznaczają mniejsze znaczenie.

Takie podejście pozwala LoRA zachować podstawowe cechy danych przy jednoczesnej redukcji wymiarowości, optymalizując w ten sposób proces dostrajania.

LoRA interweniuje w tym procesie, zamrażając wszystkie oryginalne parametry modelu i wprowadzając parę „macierzy rozkładu rang” obok oryginalnych wag. Te mniejsze macierze, oznaczone jako A i B, podlegają szkoleniu poprzez uczenie się pod nadzorem.

Kluczowym elementem tej strategii jest parametr o nazwie ranga („r”), który określa rozmiar macierzy niskiej rangi. Skrupulatny dobór „r” może dać imponujące rezultaty, nawet przy mniejszej wartości, tworząc w ten sposób macierz niskiej rangi z mniejszą liczbą parametrów do trenowania. Strategia ta została skutecznie wdrożona z wykorzystaniem bibliotek open source, takich jak HuggingFace Transformers, co umożliwia precyzyjne dostrajanie LoRA do różnych zadań z niezwykłą wydajnością.

2) QLoRA: Zwiększanie wydajności LoRA

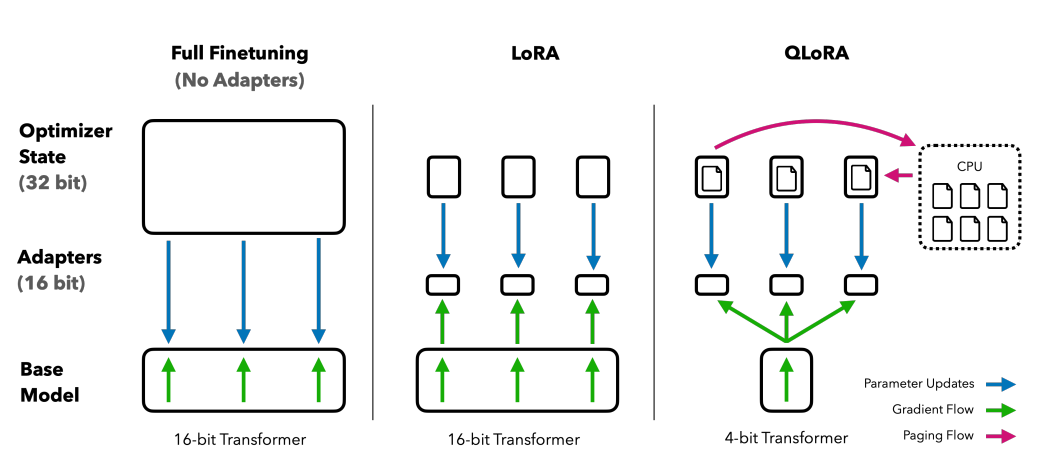

Opierając się na fundamencie LoRA, QLoRA dodatkowo minimalizuje wymagania dotyczące pamięci. Wprowadzony przez Tim Dettmers i inni w 2023 r, łączy adaptację niskiego rzędu z kwantyzacją, wykorzystując 4-bitowy format kwantyzacji zwany Normalny pływak or nf4. Kwantyzacja to zasadniczo proces, który przenosi dane z reprezentacji informacyjnej o wyższej reprezentacji do takiej, która zawiera mniej informacji. Podejście to utrzymuje skuteczność 16-bitowych metod dostrajania, dekwantyzując wagi 4-bitowe do 16-bitów, zgodnie z potrzebą podczas procesów obliczeniowych.

Porównanie metod dostrajania: QLORA ulepsza LoRA dzięki 4-bitowej precyzyjnej kwantyzacji i optymalizatorom stronicowanym do zarządzania skokami pamięci

QLoRA wykorzystuje NumericFloat4 (nf4), ukierunkowując każdą warstwę architektury transformatora i wprowadza koncepcję podwójnej kwantyzacji w celu dalszego zmniejszenia zużycia pamięci wymaganego do dostrajania. Osiąga się to poprzez wykonanie kwantyzacji na już skwantowanych stałych, co jest strategią, która pozwala uniknąć typowych skoków pamięci w punkcie kontrolnym gradientu poprzez wykorzystanie optymalizatorów stronicowanych i ujednoliconego zarządzania pamięcią.

Guanako, będący zespołem dostosowanym do QLORA, wyznacza punkt odniesienia w rozwiązaniach typu chatbot o otwartym kodzie źródłowym. Jego działanie, potwierdzone w drodze systematycznych ocen przeprowadzanych przez ludzi i zautomatyzowanych, podkreśla jego dominację i skuteczność w terenie.

Wersje 65B i 33B Guanaco, dostrojone przy użyciu zmodyfikowanej wersji OASST1 zbioru danych, okazują się groźnymi konkurentami dla znanych modeli, takich jak ChatGPT a nawet GPT-4.

Dostrajanie za pomocą uczenia się przez wzmacnianie na podstawie informacji zwrotnej od ludzi

Uczenie się przez wzmacnianie na podstawie informacji zwrotnej od ludzi (RLHF) wchodzi w grę podczas dostrajania wcześniej wyszkolonych modeli językowych, aby lepiej odpowiadały wartościom ludzkim. Koncepcja ta została wprowadzona przez Open AI w 2017 roku, kładąc podwaliny pod ulepszone podsumowania dokumentów i rozwój Poleć GPT.

U podstaw RLHF leży paradygmat uczenia się przez wzmacnianie, rodzaj techniki uczenia maszynowego, w której: agent uczy się, jak zachować się w środowisko przeprowadzając działania i odbieranie nagrodyTo ciągła pętla akcja oraz informacja zwrotna, gdzie agent jest zachęcany do dokonywania wyborów, które przyniosą najwyższą nagrodę.

Przekładając to na dziedzinę modeli językowych, agent jest model sama, działająca w ramach środowisko danego okna kontekstowego i podejmowanie decyzji w oparciu o były, który jest zdefiniowany przez bieżące tokeny w oknie kontekstowym. „przestrzeń akcji” obejmuje wszystkie potencjalne tokeny, spośród których model może wybierać, a celem jest wybranie tokena, który najlepiej odpowiada ludzkim preferencjom.

Proces RLHF w dużym stopniu wykorzystuje opinie ludzi, wykorzystując je do uczenia modelu nagrody. Model ten odgrywa kluczową rolę w kierowaniu wstępnie wytrenowanym modelem podczas procesu dostrajania, zachęcając go do generowania wyników bardziej zgodnych z wartościami ludzkimi. Jest to proces dynamiczny i iteracyjny, w którym model uczy się poprzez serię „wdrożeń” – termin używany do opisania sekwencji stanów i działań prowadzących do nagrody w kontekście generowania języka.

Jednym z niezwykłych potencjałów RLHF jest możliwość personalizacji asystentów AI, dopasowując ich do indywidualnych preferencji użytkowników, niezależnie od ich poczucia humoru czy codziennych nawyków. Otwiera to możliwości tworzenia systemów AI, które są nie tylko zaawansowane technicznie, ale także inteligentne emocjonalnie, zdolne do rozumienia i reagowania na niuanse w komunikacji międzyludzkiej.

Należy jednak pamiętać, że RLHF nie jest rozwiązaniem niezawodnym. Modele są nadal podatne na generowanie niepożądanych wyników, co jest odzwierciedleniem ogromnych, często nieuregulowanych i stronniczych danych, na których są trenowane.

Podsumowanie

Proces dostrajania, będący krytycznym krokiem w wykorzystaniu pełnego potencjału LLM, takich jak Alpaca, Falcon i GPT-4, stał się bardziej wyrafinowany i ukierunkowany, oferując dostosowane rozwiązania do szerokiego zakresu zadań.

Widzieliśmy dostrajanie jednozadaniowe, które specjalizuje się w modelach w określonych rolach, oraz metody dostrajania efektywnego pod kątem parametrów (PEFT), w tym LoRA i QLoRA, których celem jest uczynienie procesu uczenia bardziej wydajnym i opłacalnym. Zmiany te otwierają drzwi do zaawansowanych funkcji sztucznej inteligencji dla szerszej publiczności.

Co więcej, wprowadzenie przez Open AI technologii Reinforcement Learning from Human Feedback (RLHF) to krok w kierunku tworzenia systemów AI, które rozumieją ludzkie wartości i preferencje oraz lepiej je do nich dostosowują, co otwiera drogę do powstania asystentów AI, które są nie tylko inteligentne, ale także wrażliwe na indywidualne potrzeby użytkowników. Zarówno RLHF, jak i PEFT działają synergicznie, zwiększając funkcjonalność i wydajność dużych modeli językowych (LJM).

Ponieważ firmy, przedsiębiorstwa i osoby fizyczne chcą zintegrować te dopracowane LLM w swojej działalności, zasadniczo witają przyszłość, w której sztuczna inteligencja będzie czymś więcej niż narzędziem; to partner, który rozumie i dostosowuje się do kontekstu ludzkiego, oferując rozwiązania innowacyjne i spersonalizowane.