Intelligenza Artificiale

StyleTTS 2: sintesi vocale a livello umano con modelli di linguaggio vocale di grandi dimensioni

A causa dell'incremento degli approcci di sintesi vocale naturale e sintetica, uno dei maggiori risultati ottenuti dal settore dell'intelligenza artificiale negli ultimi anni è stato quello di sintetizzare efficacemente strutture di sintesi vocale con potenziali applicazioni in diversi settori, tra cui audiolibri, assistenti virtuali, sistemi vocali. - narrazioni e altro ancora, con alcune modalità all'avanguardia che offrono prestazioni ed efficienza a livello umano in un'ampia gamma di attività legate al parlato. Tuttavia, nonostante le loro ottime prestazioni, c'è ancora spazio per miglioramenti nelle attività grazie al parlato espressivo e diversificato, alla necessità di una grande quantità di dati di addestramento per ottimizzare i framework di sintesi vocale zero-shot e alla robustezza per i testi OOD o fuori distribuzione che conducono agli sviluppatori di lavorare su un framework di sintesi vocale più robusto e accessibile.

In questo articolo parleremo di StyleTTS-2, un framework di sintesi vocale robusto e innovativo costruito sulle basi del framework StyleTTS e mira a presentare il passo successivo verso sistemi di sintesi vocale all'avanguardia. Il framework StyleTTS2 modella gli stili vocali come variabili casuali latenti e utilizza un modello di diffusione probabilistico per campionare questi stili vocali o variabili casuali consentendo così al framework StyleTTS2 di sintetizzare un discorso realistico in modo efficace senza utilizzare input audio di riferimento. Grazie a questo approccio, il framework StyleTTS2 è in grado di fornire risultati migliori e mostra un'elevata efficienza rispetto agli attuali framework text-to-speech all'avanguardia, ma è anche in grado di sfruttare la diversa sintesi vocale offerta dai framework del modello di diffusione. Discuteremo il framework StyleTTS2 in maggiore dettaglio e parleremo della sua architettura e metodologia, dando anche uno sguardo ai risultati raggiunti dal framework. Quindi iniziamo.

StyleTTS2 per la sintesi vocale: un'introduzione

StyleTTS2 è un innovativo modello di sintesi vocale che fa il passo successivo verso la creazione di framework TTS a livello umano ed è basato su StyleTTS, un testo basato sullo stile per modello generativo del parlato. Il framework StyleTTS2 modella gli stili vocali come variabili casuali latenti e utilizza un modello di diffusione probabilistico per campionare questi stili vocali o variabili casuali consentendo così al framework StyleTTS2 di sintetizzare un discorso realistico in modo efficace senza utilizzare input audio di riferimento. La modellazione degli stili come variabili casuali latenti è ciò che separa il framework StyleTTS2 dal suo predecessore, il framework StyleTTS, e mira a generare lo stile vocale più adatto per il testo di input senza bisogno di un input audio di riferimento ed è in grado di ottenere diffusioni latenti efficaci durante l'assunzione vantaggio delle diverse capacità di sintesi vocale offerte da modelli di diffusione. Inoltre, il framework StyleTTS2 impiega anche un ampio modello SLM o Speech Language pre-addestrato come discriminatori come il framework WavLM, e lo accoppia con il proprio nuovo approccio di modellazione della durata differenziale per addestrare il framework end-to-end e, in definitiva, generare parlato con maggiore naturalezza. Grazie all'approccio che segue, il framework StyleTTS2 supera gli attuali framework all'avanguardia per le attività di generazione del parlato ed è uno dei framework più efficienti per il pre-addestramento di modelli vocali su larga scala in un contesto zero-shot per le attività di adattamento dei parlanti.

Andando avanti, per fornire una sintesi vocale da testo a livello umano, il framework StyleTTs2 incorpora gli insegnamenti tratti dai lavori esistenti, inclusi modelli di diffusione per la sintesi vocale e modelli di linguaggio vocale di grandi dimensioni. I modelli di diffusione vengono solitamente utilizzati per attività di sintesi vocale grazie alla loro capacità di controllo dettagliato del parlato e alle diverse capacità di campionamento del parlato. Tuttavia, i modelli di diffusione non sono efficienti quanto i framework non iterativi basati su GAN e una delle ragioni principali di ciò è la necessità di campionare rappresentazioni latenti, forme d'onda e spettrogrammi mel in modo iterativo fino alla durata target del discorso.

D'altra parte, lavori recenti sui modelli linguistici di grandi dimensioni hanno indicato la loro capacità di migliorare la qualità dei compiti di generazione del testo in discorso e di adattarsi bene al parlante. I modelli del linguaggio vocale di grandi dimensioni convertono in genere l'input di testo in rappresentazioni quantizzate o continue derivate da strutture del linguaggio vocale pre-addestrate per attività di ricostruzione del parlato. Tuttavia, le funzionalità di questi modelli del linguaggio vocale non sono ottimizzate direttamente per la sintesi vocale. Al contrario, il framework StyleTTS2 sfrutta la conoscenza acquisita da grandi framework SLM utilizzando l'addestramento contraddittorio per sintetizzare le caratteristiche dei modelli del linguaggio vocale senza utilizzare mappe dello spazio latente e, quindi, apprendendo direttamente uno spazio latente ottimizzato per la sintesi vocale.

StyleTTS2: Architettura e Metodologia

Fondamentalmente, StyleTTS2 è costruito sul suo predecessore, il framework StyleTTS che è un framework text-to-speech non autoregressivo che utilizza un codificatore di stile per derivare un vettore di stile dall'audio di riferimento, consentendo così la generazione di un parlato espressivo e naturale. Il vettore di stile utilizzato nel framework StyleTTS è incorporato direttamente nel codificatore, nella durata e nei predittori facendo uso di AdaIN o Adaptive Instance Normalization, consentendo così al modello StyleTTS di generare output vocali con prosodia, durata e persino emozioni variabili. Il framework StyleTTS è composto da 8 modelli in totale suddivisi in tre categorie

- Modelli acustici o sistema di generazione vocale con un codificatore di stile, un codificatore di testo e un decodificatore vocale.

- Un sistema di previsione della sintesi vocale che utilizza predittori di prosodia e durata.

- Un sistema di utilità che include un allineatore di testo, un estrattore di tono e un discriminatore per scopi di formazione.

Grazie al suo approccio, il framework StyleTTS offre prestazioni all'avanguardia relative alla sintesi vocale controllabile e diversificata. Tuttavia, questa prestazione presenta degli svantaggi, come il degrado della qualità del campione, limitazioni espressive e la dipendenza da applicazioni che ostacolano il parlato in tempo reale.

Migliorando il framework StyleTTS, il modello StyleTTS2 si traduce in una maggiore espressività sintesi vocale compiti con prestazioni fuori distribuzione migliorate e un elevato livello di qualità umana. Il framework StyleTTS2 si avvale di un processo di training end-to-end che ottimizza i diversi componenti con training contraddittorio e sintesi diretta della forma d'onda congiuntamente. A differenza del framework StyleTTS, il framework StyleTTS2 modella lo stile del parlato come una variabile latente e lo campiona tramite modelli di diffusione generando così diversi campioni del parlato senza utilizzare un audio di riferimento. Diamo uno sguardo dettagliato a questi componenti.

Formazione end-to-end per le interferenze

Nel framework StyleTTS2, viene utilizzato un approccio di formazione end-to-end per ottimizzare vari componenti di sintesi vocale per le interferenze senza dover fare affidamento su componenti fissi. Il framework StyleTTS2 raggiunge questo obiettivo modificando il decodificatore per generare la forma d'onda direttamente dal vettore di stile, dalle curve di tono ed energia e dalle rappresentazioni allineate. La struttura rimuove quindi l'ultimo strato di proiezione del decodificatore e lo sostituisce con un decodificatore di forme d'onda. Il framework StyleTTS2 utilizza due codificatori: un decodificatore basato su HifiGAN per generare direttamente la forma d'onda e un decodificatore basato su iSTFT per produrre fase e ampiezza che vengono convertite in forme d'onda per interferenze e training più rapidi.

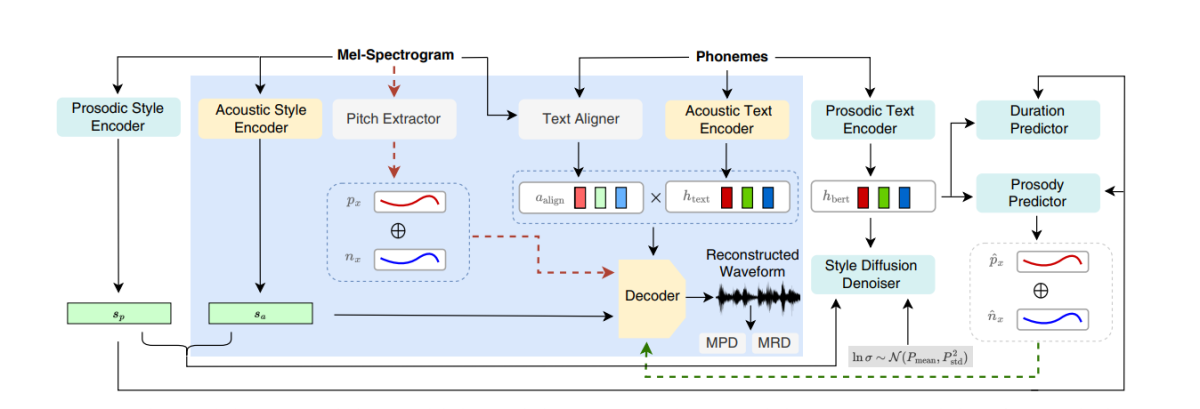

La figura sopra rappresenta i modelli acustici utilizzati per il pre-allenamento e l'allenamento congiunto. Per ridurre il tempo di allenamento, i moduli vengono prima ottimizzati nella fase di pre-allenamento e poi durante l'allenamento congiunto vengono ottimizzati tutti i componenti meno l'estrattore di pece. Il motivo per cui l'allenamento congiunto non ottimizza l'estrattore del tono è perché viene utilizzato per fornire la verità fondamentale per le curve del tono.

La figura sopra rappresenta l'addestramento contraddittorio del modello del linguaggio vocale e l'interferenza con il framework WavLM pre-addestrato ma non pre-sintonizzato. Il processo differisce da quello menzionato sopra in quanto può richiedere diversi testi di input ma accumula i gradienti per aggiornare i parametri in ciascun batch.

Diffusione di stili

Il framework StyleTTS2 mira a modellare il parlato come una distribuzione condizionale attraverso una variabile latente che segue la distribuzione condizionale, e questa variabile è chiamata stile vocale generalizzato e rappresenta qualsiasi caratteristica nel campione vocale oltre l'ambito di qualsiasi contenuto fonetico incluso l'accento lessicale, prosodia, velocità di pronuncia e persino transizioni formanti.

Discriminatori del modello del linguaggio vocale

I modelli del linguaggio vocale sono rinomati per le loro capacità generali di codificare informazioni preziose su un'ampia gamma di aspetti semantici e acustici, e le rappresentazioni SLM sono state tradizionalmente in grado di imitare le percezioni umane per valutare la qualità del discorso sintetizzato generato. Il framework StyleTTS2 utilizza un approccio di formazione contraddittorio per sfruttare la capacità dei codificatori SLM di eseguire attività generative e utilizza un framework WavLM a 12 livelli come discriminatore. Questo approccio consente al framework di abilitare la formazione su testi OOD o Out Of Distribution che possono aiutare a migliorare le prestazioni. Inoltre, per evitare problemi di overfitting, il framework campiona i testi OOD e quelli in distribuzione con uguale probabilità.

Modellazione della durata differenziabile

Tradizionalmente, nei framework di sintesi vocale viene utilizzato un predittore di durata che produce durate di fonemi, ma i metodi di upsampling utilizzati da questi predittori di durata spesso bloccano il flusso del gradiente durante il processo di training E2E e il framework NaturalSpeech impiega un upsampler basato sull'attenzione per livelli umani. conversione da testo a parlato. Tuttavia, il framework StyleTTS2 ritiene che questo approccio sia instabile durante l'addestramento contraddittorio perché StyleTTS2 si allena utilizzando un sovracampionamento differenziabile con diversi addestramenti contraddittori senza la perdita di termini aggiuntivi a causa della mancata corrispondenza della lunghezza dovuta a deviazioni. Sebbene l'utilizzo di un approccio di time warping dinamico e morbido possa aiutare a mitigare questa discrepanza, utilizzarlo non è solo costoso dal punto di vista computazionale, ma la sua stabilità è anche un problema quando si lavora con obiettivi avversari o attività di ricostruzione mel. Pertanto, per ottenere prestazioni di livello umano con la formazione contraddittoria e stabilizzare il processo di formazione, il framework StyleTTC2 utilizza un approccio di upsampling non parametrico. Il sovracampionamento gaussiano è un popolare approccio di sovracampionamento non parametrico per convertire le durate previste, sebbene abbia i suoi limiti grazie alla lunghezza fissa dei kernel gaussiani predeterminati. Questa restrizione per il sovracampionamento gaussiano limita la sua capacità di modellare accuratamente allineamenti con lunghezze diverse.

Per affrontare questa limitazione, il framework StyleTTC2 propone di utilizzare un nuovo approccio di sovracampionamento non parametrico senza alcuna formazione aggiuntiva e in grado di tenere conto delle diverse lunghezze degli allineamenti. Per ogni fonema, il framework StyleTTC2 modella l'allineamento come una variabile casuale e indica l'indice della cornice vocale con cui si allinea il fonema.

Formazione e valutazione del modello

Il framework StyleTTC2 è addestrato e sperimentato su tre set di dati: VCTK, LibriTTS e LJSpeech. Il componente a singolo altoparlante del framework StyleTTS2 viene addestrato utilizzando il set di dati LJSpeech che contiene circa 13,000 campioni audio suddivisi in 12,500 campioni di addestramento, 100 campioni di convalida e quasi 500 campioni di test, con un tempo di esecuzione combinato pari a quasi 24 ore. Il componente multi-altoparlante del framework viene addestrato sul set di dati VCTK costituito da oltre 44,000 clip audio con oltre 100 singoli madrelingua con accenti diversi ed è suddiviso in 43,500 campioni di formazione, 100 campioni di convalida e quasi 500 campioni di test. Infine, per dotare il framework di capacità di adattamento zero-shot, il framework viene addestrato sul set di dati LibriTTS combinato costituito da clip audio per un totale di circa 250 ore di audio con oltre 1,150 singoli relatori. Per valutare le sue prestazioni, il modello utilizza due parametri: MOS-N o punteggio medio di opinione di naturalezza, e MUSCHIO o Punteggio medio di opinione di somiglianza.

Risultati

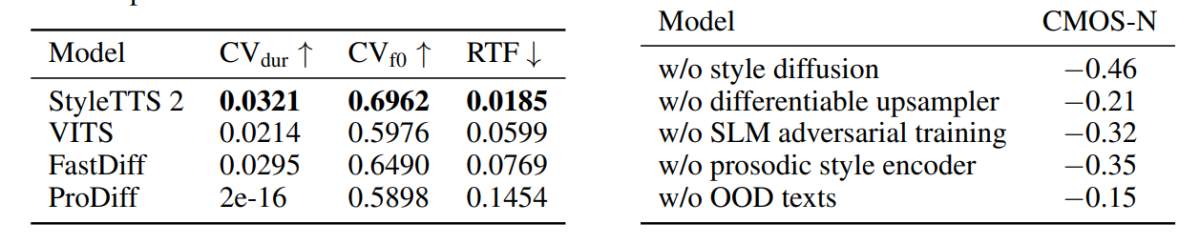

L'approccio e la metodologia utilizzati nel framework StyleTTS2 sono dimostrati nelle sue prestazioni poiché il modello supera diversi framework TTS all'avanguardia, in particolare sul set di dati NaturalSpeech e lungo il percorso, stabilendo un nuovo standard per il set di dati. Inoltre, il framework StyleTTS2 supera il framework VITS all'avanguardia sul set di dati VCTK e i risultati sono dimostrati nella figura seguente.

Il modello StyleTTS2 supera anche i modelli precedenti sul set di dati LJSpeech e non mostra alcun grado di degrado della qualità sui testi OOD o fuori distribuzione come visualizzato dai framework precedenti sugli stessi parametri. Inoltre, nell'impostazione zero-shot, il modello StyleTTC2 supera il modello Vall-E esistente in termini di naturalezza, sebbene rimanga indietro in termini di somiglianza. Tuttavia, vale la pena notare che il framework StyleTTS2 è in grado di raggiungere prestazioni competitive nonostante l'addestramento solo su 245 ore di campioni audio rispetto alle oltre 60 ore di addestramento del framework Vall-E, dimostrando così che StyleTTC2 è un'alternativa efficiente in termini di dati. ai grandi metodi di pre-addestramento esistenti come quelli utilizzati nel Vall-E.

Andando avanti, a causa della mancanza di dati di testo audio etichettati con emozioni, il framework StyleTTC2 utilizza il modello GPT-4 per generare oltre 500 istanze attraverso diverse emozioni per la visualizzazione di vettori di stile che il framework crea utilizzando i suoi emittente

Nella prima figura, gli stili emotivi in risposta ai sentimenti del testo in input sono illustrati dai vettori di stile del modello LJSpeech e dimostra la capacità del framework StyleTTC2 di sintetizzare il discorso espressivo con emozioni diverse. La seconda figura illustra la forma di cluster distinti per ciascuno dei cinque singoli altoparlanti, descrivendo così un'ampia gamma di diversità provenienti da un singolo file audio. La figura finale mostra il gruppo sciolto di emozioni dell'oratore 1 e rivela che, nonostante alcune sovrapposizioni, i gruppi basati sulle emozioni sono prominenti, indicando così la possibilità di manipolare la melodia emotiva di un oratore indipendentemente dal campione audio di riferimento e dal suo tono di input. . Nonostante utilizzi un approccio basato sulla diffusione, il framework StyleTTS2 riesce a sovraperformare i framework all'avanguardia esistenti tra cui VITS, ProDiff e FastDiff.

Considerazioni finali

In questo articolo abbiamo parlato di StyleTTS2, un framework di sintesi vocale nuovo, robusto e innovativo che si basa sulle fondamenta del framework StyleTTS e mira a presentare il passo successivo verso sistemi di sintesi vocale all'avanguardia. Il framework StyleTTS2 modella gli stili vocali come variabili casuali latenti e utilizza un modello di diffusione probabilistica per campionare questi stili vocali o variabili casuali consentendo così al framework StyleTTS2 di sintetizzare un discorso realistico in modo efficace senza utilizzare input audio di riferimento. Il framework StyleTTS2 utilizza la diffusione dello stile e discriminatori SLM per ottenere prestazioni di livello umano nelle attività di sintesi vocale e riesce a superare le strutture all'avanguardia esistenti su un'ampia gamma di attività vocali.