Intelligenza Artificiale

Diffusione video stabile: modelli di diffusione video latente su set di dati di grandi dimensioni

AI generativa è ormai da tempo una forza trainante nella comunità dell'intelligenza artificiale e i progressi compiuti nel campo della modellazione generativa di immagini, in particolare con l'uso di modelli di diffusione, hanno aiutato i modelli video generativi a progredire in modo significativo non solo nella ricerca, ma anche in termini di applicazioni del mondo reale. Convenzionalmente, i modelli video generativi vengono addestrati da zero oppure sono parzialmente o completamente perfezionati da modelli di immagini preaddestrati con livelli temporali aggiuntivi, su una combinazione di set di dati di immagini e video.

Portando avanti i progressi nei modelli video generativi, in questo articolo parleremo di Modello di diffusione video stabile, un modello di diffusione video latente in grado di generare immagini all'avanguardia in alta risoluzione in video e contenuti di testo in video. Parleremo di come i modelli di diffusione latente addestrati per la sintesi di immagini 2D hanno migliorato le capacità e l'efficienza dei modelli video generativi aggiungendo strati temporali e perfezionando i modelli su piccoli set di dati costituiti da video di alta qualità. Approfondiremo l'architettura e il funzionamento del modello di diffusione video stabile, ne valuteremo le prestazioni su vari parametri e lo confronteremo con gli attuali framework all'avanguardia per la generazione di video. Quindi iniziamo.

Modello di diffusione video stabile e modelli video generativi: un'introduzione

Grazie al suo potenziale quasi illimitato, l’intelligenza artificiale generativa è ormai da tempo il principale oggetto di ricerca per i professionisti dell’intelligenza artificiale e del machine learning e negli ultimi anni si sono visti rapidi progressi sia in termini di efficienza che di prestazioni dei modelli di immagini generative. Gli insegnamenti tratti dai modelli di immagini generativi hanno consentito a ricercatori e sviluppatori di fare progressi sui modelli video generativi, con conseguente maggiore praticità e applicazioni nel mondo reale. Tuttavia, la maggior parte della ricerca che tenta di migliorare le capacità dei modelli video generativi si concentra principalmente sull’esatta disposizione degli strati temporali e spaziali, prestando poca attenzione all’analisi dell’influenza della selezione dei dati giusti sul risultato di questi modelli generativi.

Grazie ai progressi compiuti dai modelli generativi di immagini, i ricercatori hanno osservato che l’impatto della distribuzione dei dati di addestramento sulle prestazioni dei modelli generativi è infatti significativo e indiscusso. Inoltre, i ricercatori hanno anche osservato che il pre-addestramento di un modello di immagine generativa su un set di dati ampio e diversificato, seguito dalla messa a punto su un set di dati più piccolo con una migliore qualità, spesso si traduce in un miglioramento significativo delle prestazioni. Tradizionalmente, i modelli video generativi implementano gli apprendimenti ottenuti da modelli di immagini generativi di successo, e i ricercatori devono ancora studiare l’effetto dei dati, e le strategie di formazione devono ancora essere studiate. Il modello di diffusione video stabile è un tentativo di migliorare le capacità dei modelli video generativi avventurandosi in territori precedentemente inesplorati con particolare attenzione alla selezione dei dati.

I recenti modelli video generativi si basano su modelli di diffusione e approcci di condizionamento del testo o di condizionamento delle immagini per sintetizzare più fotogrammi video o immagini coerenti. I modelli di diffusione sono noti per la loro capacità di apprendere come eliminare gradualmente il rumore da un campione dalla distribuzione normale implementando un processo di perfezionamento iterativo e hanno fornito risultati desiderabili su video ad alta risoluzione e sintesi di testo in immagini. Utilizzando lo stesso principio alla base, il modello di diffusione video stabile addestra un modello di diffusione video latente sul proprio set di dati video insieme all'uso di reti generative avversarie o GAN e persino di modelli autoregressivi in una certa misura.

Il modello di diffusione video stabile segue una strategia unica mai implementata da nessun modello video generativo poiché si basa su linee di base di diffusione video latente con un'architettura fissa e una strategia di formazione fissa seguita dalla valutazione dell'effetto della cura dei dati. Il modello di diffusione video stabile mira a fornire i seguenti contributi nel campo della modellazione video generativa.

- Presentare un flusso di lavoro di data curation sistematico ed efficace nel tentativo di trasformare un'ampia raccolta di campioni video non curati in un set di dati di alta qualità che viene poi utilizzato dai modelli video generativi.

- Per addestrare immagini all'avanguardia a video e testo a modelli video che superino le prestazioni dei framework esistenti.

- Condurre esperimenti specifici del dominio per sondare la comprensione 3D e una forte priorità di movimento del modello.

Ora, il modello di diffusione video stabile implementa gli insegnamenti tratti dai modelli di diffusione video latente e dalle tecniche di data curation al centro delle sue fondamenta.

Modelli di diffusione video latente

I modelli di diffusione video latente o Video-LDM seguono l'approccio di addestramento del modello generativo primario in uno spazio latente con complessità computazionale ridotta e la maggior parte dei Video-LDM implementa un modello testo-immagine preaddestrato accoppiato con l'aggiunta di strati di miscelazione temporale nel preaddestramento architettura. Di conseguenza, la maggior parte dei modelli di diffusione video latente addestrano solo strati temporali o saltano del tutto il processo di addestramento, a differenza del modello di diffusione video stabile che ottimizza l'intero framework. Inoltre, per sintetizzare dati da testo a video, il modello di diffusione video stabile si condiziona direttamente su un prompt di testo e i risultati indicano che la struttura risultante può essere facilmente messa a punto in una sintesi multi-vista o in un modello da immagine a video.

Cura dei dati

La Data Curation è una componente essenziale non solo del modello di diffusione video stabile, ma anche dei modelli generativi nel loro complesso perché è essenziale pre-addestrare modelli di grandi dimensioni su set di dati su larga scala per migliorare le prestazioni in diverse attività, tra cui la modellazione del linguaggio o la generazione discriminativa di testo e immagini. , e altro ancora. La Data Curation è stata implementata con successo su modelli di immagini generative sfruttando le capacità di rappresentazioni efficienti di linguaggio-immagine, sebbene tali discussioni non siano mai state focalizzate sullo sviluppo di modelli video generativi. Ci sono diversi ostacoli che gli sviluppatori devono affrontare quando si curano i dati per i modelli video generativi e, per affrontare queste sfide, il modello di diffusione video stabile implementa una strategia di formazione in tre fasi, con risultati migliori e un aumento significativo delle prestazioni.

Data Curation per la sintesi video di alta qualità

Come discusso nella sezione precedente, il modello di diffusione video stabile implementa una strategia di formazione in tre fasi, che porta a risultati migliori e a un aumento significativo delle prestazioni. La fase I è un preformazione dell'immagine fase che utilizza un modello di diffusione testo-immagine 2D. La fase II è per videopreformazione in cui il framework si allena su una grande quantità di dati video. Infine, abbiamo la Fase III per messa a punto del video in cui il modello viene perfezionato su un piccolo sottoinsieme di video di alta qualità e alta risoluzione.

Tuttavia, prima che il modello di diffusione video stabile implementi queste tre fasi, è fondamentale elaborare e annotare i dati poiché fungono da base per la fase II o la fase di pre-addestramento video e svolgono un ruolo fondamentale nel garantire il risultato ottimale. Per garantire la massima efficienza, il framework implementa innanzitutto una pipeline di rilevamento dei tagli a cascata a 3 diversi livelli di FPS o fotogrammi al secondo e la necessità di questa pipeline è dimostrata nell'immagine seguente.

Successivamente, il modello di diffusione video stabile annota ogni clip video utilizzando tre diversi metodi di sottotitoli sintetici. La tabella seguente confronta i set di dati utilizzati nello Stable Diffusion Framework prima e dopo il processo di filtraggio.

Fase I: pre-formazione sull'immagine

La prima fase della pipeline a tre fasi implementata nel modello di diffusione video stabile è il pre-addestramento delle immagini e, per raggiungere questo obiettivo, la struttura iniziale del modello di diffusione video stabile è basata su un modello di diffusione delle immagini pre-addestrato, vale a dire il Diffusione stabile 2.1 modello che lo dota di rappresentazioni visive più forti.

Fase II: pre-formazione video

La seconda fase è la fase di pre-formazione video e si basa sui risultati secondo cui l'uso della cura dei dati nei modelli di immagini generative multimodali spesso si traduce in risultati migliori e maggiore efficienza insieme a una potente generazione di immagini discriminative. Tuttavia, a causa della mancanza di rappresentazioni pronte per filtrare campioni indesiderati per modelli video generativi, il modello di diffusione video stabile si basa sulle preferenze umane come segnali di input per la creazione di un set di dati appropriato utilizzato per il pre-addestramento del framework. La figura seguente dimostra l'effetto positivo del pre-addestramento del framework su un set di dati curato che aiuta a migliorare le prestazioni complessive per il pre-addestramento video su set di dati più piccoli.

Per essere più specifici, il framework utilizza diversi metodi per curare sottoinsiemi di diffusione video latente e considera la classificazione dei modelli LVD addestrati su questi set di dati. Inoltre, il framework Stable Video Diffusion rileva anche che l'uso di set di dati curati per l'addestramento dei framework aiuta a migliorare le prestazioni del framework e dei modelli di diffusione in generale. Inoltre, la strategia di data curation funziona anche su set di dati più grandi, più rilevanti e altamente pratici. La figura seguente dimostra l'effetto positivo del pre-addestramento del framework su un set di dati curato che aiuta a migliorare le prestazioni complessive per il pre-addestramento video su set di dati più piccoli.

Fase III: messa a punto di alta qualità

Fino alla fase II, il framework Stable Video Diffusion si concentra sul miglioramento delle prestazioni prima del pre-addestramento video e nella terza fase, il framework pone l'accento sull'ottimizzazione o sull'ulteriore aumento delle prestazioni del framework dopo la messa a punto del video di alta qualità e su come il passaggio dalla Fase II alla Fase III è realizzato nel quadro. Nella Fase III, il framework si basa su tecniche di training prese in prestito da modelli di diffusione di immagini latenti e aumenta la risoluzione degli esempi di training. Per analizzare l’efficacia di questo approccio, il framework lo confronta con tre modelli identici che differiscono solo in termini di inizializzazione. Il primo modello identico ha i suoi pesi inizializzati e il processo di addestramento video viene saltato mentre i rimanenti due modelli identici vengono inizializzati con i pesi presi in prestito da altri modelli video latenti.

Risultati e conclusioni

È giunto il momento di dare un'occhiata alle prestazioni del framework Stable Video Diffusion nelle attività del mondo reale e al suo confronto con i framework allo stato dell'arte attuali. Il framework Stable Video Diffusion utilizza innanzitutto l'approccio ottimale ai dati per addestrare un modello di base, quindi esegue la messa a punto per generare diversi modelli all'avanguardia, in cui ciascun modello esegue un compito specifico.

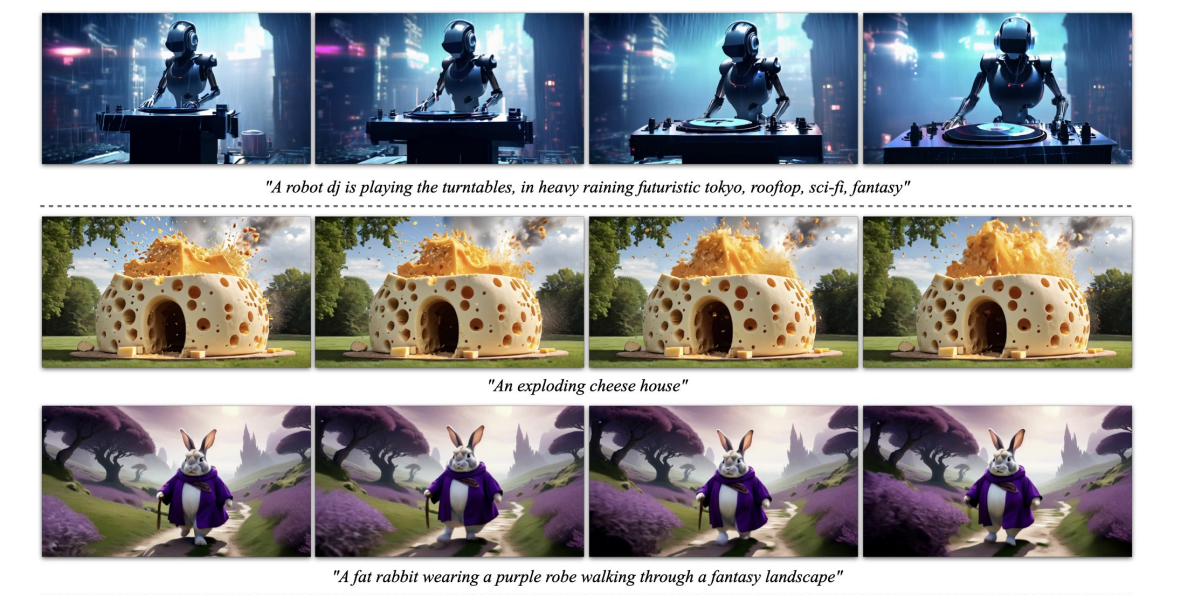

L'immagine sopra rappresenta l'immagine ad alta risoluzione in campioni video generati dal framework, mentre la figura seguente dimostra la capacità del framework di generare testo in campioni video di alta qualità.

Base pre-addestrata Model

Come discusso in precedenza, il modello Stable Video Diffusion è costruito sul framework Stable Diffusion 2.1 e, sulla base di recenti scoperte, è stato fondamentale per gli sviluppatori adottare il programma di rumore e aumentare il rumore per ottenere immagini con una migliore risoluzione durante l'allenamento della diffusione delle immagini. Modelli. Grazie a questo approccio, il modello base di diffusione video stabile apprende potenti rappresentazioni del movimento e, nel processo, supera i modelli di base per testo a generazione di video con un'impostazione di ripresa zero e i risultati vengono visualizzati nella tabella seguente.

Interpolazione dei frame e generazione di più visualizzazioni

Il framework Stable Video Diffusion perfeziona il modello da immagine a video su set di dati multi-vista per ottenere più nuove visualizzazioni di un oggetto e questo modello è noto come SVD-MV o modello Stable Video Diffusion-Multi View. Il modello SVD originale viene messo a punto con l'aiuto di due set di dati in modo tale che il framework immetta una singola immagine e restituisca una sequenza di immagini multi-vista come output.

Come si può vedere nelle immagini seguenti, il framework Stable Video Diffusion Multi View offre prestazioni elevate paragonabili al framework allo stato dell'arte Scratch Multi View, e i risultati sono una chiara dimostrazione della capacità di SVD-MV di sfruttare gli apprendimenti ottenuti dal framework SVD originale per la generazione di immagini multi-vista. Inoltre, i risultati indicano anche che l’esecuzione del modello per un numero relativamente piccolo di iterazioni aiuta a fornire risultati ottimali, come nel caso della maggior parte dei modelli ottimizzati dal framework SVD.

Nella figura sopra, le metriche sono indicate sul lato sinistro e, come si può vedere, il framework Multi View Stable Video Diffusion supera i framework Multi-View Scratch-MV e SD2.1 con un margine decente. La seconda immagine dimostra l'effetto del numero di iterazioni di formazione sulle prestazioni complessive del framework in termini di Clip Score e i framework SVD-MV forniscono risultati sostenibili.

Considerazioni finali

In questo articolo abbiamo parlato di Stable Video Diffusion, un modello di diffusione video latente in grado di generare immagini all'avanguardia in alta risoluzione in video e contenuti di testo in video. Il modello di diffusione video stabile segue una strategia unica mai implementata da nessun modello video generativo poiché si basa su linee di base di diffusione video latente con un'architettura fissa e una strategia di formazione fissa seguita dalla valutazione dell'effetto della cura dei dati.

Abbiamo parlato di come i modelli di diffusione latente addestrati per la sintesi di immagini 2D abbiano migliorato le capacità e l'efficienza di modelli video generativi aggiungendo strati temporali e perfezionando i modelli su piccoli set di dati costituiti da video di alta qualità. Per raccogliere i dati di pre-addestramento, il framework conduce studi di dimensionamento e segue pratiche sistematiche di raccolta dati e, infine, propone un metodo per curare una grande quantità di dati video e converte video rumorosi in dati di input adatti a modelli video generativi.

Inoltre, il framework Stable Video Diffusion impiega tre distinte fasi di training del modello video che vengono analizzate in modo indipendente per valutare il loro impatto sulle prestazioni del framework. Alla fine, il framework produce una rappresentazione video sufficientemente potente da mettere a punto i modelli per una sintesi video ottimale, e i risultati sono paragonabili ai modelli di generazione video all'avanguardia già in uso.