L'angolo di Anderson

Quasi l'80% dei set di dati di formazione potrebbe rappresentare un rischio legale per l'intelligenza artificiale aziendale

Un recente articolo di LG AI Research suggerisce che i set di dati presumibilmente "aperti" utilizzati per l'addestramento dei modelli di intelligenza artificiale potrebbero offrire un falso senso di sicurezza, scoprendo che quasi quattro set di dati di intelligenza artificiale su cinque etichettati come "commercialmente utilizzabili" contengono in realtà rischi legali nascosti.

Tali rischi vanno dall'inclusione di materiale protetto da copyright non divulgato a termini di licenza restrittivi nascosti nelle dipendenze di un set di dati. Se i risultati dello studio fossero accurati, le aziende che si affidano a set di dati pubblici potrebbero dover riconsiderare i loro attuali processi di intelligenza artificiale, o rischiare di incorrere in conseguenze legali a valle.

I ricercatori propongono una soluzione radicale e potenzialmente controversa: agenti di conformità basati sull'intelligenza artificiale in grado di analizzare e verificare la cronologia dei set di dati in modo più rapido e accurato rispetto agli avvocati umani.

Il documento afferma:

"Questo documento sostiene che il rischio legale dei set di dati di addestramento dell'intelligenza artificiale non può essere determinato solo esaminando i termini di licenza superficiali; un'analisi approfondita e completa della ridistribuzione dei set di dati è essenziale per garantire la conformità.

"Dato che tale analisi è al di là delle capacità umane a causa della sua complessità e portata, gli agenti AI possono colmare questa lacuna conducendola con maggiore velocità e accuratezza. Senza automazione, i rischi legali critici rimangono in gran parte inesplorati, mettendo a repentaglio lo sviluppo etico dell'AI e l'aderenza alle normative.

"Esortiamo la comunità di ricerca sull'intelligenza artificiale a riconoscere l'analisi legale end-to-end come un requisito fondamentale e ad adottare approcci basati sull'intelligenza artificiale come percorso praticabile per la conformità dei set di dati scalabili".

Esaminando 2,852 set di dati popolari che sembravano commercialmente utilizzabili in base alle loro licenze individuali, il sistema automatizzato dei ricercatori ha scoperto che solo 605 (circa il 21%) erano effettivamente legalmente sicuri per la commercializzazione una volta tracciati tutti i loro componenti e dipendenze

. nuovo documento è intitolato Non fidarti delle licenze che vedi: la conformità del set di dati richiede un tracciamento del ciclo di vita su larga scala basato sull'intelligenza artificialee proviene da otto ricercatori di LG AI Research.

Diritti e torti

Gli autori evidenziano l sfide affrontate dalle aziende che promuovono lo sviluppo dell'intelligenza artificiale in un panorama giuridico sempre più incerto, poiché la precedente mentalità accademica del "fair use" in merito alla formazione sui set di dati cede il passo a un ambiente frammentato in cui le tutele legali non sono chiare e il porto sicuro non è più garantito.

Come una pubblicazione sottolineato di recente, le aziende stanno diventando sempre più difensive riguardo alle fonti dei loro dati di training. L'autore Adam Buick commenta*:

"[Mentre] OpenAI ha divulgato le principali fonti di dati per GPT-3, il documento che introduce GPT-4 rivelato solo che i dati su cui era stato addestrato il modello erano un mix di "dati disponibili al pubblico (come i dati di Internet) e dati concessi in licenza da fornitori terzi".

Le motivazioni alla base di questo allontanamento dalla trasparenza non sono state spiegate in dettaglio dagli sviluppatori di intelligenza artificiale, che in molti casi non hanno fornito alcuna spiegazione.

Da parte sua, OpenAI ha giustificato la sua decisione di non divulgare ulteriori dettagli riguardanti GPT-4 sulla base di preoccupazioni riguardanti "il panorama competitivo e le implicazioni per la sicurezza dei modelli su larga scala", senza ulteriori spiegazioni nel rapporto.

Trasparenza può essere un termine disonesto, o semplicemente sbagliato; ad esempio, il fiore all'occhiello di Adobe Lucciola modello generativo, addestrato su dati di stock che Adobe aveva i diritti di sfruttare, presumibilmente offriva ai clienti rassicurazioni sulla legalità del loro utilizzo del sistema. In seguito, alcuni prove emerse che il data pot di Firefly si era "arricchito" con dati potenzialmente protetti da copyright provenienti da altre piattaforme.

Come abbiamo discusso all'inizio di questa settimana, sono in crescita le iniziative volte a garantire la conformità delle licenze nei set di dati, tra cui una che estrarrà solo i video di YouTube con licenze Creative Commons flessibili.

Il problema è che le licenze in sé potrebbero essere errate o concesse per errore, come sembra indicare la nuova ricerca.

Esame dei set di dati open source

È difficile sviluppare un sistema di valutazione come il Nexus degli autori in un contesto in continua evoluzione. Pertanto, l'articolo afferma che il sistema di framework NEXUS per la conformità dei dati si basa su "diversi precedenti e basi giuridiche attuali".

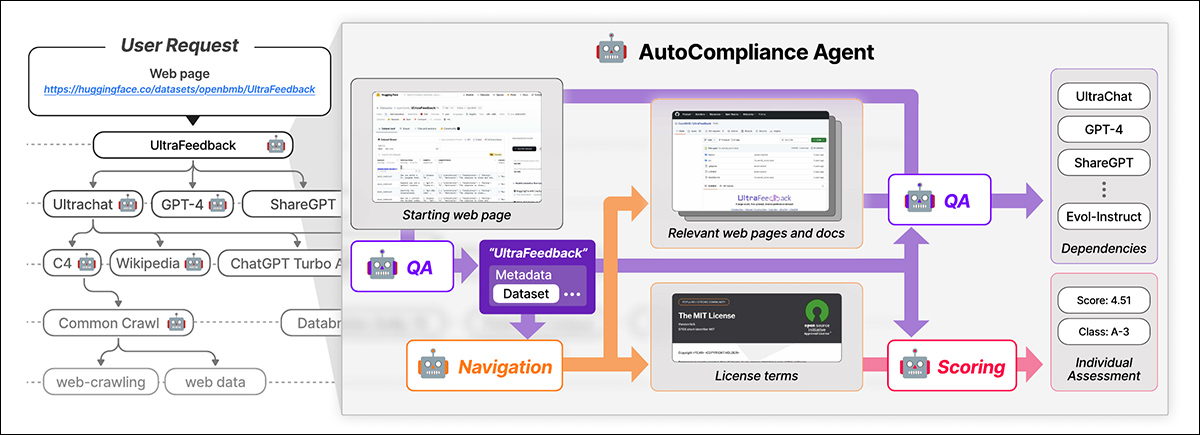

NEXUS utilizza un agente guidato dall'intelligenza artificiale chiamato Conformità automatica per la conformità automatizzata dei dati. AutoCompliance è composto da tre moduli chiave: un modulo di navigazione per l'esplorazione web; un modulo di domande e risposte (QA) per l'estrazione di informazioni; e un modulo di punteggio per la valutazione del rischio legale.

AutoCompliance inizia con una pagina web fornita dall'utente. L'IA estrae i dettagli chiave, cerca risorse correlate, identifica i termini di licenza e le dipendenze e assegna un punteggio di rischio legaleFonte: https://arxiv.org/pdf/2503.02784

Questi moduli sono alimentati da modelli di intelligenza artificiale ottimizzati, tra cui EXAONE-3.5-32B-Istruisci modello, addestrato su dati sintetici e con etichetta umana. AutoCompliance utilizza anche un database per la memorizzazione nella cache dei risultati per migliorare l'efficienza.

AutoCompliance inizia con un URL di dataset fornito dall'utente e lo tratta come entità radice, cercando i termini e le dipendenze della licenza e tracciando ricorsivamente i dataset collegati per creare un grafico delle dipendenze della licenza. Una volta mappate tutte le connessioni, calcola i punteggi di conformità e assegna le classificazioni di rischio.

Il quadro di conformità dei dati delineato nel nuovo lavoro identifica vari† tipi di entità coinvolti nel ciclo di vita dei dati, inclusi dataset, che costituiscono l'input principale per l'addestramento dell'IA; software di elaborazione dati e modelli di intelligenza artificiale, che vengono utilizzati per trasformare e utilizzare i dati; e Fornitori di servizi di piattaforma, che facilitano la gestione dei dati.

Il sistema valuta in modo olistico i rischi legali prendendo in considerazione queste diverse entità e le loro interdipendenze, andando oltre la valutazione meccanica delle licenze dei set di dati per includere un ecosistema più ampio dei componenti coinvolti nello sviluppo dell'intelligenza artificiale.

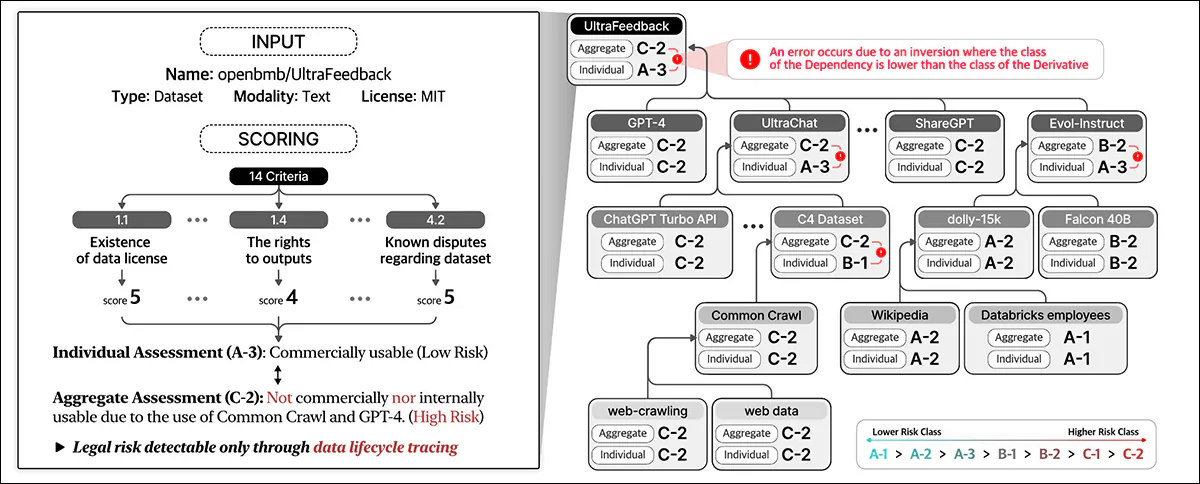

Data Compliance valuta il rischio legale lungo l'intero ciclo di vita dei dati. Assegna punteggi in base ai dettagli del set di dati e a 14 criteri, classificando le singole entità e aggregando il rischio tra le dipendenze.

Formazione e metriche

Gli autori hanno estratto gli URL dei 1,000 set di dati più scaricati su Hugging Face, sottocampionando casualmente 216 elementi per costituire un set di test.

Il modello EXAONE era messo a punto sul set di dati personalizzato degli autori, con il modulo di navigazione e il modulo di risposta alle domande utilizzando dati sinteticie il modulo di punteggio che utilizza dati etichettati dall'uomo.

Le etichette Ground-truth sono state create da cinque esperti legali formati per almeno 31 ore in compiti simili. Questi esperti umani hanno identificato manualmente dipendenze e termini di licenza per 216 casi di test, quindi hanno aggregato e perfezionato i loro risultati tramite discussione.

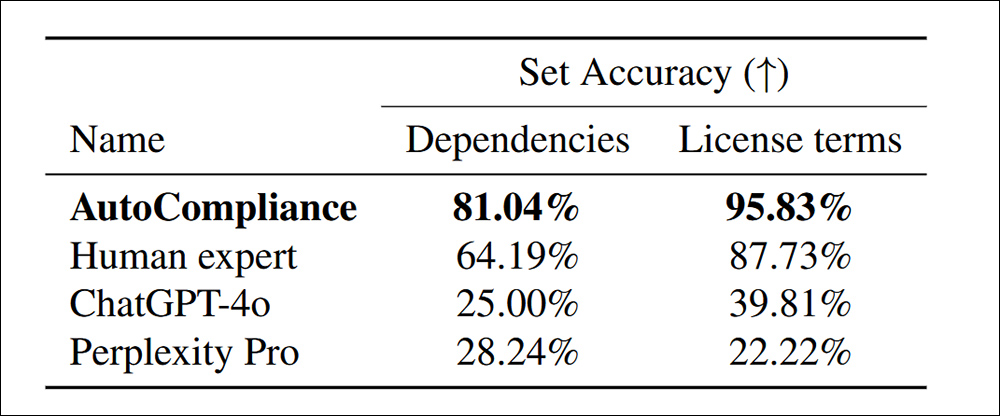

Con il sistema AutoCompliance addestrato e calibrato dall'uomo, testato contro ChatGPT-4o e Perplessità Pro, in particolare sono state scoperte più dipendenze nei termini della licenza:

Precisione nell'identificazione delle dipendenze e dei termini di licenza per 216 set di dati di valutazione.

Il documento afferma:

'AutoCompliance supera significativamente tutti gli altri agenti e gli esperti umani, raggiungendo un'accuratezza dell'81.04% e del 95.83% in ogni attività. Al contrario, sia ChatGPT-4o che Perplexity Pro mostrano un'accuratezza relativamente bassa per le attività Source e License, rispettivamente.

"Questi risultati evidenziano le prestazioni superiori di AutoCompliance, dimostrando la sua efficacia nel gestire entrambe le attività con notevole accuratezza, ma indicano anche un divario sostanziale nelle prestazioni tra i modelli basati sull'intelligenza artificiale e gli esperti umani in questi ambiti".

In termini di efficienza, l'approccio AutoCompliance ha richiesto solo 53.1 secondi per essere eseguito, rispetto ai 2,418 secondi di una valutazione umana equivalente per le stesse attività.

Inoltre, la valutazione è costata 0.29 USD, rispetto ai 207 USD degli esperti umani. Va notato, tuttavia, che questo si basa sull'affitto di un nodo GCP a2-megagpu-16gpu mensile a una tariffa di 14,225 $ al mese, il che significa che questo tipo di efficienza dei costi è correlato principalmente a un'operazione su larga scala.

Indagine sul set di dati

Per l'analisi, i ricercatori hanno selezionato 3,612 set di dati combinando i 3,000 set di dati più scaricati da Hugging Face con 612 set di dati del 2023 Iniziativa sulla provenienza dei dati.

Il documento afferma:

"A partire dalle 3,612 entità target, abbiamo identificato un totale di 17,429 entità univoche, di cui 13,817 apparivano come dipendenze dirette o indirette delle entità target.

"Per la nostra analisi empirica, consideriamo un'entità e il suo grafico delle dipendenze delle licenze come dotati di una struttura a strato singolo se l'entità non ha dipendenze e di una struttura a strati multipli se ha una o più dipendenze.

'Dei 3,612 set di dati target, 2,086 (57.8%) avevano strutture multistrato, mentre gli altri 1,526 (42.2%) avevano strutture monostrato senza dipendenze.'

I dataset protetti da copyright possono essere ridistribuiti solo con autorizzazione legale, che può provenire da una licenza, eccezioni alla legge sul copyright o termini contrattuali. La ridistribuzione non autorizzata può comportare conseguenze legali, tra cui violazione del copyright o violazioni contrattuali. Pertanto, è essenziale una chiara identificazione della non conformità.

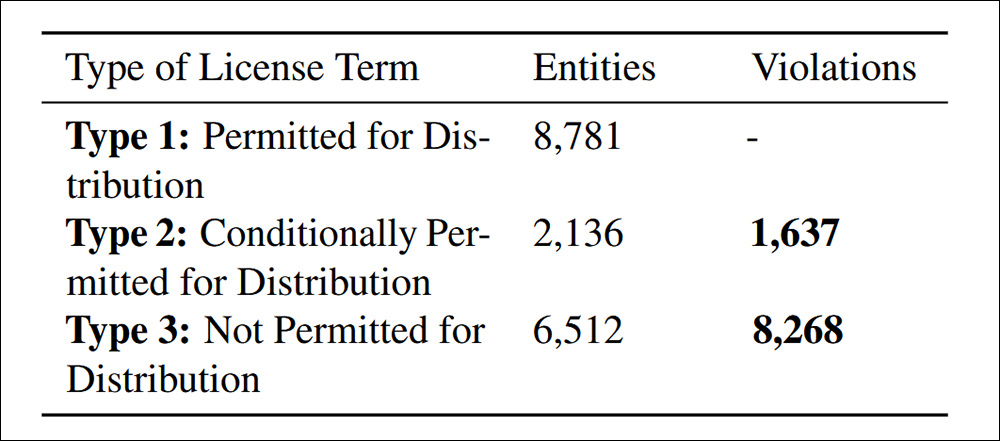

Sono state riscontrate violazioni della distribuzione in base al Criterio 4.4 di conformità dei dati citato nel documento.

Lo studio ha rilevato 9,905 casi di ridistribuzione non conforme di set di dati, suddivisi in due categorie: l'83.5% era esplicitamente vietato in base ai termini della licenza, rendendo la ridistribuzione una chiara violazione legale; e il 16.5% riguardava set di dati con condizioni di licenza contrastanti, in cui la ridistribuzione era consentita in teoria ma non soddisfaceva i termini richiesti, creando rischi legali a valle.

Gli autori ammettono che i criteri di rischio proposti in NEXUS non sono universali e possono variare a seconda della giurisdizione e dell'applicazione dell'intelligenza artificiale, e che i miglioramenti futuri dovrebbero concentrarsi sull'adattamento alle mutevoli normative globali, perfezionando al contempo la revisione legale basata sull'intelligenza artificiale.

Conclusione

Si tratta di un documento prolisso e poco intuitivo, ma affronta forse il più grande fattore di rallentamento nell'attuale adozione dell'intelligenza artificiale da parte dell'industria: la possibilità che dati apparentemente "aperti" vengano in seguito rivendicati da varie entità, individui e organizzazioni.

Ai sensi del DMCA, le violazioni possono comportare legalmente multe ingenti su un per caso base. Laddove le violazioni possono arrivare a milioni, come nei casi scoperti dai ricercatori, la potenziale responsabilità legale è davvero significativa.

Inoltre, le aziende che possono dimostrare di aver tratto beneficio dai dati upstream non possono (come di solito) rivendicano l'ignoranza come scusa, almeno nell'influente mercato statunitense. Né hanno attualmente strumenti realistici con cui penetrare le implicazioni labirintiche nascoste in accordi di licenza di set di dati presumibilmente open source.

Il problema nel formulare un sistema come NEXUS è che sarebbe già abbastanza impegnativo calibrarlo su base per singolo stato negli Stati Uniti o su base per nazione all'interno dell'UE; la prospettiva di creare un quadro veramente globale (una sorta di "Interpol per la provenienza dei set di dati") è minata non solo dalle motivazioni contrastanti dei diversi governi coinvolti, ma anche dal fatto che sia questi governi sia lo stato delle loro attuali leggi in materia sono in continuo cambiamento.

* Sostituzione delle citazioni degli autori con collegamenti ipertestuali.

† Nel documento ne vengono prescritti sei tipi, ma gli ultimi due non sono definiti.

Prima pubblicazione venerdì 7 marzo 2025