Intelligenza Artificiale

Una guida completa per mettere a punto modelli linguistici di grandi dimensioni

By

Ayush Mittal Mittale

Grandi modelli linguistici (LLM) come GPT-4, LaMDA, PaLM e altri hanno preso d'assalto il mondo con la loro straordinaria capacità di comprendere e generare testi simili a quelli umani su una vasta gamma di argomenti. Questi modelli sono pre-addestrati su enormi set di dati comprendenti miliardi di parole provenienti da Internet, libri e altre fonti.

Questa fase di pre-addestramento fornisce ai modelli un'ampia conoscenza generale su linguaggio, argomenti, capacità di ragionamento e persino alcuni pregiudizi presenti nei dati di addestramento. Tuttavia, nonostante la loro incredibile ampiezza, questi LLM pre-formati mancano di competenze specializzate per settori o attività specifici.

È qui che entra in gioco la messa a punto: il processo di adattamento di un LLM pre-addestrato per eccellere in una particolare applicazione o caso d'uso. Addestrando ulteriormente il modello su un set di dati più piccolo e specifico per un'attività, possiamo ottimizzare le sue capacità per allinearle alle sfumature e ai requisiti di quel dominio.

Il fine-tuning è un'attività analoga al trasferimento delle vaste conoscenze di un generalista altamente qualificato per creare un esperto specializzato in un determinato campo. In questa guida, esploreremo i vantaggi, i vantaggi e i vantaggi del fine-tuning degli LLM.

Che cos'è la messa a punto?

Nel suo nucleo, ritocchi implica prendere un modello pre-addestrato di grandi dimensioni e aggiornarne i parametri utilizzando una seconda fase di addestramento su un set di dati su misura per l'attività o il dominio di destinazione. Ciò consente al modello di apprendere e interiorizzare le sfumature, i modelli e gli obiettivi specifici di quell'area più ristretta.

Mentre la pre-formazione acquisisce una comprensione linguistica ampia da un corpus di testi vasto e diversificato, la messa a punto specifica quella competenza generale. È come prendere un uomo del Rinascimento e trasformarlo in un esperto del settore.

I pesi del modello pre-addestrato, che ne codificano la conoscenza generale, vengono utilizzati come punto di partenza o di inizializzazione per il processo di messa a punto. Il modello viene quindi ulteriormente addestrato, ma questa volta su esempi direttamente rilevanti per l'applicazione finale.

Esponendo il modello a questa distribuzione specializzata dei dati e ottimizzando di conseguenza i parametri del modello, rendiamo il LLM più accurato ed efficace per il caso d'uso target, beneficiando comunque delle ampie capacità pre-addestrate come base.

Perché ottimizzare i LLM?

Esistono diversi motivi principali per cui potresti voler mettere a punto un modello linguistico di grandi dimensioni:

- Personalizzazione del dominio: Ogni campo, dal legale alla medicina all'ingegneria del software, ha le proprie convenzioni linguistiche, il proprio gergo e i propri contesti. La messa a punto consente di personalizzare un modello generale per comprendere e produrre testo su misura per il dominio specifico.

- Specializzazione del compito: Gli LLM possono essere ottimizzati per varie attività di elaborazione del linguaggio naturale come il riepilogo del testo, la traduzione automatica, la risposta a domande e così via. Questa specializzazione aumenta le prestazioni sull'attività target.

- Conformità dei dati: I settori altamente regolamentati, come quello sanitario e finanziario, impongono severi requisiti in materia di privacy dei dati. La messa a punto consente di formare LLM su dati organizzativi proprietari proteggendo al contempo le informazioni sensibili.

- Dati etichettati limitati: Ottenere grandi set di dati etichettati da zero per l'addestramento di modelli può essere impegnativo. La messa a punto consente di ottenere prestazioni elevate a partire da esempi supervisionati limitati, sfruttando le capacità del modello pre-addestrato.

- Aggiornamento del modello: Man mano che nuovi dati diventano disponibili nel tempo in un dominio, è possibile ottimizzare ulteriormente i modelli per incorporare le conoscenze e le funzionalità più recenti.

- Mitigare i pregiudizi: Gli LLM possono rilevare pregiudizi sociali da ampi dati pre-formazione. La messa a punto di set di dati curati può aiutare a ridurre e correggere questi pregiudizi indesiderati.

In sostanza, la messa a punto colma il divario tra un modello generale e ampio e i requisiti mirati di un’applicazione specializzata. Migliora l'accuratezza, la sicurezza e la pertinenza degli output del modello per casi d'uso mirati.

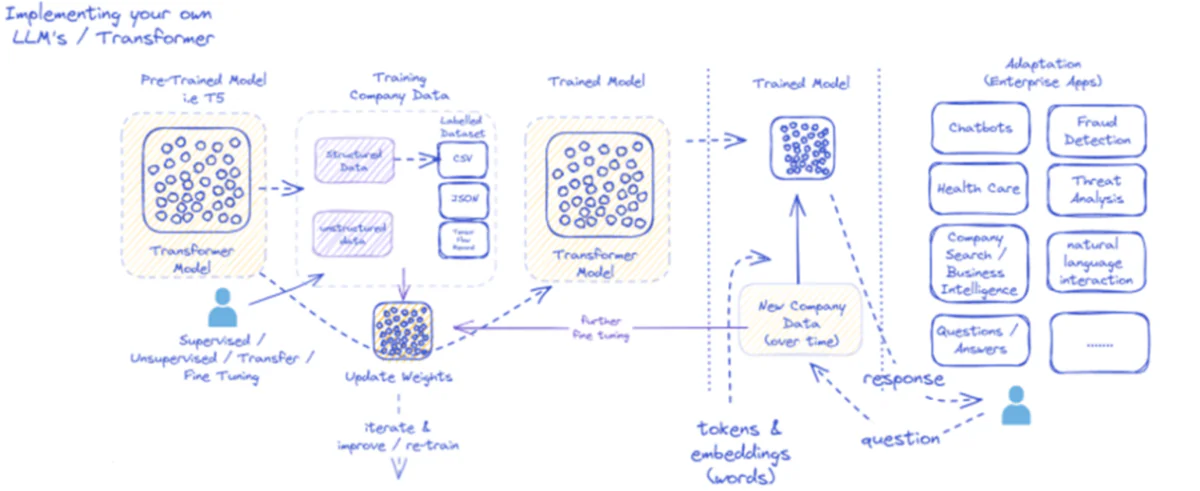

Il diagramma fornito descrive il processo di implementazione e utilizzo di modelli linguistici di grandi dimensioni (LLM), specificamente per applicazioni aziendali. Inizialmente, un modello pre-addestrato come T5 viene alimentato con dati aziendali strutturati e non strutturati, che possono essere disponibili in vari formati come CSV o JSON. Questi dati vengono sottoposti a processi di fine-tuning supervisionati, non supervisionati o di trasferimento, migliorando la pertinenza del modello alle esigenze specifiche dell'azienda.

Una volta ottimizzato il modello con i dati aziendali, i suoi pesi vengono aggiornati di conseguenza. Il modello addestrato viene quindi ripetuto attraverso ulteriori cicli di formazione, migliorando continuamente le sue risposte nel tempo con nuovi dati aziendali. Il processo è iterativo e dinamico, con l'apprendimento e la riqualificazione del modello per adattarsi all'evoluzione dei modelli di dati.

L'output di questo modello addestrato, ovvero token e incorporamenti che rappresentano parole, viene quindi distribuito per varie applicazioni aziendali. Queste applicazioni possono variare dai chatbot all'assistenza sanitaria, ognuna delle quali richiede che il modello comprenda e risponda a domande specifiche del settore. Nella finanza, le applicazioni includono il rilevamento delle frodi e l'analisi delle minacce; nel settore sanitario, i modelli possono aiutare con le richieste dei pazienti e la diagnostica.

La capacità del modello addestrato di elaborare e rispondere ai nuovi dati aziendali nel tempo garantisce che la sua utilità sia sostenibile e in continua crescita. Di conseguenza, gli utenti aziendali possono interagire con il modello tramite applicazioni, ponendo domande e ricevendo risposte informate che riflettono l'addestramento e l'ottimizzazione del modello su dati specifici del dominio.

Questa infrastruttura supporta un'ampia gamma di applicazioni aziendali, dimostrando la versatilità e l'adattabilità degli LLM se adeguatamente implementati e mantenuti in un contesto aziendale.

Approcci di messa a punto

Esistono due strategie principali quando si tratta di mettere a punto modelli linguistici di grandi dimensioni:

1) Messa a punto completa del modello

Nell'approccio di fine-tuning completo, tutti i parametri (pesi e bias) del modello pre-addestrato vengono aggiornati durante la seconda fase di addestramento. Il modello viene esposto al set di dati etichettato specifico dell'attività e il processo di training standard ottimizza l'intero modello per tale distribuzione dei dati.

Ciò consente al modello di apportare modifiche più complete e di adattarsi olisticamente all'attività o al dominio di destinazione. Tuttavia, la messa a punto completa presenta alcuni svantaggi:

- Richiede notevoli risorse computazionali e tempo per l'addestramento, simile alla fase di pre-addestramento.

- I requisiti di archiviazione sono elevati, poiché è necessario mantenere una copia separata e ottimizzata del modello per ciascuna attività.

- Esiste il rischio di un “dimentico catastrofico”, in cui la messa a punto fa sì che il modello perda alcune capacità generali apprese durante la pre-formazione.

Nonostante queste limitazioni, il perfezionamento completo rimane una tecnica potente e ampiamente utilizzata quando le risorse lo consentono e il compito target si discosta significativamente dal linguaggio generale.

2) Metodi efficienti di messa a punto

Per superare le sfide computazionali del fine-tuning completo, i ricercatori hanno sviluppato strategie efficienti che aggiornano solo un piccolo sottoinsieme dei parametri del modello durante la fase di fine-tuning. Queste tecniche parametricamente efficienti raggiungono un equilibrio tra specializzazione e riduzione del fabbisogno di risorse.

Alcuni metodi di messa a punto efficienti e popolari includono:

Sintonizzazione del prefisso: In questo caso, un piccolo numero di vettori specifici per l'attività, o "prefissi", viene introdotto e addestrato per condizionare l'attenzione del modello pre-addestrato per l'attività target. Solo questi prefissi vengono aggiornati durante la messa a punto.

LoRA (adattamento di basso rango): LORA inserisce matrici di basso rango addestrabili in ogni strato del modello pre-addestrato durante la messa a punto. Questi piccoli aggiustamenti di rango aiutano a specializzare il modello con molti meno parametri addestrabili rispetto alla messa a punto completa.

Certo, posso fornire una spiegazione dettagliata di LoRA (adattamento di basso rango) insieme alla formulazione matematica e agli esempi di codice. LoRA è una popolare tecnica di regolazione fine efficiente dei parametri (PEFT) che ha guadagnato notevole popolarità nel campo dell'adattamento del modello linguistico di grandi dimensioni (LLM).

Cos'è LoRA?

LoRA è un metodo di fine-tuning che introduce un numero limitato di parametri addestrabili nel modello LLM pre-addestrato, consentendo un adattamento efficiente alle attività successive, preservando al contempo la maggior parte delle conoscenze del modello originale. Invece di perfezionare tutti i parametri del modello LLM, LoRA inietta matrici di basso rango specifiche per l'attività nei livelli del modello, consentendo un significativo risparmio di risorse computazionali e di memoria durante il processo di fine-tuning.

Formulazione matematica

LoRA (Low-Rank Adaptation) è un metodo di fine tuning per modelli linguistici di grandi dimensioni (LLM) che introduce un aggiornamento di basso rango nelle matrici dei pesi. Per una matrice di peso 0∈W0 ∈Rd×k, LoRA aggiunge una matrice di rango basso BA, con A∈Rr×k e B∈Rd×rDurante la serata, r è il rango. Questo approccio riduce significativamente il numero di parametri addestrabili, consentendo un adattamento efficiente alle attività a valle con risorse computazionali minime. La matrice dei pesi aggiornata è data da W=W0 +B⋅A.

Questo aggiornamento di basso rango può essere interpretato come una modifica della matrice dei pesi originale $W_{0}$ aggiungendo una matrice di basso rango $BA$. Il vantaggio principale di questa formulazione è che invece di aggiornare tutti i parametri $d \times k$ in $W_{0}$, LoRA deve solo ottimizzare i parametri $r \times (d + k)$ in $A$ e $B $, riducendo significativamente il numero di parametri addestrabili.

Ecco un esempio in Python utilizzando peft libreria per applicare LoRA a un LLM pre-addestrato per la classificazione del testo:

</div> <div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color="">from</span> transformers <span class="token" data-darkreader-inline-color="">import</span> AutoModelForSequenceClassification </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color="">from</span> peft <span class="token" data-darkreader-inline-color="">import</span> get_peft_model<span class="token" data-darkreader-inline-color="">,</span> LoraConfig<span class="token" data-darkreader-inline-color="">,</span> TaskType </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Load pre-trained model</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">model <span class="token" data-darkreader-inline-color="">=</span> AutoModelForSequenceClassification<span class="token" data-darkreader-inline-color="">.</span>from_pretrained<span class="token" data-darkreader-inline-color="">(</span><span class="token" data-darkreader-inline-color="">"bert-base-uncased"</span><span class="token" data-darkreader-inline-color="">,</span> num_labels<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">2</span><span class="token" data-darkreader-inline-color="">)</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Define LoRA configuration</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">peft_config <span class="token" data-darkreader-inline-color="">=</span> LoraConfig<span class="token" data-darkreader-inline-color="">(</span>task_type<span class="token" data-darkreader-inline-color="">=</span>TaskType<span class="token" data-darkreader-inline-color="">.</span>SEQ_CLS<span class="token" data-darkreader-inline-color="">, </span>r<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">8</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color=""># Rank of the low-rank update</span> lora_alpha<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">16</span><span class="token" data-darkreader-inline-color="">,</span></code><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Scaling factor for the low-rank update</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""> target_modules<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">[</span><span class="token" data-darkreader-inline-color="">"q_lin"</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color="">"v_lin"</span><span class="token" data-darkreader-inline-color="">]</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color=""># Apply LoRA to the query and value layers</span> <span class="token" data-darkreader-inline-color="">)</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Create the LoRA-enabled model</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">model <span class="token" data-darkreader-inline-color="">=</span> get_peft_model<span class="token" data-darkreader-inline-color="">(</span>model<span class="token" data-darkreader-inline-color="">,</span> peft_config<span class="token" data-darkreader-inline-color="">)</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Fine-tune the model with LoRA</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># ... (training code omitted for brevity)</span></code></div> </div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">

In questo esempio, carichiamo un modello BERT pre-addestrato per la classificazione della sequenza e definiamo una configurazione LoRA. IL r il parametro specifica il rango dell'aggiornamento di rango basso e lora_alpha è un fattore di scala per l'aggiornamento. IL target_modules Il parametro indica quali livelli del modello dovrebbero ricevere gli aggiornamenti di basso rango. Dopo aver creato il modello abilitato per LoRA, possiamo procedere con il processo di messa a punto utilizzando la procedura di formazione standard.

Strati dell'adattatore: simile a LoRA, ma al posto degli aggiornamenti di basso rango, all'interno di ciascun blocco trasformatore del modello pre-addestrato vengono inseriti sottili strati di "adattatore". Vengono addestrati solo i parametri di questi pochi nuovi strati compatti.

Sintonizzazione rapida: Questo approccio mantiene il modello pre-addestrato completamente congelato. Invece, vengono introdotti come input degli embedding "prompt" addestrabili per attivare la conoscenza pre-addestrata del modello per l'attività target.

Questi metodi efficienti possono fornire riduzioni di calcolo fino a 100 volte rispetto alla messa a punto completa, pur ottenendo prestazioni competitive su molte attività. Riducono inoltre le esigenze di archiviazione evitando la duplicazione completa del modello.

Tuttavia, le loro prestazioni potrebbero restare indietro rispetto alla messa a punto completa di compiti molto diversi dal linguaggio generale o che richiedono una specializzazione più olistica.

Il processo di messa a punto

Indipendentemente dalla strategia di messa a punto, il processo complessivo di specializzazione di un LLM segue un quadro generale:

- Preparazione del set di dati: Dovrai ottenere o creare un set di dati etichettato che mappi gli input (richieste) agli output desiderati per l'attività di destinazione. Per attività di generazione di testo come la sintesi, si tratterebbe di coppie di testo di input e output riepilogati.

- Divisione del set di dati: seguendo le best practice, dividi il set di dati etichettato in set di training, convalida e test. Ciò separa i dati per l'addestramento del modello, l'ottimizzazione degli iperparametri e la valutazione finale.

- Sintonia iperparametro: parametri come la velocità di apprendimento, la dimensione del batch e il programma di formazione devono essere ottimizzati per la messa a punto più efficace dei dati. Questo di solito comporta un piccolo set di convalida.

- Modello di formazione: Utilizzando gli iperparametri ottimizzati, eseguire il processo di ottimizzazione fine-tuning sull'intero set di addestramento finché le prestazioni del modello sul set di convalida non smettono di migliorare (arresto anticipato).

- Valutazione: Valutare le prestazioni del modello ottimizzato sul set di test disponibile, idealmente comprendente esempi reali per il caso d'uso target, per stimare l'efficacia nel mondo reale.

- Distribuzione e monitoraggio: Una volta soddisfacente, il modello perfezionato può essere utilizzato per l'inferenza su nuovi input. È fondamentale monitorarne le prestazioni e l'accuratezza nel tempo per individuare eventuali derive concettuali.

Sebbene ciò descriva il processo complessivo, molte sfumature possono influire sul successo della messa a punto di un particolare LLM o attività. Strategie come l'apprendimento del curriculum, la messa a punto di più attività e i suggerimenti in pochi passaggi possono migliorare ulteriormente le prestazioni.

Inoltre, metodi efficienti di messa a punto comportano considerazioni aggiuntive. Ad esempio, LoRA richiede tecniche come il condizionamento degli output del modello pre-addestrato attraverso un livello di combinazione. La messa a punto rapida richiede istruzioni attentamente progettate per attivare i comportamenti giusti.

Messa a punto avanzata: incorporare il feedback umano

Sebbene la messa a punto standard supervisionata utilizzando set di dati etichettati sia efficace, un'entusiasmante frontiera è la formazione dei LLM utilizzando direttamente le preferenze e il feedback umani. Questo approccio human-in-the-loop sfrutta le tecniche dell’apprendimento per rinforzo:

PPO (Ottimizzazione della politica prossimale): In questo caso, l'LLM viene trattato come un agente di apprendimento per rinforzo, i cui output sono "azioni". Un modello di ricompensa viene addestrato per prevedere le valutazioni umane o i punteggi di qualità per questi output. Il PPO ottimizza quindi l'LLM per generare output che massimizzano i punteggi del modello di ricompensa.

RLHF (Apprendimento di rinforzo dal feedback umano): Questo estende il PPO incorporando direttamente il feedback umano nel processo di apprendimento. Invece di un modello di ricompensa fissa, le ricompense derivano da valutazioni umane iterative sui risultati dell'LLM durante la fase di messa a punto.

Pur essendo intensivi dal punto di vista computazionale, questi metodi consentono di modellare il comportamento LLM in modo più preciso in base alle caratteristiche desiderate valutate dagli esseri umani, oltre a ciò che può essere catturato in un set di dati statici.

Aziende come Anthropic hanno utilizzato RLHF per permeare i loro modelli linguistici come Claude con maggiore veridicità, etica e consapevolezza della sicurezza oltre la semplice competenza del compito.

Potenziali rischi e limitazioni

Sebbene immensamente potente, la messa a punto degli LLM non è priva di rischi che devono essere gestiti con attenzione:

Amplificazione del bias: Se i dati di perfezionamento contengono pregiudizi sociali riguardo al genere, alla razza, all'età o ad altri attributi, il modello può amplificare questi pregiudizi indesiderati. La cura di set di dati rappresentativi e imparziali è fondamentale.

Deriva fattuale: Anche dopo la messa a punto su dati di alta qualità, i modelli linguistici possono “allucinare” fatti errati o risultati incoerenti con gli esempi di formazione durante conversazioni o suggerimenti più lunghi. Potrebbero essere necessari metodi di recupero dei fatti.

Sfide di scalabilità: la messa a punto completa di modelli enormi come GPT-3 richiede immense risorse di elaborazione che potrebbero essere irrealizzabili per molte organizzazioni. Una messa a punto efficiente mitiga parzialmente questo problema, ma presenta dei compromessi.

Dimenticanza catastrofica: Durante il perfezionamento completo, i modelli possono sperimentare un dimenticatoio catastrofico, in cui perdono alcune capacità generali apprese durante il pre-addestramento. Potrebbe essere necessario l’apprendimento multitasking.

Rischi legati alla proprietà intellettuale e alla privacy: i dati proprietari utilizzati per la messa a punto possono fuoriuscire negli output del modello linguistico rilasciati pubblicamente, ponendo rischi. Le tecniche differenziali di mitigazione dei rischi legati alla privacy e alle informazioni sono aree di ricerca attive.

Nel complesso, sebbene eccezionalmente utile, la messa a punto è un processo articolato che richiede attenzione alla qualità dei dati, considerazioni sull'identità, mitigazione dei rischi e bilanciamento dei compromessi tra efficienza e prestazioni in base ai requisiti dei casi d'uso.

Il futuro: personalizzazione del modello linguistico su larga scala

Guardando al futuro, i progressi nelle tecniche di perfezionamento e adattamento dei modelli saranno cruciali per sbloccare l’intero potenziale di modelli linguistici di grandi dimensioni in diverse applicazioni e domini.

Metodi più efficienti che consentano di mettere a punto modelli ancora più grandi come PaLM con risorse limitate potrebbero democratizzare l’accesso. L’automazione delle pipeline di creazione di set di dati e l’ingegneria tempestiva potrebbero semplificare la specializzazione.

Le tecniche auto-supervisionate per ottimizzare i dati grezzi senza etichette possono aprire nuove frontiere. E gli approcci compositivi per combinare sottomodelli ottimizzati addestrati su compiti o dati diversi potrebbero consentire di costruire modelli altamente personalizzati su richiesta.

In definitiva, man mano che gli LLM diventano più onnipresenti, la capacità di personalizzarli e specializzarli senza soluzione di continuità per ogni caso d’uso immaginabile sarà fondamentale. La messa a punto e le relative strategie di adattamento del modello sono passi fondamentali per realizzare la visione di grandi modelli linguistici come assistenti IA flessibili, sicuri e potenti che aumentano le capacità umane in ogni ambito e attività.

Ho trascorso gli ultimi cinque anni immergendomi nell'affascinante mondo del Machine Learning e del Deep Learning. La mia passione e competenza mi hanno portato a contribuire a oltre 50 diversi progetti di ingegneria del software, con un focus particolare su AI/ML. La mia continua curiosità mi ha anche attirato verso l'elaborazione del linguaggio naturale, un campo che non vedo l'ora di esplorare ulteriormente.

Ti potrebbe piacere

-

Un metodo "Zen" per impedire ai modelli linguistici di creare allucinazioni

-

La ricerca rivela che gli LLM tendono a ricorrere al ragionamento semplice quando la complessità aumenta

-

Utilizzare il programma televisivo "Dr. House" per sviluppare le capacità diagnostiche dell'intelligenza artificiale

-

Identificazione del furto di modelli di intelligenza artificiale tramite dati di tracciamento segreti

-

La fine della Tabula Rasa: come i modelli mondiali pre-addestrati stanno ridefinendo l'apprendimento per rinforzo

-

Come far passare di nascosto articoli scientifici assurdi ai revisori dell'intelligenza artificiale