Ingegneria rapida

Oltre la catena del pensiero: come l'ottimizzazione delle preferenze di pensiero sta facendo progredire gli LLM

Una nuova tecnica rivoluzionaria, sviluppata da un team di ricercatori di Meta, UC Berkeley e NYU, promette di migliorare il modo in cui i sistemi di intelligenza artificiale affrontano le attività generali. Noto come "Ottimizzazione delle preferenze di pensiero” (TPO), questo metodo mira a rendere modelli linguistici di grandi dimensioni (LLM) più riflessivi e ponderati nelle loro risposte.

Lo sforzo collaborativo alla base del TPO riunisce le competenze di alcune delle principali istituzioni nella ricerca sull'intelligenza artificiale.

La meccanica dell'ottimizzazione delle preferenze di pensiero

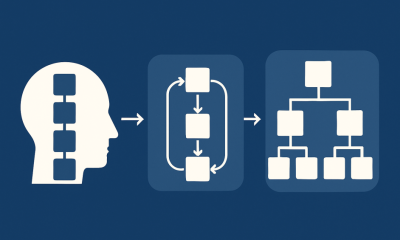

In sostanza, il TPO funziona incoraggiando i modelli di intelligenza artificiale a generare "passaggi di pensiero" prima di produrre una risposta finale. Questo processo imita i processi cognitivi umani, in cui spesso pensiamo a un problema o a una domanda prima di articolare la nostra risposta.

La tecnica prevede diversi passaggi chiave:

- Al modello viene richiesto di generare fasi di pensiero prima di rispondere a una query.

- Vengono creati più output, ciascuno con il proprio insieme di passaggi di pensiero e risposta finale.

- Un modello di valutazione valuta solo le risposte finali, non i singoli passaggi di pensiero.

- Sulla base di queste valutazioni, il modello viene poi addestrato tramite l'ottimizzazione delle preferenze.

Questo approccio differisce significativamente dalle tecniche precedenti, come Suggerimenti legati alla catena di pensiero (CoT).Mentre CoT è stato utilizzato principalmente per compiti di matematica e logica, TPO è progettato per avere un'utilità più ampia in vari tipi di query e istruzioni. Inoltre, TPO non richiede una supervisione esplicita del processo di pensiero, consentendo al modello di sviluppare strategie di pensiero efficaci e autonome.

Un'altra differenza fondamentale è che TPO supera la sfida dei dati di training limitati contenenti processi di pensiero umani. Concentrando la valutazione sull'output finale piuttosto che sui passaggi intermedi, TPO consente l'emergere di modelli di pensiero più flessibili e diversificati.

Configurazione sperimentale e risultati

Per testare l'efficacia del TPO, i ricercatori hanno condotto esperimenti utilizzando due importanti benchmark nel campo dei modelli linguistici AI: AlpacaEval e Arena-Hard. Questi benchmark sono progettati per valutare le capacità generali di seguire le istruzioni dei modelli AI in un'ampia gamma di attività.

Gli esperimenti hanno utilizzato Llama-3-8B-Instruct come modello seed, con diversi modelli di giudice impiegati per la valutazione. Questa configurazione ha permesso ai ricercatori di confrontare le prestazioni di TPO con i modelli di base e di valutarne l'impatto su vari tipi di attività.

I risultati di questi esperimenti sono stati promettenti, mostrando miglioramenti in diverse categorie:

- Ragionamento e risoluzione dei problemi: Come previsto, il TPO ha mostrato miglioramenti nei compiti che richiedono pensiero logico e analisi.

- Conoscenza generale: È interessante notare che la tecnica ha migliorato anche le prestazioni nelle query relative a informazioni fattuali di carattere generale.

- Marketing: Forse sorprendentemente, TPO ha dimostrato maggiori capacità in attività legate al marketing e alle vendite.

- Attività creative: I ricercatori hanno notato potenziali benefici in ambiti come la scrittura creativa, suggerendo che “pensare” può aiutare nella pianificazione e nella strutturazione di risultati creativi.

Questi miglioramenti non si sono limitati alle attività tradizionalmente basate sul ragionamento, il che indica che TPO ha il potenziale per migliorare le prestazioni dell'IA in un ampio spettro di applicazioni. I tassi di vincita sui benchmark AlpacaEval e Arena-Hard hanno mostrato miglioramenti significativi rispetto ai modelli di base, con TPO che ha ottenuto risultati competitivi anche se confrontati con modelli linguistici molto più grandi.

Tuttavia, è importante notare che l'attuale implementazione del TPO ha mostrato alcune limitazioni, in particolare nei compiti matematici. I ricercatori hanno osservato che le prestazioni nei problemi matematici sono effettivamente diminuite rispetto al modello di base, suggerendo che potrebbero essere necessari ulteriori perfezionamenti per affrontare domini specifici.

Implicazioni per lo sviluppo dell'intelligenza artificiale

Il successo del TPO nel migliorare le prestazioni in varie categorie apre interessanti possibilità per le applicazioni AI. Oltre ai tradizionali compiti di ragionamento e risoluzione dei problemi, questa tecnica potrebbe migliorare le capacità dell'AI nella scrittura creativa, nella traduzione linguistica e nella generazione di contenuti. Consentendo all'AI di "pensare" attraverso processi complessi prima di generare output, potremmo vedere risultati più sfumati e consapevoli del contesto in questi campi.

Nel servizio clienti, il TPO potrebbe portare a risposte più ponderate e complete da parte di chatbot e assistenti virtuali, migliorando potenzialmente la soddisfazione dell'utente e riducendo la necessità di intervento umano. Inoltre, nel regno dell'analisi dei dati, questo approccio potrebbe consentire all'IA di considerare più prospettive e potenziali correlazioni prima di trarre conclusioni da set di dati complessi, portando ad analisi più approfondite e affidabili.

Nonostante i suoi risultati promettenti, il TPO affronta diverse sfide nella sua forma attuale. Il declino osservato nei compiti correlati alla matematica suggerisce che la tecnica potrebbe non essere universalmente vantaggiosa in tutti i domini. Questa limitazione evidenzia la necessità di perfezionamenti specifici per dominio all'approccio TPO.

Un'altra sfida significativa è il potenziale aumento del sovraccarico computazionale. Il processo di generazione e valutazione di più percorsi di pensiero potrebbe aumentare i tempi di elaborazione e il fabbisogno di risorse, il che potrebbe limitare l'applicabilità del TPO in scenari in cui la rapidità di risposta è fondamentale.

Inoltre, lo studio attuale si è concentrato su una dimensione specifica del modello, sollevando interrogativi sulla scalabilità del TPO a modelli linguistici più grandi o più piccoli. Esiste anche il rischio di "pensare troppo": un "pensare" eccessivo potrebbe portare a risposte contorte o eccessivamente complesse per compiti semplici.

Trovare un equilibrio tra profondità di pensiero e complessità del compito da svolgere sarà un aspetto fondamentale per la ricerca e lo sviluppo futuri.

Direzioni future

Un'area chiave per la ricerca futura è lo sviluppo di metodi per controllare la lunghezza e la profondità dei processi di pensiero dell'IA. Ciò potrebbe comportare un adattamento dinamico, consentendo al modello di adattare la sua profondità di pensiero in base alla complessità del compito da svolgere. I ricercatori potrebbero anche esplorare parametri definiti dall'utente, consentendogli di specificare il livello di pensiero desiderato per diverse applicazioni.

L'ottimizzazione dell'efficienza sarà cruciale in quest'area. Sviluppare algoritmi per trovare il punto debole tra attenta considerazione e tempi di risposta rapidi potrebbe migliorare significativamente l'applicabilità pratica del TPO in vari domini e casi d'uso.

Man mano che i modelli di IA continuano a crescere in termini di dimensioni e capacità, sarà fondamentale esplorare come il TPO si adatta alle dimensioni del modello. Le direzioni di ricerca future potrebbero includere:

- Test del TPO su modelli linguistici di grandi dimensioni all'avanguardia per valutarne l'impatto sui sistemi di intelligenza artificiale più avanzati

- Indagare se modelli più grandi richiedano approcci diversi alla generazione e alla valutazione del pensiero

- Esplorare il potenziale del TPO per colmare il divario di prestazioni tra modelli più piccoli e più grandi, rendendo potenzialmente più efficiente l'uso delle risorse computazionali

Questa ricerca potrebbe portare allo sviluppo di sistemi di intelligenza artificiale più sofisticati, in grado di gestire compiti sempre più complessi, mantenendo efficienza e precisione.

Conclusione

Thought Preference Optimization rappresenta un significativo passo avanti nel potenziamento delle capacità dei grandi modelli linguistici. Incoraggiando i sistemi AI a "pensare prima di parlare", TPO ha dimostrato miglioramenti in un'ampia gamma di attività, rivoluzionando potenzialmente il nostro approccio allo sviluppo dell'AI.

Man mano che la ricerca in quest'area prosegue, possiamo aspettarci di vedere ulteriori perfezionamenti della tecnica, affrontando le attuali limitazioni ed espandendone le applicazioni. Il futuro dell'IA potrebbe benissimo coinvolgere sistemi che non solo elaborano informazioni, ma si impegnano anche in processi cognitivi più simili a quelli umani, portando a un'intelligenza artificiale più sfumata, consapevole del contesto e, in definitiva, più utile.