Intelligenza Artificiale

AnomalyGPT: rilevamento di anomalie industriali utilizzando LVLM

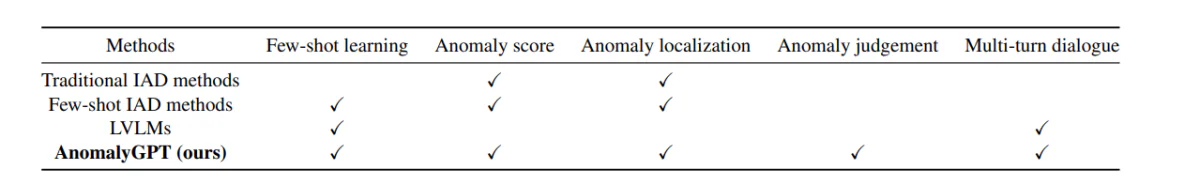

Recentemente, i Large Vision Language Models (LVLM) come LLava e MiniGPT-4 hanno dimostrato la capacità di comprendere le immagini e ottenere elevata precisione ed efficienza in diversi compiti visivi. Sebbene gli LVLM eccellano nel riconoscere oggetti comuni grazie ai loro estesi set di dati di addestramento, mancano di conoscenze specifiche del dominio e hanno una comprensione limitata dei dettagli localizzati all'interno delle immagini. Ciò limita la loro efficacia nelle attività di rilevamento di anomalie industriali (IAD). D’altra parte, i quadri IAD esistenti possono solo identificare le fonti di anomalie e richiedere l’impostazione manuale delle soglie per distinguere tra campioni normali e anomali, limitando così la loro implementazione pratica.

Lo scopo principale di un framework IAD è rilevare e localizzare anomalie negli scenari industriali e nelle immagini dei prodotti. Tuttavia, a causa dell’imprevedibilità e della rarità dei campioni di immagini del mondo reale, i modelli vengono generalmente addestrati solo su dati normali. Differenziano i campioni anomali da quelli normali in base alle deviazioni dai campioni tipici. Attualmente, i framework e i modelli IAD forniscono principalmente punteggi di anomalia per i campioni di test. Inoltre, la distinzione tra istanze normali e anomale per ciascuna classe di elementi richiede la specifica manuale delle soglie, rendendole inadatte per le applicazioni del mondo reale.

Per esplorare l’uso e l’implementazione dei Large Vision Language Models nell’affrontare le sfide poste dai framework IAD, è stato introdotto AnomalyGPT, un nuovo approccio IAD basato su LVLM. AnomalyGPT è in grado di rilevare e localizzare anomalie senza la necessità di impostare manualmente la soglia. Inoltre, AnomalyGPT può anche offrire informazioni pertinenti sull'immagine per interagire in modo interattivo con gli utenti, consentendo loro di porre domande di follow-up in base all'anomalia o alle loro esigenze specifiche.

Rilevamento delle anomalie del settore e modelli linguistici di visione di grandi dimensioni

I framework IAD esistenti possono essere classificati in due categorie.

- IAD basato sulla ricostruzione.

- IAD basato sull'incorporamento di funzionalità.

In un quadro IAD basato sulla ricostruzione, l'obiettivo principale è ricostruire i campioni di anomalie nei rispettivi campioni di controparti normali e rilevare le anomalie mediante il calcolo dell'errore di ricostruzione. SCADN, RIAD, AnoDDPM e InTra fanno uso di diversi framework di ricostruzione che vanno dalle Generative Adversarial Networks (GAN) e dagli autoencoder, al modello di diffusione e ai trasformatori.

D'altra parte, in un framework IAD basato su Feature Embedding, il motivo principale è concentrarsi sulla modellazione dell'incorporamento di feature di dati normali. Metodi come PatchSSVD cercano di trovare un'ipersfera che possa incapsulare strettamente campioni normali, mentre framework come PyramidFlow e Cfl proiettano campioni normali su una distribuzione gaussiana utilizzando flussi di normalizzazione. I framework CFA e PatchCore hanno creato un banco di memoria di campioni normali provenienti da incorporamenti di patch e utilizzano la distanza tra il campione di test che incorpora l'incorporamento normale per rilevare anomalie.

Entrambi questi metodi seguono il “una classe un modello”, un paradigma di apprendimento che richiede una grande quantità di campioni normali per apprendere le distribuzioni di ciascuna classe di oggetti. Il requisito di una grande quantità di campioni normali lo rende poco pratico per nuove categorie di oggetti e con applicazioni limitate in ambienti di prodotto dinamici. D'altra parte, il framework AnomalyGPT fa uso di un paradigma di apprendimento in contesto per le categorie di oggetti, consentendogli di abilitare l'interferenza solo con una manciata di campioni normali.

Andando avanti, abbiamo modelli linguistici di visione di grandi dimensioni o LVLM. LLM o modelli linguistici di grandi dimensioni hanno riscosso un enorme successo nel settore della PNL e vengono ora esplorati per le loro applicazioni in compiti visivi. Il framework BLIP-2 sfrutta Q-former per inserire funzionalità visive da Vision Transformer nel modello Flan-T5. Inoltre, il Quadro MiniGPT collega il segmento di immagine del framework BLIP-2 e il modello Vicuna con uno strato lineare ed esegue un processo di perfezionamento in due fasi utilizzando dati di testo-immagine. Questi approcci indicano che i framework LLM potrebbero avere alcune applicazioni per attività visive. Tuttavia, questi modelli sono stati addestrati su dati generali e non dispongono delle competenze specifiche del settore richieste per applicazioni diffuse.

Come funziona AnomalyGPT?

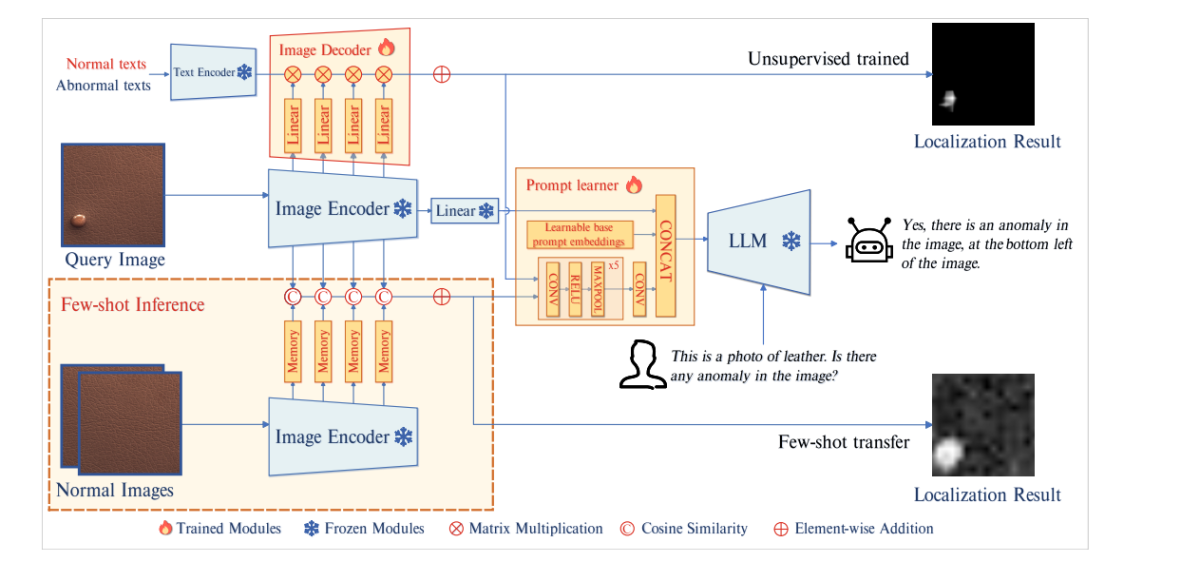

AnomalyGPT è un nuovo modello di linguaggio di visione conversazionale IAD di grandi dimensioni progettato principalmente per rilevare anomalie industriali e individuare la loro esatta posizione utilizzando immagini. Il framework AnomalyGPT utilizza un LLM e un codificatore di immagini pre-addestrato per allineare le immagini con le corrispondenti descrizioni testuali utilizzando i dati di anomalia stimolati. Il modello introduce un modulo decodificatore e un modulo di apprendimento rapido per migliorare le prestazioni dei sistemi IAD e ottenere un output di localizzazione a livello di pixel.

Architettura di modello

L'immagine sopra mostra l'architettura di AnomalyGPT. Il modello passa innanzitutto l'immagine della query al codificatore di immagini bloccate. Il modello quindi estrae le caratteristiche a livello di patch dagli strati intermedi e le invia a un decodificatore di immagini per calcolare la loro somiglianza con testi anormali e normali per ottenere i risultati per la localizzazione. Lo studente prompt li converte quindi in incorporamenti di prompt adatti a essere utilizzati come input nel LLM insieme agli input di testo dell'utente. Il modello LLM sfrutta quindi gli incorporamenti di prompt, gli input di immagini e gli input testuali forniti dall'utente per rilevare anomalie, individuarne la posizione e creare risposte finali per l'utente.

decoder

Per ottenere la localizzazione delle anomalie a livello di pixel, il modello AnomalyGPT distribuisce un decodificatore di immagini basato sulla corrispondenza delle funzionalità leggero che supporta sia i framework IAD a pochi scatti, sia i framework IAD non supervisionati. Il design del decodificatore utilizzato in AnomalyGPT si ispira ai framework WinCLIP, PatchCore e APRIL-GAN. Il modello suddivide il codificatore di immagini in 4 fasi ed estrae le funzionalità del livello di patch intermedio in ogni fase.

Tuttavia, queste caratteristiche intermedie non hanno superato l'allineamento finale immagine-testo, motivo per cui non possono essere confrontate direttamente con le caratteristiche. Per affrontare questo problema, il modello AnomalyGPT introduce livelli aggiuntivi per proiettare caratteristiche intermedie e allinearle con caratteristiche del testo che rappresentano la semantica normale e anormale.

Studente tempestivo

Il framework AnomalyGPT introduce uno studente immediato che tenta di trasformare il risultato della localizzazione in incorporamenti rapidi per sfruttare la semantica a grana fine delle immagini e mantiene anche la coerenza semantica tra il decodificatore e gli output LLM. Inoltre, il modello incorpora incorporamenti di prompt apprendibili, non correlati agli output del decodificatore, nel prompt dello studente per fornire informazioni aggiuntive per il compito IAD. Infine, il modello fornisce gli incorporamenti e le informazioni sull'immagine originale al LLM.

Il prompt learner è costituito da incorporamenti di prompt di base apprendibili e da una rete neurale convoluzionale. La rete converte il risultato della localizzazione in incorporamenti di prompt e forma una serie di incorporamenti di prompt che vengono poi combinati con gli incorporamenti di immagini nel file LLM.

Simulazione di anomalie

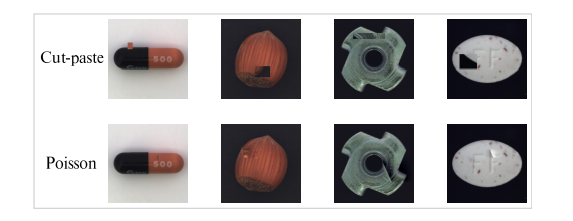

Il modello AnomalyGPT adotta il metodo NSA per simulare dati anomali. Il metodo NSA utilizza la tecnica Taglia-incolla utilizzando il metodo di editing delle immagini di Poisson per alleviare la discontinuità introdotta incollando segmenti di immagine. Il taglia-incolla è una tecnica comunemente utilizzata nei framework IAD per generare immagini di anomalie simulate.

Il metodo Taglia-incolla prevede di ritagliare casualmente una regione di blocco da un'immagine e di incollarla in una posizione casuale in un'altra immagine, creando così una porzione di anomalia simulata. Questi campioni di anomalie simulati possono migliorare le prestazioni dei modelli IAD, ma presentano uno svantaggio, poiché spesso possono produrre discontinuità evidenti. Il metodo di modifica di Poisson mira a clonare perfettamente un oggetto da un'immagine all'altra risolvendo le equazioni differenziali parziali di Poisson.

L'immagine sopra illustra il confronto tra l'editing delle immagini Poisson e Taglia-incolla. Come si può notare, sono visibili delle discontinuità nel metodo taglia-incolla, mentre i risultati del montaggio di Poisson sembrano più naturali.

Contenuto di domande e risposte

Per effettuare una tempestiva messa a punto del modello Large Vision Language, il modello AnomalyGPT genera una query testuale corrispondente sulla base dell'immagine dell'anomalia. Ogni query è composta da due componenti principali. La prima parte della query consiste in una descrizione dell'immagine di input che fornisce informazioni sugli oggetti presenti nell'immagine insieme ai loro attributi attesi. La seconda parte della query consiste nel rilevare la presenza di anomalie all'interno dell'oggetto, ovvero verificare se è presente un'anomalia nell'immagine.

L'LVLM risponde innanzitutto alla domanda se è presente un'anomalia nell'immagine? Se il modello rileva anomalie, continua a specificare la posizione e il numero delle aree anomale. Il modello divide l'immagine in una griglia 3×3 di regioni distinte per consentire al LVLM di indicare verbalmente la posizione delle anomalie come mostrato nella figura sottostante.

Il modello LVLM viene alimentato dalla conoscenza descrittiva dell'input con la conoscenza fondamentale dell'immagine di input che aiuta la migliore comprensione dei componenti dell'immagine da parte del modello.

Set di dati e metriche di valutazione

Il modello conduce i suoi esperimenti principalmente sui set di dati VisA e MVTec-AD. Il set di dati MVTech-AD è composto da 3629 immagini per scopi di formazione e 1725 immagini per test suddivise in 15 diverse categorie, motivo per cui è uno dei set di dati più popolari per i framework IAD. L'immagine di training presenta solo immagini normali mentre le immagini di test presentano sia immagini normali che anomale. D'altra parte, il set di dati VisA è composto da 9621 immagini normali e quasi 1200 immagini anomale suddivise in 12 diverse categorie.

Andando avanti, proprio come il framework IAD esistente, il modello AnomalyGPT utilizza l'AUC o le caratteristiche operative dell'area sotto il ricevitore come metrica di valutazione, con l'AUC a livello di pixel e a livello di immagine utilizzata per valutare rispettivamente le prestazioni di localizzazione delle anomalie e il rilevamento delle anomalie. Tuttavia, il modello utilizza anche l'accuratezza a livello di immagine per valutare le prestazioni dell'approccio proposto perché consente in modo univoco di determinare la presenza di anomalie senza la necessità di impostare manualmente le soglie.

Risultati

Risultati quantitativi

Rilevamento di anomalie industriali con pochi colpi

Il modello AnomalyGPT confronta i suoi risultati con i precedenti framework IAD “low-shot” tra cui PaDiM, SPADE, WinCLIP e PatchCore come linee di base.

La figura sopra confronta i risultati del modello AnomalyGPT rispetto ai framework IAD a pochi colpi. In entrambi i set di dati, il metodo seguito da AnomalyGPT supera gli approcci adottati dai modelli precedenti in termini di AUC a livello di immagine e restituisce anche una buona precisione.

Rilevamento di anomalie industriali senza supervisione

In un ambiente di addestramento non supervisionato con un gran numero di campioni normali, AnomalyGPT addestra un singolo modello su campioni ottenuti da tutte le classi all'interno di un set di dati. Gli sviluppatori di AnomalyGPT hanno optato per il framework UniAD perché è addestrato con la stessa configurazione e fungerà da base per il confronto. Inoltre, il modello si confronta anche con i framework JNLD e PaDim utilizzando la stessa impostazione unificata.

La figura sopra confronta le prestazioni di AnomalyGPT rispetto ad altri framework.

Risultati qualitativi

L'immagine sopra illustra le prestazioni del modello AnomalyGPT nel metodo di rilevamento di anomalie non supervisionato, mentre la figura seguente mostra le prestazioni del modello nell'apprendimento in contesto 1-shot.

Il modello AnomalyGPT è in grado di indicare la presenza di anomalie, contrassegnarne la posizione e fornire risultati di localizzazione a livello di pixel. Quando il modello utilizza il metodo di apprendimento in contesto 1-shot, le prestazioni di localizzazione del modello sono leggermente inferiori rispetto al metodo di apprendimento non supervisionato a causa dell'assenza di formazione.

Conclusione

AnomalyGPT è un nuovo modello di linguaggio conversazionale per la visione IAD progettato per sfruttare le potenti capacità dei modelli di linguaggio per la visione di grandi dimensioni. Non solo può identificare le anomalie in un'immagine, ma anche individuarne la posizione esatta. Inoltre, AnomalyGPT facilita i dialoghi a più turni incentrati sul rilevamento delle anomalie e mostra prestazioni eccezionali nell'apprendimento contestuale in poche riprese. AnomalyGPT approfondisce le potenziali applicazioni degli LVLM nel rilevamento di anomalie, introducendo nuove idee e possibilità per il settore IAD.