Intelligenza Artificiale

Un controllore di bias basato sull'intelligenza artificiale per articoli di notizie, disponibile in Python

Ricercatori in Canada, India, Cina e Australia hanno collaborato per produrre un pacchetto Python disponibile gratuitamente che può essere utilizzato efficacemente per individuare e sostituire il "linguaggio scorretto" nei testi delle notizie.

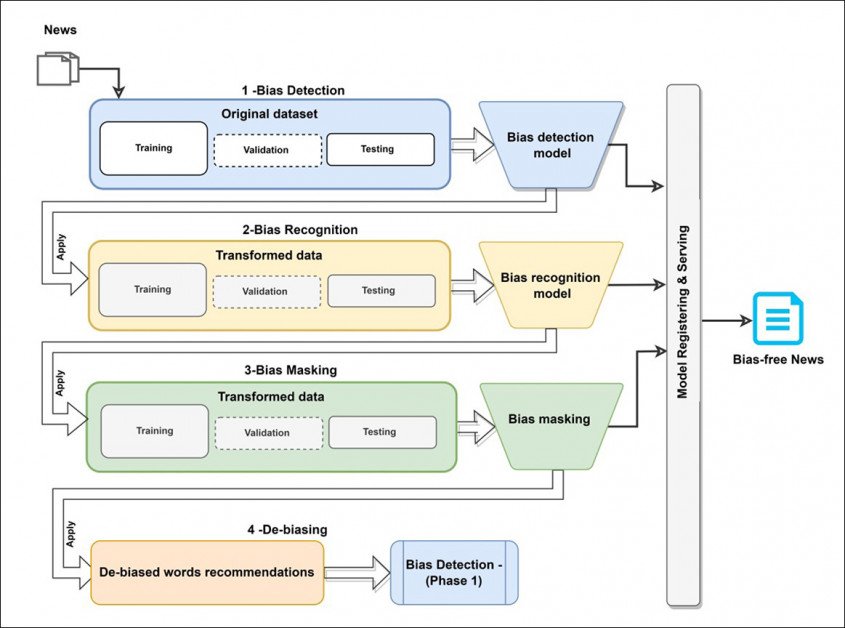

Il sistema, intitolato Dbias, utilizza varie tecnologie e database di apprendimento automatico per sviluppare un flusso di lavoro circolare in tre fasi in grado di perfezionare testo distorto fino a quando non restituisce una versione imparziale, o almeno più neutra.

Il linguaggio caricato in un frammento di notizia identificato come "di parte" viene trasformato in una versione meno incendiaria da Dbias. Fonte: https://arxiv.org/ftp/arxiv/papers/2207/2207.03938.pdf

Il sistema rappresenta una pipeline riutilizzabile e autonoma che può essere installato tramite Pip da Hugging Face e integrato in progetti esistenti come fase supplementare, componente aggiuntivo o plug-in.

Ad aprile, funzionalità simili implementate in Google Docs è stato criticato, anche per la sua mancanza di modificabilità. Dbias, d'altra parte, può essere addestrato in modo più selettivo su qualsiasi corpus di notizie che l'utente finale desidera, mantenendo la capacità di sviluppare linee guida di correttezza su misura.

La differenza fondamentale è che la pipeline Dbias è progettata per trasformare automaticamente il "linguaggio carico" (parole che aggiungono un livello critico alla comunicazione fattuale) in un linguaggio neutro o prosaico, anziché istruire l'utente su base continuativa. In sostanza, l'utente finale definirà filtri etici e addestrerà il sistema di conseguenza; nell'approccio di Google Docs, è il sistema – presumibilmente – a istruire l'utente in modo unilaterale.

Architettura concettuale per il flusso di lavoro Dbias.

Secondo i ricercatori, Dbias è il primo pacchetto di rilevamento dei bias veramente configurabile, in contrasto con i progetti di assemblaggio standard che hanno caratterizzato fino ad oggi questo sottosettore dell'elaborazione del linguaggio naturale (NLP).

. nuovo documento è intitolato Un approccio per garantire l'equità negli articoli di notizie, e proviene da collaboratori dell'Università di Toronto, della Toronto Metropolitan University, dell'Environmental Resources Management di Bangalore, della DeepBlue Academy of Sciences in Cina e dell'Università di Sydney.

Metodo

Il primo modulo in Dbias è Rilevamento bias, che sfrutta il DistillBERT pacchetto – una versione altamente ottimizzata del pacchetto di Google che richiede un uso intensivo delle macchine BERTA. Per il progetto, DistilBERT è stato messo a punto sulla Media Bias Annotation (MBIC) insieme di dati.

MBIC è costituito da articoli di notizie da una varietà di fonti dei media, tra cui l'Huffington Post, USA Today e MSNBC. I ricercatori hanno utilizzato la versione estesa del set di dati.

Sebbene i dati originali siano stati annotati da lavoratori in crowdsourcing (un metodo che è finito sotto il fuoco verso la fine del 2021), i ricercatori del nuovo documento sono stati in grado di identificare ulteriori casi di bias non etichettati nel set di dati e li hanno aggiunti manualmente. Le incidenze identificate di pregiudizi relativi a razza, istruzione, etnia, lingua, religione e genere.

Il modulo successivo, Riconoscimento dei pregiudizi, usi Riconoscimento di entità nominate (NER) per individuare parole distorte dal testo di input. Il documento afferma:

Ad esempio, la notizia "Non credete alle dicerie pseudoscientifiche sui tornado e sui cambiamenti climatici" è stata classificata come distorta dal precedente modulo di rilevamento delle dicerie, e il modulo di riconoscimento delle dicerie ora può identificare il termine "denuncia pseudoscientifica" come una parola distorta.

NER non è specificamente progettato per questo compito, ma è stato utilizzato prima per l'identificazione dei bias, in particolare per a Progetto 2021 dalla Durham University nel Regno Unito.

Per questa fase, i ricercatori hanno utilizzato RoBERta combinato con la pipeline SpaCy English Transformer NER.

La fase successiva, Mascheramento di polarizzazione, comporta una nuova maschera multipla delle parole di bias identificate, che opera in sequenza nei casi di più parole di bias identificate.

Il linguaggio caricato viene sostituito dal linguaggio pragmatico nella terza fase di Dbias. Si noti che "mettere in bocca" e "usare" equivalgono alla stessa azione, sebbene la prima sia considerata derisiva.

Se necessario, il feedback di questa fase verrà rimandato all'inizio della pipeline per un'ulteriore valutazione fino a quando non sarà stato generato un numero di frasi o parole alternative adatte. Questa fase utilizza la modellazione del linguaggio mascherato (MLM) secondo le linee stabilite da a Collaborazione 2021 condotto da Facebook Research.

Normalmente l'attività MLM maschererà il 15% delle parole in modo casuale, ma il flusso di lavoro Dbias dice invece al processo di prendere le parole distorte identificate come input.

L'architettura è stata implementata e addestrata su Google Colab Pro su una NVIDIA P100 con 24 GB di VRAM a una dimensione batch di 16, utilizzando solo due etichette (parziale e imparziale).

Test

I ricercatori hanno testato Dbias rispetto a cinque approcci comparabili: LG-TFIDF con Regressione logistica e Tfidf Vectorizer (TFIDF) incorporamenti di parole; LG-ELMO; MLP-ELMO (una rete neurale artificiale feed-forward contenente incorporamenti ELMO); BERT; e Roberta.

Le metriche utilizzate per i test erano accuratezza (ACC), precisione (PREC), richiamo (Rec) e punteggio F1. Poiché i ricercatori non conoscevano alcun sistema esistente in grado di svolgere tutti e tre i compiti in un'unica pipeline, è stato fatto un distinguo per i framework concorrenti, valutando solo i compiti principali di Dbias: rilevamento e riconoscimento dei bias.

Risultati delle prove Dbias.

Dbias è riuscito a superare i risultati di tutti i framework concorrenti, compresi quelli con un footprint di elaborazione più pesante

Il documento afferma:

"Il risultato mostra anche che gli incorporamenti neurali profondi, in generale, possono superare i metodi tradizionali di incorporamento (ad esempio TFIDF) nel compito di classificazione dei bias". Ciò è dimostrato dalle migliori prestazioni degli incorporamenti di reti neurali profonde (ad esempio, ELMO) rispetto alla vettorizzazione TFIDF quando utilizzato con LG.

"Questo è probabilmente dovuto al fatto che i deep neural embeddings riescono a catturare meglio il contesto delle parole nel testo in contesti diversi. I deep neural embeddings e i metodi deep neural (MLP, BERT, RoBERTa) offrono anche prestazioni migliori rispetto al metodo ML tradizionale (LG)."

I ricercatori osservano inoltre che i metodi basati su Transformer superano i metodi concorrenti nel rilevamento dei bias.

Un test aggiuntivo ha comportato un confronto tra Dbias e varie versioni di SpaCy Core Web, tra cui core-sm (piccolo), core-md (medio) e core-lg (grande). Dbias è riuscito a guidare il board anche in queste prove:

I ricercatori concludono osservando che le attività di riconoscimento dei bias generalmente mostrano una migliore accuratezza in modelli più grandi e più costosi, a causa - ipotizzano - dell'aumento del numero di parametri e punti dati. Osservano inoltre che l'efficacia del lavoro futuro in questo campo dipenderà da maggiori sforzi per annotare set di dati di alta qualità.

La foresta e gli alberi

Si spera che questo tipo di progetto di riconoscimento dettagliato dei pregiudizi venga infine incorporato in quadri di ricerca dei pregiudizi in grado di adottare una visione meno miope e di tenere in considerazione il fatto che la scelta di coprire una particolare storia è di per sé un atto di pregiudizio potenzialmente determinato da qualcosa di più delle semplici statistiche di visualizzazione riportate.

Pubblicato per la prima volta l'14 luglio 2022.