Tekoäly

Mistral AI: Uusien vertailuarvojen asettaminen Llama2:n ulkopuolelle avoimen lähdekoodin avaruudessa

Suuret kielimallit (LLM) ovat viime aikoina nousseet keskipisteeseen ChatGPT:n kaltaisten erottuvien esiintyjien ansiosta. Kun Meta esitteli Llama-mallinsa, se herätti uuden kiinnostuksen avoimen lähdekoodin LLM:itä kohtaan. Määränpää? Luoda kohtuuhintaisia avoimen lähdekoodin LLM:itä, jotka ovat yhtä hyviä kuin huippuluokan mallit, kuten GPT-4, mutta ilman kovaa hintalappua tai monimutkaisuutta.

Tämä kohtuuhintaisuuden ja tehokkuuden yhdistelmä ei ainoastaan avannut uusia mahdollisuuksia tutkijoille ja kehittäjille, vaan myös loi pohjan uudelle teknisen kehityksen aikakaudelle luonnollisen kielen käsittelyssä.

Viime aikoina generatiiviset AI-startupit ovat saaneet rahoitusta. Yhdessä nosti $ 20 miljoonaa, jonka tavoitteena on muotoilla avoimen lähdekoodin tekoäly. Anthropic keräsi myös vaikuttavat 450 miljoonaa dollaria, ja Cohere, joka tekee yhteistyötä Google Cloudin kanssa, vakuutena 270 miljoonaa dollaria tämän vuoden kesäkuussa.

Johdatus Mistral 7B:hen: koko ja saatavuus

Mistral AI, joka sijaitsee Pariisissa ja jonka perustajina ovat Googlen DeepMind ja Meta alumnit, julkisti ensimmäisen suuren kielimallinsa: Mistral 7B. Tämän mallin voi helposti ladata kuka tahansa GitHubista ja jopa a 13.4 gigatavun torrent.

Tämä startup onnistui saamaan ennätysmäärän alkurahoitusta jo ennen kuin tuote oli julkaissut. Mistral AI:n ensimmäinen tila 7 miljardin parametrin mallilla ylittää suorituskyvyn Laama 2 13B kaikissa testeissä ja voittaa Llaman 1 34B monissa mittareissa.

Verrattuna muihin malleihin, kuten Llama 2:een, Mistral 7B tarjoaa samanlaisia tai parempia ominaisuuksia, mutta pienemmällä laskentateholla. Vaikka perusmallit, kuten GPT-4, voivat saavuttaa enemmän, ne ovat kalliimpia eivätkä yhtä käyttäjäystävällisiä, koska ne ovat pääasiassa käytettävissä API-rajapintojen kautta.

Mitä tulee koodaustehtäviin, Mistral 7B antaa CodeLlama 7B todellinen vastakkainasettelu. Lisäksi se on 13.4 Gt:n kokoinen ja riittävän kompakti toimimaan tavallisilla koneilla.

Lisäksi Mistral 7B Instruct, joka on viritetty erityisesti opetustietosarjoja varten Halaaminen kasvot, on osoittanut loistavaa suorituskykyä. Se ylittää muut MT-Benchin 7B-mallit ja seisoo rinta rinnan 13B chat-malleilla.

Halaavat kasvot Mistral 7B esimerkki

Suorituskyvyn vertailu

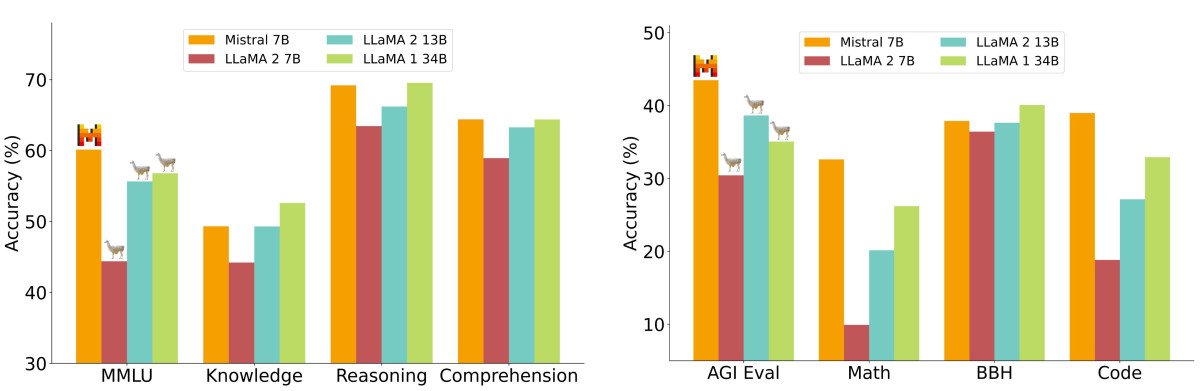

Yksityiskohtaisessa suorituskykyanalyysissä Mistral 7B mitattiin Llama 2 -perhemalleihin verrattuna. Tulokset olivat selvät: Mistral 7B ylitti huomattavasti Llama 2 13B:n kaikissa vertailuissa. Itse asiassa se vastasi Llama 34B:n suorituskykyä, erityisesti erottuaan koodin ja päättelyn vertailuarvoista.

Vertailuarvot jaettiin useisiin kategorioihin, kuten maalaisjärkinen päättely, maailman tuntemus, lukemisen ymmärtäminen, matematiikka ja koodaus. Erityisen huomionarvoinen havainto oli Mistral 7B:n kustannus-hyötysuhdemittari, jota kutsutaan "ekvivalentiksi mallikooksi". Päättelyn ja ymmärtämisen kaltaisilla osa-alueilla Mistral 7B osoitti suorituskykyä, joka oli lähes kolminkertainen Llama 2 -malliin verrattuna, mikä merkitsee potentiaalisia muistinsäästöjä ja suorituskyvyn kasvua. Tiedon vertailuarvoissa Mistral 7B oli kuitenkin läheisessä linjassa Llama 2 13B:n kanssa, mikä todennäköisesti johtuu sen parametrirajoituksista, jotka vaikuttavat tiedon pakkaamiseen.

Mikä todella tekee Mistral 7B -mallista paremman kuin useimmat muut kielimallit?

Huomiomekanismien yksinkertaistaminen

Vaikka huomiomekanismien hienoudet ovat teknisiä, niiden perusidea on suhteellisen yksinkertainen. Kuvittele lukevasi kirjaa ja korostaessasi tärkeitä lauseita; tämä on analogista tapaa, jolla huomiomekanismit "korostavat" tai antavat tärkeyden tietyille tietopisteille sarjassa.

Kielimallien yhteydessä nämä mekanismit mahdollistavat mallin keskittymisen syöttötiedon tärkeimpiin osiin, mikä varmistaa, että tulos on johdonmukainen ja kontekstuaalisesti tarkka.

Vakiomuuntajissa huomiopisteet lasketaan kaavalla:

Näiden pisteiden kaava sisältää ratkaisevan vaiheen – Q:n ja K:n matriisikertomisen. Haasteena tässä on, että sekvenssin pituuden kasvaessa molemmat matriisit laajenevat vastaavasti, mikä johtaa laskennallisesti intensiiviseen prosessiin. Tämä skaalautuvuusongelma on yksi tärkeimmistä syistä, miksi vakiomuuntajat voivat olla hitaita, erityisesti pitkien sekvenssien käsittelyssä.

Monikyselyanalysointi (MQA) nopeuttaa asioita käyttämällä yhtä avain-arvo-otsikkojoukkoa, mutta joskus se heikentää laatua. Saatat nyt miettiä, miksi ei yhdistäisi MQA:n nopeutta moniotsikkoanalysoinnin laatuun? Tässä kohtaa ryhmitelty kyselyanalysointi (GQA) astuu kuvaan.

Ryhmäkyselyn huomio (GQA)

GQA on kompromissiratkaisu. Yhden tai useamman avain-arvo-analyysipään sijaan se ryhmittelee ne. Tällä tavoin GQA saavuttaa suorituskyvyn, joka on lähellä yksityiskohtaista monipääanalyysiä, mutta MQA:n nopeudella. Mistralin kaltaisille malleille tämä tarkoittaa tehokasta suorituskykyä tinkimättä liikaa laadusta.

Liukuikkunan huomio (SWA)

Focus-patjan Liukuikkuna on toinen menetelmä, jota käytetään huomiojaksojen käsittelyssä. Tämä menetelmä käyttää kiinteän kokoista huomioikkunaa sarjan jokaisen merkin ympärillä. Kun useat kerrokset pinoavat tämän ikkunallisen huomion, ylimmät kerrokset saavat lopulta laajemman perspektiivin, joka kattaa tiedot koko syötteestä. Tämä mekanismi on analoginen konvoluutiohermoverkoissa (CNN) havaittujen vastaanottavien kenttien kanssa.

Toisaalta Longformer-mallin "laajentunut liukuvan ikkunan huomio", joka on käsitteellisesti samanlainen kuin liukuva ikkuna -menetelmä, laskee vain muutaman diagonaalin matriisi. Tämä muutos johtaa siihen, että muistin käyttö lisääntyy lineaarisesti pikemminkin kuin neliöllisesti, mikä tekee siitä tehokkaamman menetelmän pitkille sarjoille.

Mistralin tekoälyn läpinäkyvyys vs. turvallisuusongelmat hajauttamisessa

Ilmoituksessaan Mistral AI korosti myös läpinäkyvyyttä lausunnolla: "Ei temppuja, ei teollis- tai tekijänoikeudella suojattua dataa." Mutta samaan aikaan heidän ainoa tällä hetkellä saatavilla oleva mallinsa 'Mistral-7B-v0.1' on esikoulutettu perusmalli, joten se voi luoda vastauksen mihin tahansa kyselyyn ilman moderointia, mikä herättää mahdollisia turvallisuusongelmia. Vaikka malleilla, kuten GPT:llä ja Llamalla, on mekanismeja sen selvittämiseksi, milloin vastata, Mistralin täysin hajautettua luonnetta voisivat hyödyntää pahantahtoiset toimijat.

Suurten kielimallien hajauttamisella on kuitenkin puolensa. Vaikka jotkut saattavat käyttää sitä väärin, ihmiset voivat valjastaa sen voiman yhteiskunnan hyväksi ja tehdä älykkyydestä kaikkien saatavilla.

Käyttöönoton joustavuus

Yksi kohokohdista on, että Mistral 7B on saatavilla Apache 2.0 -lisenssillä. Tämä tarkoittaa, että sen käytölle ei ole todellisia esteitä – käytitpä sitä sitten henkilökohtaisiin tarkoituksiin, suuressa yrityksessä tai jopa valtion virastossa. Tarvitset vain oikean järjestelmän sen käyttämiseen tai saatat joutua investoimaan pilviresursseihin.

Vaikka on olemassa muitakin lisenssejä, kuten yksinkertaisempi MIT-lisenssi ja osuuskunta CC BY-SA-4.0, joka velvoittaa luottoja ja vastaavia lisenssejä johdannaisille, Apache 2.0 tarjoaa vankan perustan suurille yrityksille.

Tiivistelmä

Avoimen lähdekoodin suurten kielimallien, kuten Mistral 7B:n, nousu merkitsee käännekohtaista muutosta tekoälyalalla, sillä se tuo korkealaatuiset kielimallit laajemman yleisön saataville. Mistral AI:n innovatiiviset lähestymistavat, kuten ryhmiteltyjen kyselyiden huomio ja liukuvan ikkunan huomio, lupaavat tehokasta suorituskykyä laadusta tinkimättä.

Vaikka Mistralin hajautettu luonne asettaa tiettyjä haasteita, sen joustavuus ja avoimen lähdekoodin lisensointi korostavat mahdollisuuksia tekoälyn demokratisoimiseen. Maiseman kehittyessä painopiste on väistämättä näiden mallien tehon tasapainottamisessa eettisten näkökohtien ja turvallisuusmekanismien kanssa.

Mitä Mistralin seuraavaksi suunnittelee? 7B-malli oli vasta alkua. Tiimi pyrkii lanseeraamaan pian vielä suurempia malleja. Jos nämä uudet mallit vastaavat 7B:n suorituskykyä, Mistral saattaa nousta nopeasti alan huipputoimijaksi jo ensimmäisen toimintavuotensa aikana.