Andersons vinkel

Visuelle analogier til AI

Nuværende AI-modeller genkender ikke 'relationelle' billedligheder, såsom hvordan Jordens lag ligner en fersken, og overser dermed et centralt aspekt af, hvordan mennesker opfatter billeder.

Selvom der er mange computersyn modeller, der er i stand til at sammenligne billeder og finde ligheder mellem dem, har den nuværende generation af sammenligningssystemer ringe eller ingen fantasifuld kapacitet. Overvej nogle af teksterne i den klassiske sang fra 1960'erne, Dit sinds vindmøller:

Som en karrusel, der drejer rundt, løber i ringe rundt om månen

Som et ur, hvis visere fejer forbi minutterne på dets urskive

Og verden er som et æble, der hvirvler lydløst rundt i rummet

Sammenligninger af denne art repræsenterer et domæne af poetisk allusion, der er meningsfuldt for mennesker på en måde langt ud over kunstnerisk udtryk; snarere er det knyttet til, hvordan vi udvikler vores perceptuelle systemer; når vi skaber vores 'objekt'-domæne, udvikler vi et evne til visuel lighed, således at – for eksempel – tværsnit, der forestiller en fersken og planeten Jorden, eller fraktale rekursioner såsom kaffespiraler og galakseforgreninger, registrere som analog med os.

På denne måde kan vi udlede forbindelser mellem tilsyneladende uforbundne objekter og typer af objekter, og udledningssystemer (såsom tyngdekraft, momentum og overfladekohæsion), der kan anvendes på en række forskellige domæner på forskellige skalaer.

At se ting

Selv den nyeste generation af billedsammenlignings-AI-systemer, såsom Learned Perceptual Image Patch Similarity (LPIPS) og DINO, som er informeret af menneskelig feedback, udfører kun bogstavelige overfladesammenligninger.

Deres evne til at find ansigter, hvor ingen findes – dvs. pareidolia – repræsenterer ikke den slags visuelle lighedsmekanismer, som mennesker udvikler, men opstår snarere fordi ansigtssøgningsalgoritmer bruger lavniveau-ansigtsstruktur funktioner som nogle gange stemmer overens med tilfældige objekter:

Eksempler på falske positiver for ansigtsgenkendelse i datasættet 'Ansigter med ting'. Kilde

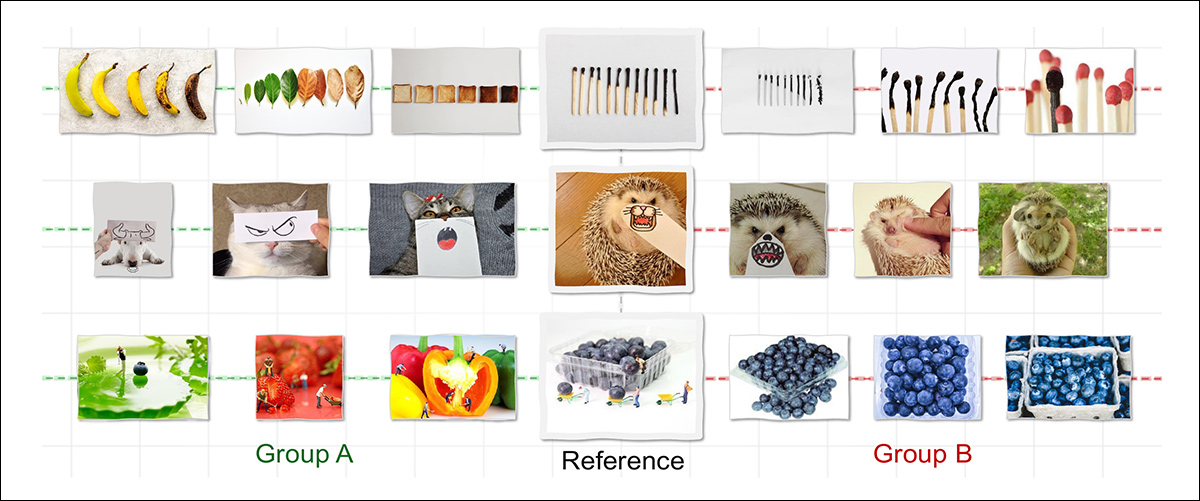

For at afgøre, om maskiner virkelig kan udvikle vores fantasifulde evne til at genkende visuel lighed på tværs af domæner, har forskere i USA udført en studere omkring Relationel visuel lighed, kuratering og træning af et nyt datasæt designet til at tvinge abstrakte relationer til at dannes mellem forskellige objekter, der ikke desto mindre er bundet af en abstrakt relation:

De fleste AI-modeller genkender kun lighed, når billeder deler overfladiske træk såsom form eller farve, hvilket er grunden til, at de kun ville forbinde Gruppe B (ovenfor) med referencen. Mennesker ser derimod også Gruppe A som ens – ikke fordi billederne ligner hinanden, men fordi de følger den samme underliggende logik, såsom at vise en transformation over tid. Det nye arbejde forsøger at reproducere denne form for strukturel eller relationel lighed med det formål at bringe maskinopfattelse tættere på menneskelig ræsonnement.. Kilde: https://arxiv.org/pdf/2512.07833

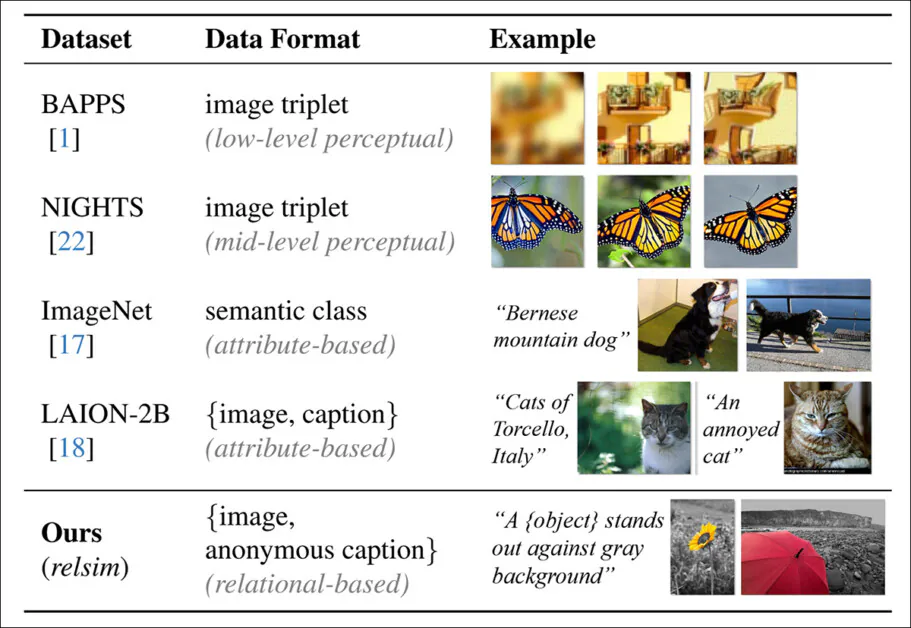

Tekstsystemet, der er udviklet til datasættet, muliggør usædvanligt abstrakte annotationer, der er designet til at tvinge AI-systemer til at fokusere på grundlæggende karakteristika snarere end specifikke lokale detaljer:

De forudsagte 'anonyme' billedtekster, der bidrager til forfatternes 'relsim'-måling.

Den kuraterede samling og dens usædvanlige billedtekststil giver næring til forfatternes nye foreslåede målestok relsim, som forfatterne har finjusteres ind i en visionssprogsmodel (VLM).

En sammenligning mellem billedtekststilen i typiske datasæt, som fokuserer på attributlighed, hvorimod relsim-tilgangen (nederste række) understreger relationel lighed.

Den nye tilgang trækker på metoder fra kognitiv videnskab, især Dedre Gentners Strukturkortlægningsteori (en undersøgelse af analogi) og Amos Tverskys definition af relationel lighed og attributlighed.

Fra det tilhørende projektwebsted, et eksempel på relationel lighed. Kilde

Forfatterne siger:

"[Mennesker] bearbejder attributlighed perceptuelt, men relationel lighed kræver konceptuel abstraktion, ofte understøttet af sprog eller forudgående viden. Dette antyder, at genkendelse af relationel lighed først kræver forståelse af billedet, trække på viden og abstrahere dets underliggende struktur."

nyt papir er titlen Relationel visuel lighed, og leveres med en projektets hjemmeside (se videoen indlejret i slutningen af denne artikel).

Metode

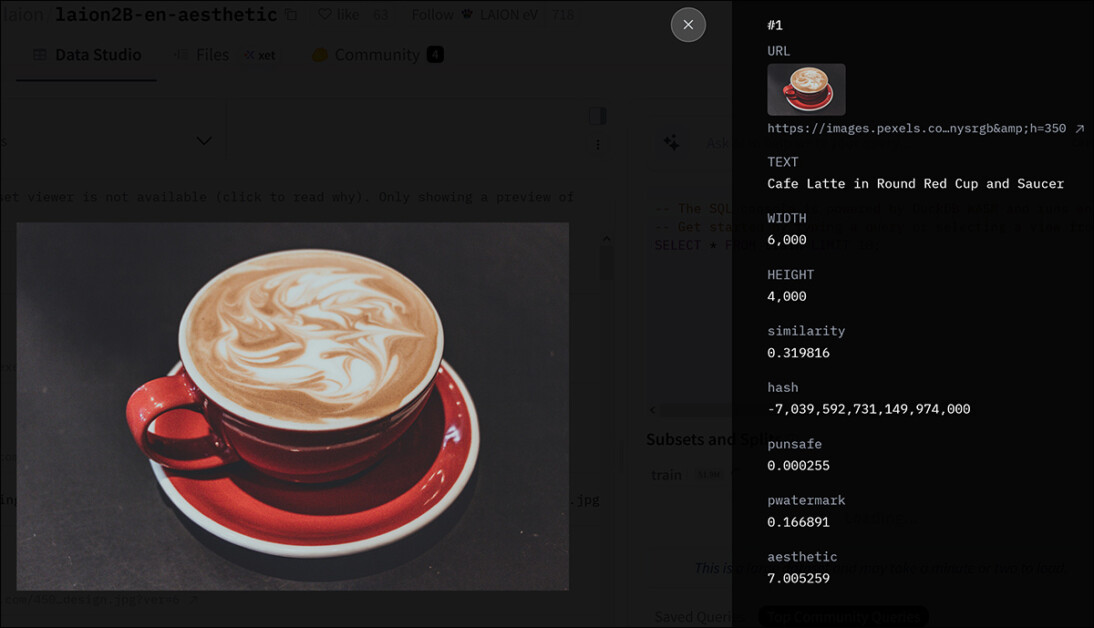

Forskerne brugte et af de mest kendte hyperskala-datasæt som udgangspunkt for deres egen samling – LAION-2B:

Metadata for en post i LAION-2B-samlingen. Kilde

114,000 billeder, der sandsynligvis indeholder elastiske relationelle strukturer, blev udtrukket fra LAION-2B, hvilket involverede filtrering af de mange billeder af lav kvalitet, der findes i det minimalt kuraterede datasæt.

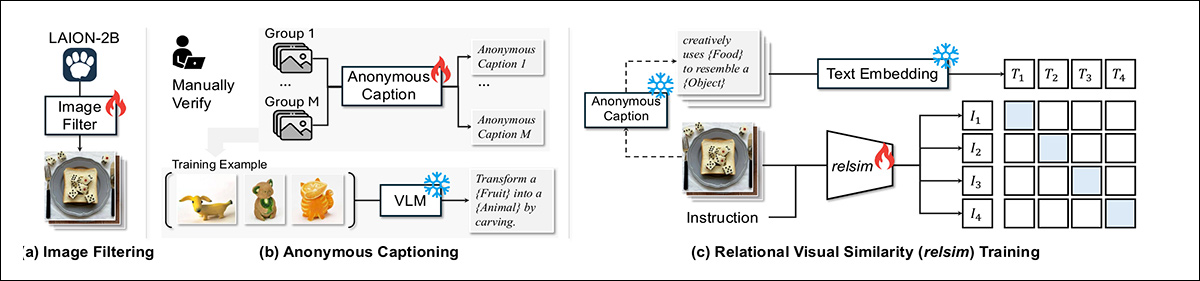

For at skabe en pipeline til denne udvælgelsesproces anvendte forfatterne Qwen2.5-VL-7B, der udnytter 1,300 positive og 11,000 negative eksempler, der er mærket med mennesker:

Relsim-systemet trænes i tre faser: filtrering af billeder fra LAION-2B for relationelt indhold; tildeling af hver gruppe en delt anonym billedtekst, der indfanger deres underliggende logik; og læring af at matche billeder med disse billedtekster ved hjælp af et kontrasttab.

Papiret siger:

"Annotatorerne blev instrueret: "Kan I se et relationelt mønster, en logik eller en struktur i dette billede, der kunne være nyttig til at oprette eller linke til et andet billede?". Den finjusterede model opnår 93 % overensstemmelse med menneskelige vurderinger, og når den anvendes på LAION-2B, giver den N = 114k billeder identificeret som relationelt interessante."

For at generere relationelle etiketter, fik forskerne Qwen-modellen til at beskrive den fælles logik bag sæt af billeder uden at navngive specifikke objekter. Denne abstraktion var vanskelig at opnå, når modellen kun så ét billede, men blev brugbar, når flere eksempler demonstrerede det underliggende mønster.

De resulterende billedtekster på gruppeniveau erstattede specifikke termer med pladsholdere som f.eks. '{Emne}' or '{Bevægelsestype}', hvilket gør dem bredt anvendelige.

Efter menneskelig verifikation blev hver billedtekst parret med alle billeder i sin gruppe. Mere end 500 sådanne grupper blev brugt til at træne modellen, som derefter blev anvendt på de 114,000 filtrerede billeder for at producere et stort sæt af abstrakte, relationelt annoterede eksempler.

Data og test

Efter udtrækning af relationelle funktioner med Qwen2.5-VL-7B blev en model finjusteret på dataene ved hjælp af LoRA, for 15,000 trin, via otte A100 GPU'er*. For tekstsiden blev relationelle billedtekster integreret ved hjælp af alle-MiniLM-L6-v2 fra Sætningstransformatorer-bibliotek.

Datasættet med 114,000 billeder med billedtekster var delt til 100,000 til træning og 14,000 til evaluering. For at teste systemet blev der anvendt en hentningsopsætning: givet et forespørgselsbillede skulle modellen finde et andet billede fra en pulje med 28,000 elementer, der udtrykte den samme relationelle idé. Hentningspuljen omfattede 14,000 evalueringsbilleder og 14,000 yderligere prøver fra LAION-2B, med 1,000 forespørgsler tilfældigt udvalgt fra evalueringssættet til benchmarking.

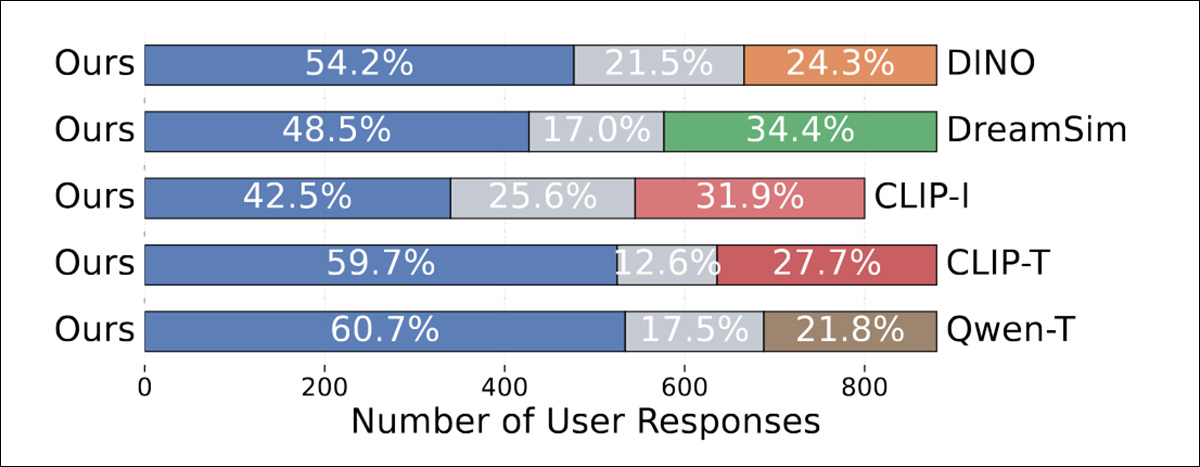

For at evaluere kvaliteten af genfindingen, GPT-4o blev brugt til at score den relationelle lighed mellem hver forespørgsel og det hentede billede på en skala fra 0 til 10. En separat menneskelig undersøgelse blev også udført for at måle brugerpræferencer (se nedenfor).

Hver deltager fik vist et anonymiseret forespørgselsbillede med to kandidater, den ene hentet ved hjælp af den foreslåede metode, den anden ved hjælp af en baseline. Deltagerne blev spurgt, hvilket billede der var mest relationelt lig forespørgslen, eller om begge var lige så tætte. For hver baseline blev 300 tripletter oprettet og bedømt af mindst tre personer hver, hvilket gav omkring 900 svar.

Relsim-tilgangen blev sammenlignet med adskillige etablerede billede-til-billede-lighedsmetoder, herunder de førnævnte LPIPS og DINO, samt drømmesimog CLIP-IUd over baselines, der direkte beregner lighedsscorer mellem billedpar, såsom LPIPS, DINO, dreamsim og CLIP-I, testede forfatterne også billedtekstbaserede metoder, hvor Qwen blev brugt til at generere en anonym eller abstrakt billedtekst for hvert billede; dette fungerede derefter som hentningsforespørgsel.

To hentningsvarianter blev evalueret, med CLIP-baseret tekst-til-billede-hentning (CLIP-T) brugt til tekst-til-billede-hentning, og Qwen-T brugte tekst-til-tekst-hentning. Begge billedtekstbaserede basislinjer brugte den originale prætrænede Qwen-model i stedet for den version, der var finjusteret på relationel logik. Dette gjorde det muligt for forfatterne at isolere effekten af gruppebaseret træning, da den finjusterede model havde været eksponeret for billedsæt i stedet for isolerede eksempler.

Eksisterende metrikker og relationel lighed

Forfatterne testede indledningsvis, om eksisterende målinger kunne indfange relationel lighed:

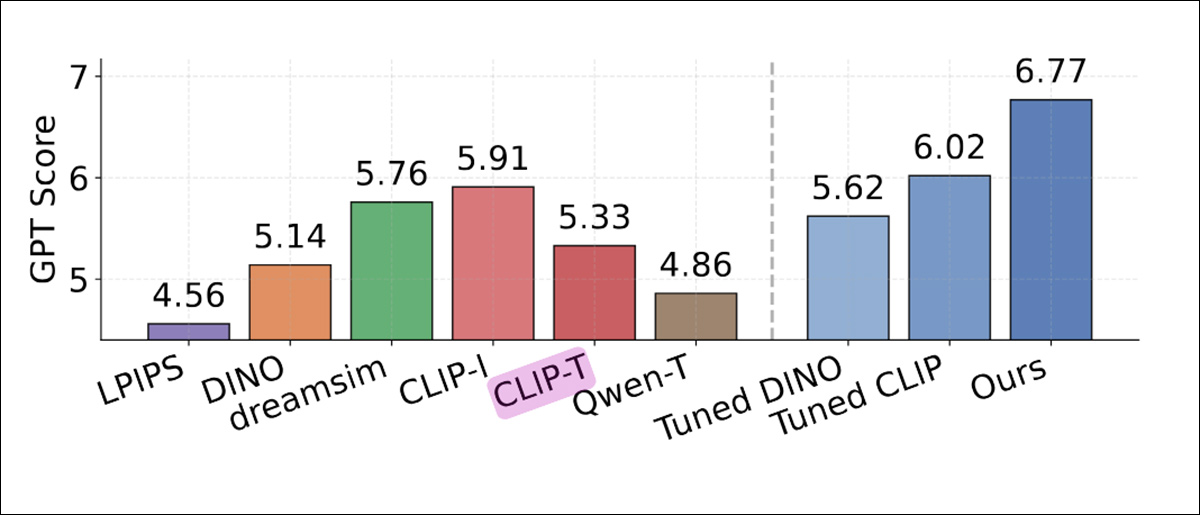

Sammenligning af hentningspræstation bedømt af GPT-4o, der viser den gennemsnitlige relationelle lighedsscore for hver metode. Konventionelle lighedsmålinger som LPIPS, DINO og CLIP-I scorede lavere. Billedtekstbaserede baselines Qwen-T og CLIP-T klarede sig også dårligere. Den højeste score blev opnået af relsim (6.77, yderst til højre, blå kolonne), hvilket indikerer, at finjustering af gruppebaserede relationelle mønstre forbedrede overensstemmelsen med GPT-4o's vurderinger.

Forfatterne angiver følgende vedrørende disse resultater:**

'[LPIPS], som udelukkende fokuserer på perceptuel lighed, opnår den laveste score (4.56). [DINO] klarer sig kun en smule bedre (5.14), sandsynligvis fordi den udelukkende trænes på en selvovervåget måde på billeddata. [CLIP-I] giver de stærkeste resultater blandt basislinjerne (5.91), formodentlig fordi der nogle gange er en vis abstraktion til stede i billedtekster.'

"CLIP-I klarer sig dog stadig dårligere i forhold til vores metode, da opnåelse af en bedre score kan kræve evnen til at nå abstraktioner på endnu højere niveauer, såsom dem i anonyme billedtekster."

I brugerundersøgelsen foretrak mennesker konsekvent relsim-metoden på tværs af alle baselines:

Relationelle lighedsscorer tildelt af GPT-4o for hver metode. Standardlighedsmålinger som LPIPS, DINO og CLIP-I scorede lavere, og de billedtekstbaserede varianter Qwen-T og CLIP-T klarede sig kun en smule bedre. Selv de justerede versioner af DINO og CLIP lukkede ikke forskellen. Den højeste score, 6.77, blev opnået med relsim-modellen, trænet med gruppebaseret supervision.

Forfatterne bemærker:

"Dette er meget opmuntrende, da det ikke blot viser, at vores model, relsim, kan med succes hente relationelt lignende billeder, men bekræfter også igen, at mennesker opfatter relationel lighed – ikke kun attributlighed!

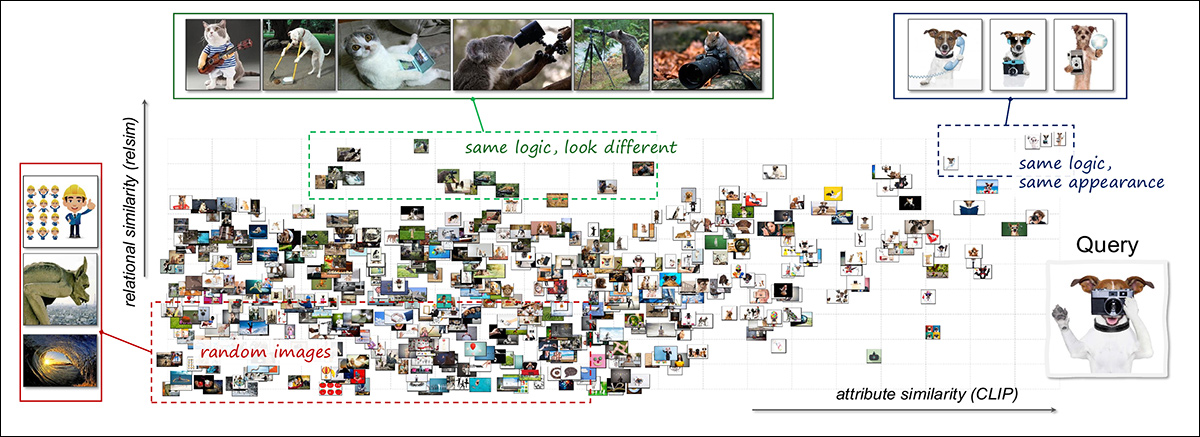

For at undersøge, hvordan relationel og attributligner kan supplere hinanden, brugte forskerne en kombineret visualiseringsmetode. Et enkelt forespørgselsbillede (En hund, der holder et kamera) blev sammenlignet med 3,000 tilfældige billeder, og ligheden blev beregnet ved hjælp af både relationelle og attributbaserede modeller:

Fælles visualisering af visuelt lighedsrum ved hjælp af relationelle og attributakser. Et enkelt forespørgselsbillede, der viser en hund, der bruger et kamera, blev sammenlignet med 3,000 andre. Resultaterne blev organiseret efter relationel lighed (lodret) og attributlighed (horisontal). Området øverst til højre indeholder billeder, der ligner forespørgslen både i logik og udseende, såsom andre hunde, der bruger værktøjer. Øverst til venstre indeholder semantisk relaterede, men visuelt forskellige tilfælde, såsom forskellige dyr, der udfører kamerarelaterede handlinger. De fleste resterende eksempler grupperes længere nede i rummet, hvilket afspejler svagere lighed. Layoutet illustrerer, hvordan relationelle og attributmodeller fremhæver komplementære aspekter af visuelle data. Se kildeartiklen for bedre opløsning.

Resultaterne afslørede klynger svarende til forskellige typer lighed: nogle billeder var både relationelt og visuelt ens, såsom andre hunde i menneskelignende positurer; andre delte relationel logik, men ikke udseende, såsom forskellige dyr, der efterlignede menneskelige handlinger; resten viste ingen af delene.

Denne analyse tyder på, at de to lighedstyper tjener forskellige roller og giver en rigere struktur, når de kombineres.

Brug cases

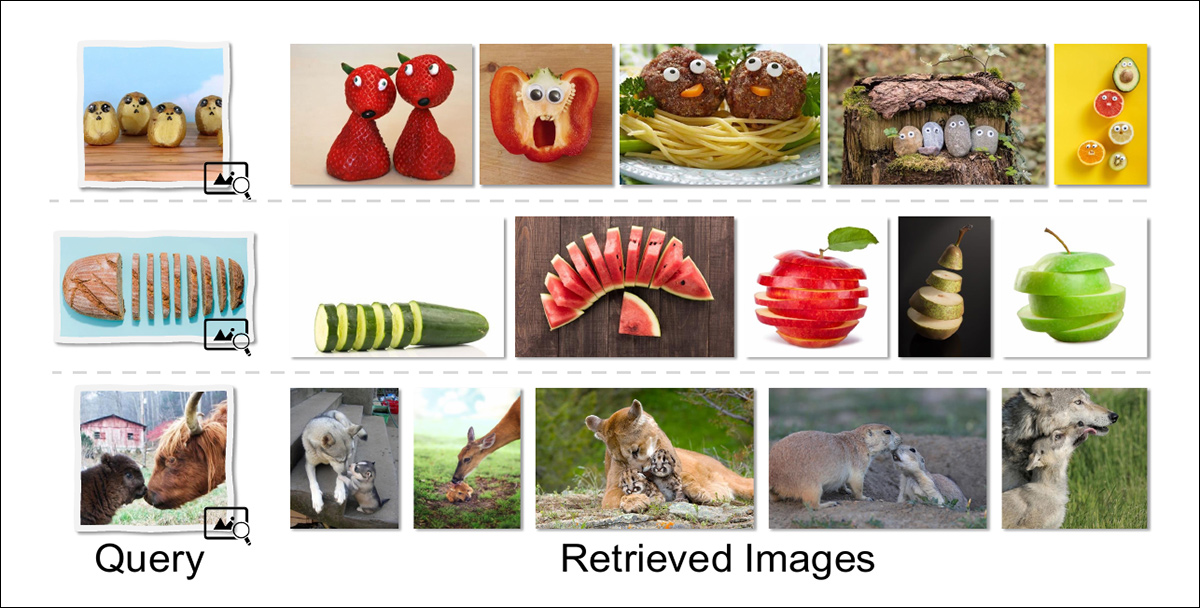

Artiklen undersøger også nogle mulige slutanvendelsesscenarier for relationel lighed, herunder relationel billedhentning, hvilket muliggør billedsøgning, der er mere i overensstemmelse med menneskers egen kreative måde at se verden på:

Relationel hentning returnerer billeder, der deler en dybere konceptuel struktur med forespørgslen, snarere end matchende overfladefunktioner. For eksempel henter en fødevare, der er designet til at ligne et ansigt, andre antropomorfe måltider; et skåret objekt giver andre skårne former; og scener med interaktion mellem voksen og afkom returnerer billeder med lignende relationelle roller, selvom art og sammensætning er forskellige.

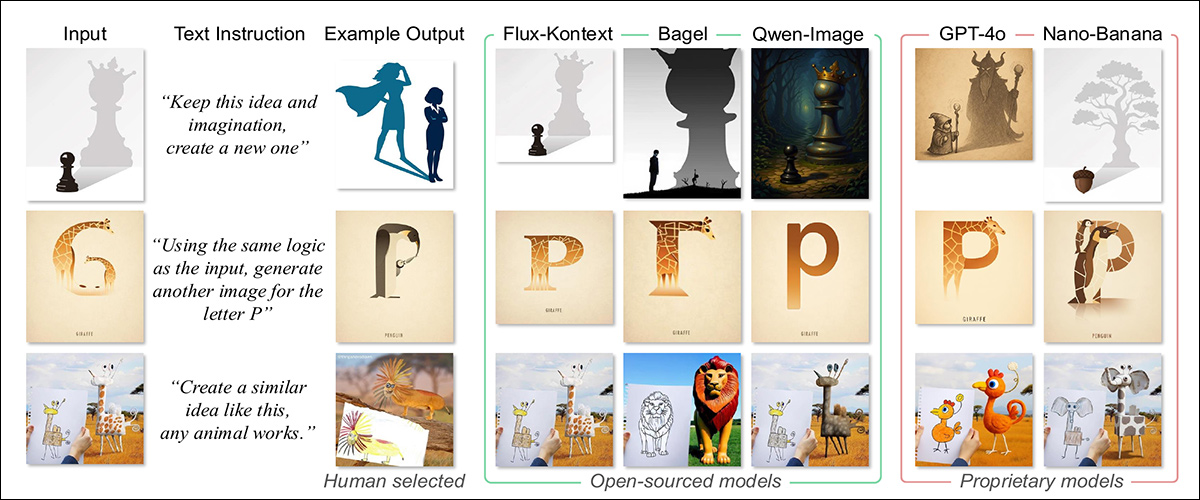

En anden mulighed er analog billedgenerering, hvilket ville muliggøre syntese af forespørgsler, der bruger relationelle strukturer snarere end direkte beskrivelser. I en sammenligning af resultater opnået fra den nuværende generation af avancerede tekst-til-billede-modeller kan vi se, at resultaterne af en sådan tilgang sandsynligvis vil være mere forskelligartede:

Givet et inputbillede og en relationel prompt blev modellerne bedt om at generere et nyt billede, der udtrykte det samme underliggende koncept. Proprietære modeller producerede mere trofaste analogier, der bevarede strukturel logik på tværs af store ændringer i form, mens open source-modeller havde en tendens til at regredere til bogstavelige eller stilistiske matches og ikke formåede at overføre den dybere idé. Output blev sammenlignet med menneskeligt kuraterede analogier, som eksemplificerede den tilsigtede transformation.

Konklusion

Generative AI-systemer ville tilsyneladende blive markant forbedret af en evne til at inkorporere abstrakt repræsentation i deres konceptualiseringer. Som det ser ud nu, har det en tendens til at returnere billeder, der er designet ud fra de mest populære eller folkerige billeder, der havde disse associationer i datasættet; udenadslære snarere end abstraktion.

Formentlig kunne dette princip være endnu mere gavnligt, hvis det kunne anvendes på generativ skrivning – især analytisk, spekulativ eller fiktiv output.

Tryk for at afspille. Kilde

* En A100 kan have 40 GB eller 80 GB VRAM; dette er ikke specificeret i dokumentet.

** Forfattercitater er overflødige og udeladt.

Først offentliggjort tirsdag den 16. december 2025