Искусственный интеллект

Стабильная диффузия видео: модели скрытой диффузии видео для больших наборов данных

Генеративный ИИ уже некоторое время является движущей силой в сообществе искусственного интеллекта, а достижения, достигнутые в области генеративного моделирования изображений, особенно с использованием моделей диффузии, помогли генеративным видеомоделям значительно продвинуться не только в исследованиях, но и с точки зрения приложения реального мира. Обычно генеративные видеомодели либо обучаются с нуля, либо частично или полностью настраиваются на основе предварительно обученных моделей изображений с дополнительными временными слоями на смеси наборов изображений и видеоданных.

Развивая достижения в области генеративных видеомоделей, в этой статье мы поговорим о Стабильная модель диффузии видео, модель скрытой диффузии видео, способная генерировать современное изображение с высоким разрешением в видео и текст в видеоконтент. Мы поговорим о том, как модели скрытой диффузии, обученные для синтеза 2D-изображений, улучшили возможности и эффективность генеративных видеомоделей за счет добавления временных слоев и точной настройки моделей на небольших наборах данных, состоящих из высококачественных видео. Мы более глубоко погрузимся в архитектуру и работу модели стабильного распространения видео, оценим ее производительность по различным показателям и сравним ее с современными платформами для создания видео. Итак, давайте начнем.

Стабильная модель диффузии видео и генеративные видеомодели: введение

Благодаря своему почти неограниченному потенциалу, генеративный ИИ уже некоторое время является основным предметом исследований для практиков ИИ и МО, и за последние несколько лет наблюдался быстрый прогресс как с точки зрения эффективности, так и производительности генеративных моделей изображений. Результаты генеративных моделей изображений позволили исследователям и разработчикам добиться прогресса в области генеративных видеомоделей, что привело к повышению их практичности и практическому применению. Однако большинство исследований, пытающихся улучшить возможности генеративных видеомоделей, сосредоточены в первую очередь на точном расположении временных и пространственных слоев, при этом мало внимания уделяется изучению влияния выбора правильных данных на результаты этих генеративных моделей.

Благодаря прогрессу, достигнутому в области генеративных моделей изображений, исследователи заметили, что влияние распределения обучающих данных на производительность генеративных моделей действительно существенно и неоспоримо. Кроме того, исследователи также заметили, что предварительная подготовка модели генеративного изображения на большом и разнообразном наборе данных с последующей ее точной настройкой на меньшем наборе данных с лучшим качеством часто приводит к значительному повышению производительности. Традиционно генеративные видеомодели реализуют знания, полученные от успешных генеративных моделей изображений, и исследователям еще предстоит изучить влияние данных, а стратегии обучения еще предстоит изучить. Модель стабильного распространения видео — это попытка расширить возможности генеративных видеомоделей, отправившись на ранее неизведанные территории, уделяя особое внимание выбору данных.

Последние модели генеративного видео основаны на моделях диффузии и подходах к обработке текста или изображения для синтеза нескольких согласованных кадров видео или изображения. Модели диффузии известны своей способностью обучаться постепенному уменьшению шума в выборке из нормального распределения путем реализации итеративного процесса уточнения, и они дают желаемые результаты при воспроизведении видео высокого разрешения и синтезе текста в изображение. Используя тот же принцип в своей основе, модель стабильной диффузии видео обучает скрытую модель диффузии видео на своем наборе видеоданных, а также использует генеративно-состязательные сети или GAN и даже в некоторой степени авторегрессионные модели.

Модель стабильного распространения видео следует уникальной стратегии, никогда не реализуемой ни одной генеративной видеомоделью, поскольку она опирается на скрытые базовые показатели распространения видео с фиксированной архитектурой и фиксированную стратегию обучения, за которой следует оценка эффекта обработки данных. Модель стабильного распространения видео призвана внести следующий вклад в область генеративного видеомоделирования.

- Представить систематический и эффективный рабочий процесс обработки данных в попытке превратить большую коллекцию непроверенных образцов видео в высококачественный набор данных, который затем будет использоваться генеративными видеомоделями.

- Обучить современные модели изображения видео и текста видео, которые превосходят существующие платформы.

- Проведение экспериментов в конкретной области для проверки понимания 3D и четкого определения движения модели.

Теперь модель стабильного распространения видео реализует знания, полученные на основе моделей скрытого распространения видео, и методов курирования данных, лежащих в основе ее основы.

Скрытые модели диффузии видео

Модели скрытой диффузии видео или Video-LDM следуют подходу обучения первичной генеративной модели в скрытом пространстве с уменьшенной вычислительной сложностью, и большинство Video-LDM реализуют предварительно обученную модель преобразования текста в изображение в сочетании с добавлением слоев временного смешивания в предварительном обучении. архитектура. В результате большинство моделей скрытой диффузии видео либо обучают только временные слои, либо вообще пропускают процесс обучения, в отличие от модели стабильной диффузии видео, которая точно настраивает всю структуру. Кроме того, для синтеза текста в видеоданные модель стабильного распространения видео напрямую зависит от текстового запроса, и результаты показывают, что полученную структуру можно легко настроить для синтеза нескольких представлений или модели изображения в видео.

Курирование данных

Курирование данных является важным компонентом не только модели стабильного распространения видео, но и генеративных моделей в целом, поскольку важно предварительно обучать большие модели на крупномасштабных наборах данных для повышения производительности при выполнении различных задач, включая языковое моделирование или распознавание текста в изображениях. , и многое другое. Курирование данных было успешно реализовано в генеративных моделях изображений за счет использования возможностей эффективных языковых представлений изображений, хотя такие обсуждения никогда не были сосредоточены на разработке генеративных видеомоделей. Разработчики сталкиваются с несколькими препятствиями при сборе данных для генеративных видеомоделей, и для решения этих проблем модель стабильного распространения видео реализует трехэтапную стратегию обучения, что приводит к улучшению результатов и значительному повышению производительности.

Курирование данных для синтеза высококачественного видео

Как обсуждалось в предыдущем разделе, модель стабильного распространения видео реализует трехэтапную стратегию обучения, что приводит к улучшению результатов и значительному повышению производительности. I этап представляет собой предварительная подготовка изображения этап, на котором используется модель распространения 2D-текста в изображение. II этап предназначен для видео предварительной подготовки в котором фреймворк обучается на большом объеме видеоданных. Наконец, у нас есть стадия III для точная настройка видео в котором модель уточняется на небольшом наборе видео высокого качества и высокого разрешения.

Однако прежде чем модель стабильного распространения видео реализует эти три этапа, крайне важно обработать и аннотировать данные, поскольку они служат основой для этапа II или этапа предварительной подготовки видео и играют решающую роль в обеспечении оптимального результата. Чтобы обеспечить максимальную эффективность, платформа сначала реализует каскадный конвейер обнаружения обрезаний на трех различных уровнях FPS или кадров в секунду, и необходимость этого конвейера продемонстрирована на следующем изображении.

Затем модель стабильного распространения видео аннотирует каждый видеоклип, используя три различных метода синтетических субтитров. В следующей таблице сравниваются наборы данных, используемые в Stable Diffusion Framework до и после процесса фильтрации.

Этап I: Предварительная тренировка изображения

Первым этапом трехэтапного конвейера, реализованного в модели стабильного распространения видео, является предварительное обучение изображения, и для достижения этого первоначальная структура модели стабильного распространения видео основана на предварительно обученной модели распространения изображения, а именно Стабильная диффузия 2.1 модель, которая снабжает ее более сильными визуальными представлениями.

Этап II: Предварительное видео-обучение

Второй этап — это этап предварительного обучения видео, и он основан на выводах о том, что использование курирования данных в мультимодальных генеративных моделях изображений часто приводит к лучшим результатам и повышению эффективности наряду с мощной дискриминационной генерацией изображений. Однако из-за отсутствия аналогичных мощных готовых представлений для фильтрации нежелательных выборок для генеративных видеомоделей модель стабильного распространения видео полагается на человеческие предпочтения в качестве входных сигналов для создания соответствующего набора данных, используемого для предварительного обучения структуры. На следующем рисунке показан положительный эффект предварительного обучения платформы на тщательно подобранном наборе данных, который помогает повысить общую производительность предварительного обучения видео на небольших наборах данных.

Если быть более конкретным, платформа использует различные методы для управления подмножествами скрытой видеодиффузии и учитывает ранжирование моделей LVD, обученных на этих наборах данных. Кроме того, фреймворк Stable Video Diffusion также обнаружил, что использование тщательно подобранных наборов данных для обучения фреймворков помогает повысить производительность фреймворка и моделей распространения в целом. Более того, стратегия курирования данных также работает с более крупными, релевантными и практичными наборами данных. На следующем рисунке показан положительный эффект предварительного обучения платформы на тщательно подобранном наборе данных, который помогает повысить общую производительность предварительного обучения видео на небольших наборах данных.

Этап III: Качественная тонкая настройка

До этапа II платформа Stable Video Diffusion фокусируется на повышении производительности перед предварительной тренировкой видео, а на третьем этапе платформа уделяет особое внимание оптимизации или дальнейшему повышению производительности платформы после тонкой настройки видео высокого качества и тому, как переход от этапа II к этапу III осуществляется в рамках. На этапе III структура использует методы обучения, заимствованные из моделей диффузии скрытых изображений, и увеличивает разрешение обучающих примеров. Чтобы проанализировать эффективность этого подхода, фреймворк сравнивает его с тремя идентичными моделями, которые отличаются только условиями инициализации. У первой идентичной модели инициализируются веса, и процесс видеообучения пропускается, тогда как оставшиеся две идентичные модели инициализируются с весами, заимствованными из других скрытых видеомоделей.

Результаты и выводы

Пришло время взглянуть на то, как фреймворк Stable Video Diffusion справляется с реальными задачами и как он соотносится с современными фреймворками. Фреймворк Stable Video Diffusion сначала использует оптимальный подход к данным для обучения базовой модели, а затем выполняет тонкую настройку для генерации нескольких современных моделей, каждая из которых выполняет определённую задачу.

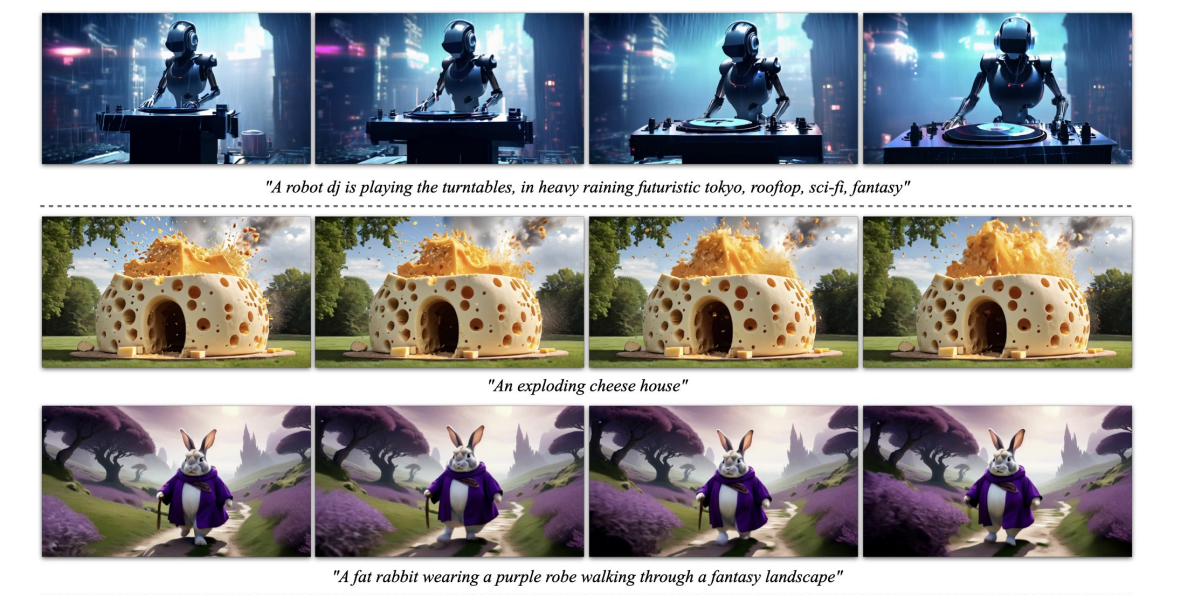

На изображении выше представлены образцы изображения с высоким разрешением в видео, созданные платформой, тогда как следующий рисунок демонстрирует способность платформы генерировать высококачественный текст в образцы видео.

Предварительно обученная база MОдел

Как обсуждалось ранее, модель Stable Video Diffusion построена на базе Stable Video Diffusion 2.1, и на основе недавних результатов разработчикам было крайне важно принять график шума и увеличить шум для получения изображений с лучшим разрешением при обучении диффузии изображений. модели. Благодаря этому подходу базовая модель Stable Video Diffusion изучает мощные представления движения и при этом превосходит базовые модели для текст к генерация видео с настройкой нулевого кадра, результаты показаны в следующей таблице.

Интерполяция кадров и генерация нескольких представлений

Платформа Stable Video Diffusion настраивает изображение на видеомодель в наборах данных с несколькими представлениями для получения нескольких новых видов объекта, и эта модель известна как SVD-MV или модель Stable Video Diffusion- Multi View. Исходная модель SVD настраивается с помощью двух наборов данных таким образом, что платформа вводит одно изображение и возвращает в качестве выходных данных последовательность изображений с несколькими представлениями.

Как видно на следующих изображениях, платформа Stable Video Diffusion Multi View обеспечивает высокую производительность, сравнимую с современной платформой Scratch Multi View, а результаты являются наглядной демонстрацией способности SVD-MV использовать полученные знания. из оригинальной структуры SVD для создания многопросмотровых изображений. Кроме того, результаты также показывают, что запуск модели за относительно меньшее количество итераций помогает получить оптимальные результаты, как и в случае с большинством моделей, точно настроенных с помощью структуры SVD.

На приведенном выше рисунке метрики указаны слева, и, как видно, платформа Stable Video Diffusion Multi View с приличным отрывом превосходит платформу Scratch-MV и SD2.1 Multi-View. Второе изображение демонстрирует влияние количества итераций обучения на общую производительность платформы с точки зрения Clip Score, а платформы SVD-MV обеспечивают устойчивые результаты.

Заключение

В этой статье мы говорили о Stable Video Diffusion, скрытой модели распространения видео, способной генерировать современное изображение с высоким разрешением в видео и текст в видеоконтент. Модель стабильного распространения видео следует уникальной стратегии, никогда не реализуемой ни одной генеративной видеомоделью, поскольку она опирается на скрытые базовые показатели распространения видео с фиксированной архитектурой и фиксированную стратегию обучения, за которой следует оценка эффекта обработки данных.

Мы говорили о том, как модели скрытой диффузии, обученные синтезировать 2D-изображения, улучшили возможности и эффективность генеративные видеомодели путем добавления временных слоев и точной настройки моделей на небольших наборах данных, состоящих из высококачественных видео. Чтобы собрать данные перед обучением, платформа проводит исследование масштабирования и следует практикам систематического сбора данных и, в конечном итоге, предлагает метод обработки большого количества видеоданных и преобразует шумные видео во входные данные, подходящие для генеративных видеомоделей.

Кроме того, платформа Stable Video Diffusion использует три отдельных этапа обучения видеомодели, которые анализируются независимо для оценки их влияния на производительность платформы. В конечном итоге инфраструктура выводит видеопредставление, достаточно мощное для точной настройки моделей для оптимального синтеза видео, а результаты сопоставимы с уже используемыми современными моделями генерации видео.