Угол Андерсона

Переосмысление видеообучения ИИ с использованием данных, ориентированных на пользователя

Тип контента, который пользователи могут захотеть создать с помощью генеративной модели, такой как Поток or Видео Хуньюань не всегда может быть легкодоступен, даже если запрос контента довольно общий, и можно предположить, что генератор сможет с ним справиться.

Один из примеров, проиллюстрированный в новой статье, которую мы рассмотрим в этой статье, показывает, что все более затмеваемая модель OpenAI Sora испытывает некоторые трудности с визуализацией анатомически правильного светлячка, используя подсказку «Тихой летней ночью на травинке светится светлячок».:

У Соры из OpenAI немного странное понимание анатомии светлячков. Источник: https://arxiv.org/pdf/2503.01739

Поскольку я редко принимаю научные заявления за чистую монету, я протестировал сегодня ту же подсказку на Sora и получил немного лучший результат. Однако Sora все еще не смог правильно отобразить свечение — вместо того, чтобы осветить кончик хвоста светлячка, где происходит биолюминесценция, он переместил свечение около ног насекомого:

Мой собственный тест подсказки исследователей в Sora дал результат, который показывает, что Sora не понимает, откуда на самом деле берется свет светлячка.

Как ни странно, Adobe Firefly Генеративному движку диффузии, обученному на защищенных авторским правом стоковых фотографиях и видео компании, удалось добиться успеха лишь в 1 случае из 3, когда я попытался выполнить ту же подсказку в функции генеративного ИИ Photoshop:

Только последнее из трех предложенных исследователями поколений вообще создает свечение в Adobe Firefly (март 2025 г.), хотя, по крайней мере, свечение расположено в правильной части анатомии насекомого.

Исследователи новой статьи привели этот пример, чтобы проиллюстрировать, что распределение, акцент и охват обучающих наборов, используемых для информирования популярных базовых моделей, могут не соответствовать потребностям пользователя, даже если пользователь не запрашивает ничего особенно сложного. Эта тема поднимает проблемы, связанные с адаптацией гипермасштабных обучающих наборов данных к их наиболее эффективным и результативным результатам в качестве генеративных моделей.

Авторы заявляют:

«[Sora] не может уловить концепцию светящегося светлячка, успешно генерируя траву и летнюю [ночь]. С точки зрения данных, мы заключаем, что это в основном связано с тем, что [Sora] не обучалась темам, связанным со светлячками, хотя и обучалась по темам, связанным со светлячками. Более того, если бы [Sora] посмотрела видео, показанное на [изображении выше], она бы поняла, как должен выглядеть светящийся светлячок».

Они представляют недавно отобранный набор данных и предполагают, что их методологию можно будет усовершенствовать в будущей работе для создания наборов данных, которые будут лучше соответствовать ожиданиям пользователей, чем многие существующие модели.

Данные для людей

По сути, их предложение предлагает подход к курированию данных, который находится где-то между пользовательскими данными для типа модели, например ЛоРА (и этот подход слишком специфичен для общего использования); а также широкий и относительно неизбирательный коллекции большого объема (такой как Laion набор данных, поддерживающий Stable Diffusion), которые конкретно не привязаны к какому-либо сценарию конечного использования.

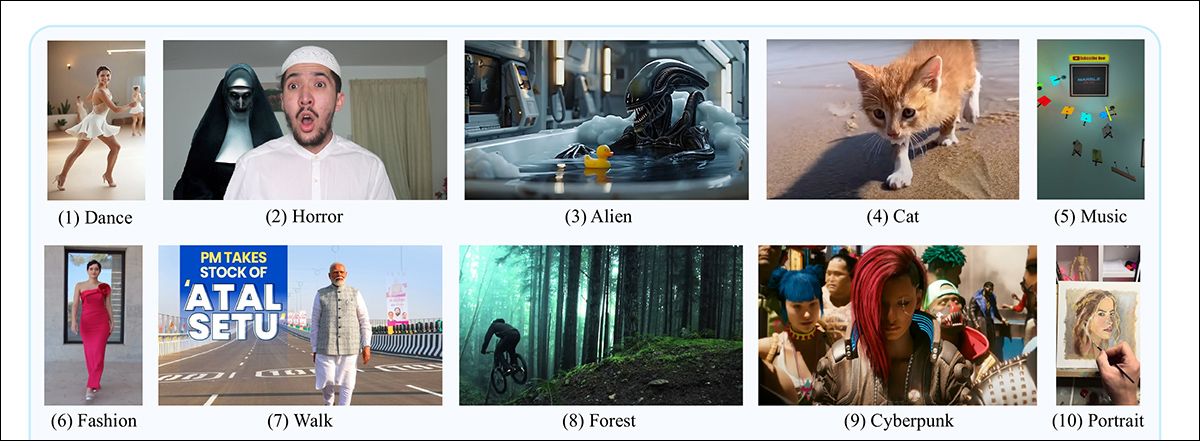

Новый подход, как методология и новый набор данных, (довольно извилисто) назван Внимание пользователей при преобразовании текста в видео или ВидеоUFO. Набор данных VideoUFO содержит 1.9 миллиона видеоклипов, охватывающих 1291 тему, ориентированную на пользователя. Сами темы были тщательно разработаны на основе существующего набора видеоданных и проанализированы с помощью различных языковых моделей и методов обработки естественного языка (NLP):

Примеры основных тем, представленных в новой статье.

Набор данных VideoUFO содержит большой объем новых видеороликов, найденных на YouTube. «Новых» в том смысле, что рассматриваемые видеоролики не встречаются в наборах видеоданных, которые в настоящее время популярны в литературе, и, следовательно, во многих подмножествах, которые были отобраны из них (и многие из видеороликов были фактически загружены после создания более старых наборов данных, упомянутых в статье).

На самом деле, авторы утверждают, что существует только 0.29% совпадают с существующими наборами видеоданных – впечатляющая демонстрация новизны.

Одной из причин этого может быть то, что авторы принимают только видеоролики YouTube с лицензией Creative Commons, которая с меньшей вероятностью будет создавать неудобства для пользователей в дальнейшем: возможно, эта категория видеороликов была менее приоритетной в предыдущих проверках YouTube и других массовых платформ.

Во-вторых, видео были запрошены на основе заранее оцененных потребностей пользователя (см. изображение выше), а не беспорядочно просмотрены. Эти два фактора в сочетании могли привести к такой новой коллекции. Кроме того, исследователи проверили идентификаторы YouTube всех участвующих видео (т. е. видео, которые могли быть позже разделены и переосмыслены для коллекции VideoUFO) по отношению к тем, которые представлены в существующих коллекциях, что подтверждает достоверность заявления.

Хотя не все в новой статье столь же убедительно, это интересное чтиво, которое подчеркивает, в какой степени мы все еще зависим от неравномерного распределения в наборах данных с точки зрения препятствий, с которыми часто сталкиваются исследователи при курировании наборов данных.

Команда новая работа называется VideoUFO: ориентированный на пользователя набор данных для генерации текста в видео в масштабе миллионаи исходит от двух исследователей, соответственно из Сиднейского технологического университета в Австралии и Чжэцзянского университета в Китае.

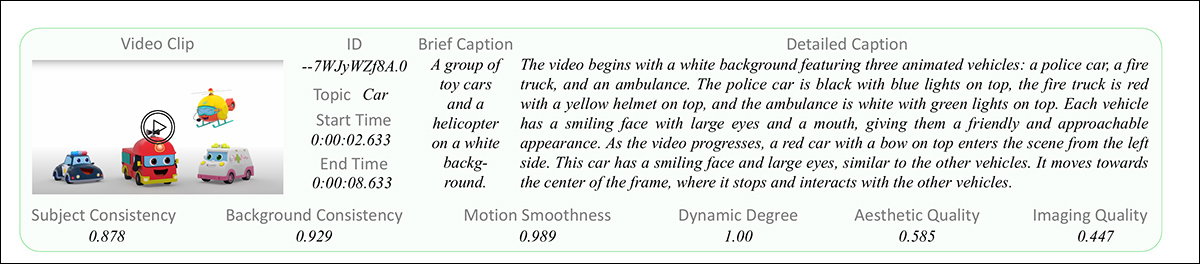

Выберите примеры из окончательно полученного набора данных.

«Персональный покупатель» для данных ИИ

Тематика и концепции, представленные в общей сумме интернет-изображений и видео, не обязательно отражают то, что среднестатистический конечный пользователь может в конечном итоге запросить от генеративной системы; даже там, где контент и спрос do имеют тенденцию сталкиваться (как в случае с порно, которое в изобилии доступны в Интернете и большой интерес для многих пользователей ИИ-генеративных систем это может не соответствовать намерениям и стандартам разработчиков для новой генеративной системы.

Помимо большого объема ежедневно загружаемых материалов NSFW, непропорционально большое количество материалов, доступных в сети, вероятно, будет поступать от рекламодателей и тех, попытка манипулировать SEOКоммерческая корысть такого рода делает распределение информации далеко не беспристрастным; что ещё хуже, сложно разработать системы фильтрации на основе искусственного интеллекта, способные справиться с этой проблемой, поскольку алгоритмы и модели, разработанные на основе значимых гипермасштабных данных, сами по себе могут отражать тенденции и приоритеты исходных данных.

Поэтому авторы новой работы подошли к проблеме, изменив предложение на противоположное: они определили, чего, скорее всего, хотят пользователи, и получили видеоролики, которые соответствуют этим потребностям.

На первый взгляд, этот подход кажется столь же вероятным, что спровоцирует семантическую гонку на дно, как и достижение сбалансированной нейтральности в стиле Википедии. Калибровка курирования данных вокруг спроса пользователей сопряжена с риском усиления предпочтений наименьшего общего знаменателя при маргинализации нишевых пользователей, поскольку интересы большинства неизбежно будут иметь больший вес.

Тем не менее, давайте посмотрим, как в статье решается эта проблема.

Дистилляция концепций с осторожностью

Исследователи использовали 2024 год ВидПроМ набор данных как источник для тематического анализа, который впоследствии будет использоваться для веб-скрапинга проекта.

По словам авторов, этот набор данных был выбран потому, что это единственный общедоступный набор данных объемом более 1 млн человек, «написанный реальными пользователями», и следует отметить, что этот набор данных сам по себе был курирован двумя авторами новой статьи.

В статье поясняется*:

«Сначала мы встраиваем все 1.67 миллиона подсказок из VidProM в 384-мерные векторы, используя SentenceTransformers Далее мы кластеризуем эти векторы с помощью K-средних. Обратите внимание, что здесь мы заранее устанавливаем количество кластеров на относительно большое значение, т. е. 2, и объединяем похожие кластеры на следующем шаге.

«Наконец, для каждого кластера мы спрашиваем ГПТ-4о «завершить тему [одно или два слова]».

Авторы отмечают, что некоторые концепции различны, но при этом тесно связаны, например: церковь и кафедральный собор. Слишком детальные критерии для случаев такого рода привели бы к внедрению понятий (например) для каждого типа породы собак, вместо термина собака; в то время как слишком широкие критерии могут объединить чрезмерное количество подконцепций в одну переполненную концепцию; поэтому в статье отмечается необходимость соблюдения баланса при оценке таких случаев.

Формы единственного и множественного числа были объединены, а глаголы были восстановлены в своих базовых (инфинитивных) формах. Чрезмерно широкие термины, такие как анимация, сцена, фильм и движение – были удалены.

Таким образом, было получено 1,291 тема (полный список доступен в дополнительном разделе исходной статьи).

Выберите веб-скрапинг

Затем исследователи использовали официальный API YouTube для поиска видео на основе критериев, полученных из набора данных 2024 года, стремясь получить 500 видео по каждой теме. Помимо требуемой лицензии Creative Commons, каждое видео должно было иметь разрешение 720p или выше и быть короче четырех минут.

Таким образом с YouTube было извлечено 586,490 XNUMX видеороликов.

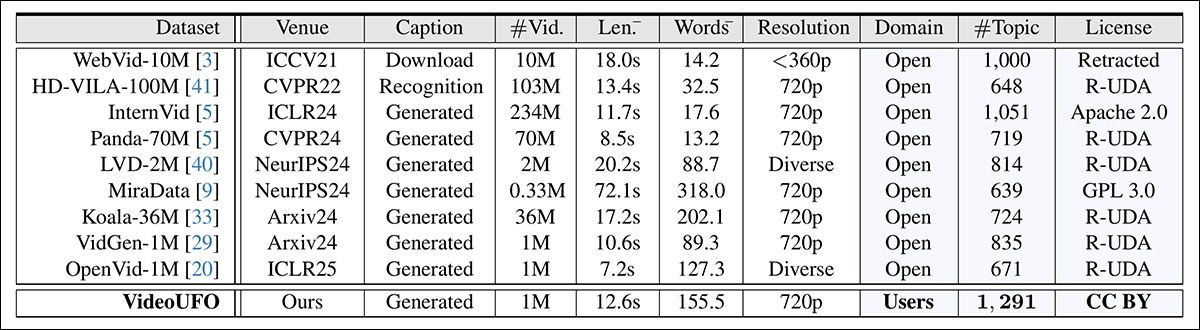

Авторы сравнили идентификатор YouTube загруженных видео с рядом популярных наборов данных: OpenVid-1M; HD-VILA-100M; Стажер-Вид; Коала-36М; ЛВД-2М; MiraData; Панда-70М; ВидГен-1Ми WebVid-10M.

Они обнаружили, что в этих старых коллекциях фигурировало всего 1,675 идентификаторов (вышеупомянутые 0.29%) клипов VideoUFO, и следует признать, что, хотя список сравнения наборов данных не является исчерпывающим, он включает в себя всех крупнейших и наиболее влиятельных игроков на сцене генеративного видео.

Разделение и оценка

Полученные видео были впоследствии сегментированы в несколько клипов, в соответствии с методологией, изложенной в статье Panda-70M, цитируемой выше. Границы кадров были оценены, сборки сшиты, и объединенные видео были разделены на отдельные клипы с предоставленными краткими и подробными субтитрами.

Каждая запись данных в наборе данных VideoUFO содержит клип, идентификатор, время начала и окончания, а также краткую и подробную подпись.

Краткие субтитры были обработаны методом Panda-70M, а подробные видеотитры - Qwen2-VL-7B, в соответствии с руководящими принципами, установленными Open-Sora-Plan. В случаях, когда клипы не воплощали успешно намеченную целевую концепцию, подробные субтитры для каждого такого клипа были загружены в GPT-4o mini, чтобы убедиться, что он действительно соответствует теме. Хотя авторы предпочли бы оценку через GPT-4o, это было бы слишком дорого для миллионов видеоклипов.

Оценка качества видео проводилась с использованием шести методов из VBench проект .

Сравнения

Авторы повторили процесс извлечения тем на вышеупомянутых предыдущих наборах данных. Для этого было необходимо семантически сопоставить полученные категории VideoUFO с неизбежно отличающимися категориями в других коллекциях; следует признать, что такие процессы предоставляют только приблизительные эквивалентные категории, и поэтому это может быть слишком субъективным процессом, чтобы гарантировать эмпирические сравнения.

Тем не менее, на изображении ниже мы видим результаты, полученные исследователями с помощью этого метода:

Сравнение основных атрибутов, полученных с помощью VideoUFO и предыдущих наборов данных.

Исследователи признают, что их анализ опирался на существующие подписи и описания, предоставленные в каждом наборе данных. Они признают, что повторное создание субтитров для старых наборов данных с использованием того же метода, что и VideoUFO, могло бы предложить более прямое сравнение. Однако, учитывая огромный объем точек данных, их вывод о том, что этот подход будет чрезмерно дорогим, кажется оправданным.

Поколение

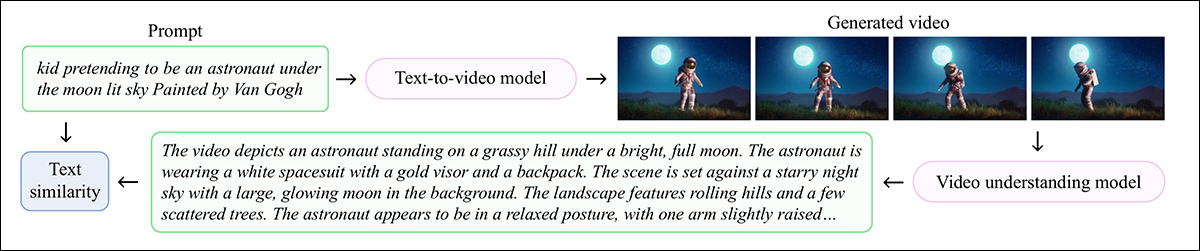

Авторы разработали эталонный тест для оценки эффективности моделей преобразования текста в видео на основе концепций, ориентированных на пользователя, под названием BenchUFO. Это повлекло за собой выбор 791 существительного из 1,291 отобранных пользовательских тем в VideoUFO. Для каждой выбранной темы затем случайным образом выбирались десять текстовых подсказок от VidProM.

Каждая подсказка была передана в модель «текст-видео», а вышеупомянутый Qwen2-VL-7B captioner использовался для оценки сгенерированных результатов. Со всеми сгенерированными видео, снабженными субтитрами, SentenceTransformers использовался для расчета косинусного сходства как для входной подсказки, так и для выходного (выведенного) описания в каждом случае.

Схема процесса BenchUFO.

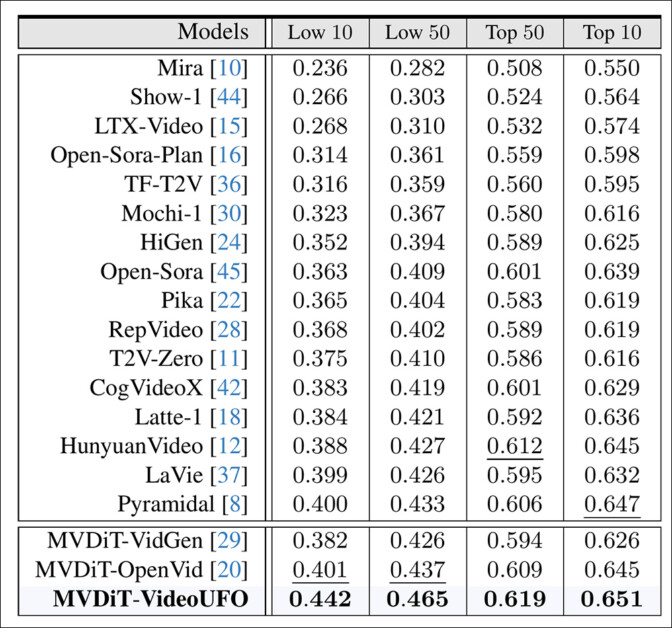

Оцениваемые генеративные модели: Mira; Шоу-1; LTX-Видео; Open-Sora-Plan; Открыть Сора; ТФ-Т2В; Моти-1; HiGen; Пика; РепВидео; T2V-ноль; CogVideoX; Латте-1; Видео Хуньюань; Жизньи пирамидальный.

Помимо VideoUFO, MVDiT-ВидГен и MVDit-OpenVid были альтернативными обучающими наборами данных.

Результаты охватывают 10–50-е места среди наиболее и наименее эффективных тем в архитектурах и наборах данных.

Результаты сравнения производительности общедоступных моделей T2V и обученных моделей авторов на BenchUFO.

Вот комментарий авторов:

«Текущие модели преобразования текста в видео не всегда хорошо работают по всем темам, ориентированным на пользователя. В частности, разница в оценках составляет от 0.233 до 0.314 между топ-10 и 10 низшими темами. Эти модели могут неэффективно понимать такие темы, как «гигантский кальмар», «животная клетка», «Ван Гог» и «древний египтянин» из-за недостаточного обучения на таких видео.

«Текущие модели преобразования текста в видео демонстрируют определённую степень последовательности в наиболее эффективных темах. Мы обнаружили, что большинство моделей преобразования текста в видео отлично справляются с созданием видеороликов на темы, связанные с животными, такие как «чайка», «панда», «дельфин», «верблюд» и «сова». Мы предполагаем, что это отчасти связано с перекосом в сторону животных в текущих наборах данных видео».

Заключение

VideoUFO — выдающееся предложение, хотя бы с точки зрения свежих данных. Если не было ошибок при оценке и исключении идентификаторов YouTube, и если набор данных содержит так много нового для исследовательской сцены материала, это редкое и потенциально ценное предложение.

Недостатком является то, что необходимо доверять основной методологии; если вы не верите, что пользовательский спрос должен определять формулы веб-скрапинга, вы покупаете набор данных, который имеет свои собственные наборы тревожных предубеждений.

Кроме того, полезность выделенных тем зависит как от надежности используемого метода выделения (что, как правило, затрудняется бюджетными ограничениями), так и от методов формулирования набора данных 2024 года, который предоставляет исходный материал.

Тем не менее, VideoUFO, безусловно, заслуживает дальнейшего изучения – и это доступно в Hugging Face.

* Моя замена ссылок на авторов гиперссылками.

Впервые опубликовано Среда, 5 марта 2025 г.