Угол Андерсона

Искусственный интеллект усовершенствует видеосъемку кошки для селфи

Генераторы видео на основе ИИ часто дают результаты, близкие к желаемому, но не совсем соответствующие текстовому запросу. Однако новая, высокоуровневая корректировка может кардинально изменить ситуацию.

Системы генерации видео часто испытывают трудности с созданием действительно креативных или необычных видеороликов и зачастую не оправдывают ожиданий, предъявляемых пользователями на основе текстовых подсказок.

Частично причина этого в том, что запутанность – дело в том, что моделям обработки изображений/языка приходится идти на компромисс в отношении продолжительности обучения на исходных данных. Слишком мало обучения – и концепции гибкие, но не полностью сформированные; слишком много – и концепции точные, но уже недостаточно гибкие для включения в новые комбинации.

Вы можете понять суть, посмотрев видео, встроенное ниже. Слева показан своего рода компромисс, который предлагают многие системы ИИ в ответ на требовательный запрос (запрос находится в начале видео во всех четырех примерах), требующий сопоставления элементов, слишком фантастического для реального обучающего примера. Справа показан результат работы ИИ, который гораздо лучше соответствует запросу:

Нажмите, чтобы играть (без звука). Справа мы видим «факторизованный» WAN 2.2, действительно отвечающий на запросы, в отличие от расплывчатых интерпретаций «стандартного» WAN 2.2 слева. Для лучшего разрешения и множества других примеров, пожалуйста, обратитесь к исходным видеофайлам, хотя представленные здесь версии отсутствуют на сайте проекта и были собраны специально для этой статьи. Источник

Что ж, хотя мы должны простить хлопающую утку человеческие руки (!), очевидно, что примеры справа гораздо лучше соответствуют исходному тексту, чем примеры слева.

Интересно, что обе представленные архитектуры по сути являются то же архитектура – популярная и очень способная Ван 2.2Китайская версия, которая в этом году значительно укрепила свои позиции в сообществах разработчиков открытого программного обеспечения и энтузиастов.

Разница заключается в том, что второй генеративный конвейер — это факторизованныйВ данном случае это означает, что для повторной интерпретации первого (исходного) кадра видео была использована большая языковая модель (LLM), благодаря чему системе будет гораздо проще предоставить пользователю то, что он запрашивает.

Эта «визуальная привязка» включает в себя внедрение изображения, созданного на основе этого улучшенного с помощью LLM запроса, в генеративный конвейер в качестве «начального кадра» и использование ЛоРА Интерпретационная модель, помогающая интегрировать кадр с «нарушителем» в процесс создания видео.

Результаты, с точки зрения оперативной точности, весьма примечательны, особенно для решения, которое кажется довольно элегантным:

Нажмите, чтобы играть (без звука). Дополнительные примеры «факторизованной» генерации видео, действительно точно соответствующих сценарию. Для получения более высокого разрешения и множества других примеров, пожалуйста, обратитесь к исходным видеофайлам, хотя представленные здесь версии отсутствуют на сайте проекта и были собраны специально для этой статьи.

Это решение предлагается в виде Новый документ Факторизованная генерация видео: разделение построения сцены и временного синтеза в моделях распространения текста в видео.и сопровождающий его видеоролик Веб-сайт проекта.

Хотя многие современные системы пытаются повысить точность подсказок, используя языковые модели для переписывания расплывчатого или недостаточно конкретного текста, в новой работе утверждается, что эта стратегия все еще приводит к неудаче, когда модель не справляется со своей задачей. внутреннее представление сцены ошибочен.

Даже при детально переписанном запросе модели преобразования текста в видео часто неправильно компонуют ключевые элементы или генерируют несовместимые начальные состояния, которые нарушают логику анимации. Пока первый кадр не соответствует описанию в запросе, результирующее видео не может быть восстановлено, независимо от того, насколько хороша модель движения.

В документе указано*:

«Модели [преобразования текста в видео] часто создают кадры со смещением распределения, но при этом достигают [оценочных показателей], сопоставимых с моделями I2V, что указывает на то, что Их моделирование движений остается достаточно естественным даже при относительно низкой точности сцены..

Модели [преобразования изображений в видео] демонстрируют взаимодополняющее поведение: высокие оценки, полученные благодаря точным исходным сценам, и более слабую временную согласованность, в то время как преобразование изображений в видео с добавлением текста уравновешивает оба аспекта.

«Этот контраст предполагает структурное несоответствие в современных моделях T2V«Для определения местоположения на основе сцены и временного синтеза используются различные индуктивные подходы, однако существующие архитектуры пытаются одновременно обучаться обоим методам в рамках одной модели».

Сравнительный диагностический анализ режимов генерации показал, что модели без явной привязки к сцене показали хорошие результаты в области движения, но часто демонстрировали недостатки в области компоновки сцены, в то время как подходы, основанные на анализе изображений, показали противоположную закономерность:

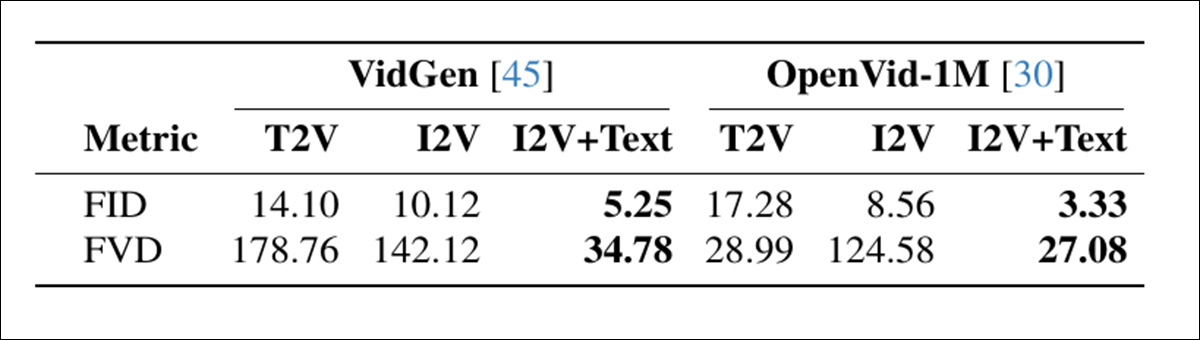

Сравнение режимов генерации видео на двух наборах данных показывает, что I2V+текст обеспечивает наилучшее качество кадров (FID) и временную согласованность (FVD), подчеркивая преимущество разделения построения сцены и движения. Источник

Эти результаты указывают на структурный недостаток, заключающийся в том, что современные модели пытаются одновременно изучать компоновку сцены и анимацию, хотя эти две задачи требуют разных типов данных. индуктивное смещениеи лучше рассматривать их отдельно.

Пожалуй, наибольший интерес представляет то, что этот «трюк» потенциально может быть применен к локальным установкам таких моделей, как WAN 2.1 и 2.2, а также к аналогичным моделям распространения видео, таким как... Видео ХуньюаньПо наблюдениям, сравнивая качество любительских разработок с коммерческими генеративными порталами, такими как Kling и Runway, можно заметить, что большинство крупных поставщиков API улучшают предложения с открытым исходным кодом, например, WAN с помощью LoRA, и, судя по всему, используют приемы, подобные описанным в новой статье. Поэтому такой подход может представлять собой попытку наверстать упущенное для сторонников свободного программного обеспечения.

Проведенные испытания показывают, что этот простой и модульный подход предлагает новый передовой подход в данной области. Тест производительности T2V-CompBenchзначительно улучшив все протестированные модели. В заключение авторы отмечают, что, хотя их система радикально повышает точность, она не решает (и не предназначена для решения) проблему... дрейф идентичностиВ настоящее время это является бичом исследований в области генеративного искусственного интеллекта.

Новая статья написана четырьмя исследователями из Федеральной политехнической школы Лозанны (EPFL) в Швейцарии.

Метод и данные

Основная идея новой методики заключается в том, что модели распространения текста в видео (T2V) должны быть «привязаны» к начальным кадрам, которые действительно соответствуют желаемому текстовому запросу.

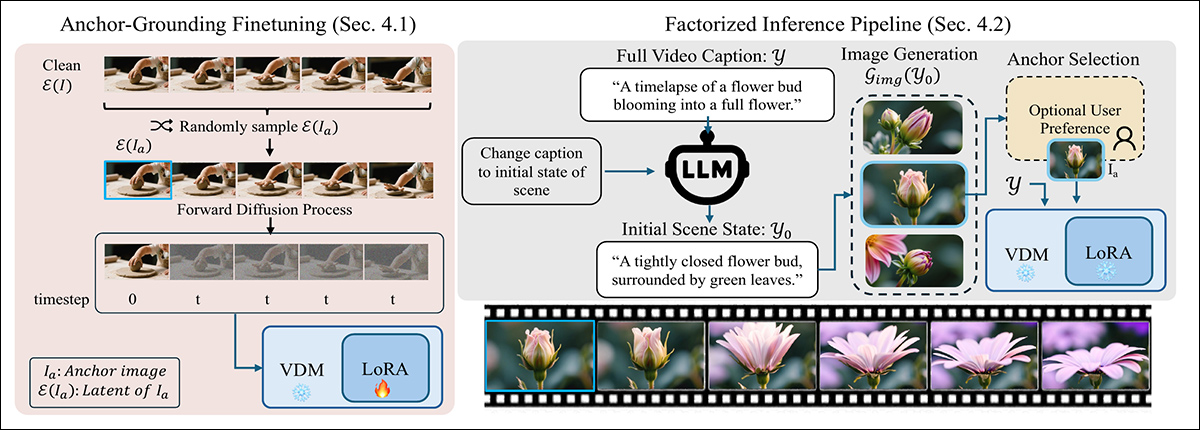

Чтобы гарантировать, что модель учитывает исходную систему координат, новый метод нарушает стандартный процесс диффузии путем введения чистого латентной из опорного изображения на нулевом временном шаге, заменяя один из обычных зашумленных входных сигналов. Этот незнакомый входной сигнал поначалу сбивает модель с толку, но с минимальным уровнем LoRA. тонкая настройкаТаким образом, система учится воспринимать введенный кадр как фиксированный визуальный ориентир, а не как часть траектории шума:

Двухэтапный метод привязки генерации текста к видео с помощью визуального якоря: слева модель дорабатывается с использованием облегченной модели LoRA, которая рассматривает внедренный чистый латентный сигнал как фиксированное ограничение сцены. Справа запрос разбивается на подпись первого кадра, которая используется для генерации изображения-якоря, направляющего видео.

На этапе вывода метод переписывает подсказку, чтобы она описывала только первый кадрс использованием LLM для извлечения правдоподобного начального состояния сцены, сфокусированного на компоновке и внешнем виде.

Этот переписанный запрос передается генератору изображений для создания потенциального опорного кадра (который пользователь может дополнительно уточнить). Выбранный кадр кодируется в скрытое изображение и внедряется в процесс диффузии путем замены первого шага по времени, что позволяет модели генерировать остальную часть видео. при этом оставаясь привязанным к исходной сцене. – процесс, который работает без необходимости внесения изменений в базовую архитектуру.

Процесс был протестирован путем создания LoRA для Wan2.2-14B, Wan2.1-1B и CogVideo1.5-5BОбучение по программе LoRA проводилось в ранг из 256, на 5000 случайно выбранных фрагментах из УльтраВидео коллекция.

Обучение длилось 6000 шагов и потребовало 48 часов работы графического процессора.† для Wan-1B и CogVideo-5B, и 96 часов работы GPU для Wan-14B. Авторы отмечают, что Wan-5B изначально поддерживает обработку только текста и текста и изображений (которые в данном случае навязываются более старым фреймворкам), и поэтому не потребовала никакой тонкой настройки.

Tests

В ходе экспериментов, проведенных в рамках этого процесса, каждая текстовая подсказка первоначально уточнялась с использованием Qwen2.5-7B-Инструктировать, которая использовала полученный результат для генерации подробной подписи к «исходному изображению», содержащей описание всей сцены. Затем это изображение было передано в QwenImage, которой было поручено создать «магическую рамку», которая должна была быть вставлена в процесс диффузии.

В качестве критериев оценки системы использовались упомянутый выше T2V-CompBench, предназначенный для проверки понимания композиции путем оценки того, насколько хорошо модели сохраняют объекты, атрибуты и действия в рамках целостной сцены; и VBench 2.0для оценки более широких рассуждений и согласованности по 18 показателям, сгруппированным в креативность, рассуждения здравого смысла, контролируемость, человеческая верность и физика:

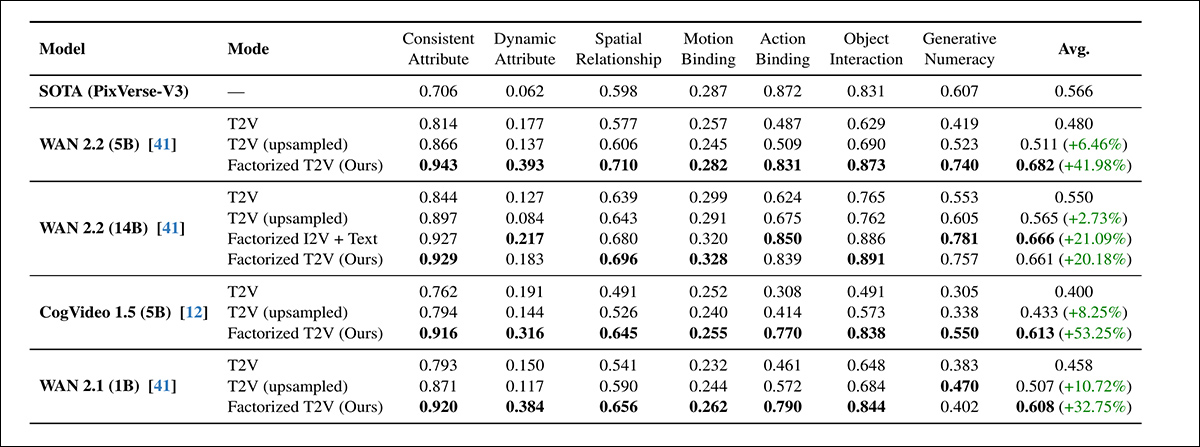

По всем семи категориям оценки T2V-CompBench факторизованный метод T2V превзошел как стандартный, так и улучшенный базовый метод T2V для каждой протестированной модели, показав прирост до 53.25%. Варианты с наивысшими баллами часто соответствовали или превосходили показатели фирменного бенчмарка PixVerse-V3.

Что касается этого первого этапа испытаний, авторы заявляют*:

«Во всех моделях добавление опорного изображения неизменно улучшает композиционные характеристики. Все меньшие по размеру модели Factorized (CogVideo 5B, Wan 5B и Wan 1B) превосходят более крупную модель Wan 14B T2V».

"Наша разложенная на составляющие модель Wan 5B также превосходит по производительности коммерческий базовый PixVerse-V3, который является лучшей моделью, согласно результатам бенчмарка. Это демонстрирует, что визуальная привязка существенно улучшает понимание сцены и действий даже в моделях с меньшими возможностями.

«В каждой группе моделей факторизованная версия превосходит исходную модель. Примечательно, что наша облегченная модель LoRA с заземлением на WAN 14B достигает производительности, сопоставимой с ее предварительно обученным вариантом I2V 14B (0.661 против 0.666), несмотря на то, что не требует полного переобучения».

Далее последовал раунд VBench2.0:

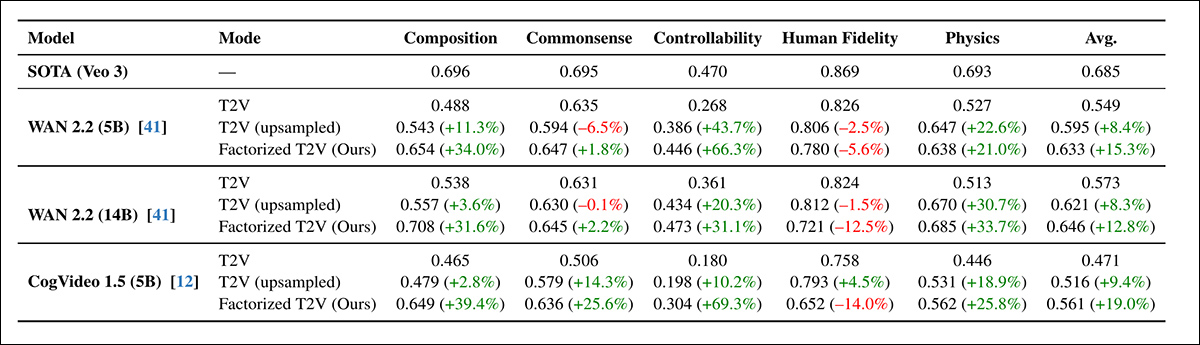

Факторизованный подход T2V последовательно улучшал производительность VBench 2.0 по таким параметрам, как композиция, здравый смысл, управляемость и физика, при этом некоторые улучшения превышали 60% — хотя точность моделирования с участием человека оставалась ниже базового уровня Veo 3.

Во всех архитектурах факторизованный подход повысил результаты во всех категориях VBench, за исключением одной. человеческая верность, которая незначительно снизилась даже при быстром увеличении разрешения. WAN 5B превзошла более крупную WAN 14B, подтвердив ранее полученные результаты T2V-CompBench, согласно которым визуальное заземление внесло больший вклад, чем масштабирование.

Хотя прирост производительности на VBench был стабильным, он был меньше, чем на T2V-CompBench, и авторы объясняют это более строгим бинарным режимом оценки в VBench.

Для качественных тестов в статье приводятся статические изображения, но для более ясного представления мы отсылаем читателя к составным видеороликам, встроенным в эту статью, с оговоркой, что исходные видеоматериалы многочисленнее и разнообразнее, а также обладают более высоким разрешением и детализацией. Найти их можно здесь. здесьЧто касается качественных результатов, в статье говорится:

«Видео с привязкой к объекту неизменно демонстрируют более точную композицию сцены, более прочную связь между объектами и их характеристиками, а также более четкую временную последовательность».

Факторизованный метод оставался стабильным даже при сокращении количества шагов диффузии с 50 до 15, демонстрируя практически полное отсутствие потери производительности на T2V-CompBench. В отличие от этого, как текстовый, так и увеличенный базовый варианты резко ухудшили свои показатели в тех же условиях.

Хотя теоретически сокращение количества шагов могло бы утроить скорость, на практике полный конвейер генерации стал быстрее лишь в 2.1 раза из-за фиксированных затрат на генерацию опорных изображений. Тем не менее, результаты показали, что привязка не только улучшила качество образца, но и помогла стабилизировать процесс диффузии, обеспечивая более быструю и эффективную генерацию без потери точности.

На сайте проекта представлены примеры генерации изображений с увеличенным разрешением и с использованием новых методов, несколько отредактированных примеров (с более низким разрешением) мы приводим здесь:

Нажмите, чтобы играть (без звука). Сравнение исходных данных с увеличенной частотой дискретизации и факторизованного подхода авторов.

Авторы заключают:

«Наши результаты показывают, что улучшенная основа, а не только увеличение пропускной способности, может быть не менее важна. Последние достижения в области диффузии T2V в значительной степени опирались на увеличение размера модели и объема обучающих данных, однако даже большие модели часто испытывают трудности с построением связной начальной сцены только на основе текста».

«Это контрастирует с распространением изображений, где масштабирование относительно простое; в видеомоделях каждое архитектурное улучшение должно применяться к дополнительному временному измерению, что делает масштабирование значительно более ресурсоемким».

«Наши результаты показывают, что улучшенная основа может дополнить масштабируемость за счет решения другого узкого места: установления правильной сцены до начала синтеза движения».

«Благодаря включению генерации видео в композицию сцены и временное моделирование, мы смягчаем ряд распространенных причин сбоев без необходимости создания значительно более крупных моделей. Мы рассматриваем это как дополнительный принцип проектирования, который может направлять будущие архитектуры к более надежному и структурированному синтезу видео».

Заключение

Хотя проблемы запутанности вполне реальны и могут потребовать специальных решений (таких как улучшенная оценка курирования и распространения перед обучением), было поразительно наблюдать, как факторизация «разъединяет» несколько упрямых и «застрявших» концептуальных подсказок, превращая их в гораздо более точные изображения — всего лишь с умеренным уровнем обработки LoRA и вмешательством заметно улучшенного начального/затравочного изображения.

Разница в ресурсах между решениями для локальных любительских проектов и коммерческими решениями может быть не столь огромной, как предполагалось, учитывая, что почти все поставщики стремятся оптимизировать свои значительные затраты на графические процессоры для потребителей.

По имеющимся данным, очень большое количество современных поставщиков генеративного видео, похоже, используют фирменные и, как правило, «улучшенные» версии китайских моделей с открытым исходным кодом. Главное преимущество этих «посреднических» систем, по-видимому, заключается в том, что они либо потрудились обучить модели LoRA, либо – с большими затратами и несколько большей отдачей – провели полную тонкую настройку весов модели.††.

Подобные выводы могли бы помочь еще больше сократить этот разрыв в контексте ситуации на рынке релизов, где китайцы, похоже, полны решимости (не обязательно из альтруистических или идеалистических соображений) демократизировать искусственный интеллект, в то время как западные деловые круги, вероятно, предпочли бы, чтобы увеличение размера моделей и ужесточение регулирования в конечном итоге изолировали действительно хорошие модели за API и многоуровневыми фильтрами контента.

* Выделено авторами, а не мной.

† В статье не указано, какой именно графический процессор был выбран и сколько их было использовано.

†† Хотя вариант LoRA более вероятен как с точки зрения экономичности, так и из-за возможности использования полных весов, а не... квантуется Веса предоставляются не всегда.

Впервые опубликовано Пятница, 19 декабря 2025 г.