Угол Андерсона

Новые исследовательские работы ставят под сомнение ценообразование «токенов» для чатов ИИ

Новые исследования показывают, что способ выставления счетов за услуги ИИ по токенам скрывает реальную стоимость от пользователей. Провайдеры могут тихо завышать цены, подделывая количество токенов или ускользая от скрытых шагов. Некоторые системы запускают дополнительные процессы, которые не влияют на результат, но все равно отображаются в счете. Были предложены инструменты аудита, но без реального надзора пользователи вынуждены платить больше, чем они осознают.

Почти во всех случаях мы, потребители, платим за чат-интерфейсы на базе искусственного интеллекта, такие как ЧатGPT-4o, в настоящее время измеряется в лексемы: невидимые блоки текста, которые остаются незамеченными во время использования, но при этом учитываются с абсолютной точностью при выставлении счетов; и хотя каждый обмен оценивается по количеству обработанных токенов, у пользователя нет прямого способа подтвердить подсчет.

Несмотря на наше (в лучшем случае) несовершенное понимание того, что мы получаем за купленную единицу «токенов», выставление счетов на основе токенов стало стандартным подходом среди поставщиков услуг, основанным на, как может показаться, шатком предположении о доверии.

Слова-символы

Токен — это не совсем то же самое, что слово, хотя часто играет схожую роль, и большинство поставщиков используют термин «токен» для описания небольших фрагментов текста, таких как слова, знаки препинания или фрагменты слов. Слово 'невероятный', например, может быть учтен одной системой как один токен, в то время как другая может разделить его на un, верить и в состоянии, при этом каждая деталь увеличивает стоимость.

Эта система применяется как к тексту, вводимому пользователем, так и к ответу модели, при этом цена рассчитывается на основе общего количества этих единиц.

Сложность заключается в том, что пользователи не увидеть этот процесс. Большинство интерфейсов не показывают количество токенов во время разговора, и способ подсчета токенов трудно воспроизвести. Даже если отображается количество после ответ, то уже слишком поздно говорить о том, было ли это справедливым, поскольку возникает несоответствие между тем, что видит пользователь, и тем, за что он платит.

Недавние исследования указывают на более глубокие проблемы: одном исследовании показывает, как провайдеры могут взимать завышенную плату, не нарушая правил, просто увеличивая количество токенов способами, которые пользователь не видит; другой выявляет несоответствие между тем, что отображается в интерфейсах, и тем, за что фактически взимается плата, создавая у пользователей иллюзию эффективности, которой на самом деле может не быть; и в третьих демонстрирует, как модели регулярно генерируют внутренние шаги рассуждений, которые никогда не отображаются пользователю, но тем не менее отображаются в счете.

Результаты исследования описывают систему, которая кажется точный, с точными числами, подразумевающими ясность, но чья базовая логика остается скрытой. Является ли это намеренным или структурным недостатком, результат один и тот же: пользователи платят за большее, чем они могут увидеть, и часто большее, чем они ожидают.

Оптом дешевле?

В первый из этих работ – под названием Is Ваш LLM переплачивает вам? Токенизация, прозрачность и стимулы, от четырех исследователей из Института программных систем Макса Планка, авторы утверждают, что риски выставления счетов на основе токенов выходят за рамки непрозрачности, указывая на встроенный стимул для поставщиков завышать количество токенов:

«Суть проблемы заключается в том, что токенизация строки не является уникальной. Например, предположим, что пользователь отправляет провайдеру запрос «Где состоится следующий NeurIPS?», провайдер передает его в LLM, и модель генерирует вывод «|San| Diego|», состоящий из двух токенов.

«Поскольку пользователь не обращает внимания на процесс генерации, корыстный поставщик может неверно сообщить пользователю о токенизации выходных данных, даже не меняя исходную строку. Например, поставщик может просто поделиться токенизацией «|S|a|n| |D|i|e|g|o|» и взять с пользователя завышенную цену — девять токенов вместо двух!»

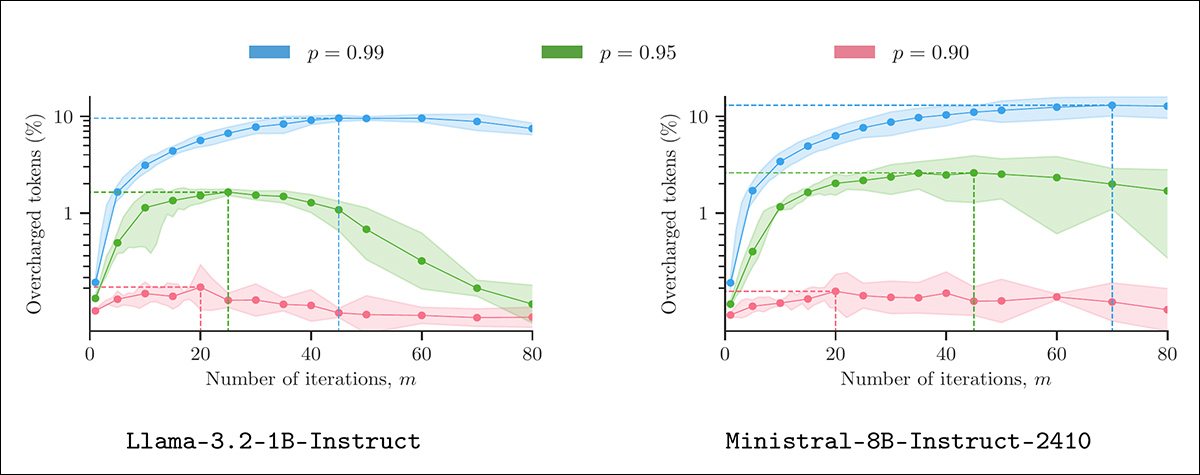

В статье представлена эвристика, способная выполнять этот вид неискренних вычислений без изменения видимого вывода и без нарушения правдоподобия при типичных настройках декодирования. Протестировано на моделях из ЛАМА, Мистраль и Гемма В серии, используя реальные подсказки, метод достигает измеримых перегрузок, не выглядя аномально:

Инфляция токенов с использованием «правдоподобного искажения информации». На каждой панели показан процент токенов с переплатой, полученных в результате применения провайдером алгоритма 1 к результатам 400 запросов LMSYS при различных параметрах выборки (m и p). Все результаты были получены при температуре 1.3°C с пятью повторениями для каждого параметра для расчета 90% доверительных интервалов. Источник: https://arxiv.org/pdf/2505.21627

Для решения этой проблемы исследователи призывают выставлять счета на основе количество символов вместо токенов, утверждая, что это единственный подход, который дает поставщикам причину честно сообщать об использовании, и утверждая, что если цель — справедливое ценообразование, то привязка стоимости к видимым символам, а не скрытым процессам, является единственным вариантом, который выдерживает проверку. Они утверждают, что ценообразование на основе символов устранит мотив для предоставления неверных отчетов, а также вознаградит более короткие и эффективные результаты.

Однако здесь есть ряд дополнительных соображений (в большинстве случаев допускаемых авторами). Во-первых, предлагаемая схема на основе символов вводит дополнительную бизнес-логику, которая может благоприятствовать продавцу по сравнению с потребителем:

«[У] поставщика, который никогда не предоставляет неверных отчетов, есть явный стимул генерировать максимально короткую последовательность выходных токенов и улучшать текущие алгоритмы токенизации, такие как BPE, чтобы они максимально сжимали последовательность выходных токенов».

Оптимистичный мотив здесь в том, что поставщик таким образом поощряется производить краткий и более значимый и ценный вывод. На практике, очевидно, существуют менее добродетельные способы для поставщика сократить количество текста.

Во-вторых, разумно предположить, утверждают авторы, что компаниям, скорее всего, потребуется законодательство для перехода от тайной системы токенов к более понятному, основанному на тексте методу выставления счетов. В конечном итоге, мятежный стартап может решить дифференцировать свой продукт, запустив его с такой моделью ценообразования; но любой, у кого есть действительно конкурентоспособный продукт (и работающий в меньшем масштабе, чем Категория ЕЕЕ) лишен стимула делать это.

Наконец, подобные алгоритмы, предлагаемые авторами, влекут за собой собственные вычислительные затраты; если затраты на расчёт «надбавки» превышают потенциальную прибыль, схема становится явно бесполезной. Однако исследователи подчёркивают, что предложенный ими алгоритм эффективен и экономичен.

Авторы предоставляют код для своих теорий на GitHub.

Переключатель

Второй статье - под названием Невидимые токены, видимые счета: насущная необходимость аудита скрытых операций в непрозрачных услугах LLM, от исследователей из Университета Мэриленда и Беркли, утверждает, что несогласованные стимулы в коммерческих языковых моделях API не ограничиваются разделением токенов, но распространяются на целые классы скрытых операций.

К ним относятся внутренние вызовы моделей, умозрительные рассуждения, использование инструментов и многоагентное взаимодействие — все это может быть выставлено пользователю в счет без возможности просмотра или обращения в суд.

Цены и прозрачность API-интерфейсов LLM для рассуждений у основных поставщиков. Все перечисленные сервисы взимают плату с пользователей за скрытые внутренние токены рассуждений, и ни один из них не делает эти токены видимыми во время выполнения. Стоимость значительно различается, при этом модель OpenAI o1-pro взимает в десять раз больше за миллион токенов, чем Claude Opus 4 или Gemini 2.5 Pro, несмотря на одинаковую непрозрачность. Источник: https://www.arxiv.org/pdf/2505.18471

В отличие от обычного выставления счетов, где количество и качество услуг можно проверить, авторы утверждают, что сегодняшние платформы LLM работают по следующим принципам: структурная непрозрачность: пользователи платят за использование токенов и API, но у них нет возможности подтвердить, что эти показатели отражают реальную или необходимую работу.

В статье определены две основные формы манипуляции: инфляция количества, когда количество токенов или вызовов увеличивается без выгоды для пользователя; и понижение качества, где менее производительные модели или инструменты молчаливо используются вместо премиальных компонентов:

«При обосновании LLM API поставщики часто поддерживают несколько вариантов одного и того же семейства моделей, отличающихся по емкости, данным обучения или стратегии оптимизации (например, ChatGPT o1, o3). Понижение уровня модели означает молчаливую замену более дешевых моделей, что может привести к несоответствию между ожидаемым и фактическим качеством обслуживания.

«Например, запрос может быть обработан моделью меньшего размера, при этом выставление счетов останется неизменным. Пользователям сложно заметить такую практику, поскольку для многих задач окончательный ответ может по-прежнему казаться правдоподобным».

В документе зафиксированы случаи, когда более девяноста процентов выставленных счетов на токенах никогда не показывались пользователям, а внутренние рассуждения раздували использование токенов более чем в двадцать раз. Оправданно это или нет, непрозрачность этих шагов лишает пользователей какой-либо основы для оценки их релевантности или легитимности.

В агентских системах непрозрачность увеличивается, поскольку внутренние обмены между агентами ИИ могут повлечь за собой расходы, не оказывая существенного влияния на конечный результат:

«Помимо внутренних рассуждений, агенты общаются, обмениваясь подсказками, резюме и инструкциями по планированию. Каждый агент интерпретирует входные данные от других и генерирует выходные данные для управления рабочим процессом. Эти межагентские сообщения могут потреблять значительные токены, которые часто не видны напрямую конечным пользователям.

«Все токены, использованные в ходе координации работы агентов, включая сгенерированные подсказки, ответы и инструкции, связанные с инструментами, обычно не отображаются для пользователя. Когда сами агенты используют модели логического мышления, выставление счетов становится ещё более непрозрачным».

Чтобы противостоять этим проблемам, авторы предлагают многоуровневую структуру аудита, включающую криптографические доказательства внутренней активности, проверяемые маркеры идентичности модели или инструмента и независимый надзор. Однако основная проблема носит структурный характер: текущие схемы выставления счетов LLM зависят от постоянного асимметрия информации, в результате чего пользователи сталкиваются с расходами, которые они не могут проверить или разбить.

Подсчет невидимого

В заключительной статье исследователей из Мэрилендского университета проблема выставления счетов переосмысливается не как вопрос неправильного использования или предоставления неверных отчетов, а как вопрос структуры. статье - под названием CoIn: Подсчет невидимых токенов рассуждений в коммерческих непрозрачных API LLM, и от десяти исследователей из Университета Мэриленда - отмечает, что большинство коммерческих услуг LLM теперь скрывают промежуточное рассуждение что способствует окончательному ответу модели, но все еще взимают плату за эти жетоны.

В статье утверждается, что это создает ненаблюдаемую поверхность биллинга, где целые последовательности могут быть изготовлены, введены или раздуты без обнаружения*:

«[Эта] невидимость позволяет провайдерам неправильно сообщать количество токенов or внедрять недорогие, сфабрикованные токены рассуждений для искусственного увеличения количества токенов. Мы называем эту практику инфляция количества токенов.

«Например, один высокоэффективный ARC-AGI, работающий на основе модели o3 компании OpenAI, потреблял 111 миллионов токенов, стоимостью 66,772.3 XNUMX долл. США Учитывая такой масштаб, даже небольшие манипуляции могут привести к существенным финансовым последствиям.

«Такая асимметрия информации позволяет компаниям, разрабатывающим программы для искусственного интеллекта, взимать с пользователей значительно завышенную плату, тем самым ущемляя их интересы».

Чтобы противостоять этой асимметрии, авторы предлагают Монета, сторонняя система аудита, предназначенная для проверки скрытых токенов без раскрытия их содержимого, которая использует хэшированные отпечатки пальцев и семантические проверки для обнаружения признаков инфляции.

Обзор системы аудита CoIn для непрозрачных коммерческих LLM. Панель A показывает, как вложения токенов рассуждений хэшируются в дерево Меркла для проверки количества токенов без раскрытия содержимого токенов. Панель B иллюстрирует проверки семантической валидности, где легкие нейронные сети сравнивают блоки рассуждений с окончательным ответом. Вместе эти компоненты позволяют сторонним аудиторам обнаруживать скрытую инфляцию токенов, сохраняя конфиденциальность поведения фирменной модели. Источник: https://arxiv.org/pdf/2505.13778

Один компонент проверяет количество токенов криптографическим способом, используя Дерево Merkle; другой оценивает релевантность скрытого контента, сравнивая его с ответом на встраивание. Это позволяет аудиторам обнаружить заполнение или нерелевантность — признаки того, что токены вставляются просто для того, чтобы поднять счет.

При развертывании в тестах CoIn достигла уровня успешного обнаружения почти 95% для некоторых форм инфляции с минимальным раскрытием базовых данных. Хотя система по-прежнему зависит от добровольного сотрудничества со стороны поставщиков и имеет ограниченное разрешение в крайних случаях, ее более широкий смысл не вызывает сомнений: сама архитектура текущего выставления счетов LLM предполагает честность, которую невозможно проверить.

Заключение

Помимо преимущества получения предоплаты от пользователей, сума-основанная на валюте (например, система «жужжания» в ЦивитАИ) помогает абстрагировать пользователей от истинной стоимости валюты, которую они тратят, или товара, который они покупают. Аналогично, предоставление продавцу свободы для определения их собственные единицы измерения еще больше оставляют потребителя в неведении относительно того, сколько он на самом деле тратит в реальном выражении денег.

Как и отсутствие часов в Лас-ВегасеПодобные меры часто направлены на то, чтобы сделать потребителя безрассудным или безразличным к стоимости.

Едва ли понятый знак, который может потребляться и определяться множеством способов, возможно, не является подходящей единицей измерения для потребления LLM — не в последнюю очередь потому, что он может стоит во много раз больше токенов для расчета более низкого результата LLM на неанглийском языке по сравнению с англоязычной сессией.

Однако вывод на основе символов, как предполагают исследователи Макса Планка, скорее всего, будет благоприятствовать более лаконичным языкам и наказывать естественно многословные языки. Поскольку визуальные индикаторы, такие как обесценивающийся счетчик токенов, вероятно, заставят нас быть немного более бережливыми на наших сессиях LLM, кажется маловероятным, что такие полезные дополнения к графическому интерфейсу появятся в ближайшее время — по крайней мере, без законодательных мер.

* Выделение текста авторами. Моё преобразование ссылок авторов в гиперссылки.

Впервые опубликовано Четверг, 29 мая 2025 г.