Искусственный интеллект

Мультимодальный ИИ развивается по мере появления ChatGPT с GPT-4V(ision)

В постоянных попытках сделать ИИ более похожим на человека, модели GPT OpenAI постоянно раздвигают границы. GPT-4 теперь может принимать запросы как в виде текста, так и изображений.

Мультимодальность в генеративном искусственном интеллекте означает способность модели создавать различные выходные данные, такие как текст, изображения или аудио, на основе входных данных. Эти модели, обученные на конкретных данных, изучают базовые закономерности для генерации аналогичных новых данных, обогащая приложения ИИ.

Последние успехи в области мультимодального искусственного интеллекта

Недавний заметный скачок в этой области можно увидеть благодаря интеграции DALL-E 3 в ChatGPT, значительному обновлению технологии преобразования текста в изображение OpenAI. Такое сочетание обеспечивает более плавное взаимодействие, поскольку ChatGPT помогает создавать точные подсказки для DALL-E 3, превращая идеи пользователей в яркие произведения искусства, созданные искусственным интеллектом. Таким образом, хотя пользователи могут напрямую взаимодействовать с DALL-E 3, наличие ChatGPT делает процесс создания искусственных изображений намного более удобным для пользователя.

Узнайте больше о DALL-E 3 и его интеграции с ChatGPT. здесь. Это сотрудничество не только демонстрирует достижения в области мультимодального искусственного интеллекта, но и упрощает создание произведений искусства с использованием искусственного интеллекта для пользователей.

С другой стороны, Google Health представил Med-PaLM M в июне этого года. Это мультимодальная генеративная модель, способная кодировать и интерпретировать разнообразные биомедицинские данные. Это было достигнуто путем тонкой настройки PaLM-E, языковой модели, для обслуживания медицинских доменов с использованием открытого исходного кода бенчмарка MultiMedBench. Этот бенчмарк состоит из более чем 1 миллиона образцов по 7 типам биомедицинских данных и 14 задач, таких как ответы на медицинские вопросы и генерация отчетов по радиологии.

Различные отрасли внедряют инновационные мультимодальные инструменты искусственного интеллекта для стимулирования расширения бизнеса, оптимизации операций и повышения вовлеченности клиентов. Прогресс в области возможностей голосового, видео и текстового искусственного интеллекта стимулирует рост мультимодального искусственного интеллекта.

Предприятия ищут мультимодальные приложения ИИ, способные перестроить бизнес-модели и процессы, открывая возможности для роста всей генеративной экосистемы ИИ, от инструментов обработки данных до новых приложений ИИ.

После запуска GPT-4 в марте некоторые пользователи заметили снижение качества его ответа с течением времени, и эту обеспокоенность поддержали известные разработчики и на форумах OpenAI. Первоначально отклонен OpenAI, позже проведенное исследование подтвердил проблему. Было выявлено снижение точности GPT-4 с 97.6% до 2.4% в период с марта по июнь, что указывает на снижение качества ответов при последующих обновлениях модели.

Шумиха вокруг Открытый ИИ ChatGPT вернулся. Теперь он поставляется с функцией видения ГПТ-4В, что позволяет пользователям использовать GPT-4 для анализа предоставленных ими изображений. Это новейшая функция, открытая для пользователей.

Добавление анализа изображений в большие языковые модели (LLM), такие как GPT-4, рассматривается некоторыми как большой шаг вперед в исследованиях и разработках ИИ. Этот вид мультимодального LLM открывает новые возможности, выводя языковые модели за рамки текста, предлагая новые интерфейсы и решая новые виды задач, создавая новый опыт для пользователей.

Обучение GPT-4V было завершено в 2022 году, а ранний доступ был открыт в марте 2023 года. Визуальная функция GPT-4V основана на технологии GPT-4. Тренировочный процесс остался прежним. Первоначально модель была обучена предсказывать следующее слово в тексте, используя огромный набор данных, состоящий из текста и изображений из различных источников, включая Интернет.

Позже он был доработан с использованием большего количества данных, используя метод под названием «Обучение с подкреплением на основе обратной связи с человеком» (RLHF), чтобы генерировать результаты, которые предпочитают люди.

Механика обзора GPT-4

Замечательные возможности языка видения GPT-4, хотя и впечатляют, имеют базовые методы, которые остаются на поверхности.

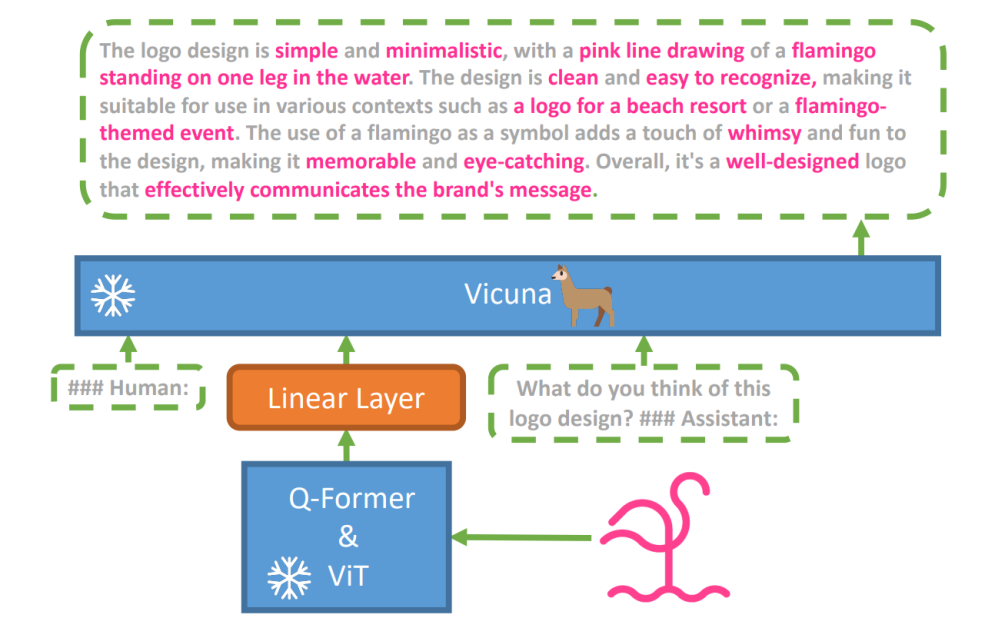

Чтобы исследовать эту гипотезу, была создана новая модель языка видения, МиниГПТ-4 был представлен с использованием передовой программы LLM под названием Викунья. В этой модели используется видеокодер с предварительно обученными компонентами для визуального восприятия, который выравнивает закодированные визуальные функции с моделью языка викуньи через один проекционный слой. Архитектура MiniGPT-4 проста, но эффективна, в ней основное внимание уделяется согласованию визуальных и языковых функций для улучшения возможностей визуального общения.

Архитектура MiniGPT-4 включает в себя видеокодер с предварительно обученными ViT и Q-Former, один слой линейной проекции и усовершенствованную модель большого языка викуньи.

Тенденция использования авторегрессионных языковых моделей в задачах визуального языка также выросла, используя кросс-модальный перенос для обмена знаниями между языковыми и мультимодальными областями.

MiniGPT-4 объединяет визуальную и языковую области, совмещая визуальную информацию от предварительно обученного видеокодера с усовершенствованным LLM. Модель использует Vicuna в качестве декодера языка и использует двухэтапный подход к обучению. Первоначально он обучается на большом наборе данных пар изображение-текст, чтобы усвоить знания визуального языка, после чего следует точная настройка на меньшем, высококачественном наборе данных для повышения надежности генерации и удобства использования.

Чтобы повысить естественность и удобство использования сгенерированного языка в MiniGPT-4, исследователи разработали двухэтапный процесс выравнивания, устраняя недостаток адекватных наборов данных для выравнивания изображения и языка. Для этой цели они создали специализированный набор данных.

Первоначально модель генерировала подробные описания входных изображений, улучшая детализацию с помощью диалоговых подсказок, соответствующих формату модели языка викуньи. Целью этого этапа было создание более полных описаний изображений.

Подсказка к описанию исходного изображения:

###Человек: Опишите этот образ подробно. Дайте как можно больше подробностей. Скажи все, что видишь. ###Ассистент:

При постобработке данных любые несоответствия или ошибки в сгенерированных описаниях исправлялись с помощью ChatGPT с последующей ручной проверкой для обеспечения высокого качества.

Подсказка для второго этапа точной настройки:

###Человек: ###Ассистент:

Это исследование открывает окно в понимание механики мультимодального генеративного ИИ, такого как GPT-4, и проливает свет на то, как можно эффективно интегрировать зрительные и языковые модальности для создания последовательных и контекстуально богатых результатов.

Изучение концепции GPT-4

Определение происхождения изображения с помощью ChatGPT

GPT-4 Vision расширяет возможности ChatGPT анализировать изображения и определять их географическое происхождение. Эта функция переводит взаимодействие с пользователем с простого текста на сочетание текста и визуальных эффектов, становясь удобным инструментом для тех, кто интересуется разными местами с помощью данных изображений.

Сложные математические концепции

GPT-4 Vision отлично справляется с изучением сложных математических идей путем анализа графических или рукописных выражений. Эта функция служит полезным инструментом для людей, желающих решать сложные математические задачи, что делает GPT-4 Vision заметным помощником в образовательной и академической областях.

Преобразование рукописного ввода в коды LaTeX

Одной из замечательных возможностей GPT-4V является способность преобразовывать рукописные данные в коды LaTeX. Эта функция является благом для исследователей, ученых и студентов, которым часто необходимо преобразовать рукописные математические выражения или другую техническую информацию в цифровой формат. Переход от рукописного текста к LaTeX расширяет горизонты оцифровки документов и упрощает процесс технического написания.

Извлечение сведений о таблице

GPT-4V демонстрирует навыки извлечения подробностей из таблиц и ответа на соответствующие запросы, что является жизненно важным преимуществом в анализе данных. Пользователи могут использовать GPT-4V для анализа таблиц, сбора ключевой информации и решения вопросов, связанных с данными, что делает его надежным инструментом для аналитиков данных и других специалистов.

Понимание визуального указания

Уникальная способность GPT-4V воспринимать визуальные указания добавляет новое измерение взаимодействию с пользователем. Понимая визуальные сигналы, GPT-4V может отвечать на запросы с более глубоким пониманием контекста.

Создание простых макетов веб-сайтов с использованием чертежей

Мотивированный этим TweetЯ попытался создать макет сайта unite.ai.

Хотя результат не совсем соответствовал моему первоначальному видению, вот результат, которого я достиг.

Ограничения и недостатки GPT-4V(ision)

Для анализа GPT-4V команда Open AI провела качественные и количественные оценки. Качественные включали внутренние тесты и внешние экспертные оценки, а количественные измеряли отказы и точность модели в различных сценариях, таких как выявление вредоносного контента, демографическое распознавание, проблемы конфиденциальности, геолокация, кибербезопасность и мультимодальный взлом.

И все же модель не идеальна.

Команда статье подчеркивает ограничения GPT-4V, такие как неверные выводы и отсутствие текста или символов в изображениях. Он может галлюцинировать или выдумывать факты. В частности, он не подходит для идентификации опасных веществ на изображениях и часто распознает их ошибочно.

При медицинской визуализации GPT-4V может давать противоречивые ответы и не учитывает стандартные методы, что приводит к потенциальным ошибочным диагнозам.

Ненадежная работа для медицинских целей (Источник)

Он также не способен уловить нюансы некоторых символов ненависти и может генерировать неприемлемый контент на основе визуальных данных. OpenAI не рекомендует использовать GPT-4V для критической интерпретации, особенно в медицинских или деликатных контекстах.

Подводя итог

Создано с использованием Fast Stable Diffusion XL. https://huggingface.co/spaces/google/sdxl

Появление GPT-4 Vision (GPT-4V) приносит с собой массу интересных возможностей и новых препятствий, которые нужно преодолеть. Прежде чем его внедрить, было приложено немало усилий для того, чтобы риски, особенно когда дело касается фотографий людей, были тщательно изучены и снижены. Впечатляет то, как GPT-4V продвинулся вперед, показав многообещающие результаты в таких сложных областях, как медицина и наука.

Теперь на столе стоит несколько больших вопросов. Например, смогут ли эти модели узнавать известных людей по фотографиям? Должны ли они угадать пол, расу или чувства человека по картинке? И нужны ли какие-то специальные настройки для помощи людям с нарушениями зрения? Эти вопросы открывают множество вопросов о конфиденциальности, справедливости и о том, как ИИ должен вписаться в нашу жизнь, и это то, о чем каждый должен иметь право голоса.