Лидеры мысли

Расшифровка возможностей и проблем для агентов LLM в генеративном искусственном интеллекте

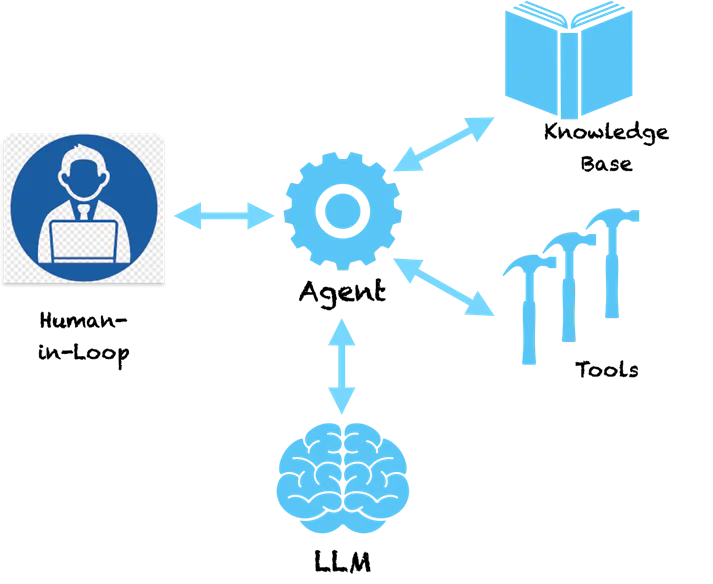

Мы наблюдаем развитие приложений генеративного искусственного интеллекта, основанных на больших языковых моделях (LLM), от подсказок к расширенной генерации извлечения (RAG) и агентам. Об агентах много говорят в промышленных и исследовательских кругах, главным образом из-за возможностей, которые эта технология обеспечивает для преобразования корпоративных приложений и обеспечения превосходного качества обслуживания клиентов. Существуют общие шаблоны создания агентов, которые позволяют сделать первые шаги на пути к общему искусственному интеллекту (AGI).

В моем предыдущем гайдмы увидели лестницу интеллектуальных шаблонов для создания приложений на основе LLM. Начиная с подсказок, которые фиксируют проблемную область и используют внутреннюю память LLM для генерации выходных данных. С помощью RAG мы дополняем подсказку внешними знаниями, полученными из базы данных векторов, для управления выходными данными. Затем, объединив вызовы LLM, мы можем построить рабочие процессы для реализации сложных приложений. Агенты выводят это на новый уровень, автоматически определяя, как должны формироваться эти цепочки LLM. Давайте посмотрим подробно.

Агенты – Под капотом

Ключевой особенностью агентов является то, что они используют способность LLM понимать язык, чтобы составить план решения конкретной проблемы. LLM понимает проблему и предлагает нам последовательность шагов для ее решения. Однако на этом дело не заканчивается. Агенты — это не чистая система поддержки, которая предоставит вам рекомендации по решению проблемы, а затем передаст вам эстафету для выполнения рекомендуемых действий. Агенты наделены инструментами, позволяющими действовать дальше. Страшно правда!?

Если мы зададим агенту такой основной вопрос:

Человек: Какую компанию основал изобретатель телефона?

Ниже приведен пример мыслительных шагов, которые может предпринять агент.

Агент (ДУМАЯ):

- Мысль: надо найти изобретателя телефона.

- Действие: Поиск [изобретатель телефона]

- Наблюдение: Александр Грэм Белл

- Мысль: мне нужно найти компанию, основанную Александром Грэмом Беллом.

- Действие: Поиск [компания, основанная Александром Грэмом Беллом]

- Наблюдение: Александр Грэм Белл стал соучредителем Американской телефонной и телеграфной компании (AT&T) в 1885 году.

- Мысль: Я нашел ответ. Я вернусь.

Агент (ОТВЕТ): Александр Грэм Белл основал AT&T в 1885 году.

Вы можете видеть, что агент следует методическому способу разбиения проблемы на подзадачи, которые можно решить, выполнив определенные действия. Действия, описанные здесь, рекомендованы LLM, и мы можем сопоставить их с конкретными инструментами для реализации этих действий. Мы могли бы включить для агента инструмент поиска, чтобы, когда он поймет, что LLM предоставил поиск в качестве действия, он будет вызывать этот инструмент с параметрами, предоставленными LLM. Поиск здесь осуществляется в Интернете, но его также можно перенаправить на поиск во внутренней базе знаний, например в базе данных векторов. Теперь система становится самодостаточной и может решать сложные проблемы, выполнив ряд шагов. Такие фреймворки, как Лангчейн и LLaMAIndex предоставляют вам простой способ создания этих агентов и подключения к инструментам и API. Amazon недавно запустила платформу Bedrock Agents, которая предоставляет визуальный интерфейс для проектирования агентов.

Под капотом агенты используют особый стиль отправки подсказок в LLM, которые заставляют их генерировать план действий. Вышеупомянутый шаблон «мысль-действие-наблюдение» популярен в агенте типа ReAct (рассуждение и действие). Другие типы агентов включают MRKL и Plan & Execute, которые в основном различаются стилем подсказок.

Для более сложных агентов действия могут быть привязаны к инструментам, вызывающим изменения в исходных системах. Например, мы могли бы подключить агента к инструменту, который проверяет остаток отпуска и подает заявку на отпуск в ERP-системе для сотрудника. Теперь мы могли бы создать красивого чат-бота, который будет взаимодействовать с пользователями и через команду чата подавать заявку на отпуск в системе. Больше никаких сложных экранов подачи заявления на отпуск, простой единый интерфейс чата. Звучит захватывающе!?

Предостережения и необходимость ответственного ИИ

А что, если у нас есть инструмент, который вызывает транзакции по торговле акциями с использованием предварительно авторизованного API. Вы создаете приложение, в котором агент изучает изменения акций (с помощью инструментов) и принимает за вас решения о покупке и продаже акций. Что, если агент продаст не те акции, потому что у него были галлюцинации и он принял неправильное решение? Поскольку LLM — это огромные модели, трудно точно определить, почему они принимают те или иные решения, поэтому галлюцинации являются обычным явлением при отсутствии надлежащих ограждений.

Хотя все агенты интересны, вы, вероятно, уже догадались, насколько они могут быть опасны. Если они начнут галлюцинировать и предпримут неправильные действия, это может привести к огромным финансовым потерям или серьезным проблемам в корпоративных системах. Следовательно, ответственный ИИ приобретает первостепенное значение в эпоху приложений, основанных на LLM. Принципы ответственного ИИ, касающиеся воспроизводимости, прозрачности и подотчетности, пытаются ограничить решения, принимаемые агентами, и предлагают анализ рисков, чтобы решить, какие действия требуют участия человека. По мере разработки более сложных агентов им требуется больше контроля, прозрачности и подотчетности, чтобы мы могли быть уверены, что мы знаем, что они делают.

Заключительные мысли

Способность агентов генерировать путь логических шагов с действиями приближает их к человеческому рассуждению. Предоставление им более мощных инструментов может дать им сверхспособности. Такие шаблоны, как ReAct, пытаются имитировать то, как люди решают проблемы, и мы увидим лучшие шаблоны агентов, которые будут актуальны для конкретных контекстов и областей (банковское дело, страхование, здравоохранение, промышленность и т. д.). Будущее уже здесь, и технологии, лежащие в основе агентов, готовы к использованию. В то же время нам необходимо уделять пристальное внимание принципам ответственного ИИ, чтобы быть уверенными, что мы не создаем Скайнет!