Быстрый инжиниринг

ChatGPT и Advanced Prompt Engineering: движущая сила эволюции ИИ

Компания OpenAI сыграла ключевую роль в разработке таких революционных инструментов, как OpenAI Gym, предназначенный для обучения алгоритмов с подкреплением, и моделей GPT-n. В центре внимания также находится DALL-E — модель искусственного интеллекта, создающая изображения на основе текстовых входных данных. Одной из таких моделей, привлекшей значительное внимание, является модель OpenAI. ChatGPT, яркий образец в области больших языковых моделей.

GPT-4: Быстрое проектирование

ChatGPT преобразил ландшафт чат-ботов, предлагая ответы, подобные человеческим, на вводимые пользователем данные и расширяя область применения — от разработки и тестирования программного обеспечения до делового общения и даже создания стихов.

В руках предприятий и частных лиц GPT-4, например, может служить неиссякаемым резервуаром знаний, владеющих предметами, начиная от математики и биологии и заканчивая юридическими исследованиями. Такие сложные и доступные модели искусственного интеллекта способны изменить будущее работы, обучения и творчества.

Генеративные модели, такие как GPT-4, могут создавать новые данные на основе существующих входных данных. Этот отличительный признак позволяет им выполнять различные задачи, включая создание текста, изображений, музыки и видео.

В контексте моделей ChatGPT и OpenAI подсказка — это ввод, который пользователи вводят в модели, обычно в виде текста. Подсказки служат основным средством контроля результатов, генерируемых этими моделями, что делает их критически важными для успешных и релевантных разговоров.

Влияние оперативного качества

Использование четко определенных подсказок является ключом к участию в полезных и содержательных разговорах с системами ИИ. Плохо определенные подсказки могут привести к выводу, который будет бесполезен для пользователя и даже может привести к вводящему в заблуждение содержимому.

Чтобы продемонстрировать влияние качества подсказок, сравним две разные подсказки, выдаваемые ChatGPT. Первая подсказка, нечётко сформулированная и предполагающая наличие у пользователя определённых знаний, генерирует потенциально бесполезный ответ. Вторая же подсказка, напротив, предоставляет больше контекста и примеров, обеспечивая более релевантный и понятный ответ.

Подскажите 1: «Расскажите мне о сверточных нейронных сетях».

Ответ 1: «Сверточные нейронные сети (CNN) — это многоуровневые персептронные сети, состоящие из полностью связанных слоев и объединенных слоев. Они обычно используются в задачах распознавания изображений. Процесс включает в себя применение фильтров к входным изображениям и уменьшение их масштаба с использованием объединенных слоев».

Подскажите 2: «Я хочу узнать о сверточных нейронных сетях, но у меня нет предварительных знаний об искусственных нейронных сетях. Можете ли вы дать понятное для новичков объяснение и пример того, как CNN используются в распознавании изображений?»

Ответ 2: «Сверточные нейронные сети (CNN) — это тип нейронной сети, в основном используемый для задач распознавания изображений. В отличие от других нейронных сетей, они используют сверточные слои и объединяющие слои для обработки изображений. Представьте, что у вас есть образ кота. CNN могут идентифицировать различные особенности изображения, такие как усы, уши и хвост, применяя фильтры и понижая дискретизацию изображения с помощью объединенных слоев. Этот процесс делает CNN очень эффективными для распознавания объектов на изображениях».

При сравнении двух ответов становится очевидным, что четко сформулированная подсказка приводит к более релевантному и удобному для пользователя ответу. Быстрый дизайн и проектирование — это растущие дисциплины, направленные на оптимизацию качества вывода моделей ИИ, таких как ChatGPT.

В следующих разделах этой статьи мы углубимся в область продвинутых методологий, направленных на уточнение моделей больших языков (LLM), таких как методы и тактики быстрого проектирования. К ним относятся обучение за несколько шагов, ReAct, цепочка мыслей, RAG и многое другое.

Передовые инженерные методы

Прежде чем продолжить, важно понять ключевую проблему, связанную с LLM, называемую «галлюцинацией». В контексте LLM «галлюцинация» означает тенденцию этих моделей генерировать результаты, которые могут казаться разумными, но не основаны на фактической реальности или заданном исходном контексте.

Эта проблема ярко проявилась в недавнем судебном деле, когда адвокат защиты использовал ChatGPT для юридических исследованийИнструмент ИИ, работающий со сбоями из-за проблемы с галлюцинациями, ссылался на несуществующие судебные дела. Эта ошибка имела серьёзные последствия, вызвав путаницу и подорвав доверие к процессу. Этот инцидент служит суровым напоминанием о необходимости срочно решить проблему «галлюцинаций» в системах ИИ.

Наше исследование методов оперативного проектирования направлено на улучшение этих аспектов LLM. Повышая их эффективность и безопасность, мы прокладываем путь для инновационных приложений, таких как извлечение информации. Кроме того, он открывает двери для беспрепятственной интеграции LLM с внешними инструментами и источниками данных, расширяя диапазон их потенциального использования.

Обучение с нулевым и малым количеством выстрелов: оптимизация на примерах

Генеративные предварительно обученные преобразователи (GPT-3) стали важным поворотным моментом в развитии моделей генеративного ИИ, поскольку в них была представлена концепцияобучение в несколько выстреловЭтот метод стал настоящим прорывом благодаря своей способности эффективно работать без необходимости сложной тонкой настройки. Фреймворк GPT-3 обсуждается в статье:Языковые модели — это немногие ученики», где авторы демонстрируют превосходство модели в различных вариантах использования без необходимости использования пользовательских наборов данных или кода.

В отличие от тонкой настройки, которая требует постоянных усилий для решения различных вариантов использования, модели с несколькими шагами демонстрируют более легкую адаптацию к более широкому спектру приложений. Хотя в некоторых случаях точная настройка может обеспечить надежное решение, она может быть дорогостоящей в больших масштабах, что делает использование моделей с несколькими шагами более практичным подходом, особенно в сочетании с оперативным проектированием.

Представьте, что вы пытаетесь перевести с английского на французский. При обучении с небольшим количеством примеров вы бы предоставили GPT-3 несколько примеров перевода, например, «морская выдра -> loutre de mer». GPT-3, будучи продвинутой моделью, может продолжать предоставлять точные переводы. При обучении с нулевым количеством примеров вы бы не предоставили ни одного примера, и GPT-3 всё равно смог бы эффективно переводить с английского на французский.

Термин «обучение с малым количеством попыток» исходит из идеи, что модели предоставляется ограниченное количество примеров для «обучения». Важно отметить, что «обучение» в данном контексте не подразумевает обновление параметров или весов модели, а скорее влияет на её эффективность.

Обучение с нулевым выстрелом продвигает эту концепцию на шаг вперед. При нулевом обучении в модели не приводятся примеры выполнения задачи. Ожидается, что модель будет хорошо работать на основе ее начального обучения, что делает эту методологию идеальной для сценариев ответов на вопросы с открытым доменом, таких как ChatGPT.

Во многих случаях модель, способная к обучению с нулевым выстрелом, может хорошо работать, если она снабжена несколькими или даже единичными примерами. Эта возможность переключаться между нулевым, однократным и поэтапным сценариями обучения подчеркивает адаптивность больших моделей, расширяя возможности их применения в различных областях.

Методы обучения с нулевым выстрелом становятся все более распространенными. Эти методы характеризуются способностью распознавать невидимые во время обучения объекты. Вот практический пример подсказки с несколькими выстрелами:

"Translate the following English phrases to French:

'sea otter' translates to 'loutre de mer'

'sky' translates to 'ciel'

'What does 'cloud' translate to in French?'"

Предоставив модели несколько примеров и задав ей вопрос, мы можем эффективно направить её к желаемому результату. В этом случае GPT-3, скорее всего, правильно переведёт слово «cloud» на французский как «nuage».

Мы подробно рассмотрим различные нюансы оперативной инженерии и её важнейшую роль в оптимизации производительности модели на этапе вывода. Мы также рассмотрим, как её можно эффективно использовать для создания экономичных и масштабируемых решений для широкого спектра вариантов использования.

Поскольку мы продолжаем изучать сложность методов оперативной инженерии в моделях GPT, важно подчеркнуть наш последний пост:Основное руководство по быстрой разработке в ChatGPT'. В этом руководстве представлены стратегии эффективного обучения моделей ИИ для множества вариантов использования.

В предыдущих обсуждениях мы рассмотрели фундаментальные методы подсказок для больших языковых моделей (LLM), такие как обучение с нулевым и малым количеством подсказок, а также обучение с помощью инструкций. Освоение этих методов критически важно для решения более сложных задач проектирования подсказок, которые мы рассмотрим здесь.

Обучение с помощью нескольких выстрелов может быть ограничено из-за ограниченного контекстного окна большинства LLM. Более того, без надлежащих мер безопасности LLM могут быть введены в заблуждение, что приведет к потенциально опасным результатам. Кроме того, многим моделям сложно решать логические задачи или следовать многоступенчатым инструкциям.

Учитывая эти ограничения, проблема заключается в использовании LLM для решения сложных задач. Очевидным решением может быть разработка более совершенных LLM или усовершенствование существующих, но это потребует значительных усилий. Итак, возникает вопрос: как мы можем оптимизировать текущие модели для улучшения решения проблем?

Не менее увлекательным является исследование того, как эта технология взаимодействует с творческими приложениями в Unite AI.Овладение искусством искусственного интеллекта: краткое руководство по путешествию и оперативному проектированию', в котором описывается, как слияние искусства и ИИ может привести к впечатляющему искусству.

Цепочка мыслей

Подсказки по цепочке мыслей используют присущие большим языковым моделям (LLM) авторегрессивные свойства, которые превосходно предсказывают следующее слово в заданной последовательности. Побуждая модель к объяснению своего мыслительного процесса, она стимулирует более тщательное и методичное генерирование идей, которые, как правило, тесно связаны с точной информацией. Это соответствие проистекает из склонности модели обрабатывать и представлять информацию вдумчиво и упорядоченно, подобно тому, как эксперт-человек объясняет слушателю сложную концепцию. Простого утверждения, например, «пошагово объясните мне, как…», часто достаточно, чтобы вызвать этот более подробный и подробный вывод.

Цепочка мыслей с нулевым выстрелом

В то время как традиционные подсказки CoT требуют предварительной подготовки с демонстрациями, развивающимся направлением является подсказка CoT с нулевой частотой. Этот подход, предложенный Кодзимой и соавторами (2022), инновационно добавляет к исходной подсказке фразу «Давайте подумаем шаг за шагом».

Давайте создадим расширенное приглашение, в котором ChatGPT будет поручено обобщить основные выводы из исследовательских работ по искусственному интеллекту и естественному языку.

В этой демонстрации мы воспользуемся способностью модели понимать и обобщать сложную информацию из академических текстов. Используя подход с несколькими попытками обучения, давайте научим ChatGPT обобщать ключевые выводы из исследовательских работ по искусственному интеллекту и обработке естественного языка:

1. Paper Title: "Attention Is All You Need"

Key Takeaway: Introduced the transformer model, emphasizing the importance of attention mechanisms over recurrent layers for sequence transduction tasks.

2. Paper Title: "BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding"

Key Takeaway: Introduced BERT, showcasing the efficacy of pre-training deep bidirectional models, thereby achieving state-of-the-art results on various NLP tasks.

Now, with the context of these examples, summarize the key findings from the following paper:

Paper Title: "Prompt Engineering in Large Language Models: An Examination"

Эта подсказка не только поддерживает четкую цепочку мыслей, но также использует подход к обучению в несколько приемов для управления моделью. Он связан с нашими ключевыми словами, фокусируясь на областях ИИ и НЛП, в частности, поручая ChatGPT выполнять сложную операцию, связанную с быстрой разработкой: подведение итогов исследовательских работ.

Реагировать на приглашение

React, или «Разум и действие», был представлен Google в статье «ReAct: синергия рассуждений и действий в языковых моделях", и произвел революцию в том, как языковые модели взаимодействуют с задачей, побуждая модель динамически генерировать как следы вербальных рассуждений, так и действия, специфичные для задачи.

Представьте себе человека-повара на кухне: он не только выполняет ряд действий (режет овощи, кипятит воду, перемешивает ингредиенты), но и участвует в вербальном мышлении или внутренней речи («теперь, когда овощи нарезаны, нужно поставить кастрюлю на плиту»). Этот непрерывный мысленный диалог помогает выстраивать стратегию процесса, адаптироваться к внезапным изменениям («У меня закончилось оливковое масло, я возьму сливочное») и запоминать последовательность задач. React имитирует эту человеческую способность, позволяя модели быстро осваивать новые задачи и принимать взвешенные решения, как это делает человек в новых или неопределенных обстоятельствах.

React может справиться с галлюцинациями, распространенной проблемой систем Chain-of-Thought (CoT). CoT, хотя и эффективная техника, не имеет возможности взаимодействовать с внешним миром, что потенциально может привести к галлюцинациям фактов и распространению ошибок. Однако React компенсирует это взаимодействием с внешними источниками информации. Это взаимодействие позволяет системе не только подтверждать свои рассуждения, но и обновлять свои знания на основе последней информации из внешнего мира.

Фундаментальную работу React можно объяснить на примере HotpotQA, задача, требующая рассуждений высокого порядка. При получении вопроса модель React разбивает вопрос на управляемые части и создает план действий. Модель генерирует след рассуждений (мысль) и идентифицирует соответствующее действие. Он может решить поискать информацию об Apple Remote во внешнем источнике, таком как Википедия (действие), и обновить свое понимание на основе полученной информации (наблюдение). С помощью нескольких шагов «мысль-действие-наблюдение» ReAct может извлекать информацию для поддержки своих рассуждений, уточняя, что ему нужно получить дальше.

Примечание:

HotpotQA — это набор данных, полученный из Википедии, состоящий из 113 XNUMX пар вопросов и ответов, предназначенных для обучения систем ИИ сложным рассуждениям, поскольку вопросы требуют рассуждений по нескольким документам для ответа. С другой стороны, Здравый смыслQA 2.0, созданный с помощью геймификации, включает в себя 14,343 XNUMX вопроса, на которые можно ответить «да/нет», и призван проверить понимание ИИ здравого смысла, поскольку вопросы намеренно составлены так, чтобы вводить модели ИИ в заблуждение.

Процесс может выглядеть примерно так:

- Мысль: «Мне нужно найти Apple Remote и совместимые с ним устройства».

- Экшн: Поиск «совместимых с Apple Remote устройств» на внешнем источнике.

- Наблюдение: получает список устройств, совместимых с Apple Remote, из результатов поиска.

- Мысль: «Исходя из результатов поиска, несколько устройств, кроме Apple Remote, могут управлять программой, для взаимодействия с которой они изначально были предназначены».

Результатом является динамичный, основанный на рассуждениях процесс, который может развиваться на основе информации, с которой он взаимодействует, что приводит к более точным и надежным ответам.

Сравнительная визуализация четырех методов подсказок — Standard, Chain-of-Thought, Act-Only и ReAct в решении HotpotQA и AlfWorld (https://arxiv.org/pdf/2210.03629.pdf)

Разработка агентов React — это специализированная задача, учитывая их способность достигать сложных целей. Например, диалоговый агент, построенный на базовой модели React, включает диалоговую память для обеспечения более насыщенного взаимодействия. Однако сложность этой задачи упрощается такими инструментами, как Langchain, который стал стандартом для разработки этих агентов.

Контекстная подсказка

Бумага 'Контекстно-ориентированные подсказки для больших языковых моделей' подчеркивает, что, хотя LLM продемонстрировали значительный успех в задачах НЛП, основанных на знаниях, их чрезмерная зависимость от параметрических знаний может ввести их в заблуждение в контекстно-зависимых задачах. Например, когда языковая модель обучается на устаревших фактах, она может давать неверные ответы, если игнорирует контекстуальные подсказки.

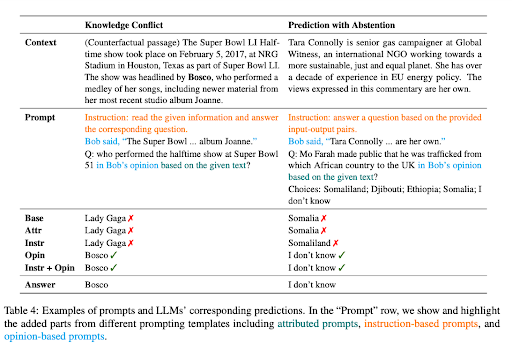

Эта проблема становится очевидной в случаях конфликта знаний, когда контекст содержит факты, отличающиеся от уже имеющихся у LLM знаний. Рассмотрим пример: Большая языковая модель (LLM), заполненная данными перед чемпионатом мира по футболу 2022 года, получает контекст, указывающий на победу Франции в турнире. Однако LLM, опираясь на свои предварительно обученные знания, продолжает утверждать, что предыдущий победитель, то есть команда, победившая на чемпионате мира 2018 года, по-прежнему является действующим чемпионом. Это классический случай «конфликта знаний».

По сути, конфликт знаний в LLM возникает, когда новая информация, предоставленная в контексте, противоречит уже имеющимся знаниям, на которых обучалась модель. Склонность модели опираться на данные предыдущего обучения, а не на новый предоставленный контекст, может приводить к неверным результатам. С другой стороны, галлюцинации в LLM — это генерация ответов, которые могут казаться правдоподобными, но не основаны на данных обучения модели или предоставленном контексте.

Другая проблема возникает, когда предоставленный контекст не содержит достаточно информации для точного ответа на вопрос, ситуация, известная как предсказание с воздержанием. Например, если LLM спрашивают об основателе Microsoft на основе контекста, который не предоставляет этой информации, в идеале он должен воздерживаться от предположений.

Чтобы повысить контекстную точность ответов LLM в этих ситуациях, исследователи предложили ряд стратегий подсказок. Эти стратегии направлены на то, чтобы ответы LLM были более адаптированы к контексту, а не полагались на закодированные знания.

Одна из таких стратегий — формулировать подсказки в виде вопросов, основанных на мнении, где контекст интерпретируется как высказывание рассказчика, а вопрос относится к его мнению. Такой подход позволяет магистру права (LLM) сосредоточиться на представленном контексте, а не на уже имеющихся знаниях.

Добавление контрфактических демонстраций к подсказкам также было признано эффективным способом повышения достоверности в случаях конфликта знаний. Эти демонстрации представляют сценарии с ложными фактами, которые побуждают модель уделять больше внимания контексту, чтобы давать точные ответы.

Инструкция тонкой настройки

Тонкая настройка инструкций — это этап обучения под наблюдением, который основан на предоставлении модели конкретных инструкций, например: «Объясните разницу между восходом и закатом». Инструкция сочетается с подходящим ответом, что-то вроде: «Рассвет относится к моменту, когда солнце появляется над горизонтом утром, а закат отмечает момент, когда солнце исчезает за горизонтом вечером». С помощью этого метода модель, по сути, учится следовать инструкциям и выполнять их.

Этот подход существенно влияет на процесс подсказок LLM, что приводит к радикальному изменению стиля подсказок. LLM с тонкой настройкой инструкций позволяет немедленно выполнять нулевые задачи, обеспечивая бесперебойную работу задач. Если LLM еще предстоит отладить, может потребоваться поэтапный подход к обучению, включающий несколько примеров в вашу подсказку, чтобы направить модель к желаемому ответу.

Инструкция Настройка с помощью GPT-4' обсуждает попытку использовать GPT-4 для генерации данных, следующих за инструкциями, для точной настройки LLM. Они использовали обширный набор данных, состоящий из 52,000 XNUMX уникальных записей с инструкциями на английском и китайском языках.

Набор данных играет ключевую роль в настройке инструкций. модели LLaMA, серия LLM с открытым исходным кодом, обеспечивающая повышенную производительность с нуля при выполнении новых задач. Заслуживают внимания такие проекты, как Стэнфорд Альпака эффективно использовали настройку самообучения, эффективный метод согласования LLM с человеческими намерениями, используя данные, сгенерированные усовершенствованными моделями учителей, настроенными на инструкции.

Основная цель исследований по настройке инструкций - повысить способность LLM к обобщению с нулевым и малократным повторением. Дополнительные данные и масштабирование модели могут дать ценную информацию. С текущим размером данных GPT-4 в 52 КБ и размером базовой модели LLaMA в 7 миллиардов параметров существует огромный потенциал для сбора большего количества данных о выполнении инструкций GPT-4 и объединения их с другими источниками данных, что приведет к обучению более крупных моделей LLaMA. для превосходной производительности.

STaR: начальное рассуждение с рассуждением

Потенциал LLM особенно заметен в сложных логических задачах, таких как математика или ответы на вопросы на основе здравого смысла. Однако процесс побуждения языковой модели к генерации обоснований — серии пошаговых обоснований или «цепочки размышлений» — имеет ряд проблем. Это часто требует создания больших наборов данных для обоснования или жертвы точностью из-за зависимости только от нескольких выводов.

«Разумеющий-самоучка» (ЗВЕЗДА) предлагает инновационное решение этих задач. Он использует простой цикл для непрерывного улучшения способности модели к рассуждениям. Этот итеративный процесс начинается с генерации обоснований для ответов на несколько вопросов с использованием нескольких рациональных примеров. Если полученные ответы неверны, модель снова пытается сгенерировать обоснование, на этот раз дающее правильный ответ. Затем модель дорабатывается с учетом всех обоснований, которые привели к правильным ответам, и процесс повторяется.

Методология STaR, демонстрирующая цикл тонкой настройки и создание образца обоснования в наборе данных CommonsenseQA (https://arxiv.org/pdf/2203.14465.pdf)

Чтобы проиллюстрировать это на практическом примере, рассмотрим вопрос «Что можно использовать для переноски маленькой собачки?» с вариантами ответов от бассейна до корзины. Модель STaR дает обоснование, определяя, что ответом должно быть что-то, способное нести маленькую собаку, и делая вывод, что правильным ответом является корзина, предназначенная для хранения вещей.

Подход STaR уникален тем, что он использует уже имеющиеся у языковой модели возможности рассуждения. Он использует процесс самогенерации и уточнения обоснований, итеративно наращивая возможности рассуждения модели. Однако цикл STaR имеет свои ограничения. Модель может не решить новые задачи в обучающем наборе, поскольку не получает прямого обучающего сигнала для задач, которые она не может решить. Для решения этой проблемы STaR вводит рационализацию. Для каждой задачи, на которую модель не может ответить правильно, она генерирует новое обоснование, предоставляя модели правильный ответ, что позволяет ей проводить обратные рассуждения.

Таким образом, STaR выступает в качестве масштабируемого метода начальной загрузки, который позволяет моделям учиться генерировать свои собственные обоснования, а также учиться решать все более сложные проблемы. Применение STaR показало многообещающие результаты в задачах, связанных с арифметикой, математическими задачами и логическими рассуждениями. В CommonsenseQA STaR улучшился как по сравнению с базовым планом с несколькими выстрелами, так и по сравнению с базовым планом, точно настроенным для прямого прогнозирования ответов, и работал сравнимо с моделью, которая в 30 раз больше.

Помеченные контекстные подсказки

Концепция чего-либо 'Помеченные контекстные подсказки' вращается вокруг предоставления модели ИИ дополнительного уровня контекста путем пометки определенной информации во входных данных. Эти теги, по сути, действуют как указатели для ИИ, указывая ему, как правильно интерпретировать контекст и генерировать ответ, который является актуальным и основанным на фактах.

Представьте, что вы беседуете с другом на определённую тему, например, «шахматы». Вы делаете утверждение и добавляете к нему ссылку, например, «(источник: Википедия)». Теперь ваш друг, который в данном случае является моделью ИИ, точно знает, откуда вы получаете информацию. Такой подход направлен на повышение достоверности ответов ИИ за счёт снижения риска галлюцинаций, или генерации ложных фактов.

Уникальным аспектом тегированных контекстных подсказок является их потенциал для улучшения «контекстного интеллекта» моделей ИИ. Например, в статье это демонстрируется на примере разнообразного набора вопросов, взятых из различных источников, таких как краткие обзоры статей Википедии по различным темам и разделы недавно опубликованной книги. Вопросы тегированы, что предоставляет модели ИИ дополнительный контекст об источнике информации.

Этот дополнительный уровень контекста может оказаться невероятно полезным, когда дело доходит до генерации ответов, которые не только точны, но и соответствуют предоставленному контексту, делая выходные данные ИИ более надежными и заслуживающими доверия.

Заключение: взгляд на многообещающие методы и будущие направления

ChatGPT от OpenAI демонстрирует неисчерпаемый потенциал больших языковых моделей (LLM) для решения сложных задач с поразительной эффективностью. Передовые методы, такие как обучение с небольшим количеством попыток, подсказки ReAct, цепочка мыслей и STaR, позволяют нам использовать этот потенциал во множестве приложений. По мере того, как мы глубже изучаем нюансы этих методологий, мы понимаем, как они формируют ландшафт ИИ, предлагая более содержательное и безопасное взаимодействие между людьми и машинами.

Несмотря на такие проблемы, как конфликт знаний, чрезмерная зависимость от параметрических знаний и возможность возникновения галлюцинаций, эти модели ИИ при правильном быстром проектировании оказались преобразующими инструментами. Тонкая настройка инструкций, подсказки с учетом контекста и интеграция с внешними источниками данных еще больше расширяют их способность рассуждать, учиться и адаптироваться.