Искусственный интеллект

Cerebras представляет самое быстрое в мире решение для вывода искусственного интеллекта: 20-кратная скорость за небольшую часть стоимости

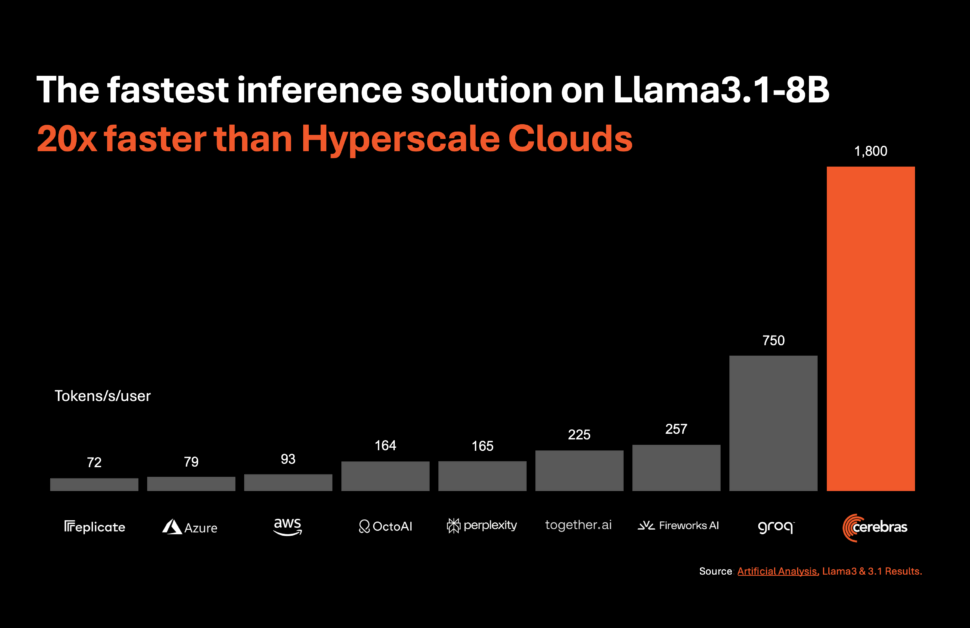

Церебральные Системы, пионер в области высокопроизводительных вычислений на основе искусственного интеллекта, представила революционное решение, которое должно произвести революцию в выводах искусственного интеллекта. 27 августа 2024 года компания объявила о запуске Cerebras Inference, самой быстрой в мире службы вывода ИИ. Благодаря показателям производительности, которые превосходят показатели традиционных систем на базе графических процессоров, Cerebras Inference обеспечивает в 20 раз большую скорость при незначительной стоимости, устанавливая новый стандарт в вычислениях с использованием искусственного интеллекта.

Беспрецедентная скорость и экономическая эффективность

Cerebras Inference разработан для обеспечения исключительной производительности различных моделей искусственного интеллекта, особенно в быстро развивающемся сегменте большие языковые модели (LLM). Например, он обрабатывает 1,800 токенов в секунду для модели Llama 3.1 8B и 450 токенов в секунду для модели Llama 3.1 70B. Эта производительность не только в 20 раз выше, чем у решений на базе графических процессоров NVIDIA, но и обходится значительно дешевле. Cerebras предлагает эту услугу по цене всего от 10 центов за миллион токенов для модели Llama 3.1 8B и от 60 центов за миллион токенов для модели Llama 3.1 70B, что представляет собой 100-кратное улучшение соотношения цены и производительности по сравнению с существующими предложениями на базе графических процессоров.

Сохранение точности при расширении границ скорости

Одним из наиболее впечатляющих аспектов Cerebras Inference является его способность поддерживать высочайшую точность, обеспечивая при этом непревзойденную скорость. В отличие от других подходов, которые жертвуют точностью ради скорости, решение Cerebras остается в пределах 16-битной области на протяжении всего процесса вывода. Это гарантирует, что прирост производительности не будет достигнут за счет качества результатов модели ИИ, что является решающим фактором для разработчиков, ориентированных на точность.

Мика Хилл-Смит, сооснователь и генеральный директор компании Artificial Analysis, подчеркнул значимость этого достижения: «Cerebras обеспечивает скорость на порядок выше, чем решения на базе графического процессора для моделей Meta Llama 3.1 8B и 70B AI. Мы измеряем скорость выше 1,800 токенов вывода в секунду на Llama 3.1 8B и выше 446 токенов вывода в секунду на Llama 3.1 70B — новый рекорд в этих тестах».

Растущая важность выводов ИИ

вывод ИИ — это самый быстрорастущий сегмент вычислений на базе искусственного интеллекта, на который приходится около 40% общего рынка аппаратного обеспечения для искусственного интеллекта. Появление высокоскоростного вывода искусственного интеллекта, такого как тот, который предлагает Cerebras, сродни внедрению широкополосного Интернета — оно открывает новые возможности и знаменует новую эру для приложений искусственного интеллекта. С помощью Cerebras Inference разработчики теперь могут создавать приложения искусственного интеллекта следующего поколения, требующие сложной производительности в реальном времени, такие как агенты искусственного интеллекта и интеллектуальные системы.

Эндрю Нг, основатель DeepLearning.AI, подчеркнул важность скорости в разработке ИИ: «DeepLearning.AI имеет несколько агентных рабочих процессов, которые требуют неоднократного запроса LLM для получения результата. Cerebras создала впечатляюще быструю функцию вывода, которая будет очень полезна для таких рабочих нагрузок.

Широкая поддержка отрасли и стратегическое партнерство

Cerebras заручилась мощной поддержкой лидеров отрасли и сформировала стратегическое партнерство для ускорения разработки приложений искусственного интеллекта. Ким Брэнсон, старший вице-президент по искусственному интеллекту и машинному обучению компании GlaxoSmithKline, одного из первых клиентов Cerebras, подчеркнул преобразующий потенциал этой технологии: «Скорость и масштаб меняют все».

Другие компании, такие как LiveKit, растерянностьи Meter также выразили энтузиазм по поводу влияния, которое Cerebras Inference окажет на их деятельность. Эти компании используют мощь вычислительных возможностей Cerebras для создания более отзывчивого, похожего на человека опыта искусственного интеллекта, улучшения взаимодействия с пользователем в поисковых системах и улучшения систем управления сетью.

Вывод Cerebras: уровни и доступность

Cerebras Inference доступен на трех уровнях по конкурентоспособным ценам: Free, Developer и Enterprise. Уровень бесплатного пользования обеспечивает бесплатный доступ к API с большими ограничениями на использование, что делает его доступным для широкого круга пользователей. Уровень разработчика предлагает гибкий вариант бессерверного развертывания: модели Llama 3.1 стоят 10 и 60 центов за миллион токенов. Уровень Enterprise предназначен для организаций с устойчивыми рабочими нагрузками, предлагая точно настроенные модели, индивидуальные соглашения об уровне обслуживания и специальную поддержку, а цены доступны по запросу.

Обеспечение вывода Cerebras: механизм масштабирования пластин 3 (WSE-3)

В основе Cerebras Inference лежит система Cerebras CS-3, работающая на базе ведущего в отрасли Wafer Scale Engine 3 (WSE-3). Этот процессор искусственного интеллекта не имеет себе равных по размеру и скорости: он предлагает в 7,000 раз большую пропускную способность памяти, чем NVIDIA H100. Огромный масштаб WSE-3 позволяет ему обслуживать множество одновременных пользователей, обеспечивая невероятную скорость без ущерба для производительности. Эта архитектура позволяет Cerebras обойти компромиссы, которые обычно возникают в системах на базе графических процессоров, обеспечивая лучшую в своем классе производительность для рабочих нагрузок ИИ.

Бесшовная интеграция и удобный для разработчиков API

Cerebras Inference разработан с учетом потребностей разработчиков. Он имеет API, который полностью совместим с API-интерфейсом OpenAI Chat Completions, что позволяет легко выполнять миграцию с минимальными изменениями кода. Такой удобный для разработчиков подход гарантирует максимально плавную интеграцию Cerebras Inference в существующие рабочие процессы, что позволяет быстро развертывать высокопроизводительные приложения искусственного интеллекта.

Cerebras Systems: внедрение инноваций в разных отраслях

Cerebras Systems — не только лидер в области вычислений на базе искусственного интеллекта, но и ключевой игрок в различных отраслях, включая здравоохранение, энергетику, правительство, научные вычисления и финансовые услуги. Решения компании сыграли важную роль в прорыве в таких учреждениях, как Национальные лаборатории, Алеф Альфа, Клиника Майо и GlaxoSmithKline.

Обеспечивая непревзойденную скорость, масштабируемость и точность, Cerebras позволяет организациям в этих секторах решать некоторые из наиболее сложных проблем в области искусственного интеллекта и за его пределами. Будь то ускорение разработки лекарств в здравоохранении или расширение вычислительных возможностей в научных исследованиях, Cerebras находится в авангарде инноваций.

Заключение: новая эра для вывода ИИ

Cerebras Systems устанавливает новый стандарт для вывода ИИ с запуском Cerebras Inference. Предлагая в 20 раз большую скорость, чем традиционные системы на базе графических процессоров, за небольшую часть стоимости, Cerebras не только делает искусственный интеллект более доступным, но и прокладывает путь для следующего поколения приложений искусственного интеллекта. Благодаря своим передовым технологиям, стратегическому партнерству и приверженности инновациям Cerebras готова привести индустрию искусственного интеллекта в новую эру беспрецедентной производительности и масштабируемости.

Для получения дополнительной информации о системах Cerebras и опробовании Cerebras Inference посетите сайт www.cerebras.ai.