Artificial Intelligence

UniTune: альтернативный нейронный метод редактирования изображений от Google

Google Research, кажется, атакует текстовое редактирование изображений с нескольких фронтов и, по-видимому, ждет, чтобы увидеть, что «берет». По горячим следам релиза на этой неделе Волшебная бумага, поисковый гигант предложил дополнительный метод на основе скрытой диффузии для выполнения невозможного в противном случае редактирования изображений на основе ИИ с помощью текстовых команд, на этот раз названный Юнитюн.

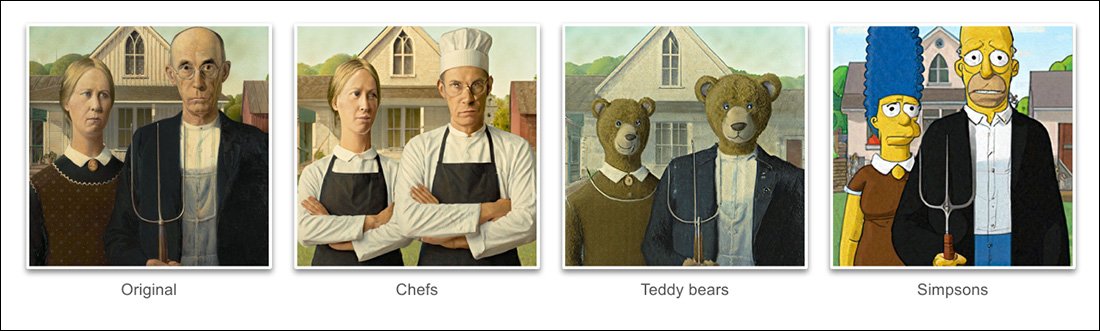

На примерах, приведенных в проекте Новый документ, UniTune достиг необычайной степени распутывание смысловой позы и идеи из фактического содержания жесткого изображения:

UniTune великолепно владеет семантической композицией. Обратите внимание, что в самом верхнем ряду изображений лица двух людей не были искажены экстраординарной трансформацией остальной части исходного изображения (справа). Источник: https://arxiv.org/pdf/2210.09477.pdf

Как уже знают поклонники стабильной диффузии, применение правок к частям изображения без неблагоприятного изменения остальной части изображения может быть сложной, а иногда и невозможной операцией. Хотя популярные дистрибутивы, такие как АВТОМАТ1111 может создавать маски для локальных и ограниченных правок, процесс сложный и часто непредсказуемый.

Очевидный ответ, по крайней мере для специалиста по компьютерному зрению, — добавить слой семантическая сегментация это способно распознавать и изолировать объекты на изображении без вмешательства пользователя, и, действительно, в последнее время было выдвинуто несколько новых инициатив в этом направлении.

Другой возможность для блокирования беспорядочных и запутанных нейронных операций редактирования изображений нужно использовать влиятельный Contrastive Language — Image Pre-training (CLIP) модуль, лежащий в основе моделей скрытой диффузии, таких как DALL-E 2 и Stable Diffusion, действует как фильтр в момент, когда модель преобразования текста в изображение готова отправить интерпретированный рендер обратно пользователю. . В этом контексте CLIP должен действовать как дозорный модуль и модуль контроля качества, отклоняя деформированные или иным образом неподходящие рендеры. Это собирается быть учрежденным (ссылка Discord) на портале Stability.ai DreamStudio, управляемом API.

Однако, поскольку CLIP, возможно, является как виновником, так и решением в таком сценарии (поскольку он, по сути, также информировал о том, как развивался образ), и поскольку требования к оборудованию могут превышать то, что, вероятно, будет доступно локально для конечного пользователя, этот подход не может быть идеальным.

Сжатый язык

Предлагаемый UniTune вместо этого «тонко настраивает» существующую модель распространения — в данном случае собственный Imagen от Google, хотя исследователи заявляют, что этот метод совместим с другими архитектурами скрытого распространения — так что в него вводится уникальный токен, который можно вызвать. включив его в текстовую подсказку.

На первый взгляд это звучит как Google будка мечты, в настоящее время навязчивая идея среди поклонников и разработчиков Stable Diffusion, которая может внедрять новых персонажей или объекты в существующую контрольную точку, часто менее чем за час, на основе нескольких исходных изображений; или еще как Текстовая инверсия, который создает «сопутствующие» файлы для контрольной точки, которые затем обрабатываются так, как если бы они были изначально обучены модели, и может использовать преимущества собственных обширных ресурсов модели, изменяя ее текстовый классификатор, в результате чего получается крошечный файл (по сравнению с минимум 2 Гб урезанных контрольных точек DreamBooth).

На самом деле, утверждают исследователи, UniTune отверг оба этих подхода. Они обнаружили, что Textual Inversion пропускает слишком много важных деталей, в то время как DreamBooth 'работает хуже и занимает больше времени' чем решение, на котором они наконец остановились.

Тем не менее, UniTune использует тот же подход с инкапсулированной семантической «метаподсказкой», что и DreamBooth, с обученными изменениями, вызываемыми уникальными словами, выбранными тренером, которые не будут конфликтовать ни с какими терминами, которые в настоящее время существуют в тщательно обученной модели общедоступного выпуска.

«Чтобы выполнить операцию редактирования, мы пробуем точно настроенные модели с подсказкой «[rare_tokens] edit_prompt» (например, «выбери двух собак в ресторане» или «выбери миньона»).

Процесс

Хотя непонятно, почему два почти идентичных документа с точки зрения их конечной функциональности должны поступить от Google на одной неделе, несмотря на огромное количество сходств между двумя инициативами, есть по крайней мере одно явное различие между UniTune и Imagic — последний использует «несжатые» подсказки на естественном языке для управления операциями редактирования изображений, тогда как UniTune обучается с помощью уникальных токенов в стиле DreamBooth.

Поэтому, если вы редактировали с помощью Imagic и хотели произвести такое преобразование…

Из статьи UniTune — UniTune противопоставляет себя любимому конкурирующему фреймворку Google для нейронного редактирования — SDEdit. Результаты UniTune показаны справа, а расчетная маска показана на втором изображении слева.

.. в Imagic вы должны ввести 'третье лицо, сидящее на заднем плане, в образе милого пушистого монстра'.

Эквивалентная команда UniTune будет «Парень сзади как [x]», Где x это какое-то странное и уникальное слово было связано с хорошо продуманной концепцией, связанной с характером пушистого монстра.

В то время как ряд изображений загружается либо в DreamBooth, либо в Textual Inversion с целью создания абстракции в стиле дипфейка, которой можно управлять во многих позах, и UniTune, и Imagic вместо этого загружают в систему одно изображение — исходное, первозданное изображение.

Это похоже на то, как работали многие инструменты редактирования на основе GAN за последние несколько лет — путем преобразования входного изображения в скрытые коды в скрытом пространстве GAN, а затем адресации этих кодов и отправки их в другие части скрытого пространства. пространство для модификации (т.е. ввод изображения молодого темноволосого человека и проецирование его через латентные коды, связанные со «старым» или «блондином» и т. д.).

Однако результаты в диффузионной модели и с помощью этого метода поразительно точны по сравнению с ними и гораздо менее неоднозначны:

Процесс тонкой настройки

Метод UniTune, по сути, отправляет исходное изображение через диффузионную модель с набором инструкций о том, как его следует изменить, используя обширные репозитории доступных данных, обученных в модели. По сути, вы можете сделать это прямо сейчас с помощью Stable Diffusion. img2img функциональность — но не без искажения или каким-то образом изменения частей изображения, которые вы бы предпочли сохранить.

В процессе UniTune система тонкая настройкаd, что означает, что UniTune заставляет модель возобновить обучение, при этом большинство ее слоев размораживаются (см. ниже). В большинстве случаев точная настройка снижает общее Генеральная значения потерь с трудом завоеванной высокопроизводительной модели в пользу введения или уточнения какого-либо другого аспекта, который желательно создать или улучшить.

Тем не менее, с UniTune кажется, что копия модели, над которой работали, хотя она может весить несколько гигабайт или больше, будет рассматриваться как одноразовая «шелуха» залога и отбрасываться в конце процесса, послужившей единственной цели. Этот случайный тоннаж данных становится ежедневным кризисом хранения для поклонников DreamBooth, чьи собственные модели, даже урезанные, занимают не менее 2 ГБ на предмет.

Как и в случае с Imagic, основная настройка в UniTune происходит на двух нижних из трех слоев в Imagen (базовый 64px, 64px>256px и 256px>1024px). В отличие от Imagic, исследователи видят некоторую потенциальную ценность в оптимизации настройки также для этого последнего и самого большого слоя сверхвысокого разрешения (хотя они еще не пытались этого сделать).

Для самого нижнего слоя в 64 пикселя модель смещается в сторону базового изображения во время обучения, при этом несколько повторяющихся пар изображения/текста загружаются в систему для 128 итераций при размере пакета 4 и с Адафактор как функция потерь, работающая со скоростью обучения 0.0001. Хотя Энкодер Т5 один замораживается во время этой тонкой настройки, он также замораживается во время первичного обучения Imagen

Описанная выше операция затем повторяется для слоя 64>256 пикселей с использованием той же процедуры увеличения шума, которая использовалась при первоначальном обучении Imagen.

Отбор проб

Существует много возможных методов выборки, с помощью которых сделанные изменения могут быть извлечены из точно настроенной модели, в том числе бесплатное руководство классификатора (CFG), опора также стабильной диффузии. CFG в основном определяет степень, в которой модель может «следовать своему воображению» и исследовать возможности рендеринга — или же, при более низких настройках, степень, в которой она должна придерживаться входных исходных данных и вносить менее радикальные или драматические изменения. .

Подобно текстовой инверсии (в меньшей степени с DreamBooth), UniTune позволяет применять различные графические стили к исходным изображениям, а также выполнять более фотореалистичное редактирование.

Исследователи также экспериментировали с SDПравитьметод «позднего старта», когда система поощряется сохранять исходные детали, будучи с самого начала лишь частично «шумом», но сохраняя при этом свои основные характеристики. Хотя исследователи использовали это только на самом нижнем из слоев (64 пикселя), они считают, что в будущем это может быть полезным дополнительным методом выборки.

Исследователи также использовали подсказка к подсказке в качестве дополнительного текстового метода для кондиционирования модели:

«В настройке «от подсказки к подсказке» мы обнаружили, что метод, который мы называем «Подсказка с подсказкой», особенно полезен для настройки точности и выразительности.

«Быстрое руководство» похоже на «Свободное руководство классификатора», за исключением того, что базовым уровнем является другое приглашение, а не безусловная модель. Это направляет модель к дельте между двумя подсказками».

Тем не менее, авторы заявляют, что быстрое руководство необходимо лишь изредка в тех случаях, когда CFG не дает желаемого результата.

Еще одним новым подходом к выборке, обнаруженным при разработке UniTune, был интерполяция, где области изображения достаточно различимы, так что исходное и измененное изображение очень похожи по составу, что позволяет использовать более «наивную» интерполяцию.

Интерполяция может сделать трудоемкие процессы UniTune излишними в случаях, когда подлежащие преобразованию области дискретны и хорошо ограничены.

Авторы предполагают, что интерполяция потенциально может работать настолько хорошо для большого количества целевых исходных изображений, что ее можно использовать в качестве настройки по умолчанию, а также отмечают, что она способна вызывать экстраординарные преобразования в случаях, когда сложные окклюзии не работают. необходимо вести переговоры более интенсивными методами.

UniTune может выполнять локальное редактирование с масками редактирования или без них, но также может в одностороннем порядке решать, где размещать изменения, с необычным сочетанием возможностей интерпретации и надежной эссенциализации исходных входных данных:

На самом верхнем изображении во втором столбце UniTune, которому было поручено вставить «красный поезд на заднем плане», поместил его в подходящее и аутентичное положение. Обратите внимание на другие примеры, как семантическая целостность исходного изображения сохраняется даже в условиях чрезвычайных изменений в пикселях и основных стилях изображений.

Задержка

Хотя первая итерация любой новой системы будет медленной, и хотя возможно, что либо участие сообщества, либо корпоративные обязательства (обычно не то и другое) в конечном итоге ускорят и оптимизируют ресурсоемкую процедуру, и UniTune, и Imagic выполняют некоторые довольно серьезные маневры машинного обучения для создания этих удивительных правок, и сомнительно, в какой степени такой ресурсоемкий процесс можно когда-либо масштабировать до внутреннего использования, а не до доступа через API (хотя последнее может быть более желательным для Google). ).

На данный момент путь от ввода до результата составляет около 3 минут на графическом процессоре T4 с дополнительными примерно 30 секундами для логического вывода (согласно любой процедуре логического вывода). Авторы признают, что это высокая задержка и ее вряд ли можно назвать «интерактивной», но они также отмечают, что модель остается доступной для дальнейшего редактирования после первоначальной настройки до тех пор, пока пользователь не завершит процесс, что сокращает время редактирования. .

Впервые опубликовано 21 октября 2022 г.