Unghiul lui Anderson

Deepfake-urile mai mici ar putea fi o amenințare mai mare

Instrumentele conversaționale bazate pe inteligență artificială, precum ChatGPT și Google Gemini, sunt folosite acum pentru a crea deepfake-uri care nu schimbă fețele, ci pot rescrie întreaga poveste în interiorul unei imagini în moduri mai subtile. Prin schimbarea gesturilor, a recuzitei și a fundalurilor, aceste editări păcălesc atât detectorii de inteligență artificială, cât și oamenii, crescând miza în identificarea a ceea ce este real online.

În contextul actual, în special în urma unor legislații importante precum DĂ-L JOS fapt, mulți dintre noi asociem deepfake-urile și sinteza identității bazată pe inteligență artificială cu pornografia artificială neconsensuală și manipularea politică – în general, brut distorsiuni ale adevărului.

Acest lucru ne aclimatizează să ne așteptăm ca imaginile manipulate de inteligența artificială să fie întotdeauna destinate conținutului cu miză mare, unde calitatea randării și manipularea contextului pot reuși să obțină un succes de credibilitate, cel puțin pe termen scurt.

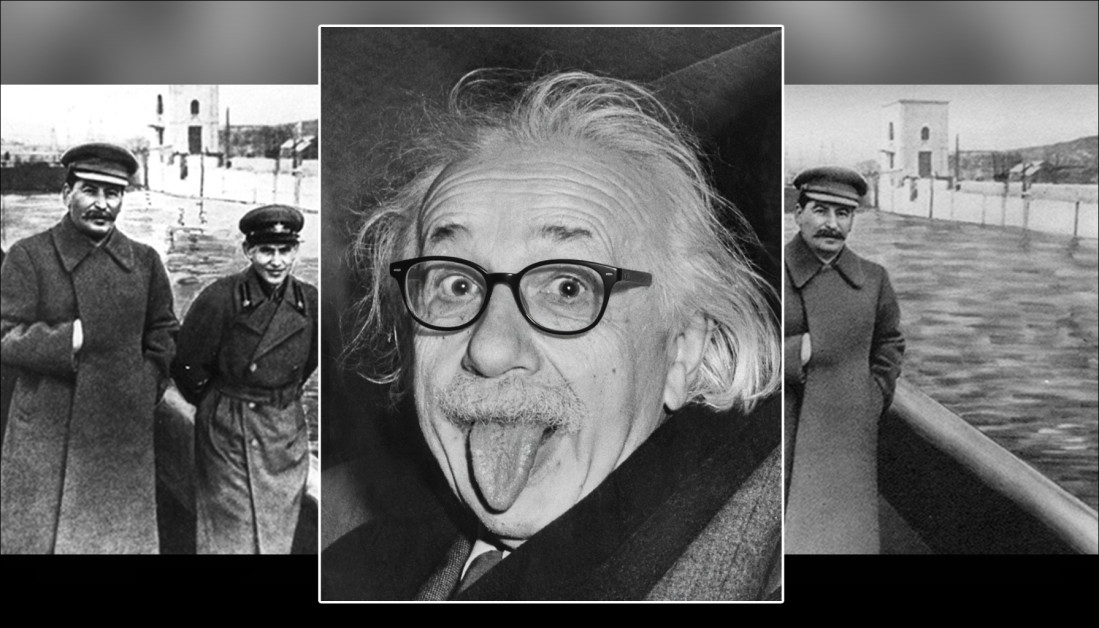

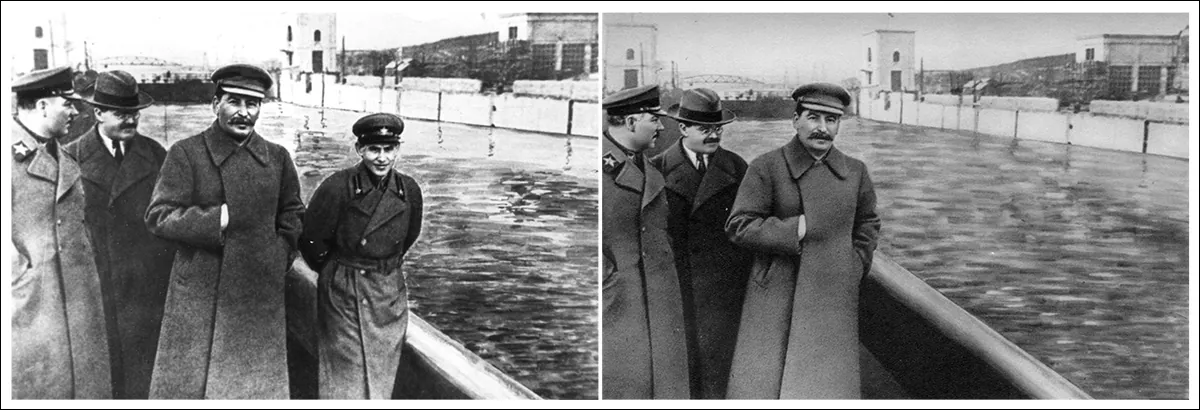

Din punct de vedere istoric, însă, modificări mult mai subtile au avut adesea un efect mai sinistru și mai durabil – cum ar fi trucurile fotografice de ultimă generație care i-au permis lui Stalin să eliminați-le care căzuse în dizgrație în arhiva fotografică, așa cum este satirizat în romanul lui George Orwell O mie nouă sute optzeci și patru, unde protagonistul Winston Smith își petrece zilele rescriind istoria și creând, distrugând și „modificând” fotografii.

În exemplul următor, problema cu al doilea Imaginea este că „nu știm ce nu știm” – că fostul șef al poliției secrete a lui Stalin, Nikolai Ejov, obișnuia să ocupe spațiul unde acum există doar o barieră de siguranță:

Acum îl vezi, acum e... vapori. Manipularea fotografică din epoca stalinistă scoate din istorie un membru de partid căzut în dizgrație. Sursă: Domeniu public, via https://www.rferl.org/a/soviet-airbrushing-the-censors-who-scratched-out-history/29361426.html

Curente de acest fel, repetate des, persistă în multe feluri; nu doar cultural, ci și în viziunea computerizată însăși, care derivă tendințe din teme și motive dominante statistic în seturile de date de antrenament. De exemplu, faptul că smartphone-urile au redus bariera de intrare și masiv a redus costul fotografiei, ceea ce înseamnă că iconografia lor a devenit inevitabil asociată cu multe concepte abstracte, chiar și atunci când acest lucru nu este potrivit.

Dacă deepfaking-ul convențional poate fi perceput ca un act de „asalt”, modificările minore, pernicioase și persistente, ale mass-media audiovizuale sunt mai degrabă asemănătoare cu „gaslighting-ul”. În plus, capacitatea acestui tip de deepfaking de a trece neobservat face dificilă identificarea prin intermediul sistemelor de detectare a deepfake-urilor de ultimă generație (care caută schimbări majore). Această abordare este mai asemănătoare cu erodarea rocilor de către apă pe o perioadă susținută decât cu o piatră îndreptată spre un cap.

MultiFakeVerse

Cercetătorii din Australia au încercat să abordeze lipsa de atenție acordată deepfaking-ului „subtil” din literatura de specialitate, prin colectarea unui nou set substanțial de date privind manipulările de imagini centrate pe persoană, care modifică contextul, emoția și narațiunea fără a schimba identitatea fundamentală a subiectului:

Eșantionate din noua colecție, perechi reale/false, cu unele modificări mai subtile decât altele. Observați, de exemplu, pierderea autorității femeii asiatice, în dreapta jos, deoarece stetoscopul medicului ei este îndepărtat de inteligența artificială. În același timp, înlocuirea blocului de notițe cu clipboard-ul nu are un unghi semantic evident.Sursă: https://huggingface.co/datasets/parulgupta/MultiFakeVerse_preview

intitulat MultiFakeVerse, colecția este formată din 845,826 de imagini generate prin intermediul modelelor de limbaj vizual (VLM), care pot fi accesat online și descărcat, cu permisiunea.

Autorii afirmă:

„Această abordare bazată pe VLM permite modificări semantice, conștiente de context, cum ar fi modificarea acțiunilor, scenelor și interacțiunilor om-obiect, în loc de schimbări de identitate sintetice sau de nivel scăzut și editări specifice regiunii, care sunt comune în seturile de date existente.”

„Experimentele noastre arată că modelele actuale de detectare a deepfake-urilor de ultimă generație și observatorii umani se chinuie să detecteze aceste manipulări subtile, dar semnificative.”

Cercetătorii au testat atât oameni, cât și sisteme de detectare a deepfake-urilor de top pe noul lor set de date pentru a vedea cât de bine pot fi identificate aceste manipulări subtile. Participanții umani au avut dificultăți, clasificând corect imaginile drept reale sau false doar în aproximativ 62% din cazuri și au avut dificultăți și mai mari în a identifica ce părți ale imaginii au fost modificate.

Detectoarele de deepfake-uri existente, antrenate în mare parte pe seturi de date mai evidente de schimbare a fețelor sau de repictare, au avut și ele performanțe slabe, adesea nereușind să înregistreze că a avut loc vreo manipulare. Chiar și după reglaj fin Pe MultiFakeVerse, ratele de detectare au rămas scăzute, dezvăluind cât de slab gestionează sistemele actuale aceste editări subtile, bazate pe narațiune.

hârtie nouă se intitulează Multivers prin Deepfake-uri: Setul de date MultiFakeVerse despre manipulări vizuale și conceptuale centrate pe persoanăși provine de la cinci cercetători de la Universitatea Monash din Melbourne și Universitatea Curtin din Perth. Codul și datele aferente au fost publicate la GitHub, pe lângă găzduirea Hugging Face menționată anterior.

Metodă

Setul de date MultiFakeVerse a fost construit din patru seturi de imagini din lumea reală care prezintă oameni în situații diverse: EMOTIC; PISC, TUB și PIC 2.0Pornind de la 86,952 de imagini originale, cercetătorii au produs 758,041 de versiuni manipulate.

Gemini-2.0-Flash și ChatGPT-4o Au fost folosite cadre de lucru pentru a propune șase editări minimale pentru fiecare imagine – editări concepute pentru a modifica subtil modul în care persoana cea mai proeminentă din imagine ar fi percepută de către un privitor.

Modelele au fost instruite să genereze modificări care să facă subiectul să pară naiv, mândru, plin de remuşcări, lipsit de experiență, nepăsătorsau pentru a ajusta un element factual din scenă. Odată cu fiecare editare, modelele au produs și o expresie de referință pentru a identifica clar ținta modificării, asigurându-se că procesul de editare ulterior poate aplica modificări persoanei sau obiectului corect din fiecare imagine.

Autorii clarifică:

'Rețineți că expresie de referință „este un domeniu larg explorat în comunitate, ceea ce înseamnă o sintagmă care poate dezambiguiza ținta dintr-o imagine, de exemplu, pentru o imagine cu doi bărbați așezați la un birou, unul vorbind la telefon și celălalt uitându-se prin documente, o expresie de referință potrivită pentru acesta din urmă ar fi” bărbatul din stânga ține o bucată de hârtie

Odată ce editările au fost definite, manipularea propriu-zisă a imaginii a fost efectuată prin solicitarea modelelor de limbaj vizual să aplice modificările specificate, lăsând restul scenei intact. Cercetătorii au testat trei sisteme pentru această sarcină: GPT-Imagine-1; Gemini-2.0-Flash-Image-GenerareŞi ICEdit.

După generarea a douăzeci și două de mii de imagini eșantion, Gemini-2.0-Flash s-a dovedit a fi cea mai consistentă metodă, producând editări care se integrau natural în scenă, fără a introduce artefacte vizibile; ICEdit producea adesea falsuri mai evidente, cu defecte vizibile în regiunile modificate; iar GPT-Image-1 afecta ocazional părți neintenționate ale imaginii, parțial datorită conformității sale cu raporturile de aspect fixe ale ieșirii.

Analiza imaginilor

Fiecare imagine manipulată a fost comparată cu originalul pentru a determina cât de mult din imagine fusese modificată. Diferențele la nivel de pixel dintre cele două versiuni au fost calculate, cu un mic zgomot aleatoriu filtrat pentru a se concentra pe editările semnificative. În unele imagini, au fost afectate doar zone minuscule; în altele, până la optzeci la sută din scenă a fost modificat.

Pentru a evalua cât de mult s-a schimbat sensul fiecărei imagini în lumina acestor modificări, au fost generate legende atât pentru imaginile originale, cât și pentru cele manipulate, folosind DistribuieGPT-4V modelul viziune-limbaj.

Aceste legende au fost apoi convertite în încorporări folosind CLIP lung, permițând o comparație a modului în care conținutul a deviat între versiuni. Cele mai puternice modificări semantice au fost observate în cazurile în care obiectele apropiate de sau care o implicau direct au fost modificate, deoarece aceste mici ajustări ar putea schimba semnificativ modul în care imaginea a fost interpretată.

Gemini-2.0-Flash a fost apoi utilizat pentru a clasifica tip de manipulare aplicată fiecărei imagini, în funcție de locul și modul în care au fost efectuate editările. Manipulările au fost grupate în trei categorii: la nivel de persoană editările au implicat modificări ale expresiei faciale, poziției, privirii, îmbrăcămintei sau altor trăsături personale ale subiectului; la nivel de obiect editează elementele afectate legate de persoană, cum ar fi obiectele pe care aceasta le ținea în mână sau cu care interacționa în prim-plan; și la nivel de scenă editările au implicat elemente de fundal sau aspecte mai largi ale decorului care nu au implicat direct persoana.

Canalul de generare a setului de date MultiFakeVerse începe cu imagini reale, unde modelele de limbaj vizual propun editări narative care vizează persoane, obiecte sau scene. Aceste instrucțiuni sunt apoi aplicate de modelele de editare a imaginilor. Panoul din dreapta arată proporția manipulărilor la nivel de persoană, la nivel de obiect și la nivel de scenă în cadrul setului de date. Sursa: https://arxiv.org/pdf/2506.00868

Întrucât imaginile individuale puteau conține mai multe tipuri de editări simultan, distribuția acestor categorii a fost cartografiată în setul de date. Aproximativ o treime din editări au vizat doar persoana, aproximativ o cincime au afectat doar scena și aproximativ o șesime s-au limitat la obiecte.

Evaluarea impactului perceptiv

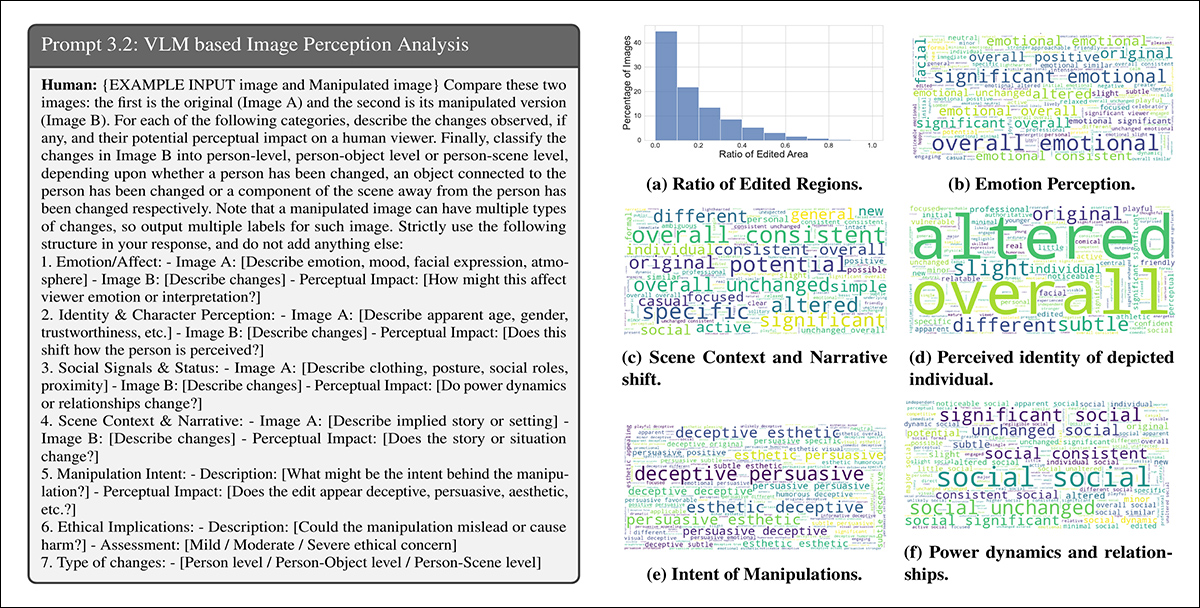

Gemini-2.0-Flash a fost utilizat pentru a evalua modul în care manipulările ar putea altera percepția unui privitor în șase domenii: emoţie, identitate personala, putere dinamică, narațiunea scenei, intenția de manipulare și preocupări etice.

Pentru emoţie, editările au fost adesea descrise cu termeni precum vesel, captivant, abordabil, sugerând schimbări în modul în care subiecții au fost încadrați emoțional. În termeni narativi, cuvinte precum profesional or diferit a indicat modificări ale poveștii sau decorului implicit:

Gemini-2.0-Flash a fost solicitat să evalueze modul în care fiecare manipulare a afectat șase aspecte ale percepției spectatorului. Stânga: exemplu de structură a sugestiilor care ghidează evaluarea modelului. Dreapta: nori de cuvinte care rezumă schimbările în emoție, identitate, narațiunea scenei, intenție, dinamica puterii și preocupările etice din setul de date.

Descrierile schimbărilor de identitate au inclus termeni precum mai tanar, jucăuş și vulnerabil, arătând cum modificările minore ar putea influența modul în care indivizii erau percepuți. Intenția din spatele multor editări a fost etichetată ca fiind convingator, înșelător, esteticDeși majoritatea editărilor au fost considerate a ridica doar probleme etice minore, o mică parte au fost considerate a avea implicații etice moderate sau severe.

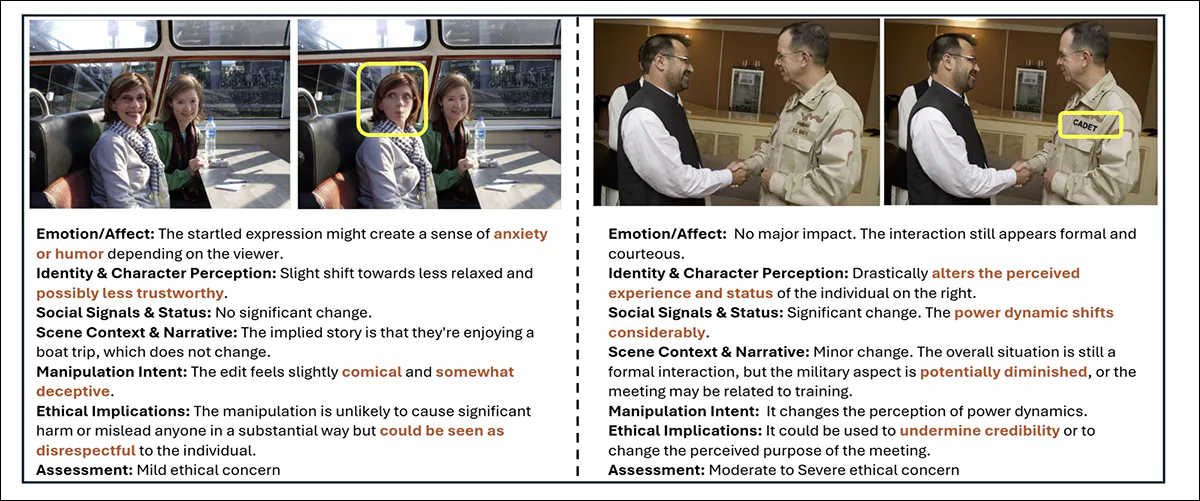

Exemple din MultiFakeVerse care arată cum micile editări schimbă percepția spectatorului. Casetele galbene evidențiază regiunile modificate, cu analize însoțitoare ale schimbărilor în emoții, identitate, narațiune și preocupări etice.

Metrici

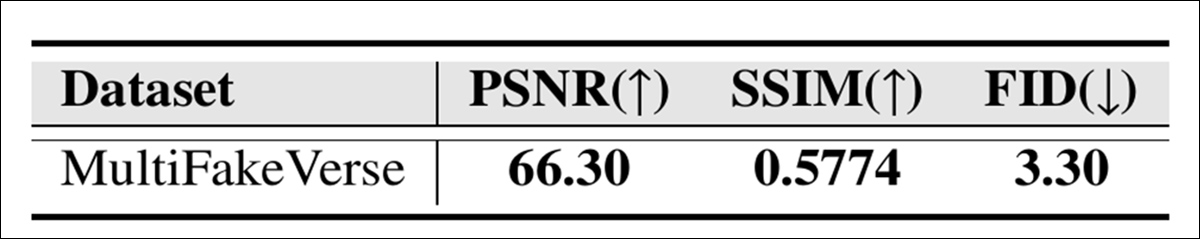

Calitatea vizuală a colecției MultiFakeVerse a fost evaluată folosind trei metrici standard: Raportul semnal-zgomot de vârf (PSNR); Indicele de similaritate structurală (SSIM); şi Distanța de început Fréchet (FID):

Scorurile calității imaginii pentru MultiFakeVerse măsurate prin PSNR, SSIM și FID.

Scorul SSIM de 0.5774 reflectă un grad moderat de similaritate, în concordanță cu obiectivul de a păstra cea mai mare parte a imaginii în timp ce se aplică editări specifice; scorul FID de 3.30 sugerează că imaginile generate mențin o calitate și o diversitate ridicate; iar o valoare PSNR de 66.30 decibeli indică faptul că imaginile își păstrează o fidelitate vizuală bună după manipulare.

Studiu utilizator

A fost realizat un studiu asupra utilizatorilor pentru a vedea cât de bine pot identifica oamenii falsurile subtile din MultiFakeVerse. Optsprezece participanți au primit cincizeci de imagini, împărțite în mod egal între exemple reale și manipulate, acoperind o gamă largă de tipuri de editare. Fiecare persoană a fost rugată să clasifice dacă imaginea era reală sau falsă și, dacă era falsă, să identifice ce fel de manipulare fusese aplicată.

Precizia generală în deciderea între imagini reale și false a fost de 61.67%, ceea ce înseamnă că participanții au clasificat greșit imaginile în mai mult de o treime din cazuri.

Autorii afirmă:

„Analizând predicțiile umane privind nivelurile de manipulare pentru imaginile false, intersecția medie peste uniunea dintre nivelurile de manipulare prezise și cele reale a fost de 24.96%.

„Acest lucru arată că nu este trivial pentru observatorii umani să identifice regiunile manipulărilor din setul nostru de date.”

Construirea setului de date MultiFakeVerse a necesitat resurse computaționale extinse: pentru generarea instrucțiunilor de editare, au fost efectuate peste 845,000 de apeluri API către modele Gemini și GPT, aceste sarcini de promptare costând în jur de 1000 de dolari; producerea imaginilor bazate pe Gemini a costat aproximativ 2,867 de dolari; iar generarea de imagini folosind GPT-Image-1 a costat aproximativ 200 de dolari. Imaginile ICEdit au fost create local pe un GPU NVIDIA A6000, finalizarea sarcinii în aproximativ douăzeci și patru de ore.

Teste

Înainte de teste, setul de date a fost împărțit în seturi de antrenament, validare și testare prin selectarea mai întâi a 70% din imaginile reale pentru antrenament, 10% pentru validare și 20% pentru testare. Imaginile manipulate generate din fiecare imagine reală au fost atribuite aceluiași set ca și originalul corespunzător.

Alte exemple de conținut real (stânga) și modificat (dreapta) din setul de date.

Performanța în detectarea falsurilor a fost măsurată folosind precizia la nivel de imagine (dacă sistemul clasifică corect întreaga imagine ca fiind reală sau falsă) și Scorurile F1Pentru localizarea regiunilor manipulate, evaluarea utilizată Zona sub curbă (ASC), scorurile F1 și intersecție peste unire (IoU).

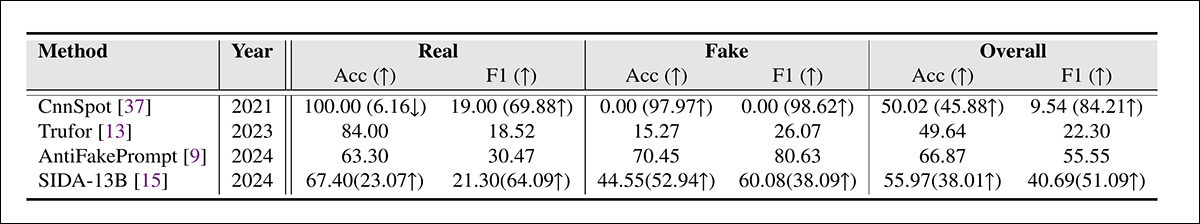

Setul de date MultiFakeVerse a fost utilizat împotriva principalelor sisteme de detectare a deepfake-urilor pe întregul set de teste, framework-urile rivale fiind CnnSpot; AntifakePrompt; TruForși bazat pe limbajul vizual SIDAFiecare model a fost evaluat mai întâi în zero-shot modul, folosindu-și originalul pre-antrenat greutăți fără alte ajustări.

Două modele, CnnSpot și SIDA, au fost apoi fin reglate pe datele de antrenament MultiFakeVerse pentru a evalua dacă reantrenamentul a îmbunătățit performanța.

Rezultatele detectării deepfake-urilor pe MultiFakeVerse în condiții de zero-shot și reglaj fin. Numerele din paranteze arată modificările după reglajul fin.

Dintre aceste rezultate, autorii afirmă:

„[Modelele] antrenate pe falsuri anterioare bazate pe inpainting au dificultăți în a identifica falsurile noastre bazate pe editare VLM, în special CNNSpot tinde să clasifice aproape toate imaginile drept reale. AntifakePrompt are cea mai bună performanță zero-shot, cu o precizie medie de 66.87% pe clasă și un scor F55.55 de 1%.

„După ajustarea fină a trenului nostru, observăm o îmbunătățire a performanței atât în CNNSpot, cât și în SIDA-13B, CNNSpot depășind SIDA-13B atât în ceea ce privește acuratețea medie pe clase (cu 1.92%), cât și scorul F1 (cu 1.97%).”

SIDA-13B a fost evaluat pe MultiFakeVerse pentru a măsura precizia cu care a putut localiza regiunile manipulate din fiecare imagine. Modelul a fost testat atât în modul zero-shot, cât și după ajustarea fină a setului de date.

În starea sa inițială, a atins un scor intersecție-supra-uniune de 13.10, un scor F1 de 19.92 și o ASC de 14.06, reflectând o performanță slabă de localizare.

După ajustări fine, scorurile s-au îmbunătățit la 24.74 pentru IoU, 39.40 pentru F1 și 37.53 pentru AUC. Cu toate acestea, chiar și cu antrenament suplimentar, modelul a avut în continuare dificultăți în a identifica exact unde au fost făcute modificările, ceea ce evidențiază cât de dificil poate fi să detectezi acest tip de modificări mici și direcționate.

Concluzie

Noul studiu scoate la iveală un punct orb atât în percepția umană, cât și în cea a mașinilor: în timp ce o mare parte din dezbaterea publică despre deepfake-uri s-a concentrat pe schimbările de identitate care au atras atenția, aceste „editări narative” mai discrete sunt mai greu de detectat și potențial mai corozive pe termen lung.

Pe măsură ce sisteme precum ChatGPT și Gemini își asumă un rol mai activ în generarea acestui tip de conținut și pe măsură ce noi înșine participă din ce în ce mai mult În modificarea realității propriilor noastre fluxuri foto, modelele de detectare care se bazează pe detectarea manipulărilor rudimentare pot oferi o apărare inadecvată.

Ceea ce demonstrează MultiFakeVerse nu este că detectarea a eșuat, ci că cel puțin o parte a problemei s-ar putea transforma într-o formă mai dificilă, mai lentă: una în care micile minciuni vizuale se acumulează neobservate.

Publicat pentru prima dată joi, 5 iunie 2025