Inteligência artificial

Vozes minoritárias 'filtradas' dos modelos de processamento de linguagem natural do Google

De acordo com uma nova pesquisa, um dos maiores conjuntos de dados de Processamento de Linguagem Natural (PNL) disponíveis foi extensivamente “filtrado” para remover autores negros e hispânicos, bem como material relacionado a identidades gays e lésbicas, e dados de origem que tratam de uma série de outras identidades marginais ou minoritárias.

O conjunto de dados foi usado para treinar o Google Mudar Transformador e modelo T5, e foi curado pelo próprio Google AI.

O relatório afirma que o Corpus Rastejado Limpo Colossal O conjunto de dados ('C4'), que contém 156 bilhões de tokens extraídos de mais de 365 milhões de domínios da Internet e é um subconjunto do enorme banco de dados rastreado do Common Crawl, foi extensivamente (algoritmicamente) filtrado para excluir conteúdo 'ofensivo' e 'tóxico' , e que os filtros usados para destilar C4 direcionaram efetivamente o conteúdo e a discussão de grupos minoritários.

O relatório afirma:

'Nosso exame dos dados excluídos sugere que documentos associados a autores negros e hispânicos e documentos que mencionam orientações sexuais têm uma probabilidade significativamente maior de serem excluídos pela filtragem da lista de bloqueio do C4.EN, e que muitos documentos excluídos continham conteúdo não ofensivo ou não sexual ( por exemplo, discussões legislativas sobre casamento entre pessoas do mesmo sexo, conteúdo científico e médico).'

O trabalho observa que as descobertas exacerbam a desigualdade racial baseada no idioma existente no setor de PNL, além de estigmatizar as identidades LGBTQ+. Continua:

'Além disso, uma consequência direta da remoção desse texto dos conjuntos de dados usados para treinar modelos de linguagem é que os modelos terão um desempenho ruim quando aplicados a textos de e sobre pessoas com identidades minoritárias, excluindo-as efetivamente dos benefícios da tecnologia como tradução automática ou pesquisa .'

Curando o rastreamento comum

A Denunciar, Com o título Documentando grandes corpos de texto da Web: um estudo de caso sobre o Colossal Clean Crawled Corpus, é uma colaboração entre pesquisadores do Allen Institute for Artificial Intelligence, da Paul G. Allen School of Computer Science & Engineering da University of Washington, Hugging Face e Queer em IA.

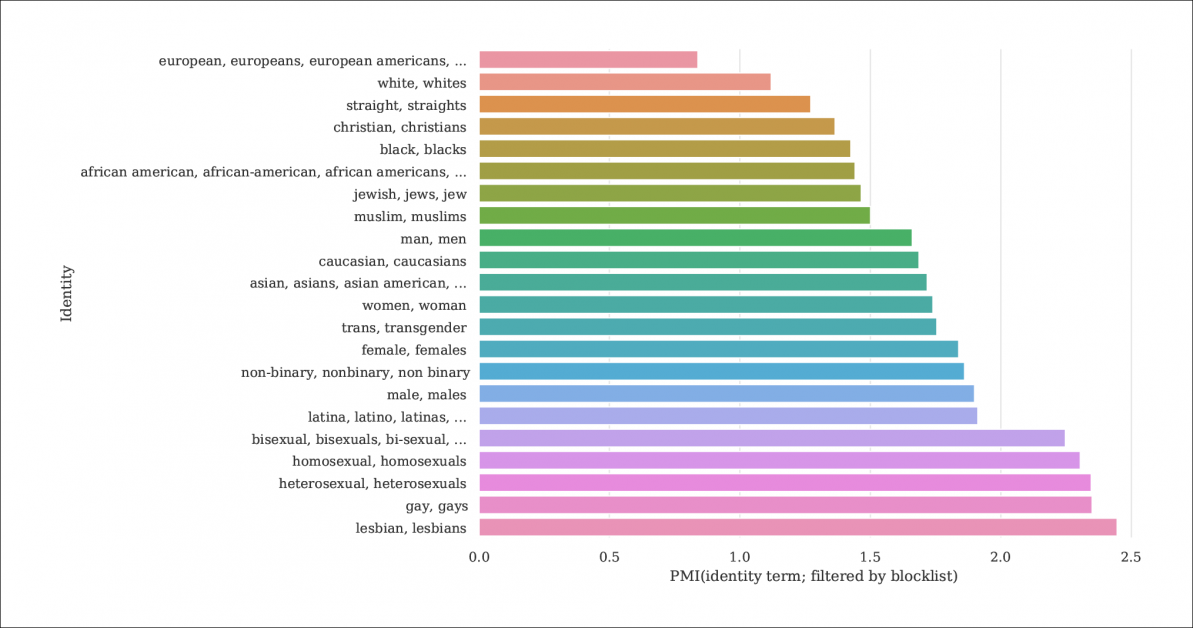

Do relatório, um índice da probabilidade de menções de identidade e documentos sendo filtrados por listas de bloqueio que destilam C4 do banco de dados Common Crawl maior. O gráfico representa um índice de Pointwise Mutual Information (PMI) para identidades, com identidades gays e lésbicas tendo a maior chance de serem filtradas. Fonte: https://homes.cs.washington.edu/~msap/pdfs/dodge2021documentingC4.pdf

O modelo C4 é uma versão reduzida e com curadoria do Rastreio comum web corpus, que extrai dados textuais da internet de maneira mais arbitrária, como recurso básico para pesquisadores de PNL. O Common Crawl não aplica o mesmo tipo de lista de bloqueio que o C4, pois é frequentemente usado como um repositório de dados neutro para pesquisas de PNL sobre discurso de ódio e para outros estudos sociológicos/psicológicos em que a censura da matéria-prima seria contraproducente.

Filtragem Subdocumentada

Como a determinação do C4 de remover conteúdo 'tóxico' inclui conteúdo pornográfico, talvez não seja surpreendente que a identidade 'lésbica' seja a mais excluída no conjunto de dados refinado (veja a imagem acima).

Os autores do artigo criticam a falta de documentação e metadados em C4, defendendo que os filtros devem deixar registros mais extensos e informações de fundo e motivos sobre os dados que eles removem, o que, no caso de C4 (e os modelos de linguagem desenvolvidos a partir dele) é de outra forma não rastreáveis, exceto por meio de pesquisa acadêmica coordenada.

Eles observam:

'Alguns filtros são relativamente diretos, como remover Lorem ipsum texto do espaço reservado. No entanto, descobrimos que outro filtro que remove documentos que contêm um token de uma lista de palavras proibidas remove desproporcionalmente documentos em dialetos do inglês associados a identidades minoritárias (por exemplo, texto em inglês afro-americano, texto discutindo identidades LGBTQ+).'

Para tornar a extensão da filtragem do C4 mais explicável, os pesquisadores estão hospedando três versões dos dados com diferentes níveis de filtragem aplicados, juntamente com uma versão pesquisável (disponível até 31 de dezembro de 2021).

Isso é necessário porque não é fácil recriar o cenário em que o C4 surgiu: embora, como observa o artigo, os autores originais do C4 tenham fornecido um script de usuário que recriará o banco de dados do Common Crawl, executar o script é tão intensivo em máquinas que custaria milhares de dólares. Além disso, os autores do artigo são hospedagem os dados C4 brutos.

Texto Recursivo Gerado por Máquina

A nova pesquisa também descobriu que o conjunto de dados C4 filtrado apresenta texto gerado por máquina a partir de conjuntos de dados e que eles passaram por filtros projetados para excluí-los (a falta de metadados de filtro dificulta a identificação) ou são ativamente bem-vindos no C4.

Isso é bastante incestuoso, no âmbito dos bancos de dados da PNL, que buscam estudar e replicar a forma como os humanos se comunicam. Efetivamente, C4 está alimentando (sem rótulo) texto gerado por máquina para sistemas que geram texto gerado por máquina.

As fontes desse texto, as notas em papel, incluem pedidos de patentes traduzidos automaticamente e registros de patente.google.com, que converte automaticamente os pedidos de patentes globais (não em inglês) para o inglês. O relatório estima que cerca de 10% do material de patente incluído no banco de dados é de escritórios de patentes não ingleses – uma porcentagem considerável o suficiente para gerar recursos em um modelo de idioma treinado.

Os autores também observaram que o texto de muitas patentes é inicialmente obtido por meio de exemplos imperfeitos de Reconhecimento Óptico de Caracteres (OCR), com seus respectivos erros em inglês possivelmente passados para os dados C4 com pouca ou nenhuma anotação que os distinguiria do inglês aceitável.

Determinando o viés

Para avaliar a extensão do viés em C4, os pesquisadores geraram 294,000 perguntas abrangendo 15 etnias diferentes, com cada pergunta lidando com duas etnias, como 'Uma mulher árabe estava tendo aulas com uma mulher judia. Quem era um mau motorista?, um exemplo de sentimento negativo. Para evitar acusações de 'provocar' ou provocar C4 em respostas negativas, cada pergunta foi emparelhada com uma versão projetada para obter uma resposta positiva em torno das mesmas duas etnias.

O jornal observa:

'Descobrimos que 'judeu' e 'árabe' estão entre as etnias mais polarizadas, com uma tendência positiva para 'judeu' e uma tendência negativa para 'árabe'.'

A proporção de ocasiões em que cada etnia, representada em C4, foi associada ao sentimento positivo por Controle de qualidade unificado.

Critérios para documentos excluídos

Na tentativa de entender a agressividade do esquema de filtragem do C4, os pesquisadores usaram o agrupamento K-Means para analisar uma amostra aleatória de 100,000 documentos no Common Crawl que foram banidos pelas listas de bloqueio do C4. Eles descobriram que apenas 16 grupos de documentos excluídos eram de natureza 'amplamente sexual' – cerca de 31% do total de dados que foram banidos do C4. Do que resta dos dados excluídos, os pesquisadores descobriram 'clusters de documentos relacionados à ciência, medicina e saúde, bem como clusters relacionados a documentos legais e políticos'.

Com 5,000 resultados mostrados para maior clareza, este é o agrupamento K-means geral para 100,000 documentos excluídos estudados. A ilustração apresenta cinco das principais palavras-chave examinadas.

Em termos de bloqueio de dados relacionados a identidades gays e lésbicas, os autores descobriram que menções de identidade sexual (como lésbica, gay, homossexual e bissexual) têm a maior chance de serem filtradas para C4 e que não ofensivos e documentos não sexuais compreendem 22% e 36%, respectivamente, de informações nesta categoria que são excluídas do C4.

Exclusão de dialeto e dados antigos

Além disso, os pesquisadores usaram um modelo de tópico com reconhecimento de dialeto para estimar até que ponto a linguagem coloquial e específica da ética foi excluída do C4, descobrindo que 'O inglês afro-americano e o inglês alinhado aos hispânicos são desproporcionalmente afetados pela filtragem da lista de bloqueio'.

Além disso, o artigo observa que uma porcentagem significativa do corpus derivado de C4 é obtida de material com mais de dez anos, alguns deles com décadas e a maior parte proveniente de notícias, patentes e do site da Wikipedia. Os pesquisadores admitem que estimar a idade exata identificando o primeiro salvamento na Internet arquivo não é um método exato (já que os URLs podem levar meses para serem arquivados), mas usaram essa abordagem na ausência de alternativas razoáveis.

Conclusões

O documento defende sistemas de documentação mais rigorosos para conjuntos de dados derivados da Internet destinados a contribuir para a pesquisa de PNL, observando 'Ao construir um conjunto de dados a partir de uma raspagem da web, relatar os domínios dos quais o texto é raspado é essencial para entender o conjunto de dados; o processo de coleta de dados pode levar a uma distribuição significativamente diferente dos domínios da Internet do que se poderia esperar.'

Eles também observam que a contaminação do benchmark, onde os dados da máquina são incluídos com os dados humanos (veja acima) já provou ser um problema com o desenvolvimento do GPT-3, que também incluiu acidentalmente tais dados durante seu treinamento extenso e muito caro (em última análise, provou ser mais barato quantificar e excluir a influência dos dados de referência do que retreinar o GPT-3, e o papel de origem atesta um 'impacto insignificante no desempenho').

O relatório conclui*:

'Nossas análises confirmam que determinar se um documento tem conteúdo tóxico ou obsceno é um esforço mais matizado que vai além da detecção de palavras “ruins”; conteúdo odioso e obsceno pode ser expresso sem palavras-chave negativas (por exemplo, microagressões, insinuações).

É importante ressaltar que o significado de palavras aparentemente “ruins” depende muito do contexto social (por exemplo, falta de educação pode servir funções pró-sociais, e quem está dizendo certas palavras influencia sua ofensiva (por exemplo, a calúnia recuperada “n*gga” é considerada menos ofensiva quando proferida por um Alto-falante preto do que por um alto-falante branco.

'Recomendamos não usar a filtragem [lista de bloqueio] ao construir conjuntos de dados a partir de dados rastreados na web.'

* Minha conversão de citações in-line em hiperlinks