Inteligência artificial

Difusão de vídeo estável: modelos de difusão de vídeo latente para grandes conjuntos de dados

IA generativa tem sido uma força motriz na comunidade de IA já há algum tempo, e os avanços feitos no campo da modelagem generativa de imagens, especialmente com o uso de modelos de difusão, ajudaram os modelos generativos de vídeo a progredir significativamente, não apenas na pesquisa, mas também em termos de aplicações do mundo real. Convencionalmente, os modelos de vídeo generativos são treinados do zero ou são parcialmente ou completamente ajustados a partir de modelos de imagem pré-treinados com camadas temporais extras, em uma mistura de conjuntos de dados de imagem e vídeo.

Avançando nos avanços nos modelos de vídeo generativos, neste artigo falaremos sobre o Modelo de difusão de vídeo estável, um modelo de difusão de vídeo latente capaz de gerar conteúdo de imagem para vídeo e texto para vídeo de alta resolução e de última geração. Falaremos sobre como os modelos de difusão latente treinados para sintetizar imagens 2D melhoraram as habilidades e a eficiência dos modelos de vídeo generativos, adicionando camadas temporais e ajustando os modelos em pequenos conjuntos de dados que consistem em vídeos de alta qualidade. Iremos nos aprofundar na arquitetura e no funcionamento do modelo de difusão de vídeo estável, avaliar seu desempenho em várias métricas e compará-lo com as estruturas de última geração atuais para geração de vídeo. Então vamos começar.

Modelo de difusão de vídeo estável e modelos de vídeo generativos: uma introdução

Graças ao seu potencial quase ilimitado, a IA generativa tem sido o principal tema de pesquisa para profissionais de IA e ML já há algum tempo, e nos últimos anos assistimos a rápidos avanços tanto em termos de eficiência como de desempenho de modelos de imagens generativas. Os aprendizados dos modelos de imagem generativos permitiram que pesquisadores e desenvolvedores avançassem em modelos de vídeo generativos, resultando em maior praticidade e aplicações no mundo real. No entanto, a maior parte da investigação que tenta melhorar as capacidades dos modelos de vídeo generativos concentra-se principalmente na disposição exacta das camadas temporais e espaciais, sendo dada pouca atenção à investigação da influência da selecção dos dados correctos no resultado destes modelos generativos.

Graças ao progresso alcançado pelos modelos de imagem generativos, os investigadores observaram que o impacto da distribuição de dados de treino no desempenho dos modelos generativos é de facto significativo e indiscutível. Além disso, os pesquisadores também observaram que o pré-treinamento de um modelo de imagem generativo em um conjunto de dados grande e diversificado, seguido de seu ajuste fino em um conjunto de dados menor e com melhor qualidade, geralmente resulta em uma melhoria significativa do desempenho. Tradicionalmente, os modelos de vídeo generativos implementam os aprendizados obtidos a partir de modelos de imagens generativos bem-sucedidos, e os pesquisadores ainda não estudaram o efeito dos dados e as estratégias de treinamento ainda não foram estudadas. O Modelo de Difusão de Vídeo Estável é uma tentativa de aprimorar as habilidades dos modelos de vídeo generativos, aventurando-se em territórios anteriormente desconhecidos, com foco especial na seleção de dados.

Modelos de vídeo generativos recentes dependem de modelos de difusão e abordagens de condicionamento de texto ou de imagem para sintetizar vários quadros de vídeo ou imagem consistentes. Os modelos de difusão são conhecidos por sua capacidade de aprender como eliminar gradualmente o ruído de uma amostra da distribuição normal, implementando um processo de refinamento iterativo, e forneceram resultados desejáveis em vídeo de alta resolução e síntese de texto para imagem. Usando o mesmo princípio em sua essência, o Modelo de Difusão de Vídeo Estável treina um modelo de difusão de vídeo latente em seu conjunto de dados de vídeo junto com o uso de Redes Adversariais Generativas ou GANs, e até mesmo modelos autorregressivos até certo ponto.

O modelo de difusão de vídeo estável segue uma estratégia única nunca implementada por qualquer modelo de vídeo generativo, pois se baseia em linhas de base de difusão de vídeo latente com uma arquitetura fixa e uma estratégia de treinamento fixa seguida pela avaliação do efeito da curadoria dos dados. O Modelo de Difusão de Vídeo Estável visa fazer as seguintes contribuições no campo da modelagem generativa de vídeo.

- Apresentar um fluxo de trabalho de curadoria de dados sistemático e eficaz na tentativa de transformar uma grande coleção de amostras de vídeo não curadas em um conjunto de dados de alta qualidade que é então usado pelos modelos de vídeo generativos.

- Para treinar modelos de imagem para vídeo de última geração e texto para vídeo que superem as estruturas existentes.

- Condução de experimentos específicos de domínio para sondar a compreensão 3D e forte antes do movimento do modelo.

Agora, o modelo de difusão de vídeo estável implementa os aprendizados dos modelos de difusão de vídeo latente e técnicas de curadoria de dados no centro de sua base.

Modelos de difusão de vídeo latente

Modelos de difusão de vídeo latente ou Vídeo-LDMs seguem a abordagem de treinar o modelo generativo primário em um espaço latente com complexidade computacional reduzida, e a maioria dos Vídeo-LDMs implementam um modelo de texto para imagem pré-treinado juntamente com a adição de camadas de mistura temporal no pré-treinamento arquitetura. Como resultado, a maioria dos modelos de difusão de vídeo latente treina apenas camadas temporais ou ignora completamente o processo de treinamento, ao contrário do modelo de difusão de vídeo estável que ajusta toda a estrutura. Além disso, para sintetizar texto em dados de vídeo, o modelo de difusão de vídeo estável condiciona-se diretamente a um prompt de texto, e os resultados indicam que a estrutura resultante pode ser facilmente ajustada em uma síntese de múltiplas visualizações ou em um modelo de imagem para vídeo.

Curadoria de dados

A curadoria de dados é um componente essencial não apenas do modelo de difusão de vídeo estável, mas para modelos generativos como um todo, porque é essencial pré-treinar modelos grandes em conjuntos de dados de grande escala para aumentar o desempenho em diferentes tarefas, incluindo modelagem de linguagem ou texto discriminativo para geração de imagem , e muito mais. A curadoria de dados foi implementada com sucesso em modelos de imagem generativos, aproveitando os recursos de representações eficientes de linguagem-imagem, embora tais discussões nunca tenham sido focadas no desenvolvimento de modelos de vídeo generativos. Existem vários obstáculos que os desenvolvedores enfrentam ao selecionar dados para modelos de vídeo generativos e, para enfrentar esses desafios, o modelo de difusão de vídeo estável implementa uma estratégia de treinamento em três estágios, resultando em resultados aprimorados e um aumento significativo no desempenho.

Curadoria de dados para síntese de vídeo de alta qualidade

Conforme discutido na seção anterior, o modelo de difusão de vídeo estável implementa uma estratégia de treinamento em três estágios, resultando em melhores resultados e um aumento significativo no desempenho. A Fase I é uma pré-treinamento de imagem etapa que faz uso de um modelo 2D de difusão de texto para imagem. A Fase II é para pré-treinamento em vídeo em que a estrutura treina em uma grande quantidade de dados de vídeo. Finalmente, temos o Estágio III para ajuste fino de vídeo em que o modelo é refinado em um pequeno subconjunto de vídeos de alta qualidade e alta resolução.

No entanto, antes que o Modelo de Difusão de Vídeo Estável implemente esses três estágios, é vital processar e anotar os dados, pois eles servem como base para o Estágio II ou estágio de pré-treinamento de vídeo e desempenham um papel crítico para garantir o resultado ideal. Para garantir a máxima eficiência, a estrutura primeiro implementa um pipeline de detecção de corte em cascata em 3 níveis variados de FPS ou quadros por segundo, e a necessidade desse pipeline é demonstrada na imagem a seguir.

Em seguida, o modelo de difusão de vídeo estável anota cada videoclipe usando três métodos variados de legenda sintética. A tabela a seguir compara os conjuntos de dados usados no Stable Diffusion Framework antes e depois do processo de filtração.

Etapa I: Pré-treinamento de imagem

O primeiro estágio no pipeline de três estágios implementado no Modelo de Difusão de Vídeo Estável é o pré-treinamento de imagem e, para conseguir isso, a estrutura inicial do Modelo de Difusão de Vídeo Estável é baseada em um modelo de difusão de imagem pré-treinado, ou seja, o Difusão estável 2.1 modelo que o equipa com representações visuais mais fortes.

Etapa II: Pré-treinamento em vídeo

A segunda etapa é a etapa de pré-treinamento de vídeo e se baseia nas descobertas de que o uso de curadoria de dados em modelos de imagens generativas multimodais geralmente resulta em melhores resultados e maior eficiência, juntamente com uma poderosa geração de imagens discriminativas. No entanto, devido à falta de representações prontas para uso semelhantes e poderosas para filtrar amostras indesejadas para modelos de vídeo generativos, o Modelo de Difusão de Vídeo Estável depende das preferências humanas como sinais de entrada para a criação de um conjunto de dados apropriado usado para pré-treinamento da estrutura. A figura a seguir demonstra o efeito positivo do pré-treinamento da estrutura em um conjunto de dados selecionado que ajuda a aumentar o desempenho geral do pré-treinamento de vídeo em conjuntos de dados menores.

Para ser mais específico, a estrutura utiliza diferentes métodos para selecionar subconjuntos de difusão de vídeo latente e considera a classificação de modelos LVD treinados nesses conjuntos de dados. Além disso, a estrutura Stable Video Diffusion também conclui que o uso de conjuntos de dados selecionados para treinar as estruturas ajuda a aumentar o desempenho da estrutura e dos modelos de difusão em geral. Além disso, a estratégia de curadoria de dados também funciona em conjuntos de dados maiores, mais relevantes e altamente práticos. A figura a seguir demonstra o efeito positivo do pré-treinamento da estrutura em um conjunto de dados selecionado que ajuda a aumentar o desempenho geral do pré-treinamento de vídeo em conjuntos de dados menores.

Estágio III: Ajuste fino de alta qualidade

Até o estágio II, a estrutura de difusão de vídeo estável concentra-se em melhorar o desempenho antes do pré-treinamento de vídeo e, no terceiro estágio, a estrutura enfatiza a otimização ou aumento adicional do desempenho da estrutura após o ajuste fino de vídeo de alta qualidade e como a transição da Fase II para a Fase III é alcançada no quadro. No Estágio III, a estrutura baseia-se em técnicas de treinamento emprestadas de modelos de difusão de imagens latentes e aumenta a resolução dos exemplos de treinamento. Para analisar a eficácia desta abordagem, o framework compara-a com três modelos idênticos que diferem apenas em termos de sua inicialização. O primeiro modelo idêntico tem seus pesos inicializados e o processo de treinamento de vídeo é ignorado, enquanto os dois modelos idênticos restantes são inicializados com os pesos emprestados de outros modelos de vídeo latentes.

Resultados e descobertas

É hora de dar uma olhada no desempenho da estrutura Stable Video Diffusion em tarefas do mundo real e como ela se compara às estruturas de última geração atuais. A estrutura Stable Video Diffusion primeiro usa a abordagem de dados ideal para treinar um modelo básico e, em seguida, realiza o ajuste fino para gerar vários modelos de última geração, onde cada modelo executa uma tarefa específica.

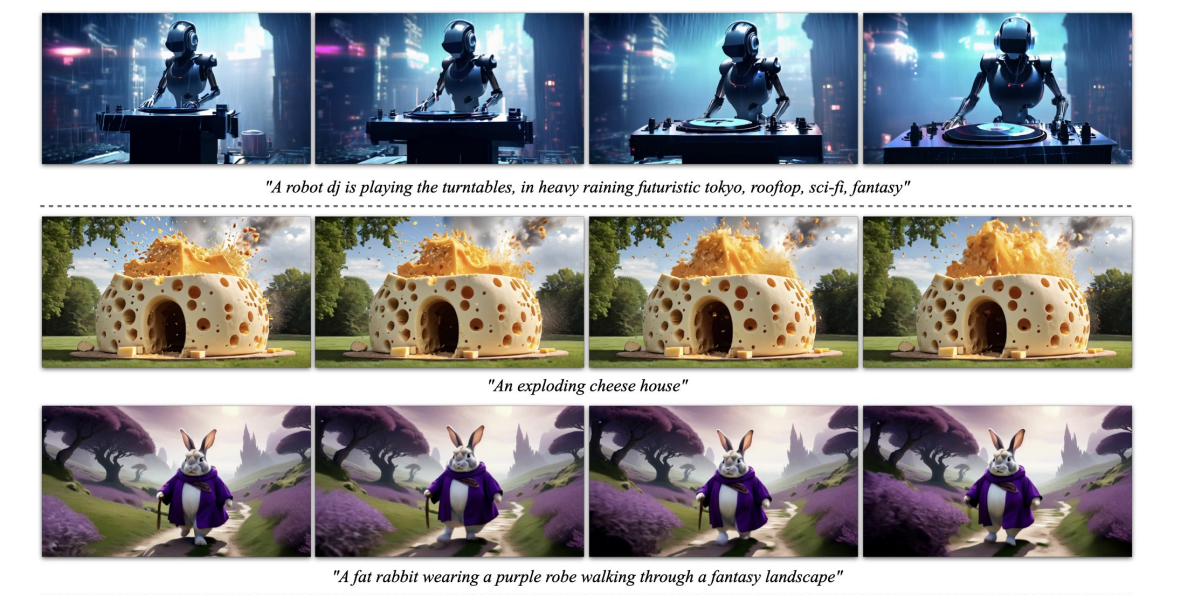

A imagem acima representa a imagem de alta resolução para amostras de vídeo geradas pela estrutura, enquanto a figura a seguir demonstra a capacidade da estrutura de gerar texto de alta qualidade para amostras de vídeo.

Base M pré-treinadaodel

Conforme discutido anteriormente, o modelo Stable Video Diffusion é construído na estrutura Stable Diffusion 2.1 e, com base em descobertas recentes, foi crucial que os desenvolvedores adotassem o cronograma de ruído e aumentassem o ruído para obter imagens com melhor resolução ao treinar a difusão de imagens. modelos. Graças a esta abordagem, o modelo base de difusão de vídeo estável aprende representações de movimento poderosas e, no processo, supera os modelos de linha de base para texto para geração de vídeo em uma configuração de disparo zero e os resultados são exibidos na tabela a seguir.

Interpolação de quadros e geração de múltiplas visualizações

A estrutura Stable Video Diffusion ajusta o modelo de imagem para vídeo em conjuntos de dados de múltiplas visualizações para obter múltiplas visualizações novas de um objeto, e este modelo é conhecido como SVD-MV ou modelo Stable Video Diffusion-Multi View. O modelo SVD original é ajustado com a ajuda de dois conjuntos de dados de forma que a estrutura insira uma única imagem e retorne uma sequência de imagens de visualização múltipla como saída.

Como pode ser visto nas imagens a seguir, o framework Stable Video Diffusion Multi View oferece alto desempenho comparável ao framework Scratch Multi View de última geração, e os resultados são uma demonstração clara da capacidade do SVD-MV de aproveitar os aprendizados obtidos. da estrutura SVD original para geração de imagens multivisualização. Além disso, os resultados também indicam que a execução do modelo para um número relativamente menor de iterações ajuda a fornecer resultados ideais, como é o caso da maioria dos modelos ajustados a partir da estrutura SVD.

Na figura acima, as métricas são indicadas no lado esquerdo e como pode ser visto, a estrutura Stable Video Diffusion Multi View supera a estrutura Scratch-MV e SD2.1 Multi-View por uma margem decente. A segunda imagem demonstra o efeito do número de iterações de treinamento no desempenho geral da estrutura em termos de Clip Score, e as estruturas SVD-MV entregam resultados sustentáveis.

Considerações Finais

Neste artigo, falamos sobre Stable Video Diffusion, um modelo de difusão de vídeo latente capaz de gerar conteúdo de imagem para vídeo e texto para vídeo de alta resolução e de última geração. O modelo de difusão de vídeo estável segue uma estratégia única nunca implementada por qualquer modelo de vídeo generativo, pois se baseia em linhas de base de difusão de vídeo latente com uma arquitetura fixa e uma estratégia de treinamento fixa seguida pela avaliação do efeito da curadoria dos dados.

Já falamos sobre como os modelos de difusão latente treinados para sintetizar imagens 2D melhoraram as habilidades e a eficiência de modelos de vídeo generativos adicionando camadas temporais e ajustando os modelos em pequenos conjuntos de dados que consistem em vídeos de alta qualidade. Para coletar os dados de pré-treinamento, a estrutura conduz estudos de escalonamento e segue práticas sistemáticas de coleta de dados e, em última análise, propõe um método para curar uma grande quantidade de dados de vídeo e converte vídeos ruidosos em dados de entrada adequados para modelos de vídeo generativos.

Além disso, a estrutura Stable Video Diffusion emprega três estágios distintos de treinamento de modelos de vídeo que são analisados independentemente para avaliar seu impacto no desempenho da estrutura. Em última análise, a estrutura produz uma representação de vídeo poderosa o suficiente para ajustar os modelos para uma síntese de vídeo ideal, e os resultados são comparáveis aos modelos de geração de vídeo de última geração já em uso.