Inteligência artificial

NeRF dá mais um passo para substituir o CGI

Pesquisadores do MIT e do Google deram um grande passo para resolver um dos obstáculos mais fundamentais para uma tecnologia emergente baseada em IA que pode eventualmente substituir o CGI – separando as imagens do campo de radiância neural (NeRF) em seus componentes visuais constituintes, para que as imagens possam ser retexturizado e re-iluminado.

A nova abordagem, denominada NeRFator, divide efetivamente as imagens capturadas em normais por objeto (aos quais as texturas podem ser atribuídas), visibilidade de luz, albedo (a proporção de luz incidental que é refletida de uma superfície) e funções de distribuição de refletância bidirecional (BRDFs).

Com essas facetas isoladas, é possível não apenas alternar texturas para objetos individuais ou grupos de objetos, mas também adicionar novas e únicas fontes de iluminação e implementações de sombra, descontando qualquer uma que tenha sido capturada pelas matrizes multicâmera que geram entrada para imagens NeRF.

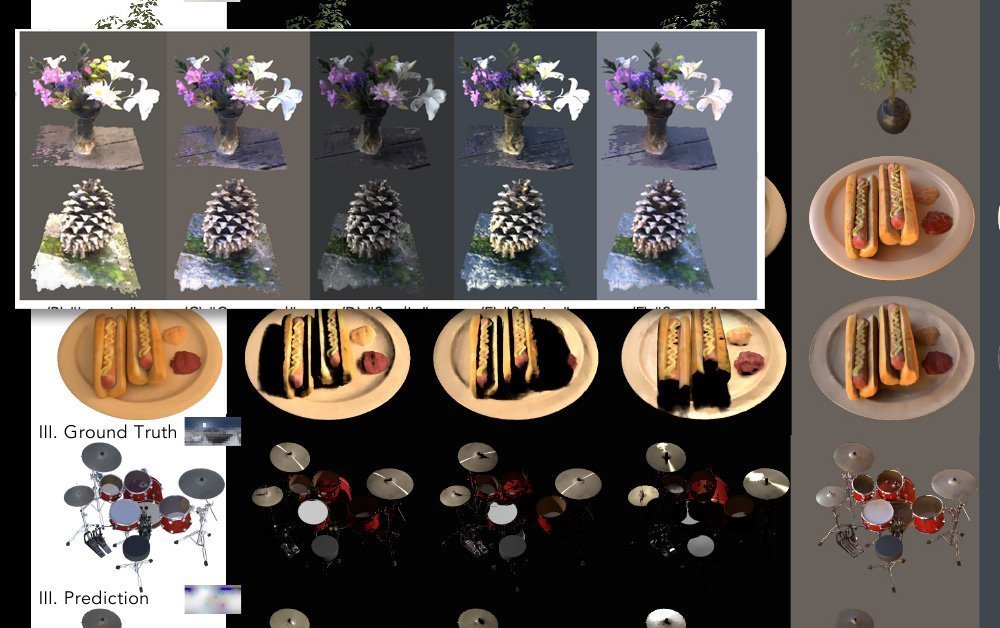

Normals, visibilidade, albedo e BRDF separados sob NeRFactor. Fonte: https://www.youtube.com/watch?v=UUVSPJlwhPg

O modelo suporta sombras suaves ou duras de fontes de iluminação arbitrárias definidas pelo usuário e separa os quatro aspectos do vídeo capturado programaticamente, usando uma perda de reconstrução, dados de cálculos anteriores de BRDF e regularização básica de suavidade simples.

Fluxo de trabalho do NeRFactor, extraindo facetas acionáveis separadamente de imagens derivadas de matrizes de múltiplas câmeras. Fonte: https://arxiv.org/pdf/2106.01970.pdf

O NeRFactor usa uma sonda de luz HDR, uma abordagem bem estabelecida que permeou a cena visual industrial e artística desde sua introdução em 1998, para avaliar possíveis rotas de raios, o que permite iluminação arbitrária. Uma vez que isso gera um número ingovernável de parâmetros possíveis, a sonda de luz é filtrada por um perceptron multicamada (MLP), que mapeia a geometria percebida para a sonda sem tentar calcular um mapa de volume de iluminação completo para o espaço do modelo.

Dois modelos de campo de radiância neural são usados para demonstrar cinco modelos de iluminação possíveis no NeRFactor. Clique na imagem para maior resolução.

Motivo para Reflexão

A nova pesquisa é talvez mais significativa na separação das camadas de imagens capturadas que controlam a reflexão. Este continua sendo um dos maiores desafios para imagens de campo de radiância neural, uma vez que um sistema NeRF verdadeiramente novo e flexível precisará não apenas ser capaz de substituir texturas, mas crucialmente precisará de alguma maneira de refletir objetos em movimento (além de apenas o ambiente fixo geral). que normalmente seria contabilizado em um fluxo de trabalho CGI.

Este problema foi notado recentemente em relação à Intel's nova pesquisa impressionante em transformar imagens de videogame em vídeo fotorrealista por meio de redes neurais convolucionais. Em tais fluxos de trabalho, muitos aspectos 'preparados' do material de origem precisariam se tornar discretos e trocáveis, e isso é indiscutivelmente mais fácil de resolver para reiluminação (que é uma função da geometria sendo renderizada no NeRF) do que para reflexões (que utilizam ' fora da tela' geometria que está totalmente fora do escopo do modelo).

Portanto, isolar as camadas no vídeo NeRF que facilitam a reflexão traz o NeRF um passo mais perto de resolver seu 'desafio de reflexão'.

O uso de um ambiente HDR já resolve o problema de geração de reflexos do ambiente mundial (ou seja, céus, paisagens e outros fatores ambientais 'fixos'), mas novas abordagens serão necessárias para introduzir reflexos em movimento e dinâmicos.

Fotogrametria com NeRF

As imagens do Neural Radiance Field usam análise de aprendizado de máquina para desenvolver um espaço completamente volumétrico a partir de uma cena ou objeto que foi capturado de vários ângulos.

Vários esquemas baseados em NeRF que surgiram no ano passado usaram um número diversificado de dispositivos de câmera contribuintes; alguns usam 16 ou mais câmeras, outros apenas uma ou duas. Em todos os casos, os pontos de vista intermediários são 'preenchidos' (ou seja, interpretados) para que a cena ou o objeto possam ser navegados com fluidez.

A entidade resultante é um espaço completamente volumétrico, com uma compreensão 3D intrínseca que pode ser explorada de várias maneiras, incluindo a capacidade de gerar malhas CG tradicionais a partir da soma analisada em 3D das imagens de entrada.

NeRF no contexto de um 'novo CGI'

As imagens do campo de radiância neural são desenhado diretamente de imagens do mundo real, incluindo imagens em movimento de pessoas, objetos e cenas. Em contraste, uma metodologia CGI 'estuda' e interpreta o mundo, exigindo trabalhadores qualificados para construir malhas, rigs e texturas que fazem uso de imagens do mundo real (ou seja, capturas faciais e ambientais). Continua sendo uma abordagem essencialmente interpretativa e artesanal, cara e trabalhosa.

Além disso, o CGI teve problemas contínuos com o efeito 'uncanny valley' em seus esforços para recriar semelhanças humanas, o que não apresenta restrições a uma abordagem baseada em NeRF, que simplesmente captura vídeos ou imagens de pessoas reais e os manipula.

Além disso, o NeRF pode gerar geometria de malha tradicional em estilo CGI diretamente a partir de fotos conforme necessário e, na verdade, suplantar muitos dos procedimentos manuais que sempre foram necessários em imagens geradas por computador.

Desafios para NeRF

Esta pesquisa mais recente do MIT e do Google ocorre no contexto de uma verdadeira enxurrada de artigos NeRF no ano passado, muitos dos quais ofereceram soluções para os vários desafios lançados pelo artigo inicial de 2020.

Em abril, a inovação de um consórcio de pesquisa chinês forneceu uma maneira de isolar discretamente as linhas de tempo individuais de facetas em uma cena NeRF, incluindo pessoas.

A pesquisa chinesa permite que os usuários finais copiem, colem e redimensionem os elementos capturados, separando-os da linha do tempo linear do vídeo original. Fonte: https://www.youtube.com/watch?v=Wp4HfOwFGP4

Essa abordagem não apenas permite reimaginar a cena de qualquer ângulo capturado pelo conjunto de câmeras (e não apenas a visão única representada em uma captura de vídeo típica), mas também permite uma composição versátil – e até mesmo a capacidade de representar duas facetas do mesmo filmagens que estão sendo executadas em seus próprios períodos de tempo individuais (ou mesmo em execução inversa, conforme necessário).

A pesquisa chinesa permite que os usuários finais copiem, colem e redimensionem os elementos capturados, separando-os da linha do tempo linear do vídeo original. Fonte: https://www.youtube.com/watch?v=Wp4HfOwFGP4

Um dos maiores desafios do NeRF é reduzir os recursos consideráveis necessários para treinar uma cena, e isso foi abordado em vários artigos recentes. Por exemplo, o Max Planck Institute for Intelligent Systems introduziu recentemente QuiloNeRF, que não apenas acelera os tempos de renderização em um fator de 1000, mas também permite que o NeRF opere de forma interativa.

KiloNeRF executando um ambiente interativo a 50 fps em uma GTX 1080ti. Fonte: https://github.com/creiser/kilonerf

No entanto, a inovação de velocidade NeRF que realmente capturou a imaginação de pesquisadores e do público em 2021 foi a PlenOctrees colaboração, liderada pela UC Berkeley, que oferece renderização em tempo real de Neural Radiance Fields:

O efeito das capacidades interativas do PlenOctree foi reproduzido em um interface ao vivo baseada na web.

Movimento interativo ao vivo de um objeto PlenOctrees no Firefox (o movimento é mais suave e dinâmico do que este GIF representa). Fonte: http://alexyu.net/plenoctrees/demo/

Além disso, Recursivo-NeRF (de um artigo de maio de 2021 de pesquisadores da Tsinghua University) oferece renderização recursiva de alta qualidade sob demanda. Em vez de obrigar o usuário a renderizar cenas inteiras, incluindo partes que não podem ser vistas, o Recursive-NeRF fornece algo semelhante à compactação com perdas do JPEG e pode gerar sub-NeRFs discretos para lidar com imagens extras sob demanda - obtendo uma enorme economia em recursos computacionais .

Retendo detalhes enquanto descarta cálculos de renderização desnecessários com Recursive-NeRF. Clique na imagem para maior resolução. Fonte: https://arxiv.org/pdf/2105.09103.pdf

Outras abordagens incluem FastNeRF, que afirma alcançar renderização neural de alta fidelidade a 200 fps.

Foi observado que muitas das técnicas de otimização para NeRF envolvem 'assando' a cena, ao se comprometer com aspectos que se deseja renderizar e descartar outras facetas, o que limita a exploração, mas acelera muito a interatividade.

A desvantagem disso é que o estresse se move da GPU para o armazenamento, porque as cenas pré-fabricadas ocupam uma quantidade excessiva de espaço em disco; até certo ponto, isso pode ser mitigado diminuindo a amostragem dos dados preparados, embora isso também envolva um certo compromisso, em termos de fechar caminhos de exploração ou interatividade.

Em relação à captura de movimento e rigging, uma nova abordagem das universidades de Zheijang e Cornell, revelado em maio, ofereceu um método para recriar humanos animáveis usando campos de peso de mesclagem e estruturas de esqueleto interpretadas a partir do vídeo de entrada:

Estrutura esquelética derivada em Animatable NeRF. Fonte: https://www.youtube.com/watch?v=eWOSWbmfJo4

Quando o NeRF terá seu momento 'Jurassic Park'?

Apesar do ritmo acelerado de progresso com a síntese de imagens por meio de campos de radiância neural, é somente nesse período que qualquer tipo de 'lei da termodinâmica' será estabelecido para o quão implantável o NeRF pode se tornar. Em termos de uma linha do tempo análoga à história do CGI, o NeRF está atualmente pairando em torno de 1973, pouco antes do primeiro uso de CGI em Westworld.

Isso não significa que o NeRF precisará necessariamente esperar nove anos por seu equivalente Ira de Khan marco miliário, ou décadas para avanços semelhantes que o CGI alcançou sob o patrocínio entusiástico de James Cameron em 1989 The Abyss ou 1991 Terminator 2 – e então, a tecnologia é verdadeiramente revolucionária momento de fuga em 1993 Jurassic Park.

A cena da imagem mudou muito desde o longo período de estagnação dos efeitos visuais fotoquímicos, que dominou a produção cinematográfica e televisiva desde o nascimento do cinema até o início dos anos 1990. O advento da revolução do PC e a aceleração da lei de Moore levaram à revolução do CGI, que de outra forma poderia ter ocorrido já na década de 1960.

Resta saber se existe alguma barreira tão implacável que possa impedir o progresso do NeRF por tanto tempo - e se as inovações subsequentes na visão computacional não poderão, entretanto, ultrapassar completamente o NeRF como o principal candidato à coroa do CGI, caracterizando os campos de radiação neural. como a 'máquina de fax' de curta duração da síntese de imagens neurais.

Até agora, o NeRF não foi usado em nenhum contexto fora da pesquisa acadêmica; mas é notável que os principais players, como o Google Research, e muitos dos laboratórios de pesquisa de visão computacional mais proeminentes estejam competindo pelo mais recente avanço do NeRF.

Muitos dos maiores obstáculos do NeRF começaram a ser resolvidos diretamente este ano; se a pesquisa subsequente oferecer uma solução para o 'problema de reflexão', e as muitas vertentes da pesquisa de otimização de NeRF se unirem em uma solução decisiva para as consideráveis demandas de processamento e/ou armazenamento da tecnologia, NeRF realmente tem uma chance de se tornar 'o novo CGI ' nos próximos cinco anos.