Inteligência artificial

A IA multimodal evolui à medida que ChatGPT ganha visão com GPT-4V(ision)

No esforço contínuo para tornar a IA mais parecida com os humanos, os modelos GPT da OpenAI têm continuamente ultrapassado os limites. O GPT-4 agora é capaz de aceitar solicitações de texto e imagens.

A multimodalidade na IA generativa denota a capacidade de um modelo de produzir resultados variados, como texto, imagens ou áudio com base na entrada. Esses modelos, treinados em dados específicos, aprendem padrões subjacentes para gerar novos dados semelhantes, enriquecendo as aplicações de IA.

Avanços recentes em IA multimodal

Um salto notável recente neste campo é visto com a integração do DALL-E 3 no ChatGPT, uma atualização significativa na tecnologia de texto para imagem da OpenAI. Essa combinação permite uma interação mais suave, onde o ChatGPT auxilia na elaboração de prompts precisos para o DALL-E 3, transformando as ideias do usuário em arte vívida gerada por IA. Assim, embora os usuários possam interagir diretamente com o DALL-E 3, ter ChatGPT no mix torna o processo de criação de arte de IA muito mais fácil de usar.

Confira mais sobre o DALL-E 3 e sua integração com ChatGPT SUA PARTICIPAÇÃO FAZ A DIFERENÇA. Esta colaboração não apenas mostra o avanço da IA multimodal, mas também torna a criação de arte com IA uma brisa para os usuários.

A saúde do Google, por outro lado, introduziu Med-PaLM M em junho deste ano. É um modelo generativo multimodal capaz de codificar e interpretar diversos dados biomédicos. Isto foi conseguido através do ajuste fino do PaLM-E, um modelo de linguagem, para atender aos domínios médicos utilizando um benchmark de código aberto, o MultiMedBench. Este benchmark consiste em mais de 1 milhão de amostras em 7 tipos de dados biomédicos e 14 tarefas, como resposta a perguntas médicas e geração de relatórios radiológicos.

Vários setores estão adotando ferramentas inovadoras de IA multimodal para impulsionar a expansão dos negócios, agilizar as operações e aumentar o envolvimento do cliente. O progresso nas capacidades de IA de voz, vídeo e texto está impulsionando o crescimento da IA multimodal.

As empresas procuram aplicações multimodais de IA capazes de reformular modelos e processos de negócios, abrindo caminhos de crescimento em todo o ecossistema generativo de IA, desde ferramentas de dados até aplicações emergentes de IA.

Após o lançamento do GPT-4 em março, alguns usuários observaram um declínio na qualidade de sua resposta ao longo do tempo, uma preocupação compartilhada por desenvolvedores notáveis e nos fóruns da OpenAI. Inicialmente descartado por um OpenAI, um posterior estudo confirmou o problema. Revelou uma queda na precisão do GPT-4 de 97.6% para 2.4% entre março e junho, indicando um declínio na qualidade da resposta com atualizações subsequentes do modelo.

O hype em torno IA aberta ChatGPT está de volta agora. Agora vem com um recurso de visão GPT-4V, permitindo que os usuários façam com que o GPT-4 analise as imagens fornecidas por eles. Este é o recurso mais recente que foi aberto aos usuários.

Adicionar análise de imagens a grandes modelos de linguagem (LLMs), como GPT-4, é visto por alguns como um grande avanço na pesquisa e desenvolvimento de IA. Este tipo de LLM multimodal abre novas possibilidades, levando modelos de linguagem além do texto para oferecer novas interfaces e resolver novos tipos de tarefas, criando novas experiências para os usuários.

O treinamento do GPT-4V foi concluído em 2022, com acesso antecipado lançado em março de 2023. O recurso visual do GPT-4V é alimentado pela tecnologia GPT-4. O processo de treinamento permaneceu o mesmo. Inicialmente, o modelo foi treinado para prever a próxima palavra em um texto usando um enorme conjunto de dados de texto e imagens de várias fontes, incluindo a Internet.

Mais tarde, foi aperfeiçoado com mais dados, empregando um método denominado aprendizagem por reforço a partir de feedback humano (RLHF), para gerar resultados preferidos pelos humanos.

Mecânica de visão GPT-4

As notáveis capacidades de linguagem de visão do GPT-4, embora impressionantes, têm métodos subjacentes que permanecem na superfície.

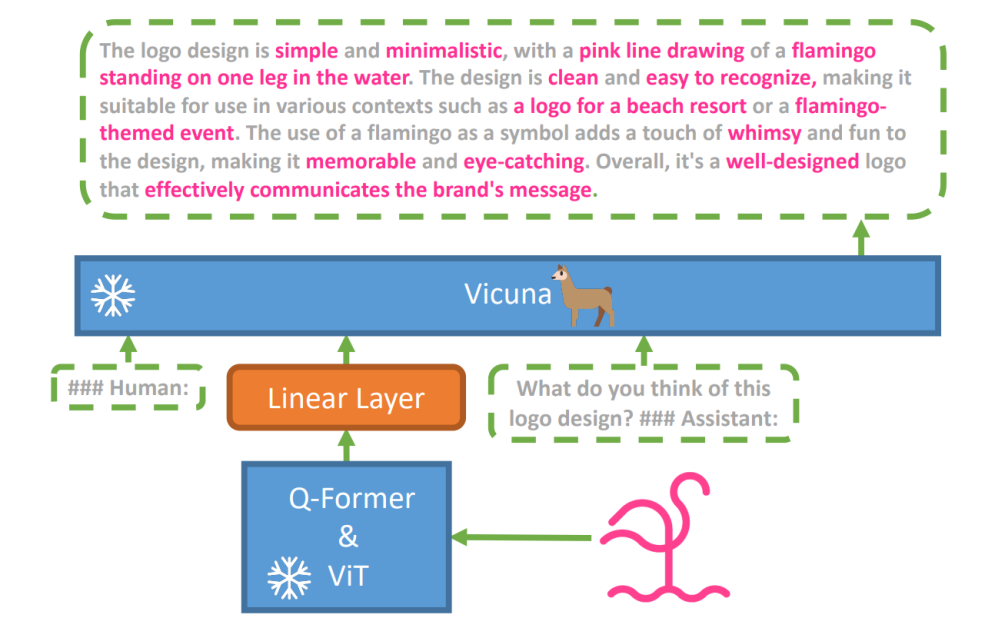

Para explorar esta hipótese, um novo modelo de visão-linguagem, miniGPT-4 foi introduzido, utilizando um LLM avançado chamado Vicuna. Este modelo utiliza um codificador de visão com componentes pré-treinados para percepção visual, alinhando características visuais codificadas com o modelo de linguagem Vicuna através de uma única camada de projeção. A arquitetura do MiniGPT-4 é simples, mas eficaz, com foco no alinhamento de recursos visuais e de linguagem para melhorar as capacidades de conversação visual.

A arquitetura do MiniGPT-4 inclui um codificador de visão com ViT e Q-Former pré-treinados, uma única camada de projeção linear e um modelo avançado de linguagem grande Vicuna.

A tendência de modelos linguísticos autorregressivos em tarefas de linguagem visual também cresceu, capitalizando a transferência intermodal para compartilhar conhecimento entre domínios linguísticos e multimodais.

MiniGPT-4 conecta os domínios visual e de linguagem alinhando informações visuais de um codificador de visão pré-treinado com um LLM avançado. O modelo utiliza Vicuna como decodificador de linguagem e segue uma abordagem de treinamento em duas etapas. Inicialmente, ele é treinado em um grande conjunto de dados de pares imagem-texto para compreender o conhecimento da linguagem visual, seguido de ajuste fino em um conjunto de dados menor e de alta qualidade para aumentar a confiabilidade e a usabilidade da geração.

Para melhorar a naturalidade e usabilidade da linguagem gerada no MiniGPT-4, os pesquisadores desenvolveram um processo de alinhamento em duas etapas, abordando a falta de conjuntos de dados adequados de alinhamento de linguagem de visão. Eles fizeram a curadoria de um conjunto de dados especializado para essa finalidade.

Inicialmente, o modelo gerou descrições detalhadas das imagens de entrada, aprimorando os detalhes por meio de um prompt conversacional alinhado ao formato do modelo da linguagem Vicuna. Esta etapa teve como objetivo gerar descrições de imagens mais abrangentes.

Prompt de descrição inicial da imagem:

###Humano: Descreva esta imagem em detalhes. Dê o máximo de detalhes possível. Diga tudo o que você vê. ###Assistente:

Para o pós-processamento dos dados, quaisquer inconsistências ou erros nas descrições geradas foram corrigidos através do ChatGPT, seguido de verificação manual para garantir alta qualidade.

Prompt de ajuste fino de segundo estágio:

###Humano: ###Assistente:

Esta exploração abre uma janela para a compreensão da mecânica da IA generativa multimodal como o GPT-4, esclarecendo como as modalidades de visão e linguagem podem ser efetivamente integradas para gerar resultados coerentes e contextualmente ricos.

Explorando a Visão GPT-4

Determinando origens de imagens com ChatGPT

O GPT-4 Vision aprimora a capacidade do ChatGPT de analisar imagens e identificar suas origens geográficas. Esse recurso faz a transição das interações do usuário de apenas texto para uma mistura de texto e imagens, tornando-se uma ferramenta útil para aqueles curiosos sobre diferentes lugares por meio de dados de imagem.

Conceitos matemáticos complexos

GPT-4 Vision se destaca em aprofundar ideias matemáticas complexas, analisando expressões gráficas ou manuscritas. Este recurso atua como uma ferramenta útil para indivíduos que buscam resolver problemas matemáticos complexos, tornando o GPT-4 Vision uma ajuda notável nas áreas educacional e acadêmica.

Convertendo entrada manuscrita em códigos LaTeX

Uma das habilidades notáveis do GPT-4V é a capacidade de traduzir entradas manuscritas em códigos LaTeX. Esse recurso é uma vantagem para pesquisadores, acadêmicos e estudantes que muitas vezes precisam converter expressões matemáticas manuscritas ou outras informações técnicas em formato digital. A transformação do manuscrito para LaTeX amplia o horizonte da digitalização de documentos e simplifica o processo de redação técnica.

Extraindo detalhes da tabela

GPT-4V demonstra habilidade em extrair detalhes de tabelas e responder a consultas relacionadas, um ativo vital na análise de dados. Os usuários podem utilizar o GPT-4V para examinar tabelas, coletar insights importantes e resolver questões baseadas em dados, tornando-o uma ferramenta robusta para analistas de dados e outros profissionais.

Compreendendo o apontamento visual

A capacidade única do GPT-4V de compreender a indicação visual adiciona uma nova dimensão à interação do usuário. Ao compreender as dicas visuais, o GPT-4V pode responder a perguntas com uma compreensão contextual mais elevada.

Construindo sites de maquete simples usando um desenho

Motivado por isso Tweet, tentei criar um modelo para o site unite.ai.

Embora o resultado não tenha correspondido à minha visão inicial, aqui está o resultado que alcancei.

Limitações e falhas do GPT-4V (isão)

Para analisar o GPT-4V, a equipe Open AI realizou avaliações qualitativas e quantitativas. Os qualitativos incluíram testes internos e análises de especialistas externos, enquanto os quantitativos mediram recusas de modelos e precisão em vários cenários, como identificação de conteúdo prejudicial, reconhecimento demográfico, preocupações com privacidade, geolocalização, segurança cibernética e jailbreaks multimodais.

Mesmo assim o modelo não é perfeito.

A papel destaca as limitações do GPT-4V, como inferências incorretas e falta de texto ou caracteres nas imagens. Pode ter alucinações ou inventar fatos. Particularmente, não é adequado para identificar substâncias perigosas em imagens, muitas vezes identificando-as incorretamente.

Em imagens médicas, o GPT-4V pode fornecer respostas inconsistentes e carece de conhecimento das práticas padrão, levando a possíveis diagnósticos incorretos.

Desempenho não confiável para fins médicos (fonte)

Também não consegue compreender as nuances de certos símbolos de ódio e pode gerar conteúdo impróprio com base em informações visuais. A OpenAI desaconselha o uso do GPT-4V para interpretações críticas, especialmente em contextos médicos ou sensíveis.

Resumindo

Criado usando Fast Stable Diffusion XL https://huggingface.co/spaces/google/sdxl

A chegada do GPT-4 Vision (GPT-4V) traz um monte de possibilidades interessantes e novos obstáculos para superar. Antes de implementá-lo, muito esforço foi feito para garantir que os riscos, especialmente quando se trata de fotos de pessoas, fossem bem analisados e reduzidos. É impressionante ver como o GPT-4V avançou, mostrando-se muito promissor em áreas complicadas como medicina e ciência.

Agora, há algumas grandes questões sobre a mesa. Por exemplo, esses modelos deveriam ser capazes de identificar pessoas famosas a partir de fotos? Eles deveriam adivinhar o gênero, a raça ou os sentimentos de uma pessoa a partir de uma imagem? E deveria haver ajustes especiais para ajudar os deficientes visuais? Estas questões abrem uma caixa de vermes sobre privacidade, justiça e como a IA deve se encaixar em nossas vidas, algo em que todos deveriam ter uma palavra a dizer.