Inteligência artificial

Aproveitar a atenção humana pode melhorar imagens geradas por IA

Uma nova pesquisa da China propôs um método para melhorar a qualidade das imagens geradas por Modelos de difusão latente (LDMs) modelos como Difusão Estável.

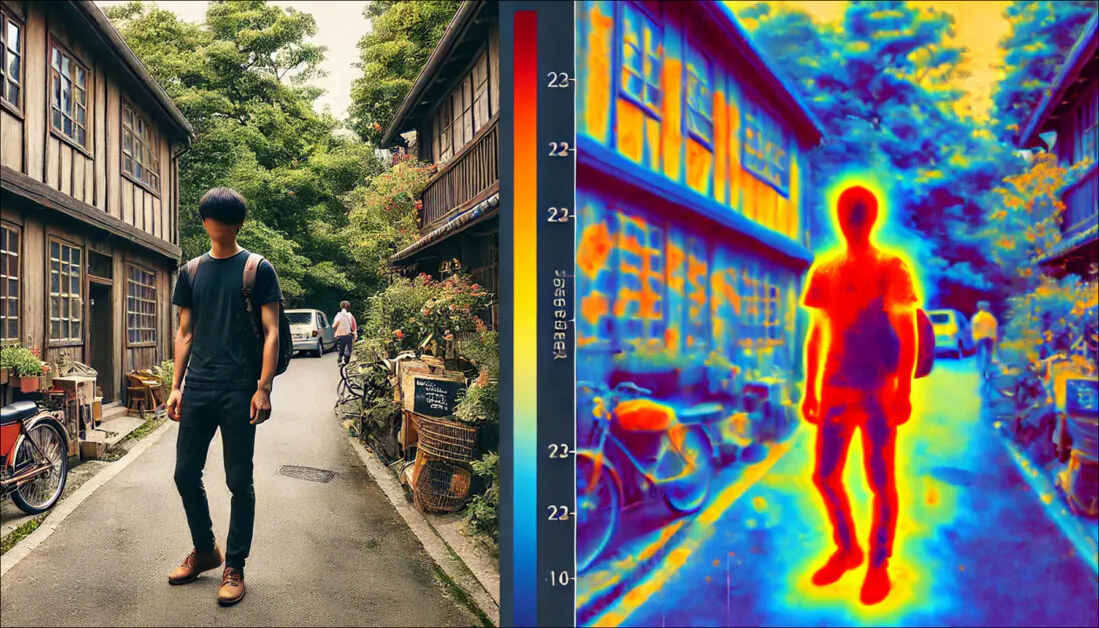

O método se concentra na otimização da regiões salientes de uma imagem – áreas com maior probabilidade de atrair a atenção humana.

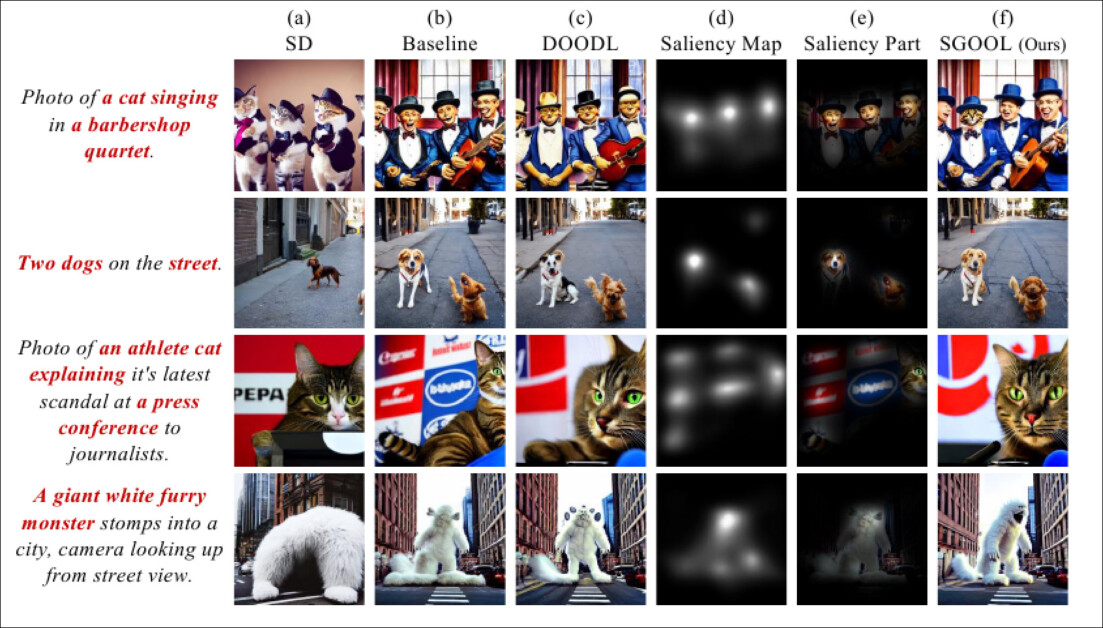

A nova pesquisa descobriu que os mapas de saliência (quarta coluna da esquerda) podem ser usados como um filtro, ou "máscara", para direcionar o foco de atenção em processos de redução de ruído para áreas da imagem nas quais os humanos têm mais probabilidade de prestar atenção. Fonte: https://arxiv.org/pdf/2410.10257

Os métodos tradicionais otimizam a imagem inteira uniformemente, enquanto a nova abordagem utiliza um detector de saliência para identificar e priorizar regiões mais "importantes", como os humanos fazem.

Em testes quantitativos e qualitativos, o método dos pesquisadores foi capaz de superar modelos anteriores baseados em difusão, tanto em termos de qualidade de imagem quanto de fidelidade aos prompts de texto.

A nova abordagem também obteve a melhor pontuação em um teste de percepção humana com 100 participantes.

Seleção natural

Saliência, a capacidade de priorizar informações no mundo real e em imagens, é uma parte essencial da visão humana.

Um exemplo simples disso é a maior atenção aos detalhes que a arte clássica atribui a áreas importantes de uma pintura, como o rosto, em um retrato, ou os mastros de um navio, em um tema marítimo; em tais exemplos, a atenção do artista converge para o tema central, o que significa que detalhes amplos, como o fundo de um retrato ou as ondas distantes de uma tempestade, são mais esquemáticos e amplamente representativos do que detalhados.

Com base em estudos humanos, surgiram na última década métodos de aprendizado de máquina que podem replicar ou pelo menos aproximar esse locus de interesse humano em qualquer imagem.

A segmentação de objetos (segmentação semântica) pode ajudar a individualizar facetas de uma imagem e desenvolver mapas de saliência correspondentes. Fonte: https://arxiv.org/pdf/1312.6034

Na literatura de pesquisa, o detector de mapa de saliência mais popular nos últimos cinco anos foi o de 2016 Mapeamento de ativação de classe ponderada por gradiente (Grad-CAM), que mais tarde evoluiu para a iniciativa melhorada Grad-CAM++ sistema, entre outras variantes e refinamentos.

O Grad-CAM utiliza o ativação de gradiente de um token semântico (como 'cachorro' ou 'gato') para produzir um mapa visual de onde o conceito ou anotação parece provavelmente estar representado na imagem.

Exemplos do artigo original do Grad-CAM. Na segunda coluna, a retropropagação guiada individualiza todos os recursos contribuintes. Na terceira coluna, os mapas semânticos são desenhados para os dois conceitos 'cachorro' e 'gato'. A quarta coluna representa a concatenação das duas inferências anteriores. A quinta, o mapa de oclusão (mascaramento) que corresponde à inferência; e, finalmente, na sexta coluna, o Grad-CAM visualiza uma camada ResNet-18. Fonte: https://arxiv.org/pdf/1610.02391

Pesquisas humanas sobre os resultados obtidos por esses métodos revelaram uma correspondência entre essas individuações matemáticas de pontos-chave de interesse em uma imagem e a atenção humana (ao escanear a imagem).

SGOOL

A novo papel considera o que a saliência pode trazer aos sistemas de texto para imagem (e, potencialmente, texto para vídeo), como Difusão Estável e Fluxo.

Ao interpretar o prompt de texto de um usuário, os Modelos de Difusão Latente exploram seus espaço latente para conceitos visuais aprendidos que correspondem às palavras ou frases usadas. Eles então analisam esses pontos de dados encontrados por meio de um denoising processo em que o ruído aleatório é gradualmente transformado em uma interpretação criativa do prompt de texto do usuário.

Neste ponto, no entanto, o modelo fornece igual atenção a cada parte da imagem. Desde a popularização dos modelos de difusão em 2022, com o lançamento do OpenAI disponível Laje geradores de imagens e o subsequente código aberto da estrutura Stable Diffusion da Stability.ai, os usuários descobriram que seções "essenciais" de uma imagem geralmente não são atendidas.

Considerando que numa representação típica de um ser humano, o rosto da pessoa (que é de importância máxima (para o observador) provavelmente não ocupará mais do que 10-35% da imagem total, esse método democrático de dispersão da atenção vai contra a natureza da percepção humana e a história da arte e da fotografia.

Quando os botões da calça jeans de uma pessoa recebem o mesmo peso de computação que seus olhos, a alocação de recursos pode ser considerada não ideal.

Portanto, o novo método proposto pelos autores, intitulado Otimização guiada por saliência de latentes de difusão (SGOOL), usa um mapeador de saliência para aumentar a atenção em áreas negligenciadas de uma imagem, dedicando menos recursos a seções que provavelmente permaneceriam na periferia da atenção do observador.

Forma

O pipeline SGOOL inclui geração de imagens, mapeamento de saliência e otimização, com a imagem geral e a imagem com saliência refinada processadas em conjunto.

Esquema conceitual para SGOOL.

Os embeddings latentes do modelo de difusão são otimizados diretamente com afinação, eliminando a necessidade de treinar um modelo específico. Universidade de Stanford Modelo implícito de difusão de redução de ruído O método de amostragem (DDIM), familiar aos usuários do Stable Diffusion, é adaptado para incorporar as informações secundárias fornecidas pelos mapas de saliência.

O artigo afirma:

'Primeiro, empregamos um detector de saliência para imitar o sistema de atenção visual humano e marcar as regiões salientes. Para evitar o retreinamento de um modelo adicional, nosso método otimiza diretamente os latentes de difusão.

'Além disso, o SGOOL utiliza um processo de difusão invertível e o dota com os méritos da implementação de memória constante. Portanto, nosso método se torna um método de ajuste fino plug-and-play e eficiente em termos de parâmetros. Experimentos extensivos foram feitos com várias métricas e avaliações humanas.'

Como este método requer múltiplas iterações do processo de redução de ruído, os autores adotaram o Otimização Direta de Latentes de Difusão (DOODL), que fornece uma estrutura difusão invertível processo – embora ainda aplique atenção à totalidade da imagem.

Para definir áreas de interesse humano, os pesquisadores empregaram o modelo de 2022 da Universidade de Dundee. Estrutura TransalNet.

Exemplos de detecção de saliência do projeto TransalNet de 2022. Fonte: https://discovery.dundee.ac.uk/ws/portalfiles/portal/89737376/1_s2.0_S0925231222004714_main.pdf

As regiões salientes processadas pelo TransalNet foram então cortadas para gerar seções de saliência conclusivas, provavelmente de maior interesse para pessoas reais.

A diferença entre o texto do usuário e a imagem deve ser considerada, em termos de definição de um função de perda que pode determinar se o processo está funcionando. Para isso, uma versão do OpenAI's Pré-treinamento de Linguagem Contrastiva–Imagem (CLIP) – atualmente um pilar do setor de pesquisa de síntese de imagens – foi usado, juntamente com a consideração da estimativa distância semântica entre o prompt de texto e a saída da imagem global (sem saliência).

Os autores afirmam:

'[A] função de perda final considera as relações entre as partes salientes e a imagem global simultaneamente, o que ajuda a equilibrar os detalhes locais e a consistência global no processo de geração.

'Essa perda com consciência de saliência é alavancada para otimizar a imagem latente. Os gradientes são computados no ruído [latente] e alavancados para melhorar o efeito de condicionamento do prompt de entrada em aspectos salientes e globais da imagem original gerada.'

Dados e testes

Para testar o SGOOL, os autores usaram uma distribuição 'vanilla' de Difusão Estável V1.4 (denotada como 'SD' nos resultados do teste) e Difusão Estável com orientação CLIP (denotada como 'baseline' nos resultados).

O sistema foi avaliado em relação a três conjuntos de dados públicos: Processos Sintáticos Comuns (CPS), Banco de desenho, e DailyDallE*.

Este último contém 99 prompts elaborados de um artista apresentado em uma das postagens do blog da OpenAI, enquanto o DrawBench oferece 200 prompts em 11 categorias. O CSP é composto de 52 prompts baseados em oito casos gramaticais diversos.

Para SD, linha de base e SGOOL, nos testes, foi utilizado o modelo CLIP Vitamina B-32 para gerar os embeddings de imagem e texto. O mesmo prompt e semente aleatória foi usado. O tamanho da saída foi 256×256, e os pesos e configurações padrão do TransalNet foram empregados.

Além da métrica de pontuação CLIP, uma estimativa Pontuação de Preferência Humana (HPS) foi usado, além de um estudo do mundo real com 100 participantes.

Resultados quantitativos comparando o SGOOL com configurações anteriores.

Em relação aos resultados quantitativos apresentados na tabela acima, o artigo afirma:

'[Nosso] modelo supera significativamente o SD e o Baseline em todos os conjuntos de dados sob as métricas de pontuação CLIP e HPS. Os resultados médios do nosso modelo na pontuação CLIP e HPS são 3.05 e 0.0029 maiores que o segundo colocado, respectivamente.'

Os autores estimaram ainda os gráficos de caixa das pontuações HPS e CLIP em relação às abordagens anteriores:

Diagramas de caixa para as pontuações HPS e CLIP obtidas nos testes.

Eles comentam:

'Pode-se observar que nosso modelo supera os outros modelos, indicando que ele é mais capaz de gerar imagens consistentes com os prompts.

'No entanto, no box plot, não é fácil visualizar a comparação do box plot devido ao tamanho desta métrica de avaliação em [0, 1]. Portanto, procedemos para plotar os gráficos de barras correspondentes.

'Pode ser visto que o SGOOL supera o SD e o Baseline em todos os conjuntos de dados sob a pontuação CLIP e métricas HPS. Os resultados quantitativos demonstram que nosso modelo pode gerar imagens semanticamente mais consistentes e preferidas por humanos.'

Os pesquisadores observam que, embora o modelo de base seja capaz de melhorar a qualidade da saída da imagem, ele não considera as áreas salientes da imagem. Eles argumentam que o SGOOL, ao chegar a um compromisso entre a avaliação global e a saliente da imagem, obtém imagens melhores.

Em comparações qualitativas (automatizadas), o número de otimizações foi definido como 50 para SGOOL e DOODL.

Resultados qualitativos para os testes. Por favor, consulte o artigo fonte para melhor definição.

Aqui os autores observam:

'Na [primeira linha], os assuntos do prompt são “um gato cantando” e “um quarteto de barbearia”. Há quatro gatos na imagem gerada por SD, e o conteúdo da imagem está mal alinhado com o prompt.

'O gato é ignorado na imagem gerada pelo Baseline, e há uma falta de detalhes na representação do rosto e nos detalhes da imagem. O DOODL tenta gerar uma imagem que seja consistente com o prompt.

'No entanto, como o DOODL otimiza a imagem global diretamente, as pessoas na imagem são otimizadas em direção ao gato.'

Eles observam ainda que o SGOOL, por outro lado, gera imagens que são mais consistentes com o prompt original.

No teste de percepção humana, 100 voluntários avaliaram as imagens de teste quanto à qualidade e consistência semântica (ou seja, quão próximas elas aderiram aos prompts do texto de origem). Os participantes tiveram tempo ilimitado para fazer suas escolhas.

Resultados do teste de percepção humana.

Como o artigo aponta, o método dos autores é notavelmente preferível às abordagens anteriores.

Conclusão

Pouco tempo depois de as deficiências abordadas neste artigo se terem tornado evidentes nas instalações locais de Difusão Estável, vários métodos personalizados (como Depois do detalhista) surgiu para forçar o sistema a aplicar atenção extra às áreas de maior interesse humano.

No entanto, esse tipo de abordagem exige que o sistema de difusão passe inicialmente pelo processo normal de aplicar a mesma atenção a cada parte da imagem, com o trabalho adicional sendo feito como um estágio extra.

As evidências do SGOOL sugerem que a aplicação da psicologia humana básica à priorização de seções de imagem poderia melhorar muito a inferência inicial, sem etapas de pós-processamento.

* O artigo fornece o mesmo link para isso que para CommonSyntacticProcesses.

Primeira publicação quarta-feira, 16 de outubro de 2024