Inteligência artificial

Melhor desempenho de aprendizado de máquina por meio de redimensionamento de imagem baseado em CNN

O Google Research propôs um novo método para melhorar a eficiência e a precisão dos fluxos de trabalho de treinamento de visão computacional baseados em imagens, melhorando a maneira como as imagens em um conjunto de dados são reduzidas no estágio de pré-processamento.

De acordo com o relatório papel Aprendendo a redimensionar imagens para tarefas de visão computacional, os pesquisadores Hossein Talebi e Peyman Milanfar utilizam uma CNN para criar uma nova arquitetura de redimensionamento de imagem híbrida que produz uma melhoria notável nos resultados de reconhecimento obtidos em quatro conjuntos de dados populares de visão computacional.

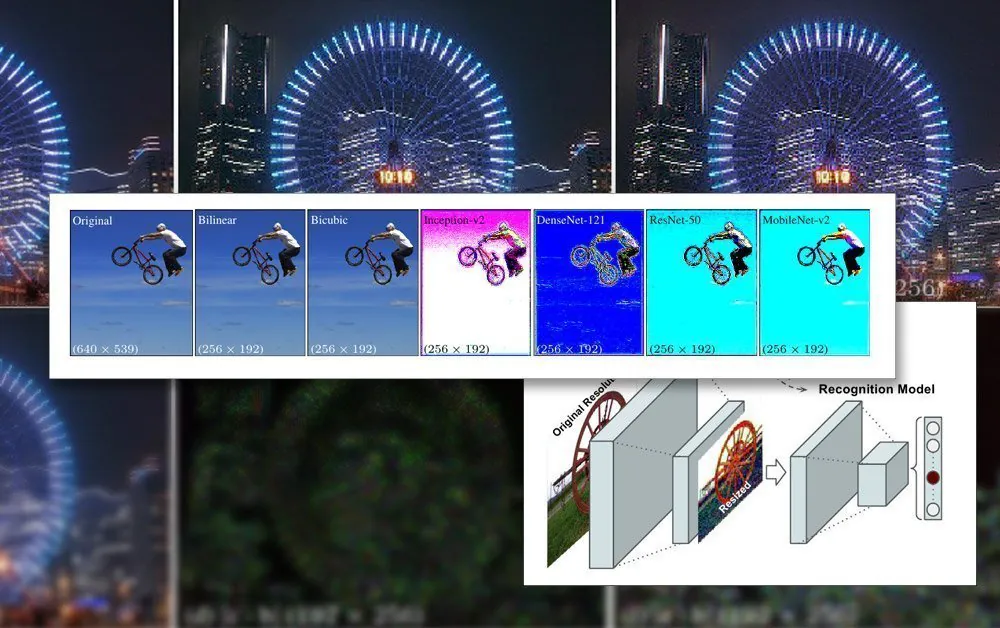

O quadro conjunto proposto para reconhecimento e redimensionamento. Fonte: https://arxiv.org/pdf/2103.09950.pdf

O artigo observa que os métodos de redimensionamento/redimensionamento usados atualmente em pipelines automatizados de aprendizado de máquina estão desatualizados há décadas e frequentemente usam apenas métodos básicos bilineares, bicúbicos e vizinhos mais próximos. redimensionando – métodos que tratam todos os pixels indiscriminadamente.

Em contraste, o método proposto aumenta os dados da imagem por meio de uma CNN e incorpora essa entrada nas imagens redimensionadas que, por fim, passarão pela arquitetura do modelo.

Restrições de imagem no treinamento de IA

Para treinar um modelo que lida com imagens, uma estrutura de aprendizado de máquina incluirá um estágio de pré-processamento, onde uma variedade díspar de imagens de vários tamanhos, espaços de cores e resoluções (que contribuirão para o conjunto de dados de treinamento) são sistematicamente cortadas e redimensionado em dimensões consistentes e um formato único e estável.

Em geral, isso envolverá algum compromisso com base no formato PNG, onde será estabelecido um compromisso entre tempo/recursos de processamento, tamanho do arquivo e qualidade da imagem.

Na maioria dos casos, as dimensões finais da imagem processada são muito pequenas. Abaixo, vemos um exemplo de imagem com resolução de 80 × 80 na qual alguns dos primeiros conjuntos de dados de deepfakes foram gerados:

Como os rostos (e outros assuntos possíveis) raramente se encaixam na proporção quadrada necessária, pode ser necessário adicionar barras pretas (ou espaço desperdiçado permitido) para homogeneizar as imagens, reduzindo ainda mais os dados de imagem utilizáveis reais:

Aqui, o rosto foi extraído de uma área maior da imagem até ser recortado da forma mais econômica possível para incluir toda a área do rosto. No entanto, como visto à direita, grande parte da área restante não será utilizada durante o treinamento, reforçando a importância da qualidade da imagem dos dados redimensionados.

Como os recursos de GPU melhoraram nos últimos anos, com a nova geração de placas NVIDIA equipadas com quantidades crescentes de video-RAM (VRAM), os tamanhos médios de imagem de contribuição estão começando a aumentar, embora 224 × 224 pixels ainda seja bastante padrão (por exemplo, é o tamanho do ResNet-50 conjunto de dados).

Uma imagem não redimensionada de 224 × 244 pixels.

Encaixando lotes na VRAM

A razão pela qual as imagens devem ser todas do mesmo tamanho é que Gradiente descendente, o método pelo qual o modelo melhora ao longo do tempo, requer dados de treinamento uniformes.

A razão pela qual as imagens precisam ser tão pequenas é que elas devem ser carregadas (totalmente descompactadas) na VRAM durante o treinamento em pequenos lotes, geralmente entre 6 a 24 imagens por lote. Poucas imagens por lote e não há material de grupo suficiente para generalizar bem, além de estender o tempo de treinamento; demais, e o modelo pode falhar em obter as características e detalhes necessários (veja abaixo).

Esta seção de 'carregamento ao vivo' da arquitetura de treinamento é chamada de espaço latente. É aqui que os recursos são extraídos repetidamente dos mesmos dados (ou seja, as mesmas imagens) até que o modelo tenha convergido para um estado em que tenha todo o conhecimento generalizado necessário para realizar transformações em dados posteriores não vistos de um tipo semelhante.

Esse processo geralmente leva dias, embora possa levar até um mês ou mais de cogitação constante e inflexível 24 horas por dia, 7 dias por semana, para alcançar uma generalização útil. Os aumentos no tamanho da VRAM são úteis apenas até certo ponto, pois até mesmo pequenos incrementos na resolução da imagem podem ter um efeito de ordem de grandeza na capacidade de processamento e efeitos relacionados na precisão que nem sempre são favoráveis.

O uso de maior capacidade de VRAM para acomodar tamanhos de lote maiores também é uma bênção mista, pois as maiores velocidades de treinamento obtidas por isso são provavelmente será compensado por resultados menos precisos.

Portanto, uma vez que a arquitetura de treinamento é tão restrita, qualquer coisa que possa efetuar uma melhoria dentro das limitações existentes do pipeline é uma conquista notável.

Como o downsizing superior ajuda

A qualidade final de uma imagem que será incluída em um conjunto de dados de treinamento provou ter um efeito de melhoria no resultado do treinamento, particularmente em tarefas de reconhecimento de objetos. Em 2018, pesquisadores do Max Planck Institute for Intelligent Systems contendido que a escolha do método de reamostragem impacta notavelmente o desempenho e os resultados do treinamento.

Além disso, trabalhos anteriores do Google (co-escritos pelos autores do novo artigo) descobriram que a precisão da classificação pode ser melhorada por mantendo o controle sobre artefatos de compressão em imagens de conjunto de dados.

O modelo CNN incorporado ao novo reamostrador combina o redimensionamento bilinear com um recurso de 'ignorar conexão' que pode incorporar a saída da rede treinada na imagem redimensionada.

Diferentemente de uma arquitetura típica de codificador/decodificador, a nova proposta pode atuar não apenas como um gargalo de alimentação direta, mas também como um gargalo inverso para o escalonamento para qualquer tamanho e/ou proporção de tela. Além disso, o método de reamostragem "padrão" pode ser substituído por qualquer outro método tradicional adequado, como o Lanczos.

Detalhes de alta frequência

O novo método produz imagens que, na prática, parecem "incorporar" características-chave (que serão reconhecidas pelo processo de treinamento) diretamente na imagem de origem. Em termos estéticos, os resultados são nada convencionais:

O novo método aplicado em quatro redes – Inception V2; DenseNet-121; ResNet-50; e MobileNet-V2. Os resultados do método de redução/redimensionamento de imagens do Google Research produzem imagens com agregação óbvia de pixels, antecipando os principais recursos que serão identificados durante o processo de treinamento.

Os pesquisadores observam que esses experimentos iniciais são otimizados exclusivamente para tarefas de reconhecimento de imagem e que, em testes, seu "redimensionador aprendido" com tecnologia CNN conseguiu alcançar taxas de erro melhores nessas tarefas. Os pesquisadores pretendem, no futuro, aplicar o método a outros tipos de aplicações de visão computacional baseadas em imagens.