Artificial Intelligence

Zero123++: pojedynczy obraz do spójnego modelu podstawowego dyfuzji z wieloma widokami

W ciągu ostatnich kilku lat nastąpił szybki postęp w zakresie wydajności, wydajności i możliwości generatywnych powstającej powieści Modele generatywne AI które wykorzystują obszerne zbiory danych i praktyki generowania dyfuzji 2D. Obecnie generatywne modele sztucznej inteligencji są niezwykle zdolne do generowania różnych form treści multimedialnych 2D i do pewnego stopnia 3D, w tym tekstu, obrazów, filmów, plików GIF i innych.

W tym artykule będziemy mówić o frameworku Zero123++, modelu AI generującym dyfuzję uwarunkowaną obrazem, którego celem jest generowanie spójnych obrazów 3D z wieloma widokami przy użyciu pojedynczego widoku. Aby zmaksymalizować korzyści uzyskane z wcześniej wytrenowanych modeli generatywnych, platforma Zero123++ implementuje liczne schematy uczenia i warunkowania, aby zminimalizować wysiłek potrzebny do dostrojenia standardowych modeli obrazu dyfuzyjnego. Zagłębimy się w architekturę, działanie i wyniki frameworka Zero123++ oraz przeanalizujemy jego możliwości w zakresie generowania spójnych obrazów o wysokiej jakości i wielu widokach z jednego obrazu. Więc zacznijmy.

Zero123 i Zero123++: wprowadzenie

Framework Zero123++ to model sztucznej inteligencji generujący dyfuzję uwarunkowaną obrazem, którego celem jest generowanie spójnych obrazów 3D z wieloma widokami przy użyciu pojedynczego widoku. Framework Zero123++ jest kontynuacją frameworka Zero123 lub Zero-1-to-3, który wykorzystuje technikę syntezy obrazu typu zero-shot, aby stworzyć pionierską konwersję pojedynczego obrazu do 3D typu open source. Chociaż framework Zero123++ zapewnia obiecującą wydajność, obrazy generowane przez ten framework mają widoczne niespójności geometryczne i jest to główny powód, dla którego nadal istnieje luka pomiędzy scenami 3D i obrazami z wielu widoków.

Struktura Zero-1 do 3 służy jako podstawa dla kilku innych platform, w tym SyncDreamer, One-2-3-45, Consistent123 i innych, które dodają dodatkowe warstwy do platformy Zero123 w celu uzyskania bardziej spójnych wyników podczas generowania obrazów 3D. Inne platformy, takie jak ProlificDreamer, DreamFusion, DreamGaussian i inne, stosują podejście oparte na optymalizacji w celu uzyskania obrazów 3D poprzez destylację obrazu 3D z różnych niespójnych modeli. Chociaż techniki te są skuteczne i generują zadowalające obrazy 3D, wyniki można poprawić poprzez wdrożenie podstawowego modelu dyfuzji, zdolnego do spójnego generowania obrazów z wielu widoków. W związku z tym framework Zero123++ przyjmuje Zero-1 do-3 i dostraja nowy podstawowy model dyfuzji z wieloma widokami ze Stable Diffusion.

W modelu od 1 do 3 każdy nowy widok jest generowany niezależnie, a to podejście prowadzi do niespójności między widokami generowanymi, ponieważ modele dyfuzji mają charakter próbkowania. Aby rozwiązać ten problem, platforma Zero123++ przyjmuje podejście polegające na układaniu kafelków, w którym obiekt jest otoczony sześcioma widokami w jednym obrazie, i zapewnia prawidłowe modelowanie łącznego rozkładu obrazów obiektu z wielu widoków.

Kolejnym poważnym wyzwaniem stojącym przed programistami pracującymi nad frameworkiem Zero-1 do 3 jest to, że nie wykorzystuje on w wystarczającym stopniu możliwości oferowanych przez Stabilna dyfuzja co ostatecznie prowadzi do nieefektywności i dodatkowych kosztów. Istnieją dwa główne powody, dla których platforma Zero 1 do 3 nie może zmaksymalizować możliwości oferowanych przez Stable Diffusion

- Podczas uczenia w warunkach obrazu struktura od zera do 1 nie uwzględnia skutecznie lokalnych ani globalnych mechanizmów warunkowania oferowanych przez Stable Diffusion.

- Podczas uczenia struktura Zero 1 do 3 wykorzystuje zmniejszoną rozdzielczość, czyli podejście, w którym rozdzielczość wyjściowa jest zmniejszana poniżej rozdzielczości szkoleniowej, co może obniżyć jakość generowania obrazu dla modeli ze stabilną dyfuzją.

Aby rozwiązać te problemy, platforma Zero123++ implementuje szereg technik warunkowania, które maksymalizują wykorzystanie zasobów oferowanych przez Stable Diffusion i utrzymują jakość generowania obrazów dla modeli Stable Diffusion.

Poprawa kondycji i konsystencji

Próbując poprawić kondycjonowanie obrazu i spójność obrazu w wielu widokach, platforma Zero123++ zaimplementowała różne techniki, przy czym głównym celem było ponowne wykorzystanie wcześniejszych technik pochodzących z wstępnie wyszkolonego modelu Stable Diffusion.

Generacja wielu widoków

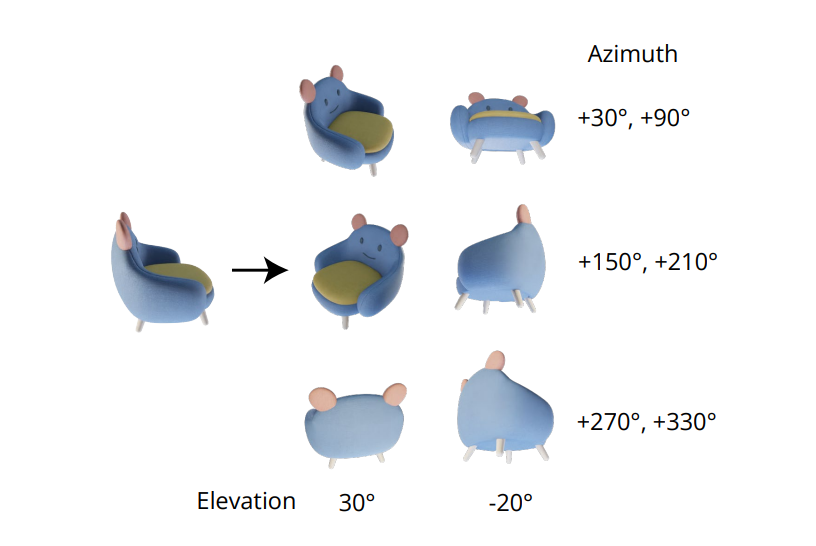

Niezbędna jakość generowania spójnych obrazów wielowidokowych polega na prawidłowym modelowaniu łącznego rozkładu wielu obrazów. W strukturze od 1 do 3 korelacja między obrazami z wielu widoków jest ignorowana, ponieważ dla każdego obrazu struktura niezależnie i osobno modeluje warunkową dystrybucję krańcową. Jednak w środowisku Zero123++ programiści wybrali podejście polegające na układaniu kafelków, które polega na ułożeniu 6 obrazów w pojedynczą klatkę/obraz w celu spójnego generowania wielu widoków, a proces ten pokazano na poniższym obrazie.

Co więcej, zauważono, że orientacje obiektów mają tendencję do ujednoznaczniania podczas uczenia modelu na podstawie pozycji kamery i aby zapobiec temu ujednoznacznieniu, platforma Zero 1 do 3 ćwiczy pozycje kamery z kątami elewacji i azymutem względnym względem danych wejściowych. Aby wdrożyć to podejście, konieczna jest znajomość kąta elewacji widoku danych wejściowych, który jest następnie używany do określenia względnej pozycji pomiędzy nowatorskimi widokami wejściowymi. Próbując poznać ten kąt elewacji, frameworki często dodają moduł szacowania wysokości, a takie podejście często wiąże się z dodatkowymi błędami w rurociągu.

Harmonogram hałasu

Skalowany harmonogram liniowy, oryginalny harmonogram szumów dla Stable Diffusion koncentruje się głównie na szczegółach lokalnych, ale jak widać na poniższym obrazie, ma bardzo niewiele kroków z niższym SNR lub stosunkiem sygnału do szumu.

Te etapy niskiego stosunku sygnału do szumu występują na początku etapu odszumiania, etapu kluczowego dla określenia globalnej struktury niskich częstotliwości. Zmniejszenie liczby kroków na etapie odszumiania, podczas zakłócania lub uczenia, często skutkuje większymi zmianami strukturalnymi. Chociaż ta konfiguracja jest idealna do generowania pojedynczego obrazu, ogranicza ona zdolność struktury do zapewnienia globalnej spójności między różnymi widokami. Aby pokonać tę przeszkodę, platforma Zero123++ dostraja model LoRA w ramach platformy v-prediction Stable Diffusion 2 w celu wykonania zadania zabawki, a wyniki przedstawiono poniżej.

Dzięki skalowanemu, liniowemu harmonogramowi szumów model LoRA nie ulega nadmiernemu dopasowaniu, a jedynie nieznacznie wybiela obraz. I odwrotnie, podczas pracy z liniowym harmonogramem szumów środowisko LoRA pomyślnie generuje pusty obraz niezależnie od monitu wejściowego, co oznacza wpływ harmonogramu szumów na zdolność środowiska do dostosowania się do nowych wymagań na całym świecie.

Skalowana uwaga referencyjna dla warunków lokalnych

Dane wejściowe pojedynczego widoku lub obrazy kondycjonujące w strukturze od Zero 1 do 3 są łączone z zaszumionymi danymi wejściowymi w wymiarze cech, które mają zostać zaszumione w celu kondycjonowania obrazu.

To połączenie prowadzi do nieprawidłowej zgodności przestrzennej w pikselach między obrazem docelowym a sygnałem wejściowym. Aby zapewnić odpowiednie dane wejściowe dotyczące lokalnego warunkowania, platforma Zero123++ wykorzystuje skalowaną uwagę referencyjną, podejście, w którym uruchomienie odszumiającego modelu UNet jest odwoływane do dodatkowego obrazu referencyjnego, po czym następuje dołączenie macierzy wartości i klucza samouwagi z odniesienia obraz do odpowiednich warstw uwagi, gdy sygnał wejściowy modelu zostanie odszumiony, co pokazano na poniższym rysunku.

Podejście referencyjne jest w stanie poprowadzić model dyfuzji w celu wygenerowania obrazów mających wspólną teksturę z obrazem referencyjnym i treść semantyczną bez żadnego dostrajania. Dzięki precyzyjnemu dostrojeniu podejście Reference Attention zapewnia doskonałe wyniki przy skalowaniu ukrytych wartości.

Kondycjonowanie globalne: FlexDiffuse

W oryginalnym podejściu Stable Diffusion osadzania tekstu są jedynym źródłem osadzania globalnego, a podejście to wykorzystuje platformę CLIP jako koder tekstu do przeprowadzania badań krzyżowych pomiędzy osadzeniem tekstu a ukrytymi modelami. W rezultacie programiści mogą dowolnie wykorzystywać wyrównanie między przestrzeniami tekstowymi, a wynikowymi obrazami CLIP w celu wykorzystania go do globalnego warunkowania obrazu.

W ramach Zero123++ zaproponowano wykorzystanie możliwego do wyszkolenia wariantu mechanizmu prowadzenia liniowego w celu włączenia globalnego warunkowania obrazu do struktury przy minimalnych strojenie potrzebne, a wyniki przedstawiono na poniższym obrazku. Jak widać, bez obecności globalnego uwarunkowania obrazu, jakość treści generowanych przez framework jest zadowalająca dla widocznych obszarów, które odpowiadają obrazowi wejściowemu. Jednakże jakość obrazu generowanego przez strukturę niewidocznych obszarów ulega znacznemu pogorszeniu, co wynika głównie z niemożności wywnioskowania przez model globalnej semantyki obiektu.

Architektura modelu

Framework Zero123++ jest trenowany z modelem Stable Diffusion 2v jako podstawą przy użyciu różnych podejść i technik wymienionych w artykule. Struktura Zero123++ jest wstępnie przeszkolona na zestawie danych Objaverse, który jest renderowany przy użyciu losowego oświetlenia HDRI. Struktura przyjmuje również podejście do harmonogramu etapowego szkolenia stosowane w strukturze zmian obrazu stabilnego rozproszenia, próbując jeszcze bardziej zminimalizować ilość wymaganego dostrajania i zachować jak najwięcej z wcześniejszego stabilnego rozproszenia.

Działanie lub architekturę frameworka Zero123++ można dalej podzielić na kolejne kroki lub fazy. W pierwszej fazie struktura dostraja macierze KV warstw wzajemnej uwagi oraz warstwy samouważności Stable Diffusion z AdamW jako optymalizatorem, 1000 kroków rozgrzewkowych i harmonogram szybkości uczenia się cosinusa maksymalizujący przy 7×10-5. W drugiej fazie struktura wykorzystuje wysoce konserwatywne, stałe tempo uczenia się z 2000 seriami rozgrzewkowymi i wykorzystuje podejście Min-SNR, aby zmaksymalizować wydajność podczas treningu.

Zero123++: Wyniki i porównanie wydajności

Jakość wykonania

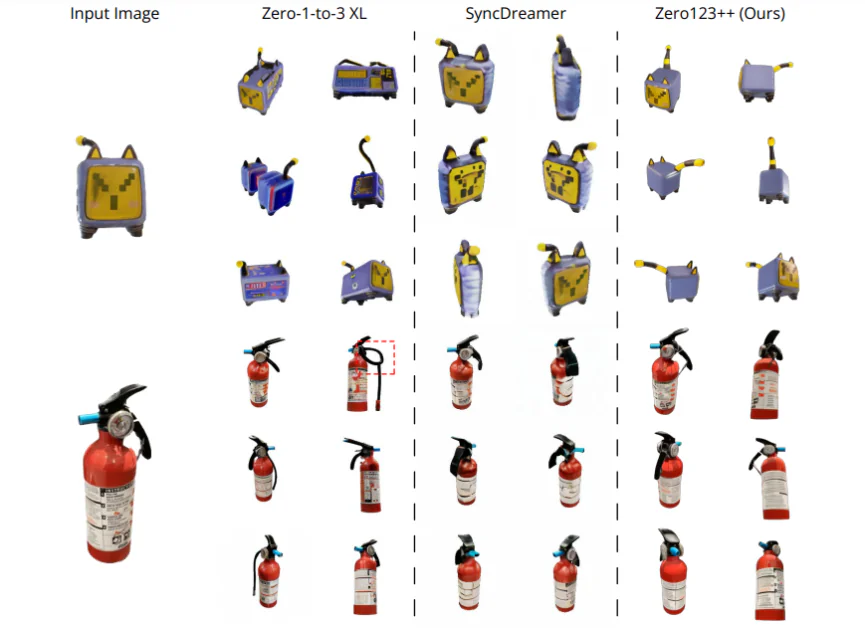

Aby ocenić wydajność frameworka Zero123++ na podstawie generowanej jakości, porównuje się go z SyncDreamer i Zero-1-to-3-XL, dwoma najnowocześniejszymi frameworkami do generowania treści. Ramy są porównywane z czterema obrazami wejściowymi o różnym zakresie. Pierwsze zdjęcie to elektryczny kot-zabawka, pobrane bezpośrednio ze zbioru danych Objaverse i przedstawia dużą niepewność co do tylnej części obiektu. Drugi to obraz gaśnicy, a trzeci to obraz psa siedzącego na rakiecie, wygenerowany przez model SDXL. Ostateczny obraz to ilustracja anime. Wymagane stopnie wysokości podbudowy osiąga się przy użyciu metody szacowania wysokości w ramach One-2-3-4-5, a usuwanie tła osiąga się przy użyciu struktury SAM. Jak widać, platforma Zero123++ konsekwentnie generuje wysokiej jakości obrazy z wieloma widokami i jest w stanie równie dobrze uogólniać na ilustracje 2D spoza domeny, jak i obrazy generowane przez sztuczną inteligencję.

Analiza ilościowa

Aby ilościowo porównać platformę Zero123++ z najnowocześniejszymi platformami Zero-1 do 3 i Zero-1 do-3 XL, programiści oceniają wynik podobieństwa wyuczonej łaty obrazu percepcyjnego (LPIPS) tych modeli na podstawie podzielonych danych walidacyjnych, stanowiących podzbiór zbioru danych Objaverse. Aby ocenić wydajność modelu podczas generowania obrazów w wielu widokach, programiści sąsiadują odpowiednio z podstawowymi obrazami referencyjnymi i 6 wygenerowanymi obrazami, a następnie obliczają wynik podobieństwa wyuczonej łaty obrazu percepcyjnego (LPIPS). Wyniki przedstawiono poniżej i jak wyraźnie widać, framework Zero123++ osiąga najlepszą wydajność w zestawie podziału walidacyjnego.

Tekst do oceny wielu widoków

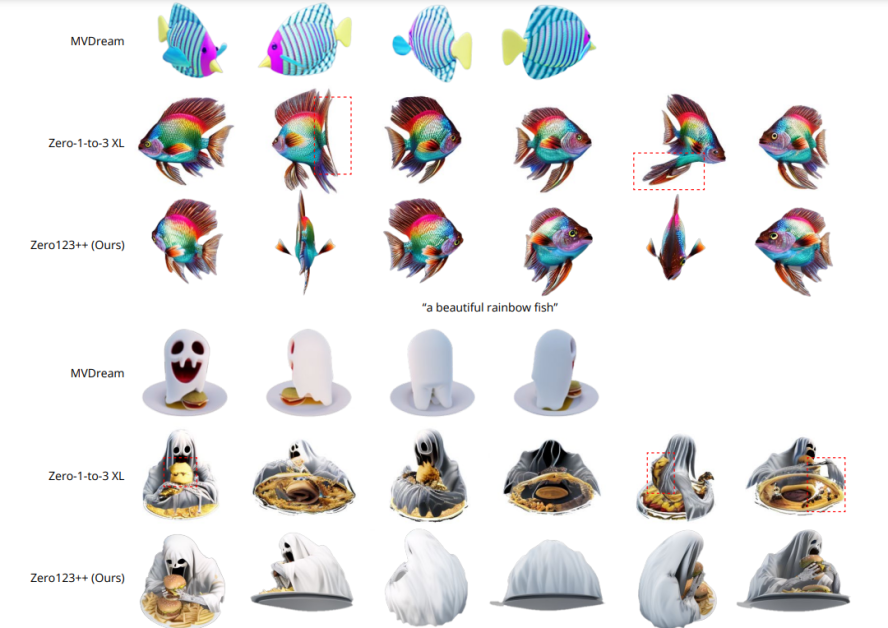

Aby ocenić możliwości platformy Zero123++ w generowaniu treści typu Text to Multi-View, programiści najpierw wykorzystują platformę SDXL z podpowiedziami tekstowymi do wygenerowania obrazu, a następnie wykorzystują platformę Zero123++ do wygenerowanego obrazu. Wyniki przedstawiono na poniższym obrazie i jak widać, w porównaniu ze strukturą Zero 1 do 3, która nie może zagwarantować spójnego generowania wielu widoków, platforma Zero123++ zapewnia spójne, realistyczne i bardzo szczegółowe wieloobrazy przeglądaj obrazy, wdrażając zamiana tekstu na obraz na wiele widoków podejście lub rurociąg.

Zero123++ Sieć kontroli głębokości

Oprócz podstawowego frameworka Zero123++ programiści wypuścili także Depth ControlNet Zero123++, wersję oryginalnego frameworka z kontrolą głębi, zbudowaną przy użyciu architektury ControlNet. Znormalizowane obrazy liniowe są renderowane w odniesieniu do kolejnych obrazów RGB, a struktura ControlNet jest szkolona w zakresie kontrolowania geometrii struktury Zero123++ przy użyciu percepcji głębi.

Wnioski

W tym artykule omówiliśmy Zero123++, model AI generujący dyfuzję uwarunkowaną obrazem, którego celem jest generowanie spójnych obrazów 3D z wieloma widokami przy użyciu pojedynczego widoku. Aby zmaksymalizować korzyści uzyskane z wcześniej wytrenowanych modeli generatywnych, platforma Zero123++ implementuje liczne schematy uczenia i warunkowania, aby zminimalizować wysiłek potrzebny do dostrojenia standardowych modeli obrazu dyfuzyjnego. Omówiliśmy także różne podejścia i ulepszenia wdrożone przez framework Zero123++, które pomagają mu osiągnąć wyniki porównywalne, a nawet przewyższające te osiągane przez najnowocześniejsze frameworki.

Jednak pomimo swojej wydajności i możliwości spójnego generowania wysokiej jakości obrazów z wielu widoków, platforma Zero123++ nadal wymaga pewnych ulepszeń, a potencjalnymi obszarami badań są:

- Dwustopniowy model rafinacji co mogłoby rozwiązać problem niezdolności Zero123++ do spełnienia globalnych wymagań dotyczących spójności.

- Dodatkowe skalowanie aby jeszcze bardziej ulepszyć zdolność Zero123++ do generowania obrazów o jeszcze wyższej jakości.