Artificial Intelligence

StyleTTS 2: zamiana tekstu na mowę na poziomie człowieka z dużymi modelami języka mowy

W związku z rozwojem metod syntezy mowy naturalnej i syntetycznej jednym z głównych osiągnięć branży sztucznej inteligencji w ciągu ostatnich kilku lat jest skuteczna synteza struktur zamiany tekstu na mowę z potencjalnymi zastosowaniami w różnych branżach, w tym audiobookach, wirtualnych asystentach, systemach głosowych -narracje i nie tylko, z niektórymi najnowocześniejszymi trybami zapewniającymi wydajność i efektywność na poziomie człowieka w szerokiej gamie zadań związanych z mową. Jednak pomimo ich dobrej wydajności, nadal istnieje pole do ulepszenia w przypadku zadań dzięki wyrazistej i zróżnicowanej mowie, wymaganiu dużej ilości danych szkoleniowych w celu optymalizacji struktur zamiany tekstu na mowę zerową oraz odporności na prowadzenie tekstów OOD lub Out of Distribution programistom pracę nad bardziej niezawodnym i dostępnym frameworkiem zamiany tekstu na mowę.

W tym artykule będziemy mówić o StyleTTS-2, solidnym i innowacyjnym frameworku zamiany tekstu na mowę, zbudowanym na fundamentach StyleTTS i mającym na celu przedstawienie kolejnego kroku w kierunku najnowocześniejszych systemów tekstu na mowę. Struktura StyleTTS2 modeluje style mowy jako ukryte zmienne losowe i wykorzystuje probabilistyczny model dyfuzji do próbkowania tych stylów mowy lub zmiennych losowych, umożliwiając w ten sposób platformie StyleTTS2 efektywną syntezę realistycznej mowy bez użycia referencyjnych wejść audio. Dzięki takiemu podejściu framework StyleTTS2 jest w stanie zapewnić lepsze wyniki i wykazuje wysoką wydajność w porównaniu z obecnymi najnowocześniejszymi frameworkami zamiany tekstu na mowę, ale jest także w stanie wykorzystać różnorodną syntezę mowy oferowaną przez ramy modelu dyfuzji. Będziemy omawiać framework StyleTTS2 bardziej szczegółowo, mówić o jego architekturze i metodologii, jednocześnie przyglądając się wynikom osiągniętym przez framework. Więc zacznijmy.

StyleTTS2 do syntezy tekstu na mowę: wprowadzenie

StyleTTS2 to innowacyjny model syntezy tekstu na mowę, który stanowi kolejny krok w kierunku tworzenia struktur TTS na poziomie ludzkim i opiera się na StyleTTS, tekście opartym na stylach model generowania mowy. Struktura StyleTTS2 modeluje style mowy jako ukryte zmienne losowe i wykorzystuje probabilistyczny model dyfuzji do próbkowania tych stylów mowy lub zmiennych losowych, umożliwiając w ten sposób platformie StyleTTS2 efektywną syntezę realistycznej mowy bez użycia referencyjnych wejść audio. Modelowanie stylów jako ukrytych zmiennych losowych odróżnia platformę StyleTTS2 od jej poprzedniczki, platformy StyleTTS, i ma na celu wygenerowanie najbardziej odpowiedniego stylu mowy dla tekstu wejściowego bez konieczności referencyjnego wejścia audio i jest w stanie osiągnąć efektywne dyfuzje ukryte podczas pobierania korzyści z różnorodnych możliwości syntezy mowy oferowanych przez modele dyfuzyjne. Ponadto platforma StyleTTS2 wykorzystuje również wstępnie wytrenowany duży model SLM lub model języka mowy jako dyskryminatory, takie jak framework WavLM, i łączy go z własnym, nowatorskim podejściem do modelowania różnicowego czasu trwania, aby wyszkolić platformę od końca do końca i ostatecznie wygenerować mowę o zwiększonej naturalności. Dzięki przyjętemu podejściu framework StyleTTS2 przewyższa obecne najnowocześniejsze frameworki do zadań generowania mowy i jest jednym z najbardziej wydajnych frameworków do wstępnego uczenia wielkoskalowych modeli mowy w ustawieniu zerowym dla zadań adaptacji mówcy.

Idąc dalej, aby zapewnić syntezę tekstu na mowę na poziomie człowieka, platforma StyleTTs2 uwzględnia wnioski z istniejących prac, w tym modele dyfuzji do syntezy mowy i duże modele języka mowy. Modele dyfuzyjne są zwykle używane do zadań związanych z syntezą mowy ze względu na ich zdolność do precyzyjnej kontroli mowy i różnorodne możliwości próbkowania mowy. Jednak modele dyfuzyjne nie są tak wydajne, jak nieiteracyjne struktury oparte na GAN, a głównym powodem tego jest wymóg iteracyjnego próbkowania ukrytych reprezentacji, kształtów fal i spektrogramów mel do docelowego czasu trwania mowy.

Z drugiej strony, ostatnie prace dotyczące dużych modeli języka mowy wykazały ich zdolność do poprawy jakości zadań związanych z generowaniem tekstu na mowę i dobrego dostosowania się do mówiącego. Duże modele języka mowy zazwyczaj przekształcają wprowadzany tekst na skwantowane lub ciągłe reprezentacje pochodzące z wcześniej wytrenowanych struktur języka mowy na potrzeby zadań rekonstrukcji mowy. Jednakże funkcje tych modeli języka mowy nie są zoptymalizowane bezpośrednio pod kątem syntezy mowy. W przeciwieństwie do tego, framework StyleTTS2 wykorzystuje wiedzę zdobytą przez duże frameworki SLM wykorzystujące trening kontradyktoryjny do syntezy cech modeli języka mowy bez użycia map przestrzeni ukrytej, a zatem bezpośredniego uczenia się przestrzeni ukrytej zoptymalizowanej pod kątem syntezy mowy.

StyleTTS2: Architektura i metodologia

W swojej istocie StyleTTS2 opiera się na swoim poprzedniku, frameworku StyleTTS, który jest nieautoregresywnym frameworkiem zamiany tekstu na mowę, który wykorzystuje koder stylu do wyprowadzenia wektora stylu z referencyjnego dźwięku, umożliwiając w ten sposób ekspresyjne i naturalne generowanie mowy. Wektor stylu używany w frameworku StyleTTS jest włączany bezpośrednio do kodera, czasu trwania i predyktorów poprzez wykorzystanie AdaIN lub adaptacyjnej normalizacji instancji, umożliwiając w ten sposób modelowi StyleTTS generowanie komunikatów mowy o różnej prozodii, czasie trwania, a nawet emocjach. Framework StyleTTS składa się łącznie z 8 modeli podzielonych na trzy kategorie

- Modele akustyczne lub system generowania mowy z koderem stylu, koderem tekstu i dekoderem mowy.

- System przewidywania tekstu na mowę wykorzystujący prozodię i predyktory czasu trwania.

- System narzędziowy obejmujący moduł wyrównywania tekstu, ekstraktor wysokości i dyskryminator do celów szkoleniowych.

Dzięki swojemu podejściu framework StyleTTS zapewnia najnowocześniejszą wydajność związaną z kontrolowaną i różnorodną syntezą mowy. Jednak ta wydajność ma swoje wady, takie jak pogorszenie jakości próbki, ograniczenia ekspresji i poleganie na aplikacjach zakłócających mowę w czasie rzeczywistym.

Udoskonalając strukturę StyleTTS, model StyleTTS2 zapewnia lepszą ekspresję tekst na mowę zadań o lepszej wydajności poza dystrybucją i wysokiej jakości na poziomie ludzkim. Struktura StyleTTS2 wykorzystuje kompleksowy proces szkolenia, który optymalizuje różne komponenty za pomocą treningu kontradyktoryjnego i łącznie bezpośredniej syntezy przebiegów. W przeciwieństwie do struktury StyleTTS, struktura StyleTTS2 modeluje styl mowy jako zmienną ukrytą i próbkuje go za pomocą modeli dyfuzji, generując w ten sposób różnorodne próbki mowy bez użycia referencyjnego dźwięku. Przyjrzyjmy się szczegółowo tym komponentom.

Kompleksowe szkolenie w zakresie zakłóceń

W ramach StyleTTS2 zastosowano kompleksowe podejście szkoleniowe w celu optymalizacji różnych komponentów tekstu na mowę pod kątem zakłóceń, bez konieczności polegania na stałych komponentach. Struktura StyleTTS2 osiąga to poprzez modyfikację dekodera w celu wygenerowania kształtu fali bezpośrednio z wektora stylu, krzywych wysokości i energii oraz wyrównanych reprezentacji. Następnie platforma usuwa ostatnią warstwę projekcyjną dekodera i zastępuje ją dekoderem kształtu fali. Struktura StyleTTS2 wykorzystuje dwa kodery: dekoder oparty na HifiGAN do bezpośredniego generowania kształtu fali oraz dekoder oparty na iSTFT do tworzenia fazy i wielkości, które są przekształcane na kształty fal w celu szybszej interferencji i treningu.

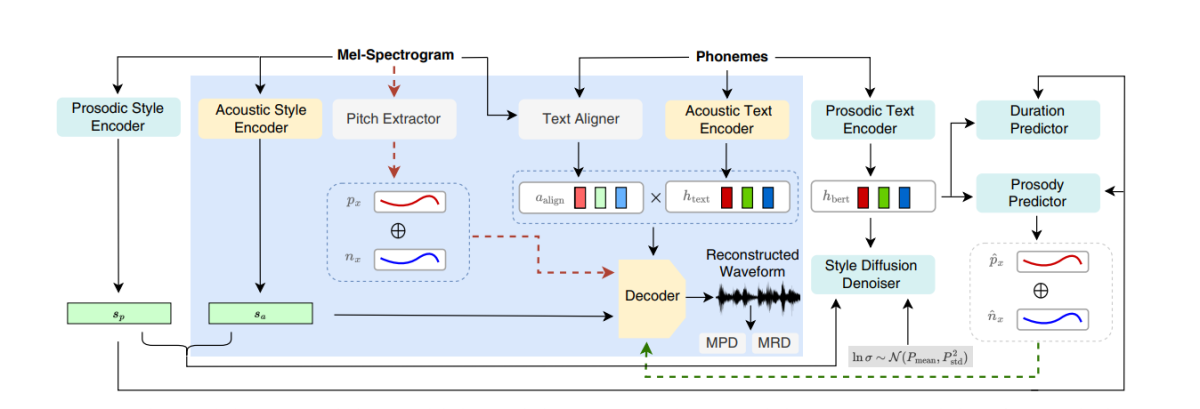

Powyższy rysunek przedstawia modele akustyczne stosowane podczas treningu przedtreningowego i wspólnego. Aby skrócić czas szkolenia, moduły są najpierw optymalizowane w fazie przedtreningowej, a następnie optymalizowane są wszystkie komponenty bez ekstraktora boiska podczas wspólnego szkolenia. Powodem, dla którego wspólne szkolenie nie optymalizuje ekstraktora wysokości tonu, jest to, że służy on do zapewnienia podstawowej prawdy o krzywych wysokości tonu.

Powyższy rysunek przedstawia trening kontradyktoryjny modelu języka mowy i interakcję ze strukturą WavLM, wstępnie wyszkoloną, ale nie dostrojoną. Proces różni się od opisanego powyżej, ponieważ może wymagać różnych tekstów wejściowych, ale gromadzi gradienty w celu aktualizacji parametrów w każdej partii.

Rozpowszechnianie stylu

Struktura StyleTTS2 ma na celu modelowanie mowy jako rozkładu warunkowego za pomocą ukrytej zmiennej, która następuje po rozkładzie warunkowym, a zmienna ta nazywa się uogólnionym stylem mowy i reprezentuje dowolną cechę próbki mowy poza zakresem jakiejkolwiek treści fonetycznej, w tym akcentu leksykalnego, prozodię, tempo mówienia, a nawet przejścia formantów.

Dyskryminatory modelu języka mowy

Modele języka mowy są znane ze swoich ogólnych zdolności do kodowania cennych informacji dotyczących szerokiego zakresu semantyki i aspektów akustycznych, a reprezentacje SLM tradycyjnie były w stanie naśladować ludzkie postrzeganie w celu oceny jakości generowanej syntezowanej mowy. Struktura StyleTTS2 wykorzystuje podejście do szkolenia kontradyktoryjnego, aby wykorzystać zdolność koderów SLM do wykonywania zadań generatywnych i wykorzystuje 12-warstwową strukturę WavLM jako dyskryminator. Dzięki takiemu podejściu platforma umożliwia szkolenia w zakresie tekstów OOD lub Out Of Distribution, które mogą pomóc w poprawie wydajności. Ponadto, aby zapobiec problemom związanym z nadmiernym dopasowaniem, platforma próbkuje teksty OOD i dystrybucję z równym prawdopodobieństwem.

Modelowanie różniczkowalnego czasu trwania

Tradycyjnie predyktor czasu trwania jest używany w strukturach zamiany tekstu na mowę, które generują czasy trwania fonemów, ale metody próbkowania w górę stosowane przez te predyktory czasu trwania często blokują przepływ gradientu podczas procesu uczenia E2E, a struktura NaturalSpeech wykorzystuje oparty na uwadze upsampler dla poziomu ludzkiego konwersja tekstu na mowę. Jednak w ramach StyleTTS2 podejście to jest niestabilne podczas treningu kontradyktoryjnego, ponieważ StyleTTS2 trenuje przy użyciu różnicowego upsamplingu z różnymi treningami kontradyktoryjnymi bez utraty dodatkowych terminów z powodu niedopasowania długości spowodowanego odchyleniami. Chociaż zastosowanie miękkiego, dynamicznego podejścia do dopasowania czasu może pomóc w złagodzeniu tego niedopasowania, jego użycie jest nie tylko kosztowne obliczeniowo, ale jego stabilność stanowi również problem podczas pracy z celami kontradyktoryjnymi lub zadaniami rekonstrukcji mel. Dlatego, aby osiągnąć wydajność na poziomie ludzkim dzięki szkoleniu kontradyktoryjnemu i ustabilizować proces szkolenia, platforma StyleTTC2 wykorzystuje nieparametryczne podejście do próbkowania w górę. Upsampling Gaussa to popularna metoda nieparametrycznego upsamplingu służąca do konwersji przewidywanych czasów trwania, chociaż ma swoje ograniczenia ze względu na stałą długość z góry określonych jąder Gaussa. To ograniczenie dla próbkowania Gaussa ogranicza jego zdolność do dokładnego modelowania dopasowań o różnych długościach.

Aby stawić czoła tym ograniczeniom, platforma StyleTTC2 proponuje zastosowanie nowego, nieparametrycznego podejścia do próbkowania w górę, bez dodatkowego szkolenia i umożliwiającego uwzględnienie różnych długości dopasowań. Dla każdego fonemu struktura StyleTTC2 modeluje wyrównanie jako zmienną losową i wskazuje indeks ramki mowy, z którą dopasowuje się fonem.

Szkolenie i ocena modeli

Struktura StyleTTC2 jest szkolona i eksperymentowana na trzech zbiorach danych: VCTK, LibriTTS i LJSpeech. Komponent oparty na jednym głośniku w ramach StyleTTS2 jest szkolony przy użyciu zestawu danych LJSpeech, który zawiera około 13,000 12,500 próbek audio podzielonych na 100 500 próbek szkoleniowych, 24 próbek weryfikacyjnych i prawie 44,000 próbek testowych, a ich łączny czas działania wynosi prawie 100 godziny. Komponent platformy obejmujący wiele głośników jest szkolony na zbiorze danych VCTK składającym się z ponad 43,500 100 klipów audio z udziałem ponad 500 indywidualnych native speakerów z różnymi akcentami i jest podzielony na 250 1,150 próbek szkoleniowych, XNUMX próbek walidacyjnych i prawie XNUMX próbek testowych. Wreszcie, aby wyposażyć platformę w możliwości adaptacji zero-shot, platforma jest szkolona na połączonym zestawie danych LibriTTS, który składa się z klipów audio obejmujących łącznie około XNUMX godzin dźwięku z udziałem ponad XNUMX indywidualnych głośników. Aby ocenić jego wydajność, model wykorzystuje dwie metryki: MOS-N lub średni wynik opinii dotyczący naturalności oraz MECH lub Średni wynik opinii dotyczący podobieństwa.

Efekt

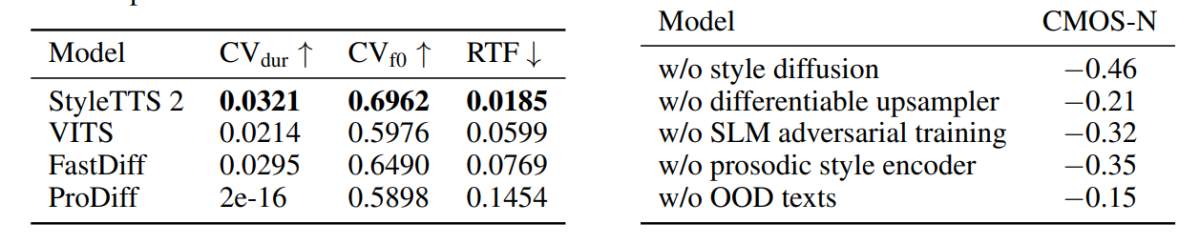

Podejście i metodologia zastosowana w ramach StyleTTS2 została zaprezentowana w jego wydajności, ponieważ model przewyższa kilka najnowocześniejszych platform TTS, szczególnie w przypadku zbioru danych NaturalSpeech i w trakcie jego trwania, ustanawiając nowy standard dla zbioru danych. Co więcej, platforma StyleTTS2 przewyższa najnowocześniejszą platformę VITS w zestawie danych VCTK, a wyniki przedstawiono na poniższym rysunku.

Model StyleTTS2 przewyższa także poprzednie modele w zestawie danych LJSpeech i nie wykazuje żadnego stopnia pogorszenia jakości tekstów OOD lub tekstów poza dystrybucją, jak to było wyświetlane we wcześniejszych platformach na podstawie tych samych metryk. Co więcej, w ustawieniu zerowym model StyleTTC2 przewyższa istniejącą platformę Vall-E pod względem naturalności, chociaż pozostaje w tyle pod względem podobieństwa. Warto jednak zauważyć, że framework StyleTTS2 jest w stanie osiągnąć konkurencyjną wydajność pomimo trenowania jedynie na 245 godzinach próbek audio w porównaniu z ponad 60 2 godzin szkolenia dla frameworka Vall-E, co udowadnia, że StyleTTCXNUMX jest alternatywą wydajną pod względem danych do istniejących dużych metod szkolenia wstępnego stosowanych w Vall-E.

Idąc dalej, ze względu na brak danych tekstowych audio oznaczonych emocjami, framework StyleTTC2 wykorzystuje model GPT-4 do generowania ponad 500 instancji różnych emocji w celu wizualizacji wektorów stylu, które framework tworzy przy użyciu swojego dyfuzja proces.

Na pierwszym rysunku style emocjonalne w odpowiedzi na nastroje w tekście wejściowym zilustrowano za pomocą wektorów stylu z modelu LJSpeech, co pokazuje zdolność platformy StyleTTC2 do syntezy mowy ekspresyjnej z różnymi emocjami. Drugi rysunek przedstawia odrębną formę skupień dla każdego z pięciu poszczególnych głośników, przedstawiając w ten sposób szeroki zakres różnorodności pochodzącej z pojedynczego pliku audio. Ostatni rysunek przedstawia luźne skupienie emocji z głośnika 1 i pokazuje, że pomimo pewnego nakładania się, dominują skupiska oparte na emocjach, co wskazuje na możliwość manipulowania melodią emocjonalną mówcy niezależnie od referencyjnej próbki audio i jej tonu wejściowego . Pomimo zastosowania podejścia opartego na rozpowszechnianiu, platforma StyleTTS2 przewyższa istniejące, najnowocześniejsze platformy, w tym VITS, ProDiff i FastDiff.

Final Thoughts

W tym artykule omówiliśmy StyleTTS2, nowatorską, solidną i innowacyjną platformę syntezy mowy zbudowaną na fundamentach platformy StyleTTS, której celem jest przedstawienie kolejnego kroku w kierunku najnowocześniejszych systemów syntezy mowy. Struktura StyleTTS2 modeluje style mowy jako ukryte zmienne losowe i wykorzystuje probabilistyczny model dyfuzji do próbkowania tych stylów mowy lub zmiennych losowych, umożliwiając w ten sposób platformie StyleTTS2 efektywną syntezę realistycznej mowy bez użycia referencyjnych wejść audio. Struktura StyleTTS2 wykorzystuje dyfuzję stylów i dyskryminatory SLM osiągnąć wydajność na poziomie ludzkim w przypadku zadań związanych z syntezą mowy i przewyższa istniejące najnowocześniejsze platformy w szerokim zakresie zadań związanych z mową.