Artificial Intelligence

Stabilna dyfuzja wideo: modele dyfuzji ukrytego wideo do dużych zbiorów danych

generatywna sztuczna inteligencja już od jakiegoś czasu jest siłą napędową społeczności AI, a postęp w dziedzinie generatywnego modelowania obrazu, zwłaszcza z wykorzystaniem modeli dyfuzyjnych, pomógł w znacznym postępie generatywnych modeli wideo nie tylko w badaniach, ale także pod względem aplikacje świata rzeczywistego. Konwencjonalnie generatywne modele wideo są albo trenowane od podstaw, albo są częściowo lub całkowicie dostrajane na podstawie wstępnie wytrenowanych modeli obrazu z dodatkowymi warstwami czasowymi, na mieszaninie zbiorów danych obrazu i wideo.

Kontynuując postęp w generatywnych modelach wideo, w tym artykule porozmawiamy o Stabilny model dyfuzji wideo, ukryty model dyfuzji wideo umożliwiający generowanie najnowocześniejszego obrazu w wysokiej rozdzielczości i treści wideo w wysokiej rozdzielczości. Porozmawiamy o tym, jak modele dyfuzji ukrytej wyszkolone do syntezy obrazów 2D poprawiły możliwości i wydajność generatywnych modeli wideo poprzez dodanie warstw czasowych i dostrojenie modeli na małych zbiorach danych składających się z filmów wysokiej jakości. Zagłębimy się w architekturę i działanie stabilnego modelu dyfuzji wideo, ocenimy jego wydajność na podstawie różnych wskaźników i porównamy go z aktualnymi najnowocześniejszymi frameworkami do generowania wideo. Więc zacznijmy.

Stabilny model dyfuzji wideo i generatywne modele wideo: wprowadzenie

Dzięki swemu niemal nieograniczonemu potencjałowi, Generatywna AI już od jakiegoś czasu jest głównym przedmiotem badań praktyków AI i ML, a w ciągu ostatnich kilku lat nastąpił szybki postęp zarówno pod względem efektywności, jak i wydajności generatywnych modeli obrazu. Wnioski wyciągnięte z generatywnych modeli obrazu umożliwiły naukowcom i programistom poczynienie postępów w zakresie generatywnych modeli wideo, co skutkuje większą praktycznością i zastosowaniami w świecie rzeczywistym. Jednak większość badań mających na celu poprawę możliwości generatywnych modeli wideo koncentruje się przede wszystkim na dokładnym rozmieszczeniu warstw czasowych i przestrzennych, a niewiele uwagi poświęca się badaniu wpływu wyboru właściwych danych na wynik tych modeli generatywnych.

Dzięki postępowi w zakresie generatywnych modeli obrazu badacze zaobserwowali, że wpływ dystrybucji danych uczących na wydajność modeli generatywnych jest rzeczywiście znaczący i niekwestionowany. Co więcej, badacze zaobserwowali również, że wstępne nauczenie generatywnego modelu obrazu na dużym i zróżnicowanym zbiorze danych, a następnie dostrojenie go na mniejszym zbiorze danych o lepszej jakości często skutkuje znaczną poprawą wydajności. Tradycyjnie w generatywnych modelach wideo wykorzystuje się wiedzę uzyskaną z udanych generatywnych modeli obrazu, a badacze nie zbadali jeszcze wpływu danych, a strategie szkoleniowe nie zostały jeszcze zbadane. Model stabilnej dyfuzji wideo jest próbą zwiększenia możliwości generatywnych modeli wideo poprzez wyprawę na nieznane wcześniej terytoria, ze szczególnym naciskiem na selekcję danych.

Najnowsze generatywne modele wideo opierają się na modelach dyfuzji oraz podejściach do warunkowania tekstu lub warunkowania obrazu w celu syntezy wielu spójnych klatek wideo lub obrazów. Modele dyfuzyjne są znane ze swojej zdolności do uczenia się, jak stopniowo odszumiać próbkę z rozkładu normalnego poprzez wdrożenie iteracyjnego procesu udoskonalania, i dostarczyły pożądanych wyników w przypadku wideo o wysokiej rozdzielczości oraz syntezy tekstu na obraz. Wykorzystując tę samą zasadę, model stabilnej dyfuzji wideo uczy ukrytego modelu dyfuzji wideo na swoim zbiorze danych wideo wraz z wykorzystaniem generatywnych sieci przeciwstawnych lub GAN, a nawet w pewnym stopniu modeli autoregresyjnych.

Model stabilnego rozpowszechniania wideo opiera się na unikalnej strategii, która nigdy nie została wdrożona w żadnym generatywnym modelu wideo, ponieważ opiera się na bazowych danych dotyczących rozpowszechniania ukrytego wideo ze stałą architekturą i stałą strategią uczenia, po której następuje ocena efektu selekcji danych. Model stabilnej dyfuzji wideo ma na celu wniesienie następującego wkładu w dziedzinie generatywnego modelowania wideo.

- Zaprezentowanie systematycznego i skutecznego przepływu pracy związanego z przeglądaniem danych w celu przekształcenia dużej kolekcji nieprzetworzonych próbek wideo w wysokiej jakości zbiór danych, który będzie następnie wykorzystywany w generatywnych modelach wideo.

- Aby wyszkolić najnowocześniejsze modele obrazu na wideo i tekstu na wideo, które przewyższają istniejące platformy.

- Przeprowadzanie eksperymentów specyficznych dla danej dziedziny w celu sprawdzenia zrozumienia 3D i silnego wcześniejszego poznania ruchu modelu.

Obecnie model stabilnej dyfuzji wideo wykorzystuje wnioski wyciągnięte z modeli dyfuzji ukrytego wideo i technik przetwarzania danych, stanowiących podstawę jego podstaw.

Modele dyfuzji ukrytego wideo

Modele dyfuzji utajonego wideo lub wideo-LDM opierają się na podejściu polegającym na szkoleniu podstawowego modelu generatywnego w ukrytej przestrzeni o zmniejszonej złożoności obliczeniowej, a większość wideo-LDM implementuje wstępnie wytrenowany model tekstu na obraz w połączeniu z dodatkiem warstw mieszania czasowego we wstępnym szkoleniu architektura. W rezultacie większość modeli dyfuzji ukrytego wideo albo trenuje tylko warstwy tymczasowe, albo całkowicie pomija proces uczenia, w przeciwieństwie do stabilnego modelu dyfuzji wideo, który dostraja całą strukturę. Co więcej, w przypadku syntezy tekstu na dane wideo, model stabilnego rozproszenia wideo bezpośrednio warunkuje się w odpowiedzi na monit tekstowy, a wyniki wskazują, że powstałą strukturę można łatwo dostroić do syntezy wielu widoków lub modelu obrazu do wideo.

Kuracja danych

Sprawdzanie danych jest istotnym elementem nie tylko stabilnego modelu dyfuzji wideo, ale modeli generatywnych jako całości, ponieważ niezbędne jest wstępne nauczenie dużych modeli na dużych zbiorach danych w celu zwiększenia wydajności różnych zadań, w tym modelowania języka lub generowania różnicowego tekstu na obraz , i wiele więcej. Sprawdzanie danych zostało pomyślnie wdrożone w generatywnych modelach obrazu poprzez wykorzystanie możliwości wydajnych reprezentacji językowo-obrazowych, chociaż tego typu dyskusje nigdy nie były skupiane na opracowywaniu generatywnych modeli wideo. Programiści napotykają kilka przeszkód podczas gromadzenia danych na potrzeby generatywnych modeli wideo. Aby sprostać tym wyzwaniom, w modelu stabilnego rozpowszechniania wideo zastosowano trzyetapową strategię szkoleniową, co zapewnia lepsze wyniki i znaczny wzrost wydajności.

Weryfikacja danych w celu syntezy wideo wysokiej jakości

Jak omówiono w poprzedniej sekcji, model stabilnego rozpowszechniania wideo wdraża trzyetapową strategię szkoleniową, co skutkuje lepszymi wynikami i znacznym wzrostem wydajności. Etap I to przygotowanie obrazu etap, który wykorzystuje model dyfuzji tekstu na obraz 2D. Etap II przeznaczony jest dla wstępne szkolenie wideo w którym framework trenuje na dużej ilości danych wideo. Wreszcie mamy III etap dostrajanie wideo w którym model jest udoskonalany na niewielkim podzbiorze filmów o wysokiej jakości i rozdzielczości.

Zanim jednak model stabilnego rozpowszechniania wideo wdroży te trzy etapy, istotne jest przetworzenie i dodanie adnotacji do danych, ponieważ stanowią one podstawę dla etapu II, czyli etapu wstępnego szkolenia wideo i odgrywają kluczową rolę w zapewnieniu optymalnej wydajności. Aby zapewnić maksymalną wydajność, platforma najpierw implementuje kaskadowy potok wykrywania cięć przy 3 różnych poziomach FPS lub klatek na sekundę, a potrzebę stosowania tego potoku pokazano na poniższym obrazie.

Następnie model stabilnego rozprzestrzeniania wideo dodaje adnotacje do każdego klipu wideo przy użyciu trzech różnych metod tworzenia napisów syntetycznych. W poniższej tabeli porównano zbiory danych użyte w Stable Diffusion Framework przed i po procesie filtracji.

Etap I: Przygotowanie wizerunkowe

Pierwszym etapem trzyetapowego potoku wdrażanego w modelu stabilnego dyfuzji wideo jest wstępne szkolenie obrazu. Aby to osiągnąć, początkowa struktura modelu stabilnego dyfuzji wideo opiera się na wstępnie wytrenowanym modelu dyfuzji obrazu, a mianowicie Stabilna dyfuzja 2.1 model, który wyposaża go w silniejsze reprezentacje wizualne.

Etap II: Szkolenie wstępne wideo

Drugi etap to etap wstępnego szkolenia wideo, który opiera się na ustaleniach, że wykorzystanie selekcji danych w multimodalnych generatywnych modelach obrazu często skutkuje lepszymi wynikami i zwiększoną wydajnością wraz z potężnym generowaniem obrazów dyskryminacyjnych. Jednakże ze względu na brak podobnych, gotowych reprezentacji do filtrowania niepożądanych próbek dla generatywnych modeli wideo, model stabilnego rozprzestrzeniania wideo opiera się na ludzkich preferencjach jako sygnałach wejściowych do tworzenia odpowiedniego zbioru danych wykorzystywanego do wstępnego uczenia platformy. Poniższy rysunek przedstawia pozytywny wpływ wstępnego szkolenia platformy na wyselekcjonowanym zestawie danych, który pomaga zwiększyć ogólną wydajność wstępnego szkolenia wideo na mniejszych zestawach danych.

Mówiąc dokładniej, struktura wykorzystuje różne metody selekcji podzbiorów ukrytego rozpowszechniania wideo i uwzględnia ranking modeli LVD wytrenowanych na tych zbiorach danych. Co więcej, w ramach Stable Video Diffusion stwierdzono również, że wykorzystanie wybranych zbiorów danych do szkolenia frameworków pomaga w zwiększeniu wydajności frameworka i ogólnie modeli dyfuzji. Co więcej, strategia selekcji danych działa również w przypadku większych, bardziej odpowiednich i wysoce praktycznych zbiorów danych. Poniższy rysunek przedstawia pozytywny wpływ wstępnego szkolenia platformy na wyselekcjonowanym zestawie danych, który pomaga zwiększyć ogólną wydajność wstępnego szkolenia wideo na mniejszych zestawach danych.

Etap III: Dostrajanie wysokiej jakości

Aż do etapu II framework Stable Video Diffusion skupia się na poprawie wydajności przed wstępnym szkoleniem wideo, a na trzecim etapie framework kładzie nacisk na optymalizację lub dalsze zwiększanie wydajności frameworku po dostrojeniu wysokiej jakości wideo oraz w jaki sposób przejście z etapu II do etapu III odbywa się w ramach. Na etapie III struktura czerpie z technik szkoleniowych zapożyczonych z modeli dyfuzji obrazu ukrytego i zwiększa rozdzielczość przykładów szkoleniowych. Aby przeanalizować skuteczność tego podejścia, framework porównuje je z trzema identycznymi modelami, które różnią się jedynie inicjalizacją. W pierwszym identycznym modelu inicjalizowane są wagi, a proces uczenia wideo jest pomijany, natomiast w pozostałych dwóch identycznych modelach inicjalizowane są wagi zapożyczone z innych ukrytych modeli wideo.

Wyniki i ustalenia

Czas przyjrzeć się, jak framework Stable Video Diffusion radzi sobie z zadaniami w świecie rzeczywistym i jak wypada w porównaniu z obecnym stanem wiedzy. Struktura Stable Video Diffusion najpierw wykorzystuje optymalne podejście do danych do uczenia modelu podstawowego, a następnie przeprowadza dostrajanie w celu wygenerowania kilku najnowocześniejszych modeli, z których każdy model wykonuje określone zadanie.

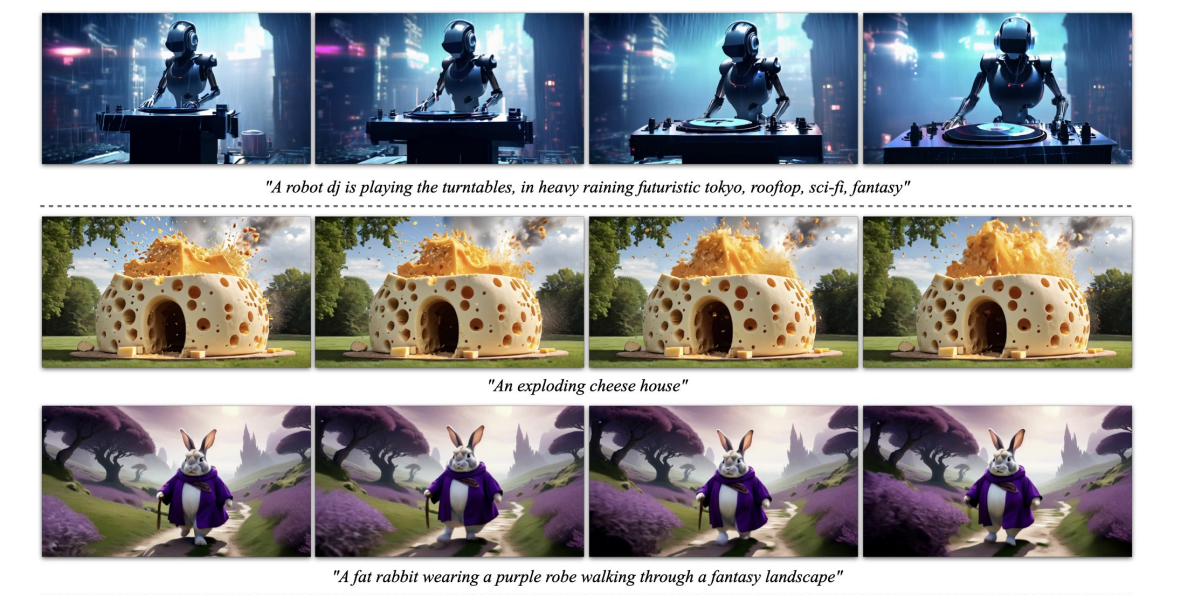

Powyższy obrazek przedstawia próbki obrazu o wysokiej rozdzielczości wygenerowane przez platformę, natomiast poniższy rysunek przedstawia zdolność platformy do generowania wysokiej jakości próbek tekstu na wideo.

Wstępnie przeszkolona baza MOdel

Jak wspomniano wcześniej, model Stable Video Diffusion jest zbudowany na frameworku Stable Diffusion 2.1 i na podstawie najnowszych ustaleń dla programistów istotne było przyjęcie harmonogramu szumów i zwiększenie szumu, aby uzyskać obrazy o lepszej rozdzielczości podczas uczenia dyfuzji obrazu modele. Dzięki takiemu podejściu model podstawowy Stable Video Diffusion uczy się potężnych reprezentacji ruchu i w trakcie tego procesu przewyższa modele bazowe tekst do generowanie wideo przy ustawieniu zerowym, a wyniki przedstawiono w poniższej tabeli.

Interpolacja klatek i generowanie wielu widoków

Struktura Stable Video Diffusion dostraja obraz do modelu wideo w zbiorach danych z wieloma widokami, aby uzyskać wiele nowatorskich widoków obiektu, a model ten jest znany jako model SVD-MV lub model Stable Video Diffusion-Multi View. Oryginalny model SVD jest dopracowywany za pomocą dwóch zestawów danych w taki sposób, że platforma wprowadza pojedynczy obraz i jako wynik zwraca sekwencję obrazów z wielu widoków.

Jak widać na poniższych ilustracjach, framework Stable Video Diffusion Multi View zapewnia wysoką wydajność porównywalną z najnowocześniejszym frameworkiem Scratch Multi View, a wyniki wyraźnie pokazują zdolność SVD-MV do wykorzystania zdobytej wiedzy z oryginalnego frameworka SVD do generowania obrazów z wieloma widokami. Co więcej, wyniki wskazują również, że uruchomienie modelu przez stosunkowo mniejszą liczbę iteracji pomaga w uzyskaniu optymalnych wyników, jak ma to miejsce w przypadku większości modeli dostrojonych na podstawie platformy SVD.

Na powyższym rysunku metryki pokazano po lewej stronie i jak widać, framework Stable Video Diffusion Multi View przewyższa frameworki Scratch-MV i SD2.1 Multi-View z przyzwoitym marginesem. Drugi obraz pokazuje wpływ liczby iteracji szkoleniowych na ogólną wydajność frameworka pod względem Clip Score, a frameworki SVD-MV zapewniają trwałe wyniki.

Final Thoughts

W tym artykule omówiliśmy Stable Video Diffusion, ukryty model dyfuzji wideo, który może generować najnowocześniejszy obraz w wysokiej rozdzielczości i tekst w treści wideo. Model stabilnego rozpowszechniania wideo opiera się na unikalnej strategii, która nigdy nie została wdrożona w żadnym generatywnym modelu wideo, ponieważ opiera się na bazowych danych dotyczących rozpowszechniania ukrytego wideo ze stałą architekturą i stałą strategią uczenia, po której następuje ocena efektu selekcji danych.

Rozmawialiśmy o tym, jak modele dyfuzji utajonej wyszkolone do syntezy obrazów 2D poprawiły możliwości i wydajność generatywne modele wideo dodając warstwy tymczasowe i dostrajając modele na małych zbiorach danych składających się z wysokiej jakości filmów. Aby zebrać dane przed szkoleniem, platforma przeprowadza badanie skalowania i postępuje zgodnie z praktykami systematycznego gromadzenia danych, a ostatecznie proponuje metodę selekcji dużej ilości danych wideo i konwertuje zaszumione filmy na dane wejściowe odpowiednie dla generatywnych modeli wideo.

Co więcej, platforma Stable Video Diffusion wykorzystuje trzy różne etapy uczenia modelu wideo, które są analizowane niezależnie w celu oceny ich wpływu na wydajność platformy. Ostatecznie platforma generuje reprezentację wideo wystarczająco potężną, aby dostroić modele w celu uzyskania optymalnej syntezy wideo, a wyniki są porównywalne z najnowocześniejszymi już używanymi modelami generowania wideo.