Artificial Intelligence

Rozplątanie to kolejna rewolucja w deepfake'u

W nowym projekcie wykorzystuje się powiększanie danych CGI, aby uzyskać większą kontrolę nad fałszywymi obrazami. Chociaż w dalszym ciągu nie można skutecznie używać głowic CGI do uzupełniania brakujących luk w zbiorach danych dotyczących fałszywych twarzy, nowa fala badań nad wyplątaniem tożsamości z kontekstu oznacza, że wkrótce być może nie będzie to konieczne.

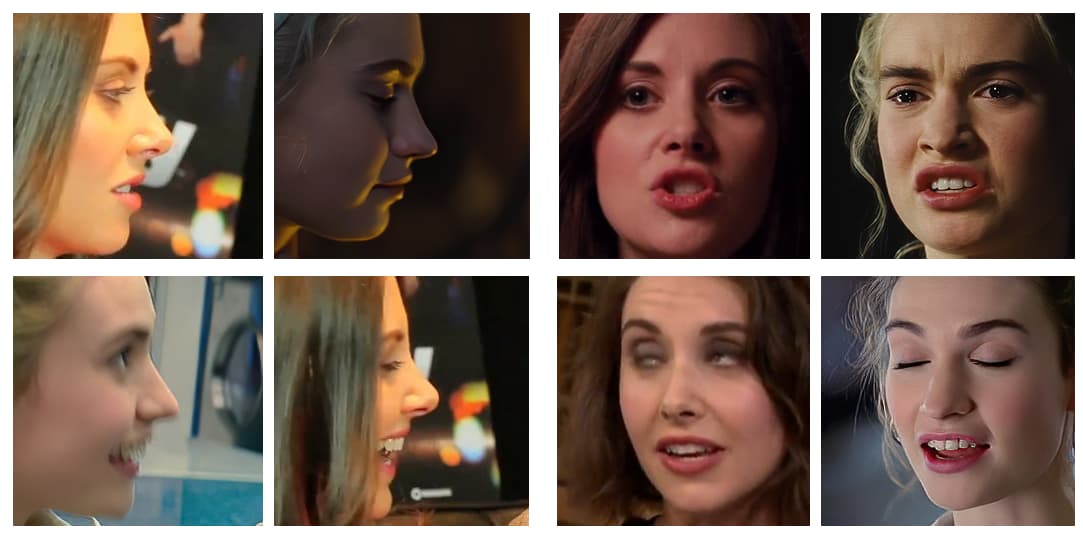

Twórcy niektórych z odnoszących największe sukcesy wirusowych filmów typu deepfake z ostatnich kilku lat bardzo starannie wybierają swoje filmy źródłowe, unikając długich zdjęć profilowych (tj. tego rodzaju zdjęć mugshots z boku spopularyzowanych podczas policyjnych procedur aresztowań), ostrych kątów oraz niezwykłej lub przesadnej ekspresji . Coraz częściej filmy demonstracyjne produkowane przez wirusowych deepfakerów to zredagowane kompilacje, w których wybierane są „najłatwiejsze” ujęcia i wyrażenia do deepfake'a.

Tak naprawdę najbardziej odpowiednim docelowym filmem, w którym można umieścić sfałszowaną gwiazdę, jest taki, w którym pierwotna osoba (której tożsamość zostanie wymazana przez deepfake) patrzy prosto w kamerę, z minimalnym zakresem wyrazu twarzy.

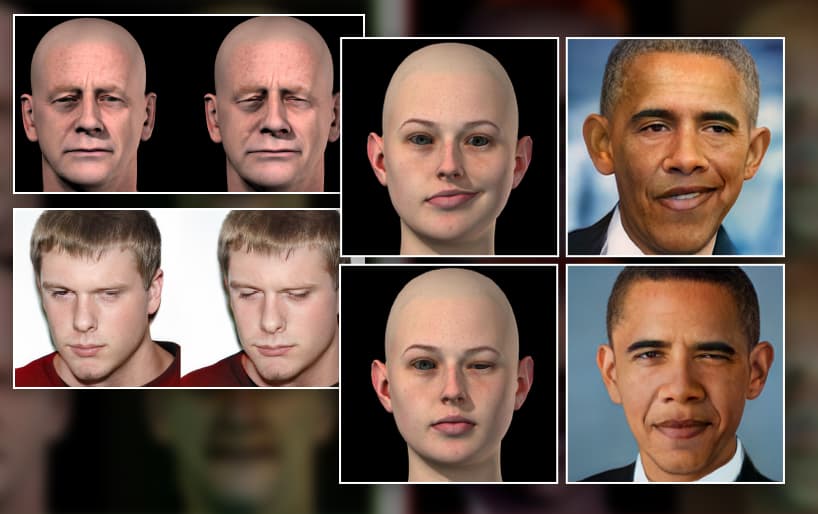

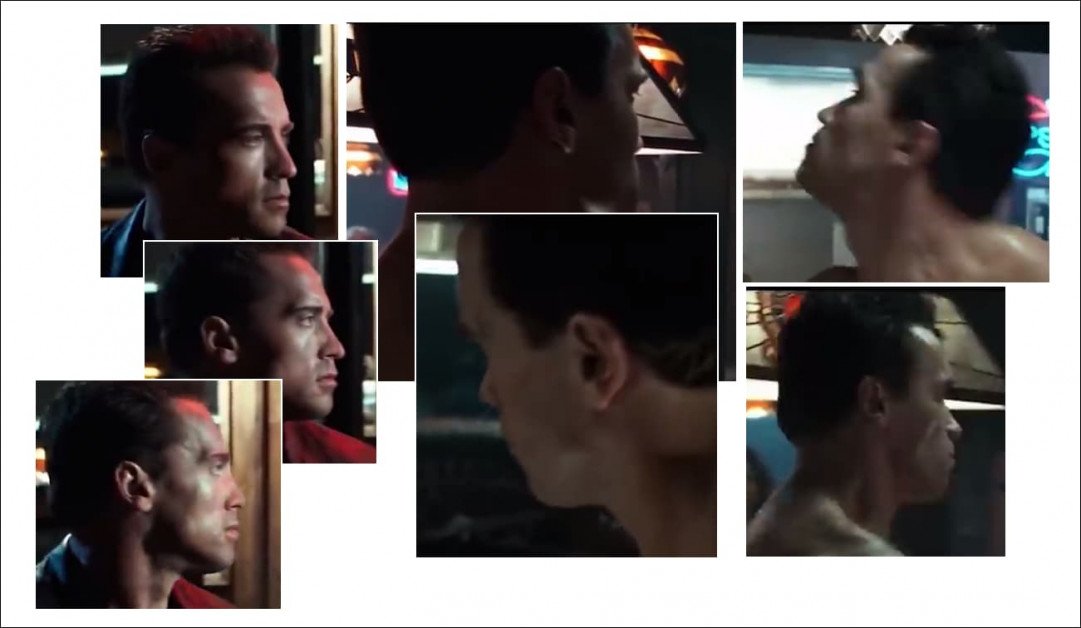

Większość popularnych deepfake’ów z ostatnich lat pokazywała osoby zwrócone twarzą w stronę kamery i albo noszące tylko popularne wyrażenia (takie jak uśmiech), które można łatwo wydobyć z materiałów paparazzi z czerwonego dywanu, albo (jak w przypadku podróbki Sylvestra Stallone z 2019 r. jak Terminator na zdjęciu po lewej), najlepiej bez żadnej ekspresji, ponieważ neutralne wyrażenia są niezwykle powszechne, co ułatwia ich włączenie do modeli deepfake.

Ponieważ technologie deepfake, takie jak GłębokaTwarzLab i Zamiana twarzy bardzo dobrze wykonujmy te prostsze zamiany, jesteśmy na tyle oszołomieni tym, czego dokonają, że nie zauważamy, do czego nie są zdolni i – często – nawet nie próbujemy:

Fragmenty uznanego filmu typu deepfake, w którym Arnold Schwarzenegger zmienia się w Sylvestra Stallone – chyba że kąty są zbyt trudne. Profile pozostają stałym problemem w przypadku obecnych podejść do deepfake, częściowo dlatego, że oprogramowanie open source używane do definiowania póz twarzy w frameworkach deepfake nie jest zoptymalizowane pod kątem widoków z boku, ale głównie z powodu braku odpowiedniego materiału źródłowego w jednym lub obu niezbędnych zbiory danych. Źródło: https://www.youtube.com/watch?v=AQvCmQFScMA

Nowe badania z Izraela proponuje nowatorską metodę wykorzystania danych syntetycznych, takich jak głowy CGI, aby wprowadzić deepfaking w lata 2020. poprzez rzeczywiste oddzielenie tożsamości twarzy (tj. podstawowych cech twarzy „Toma Cruise'a” pod każdym kątem) od ich kontekstu (tj. patrząc w górę, patrząc na boki, nachmurzenie, krzywiąc się w ciemności, brwi zmarszczyły się, zamknięte oczyItp.).

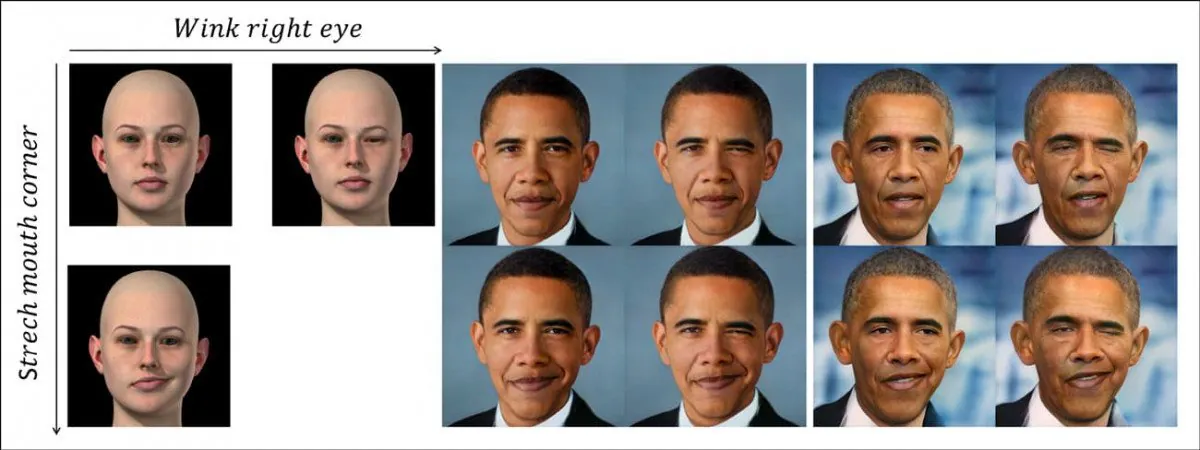

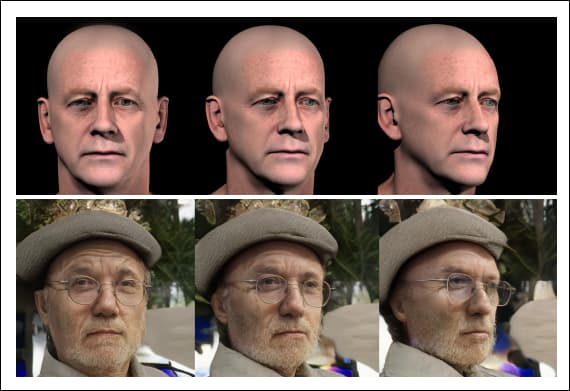

Nowy system dyskretnie oddziela pozę i kontekst (tj. mruganie okiem) od kodowania tożsamości danej osoby, wykorzystując niepowiązane syntetyczne dane dotyczące twarzy (na zdjęciu po lewej). W górnym rzędzie widzimy mrugnięcie okiem przeniesione na tożsamość Baracka Obamy, spowodowane wyuczoną nieliniową ścieżką ukrytej przestrzeni GAN, reprezentowaną przez obraz CGI po lewej stronie. W rzędzie poniżej widzimy rozciągnięty kącik ust przeniesiony na byłego prezydenta. Na dole po prawej stronie widzimy zastosowanie obu cech jednocześnie. Źródło: https://arxiv.org/pdf/2111.08419.pdf

To nie jest byle co deepfake head-lalkarstwo, technika bardziej odpowiednia w przypadku awatarów i synchronizacji warg części twarzy, która ma ograniczony potencjał w zakresie pełnoprawnych transformacji wideo typu deepfake.

Stanowi to raczej krok naprzód w kierunku zasadniczego oddzielenia instrumentalności (takiej jak „zmienić kąt głowy”, „zmarszczyć brwi”) od tożsamości, oferując ścieżkę do platformy deepfake wysokiego poziomu, a nie „pochodnej” syntezy obrazów.

Nowa gazeta nosi tytuł Koder Delta-GAN: kodowanie zmian semantycznych w celu jawnej edycji obrazu przy użyciu kilku próbek syntetycznychi pochodzi od naukowców z Technion – Izraelskiego Instytutu Technologii.

Aby zrozumieć, na czym polega ta praca, przyjrzyjmy się, jak obecnie produkowane są deepfakes wszędzie, od witryn pornograficznych typu deepfake po Przemysłowe światło i magia (ponieważ repozytorium open source DeepFaceLab dominuje obecnie zarówno w przypadku „amatorskiego”, jak i profesjonalnego deepfakingu).

Co powstrzymuje obecną technologię Deepfake?

Deepfakes są obecnie tworzone poprzez szkolenie koder/dekoder model uczenia maszynowego na dwóch folderach zawierających obrazy twarzy – osoby, którą chcesz „zamalować” (we wcześniejszym przykładzie był to Arnie) i osoby, którą chcesz nałożyć na materiał filmowy (Sly).

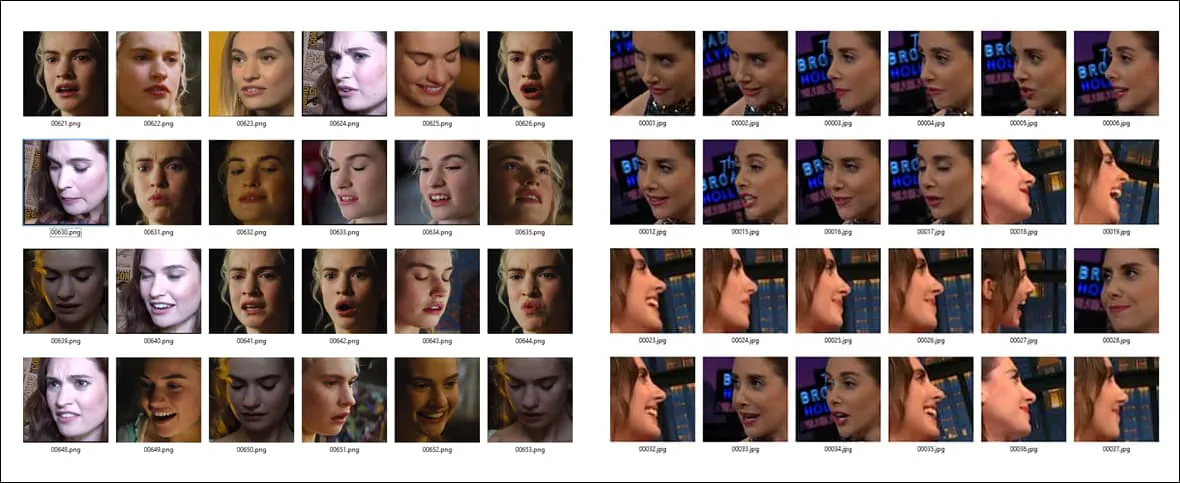

Przykłady różnych pozycji i warunków oświetleniowych dla dwóch różnych zestawów twarzy. Zwróć uwagę na charakterystyczne wyrażenie na końcu trzeciego wiersza w kolumnie A, które prawdopodobnie nie będzie miało bliskiego odpowiednika w innym zbiorze danych.

Zatem system kodera/dekodera porównuje każdy pojedynczy obraz w każdym folderze, utrzymując, ulepszając i powtarzając tę operację przez setki tysięcy iteracji (często nawet przez tydzień), dopóki nie zrozumie podstawowych cech obu tożsamości na tyle dobrze, aby móc je dowolnie zamieniać.

W przypadku każdej z dwóch osób zamienianych w tym procesie architektura deepfake dowiaduje się o tożsamości uwikłany w kontekst. Nie może nauczyć się i zastosować zasad dotyczących ogólnej pozy „na dobre i na zawsze”, ale potrzebuje licznych przykładów w zbiorze danych szkoleniowych dla każdej tożsamości, która będzie zaangażowana w zamianę twarzy.

Dlatego jeśli chcesz zamienić dwie tożsamości, które robią coś bardziej niezwykłego niż tylko uśmiechanie się lub patrzenie prosto do kamery, będziesz potrzebować wiele przykłady tej konkretnej pozy/tożsamości w dwóch zestawach twarzy:

Ponieważ cechy identyfikacji twarzy i pozy są obecnie ze sobą powiązane, w celu wytrenowania skutecznego modelu deepfake w systemach takich jak DeepFaceLab potrzebna jest szeroko zakrojona równość ekspresji, ułożenia głowy i (w mniejszym stopniu) oświetlenia w dwóch zbiorach danych dotyczących twarzy. Im mniej konkretna konfiguracja (taka jak „widok z boku/uśmiech/oświetlenie słoneczne”) jest widoczna w obu zestawach twarzy, tym mniej dokładnie będzie ona renderowana w filmie typu deepfake, jeśli zajdzie taka potrzeba.

Jeśli zestaw A zawiera niezwykłą pozę, ale zestawowi B jej brakuje, to raczej nie masz szczęścia; bez względu na to, jak długo będziesz trenował model, nigdy nie nauczy się on dobrze odtwarzać tej pozycji między tożsamościami, ponieważ podczas treningu miał tylko połowę niezbędnych informacji.

Nawet jeśli masz pasujące obrazy, może to nie wystarczyć: jeśli zestaw A ma pasującą pozę, ale przy ostrym świetle bocznym, w porównaniu z równoważną pozą o płaskim świetle w drugim zestawie twarzy, jakość zamiany zwyciężyła nie będzie tak dobre, jak gdyby każdy z nich miał wspólne cechy oświetlenia.

Dlaczego danych jest mało

Jeśli nie jesteś regularnie aresztowany, prawdopodobnie nie masz zbyt wielu zdjęć z boku. Wszystko, co się pojawiło, prawdopodobnie wyrzuciłeś. Ponieważ agencje fotograficzne robią to samo, trudno jest uzyskać zdjęcia twarzy profilowych.

Deepfakerzy często dołączają wiele kopii ograniczonych danych profilu z boku, które posiadają dla tożsamości w zestawie twarzy, tylko po to, aby ta pozycja uzyskała co najmniej mało uwagę i czas podczas szkolenia, zamiast być dyskontowanym jako odstające.

Istnieje jednak o wiele więcej możliwych typów zdjęć twarzy widzianych z boku, niż można prawdopodobnie uwzględnić w zbiorze danych – uśmiechając, marszcząc brwi, krzyczeć, płacz, ciemno oświetlony, pogardliwy, znudzony, wesoły, oświetlona lampą błyskową, patrząc w górę, patrząc w dół, Otwarte oczy, oczy zamknięte…i tak dalej. Dowolna z tych pozycji w wielu kombinacjach może być potrzebna w docelowym docelowym filmie typu deepfake.

A to tylko profile. Ile masz zdjęć, na których patrzysz? prosto w górę? Czy masz dość, aby szeroko reprezentować 10,000 XNUMX możliwych wyrażeń możesz mieć na sobie, trzymając dokładnie tę pozę pod dokładnie tym kątem kamery, zakrywając przynajmniej część milion możliwych środowisk oświetleniowych?

Są szanse, że nawet nie masz pierwszej zdjęcie siebie patrzącego w górę. A to tylko dwa kąty ze stu lub więcej potrzebnych do pełnego pokrycia.

Nawet gdyby możliwe było wygenerowanie pełnego pokrycia twarzy pod każdym kątem w różnych warunkach oświetleniowych, powstały zbiór danych byłby o wiele za duży, aby go wytrenować, rzędu setek tysięcy zdjęć; a nawet jeśli mógłby zostać przeszkolony, charakter procesu uczenia obecnych frameworków deepfake spowodowałby odrzucenie ogromnej większości tych dodatkowych danych na rzecz ograniczonej liczby funkcji pochodnych, ponieważ obecne frameworki są redukcjonistyczne i niezbyt skalowalne.

Substytucja syntetyczna

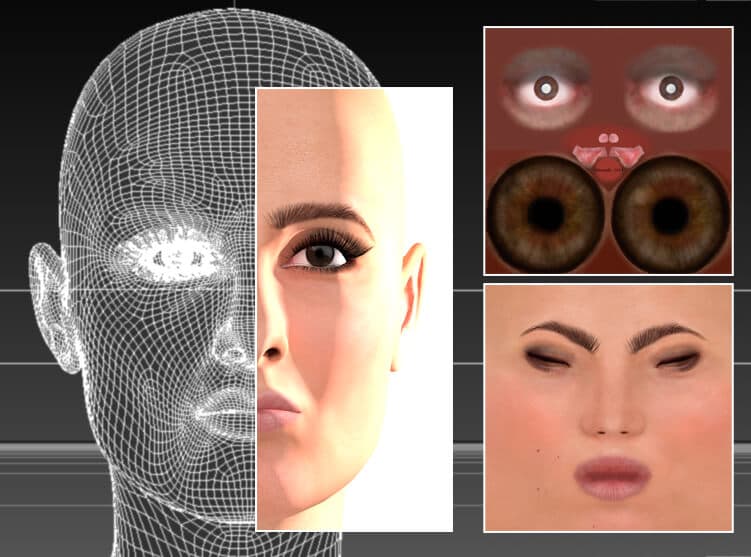

Od początków deepfake’ów deepfakerzy eksperymentowali z wykorzystaniem obrazów w stylu CGI i głów wykonanych w aplikacjach 3D, takich jak Cinema4D i Maya, w celu wygenerowania „brakujących póz”.

Nie jest konieczna sztuczna inteligencja; aktorka jest odtwarzana w tradycyjnym programie CGI, Cinema 4D, przy użyciu siatek i tekstur bitmapowych – technologii, której początki sięgają lat 1960. XX wieku, ale która znalazła szerokie zastosowanie dopiero od lat 1990. XX wieku. Teoretycznie ten model twarzy można wykorzystać do generowania fałszywych danych źródłowych dotyczących nietypowych póz, stylów oświetlenia i wyrazu twarzy. W rzeczywistości przydaje się to w ograniczonym stopniu lub nie ma żadnego zastosowania w deepfakingu, ponieważ „fałszywość” renderów ma tendencję do przenikania w zamienionych filmach. Źródło: zdjęcie autora tego artykułu pod adresem https://rossdawson.com/futurist/implications-of-ai/comprehensive-guide-ai-artificial-intelligence-visual-effects-vfx/

Ta metoda jest zazwyczaj wcześnie porzucana przez nowych praktyków deepfake, ponieważ chociaż może zapewnić pozy i wyrażenia, które w innym przypadku byłyby niedostępne, syntetyczny wygląd twarzy CGI zwykle odbija się na zamianach z powodu splątania identyfikatora i informacji kontekstowych/semantycznych.

Może to prowadzić do nagłego pojawienia się twarzy z „doliny niesamowitej” w skądinąd przekonującym filmie typu deepfake, gdy algorytm zaczyna czerpać z jedynych danych, jakie może posiadać na temat nietypowej pozy lub wyrazu twarzy – ewidentnie fałszywych twarzy.

Do najpopularniejszych tematów wśród deepfakerów należy algorytm 3D deepfake australijskiej aktorki Margot Robbie. włączony w domyślnej instalacji DeepFaceLive, wersja DeepFaceLab, która może wykonywać deepfakes w transmisji na żywo, takiej jak sesja kamery internetowej. Wersja CGI, jak pokazano powyżej, może zostać wykorzystana do uzyskania nietypowych „brakujących” kątów w fałszywych zbiorach danych. Source: https://sketchfab.com/3d-models/margot-robbie-bust-for-full-color-3d-printing-98d15fe0403b4e64902332be9cfb0ace

Twarze CGI jako oddzielne wytyczne koncepcyjne

Zamiast tego nowa metoda Delta-GAN Encoder (DGE) opracowana przez izraelskich badaczy jest bardziej skuteczna, ponieważ informacje o pozie i kontekście z obrazów CGI zostały całkowicie oddzielone od informacji o „tożsamości” celu.

Zasadę tę możemy zobaczyć w działaniu na poniższym obrazku, na którym uzyskano różne orientacje głowy, stosując obrazy CGI jako wytyczne. Ponieważ cechy tożsamości nie są powiązane z cechami kontekstowymi, nie ma prześwitu ani przez sztucznie wyglądający syntetyczny wygląd twarzy CGI, ani przez przedstawioną na niej tożsamość:

Dzięki nowej metodzie nie trzeba znajdować trzech oddzielnych, prawdziwych obrazów źródłowych, aby odtworzyć deepfake pod różnymi kątami – wystarczy obrócić głowicę CGI, której abstrakcyjne cechy wysokiego poziomu są nanoszone na tożsamość bez wyciekania żadnego identyfikatora Informacja.

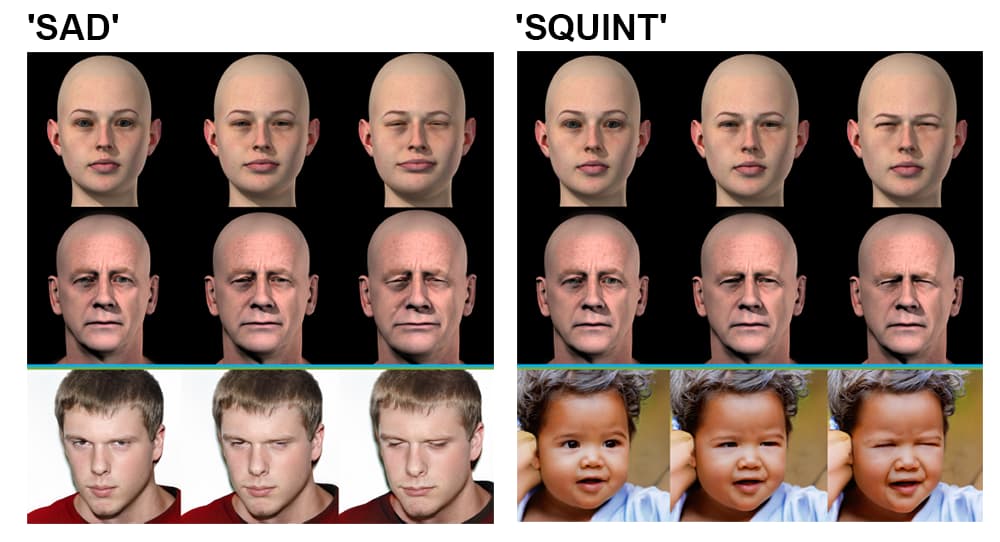

Koder Delta-GAN. Grupa u góry po lewej stronie: kąt obrazu źródłowego można zmienić w ciągu sekundy, aby wyrenderować nowy obraz źródłowy, który znajduje odzwierciedlenie na wyjściu; grupa w prawym górnym rogu: oświetlenie również jest oddzielone od tożsamości, co pozwala na nakładanie się stylów oświetlenia; grupa w lewym dolnym rogu: wiele szczegółów twarzy zostało zmienionych, aby uzyskać „smutny” wyraz; grupa w prawym dolnym rogu: zmienia się jeden szczegół wyrazu twarzy, tak że oczy mrużą.

To oddzielenie tożsamości i kontekstu osiąga się na etapie szkolenia. Plan nowej architektury deepfake wyszukuje ukryty wektor we wstępnie wytrenowanej sieci generatywnej kontradyktoryjnej (GAN), która pasuje do obrazu, który ma zostać przekształcony — metodologia Sim2Real oparta na badaniu z 2018 r. projekt z sekcji badań nad sztuczną inteligencją IBM.

Naukowcy zauważają:

„Mając zaledwie kilka próbek, które różnią się określonym atrybutem, można poznać rozplątane zachowanie wstępnie wytrenowanego splątanego modelu generatywnego. Aby osiągnąć ten cel, nie są potrzebne dokładne próbki ze świata rzeczywistego, co niekoniecznie jest wykonalne.

„Wykorzystując nierealistyczne próbki danych, ten sam cel można osiągnąć dzięki wykorzystaniu semantyki zakodowanych wektorów ukrytych. Stosowanie pożądanych zmian w istniejących próbkach danych można przeprowadzić bez wyraźnej eksploracji ukrytych zachowań kosmicznych.

Naukowcy spodziewają się, że podstawowe zasady rozplątywania zbadane w ramach projektu można przenieść do innych dziedzin, takich jak symulacje architektury wnętrz, oraz że metoda Sim2Real zastosowana w programie Delta-GAN-Encoder może ostatecznie umożliwić wykorzystanie narzędzi deepfake w oparciu o zwykłe szkice, a nie Wejście w stylu CGI.

Można argumentować, że stopień, w jakim nowy izraelski system może, ale nie musi, być w stanie zsyntetyzować fałszywe filmy wideo, jest znacznie mniej znaczący niż postęp, jaki poczyniły badania w oddzielaniu kontekstu od tożsamości, w procesie uzyskiwania większej kontroli nad ukrytą przestrzenią z sieci GAN.

Rozplątanie jest aktywnym obszarem badań nad syntezą obrazu; w styczniu 2021 r. badanie prowadzone przez Amazon papier wykazał podobną kontrolę pozycji i rozplątanie, a w 2018 r papier z Instytutów Zaawansowanych Technologii w Shenzhen Chińskiej Akademii Nauk poczynili postępy w generowaniu arbitralnych punktów widzenia w sieci GAN.