Artificial Intelligence

Renderowanie neuronowe: NeRF spaceruje na świeżym powietrzu

W ramach współpracy Google Research i Uniwersytetu Harvarda opracowano nową metodę tworzenia 360-stopniowego wideo neuronowego całych scen przy użyciu Neuronowe pola promieniowania (NeRF). Nowatorskie podejście przybliża NeRF o krok do swobodnego, abstrakcyjnego wykorzystania w dowolnym środowisku, bez ograniczeń modele stołowe or zamknięte scenariusze wnętrz.

Pełny film znajdziesz na końcu artykułu. Źródło: https://www.youtube.com/watch?v=YStDS2-Ln1s

Mip-NeRF 360 może obsługiwać rozszerzone tła i „nieskończone” obiekty, takie jak niebo, ponieważ w przeciwieństwie do większości poprzednich wersji wyznacza ograniczenia w sposobie interpretacji promieni świetlnych i tworzy granice uwagi, które racjonalizują w przeciwnym razie długie czasy szkolenia. Więcej przykładów i szerszy wgląd w proces można znaleźć w nowym, towarzyszącym filmie wideo umieszczonym na końcu tego artykułu.

Połączenia nowy papier jest zatytułowany Mip-NeRF 360: Nieograniczone, antyaliasingowe pola promieniowania neuronowego, a kieruje nim starszy pracownik naukowy w Google Research Jon Barron.

Aby zrozumieć przełom, należy mieć podstawową wiedzę na temat działania syntezy obrazu opartej na polu promieniowania neuronowego.

Co to jest NeRF?

Opisywanie sieci NeRF w kategoriach „wideo” jest problematyczne, ponieważ jest ona bliższa sieci w pełni zrealizowanej w 3D, ale Na bazie AI środowisko wirtualne, w którym wiele punktów widzenia z pojedynczych zdjęć (w tym klatek wideo) jest wykorzystywanych do połączenia sceny, która technicznie istnieje tylko w ukrytej przestrzeni algorytmu uczenia maszynowego – ale z której można dowolnie wyodrębnić niezwykłą liczbę punktów widzenia i filmów .

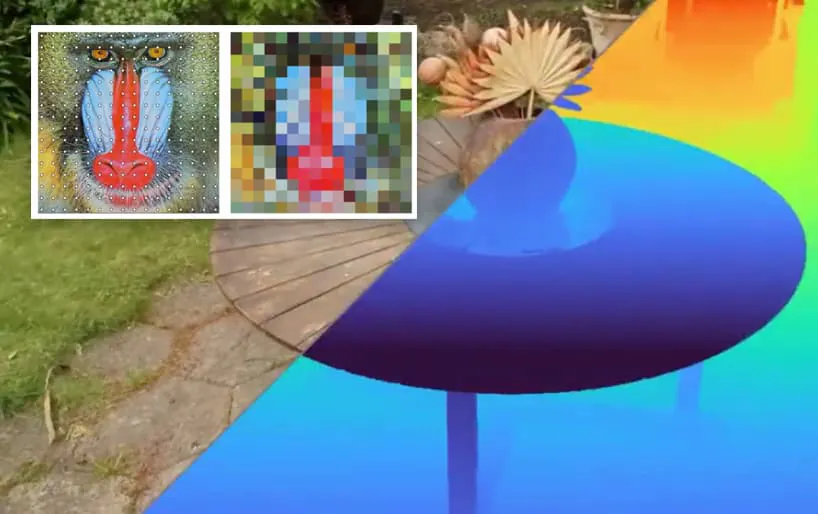

Przedstawienie wielu punktów przechwytywania kamer, które dostarczają dane, które NeRF łączy w scenę neuronową (na zdjęciu po prawej).

Informacje pochodzące z przesłanych zdjęć są przekształcane w macierz podobną do tradycyjnej siatka wokseli w procesach CGI, w których każdy punkt przestrzeni 3D kończy się wartością, dzięki czemu można nawigować po scenie.

Tradycyjna matryca wokseli umieszcza informacje o pikselach (które zwykle istnieją w kontekście 2D, np. siatka pikseli w pliku JPEG) w przestrzeni trójwymiarowej. Źródło: ResearchGate

Po obliczeniu odstępu między zdjęciami (jeśli to konieczne) ścieżka każdego możliwego piksela każdego zdjęcia składowego jest skutecznie „śledzona promieniami” i przypisywana jest mu wartość koloru, w tym wartość przezroczystości (bez której macierz neuronowa byłaby całkowicie nieprzezroczysta, lub całkowicie pusty).

Podobnie jak siatki wokseli i w odróżnieniu W przestrzeni współrzędnych 3D opartej na CGI „wnętrze” „zamkniętego” obiektu nie istnieje w matrycy NeRF. Jeśli chcesz, możesz rozebrać zestaw perkusyjny CGI i zajrzeć do środka; ale w przypadku NeRF istnienie zestawu perkusyjnego kończy się, gdy wartość przezroczystości jego powierzchni wynosi „1”.

Szerszy widok piksela

Mip-NeRF 360 jest rozszerzeniem badania z marca 2021 r, który skutecznie wprowadził efektywne wygładzanie do NeRF bez wyczerpującego supersamplingu.

NeRF tradycyjnie oblicza tylko jedną ścieżkę piksela, która jest skłonna wytworzyć rodzaj „starostki” które charakteryzowały wczesne formaty obrazów internetowych, a także wcześniejsze systemy gier. Te postrzępione krawędzie rozwiązano różnymi metodami, zwykle polegającymi na próbkowaniu sąsiednich pikseli i znajdowaniu średniej reprezentacji.

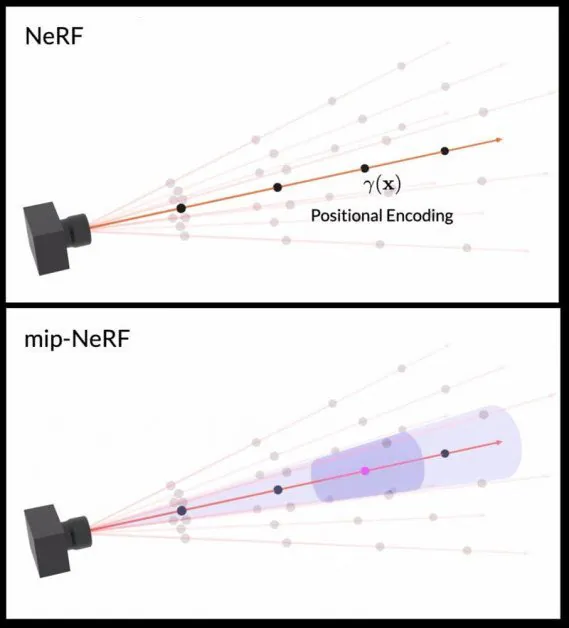

Ponieważ tradycyjny NeRF próbkuje tylko ścieżkę jednego piksela, Mip-NeRF wprowadził „stożkowy” obszar zlewni, podobny do latarki szerokostrumieniowej, który dostarcza wystarczających informacji o sąsiadujący pikseli w celu uzyskania ekonomicznego antyaliasingu z poprawioną szczegółowością.

Stożkowa zlewnia stożkowa używana przez Mip-NeRF jest cięta na stożkowe ścięty (dolny obraz), które są dalej „rozmyte”, tworząc niejasne przestrzenie Gaussa, które można wykorzystać do obliczenia dokładności i aliasu piksela. Źródło: https://www.youtube.com/watch?v=EpH175PY1A0

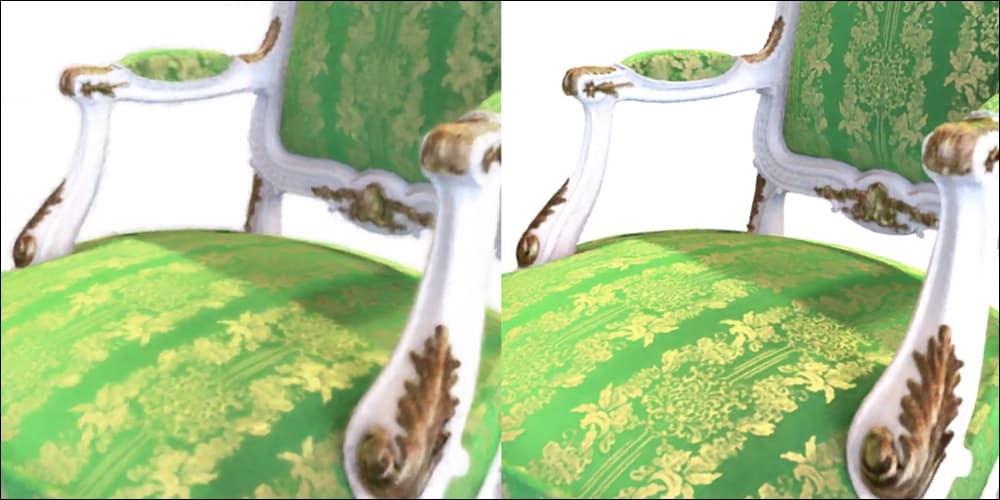

Poprawa w stosunku do standardowej implementacji NeRF była zauważalna:

Mip-NeRF (po prawej), wydany w marcu 2021 r., zapewnia lepszą szczegółowość dzięki bardziej wszechstronnemu, ale ekonomicznemu potokowi aliasingu, a nie tylko „rozmywaniu” pikseli w celu uniknięcia postrzępionych krawędzi. Źródło: https://jonbarron.info/mipnerf/

NeRF bez ograniczeń

W marcowym artykule nierozwiązano trzech problemów związanych ze stosowaniem Mip-NeRF w nieograniczonych środowiskach, które mogą obejmować bardzo odległe obiekty, w tym niebo. W nowym artykule rozwiązano ten problem, stosując a w stylu Kalmana warp do gaussów Mip-NeRF.

Po drugie, większe sceny wymagają większej mocy obliczeniowej i wydłużonego czasu uczenia, co Mip-NeRF 360 rozwiązuje poprzez „destylację” geometrii sceny za pomocą małej „propozycji” perceptron wielowarstwowy (MLP), który wstępnie ogranicza geometrię przewidywaną przez duży standard NeRF MLP. Przyspiesza to trening trzykrotnie.

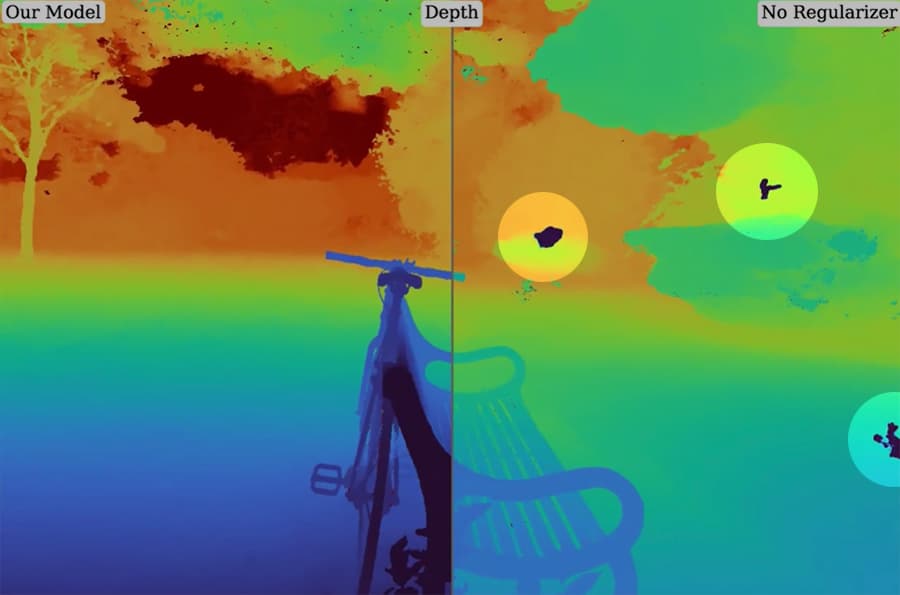

Wreszcie, większe sceny sprawiają, że dyskretyzacja interpretowanej geometrii jest niejednoznaczna, co skutkuje rodzajem artefaktów, które gracze mogą znać, gdy wynik gry „rozdziera się”. W nowym artykule rozwiązano ten problem, tworząc nowy regulator odstępów promieni Mip-NeRF.

Po prawej stronie widzimy niechciane artefakty w Mip-NeRF ze względu na trudność w ograniczeniu tak dużej sceny. Po lewej stronie widzimy, że nowy regularyzator zoptymalizował scenę na tyle dobrze, aby usunąć te zakłócenia.

Aby dowiedzieć się więcej o nowej gazecie, obejrzyj poniższy film, a także Wprowadzenie wideo z marca 2021 r do Mip-NeRF. Możesz także dowiedzieć się więcej na temat badań NeRF, sprawdzając nasz dotychczasowy zasięg.

Pierwotnie opublikowano 25 listopada 2021 r

21 grudnia 2021, 12:25 – Wymieniono martwe wideo. – MA